Génération de contenu par IA

Découvrez ce qu'est la génération de contenu par IA, son fonctionnement, ses avantages et défis, ainsi que les meilleures pratiques pour utiliser les outils d'I...

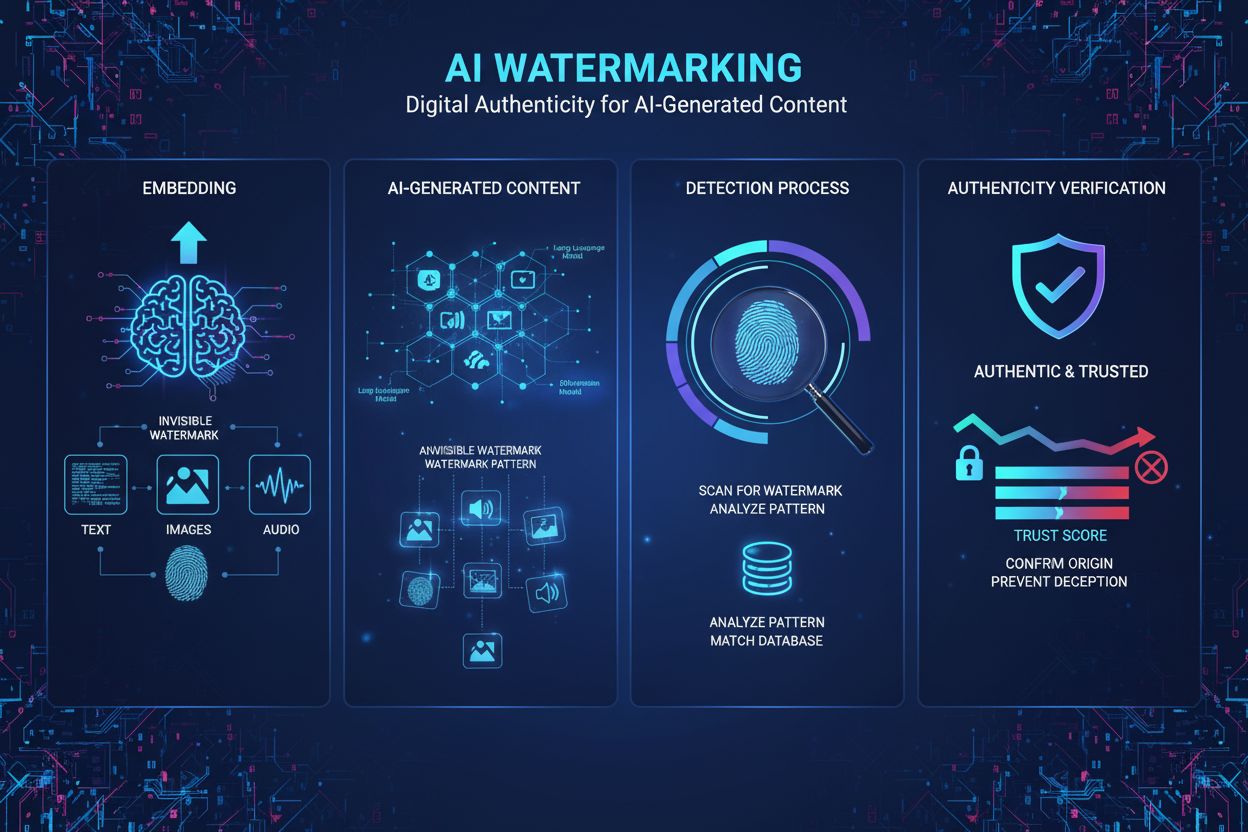

Le filigranage du contenu généré par l’IA est le processus d’intégration de marqueurs numériques invisibles ou visibles dans des textes, images, audio ou vidéos générés par l’IA afin d’identifier et d’authentifier ce contenu comme étant produit par une machine. Ces filigranes servent d’empreintes digitales numériques permettant la détection, la vérification et le suivi du matériel généré par l’IA à travers différentes plateformes et applications.

Le filigranage du contenu généré par l’IA est le processus d'intégration de marqueurs numériques invisibles ou visibles dans des textes, images, audio ou vidéos générés par l’IA afin d’identifier et d’authentifier ce contenu comme étant produit par une machine. Ces filigranes servent d’empreintes digitales numériques permettant la détection, la vérification et le suivi du matériel généré par l’IA à travers différentes plateformes et applications.

Le filigranage du contenu généré par l’IA désigne le processus d’intégration de marqueurs, motifs ou signatures numériques dans le matériel généré par l’IA afin d’identifier, d’authentifier et de tracer son origine. Ces filigranes agissent comme des empreintes digitales numériques permettant de distinguer le contenu produit par une machine de celui rédigé par un humain, que ce soit sous forme de texte, d’images, d’audio ou de vidéo. L’objectif principal du filigranage de contenu IA est d’apporter de la transparence sur la provenance du contenu tout en luttant contre la désinformation, en protégeant la propriété intellectuelle et en assurant la responsabilité dans le paysage en pleine expansion de l’intelligence artificielle générative. Contrairement aux filigranes traditionnels, visibles sur des documents physiques ou des images, les techniques modernes de filigranage IA reposent souvent sur des motifs invisibles détectables uniquement via des algorithmes spécialisés, préservant la qualité du contenu tout en maintenant de solides capacités d’authentification.

Le concept de filigranage trouve son origine dans le monde physique, où des marques invisibles sur les billets de banque et documents servaient à lutter contre la contrefaçon. Avec la généralisation des médias numériques, les chercheurs ont adapté les techniques de filigranage aux images, à l’audio et à la vidéo dans les années 1990 et 2000. Cependant, l’émergence de modèles IA génératifs avancés tels que ChatGPT, DALL-E et Midjourney en 2022-2023 a rendu urgente la standardisation des méthodes d’authentification du contenu IA. Les progrès rapides des capacités de l’IA, produisant des contenus synthétiques de plus en plus réalistes, ont incité gouvernements, entreprises technologiques et organisations de la société civile à faire du filigranage un garde-fou essentiel. Selon une étude de la Brookings Institution, plus de 78 % des entreprises reconnaissent l’importance des outils de surveillance du contenu basé sur l’IA pour la gestion des risques liés aux médias synthétiques. L’AI Act de l’UE, adopté officiellement en mars 2024, est devenu le premier cadre réglementaire majeur à imposer le filigranage du contenu IA, exigeant des fournisseurs de systèmes IA qu’ils marquent leur production comme générée par l’IA. Cet élan réglementaire a accéléré la recherche et le développement autour des technologies de filigranage, avec des entreprises comme Google DeepMind, OpenAI et Meta investissant massivement dans des solutions robustes de filigranage.

Le filigranage IA s’appuie sur deux grandes approches techniques : le filigranage visible et le filigranage invisible. Les filigranes visibles incluent des mentions, logos ou étiquettes évidentes ajoutées au contenu—comme les cinq carrés colorés placés par DALL-E sur les images générées ou le préambule de ChatGPT « en tant que modèle de langage entraîné par OpenAI ». Bien que faciles à mettre en œuvre, ces filigranes sont très simples à retirer via des modifications basiques. Le filigranage invisible, au contraire, intègre des motifs subtils imperceptibles à l’œil humain mais détectables par des algorithmes spécialisés. Pour les images générées par IA, des techniques comme les filigranes tree-ring développées à l’Université du Maryland intègrent des motifs dans le bruit initial avant le processus de diffusion, les rendant résistants au recadrage, à la rotation ou au filtrage. Pour le texte généré par IA, le filigranage statistique est l’approche la plus prometteuse : le modèle de langage favorise subtilement certains jetons (« jetons verts ») tout en évitant d’autres (« jetons rouges ») selon le contexte. Cela crée une distribution inhabituelle de mots que les algorithmes de détection peuvent identifier de façon fiable. Le filigranage audio intègre des motifs imperceptibles dans des plages de fréquences hors de portée de l’oreille humaine (sous 20 Hz ou au-dessus de 20 000 Hz), à l’image du filigranage d’image mais adapté à l’acoustique. La technologie SynthID de Google DeepMind illustre le filigranage moderne en entraînant conjointement modèles de génération et de détection pour garantir robustesse et qualité quel que soit le type de transformation subi par le contenu.

| Méthode de filigranage | Type de contenu | Robustesse | Impact sur la qualité | Nécessite un accès au modèle | Détectabilité |

|---|---|---|---|---|---|

| Filigranage visible | Images, Vidéo | Très faible | Aucun | Non | Élevée (Humaine) |

| Filigranage statistique | Texte, Images | Élevée | Minime | Oui | Élevée (Algorithmique) |

| Basé sur l’apprentissage automatique | Images, Audio | Élevée | Minime | Oui | Élevée (Algorithmique) |

| Filigranage tree-ring | Images | Très élevée | Aucun | Oui | Élevée (Algorithmique) |

| Provenance du contenu (C2PA) | Tous médias | Moyenne | Aucun | Non | Moyenne (Métadonnées) |

| Détection a posteriori | Tous médias | Faible | N/A | Non | Faible (Peu fiable) |

Le filigranage statistique s’avère être la technique la plus adaptée pour authentifier le texte généré par IA, car le texte ne possède pas la dimensionnalité des images ou de l’audio permettant d’y intégrer des motifs. Lors de la génération, un modèle de langage reçoit des instructions pour favoriser certains jetons selon une clé cryptographique connue uniquement du développeur. L’aléa du modèle est « biaisé » selon ce schéma, l’amenant à sélectionner préférentiellement certains mots ou expressions tout en en évitant d’autres. Les protocoles de détection analysent alors le texte pour calculer la probabilité que ces motifs de jetons aient été observés par hasard ; des motifs statistiquement improbables signalent la présence d’un filigrane. Des travaux de l’Université du Maryland et d’OpenAI ont montré que cette approche pouvait atteindre une grande précision de détection tout en préservant la qualité textuelle. Cependant, le filigranage statistique du texte présente des limites : les réponses factuelles avec peu de flexibilité (ex. solutions mathématiques ou faits historiques) sont plus difficiles à filigraner efficacement, et une réécriture ou traduction approfondie réduit fortement la confiance de détection. L’implémentation SynthID Text, désormais disponible dans Hugging Face Transformers v4.46.0+, offre un filigranage de niveau production configurable via des paramètres tels que la clé cryptographique et la longueur des n-grammes pour équilibrer robustesse et détectabilité.

Les images générées par IA bénéficient d’approches de filigranage plus sophistiquées grâce à la richesse dimensionnelle de l’image. Le filigranage tree-ring intègre des motifs cachés dans l’image initiale avant diffusion, rendant les filigranes résistants au recadrage, au flou ou à la rotation sans dégrader la qualité. Le filigranage basé sur l’apprentissage automatique (Meta, Google) utilise des réseaux neuronaux pour intégrer et détecter des filigranes imperceptibles, atteignant plus de 96 % de précision sur les images non modifiées tout en restant robuste face aux attaques pixel par pixel. Le filigranage audio applique des principes semblables, intégrant des motifs imperceptibles dans des bandes de fréquences hors de portée auditive. AudioSeal, développé par Meta, entraîne conjointement le générateur et le détecteur pour créer des filigranes robustes aux transformations naturelles audio tout en préservant une qualité sonore identique à l’original. La technologie utilise une perte perceptuelle pour garantir que l’audio filigrané reste indiscernable, tout en recourant à une perte de localisation pour détecter les filigranes malgré les perturbations. Ces approches démontrent que le filigranage invisible permet d’allier robustesse et préservation de la qualité, à condition d’avoir accès au modèle IA pour l’intégration du filigrane.

L’environnement réglementaire du filigranage du contenu IA a évolué rapidement, plusieurs juridictions ayant mis en place ou proposé des obligations de filigranage. L’AI Act de l’UE, adopté officiellement en mars 2024, constitue le cadre réglementaire le plus complet, imposant aux fournisseurs de systèmes IA de marquer leur production comme générée par IA. Cette réglementation concerne tous les systèmes IA génératifs déployés dans l’Union européenne et établit une obligation légale de conformité au filigranage. L’AI Transparency Act (SB 942) de Californie, applicable au 1er janvier 2026, impose aux fournisseurs concernés de proposer gratuitement au public des outils de détection de contenu IA, ce qui revient à exiger le filigranage ou des mécanismes d’authentification équivalents. Le National Defense Authorization Act (NDAA) des États-Unis pour l’exercice 2024 prévoit une compétition dotée de prix pour évaluer les technologies de filigranage et demande au Département de la Défense d’étudier et de piloter l’application de « normes techniques industrielles ouvertes » pour intégrer les informations de provenance dans les métadonnées. Le décret de la Maison Blanche sur l’IA charge le Département du Commerce d’identifier et développer des standards pour l’étiquetage du contenu généré par IA. Ces initiatives témoignent d’un consensus croissant sur le fait que le filigranage IA est essentiel à la transparence, la responsabilité et la protection des consommateurs. Cependant, la mise en œuvre reste complexe, notamment pour les modèles open-source, la coordination internationale et la faisabilité technique de standards universels de filigranage.

En dépit de réels progrès techniques, le filigranage IA présente d’importantes limites qui restreignent son efficacité réelle. La suppression du filigrane reste possible via plusieurs techniques d’évasion : paraphrase de texte, recadrage ou filtrage d’images, traduction dans d’autres langues, ou perturbations adversariales. Des recherches de l’Université Duke ont montré des attaques de type preuve de concept contre les détecteurs de filigranage fondés sur l’apprentissage automatique, prouvant que même les approches avancées restent vulnérables face à des adversaires déterminés. Le problème de non-universalité est une autre limite clé : les détecteurs sont spécifiques à chaque modèle, obligeant les utilisateurs à solliciter chaque service de détection IA pour vérifier l’origine d’un contenu. Sans registre centralisé ni protocoles standardisés, la vérification du caractère généré par IA reste un processus inefficace et ad hoc. Les taux de faux positifs lors de la détection, notamment pour le texte, posent problème ; les algorithmes peuvent signaler à tort un contenu humain comme généré par IA ou manquer un filigrane après modifications mineures. La compatibilité avec les modèles open-source soulève des enjeux de gouvernance, car le filigrane peut être désactivé en supprimant le code téléchargé. La dégradation de la qualité survient lorsque les algorithmes de filigranage contraignent artificiellement la sortie du modèle, réduisant potentiellement la qualité ou la flexibilité pour les tâches factuelles ou à génération contrainte. Les implications sur la vie privée sont également à considérer, notamment si les filigranes contiennent des informations identifiantes sur l’utilisateur. Enfin, la confiance de détection chute significativement sur les contenus courts ou fortement modifiés, limitant l’utilité du filigranage dans certains cas d’usage.

L’avenir du filigranage IA dépendra de l’innovation technique continue, de l’harmonisation réglementaire et de la mise en place d’une infrastructure de confiance pour la détection et la vérification des filigranes. Les chercheurs explorent des filigranes détectables publiquement tout en conservant leur robustesse, permettant une vérification décentralisée sans tiers de confiance. Les efforts de standardisation via des organismes comme l’ICANN ou des consortiums industriels pourraient instaurer des protocoles universels, réduisant la fragmentation et facilitant la détection inter-plateformes. L’intégration avec les standards de provenance du contenu tels que C2PA pourrait permettre des approches d’authentification en couches combinant filigrane et traçabilité par métadonnées. Le développement de filigranes résistants à la traduction et à la paraphrase est un axe de recherche actif, avec des applications potentielles pour l’authentification multilingue. Les systèmes de vérification basés sur la blockchain pourraient fournir un historique immuable des détections et de la provenance, renforçant la confiance dans les résultats. À mesure que les capacités de l’IA générative progressent, les techniques de filigranage devront évoluer pour rester efficaces face à des tentatives d’évasion toujours plus sophistiquées. La dynamique réglementaire impulsée par l’AI Act de l’UE et la législation californienne devrait entraîner une adoption mondiale de standards, créant des incitations de marché pour des solutions robustes. Cependant, il faut garder à l’esprit que le filigranage gérera principalement le contenu généré par les modèles commerciaux populaires, tout en restant limité dans les scénarios critiques exigeant une détection immédiate. L’intégration des plateformes de surveillance du contenu IA comme AmICited avec l’infrastructure de filigranage permettra aux organisations de suivre l’attribution de leur marque sur les systèmes IA, garantissant une reconnaissance adéquate lors de la citation de leur domaine. Les développements futurs devraient insister sur la collaboration humain-IA dans l’authentification, combinant détection automatisée et vérification humaine pour les cas sensibles en journalisme, droit et recherche académique.

Les filigranes visibles sont facilement détectables par l’humain, tels que des logos ou des mentions textuelles ajoutées à des images ou extraits audio, mais ils sont faciles à retirer ou à falsifier. Les filigranes invisibles intègrent des motifs subtils imperceptibles à l’œil nu mais détectables par des algorithmes spécialisés, ce qui les rend bien plus robustes face aux tentatives de manipulation ou de suppression. Les filigranes invisibles sont généralement préférés pour l’authentification des contenus IA car ils préservent la qualité tout en offrant une sécurité renforcée contre l’évasion.

Le filigranage statistique pour le texte fonctionne en influençant subtilement la sélection des jetons du modèle de langage lors de la génération. Le développeur du modèle 'biaisera les dés' à l’aide d’un schéma cryptographique, poussant le modèle à privilégier certains 'jetons verts' et à éviter les 'jetons rouges' selon le contexte précédent. Les algorithmes de détection analysent ensuite le texte pour identifier si les jetons privilégiés apparaissent avec une fréquence statistiquement inhabituelle, indiquant la présence d’un filigrane. Cette approche préserve la qualité textuelle tout en intégrant une empreinte détectable.

Les principaux défis incluent la facilité de suppression du filigrane via de simples modifications ou transformations, l’absence de détection universelle entre différents modèles d’IA, et la difficulté de filigraner le texte par rapport aux images ou à l’audio. De plus, le filigranage requiert la coopération des développeurs de modèles IA, est incompatible avec les modèles open-source, et peut dégrader la qualité du contenu s’il est mal implémenté. Les faux positifs et faux négatifs lors de la détection restent également des obstacles techniques importants.

L’AI Act de l’UE, adopté officiellement en mars 2024, impose aux fournisseurs de systèmes IA de marquer leurs productions comme contenu généré par IA. L’AI Transparency Act de Californie (SB 942), en vigueur au 1er janvier 2026, exige que les fournisseurs concernés mettent à disposition des outils de détection de contenu libres et accessibles au public. Le National Defense Authorization Act (NDAA) des États-Unis pour l’exercice 2024 intègre des dispositions pour l’évaluation des technologies de filigranage et le développement de normes industrielles sur la provenance du contenu.

Le filigranage intègre des motifs d’identification directement dans le contenu généré par l’IA, créant ainsi une empreinte numérique permanente qui persiste même en cas de copie ou modification du contenu. La provenance du contenu, comme la norme C2PA, stocke séparément dans les métadonnées les informations relatives à l’origine et à l’historique des modifications. Le filigranage est plus résistant à l’évasion mais nécessite la coopération du développeur du modèle, tandis que la provenance est plus facile à mettre en œuvre mais peut être supprimée en copiant le contenu sans ses métadonnées.

SynthID est une technologie de Google DeepMind qui filigrane et identifie le contenu généré par l’IA en intégrant des filigranes numériques directement dans les images, l’audio, le texte et la vidéo. Pour le texte, SynthID utilise un processeur de logits qui renforce la chaîne de génération du modèle pour encoder les informations de filigranage sans altérer significativement la qualité. La technologie emploie des modèles d’apprentissage automatique pour intégrer et détecter les filigranes, ce qui la rend résistante aux attaques courantes tout en préservant la fidélité du contenu.

Oui, des acteurs motivés peuvent supprimer ou contourner les filigranes par diverses techniques telles que la paraphrase du texte, le recadrage ou le filtrage des images, ou la traduction dans d’autres langues. Cependant, supprimer des filigranes sophistiqués requiert une expertise technique et la connaissance du schéma de filigranage. Les filigranes statistiques sont plus robustes que les approches traditionnelles, mais la recherche a démontré des attaques de type preuve de concept même contre des méthodes avancées, montrant qu’aucun filigranage n’est totalement infaillible.

Commencez à suivre comment les chatbots IA mentionnent votre marque sur ChatGPT, Perplexity et d'autres plateformes. Obtenez des informations exploitables pour améliorer votre présence IA.

Découvrez ce qu'est la génération de contenu par IA, son fonctionnement, ses avantages et défis, ainsi que les meilleures pratiques pour utiliser les outils d'I...

Découvrez si le contenu généré par l’IA est efficace pour la visibilité dans la recherche IA, y compris les meilleures pratiques de création de contenu, les str...

Découvrez ce qu'est la détection de contenu par l'IA, comment fonctionnent les outils de détection grâce à l'apprentissage automatique et au traitement du langa...