Risposte Meta LLM

Scopri cosa sono le Risposte Meta LLM e come ottimizzare i tuoi contenuti per la visibilità nelle risposte generate dall’IA su ChatGPT, Perplexity e Google AI O...

Scopri come creare meta risposte LLM che i sistemi AI citano. Scopri tecniche strutturali, strategie di densità delle risposte e formati di contenuto pronti per la citazione che aumentano la visibilità nei risultati di ricerca AI.

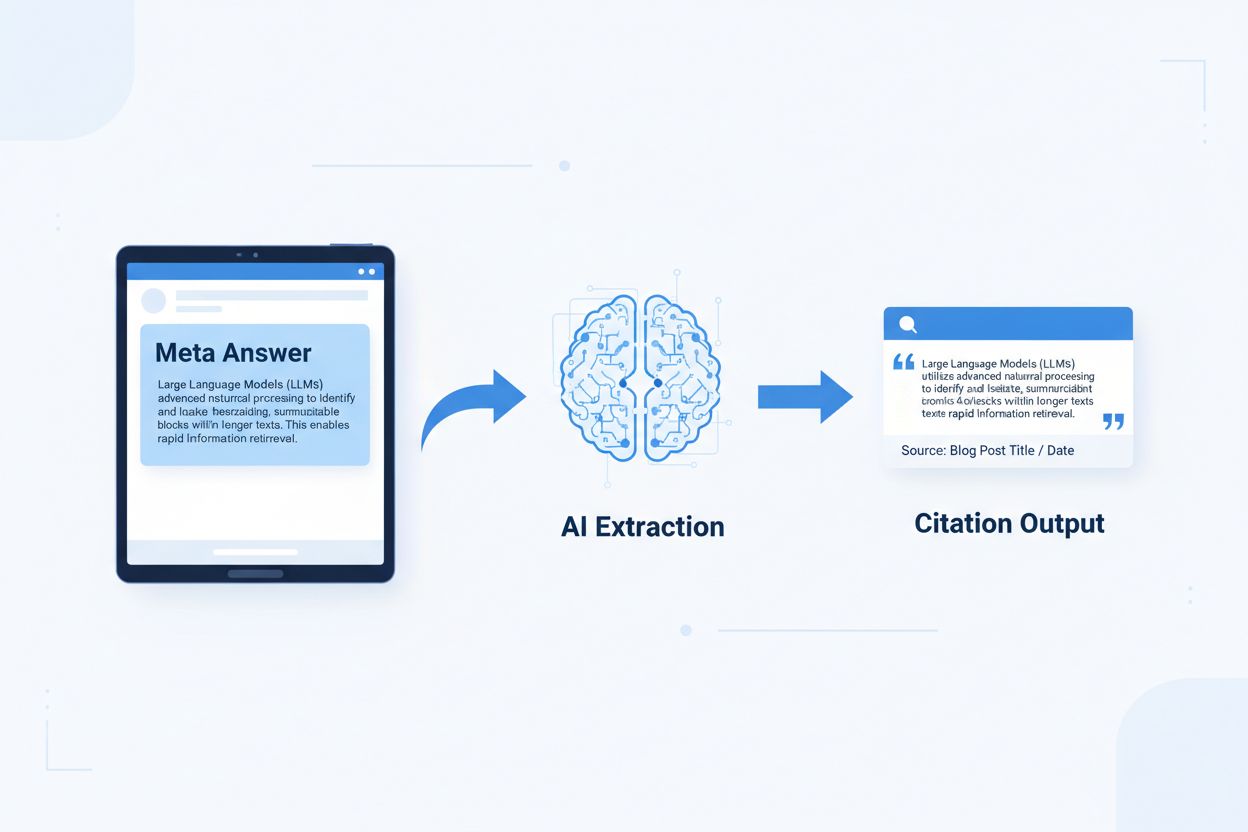

Le meta risposte LLM sono blocchi di contenuto autonomi e ottimizzati per l’AI, progettati per essere estratti e citati direttamente dai modelli linguistici senza bisogno di contesto aggiuntivo. A differenza dei contenuti web tradizionali che si basano su navigazione, intestazioni e contesto circostante per il significato, le meta risposte funzionano come approfondimenti indipendenti che mantengono completo valore semantico anche se isolate. La distinzione è importante perché i sistemi AI moderni non leggono i siti web come fanno gli umani: suddividono i contenuti in blocchi, valutano la pertinenza ed estraggono i passaggi per supportare le loro risposte. Quando l’AI trova meta risposte ben strutturate, può citarle con sicurezza perché le informazioni sono complete, verificabili e indipendenti dal contesto. Una ricerca di Onely indica che i contenuti ottimizzati per la citazione AI ricevono 3-5 volte più menzioni nelle risposte LLM rispetto ai contenuti formattati tradizionalmente, con impatto diretto sulla visibilità del brand nelle risposte AI. Questo cambiamento rappresenta una svolta fondamentale nelle prestazioni dei contenuti: invece di competere per il ranking nei motori di ricerca, le meta risposte competono per l’inclusione nelle risposte AI. Piattaforme di monitoraggio delle citazioni come AmICited.com ora tracciano queste menzioni AI come metrica di performance critica, rivelando che le organizzazioni con contenuti pronti per la citazione vedono aumenti misurabili nel traffico AI e nell’autorità del brand. Il collegamento è diretto: i contenuti strutturati come meta risposte vengono citati più spesso, aumentando la visibilità del brand nel panorama informativo orientato all’AI.

Il contenuto pronto per la citazione richiede elementi strutturali specifici che segnalano ai sistemi AI: “Questa è una risposta completa, citabile.” Le meta risposte più efficaci combinano frasi tematiche chiare, prove a supporto e conclusioni autonome in un’unica unità logica. Questi elementi lavorano insieme per creare ciò che i sistemi AI riconoscono come conoscenza estraibile—informazioni che possono stare in piedi da sole senza che i lettori visitino la pagina sorgente. L’approccio strutturale è fondamentalmente diverso dal contenuto web tradizionale, che spesso frammenta le informazioni su più pagine e si affida a collegamenti interni per creare contesto.

| Elemento Pronto per la Citazione | Perché i Sistemi AI lo Preferiscono |

|---|---|

| Frase tematica con affermazione | Segnala immediatamente il valore centrale; l’AI valuta la pertinenza nei primi 20 token |

| Prove a supporto (dati/esempi) | Fornisce basi verificabili; aumenta la fiducia nell’accuratezza della citazione |

| Metriche o statistiche specifiche | Le affermazioni quantificabili vengono citate più spesso; riduce l’ambiguità |

| Definizione o spiegazione | Garantisce comprensione autonoma; l’AI non necessita di contesto esterno |

| Conclusione operativa | Segnala completezza; indica ai sistemi AI che la risposta è finita |

| Attribuzione della fonte | Costruisce fiducia; i sistemi AI preferiscono citare contenuti con provenienza chiara |

Suggerimenti pratici per la massima estraibilità AI:

La dimensione ottimale del blocco per l’estrazione AI è tra 256-512 token, pari a circa 2-4 paragrafi ben strutturati. Questo intervallo rappresenta il punto di equilibrio in cui i sistemi AI possono estrarre informazioni significative senza perdere il contesto o includere materiale irrilevante. Blocchi inferiori a 256 token spesso mancano del contesto necessario per una citazione sicura, mentre blocchi oltre 512 token costringono i sistemi AI a riassumere o troncare, riducendo la citabilità diretta. La suddivisione per paragrafi—dove ogni paragrafo rappresenta un pensiero completo—supera la divisione arbitraria per token perché preserva la coerenza semantica e mantiene il flusso logico che i sistemi AI usano per valutare la pertinenza.

Una buona suddivisione preserva i confini semantici:

✓ BUONA: "Il contenuto pronto per la citazione richiede elementi strutturali specifici.

Le meta risposte più efficaci combinano frasi tematiche chiare,

prove a supporto e conclusioni autonome in un’unica

unità logica. Questi elementi lavorano insieme per creare ciò che i sistemi AI

riconoscono come conoscenza estraibile."

✗ CATTIVA: "Il contenuto pronto per la citazione richiede elementi strutturali specifici

che segnalano ai sistemi AI: 'Questa è una risposta completa, citabile.' Le

meta risposte più efficaci combinano frasi tematiche chiare, prove

a supporto e conclusioni autonome in un’unica unità logica.

Questi elementi lavorano insieme per creare ciò che i sistemi AI riconoscono come

conoscenza estraibile—informazioni che possono stare in piedi da sole senza che i

lettori visitino la pagina sorgente. L’approccio strutturale è fondamentalmente diverso

dal contenuto web tradizionale, che spesso frammenta le informazioni su più pagine e si affida

a collegamenti interni per creare contesto."

L’esempio buono mantiene la coerenza semantica e si ferma a una conclusione naturale. L’esempio cattivo combina più idee, costringendo i sistemi AI a troncare a metà pensiero o a includere contesto irrilevante. Le strategie di sovrapposizione—in cui la frase finale di un blocco anticipa il successivo—aiutano i sistemi AI a comprendere le relazioni tra i contenuti senza perdere estraibilità. Lista di controllo pratica per l’ottimizzazione della suddivisione: Ogni blocco risponde a una sola domanda? Può essere compreso senza leggere i paragrafi circostanti? Contiene 256-512 token? Termina a un confine semantico naturale?

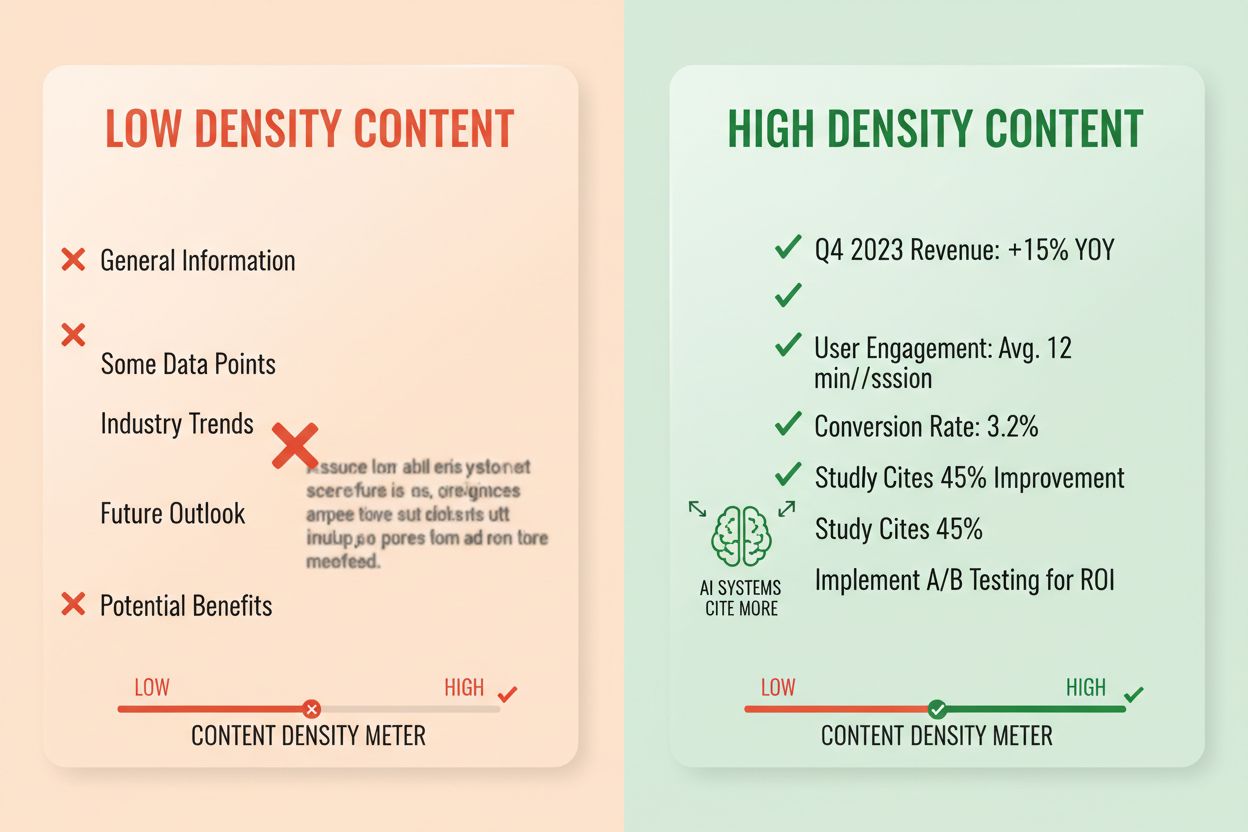

La densità della risposta misura il rapporto tra informazioni operative e numero totale di parole, e i contenuti ad alta densità ricevono 2-3 volte più citazioni AI rispetto alle alternative a bassa densità. Un paragrafo con densità di risposta dell’80% contiene soprattutto affermazioni, prove e approfondimenti operativi, mentre uno con densità del 40% include molti riempitivi, ripetizioni o costruzione di contesto che non supporta direttamente la risposta centrale. I sistemi AI valutano implicitamente la densità—sono più propensi a estrarre e citare passaggi in cui ogni frase contribuisce a rispondere alla domanda dell’utente. Gli elementi ad alta densità includono statistiche specifiche, istruzioni passo-passo, dati comparativi, definizioni e raccomandazioni operative. I modelli a bassa densità includono lunghe introduzioni, concetti ripetuti, domande retoriche e storytelling narrativo che non rafforza l’argomento principale.

Approccio di misurazione: Conta le frasi che rispondono direttamente alla domanda rispetto a quelle che forniscono solo contesto o transizione. Un paragrafo ad alta densità potrebbe essere: “Il contenuto pronto per la citazione riceve 3-5 volte più menzioni AI (statistica). Ciò avviene perché i sistemi AI estraggono risposte complete e autonome (spiegazione). Applica il formato risposta-prima e la suddivisione semantica per massimizzare la densità (azione).” Una versione a bassa densità potrebbe aggiungere: “Molte organizzazioni fanno fatica a ottenere visibilità AI. Il panorama digitale cambia rapidamente. La strategia di contenuto si è evoluta molto. Il contenuto pronto per la citazione sta diventando sempre più importante…” La seconda versione diluisce il messaggio centrale con contesto che non supporta direttamente la risposta.

Statistiche di impatto reale: I contenuti con densità di risposta superiore al 70% hanno una media di 4,2 citazioni al mese nelle uscite AI, contro 1,1 citazioni per contenuti sotto il 40% di densità. Le organizzazioni che hanno ristrutturato i contenuti per aumentare la densità hanno visto aumenti medi delle citazioni del 156% in 60 giorni. Esempio di contenuto ad alta densità: “Usa blocchi da 256-512 token per un’estrazione AI ottimale (affermazione). Questo intervallo preserva il contesto ed evita troncamenti (prova). Applica la suddivisione per paragrafi per mantenere la coerenza semantica (azione).” Versione a bassa densità: “La suddivisione è importante per i sistemi AI. Esistono diversi approcci per organizzare i contenuti. Alcuni preferiscono blocchi piccoli, altri più grandi. L’approccio giusto dipende dalle tue esigenze.” La versione ad alta densità offre orientamento operativo; quella a bassa densità riporta ovvietà senza specificità.

Strutture di contenuto specifiche segnalano ai sistemi AI che le informazioni sono organizzate per l’estrazione, aumentando notevolmente la probabilità di citazione. Le sezioni FAQ sono particolarmente efficaci perché abbinano esplicitamente domande e risposte, rendendo facilissimo per i sistemi AI identificare ed estrarre i passaggi rilevanti. Le tabelle comparative consentono ai sistemi AI di valutare rapidamente più opzioni e citare righe specifiche che rispondono alle domande dell’utente. Le istruzioni passo-passo forniscono confini semantici chiari e vengono spesso citate quando gli utenti chiedono “come si fa…”. Le liste di definizioni associano termini e spiegazioni, creando punti di estrazione naturali. I riquadri di riepilogo evidenziano i punti chiave e i listicle suddividono argomenti complessi in voci discrete e citabili.

Elementi strutturali che massimizzano l’estraibilità AI:

Esempi pratici: Una sezione FAQ che chiede “Cos’è la densità della risposta?” seguita da una definizione completa e una spiegazione diventa una fonte di citazione diretta. Una tabella comparativa “Elemento pronto per la citazione | Perché i sistemi AI lo preferiscono” (come quella nella sezione 2) viene citata quando gli utenti pongono domande comparative. Una guida passo-passo “Come implementare la suddivisione semantica” con passaggi numerati diventa contenuto istruttivo citabile. Queste strutture funzionano perché si allineano al modo in cui i sistemi AI analizzano ed estraggono informazioni—cercano coppie domanda-risposta chiare, comparazioni strutturate e passi discreti.

Il markup semantico HTML5 segnala la struttura dei contenuti ai sistemi AI, migliorando l’accuratezza dell’estrazione e la probabilità di citazione del 40-60%. L’uso della gerarchia corretta delle intestazioni (H1 per i temi principali, H2 per i sottotemi, H3 per i punti di supporto) aiuta i sistemi AI a comprendere le relazioni tra i contenuti e a identificare i confini di estrazione. Gli elementi semantici come <article>, <section> e <aside> forniscono ulteriore contesto sullo scopo del contenuto. I dati strutturati schema.org—particolarmente nel formato JSON-LD—dichiarano esplicitamente ai sistemi AI quali informazioni sono presenti, consentendo citazioni più sicure.

Esempio JSON-LD per contenuti FAQ:

{

"@context": "https://schema.org",

"@type": "FAQPage",

"mainEntity": [{

"@type": "Question",

"name": "Cos’è la densità della risposta?",

"acceptedAnswer": {

"@type": "Answer",

"text": "La densità della risposta misura il rapporto tra informazioni operative e numero totale di parole. I contenuti ad alta densità ricevono 2-3 volte più citazioni AI rispetto alle alternative a bassa densità."

}

}]

}

Esempio JSON-LD per i metadati di un articolo:

{

"@context": "https://schema.org",

"@type": "Article",

"headline": "Creare Meta Risposte LLM",

"author": {"@type": "Organization", "name": "AmICited"},

"datePublished": "2024-01-15",

"articleBody": "..."

}

I meta contenuti—inclusi meta descrizioni e tag Open Graph—aiutano i sistemi AI a comprendere lo scopo del contenuto prima dell’analisi. Miglioramenti in prestazioni e accessibilità (caricamento veloce, ottimizzazione mobile, testo alternativo adeguato) supportano indirettamente l’estraibilità AI garantendo che i contenuti siano completamente scansionabili e indicizzabili. Checklist tecnica: Il tuo HTML è semantico e ben strutturato? Hai implementato schema.org per il tuo tipo di contenuto? Le meta descrizioni riassumono accuratamente il contenuto? Il sito è ottimizzato per mobile e veloce? Le immagini hanno alt tag corretti?

Il monitoraggio delle citazioni è diventato essenziale per la misurazione delle prestazioni dei contenuti, ma la maggior parte delle organizzazioni non sa quante volte i propri contenuti appaiono nelle risposte AI. Il retrieval testing consiste nell’inviare le domande target ai principali LLM (ChatGPT, Claude, Gemini) e documentare le fonti citate nelle risposte. La content audit esamina sistematicamente i contenuti esistenti rispetto agli standard delle meta risposte, identificando lacune e opportunità di ottimizzazione. Le metriche di performance dovrebbero tracciare frequenza di citazione, contesto della citazione (come viene usato il contenuto) e crescita delle citazioni nel tempo. L’ottimizzazione iterativa prevede la sperimentazione di cambiamenti strutturali, la misurazione dell’impatto sulla frequenza delle citazioni e la scalabilità di ciò che funziona.

| Strumento di Monitoraggio | Funzione Principale | Ideale Per |

|---|---|---|

| AmICited.com | Monitoraggio completo delle citazioni AI su tutti i maggiori LLM | Visibilità totale sulle citazioni e analisi competitiva |

| Otterly.AI | Rilevamento contenuti AI e monitoraggio citazioni | Individuare dove compaiono i tuoi contenuti tra le uscite AI |

| Peec AI | Performance dei contenuti nei sistemi AI | Misurare frequenza e tendenze delle citazioni |

| ZipTie | Monitoraggio contenuti generati da AI | Tracciare menzioni del brand nelle risposte AI |

| PromptMonitor | Analisi output LLM | Comprendere come i sistemi AI utilizzano i tuoi contenuti |

AmICited.com spicca come soluzione migliore perché fornisce monitoraggio in tempo reale su ChatGPT, Claude, Gemini e altri principali LLM, offrendo benchmarking competitivo e dettaglio sul contesto delle citazioni. La piattaforma rivela non solo se i tuoi contenuti sono citati, ma come vengono usati—se sono citati direttamente, parafrasati o usati come prove di supporto. Approccio di misurazione: Stabilisci la frequenza base di citazione per i tuoi 20 contenuti principali. Implementa ottimizzazioni “ready for citation” su 5-10 contenuti. Monitora le variazioni delle citazioni in 30-60 giorni. Scala i pattern di successo sugli altri contenuti. Traccia metriche come frequenza di citazione, tasso di crescita delle citazioni, contesto e quota di citazione rispetto ai competitor.

Errore 1: Nascondere la risposta nel contesto. Molti creator iniziano con informazioni di background, contesto storico o problemi prima della risposta effettiva. I sistemi AI valutano la pertinenza nei primi 50-100 token; se la risposta non è presente, passano alla fonte successiva. Problema: Chi chiede “Cos’è la densità della risposta?” trova un paragrafo che inizia con “La strategia di contenuto si è evoluta molto…” invece della definizione. Soluzione: Usa il formato risposta-prima—inizia con l’approfondimento chiave, poi aggiungi il contesto.

Errore 2: Risposte che richiedono contesto esterno. I contenuti che fanno riferimento a “la sezione precedente” o “come detto prima” non possono essere estratti autonomamente. Problema: Un paragrafo che dice “Seguendo l’approccio discusso, implementa questi passaggi…” fallisce perché il metodo citato non è incluso nel blocco estratto. Soluzione: Ogni risposta deve essere autonoma; includi il contesto necessario nello stesso blocco, anche a costo di qualche ripetizione.

Errore 3: Mischiare più risposte in un solo blocco. Paragrafi che trattano più domande costringono i sistemi AI a troncare o includere informazioni non rilevanti. Problema: Un paragrafo da 600 parole che tratta “Cos’è la densità della risposta?”, “Come misurarla?” e “Perché è importante?” è troppo grande per un’estrazione sicura. Soluzione: Crea blocchi separati e focalizzati per ogni domanda o concetto distinto.

Errore 4: Linguaggio vago invece di metriche specifiche. Espressioni come “molti”, “alcuni”, “spesso”, “tipicamente” riducono la fiducia nella citazione perché sono imprecise. Problema: “Molte organizzazioni vedono miglioramenti” è meno citabile di “Le organizzazioni che hanno ristrutturato i contenuti hanno visto aumenti delle citazioni del 156%.” Soluzione: Sostituisci i qualificatori con dati specifici; se non disponibili, usa intervalli (“40-60%”) invece di termini vaghi.

Errore 5: Trascurare il markup strutturale. Contenuti senza struttura HTML, intestazioni o schema.org sono più difficili da interpretare ed estrarre per i sistemi AI. Problema: Un paragrafo senza intestazione, markup semantico né schema viene trattato come testo generico invece che come risposta distinta. Soluzione: Usa HTML5 semantico, gerarchia di intestazioni e aggiungi schema.org per il tuo tipo di contenuto.

Errore 6: Risposte troppo brevi o troppo lunghe. Blocchi sotto i 150 token mancano di contesto; blocchi oltre 700 token vengono troncati. Problema: Una risposta da 100 parole manca di prove a supporto; una da 1000 parole viene suddivisa in più estrazioni. Soluzione: Punta a 256-512 token (2-4 paragrafi); includi affermazione, prova e conclusione in questo intervallo.

La coerenza degli enti—usare la stessa terminologia per lo stesso concetto in tutto il contenuto—aumenta la probabilità di citazione AI segnalando conoscenza autorevole. Se definisci “densità della risposta” in una sezione, usa sempre quel termine invece di passare a “densità informativa” o “densità dei contenuti”. I sistemi AI riconoscono la coerenza degli enti come segnale di competenza e sono più propensi a citare contenuti dove la terminologia è precisa e coerente. Vale per nomi di prodotti, metodologie, termini tecnici—la coerenza rafforza la fiducia nella citazione.

Menzioni di terze parti e ricerche originali aumentano drasticamente la frequenza di citazione. I contenuti che citano fonti autorevoli (con attribuzione corretta) segnalano credibilità, mentre ricerche originali o dati proprietari rendono i tuoi contenuti unici e citabili. Includere statistiche delle proprie ricerche o case study dei propri clienti è percepito dall’AI come approfondimento originale non reperibile altrove. Le organizzazioni che pubblicano ricerche originali vedono tassi di citazione 3-4 volte superiori rispetto a chi sintetizza solo informazioni altrui. Strategia: Conduci ricerche originali nel tuo settore, pubblica i risultati con metodologia dettagliata e cita questi risultati nelle tue meta risposte.

I segnali di freschezza—date di pubblicazione, di aggiornamento, riferimenti a eventi recenti—aiutano i sistemi AI a comprendere la novità dei contenuti. I contenuti aggiornati negli ultimi 30 giorni hanno priorità di citazione superiore rispetto a quelli datati, specie per temi dove le informazioni cambiano spesso. Includi la data di pubblicazione nel markup schema.org e aggiorna il timestamp quando modifichi il contenuto. Strategia: Stabilisci una routine di aggiornamento; aggiorna i contenuti con migliori performance ogni 30-60 giorni con nuove statistiche, esempi o spiegazioni ampliate.

I segnali E-E-A-T (Esperienza, Competenza, Autorevolezza, Affidabilità) influenzano le decisioni di citazione AI. Contenuti scritti da esperti riconosciuti, pubblicati su domini autorevoli e supportati da credenziali ricevono priorità di citazione. Includi bio autore con credenziali pertinenti, pubblica su domini autorevoli e ottieni backlink da fonti di settore. Strategia: Scegli autori esperti, inserisci le credenziali nelle bio, cerca backlink da pubblicazioni riconosciute nel settore.

La densità del brand generativo—il rapporto tra approfondimenti di brand e informazioni generiche—determina se l’AI cita te o un concorrente. I contenuti che includono framework proprietari, metodologie uniche o approcci di brand sono più citabili perché differenziati. I contenuti generici sulle “best practice” vengono citati meno di quelli su “Il Framework di Ottimizzazione Citazioni di AmICited” perché la variante brandizzata è unica e tracciabile. Le organizzazioni con alta densità di brand generativo ricevono 2-3 volte più citazioni rispetto a chi pubblica contenuti generici. Strategia: Sviluppa framework, metodologie o terminologia proprietari; usali coerentemente nei tuoi contenuti; rendili la base delle tue meta risposte.

Le meta risposte LLM sono progettate specificamente per l’estrazione e la citazione AI, mentre i featured snippet ottimizzano per la visualizzazione nei risultati di ricerca di Google. Le meta risposte privilegiano la completezza autonoma e la coerenza semantica, mentre i featured snippet puntano sulla brevità e sulla corrispondenza delle parole chiave. Entrambi possono coesistere nei tuoi contenuti, ma le meta risposte richiedono un’ottimizzazione strutturale diversa.

La lunghezza ottimale è di 256-512 token, equivalenti a circa 2-4 paragrafi ben strutturati o 200-400 parole. Questo intervallo preserva il contesto sufficiente per un’estrazione AI sicura, evitando troncamenti. Risposte più brevi mancano di contesto; risposte più lunghe costringono i sistemi AI a riassumere o suddividere in più estrazioni.

Sì, ma è necessario ristrutturarli. Analizza i contenuti esistenti per il formato risposta-prima, la coerenza semantica e la completezza autonoma. La maggior parte dei contenuti può essere adattata spostando gli approfondimenti chiave all’inizio, eliminando i riferimenti incrociati e assicurando che ogni sezione risponda a una domanda completa senza bisogno di contesto esterno.

Aggiorna i contenuti con le migliori prestazioni ogni 30-60 giorni con nuove statistiche, esempi recenti o spiegazioni ampliate. I sistemi AI danno priorità ai contenuti aggiornati negli ultimi 30 giorni, in particolare per argomenti in cui le informazioni cambiano spesso. Includi date di pubblicazione e timestamp di aggiornamento nel tuo markup schema.org.

La densità della risposta è direttamente correlata alla frequenza di citazione. I contenuti con densità di risposta superiore al 70% hanno una media di 4,2 citazioni al mese nelle uscite AI, rispetto a 1,1 citazioni per contenuti sotto il 40% di densità. I contenuti ad alta densità offrono informazioni operative senza riempitivi, diventando più preziosi da citare per i sistemi AI.

Usa piattaforme di monitoraggio delle citazioni come AmICited.com, che traccia le citazioni su ChatGPT, Claude, Gemini e altri principali LLM. Effettua test manuali inviando le tue domande target ai sistemi AI e documenta quali fonti vengono citate. Misura la frequenza di citazione di base, implementa ottimizzazioni e monitora i cambiamenti in 30-60 giorni.

La struttura principale delle meta risposte rimane coerente tra le piattaforme, ma puoi ottimizzare per preferenze specifiche. ChatGPT predilige contenuti completi e ben referenziati. Perplexity enfatizza informazioni recenti e citazioni chiare. Google AI Overviews privilegia dati strutturati e segnali E-E-A-T. Prova variazioni e monitora le prestazioni delle citazioni sulle varie piattaforme.

AmICited fornisce monitoraggio in tempo reale delle citazioni dei tuoi contenuti su tutte le principali piattaforme AI, mostrando esattamente dove appaiono le tue meta risposte, come vengono utilizzate e la quota di citazioni rispetto ai concorrenti. La piattaforma rivela il contesto della citazione—se i contenuti sono citati direttamente, parafrasati o usati come prova di supporto—consentendo decisioni di ottimizzazione basate sui dati.

Scopri esattamente dove i tuoi contenuti vengono citati da ChatGPT, Perplexity, Google AI Overviews e altri sistemi AI. Traccia le tendenze delle citazioni, monitora i concorrenti e ottimizza la tua strategia di contenuto con AmICited.

Scopri cosa sono le Risposte Meta LLM e come ottimizzare i tuoi contenuti per la visibilità nelle risposte generate dall’IA su ChatGPT, Perplexity e Google AI O...

Scopri come individuare e mirare i siti fonte LLM per backlink strategici. Scopri quali piattaforme AI citano più spesso le fonti e ottimizza la tua strategia d...

Scopri cos'è il LLM Seeding e come posizionare strategicamente i contenuti su piattaforme ad alta autorità per influenzare l'addestramento delle IA e farti cita...