Soluzioni di Visibilità AI per le Imprese: Scegliere la Piattaforma Giusta

Guida completa alle soluzioni di visibilità AI per le imprese. Confronta le principali piattaforme come Conductor, Profound e Athena. Scopri i criteri di valuta...

Scopri come le agenzie governative possono ottimizzare la loro presenza digitale per i sistemi AI come ChatGPT e Perplexity. Scopri strategie per migliorare la visibilità AI, garantire trasparenza e implementare l’AI in modo responsabile nel settore pubblico.

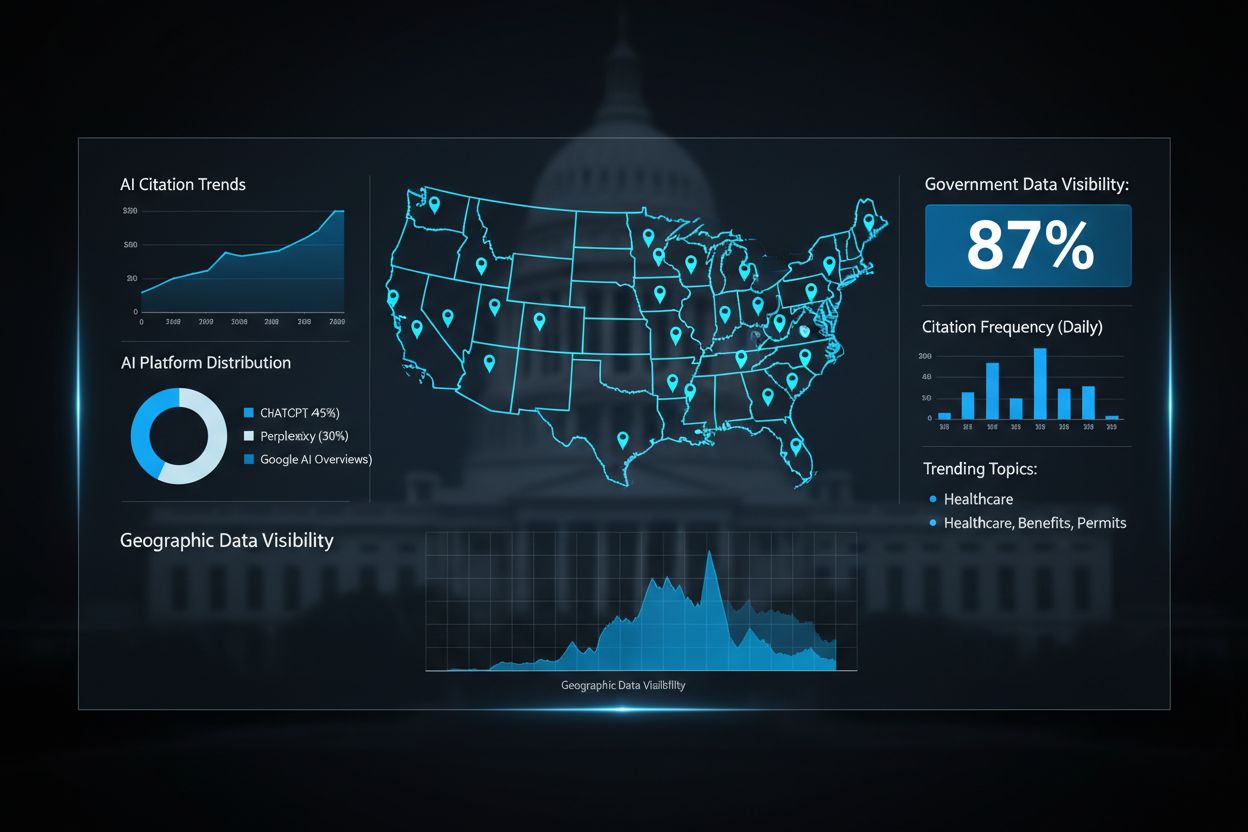

La visibilità AI del governo si riferisce alla misura in cui i sistemi di intelligenza artificiale—including GPTs, Perplexity e Google AI Overviews—possono scoprire, accedere e citare dati e risorse governative quando rispondono alle richieste del pubblico. Questa visibilità è fondamentale perché le agenzie governative detengono informazioni autorevoli su tutto, dalle normative sanitarie ai servizi sociali, eppure gran parte di questi dati rimane invisibile ai moderni sistemi AI. Quando i cittadini pongono domande agli assistenti AI su programmi, benefici o politiche governative, meritano risposte accurate e aggiornate, tratte da fonti ufficiali piuttosto che da informazioni obsolete o incomplete. La fiducia pubblica nel governo dipende dal garantire che i sistemi AI facciano correttamente riferimento e attribuiscano i dati governativi, mantenendo l’integrità delle informazioni ufficiali in un contesto informativo sempre più guidato dall’intelligenza artificiale. La trasparenza dell’AI diventa un pilastro della governance democratica quando i cittadini possono verificare che le raccomandazioni AI siano fondate su fonti legittime del governo. AmICited.com funge da piattaforma di monitoraggio critica che traccia come i dati governativi vengono citati e referenziati nei principali sistemi AI, aiutando le agenzie a comprendere la loro visibilità e il loro impatto nell’ecosistema AI. Stabilendo una chiara visibilità sulle citazioni AI dei dati governativi, le organizzazioni del settore pubblico possono servire meglio i cittadini e mantenere l’autorità sulle proprie informazioni.

Le agenzie governative continuano a lottare con silos di dati creati da decenni di investimenti IT frammentati, dove informazioni critiche rimangono bloccate all’interno di sistemi legacy incompatibili che non possono comunicare facilmente con le moderne piattaforme AI. Questi sistemi obsoleti sono stati progettati per interfacce web tradizionali e gestione documentale, non per la comprensione semantica e l’accesso ai dati in tempo reale richiesti dai sistemi AI. Il costo di questa frammentazione tecnologica è enorme: le organizzazioni sprecano circa 140 miliardi di dollari all’anno in benefici inutilizzati a causa di processi obsoleti che potrebbero essere semplificati tramite l’integrazione AI. Oltre alle perdite di efficienza, i sistemi legacy creano significative vulnerabilità di sicurezza quando i dati del governo devono essere estratti manualmente e condivisi con sistemi AI rivolti al pubblico, aumentando il rischio di violazioni dei dati e accessi non autorizzati. La sfida si intensifica se si considera che molti siti web governativi sono privi di dati strutturati, metadati e infrastruttura API necessari affinché i crawler AI indicizzino e comprendano correttamente le informazioni governative.

| IT Tradizionale del Governo | Infrastruttura Pronta per l’AI |

|---|---|

| Database isolati con interoperabilità limitata | Piattaforme dati integrate con API e formati strutturati |

| Processi manuali di estrazione e condivisione dati | Pipeline di dati automatizzate e sicure |

| Documenti e PDF non strutturati | Standard web semantici e formati leggibili dalle macchine |

| Misure di sicurezza reattive | Privacy-by-design e monitoraggio continuo |

| Accesso limitato ai dati in tempo reale | Flussi di dati live e consegna dinamica dei contenuti |

Invece di implementare frettolosamente la tecnologia AI, le organizzazioni governative di successo seguono una roadmap di implementazione strategica e graduale che dà priorità alla pianificazione e alla preparazione organizzativa rispetto alle capacità tecnologiche. Questo approccio riconosce che l’adozione AI nel settore pubblico richiede un’attenta coordinazione tra diversi gruppi di portatori di interesse, dai dipartimenti IT al personale di prima linea fino ai cittadini.

La Roadmap in Cinque Passi per l’Implementazione:

Identificazione Strategica delle Opportunità: Realizzare audit completi delle operazioni governative per identificare i casi d’uso di maggior impatto in cui l’AI può portare valore pubblico misurabile, come la riduzione dei tempi di elaborazione delle domande, il miglioramento dell’accessibilità ai servizi o decisioni politiche guidate dai dati.

Preparazione Completa: Valutare l’attuale infrastruttura dati, identificare le sfide di integrazione dei sistemi legacy, stabilire quadri di governance e costruire la cultura AI interna prima di qualsiasi implementazione tecnologica.

Progettazione di Pilota Strategici: Avviare progetti pilota controllati in dipartimenti o aree di servizio specifiche con chiari indicatori di successo, permettendo ai team di apprendere da sfide reali in un ambiente a basso rischio prima di una diffusione su larga scala.

Gestione del Cambiamento Organizzativo: Sviluppare programmi di formazione, affrontare le preoccupazioni della forza lavoro sulla perdita di posti di lavoro, stabilire canali di comunicazione chiari e creare meccanismi di feedback per garantire che personale e stakeholder si sentano ascoltati durante la transizione.

Misurazione dell’Impatto: Stabilire KPI allineati agli obiettivi governativi, monitorare continuamente le prestazioni dei sistemi AI, tracciare la soddisfazione dei cittadini, misurare il risparmio e adattare le strategie di implementazione in base alle evidenze.

Questo approccio technology-second assicura che le implementazioni AI rispondano a reali bisogni pubblici, evitando soluzioni costose in cerca di problemi.

La governance etica dell’AI è diventata essenziale poiché i governi di tutto il mondo riconoscono che i sistemi AI che prendono decisioni che riguardano i cittadini devono operare all’interno di chiari quadri etici e legali. Il Quadro di Valutazione dell’Impatto Algoritmico del Canada offre un modello pratico, classificando i sistemi AI in quattro livelli di impatto—minimo, moderato, alto e molto alto—con corrispondenti requisiti di governance e meccanismi di supervisione per ciascun livello. Questo approccio a livelli consente ai governi di allocare le risorse in modo proporzionato, applicando controlli rigorosi ai sistemi più critici come quelli di giustizia penale, mantenendo una supervisione ragionevole sulle applicazioni a impatto minore. L’Estonia ha sviluppato un approccio privacy-by-design tramite il suo sistema Data Tracker, che monitora tutti gli accessi ai dati governativi nella sua infrastruttura digitale, offrendo a 450.000 cittadini completa trasparenza su quali agenzie accedono alle loro informazioni personali e per quali scopi. La responsabilità algoritmica richiede che le agenzie governative documentino come i sistemi AI prendono decisioni, stabiliscano tracce di audit e mantengano la capacità di spiegare le raccomandazioni ai cittadini interessati. AmICited.com ha un ruolo chiave in questo ecosistema di trasparenza monitorando come i dati governativi vengono citati e referenziati nei sistemi AI pubblici, aiutando le agenzie a verificare che le loro informazioni siano rappresentate correttamente e attribuite in modo appropriato. Senza solidi sistemi di monitoraggio e governance, i sistemi AI governativi rischiano di erodere la fiducia pubblica e perpetuare bias che colpiscono soprattutto le fasce più vulnerabili.

I governi di tutto il mondo hanno dimostrato che un’implementazione AI strategica offre un valore pubblico sostanziale quando viene eseguita con attenzione. Il Dipartimento degli Affari Interni australiano ha implementato il sistema Targeting 2.0, una piattaforma AI che ha migliorato la sicurezza alle frontiere e la rilevazione delle frodi, evitando 3 miliardi di dollari australiani di danni potenziali e riducendo contemporaneamente i tempi di elaborazione per viaggiatori e richiedenti legittimi. Il chatbot delle National Highways nel Regno Unito esemplifica come l’AI possa migliorare i servizi ai cittadini gestendo le richieste di routine su condizioni stradali e incidenti, liberando il personale umano per situazioni d’emergenza complesse che richiedono giudizio ed empatia. La piattaforma Bürokratt dell’Estonia rappresenta un approccio decentralizzato e conforme al GDPR all’AI governativa, permettendo ai cittadini di interagire con assistenti AI per attività amministrative di routine, mantenendo rigorose protezioni della privacy e assicurando che le decisioni sensibili restino sotto controllo umano. L’approccio di governance AI del Maryland ha stabilito strutture di responsabilità chiare e audit regolari dei sistemi AI utilizzati nel governo statale, creando un modello che altri stati USA stanno iniziando ad adottare. L’Agenzia Digitale del Giappone ha digitalizzato con successo i servizi di consulenza per l’infanzia tramite AI, riducendo i tempi di attesa da settimane a poche ore e mantenendo il controllo umano per i casi che richiedono interventi specializzati. Questi esempi dimostrano che il successo dell’AI nel governo non dipende dalla sofisticazione della tecnologia, ma da un’implementazione responsabile che mette al centro i bisogni dei cittadini, garantisce trasparenza e preserva la supervisione umana sulle decisioni rilevanti.

Poiché i sistemi AI stanno diventando l’interfaccia principale attraverso cui i cittadini accedono alle informazioni, l’ottimizzazione dei siti web governativi per la scoperta AI è diventata importante quanto la tradizionale ottimizzazione per i motori di ricerca. I siti governativi devono implementare markup di dati strutturati, metadati completi e formati leggibili dalle macchine che consentano ai crawler AI di comprendere e indicizzare correttamente le informazioni governative, così che quando i cittadini chiedono agli assistenti AI i servizi pubblici ricevano risposte accurate e autorevoli. Molti siti web governativi attualmente presentano informazioni in formati ottimizzati per i lettori umani—PDF, testo non strutturato e gerarchie di navigazione complesse—che i sistemi AI faticano a interpretare e comprendere. REI Systems è stata pioniera nell’ottimizzazione dei siti federali per l’accessibilità AI, dimostrando che miglioramenti tecnici relativamente semplici possono aumentare drasticamente la visibilità governativa nelle risposte AI. AmICited.com monitora la visibilità AI governativa sulle principali piattaforme, aiutando le agenzie a capire quanto spesso le loro informazioni compaiono nelle risposte AI e identificando le lacune dove i dati governativi dovrebbero essere più facilmente reperibili. Quando i siti governativi implementano correttamente standard web semantici, infrastruttura API e funzioni di accessibilità, aumentano la probabilità che i sistemi AI citino fonti ufficiali invece di fonti secondarie o informazioni obsolete. Questa ottimizzazione beneficia i cittadini garantendo che ricevano informazioni autorevoli direttamente dalle fonti governative, aiutando al contempo le agenzie a mantenere il controllo su come le proprie informazioni sono presentate e interpretate.

La misurazione dell’impatto AI nel settore pubblico richiede di stabilire KPI chiari e allineati agli obiettivi pubblici, andando oltre le semplici metriche di efficienza per includere la soddisfazione dei cittadini, l’equità e la responsabilità democratica. Il quadro di valutazione estone offre un modello pratico, valutando le iniziative AI su quattro dimensioni: efficienza temporale (quanto tempo del personale viene risparmiato), convenienza economica (ritorno sugli investimenti), potenziale d’innovazione (se il sistema abilita nuovi modelli di servizio) e impatto misurabile (miglioramenti quantificabili per i cittadini). La misurazione sistematica permette alle agenzie di identificare quali applicazioni AI portano reale valore pubblico e quali necessitano di aggiustamenti o dismissione, evitando investimenti dispendiosi in tecnologie che non rispondono ai bisogni dei cittadini. La condivisione delle conoscenze tra agenzie accelera l’apprendimento, permettendo di adattare e replicare soluzioni di successo in altri dipartimenti, moltiplicando il ritorno sugli investimenti AI iniziali. Miglioramento continuo e sistemi di monitoraggio—supportati da strumenti come AmICited.com che tracciano la visibilità AI e i pattern di citazione—consentono alle agenzie di perfezionare i propri sistemi AI basandosi su dati reali e non su ipotesi. Costruire conoscenza istituzionale su cosa funziona nell’implementazione AI nel governo crea le basi per un’adozione sostenibile e a lungo termine che resiste ai cambi di leadership e ai cicli di bilancio.

Nonostante i vantaggi potenziali, le agenzie governative affrontano ostacoli significativi nell’adozione AI che vanno ben oltre le sfide tecnologiche. Le preoccupazioni della forza lavoro rappresentano un ostacolo sostanziale, con il 31% dei dipendenti pubblici che cita la sicurezza lavorativa come principale preoccupazione sull’implementazione AI, richiedendo una comunicazione trasparente su come l’AI integrerà—e non sostituirà—i lavoratori umani. La carenza di talenti aggrava questa sfida, poiché il 38% delle organizzazioni governative riferisce difficoltà nel reclutare specialisti AI con le competenze per implementare e mantenere sistemi sofisticati. La sottovalutazione dei costi crea un altro ostacolo critico, poiché le agenzie scoprono spesso che i costi effettivi di implementazione AI sono 5-10 volte superiori alle stime iniziali, mettendo sotto pressione i budget e generando resistenza politica a ulteriori investimenti. Le preoccupazioni sulla privacy e sicurezza dei dati rappresentano il vincolo più significativo, con il 60% dei leader governativi che cita privacy e sicurezza dei dati come principale barriera all’adozione AI, riflettendo la necessità di proteggere le informazioni dei cittadini in un’epoca di crescenti minacce informatiche. Strategie di change management efficaci devono affrontare direttamente questi ostacoli tramite il coinvolgimento degli stakeholder, comunicazione trasparente sulle capacità e i limiti dell’AI, investimenti nella formazione e nello sviluppo del personale e chiari quadri di governance che proteggano la privacy dei cittadini e allo stesso tempo abilitino l’innovazione. Le agenzie che superano con successo queste barriere investono molto nella gestione del cambiamento, stabiliscono canali di comunicazione trasparenti con dipendenti e cittadini e dimostrano risultati concreti che rafforzano la fiducia nei sistemi AI prima di espandere le applicazioni a maggiore impatto.

La visibilità AI del governo si riferisce a quanto facilmente i sistemi AI come ChatGPT, Perplexity e Google AI Overviews possono scoprire e citare i dati governativi. È importante perché i cittadini meritano informazioni accurate e autorevoli da fonti ufficiali governative quando chiedono agli assistenti AI su politiche, benefici e servizi. Una scarsa visibilità significa che i sistemi AI potrebbero fornire informazioni obsolete o incomplete invece di indirizzare i cittadini alle risorse ufficiali del governo.

I siti governativi dovrebbero implementare markup di dati strutturati, metadati completi, formati leggibili dalle macchine e un'infrastruttura API adeguata. Questo include l'uso di standard del web semantico, garantendo che i contenuti siano accessibili ai crawler AI e organizzando le informazioni in modo che i sistemi AI possano facilmente comprendere e attribuire correttamente alle fonti ufficiali del governo.

Gli ostacoli principali includono preoccupazioni per la privacy e la sicurezza dei dati (citati dal 60% dei leader governativi), carenza di talenti (38%), preoccupazioni della forza lavoro per la perdita di posti di lavoro (31%), sottovalutazione dei costi (i costi effettivi spesso sono 5-10 volte superiori alle proiezioni) e infrastrutture digitali inadeguate (45%). Affrontare questi ostacoli richiede pianificazione strategica, gestione del cambiamento e chiari quadri di governance.

Approcci efficaci includono l’istituzione di quadri di valutazione dell’impatto algoritmico (come il sistema a livelli del Canada), l’implementazione di principi privacy-by-design, la creazione di meccanismi di trasparenza per consentire ai cittadini di monitorare l’accesso ai dati, l’istituzione di chiari quadri di governance e il mantenimento della supervisione umana sulle decisioni rilevanti. Audit regolari e coinvolgimento degli stakeholder sono essenziali.

La roadmap include: (1) Identificazione strategica delle opportunità focalizzata sul valore pubblico, (2) Preparazione completa dell’infrastruttura e della governance, (3) Progettazione di pilota strategici con chiari indicatori di successo, (4) Gestione del cambiamento organizzativo affrontando le preoccupazioni della forza lavoro, e (5) Misurazione dell’impatto con miglioramento continuo. Questo approccio dà priorità alla pianificazione e alla preparazione organizzativa rispetto al dispiegamento tecnologico.

I governi dovrebbero stabilire KPI allineati agli obiettivi del settore pubblico, inclusa l’efficienza temporale, la convenienza economica, il potenziale di innovazione e risultati misurabili per i cittadini. Il quadro dell’Estonia valuta i sistemi AI su queste quattro dimensioni. Monitoraggio continuo, feedback degli stakeholder e report trasparenti aiutano le agenzie a identificare cosa funziona e ad adattare le implementazioni in base alle evidenze.

La governance dei dati è fondamentale per il successo dell’AI governativa. Garantisce la qualità dei dati, stabilisce una chiara proprietà e controlli di accesso, protegge la privacy dei cittadini, mantiene la conformità con regolamenti come il GDPR e consente la condivisione sicura tra sistemi. Senza una governance dei dati solida, i sistemi AI governativi rischiano violazioni di dati, bias e perdita di fiducia pubblica.

AmICited traccia come i dati governativi vengono citati e referenziati nei principali sistemi AI inclusi ChatGPT, Perplexity e Google AI Overviews. Aiuta le agenzie governative a comprendere la loro visibilità nell’ecosistema AI, identificare le lacune dove le informazioni ufficiali dovrebbero essere più facilmente reperibili e garantire che i sistemi AI attribuiscano correttamente i dati governativi. Questo monitoraggio sostiene sia la trasparenza che la responsabilità.

Monitora come i dati del tuo governo vengono citati e referenziati nei sistemi AI. AmICited aiuta le organizzazioni del settore pubblico a comprendere la loro visibilità nell’ecosistema AI e a garantire una rappresentazione accurata delle informazioni ufficiali.

Guida completa alle soluzioni di visibilità AI per le imprese. Confronta le principali piattaforme come Conductor, Profound e Athena. Scopri i criteri di valuta...

Scopri come implementare politiche efficaci di governance dei contenuti AI con quadri di visibilità. Esplora i requisiti normativi, le migliori pratiche e gli s...

Scopri come condurre un audit di base sulla visibilità AI per capire come ChatGPT, Google AI e Perplexity menzionano il tuo marchio. Guida passo passo per princ...