Ricerca AI multimodale

Scopri come i sistemi di ricerca AI multimodale elaborano insieme testo, immagini, audio e video per offrire risultati più accurati e contestualmente rilevanti ...

Diventa esperto nell’ottimizzazione della ricerca AI multimodale. Scopri come ottimizzare immagini e query vocali per risultati di ricerca potenziati dall’AI, con strategie per GPT-4o, Gemini e LLM.

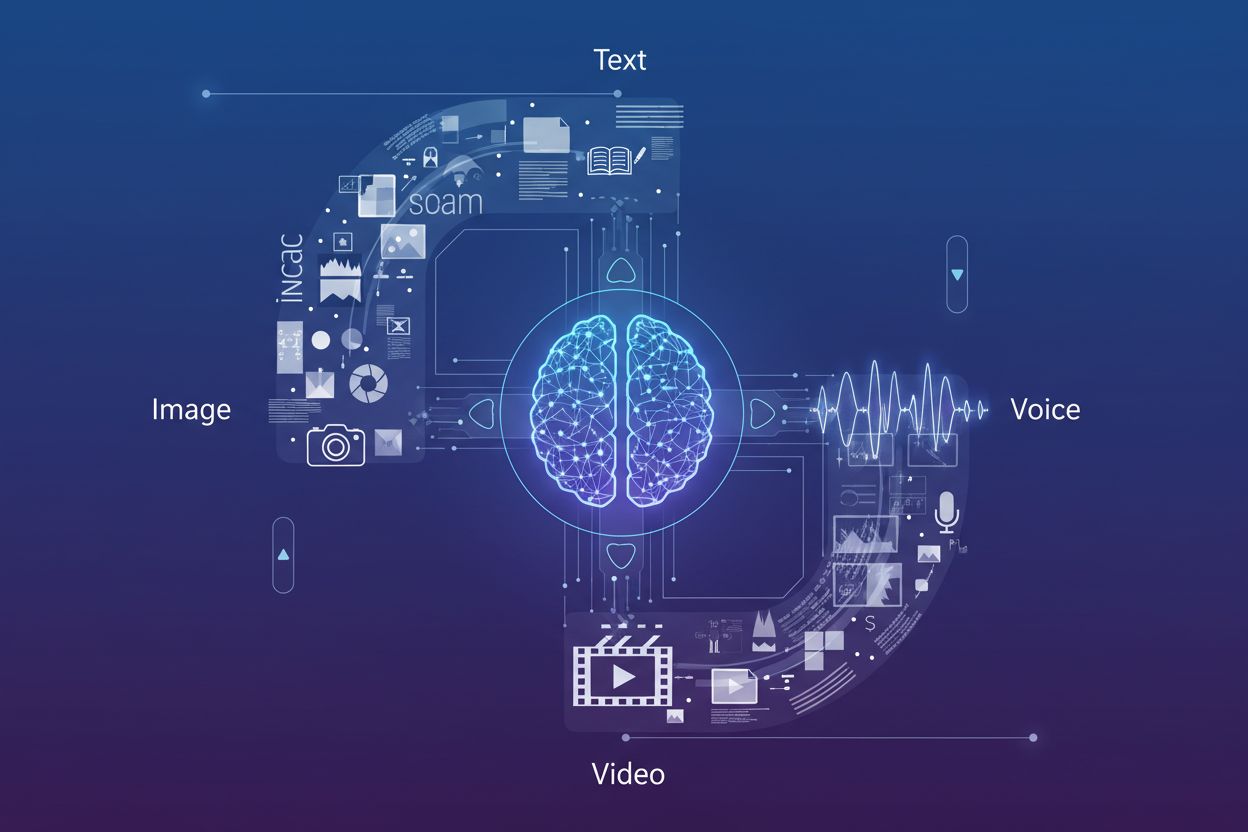

La ricerca AI multimodale rappresenta un cambiamento fondamentale nel modo in cui i motori di ricerca processano e comprendono le query degli utenti, integrando diversi tipi di dati—testo, immagini, voce e video—in un’esperienza di ricerca unificata. Invece di trattare ogni modalità come un canale separato, i sistemi di ricerca moderni sfruttano ora modelli AI multimodali in grado di analizzare e correlare informazioni simultaneamente attraverso diversi formati, consentendo risultati più contestuali e accurati. Questa evoluzione dalla ricerca monomodale (dove le query testuali restituivano solo risultati testuali) a sistemi multimodali integrati riflette la realtà di come gli utenti interagiscono naturalmente con le informazioni—combinando domande vocali con riferimenti visivi, caricando immagini per fornire contesto e aspettandosi risultati che sintetizzino più tipi di contenuti. L’importanza di questo cambiamento non può essere sottovalutata: modifica radicalmente il modo in cui i creatori di contenuti devono ottimizzare la loro presenza digitale e come i brand devono monitorare la propria visibilità su tutti i canali di ricerca. Comprendere l’ottimizzazione per la ricerca multimodale non è più opzionale per le aziende che vogliono mantenere visibilità competitiva in ambienti di ricerca guidati dall’AI.

L’emergere di avanzati modelli multimodali ha trasformato le capacità di ricerca, con diverse piattaforme leader che ora offrono sofisticati modelli visione-linguaggio in grado di processare e comprendere contenuti su più modalità simultaneamente. Ecco come si confrontano i principali player:

| Nome Modello | Creatore | Capacità Chiave | Ideale Per |

|---|---|---|---|

| GPT-4o | OpenAI | Analisi immagini in tempo reale, elaborazione vocale, risposta in 320ms | Ragionamento visivo complesso, conversazioni multimodali |

| Gemini | Ricerca integrata, comprensione video, ragionamento cross-modale | Integrazione con la ricerca, analisi contenuti completa | |

| Claude 3.7 | Anthropic | Analisi documenti, interpretazione immagini, comprensione sfumata | Documentazione tecnica, analisi visuali approfondite |

| LLaVA | Comunità open-source | Elaborazione visione-linguaggio leggera, inferenza efficiente | Ambienti con risorse limitate, edge deployment |

| ImageBind | Meta | Embedding cross-modale, comprensione audio-visiva | Correlazione contenuti multimediali, ricerca semantica |

Questi modelli rappresentano lo stato dell’arte nella tecnologia di ricerca AI, ciascuno ottimizzato per diversi casi d’uso e scenari di implementazione. Le organizzazioni devono comprendere quali modelli alimentano le loro piattaforme di ricerca target per ottimizzare efficacemente i contenuti per la scoperta. Il rapido avanzamento di queste tecnologie richiede che le strategie di visibilità nella ricerca siano flessibili e adattive per accogliere nuove capacità e fattori di ranking.

L’ottimizzazione per la ricerca immagini è diventata cruciale poiché le capacità di ricerca visiva si stanno espandendo notevolmente—Google Lens da solo ha registrato 10 milioni di visite a maggio 2025, a dimostrazione della crescita esplosiva delle query di ricerca basate su immagini. Per massimizzare la visibilità nei risultati di AI per la ricerca immagini, i creatori di contenuti dovrebbero implementare una strategia di ottimizzazione completa:

Questo approccio a più livelli garantisce che le immagini siano rintracciabili non solo tramite la ricerca immagini tradizionale, ma anche tramite sistemi AI multimodali che analizzano i contenuti visivi in relazione a testo e metadati circostanti.

L’integrazione dei Large Language Models nella ricerca vocale ha trasformato radicalmente il modo in cui i motori di ricerca interpretano e rispondono alle query parlate, andando ben oltre la semplice corrispondenza di keyword verso una sofisticata comprensione contestuale. La ricerca vocale tradizionale si basava su corrispondenze fonetiche e basilari tecniche di NLP, ma i moderni sistemi di ricerca vocale potenziati da LLM comprendono ora intenti, contesti, sfumature e schemi conversazionali con notevole precisione. Questo cambiamento significa che l’ottimizzazione per la ricerca vocale non può più concentrarsi solo sulle keyword esatte; al contrario, i contenuti devono essere strutturati per rispondere all’intento sottostante delle query conversazionali che gli utenti esprimono naturalmente. Le implicazioni sono profonde: una domanda come “Qual è il modo migliore per riparare un rubinetto che perde in cucina?” è fondamentalmente diversa dal digitare “riparare rubinetto che perde”, e i contenuti devono rispondere sia alla domanda che all’esigenza implicita di una guida passo-passo. Gli snippet in evidenza sono emersi come principale fonte per le risposte vocali, con i motori di ricerca che preferiscono risposte concise e dirette in cima ai risultati. Comprendere questa gerarchia—dove le risposte vocali vengono prelevate dagli snippet in evidenza—è essenziale per qualsiasi strategia di contenuti che miri ai dispositivi e assistenti vocali.

Ottimizzare per le query conversazionali richiede una ristrutturazione fondamentale del modo in cui i contenuti sono organizzati e presentati, passando da paragrafi densi di keyword a formati domanda-risposta naturali che riflettano il linguaggio parlato. I contenuti dovrebbero essere organizzati con intestazioni basate su domande che rispondano direttamente alle query vocali più comuni, seguite da risposte concise e autorevoli che offrano valore immediato senza costringere l’utente a leggere spiegazioni troppo lunghe. Questo approccio è in linea con il modo in cui i sistemi di elaborazione del linguaggio naturale estraggono risposte dai contenuti web—cercano coppie domanda-risposta chiare e affermazioni dirette che possano essere isolate e lette dagli assistenti vocali. Implementare markup di dati strutturati che identifichino esplicitamente domande e risposte aiuta i motori di ricerca a comprendere la natura conversazionale dei tuoi contenuti e aumenta la probabilità di essere selezionati per i risultati vocali. Frasi lunghe e conversazionali dovrebbero essere integrate naturalmente nei contenuti, evitando forzature di keyword. L’obiettivo è creare contenuti che suonino naturali quando letti ad alta voce e, allo stesso tempo, siano ottimizzati per i sistemi AI che analizzano e estraggono informazioni dalle tue pagine. Questo equilibrio tra leggibilità umana e interpretabilità per le macchine è la base di una efficace ottimizzazione per la ricerca vocale.

Implementare correttamente il schema markup è essenziale per segnalare ai sistemi AI multimodali cosa rappresentano i tuoi contenuti e come dovrebbero essere interpretati nei diversi contesti di ricerca. Le implementazioni di dati strutturati più efficaci per la ricerca multimodale includono lo schema FAQ (che marca esplicitamente le coppie domanda-risposta per la ricerca vocale), lo schema HowTo (che fornisce istruzioni passo-passo in formato leggibile dalle macchine) e lo schema Local Business (che aiuta nelle query multimodali basate sulla posizione). Oltre a questi tipi principali, implementare schema Article, Product ed Event assicura che i tuoi contenuti siano correttamente categorizzati e compresi dai sistemi AI che analizzano le tue pagine. Il Rich Results Test di Google dovrebbe essere utilizzato regolarmente per verificare che il markup schema sia implementato correttamente e riconosciuto dai sistemi di ricerca. Le basi della SEO tecnica—struttura HTML pulita, tempi di caricamento rapidi, responsività mobile e corretta canonicalizzazione—diventano ancora più critiche negli ambienti di ricerca multimodale, dove i sistemi AI devono analizzare rapidamente i tuoi contenuti su più formati. Le organizzazioni dovrebbero condurre audit completi della propria libreria di contenuti per identificare opportunità di implementazione schema, dando priorità alle pagine ad alto traffico e ai contenuti che si prestano naturalmente a formati domanda-risposta o istruzionali.

Monitorare le performance nella ricerca multimodale richiede un cambiamento nei parametri rispetto al traffico organico tradizionale, con particolare attenzione a impression degli snippet in evidenza, coinvolgimento vocale e tassi di conversione dalle fonti multimodali. Google Search Console offre visibilità sulle performance degli snippet in evidenza, mostrando quanto spesso i tuoi contenuti appaiono in posizione zero e quali query li attivano—dati direttamente correlati alla visibilità nella ricerca vocale. Le metriche di coinvolgimento da mobile diventano sempre più importanti, poiché la ricerca vocale è utilizzata principalmente su dispositivi mobili e smart speaker, rendendo i tassi di conversione mobile e la durata della sessione KPI critici per i contenuti ottimizzati per la voce. Le piattaforme di analytics dovrebbero essere configurate per tracciare le fonti di traffico provenienti da assistenti vocali e ricerca immagini separatamente dalla ricerca organica tradizionale, permettendoti di comprendere quali canali multimodali generano traffico di maggior valore. Le metriche sulla ricerca vocale dovrebbero includere non solo il volume di traffico ma anche la qualità della conversione, poiché chi cerca tramite voce spesso ha intenti e comportamenti diversi rispetto a chi cerca tramite testo. Monitorare le citazioni del brand negli AI Overviews e in altri risultati di ricerca generati da AI offre insight su come il tuo brand viene rappresentato in questi nuovi formati. Audit regolari delle performance degli snippet in evidenza, insieme all’analisi del traffico vocale, permettono di avere un quadro completo della visibilità e del ROI nella ricerca multimodale.

La traiettoria della ricerca multimodale punta verso trend di ricerca AI sempre più sofisticati che sfumano i confini tra ricerca, navigazione e completamento diretto di task, con gli AI Overviews che già mostrano un aumento di utilizzo superiore al 10% man mano che gli utenti adottano i riassunti generati dall’AI. Le capacità emergenti comprendono sistemi AI agentici in grado di agire per conto degli utenti—prenotando, effettuando acquisti o fissando appuntamenti—partendo da query multimodali che combinano voce, immagine e informazioni contestuali. La personalizzazione diventerà sempre più granulare, con sistemi AI che comprenderanno non solo cosa chiedono gli utenti ma anche preferenze, posizione, cronologia di acquisti e comportamenti per offrire risultati iper-pertinenti su tutte le modalità. Le capacità di ricerca in tempo reale si stanno espandendo, permettendo agli utenti di porre domande su eventi live, condizioni attuali o notizie in tempo reale con l’aspettativa di risposte immediate e accurate sintetizzate da più fonti. La ricerca video maturerà come modalità primaria, con sistemi AI che comprenderanno non solo i metadati ma anche i contenuti all’interno dei video, permettendo agli utenti di cercare momenti specifici, concetti o informazioni all’interno di librerie video. Il panorama competitivo favorirà sempre più i brand ottimizzati su tutte le modalità, poiché la visibilità in un canale (snippet in evidenza, ricerca immagini, risultati vocali) influenzerà direttamente quella nelle altre modalità tramite segnali di ranking cross-modale.

Poiché la ricerca multimodale diventa il paradigma dominante, il monitoraggio AI si è evoluto dal semplice tracking delle posizioni di ricerca al monitoraggio completo delle citazioni del brand tra ricerca per immagini, risultati vocali e overview generate dall’AI. AmICited offre visibilità essenziale su come appare il tuo brand negli AI Overviews, negli snippet in evidenza e nei risultati vocali—monitorando non solo se sei posizionato, ma anche come il tuo brand viene rappresentato e citato da sistemi AI che sintetizzano informazioni da più fonti. La piattaforma traccia le citazioni delle immagini nei risultati di ricerca visiva, assicurando che i tuoi contenuti visivi siano correttamente attribuiti e collegati al tuo dominio, proteggendo sia la tua autorità SEO che la visibilità del brand. Le menzioni vocali vengono monitorate su smart speaker e assistenti vocali, catturando come i tuoi contenuti vengono letti agli utenti in contesti voice-first dove le metriche tradizionali di click-through non si applicano. Con i risultati di ricerca generati dall’AI che ora rappresentano una quota significativa delle interazioni degli utenti, comprendere la tua visibilità in questi nuovi formati è fondamentale—AmICited fornisce l’infrastruttura di monitoraggio necessaria per tracciare, misurare e ottimizzare la tua presenza su tutti i canali di ricerca multimodale. Per i brand che vogliono mantenere una visibilità competitiva nel panorama della ricerca guidata dall’AI, il monitoraggio multimodale completo tramite piattaforme come AmICited non è più opzionale, ma essenziale per comprendere e proteggere la propria presenza digitale.

La ricerca AI multimodale integra diversi tipi di dati—testo, immagini, voce e video—per offrire un'esperienza di ricerca unificata. I moderni sistemi di ricerca sfruttano ora modelli AI multimodali in grado di analizzare e correlare simultaneamente informazioni in diversi formati, abilitando risultati più contestuali e precisi rispetto alla ricerca monomodale.

Ottimizza le immagini utilizzando contenuti originali di alta qualità, nomi file descrittivi e testi alternativi completi. Implementa lo schema markup, fornisci un testo circostante contestuale, includi più angolazioni dello stesso soggetto e comprimi i file per un caricamento rapido. Queste pratiche assicurano visibilità sia nella ricerca per immagini tradizionale che nei sistemi AI multimodali.

Gli snippet in evidenza sono la principale fonte per le risposte nella ricerca vocale. Gli assistenti vocali estraggono risposte concise e dirette dai risultati in posizione zero nelle pagine dei motori di ricerca. Ottimizzare i contenuti per apparire negli snippet in evidenza è essenziale per visibilità e posizionamento nella ricerca vocale.

Struttura i contenuti con intestazioni basate su domande che rispondono direttamente alle query vocali più comuni, seguite da risposte concise. Usa un linguaggio naturale e conversazionale e implementa markup di dati strutturati (schema FAQ, schema HowTo) per aiutare i sistemi AI a comprendere la natura conversazionale dei tuoi contenuti.

I principali modelli multimodali includono GPT-4o (OpenAI), Gemini (Google), Claude 3.7 (Anthropic), LLaVA (open-source) e ImageBind (Meta). Ognuno offre capacità e contesti di utilizzo differenti. Capire quali modelli alimentano le piattaforme di ricerca target ti aiuta a ottimizzare efficacemente i tuoi contenuti.

Monitora le impression degli snippet in evidenza in Google Search Console, osserva le metriche di coinvolgimento da mobile, analizza il traffico vocale separatamente dalla ricerca organica tradizionale e misura i tassi di conversione dalle fonti multimodali. Monitora le citazioni del brand negli AI Overviews e controlla come appaiono i tuoi contenuti nei diversi formati.

AmICited monitora come appare il tuo brand negli AI Overviews, snippet in evidenza, risultati per immagini e risposte vocali. Poiché i risultati di ricerca generati dall'AI stanno diventando predominanti, un monitoraggio multimodale completo è essenziale per comprendere e proteggere la tua presenza digitale su tutti i canali di ricerca.

Il futuro prevede sistemi AI sempre più sofisticati con capacità agentiche in grado di agire per conto degli utenti, risultati altamente personalizzati basati su preferenze e comportamenti, ricerca in tempo reale su eventi dal vivo e capacità mature di ricerca video. I brand ottimizzati su tutte le modalità avranno vantaggi competitivi.

Tieni traccia di come appare il tuo brand negli AI Overviews, nei risultati di ricerca per immagini e nelle risposte vocali. Ottieni visibilità in tempo reale sulla tua presenza nella ricerca multimodale.

Scopri come i sistemi di ricerca AI multimodale elaborano insieme testo, immagini, audio e video per offrire risultati più accurati e contestualmente rilevanti ...

Scopri come ottimizzare testo, immagini e video per i sistemi di IA multimodale. Scopri strategie per migliorare citazioni e visibilità AI su ChatGPT, Gemini e ...

Scopri cos'è il contenuto multimodale per l'IA, come funziona e perché è importante. Esplora esempi di sistemi di IA multimodale e le loro applicazioni nei vari...

Consenso Cookie

Usiamo i cookie per migliorare la tua esperienza di navigazione e analizzare il nostro traffico. See our privacy policy.