La Visione a Lungo Termine per la Visibilità nell’AI: Dove Stiamo Andando

Esplora il futuro del monitoraggio della visibilità nell’AI, dagli standard di trasparenza alla conformità normativa. Scopri come i brand possono prepararsi al ...

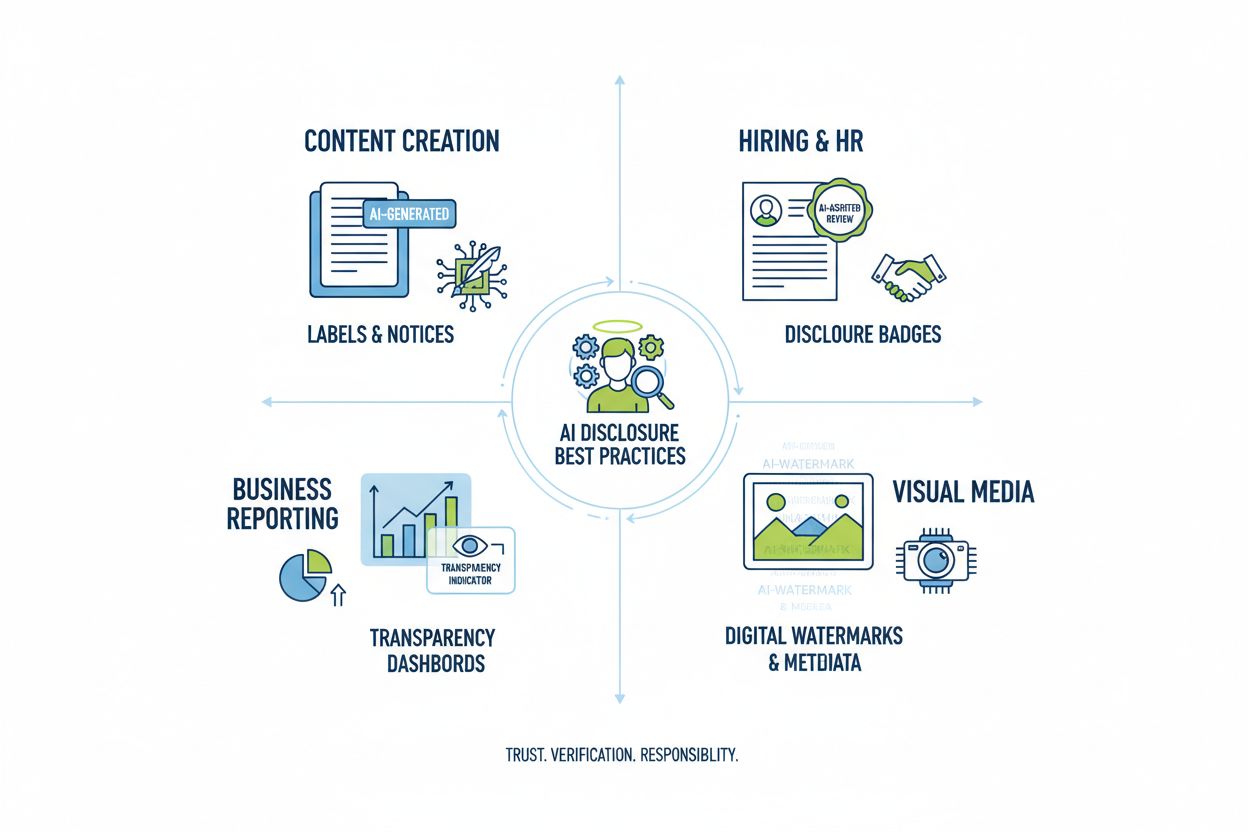

Scopri le migliori pratiche essenziali per la trasparenza e la divulgazione dell’IA. Esplora metodi comportamentali, verbali e tecnici di divulgazione per costruire fiducia e garantire la conformità alle normative sull’IA in evoluzione.

La trasparenza dell’IA è diventata un imperativo fondamentale in un’epoca in cui i sistemi di intelligenza artificiale influenzano tutto, dalla creazione di contenuti alle decisioni di assunzione fino ai consigli finanziari. Con la proliferazione di contenuti generati dall’IA sulle piattaforme digitali, le organizzazioni affrontano una crescente pressione a divulgare quando e come utilizzano queste tecnologie, non solo come obbligo legale ma come requisito essenziale per mantenere fiducia e credibilità con il proprio pubblico. Le poste in gioco sono particolarmente alte per brand e creatori di contenuti, poiché i consumatori chiedono sempre più spesso di sapere se le informazioni che ricevono provengano da competenza umana o da generazione algoritmica. Senza pratiche di divulgazione trasparenti, le organizzazioni rischiano di erodere la fiducia costruita in anni di lavoro, incorrendo in potenziali danni reputazionali, sanzioni normative e perdita di fiducia del pubblico. Il rapporto tra trasparenza e credibilità è simbiotico: le organizzazioni che divulgano proattivamente il proprio uso dell’IA dimostrano integrità e rispetto verso gli stakeholder, posizionandosi come attori onesti in un panorama sempre più guidato dall’intelligenza artificiale.

La proliferazione di contenuti generati dall’IA ha creato un profondo paradosso della fiducia: il pubblico fatica a distinguere tra opere autenticamente realizzate da umani e sofisticate alternative generate da IA, mentre la trasparenza riguardo all’uso dell’IA rimane incoerente tra i diversi settori. Questa confusione mina il contratto fondamentale tra creatori e consumatori, secondo cui il pubblico si aspetta di conoscere la vera origine dei contenuti fruiti. Quando i contenuti generati dall’IA vengono presentati senza divulgazione, si viola tale accordo implicito, creando una dicotomia “reale vs. artificiale” che va oltre le semplici preoccupazioni di autenticità, fino a toccare aspetti di inganno, manipolazione e consenso informato. Il paradosso si approfondisce perché alcuni contenuti generati dall’IA possono essere indistinguibili dal lavoro umano per qualità e stile, rendendo inaffidabili gli indizi visivi o stilistici sull’origine. La trasparenza è fondamentale proprio perché risolve questo paradosso, fornendo al pubblico le informazioni necessarie per prendere decisioni consapevoli su ciò che consuma e in cui ripone fiducia. Le organizzazioni che adottano pratiche di divulgazione chiare trasformano lo scetticismo potenziale in fiducia, dimostrando di non avere nulla da nascondere e tutto da guadagnare da una comunicazione onesta.

Il contesto normativo che riguarda la divulgazione dell’IA sta evolvendo rapidamente, con molteplici giurisdizioni che introducono o propongono requisiti cui le organizzazioni devono adeguarsi con attenzione. L’AI Act dell’UE, uno dei framework più completi, impone che i contenuti generati o pesantemente modificati dall’IA includano una divulgazione visibile o a livello di metadati, con specifici requisiti per i sistemi di IA ad alto rischio e obblighi di trasparenza per gli sviluppatori. Negli Stati Uniti, la FTC ha avvertito che il mancato aggiornamento dei Termini d’Uso e delle Politiche sulla Privacy per l’uso dell’IA può costituire pratica ingannevole, mentre regolamenti a livello statale—soprattutto la recente legge californiana AI Frontier Model—impongono obblighi di trasparenza e reporting rafforzati agli sviluppatori di grandi sistemi IA. Considerazioni su copyright e proprietà intellettuale aggiungono un ulteriore livello di complessità, poiché le organizzazioni devono dichiarare se i dati di training includono materiale protetto da copyright e come sono stati addestrati i sistemi IA. Inoltre, i requisiti di GDPR e CCPA si estendono ai sistemi IA che trattano dati personali, imponendo la divulgazione di decisioni automatizzate e la fornitura di informazioni significative sul trattamento effettuato dall’IA. La tabella seguente riassume i principali requisiti normativi nelle principali giurisdizioni:

| Giurisdizione | Regolamento | Requisiti chiave | Data di entrata in vigore |

|---|---|---|---|

| Unione Europea | EU AI Act | Divulgazione per IA ad alto rischio; report di trasparenza; etichettatura tramite metadati per contenuti generati da IA | A scaglioni (2024-2026) |

| Stati Uniti (Federale) | Linee guida FTC | Aggiornamento privacy policy; divulgazione uso IA; evitare pratiche ingannevoli | In corso |

| California | AI Frontier Model Law | Divulgazione standardizzata; obblighi di reporting; misure di sicurezza | 2025 |

| Unione Europea | GDPR | Divulgazione decisioni automatizzate; informazioni su processi IA | In corso |

| Stati Uniti (Multi-stato) | CCPA e simili | Divulgazione uso dati nei sistemi IA; opzioni di opt-out | Variabile per stato |

| Internazionale | Considerazioni copyright | Divulgazione fonti dati di training; gestione copyright nei risultati IA | In sviluppo |

Le organizzazioni che operano in più giurisdizioni devono implementare pratiche di divulgazione che soddisfino i requisiti più stringenti, poiché la conformità a uno standard spesso supera il minimo richiesto dagli altri.

I segnali comportamentali rappresentano la forma più sottile ma potente di divulgazione dell’IA, agendo attraverso la presentazione, lo stile, la voce e le scelte creative che il pubblico percepisce inconsciamente quando valuta l’autenticità di un contenuto. Questi segnali includono schemi distintivi nello stile di scrittura, coerenza della voce, scelte di composizione visiva, caratteristiche di avatar o persona e la “fedeltà” complessiva della rappresentazione del creatore—ossia quanto il contenuto rifletta una personalità e decisione umana autentica. Ad esempio, un testo generato dall’IA spesso mostra determinati schemi nella struttura delle frasi, nelle scelte di vocabolario e nel flusso logico diversi rispetto alla scrittura umana, mentre immagini generate dall’IA possono presentare incoerenze in luci, anatomia o dettagli di sfondo che un occhio esperto può rilevare. Il concetto di fedeltà del creatore è centrale: il pubblico sviluppa aspettative su come dovrebbe apparire, esprimersi e presentarsi un determinato creatore, e deviazioni da questo schema possono segnalare la presenza dell’IA. Tuttavia, affidarsi solo ai segnali comportamentali è problematico perché i sistemi IA migliorano rapidamente nell’imitare le caratteristiche umane, e non ci si può aspettare che il pubblico diventi esperto in forensica IA. I segnali comportamentali dovrebbero quindi integrare, e non sostituire, i metodi di divulgazione espliciti, fungendo da livello secondario di trasparenza che rafforza, ma non sostituisce, una comunicazione chiara e diretta sull’uso dell’IA.

Le strategie di divulgazione verbale offrono una comunicazione esplicita e diretta sull’uso dell’IA tramite segnali linguistici che non lasciano ambiguità sull’origine del contenuto e il coinvolgimento dell’IA. Questi metodi sono essenziali perché creano una traccia documentata della divulgazione e assicurano che il pubblico riceva informazioni inequivocabili sull’uso dell’IA. Le organizzazioni possono implementare la divulgazione verbale con diversi approcci complementari:

L’adeguatezza di ciascun metodo dipende dal contesto: le etichette sono efficaci per social e contenuti visivi, i watermark per video e audio, le byline per lavori giornalistici e creativi, i campi di divulgazione per contenuti lunghi, e i riconoscimenti per progetti complessi. Le organizzazioni dovrebbero adottare metodi di divulgazione coerenti con il formato dei contenuti e le aspettative del pubblico, assicurando che la divulgazione sia impossibile da ignorare pur rimanendo non intrusiva per l’esperienza utente.

I segnali tecnici e i metadati forniscono informazioni standardizzate e leggibili dalle macchine sul coinvolgimento dell’IA, permettendo il rilevamento, la verifica e il tracciamento automatizzati dei contenuti generati dall’IA negli ecosistemi digitali. Questi approcci utilizzano dati incorporati e tecniche crittografiche per creare registri permanenti e resistenti alle manomissioni sull’origine e la storia di elaborazione dei contenuti. Gli standard IPTC, recentemente aggiornati con proprietà specifiche per l’IA, consentono di incorporare informazioni strutturate sull’uso dell’IA direttamente nei file immagine, inclusi dettagli sui sistemi IA utilizzati, elaborazioni applicate e modifiche manuali. La C2PA (Coalition for Content Provenance and Authenticity) rappresenta uno standard emergente di settore che impiega firme crittografiche e credenziali di contenuto per stabilire catene di custodia verificabili per i contenuti digitali, rendendo possibile risalire alla fonte originale e a tutte le modifiche subite. Questi approcci tecnici colmano un limite fondamentale della divulgazione leggibile dall’uomo: creano registri permanenti e verificabili che non possono essere facilmente rimossi o alterati, e consentono ai sistemi automatici di identificare e segnalare i contenuti generati dall’IA su larga scala. Le organizzazioni che implementano la divulgazione tecnica dovrebbero considerare l’adozione di credenziali C2PA per contenuti di valore, l’inserimento di metadati IPTC in immagini e file multimediali, e la tenuta di una documentazione dettagliata del tipo di fonte digitale che tracci il coinvolgimento dell’IA lungo il ciclo di vita del contenuto. Il vantaggio dei segnali tecnici è la loro permanenza e verificabilità; la sfida è fare in modo che pubblico e piattaforme capiscano e rispettino tali segnali.

Una divulgazione efficace dell’IA richiede l’istituzionalizzazione delle pratiche di trasparenza lungo tutto il flusso di creazione dei contenuti, trasformando la divulgazione da elemento accessorio a componente fondamentale della governance dei contenuti. Le organizzazioni dovrebbero adottare framework di contenuto strutturato che rilevino il coinvolgimento dell’IA in ogni fase della creazione—dalla ricerca e stesura iniziale fino a editing e pubblicazione—garantendo che le informazioni di divulgazione fluiscano naturalmente nei sistemi di gestione dei contenuti. Automazione e integrazione nei flussi di lavoro sono essenziali: i CMS dovrebbero includere campi obbligatori per la divulgazione IA, promemoria automatici che richiedano ai creatori di documentare l’uso dell’IA prima della pubblicazione, e workflow di approvazione che verifichino la completezza della divulgazione prima della messa online. Questo approccio considera la divulgazione un requisito di qualità, simile alla verifica dei fatti, alla revisione legale o al rispetto dei criteri di brand. Occorre anche stabilire policy chiare su cosa costituisca uso dell’IA da divulgare (es. l’uso dell’IA per la ricerca va divulgato? E per l’editing assistito?), garantendo coerenza tra i team e prevenendo lacune di divulgazione. Formazione e documentazione sono altrettanto fondamentali: i creatori di contenuti devono ricevere indicazioni chiare su come divulgare l’uso dell’IA in base a tipologia di contenuto e piattaforma. Incorporando la divulgazione nei modelli e workflow di contenuto, le organizzazioni trasformano la trasparenza da onere di compliance a procedura standard che tutela sia l’organizzazione che il pubblico.

Le diverse applicazioni dell’IA richiedono approcci di divulgazione su misura che tengano conto di contesto, aspettative del pubblico e requisiti normativi. La creazione di contenuti (articoli, social media, testi di marketing) dovrebbe includere etichette chiare o byline modificate che indichino il coinvolgimento dell’IA, con ulteriori campi di divulgazione che specifichino quali strumenti IA sono stati usati e quale supervisione umana è stata applicata; ciò è particolarmente importante per notizie e contenuti editoriali, dove la fiducia dipende dalla comprensione dell’origine. I contesti di selezione e assunzione richiedono la divulgazione più rigorosa, poiché i candidati hanno diritto di sapere quando l’IA valuta le loro candidature o effettua screening iniziali, con spiegazioni dettagliate su come vengono prese le decisioni e quale revisione umana segue. Reporting e analisi (report finanziari, ricerche di mercato, analisi dati) dovrebbero includere divulgazione tecnica e metadati che indichino quali analisi sono state assistite dall’IA, soprattutto quando sistemi IA hanno individuato pattern o generato insight che hanno influenzato le conclusioni. I contenuti visivi (immagini, video, grafica) richiedono sia watermark visivi che divulgazione tramite metadati, poiché il pubblico non può distinguere con certezza i visual generati dall’IA da quelli autentici; ciò è fondamentale per la fotografia di cronaca, immagini di prodotto e qualsiasi contenuto in cui l’autenticità incide su acquisti o fiducia. Le comunicazioni rivolte al cliente (chatbot, risposte automatiche, customer care) devono identificare chiaramente la presenza dell’IA all’inizio dell’interazione, consentendo al cliente di richiedere assistenza umana se desiderato. Le organizzazioni dovrebbero eseguire audit sull’uso dell’IA in questi contesti e implementare pratiche di divulgazione proporzionate alla sensibilità e impatto di ogni caso, riconoscendo che i requisiti di trasparenza variano in base al modo in cui le decisioni IA incidono sul pubblico.

Il futuro della divulgazione dell’IA dipende dalla standardizzazione di settore e dallo sviluppo di framework interoperabili che consentano trasparenza coerente e comparabile tra organizzazioni e piattaforme. Standard emergenti come C2PA, le specifiche IPTC per i metadati e l’AI Risk Management Framework del NIST offrono strutture di base, ma la diffusione richiede uno sforzo coordinato tra piattaforme tecnologiche, creatori di contenuti, regolatori e associazioni di categoria. L’AI Act dell’UE e normative simili spingono verso la standardizzazione imponendo formati e categorie informative specifiche per la divulgazione, creando pressione per l’adozione di standard comuni a livello settoriale invece di approcci idiosincratici. Iniziative di settore come le linee guida etiche sull’IA della PRSA e diversi framework di trasparenza mostrano un crescente consenso sulle migliori pratiche di divulgazione, anche se l’adozione volontaria è ancora disomogenea. Il passo successivo essenziale sarà passare da standard volontari a requisiti normativi che impongano la standardizzazione della divulgazione, come le etichette nutrizionali FDA hanno standardizzato la trasparenza alimentare. Piattaforme di monitoraggio e visibilità—come AmICited.com—giocano un ruolo sempre più centrale in questo ecosistema, tracciando come l’IA cita brand e contenuti nelle risposte generate, offrendo alle organizzazioni visibilità su come il loro lavoro appare negli output IA e se avvengono la giusta attribuzione e divulgazione. Con l’avanzare e la diffusione dei sistemi IA, la capacità di monitorare, verificare e auditare le pratiche di divulgazione diventa essenziale per mantenere la fiducia negli ecosistemi digitali. Le organizzazioni che investono oggi in pratiche robuste di divulgazione e monitoraggio saranno meglio posizionate per navigare il contesto normativo in evoluzione e mantenere la fiducia del pubblico in un futuro guidato dall’intelligenza artificiale.

La divulgazione comportamentale utilizza scelte di presentazione (stile, voce, avatar) per segnalare il coinvolgimento dell'IA. La divulgazione verbale si avvale di dichiarazioni esplicite, etichette e watermark. La divulgazione tecnica incorpora metadati leggibili dalle macchine e firme crittografiche. Ogni metodo serve pubblici e contesti diversi, e le organizzazioni dovrebbero usarne più di uno insieme per una trasparenza completa.

I requisiti legali variano a seconda della giurisdizione. L'AI Act dell'UE impone la divulgazione per i sistemi di IA ad alto rischio. La FTC richiede la divulgazione quando l'uso dell'IA può influenzare le decisioni dei consumatori. Leggi statali come la California AI Frontier Model Law impongono obblighi di reporting. Il diritto d'autore richiede la divulgazione dei contenuti generati dall'IA. Le organizzazioni dovrebbero consultare un legale per requisiti specifici della giurisdizione.

Le immagini generate dall'IA dovrebbero includere sia watermark visivi che divulgazione tramite metadati. I watermark visivi devono essere visibili ma non invasivi, indicando chiaramente la generazione tramite IA. I metadati dovrebbero includere informazioni IPTC sul tipo di fonte digitale e credenziali C2PA quando disponibili. Didascalie e campi di divulgazione devono dichiarare esplicitamente che le immagini sono generate dall'IA, soprattutto per contenuti di notizie, prodotti o promozionali.

Gli standard IPTC forniscono campi di metadati strutturati per documentare l'uso dell'IA in immagini e file multimediali. Permettono il rilevamento e il tracciamento automatici dei contenuti generati dall'IA su diverse piattaforme. Le categorie di tipo di fonte digitale IPTC includono 'Trained Algorithmic Media', 'Composite Synthetic' e 'Algorithmic Media'. Questi standard sono importanti perché creano registri permanenti e verificabili del coinvolgimento dell'IA che non possono essere facilmente rimossi o alterati.

Le aziende dovrebbero condurre un audit dell'IA per identificare tutti i casi d'uso, implementare politiche di divulgazione allineate alle normative applicabili, integrare la divulgazione nei flussi di lavoro di gestione dei contenuti, formare i team sui requisiti di divulgazione e monitorare regolarmente la conformità. È essenziale consultare esperti legali specializzati nelle normative IA della propria giurisdizione, poiché i requisiti variano notevolmente tra le regioni.

Le conseguenze includono sanzioni normative (multe FTC, violazioni di leggi statali), danni reputazionali e perdita di fiducia del pubblico, responsabilità legale per violazione del copyright o pratiche ingannevoli, e possibili cause legali da parte di soggetti interessati. Le organizzazioni che non divulgano l'uso dell'IA rischiano di minare la credibilità costruita negli anni, rendendo la divulgazione proattiva un investimento strategico nella fiducia a lungo termine.

Stakeholder diversi necessitano livelli differenti di informazione. Il pubblico generale ha bisogno di affermazioni semplici e chiare sul coinvolgimento dell'IA. I regolatori chiedono documentazione tecnica dettagliata e prove di conformità. Giornalisti e creatori di contenuti necessitano informazioni specifiche sugli strumenti IA e la supervisione umana. I clienti devono capire come l'IA influenza la loro esperienza. Adatta formato e dettaglio della divulgazione alle esigenze e aspettative di ciascun pubblico.

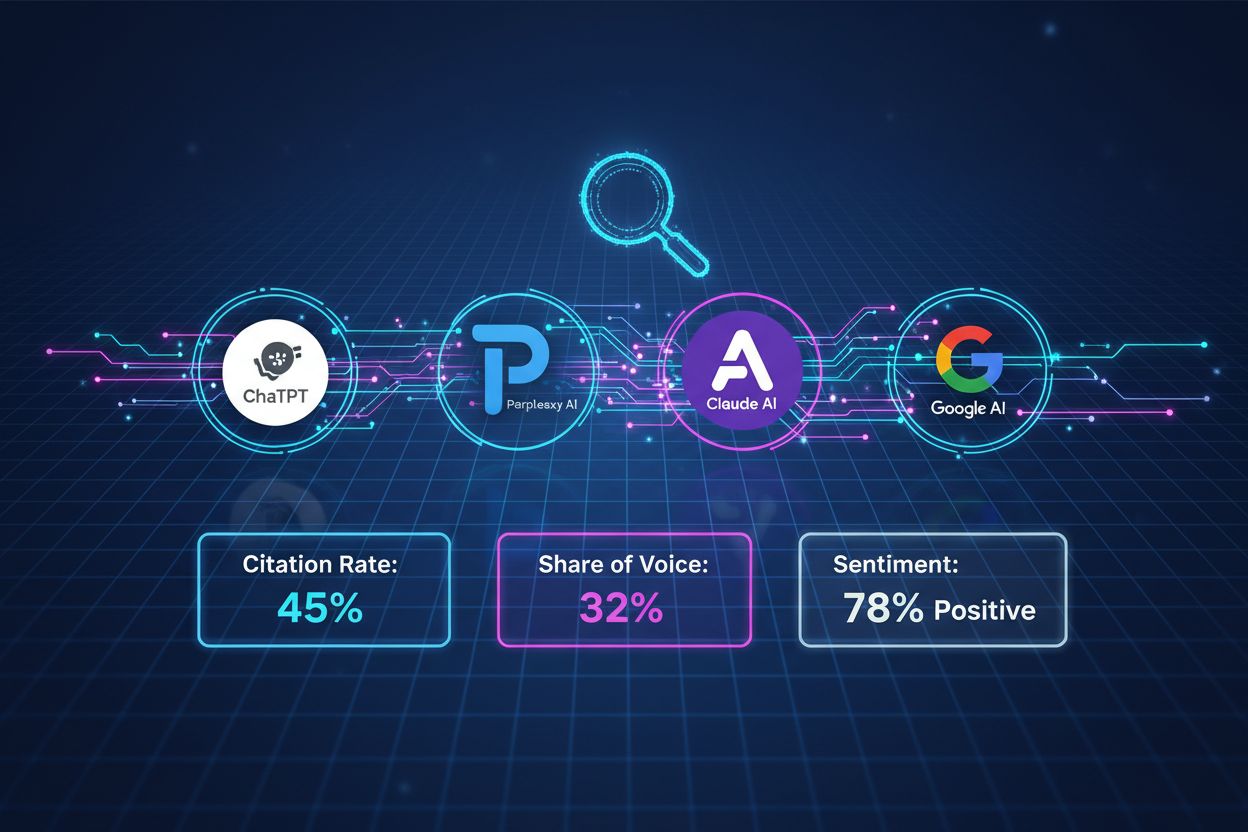

C2PA (Coalition for Content Provenance and Authenticity) fornisce credenziali crittografiche per la verifica dei contenuti. Gli standard IPTC permettono l'inserimento di metadati nelle immagini. I sistemi di gestione dei contenuti includono sempre più campi dedicati alla divulgazione IA. Piattaforme di monitoraggio come AmICited.com tracciano riferimenti e visibilità dell'IA. Framework di settore di PRSA, NIST e altri offrono linee guida. L'adozione di questi strumenti e standard sta accelerando con il rafforzamento delle normative.

Tieni traccia di come i sistemi di IA citano il tuo brand su GPT, Perplexity e Google AI Overviews. Assicurati che i tuoi contenuti ricevano la giusta attribuzione e visibilità nelle risposte generate dall'IA.

Esplora il futuro del monitoraggio della visibilità nell’AI, dagli standard di trasparenza alla conformità normativa. Scopri come i brand possono prepararsi al ...

Scopri strategie comprovate per mantenere e migliorare la visibilità dei tuoi contenuti nelle risposte generate dall’IA su ChatGPT, Perplexity e Google AI Overv...

Scopri come interpretare i risultati di un audit di visibilità AI. Comprendi la frequenza di citazione, i punteggi di visibilità del brand, la quota di voce e l...