URL canonici e AI: prevenire problemi di contenuti duplicati

Scopri come gli URL canonici prevengono i problemi di contenuti duplicati nei sistemi di ricerca AI. Scopri le migliori pratiche per implementare i canonici, mi...

La gestione SEO tradizionale dei contenuti duplicati è ben compresa: tag canonical, redirect, gestione dei parametri, ecc.

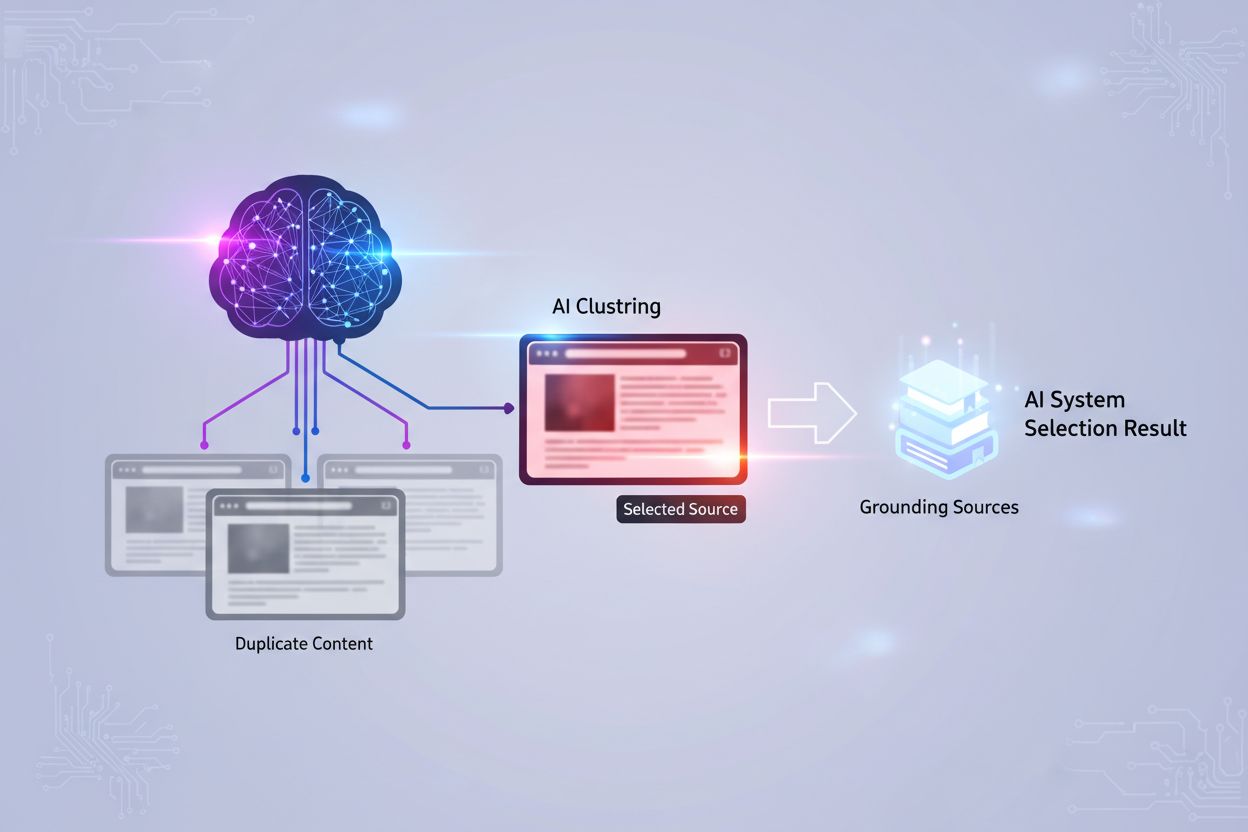

Ma come gestiscono i sistemi AI i contenuti duplicati? Le regole sembrano diverse.

Cosa ho notato:

Domande:

Qualcun altro sta affrontando questo problema?

Ottima domanda. L’AI gestisce i duplicati in modo molto diverso rispetto a Google.

Approccio Google:

Approccio AI (varia a seconda del sistema):

| Sistema AI | Gestione dei duplicati |

|---|---|

| Basato su training (ChatGPT) | Tutto ciò che era nei dati di addestramento, probabilmente più versioni |

| Basato su ricerca (Perplexity) | Deduplicazione in tempo reale sulla base della ricerca attuale |

| Ibrido (Google AI) | Misto tra segnali di indice e comprensione AI |

Il problema principale:

I modelli AI addestrati su dati web potrebbero aver ingerito contenuti sia dal tuo sito che da siti scraper. Non sanno intrinsecamente quale sia l’originale.

Cosa conta davvero per l’AI:

I tag canonical da soli non risolvono i problemi di attribuzione AI.

Misure tecniche che aiutano l’AI a identificare i tuoi contenuti come originali:

1. Segnali chiari di autore:

- Nome autore ben visibile

- Markup schema autore

- Link al profilo/biografia dell'autore

- Autore coerente su tutti i tuoi contenuti

2. Evidenza della data di pubblicazione:

- Data di pubblicazione chiara sulla pagina

- DatePublished in schema

- Date di aggiornamento dove rilevanti

3. Disambiguazione delle entità:

- Schema organizzazione

- Pagina about con informazioni chiare sull'entità

- NAP coerente sul web

4. Implementazione di llms.txt:

- Indica esplicitamente all'AI di cosa tratta il tuo sito

- Identifica i tuoi contenuti principali

- Nota proprietà/attribuzione

5. Segnali di unicità del contenuto:

- Immagini originali con i tuoi metadati

- Dati unici non disponibili altrove

- Prospettive in prima persona

Il punto chiave:

Rendi OVVIO ai sistemi AI che sei la fonte originale tramite segnali chiari e coerenti - non solo tag canonical che potrebbero non essere rispettati.

Esempio pratico dalla nostra esperienza:

Il problema che avevamo:

La nostra documentazione prodotto veniva citata, ma attribuita a siti terzi che l’avevano ripubblicata (con permesso).

Cosa abbiamo scoperto:

Come abbiamo risolto:

Segnali chiari di proprietà sui contenuti originali

Aggiunte di contenuti unici

Struttura dei link

Risultato:

Dopo 2 mesi, l’AI ha iniziato a citare la nostra documentazione originale invece dei duplicati.

Aggiungo la questione dei siti scraper:

Perché a volte vengono citati i siti scraper invece di te:

Cosa puoi fare:

Misure tecniche:

Protezione attribuzione:

Segnali proattivi:

La verità frustrante:

Una volta che l’AI si è addestrata sui contenuti degli scraper, non puoi annullarlo. Puoi solo influenzare i recuperi futuri rafforzando i segnali di autorevolezza.

Prospettiva enterprise sulla duplicazione dei contenuti per l’AI:

Le nostre sfide:

Il nostro approccio:

| Tipo di contenuto | Strategia |

|---|---|

| Varianti linguistiche | Hreflang + segnali linguistici chiari nei contenuti |

| Varianti regionali | Esempi locali unici, segnali di autore locali |

| Contenuti partner | Chiara attribuzione, prospettive distinte |

| UGC | Moderazione + commento editoriale unico |

Cosa abbiamo scoperto:

I sistemi AI sono sorprendentemente bravi a comprendere le relazioni tra i contenuti quando ricevono segnali chiari. La chiave è rendere le relazioni ESPLICITE.

Esempio:

Invece solo dei tag canonical, abbiamo aggiunto:

Rendere tutto leggibile anche per gli umani aiuta l’AI a comprendere le relazioni.

Opzioni di controllo dei crawler AI:

Attuali user agent dei crawler AI:

| Crawler | Azienda | controllo robots.txt |

|---|---|---|

| GPTBot | OpenAI | Rispetta robots.txt |

| Google-Extended | Google AI | Rispetta robots.txt |

| Anthropic-AI | Anthropic | Rispetta robots.txt |

| CCBot | Common Crawl | Rispetta robots.txt |

| PerplexityBot | Perplexity | Rispetta robots.txt |

Blocco dei contenuti duplicati dai crawler AI:

# Blocca le versioni di stampa dai crawler AI

User-agent: GPTBot

Disallow: /print/

Disallow: /*?print=

User-agent: Google-Extended

Disallow: /print/

Disallow: /*?print=

Considerazioni:

L’approccio llms.txt:

Invece di bloccare, puoi usare llms.txt per DIREZIONARE l’AI verso i tuoi contenuti canonici:

# llms.txt

Contenuti principali: /docs/

Documentazione canonica: https://yoursite.com/docs/

È ancora in fase di sviluppo ma più elegante del blocco.

Approccio di content strategy alla prevenzione dei duplicati:

La migliore strategia contro i contenuti duplicati è non averli:

Invece di:

Tattiche per l’unicità dei contenuti:

| Tattica | Come aiuta |

|---|---|

| Dati unici | Non possono essere duplicati se sono tuoi |

| Esperienza in prima persona | Specifica per te |

| Citazioni di esperti | Attribuite a persone specifiche |

| Immagini originali | Con metadati che mostrano la proprietà |

| Framework proprietari | La tua metodologia unica |

Il modo di pensare:

Se il tuo contenuto può essere copiato e incollato senza che nessuno se ne accorga, non è abbastanza differenziato. Crea contenuti che siano chiaramente TUOI.

Questa discussione ha completamente cambiato il mio modo di vedere i contenuti duplicati per l’AI. Ecco il riepilogo delle azioni:

Implementazione tecnica:

Rafforzare i segnali di autore

Indicatori chiari di proprietà

Controllo selettivo dei crawler AI

Audit sull’unicità dei contenuti

Approccio strategico:

Grazie a tutti per i contributi. È molto più complesso rispetto alla gestione tradizionale dei duplicati.

Get personalized help from our team. We'll respond within 24 hours.

Controlla quali pagine dei tuoi contenuti vengono citate dalle piattaforme AI. Identifica i problemi di contenuti duplicati che influenzano la tua visibilità AI.

Scopri come gli URL canonici prevengono i problemi di contenuti duplicati nei sistemi di ricerca AI. Scopri le migliori pratiche per implementare i canonici, mi...

Scopri come gestire e prevenire i contenuti duplicati quando utilizzi strumenti di IA. Scopri tag canonici, reindirizzamenti, strumenti di rilevamento e best pr...

Scopri come la ripubblicazione dei contenuti genera problemi di contenuto duplicato che danneggiano la visibilità nella ricerca AI più gravemente rispetto alla ...