Ricerca sui Prompt per la Visibilità AI: Comprendere le Query degli Utenti

Scopri come condurre una ricerca efficace sui prompt per la visibilità AI. Scopri la metodologia per comprendere le query degli utenti negli LLM e monitorare il...

Scopri come gli help center aumentano la visibilità AI tramite contenuti Q&A strutturati, marcatura schema FAQ e ottimizzazione strategica dei contenuti per ChatGPT, Perplexity e Gemini.

Gli help center incrementano notevolmente la visibilità AI perché il loro formato Q&A rispecchia il modo in cui i sistemi AI cercano e citano i contenuti; la marcatura schema FAQ aumenta la probabilità di citazione fino a 3,2 volte nelle risposte generate dall'AI.

Gli help center hanno tradizionalmente svolto la funzione di archivi per il supporto clienti, spesso trascurati dai team marketing focalizzati sul traffico del blog e sulla brand awareness. Tuttavia, nell’era dei motori di ricerca alimentati dall’AI come ChatGPT, Perplexity, Gemini e Grok, gli help center sono emersi come uno degli asset più preziosi per ottenere visibilità nei risultati di ricerca generativa. Il motivo principale è strutturale: gli help center sono costruiti attorno a formati domanda-e-risposta che si allineano perfettamente con il modo in cui i large language model (LLM) cercano, estraggono e citano i contenuti. Quando gli utenti pongono domande ai sistemi AI, questi cercano contenuti che corrispondano alla formulazione naturale della domanda e forniscano risposte chiare e concise—esattamente ciò che offrono gli help center ben strutturati. Questo allineamento crea un significativo vantaggio competitivo per i brand che ottimizzano i propri help center per la visibilità AI, trasformando tali piattaforme in miniere d’oro per keyword ad alta intenzione e citazioni autorevoli.

Il passaggio dalla ricerca tradizionale ai motori di risposta AI rappresenta un cambiamento fondamentale nella strategia dei contenuti. Mentre la SEO tradizionale puntava al posizionamento per keyword nei link blu di Google, l’ottimizzazione della visibilità AI si focalizza sull’ottenere citazioni nelle risposte generate dall’AI, che gli utenti leggono senza necessariamente cliccare sui siti sorgente. Gli help center eccellono in questo perché contengono esattamente il tipo di contenuto preferito dai sistemi AI: articoli focalizzati, basati su domande, con risposte chiare, formattazione strutturata e comprovata esperienza. Secondo la ricerca sull’ottimizzazione per i motori generativi, gli articoli degli help center sono scritti nel formato preciso amato da ChatGPT, Gemini e Perplexity—contenuti domanda-e-risposta brevi, chiari, con una domanda per articolo e una risposta esaustiva. Questo allineamento strutturale significa che gli help center non richiedono ottimizzazioni estese per diventare visibili all’AI; serve semplicemente una corretta implementazione di marcatura dati strutturati e segnali di aggiornamento dei contenuti per sbloccare tutto il loro potenziale.

L’architettura dei contenuti degli help center crea vantaggi naturali per i crawler AI e i modelli linguistici. Ogni articolo dell’help center segue tipicamente uno schema coerente: titolo basato su una domanda, sezione di risposta chiara e dettagli di supporto organizzati con header e punti elenco. Questa coerenza segnala ai sistemi AI che il contenuto è affidabile e ben organizzato, facilitando il lavoro dei crawler nell’analizzare e comprendere la relazione tra domande e risposte. I crawler AI non eseguono JavaScript né interpretano design di pagina complessi come fanno gli utenti umani; leggono la struttura HTML e cercano segnali semantici che indichino gerarchia e significato dei contenuti. Gli help center forniscono questi segnali in modo naturale grazie al formato Q&A, semplificando notevolmente il lavoro dei crawler e aumentando la probabilità che i contenuti vengano estratti correttamente ai fini delle citazioni.

La struttura HTML di help center ben progettati migliora ulteriormente la crawlabilità AI. Quando gli articoli utilizzano una gerarchia di heading corretta (H1 per la domanda principale, H2 per le sezioni di risposta, H3 per le sottosezioni), creano una mappa dei contenuti chiara che i sistemi AI possono seguire. Inoltre, gli help center evitano solitamente dipendenze pesanti da JavaScript e elementi interattivi complessi che potrebbero oscurare i contenuti ai crawler. Il design semplice e testuale che rende gli help center user-friendly li rende anche crawler-friendly, creando uno scenario vantaggioso in cui l’ottimizzazione per l’utente umano migliora contemporaneamente la visibilità AI. Questo è fondamentalmente diverso da molti post di blog o pagine marketing che privilegiano il design visivo e gli elementi interattivi rispetto alla chiarezza strutturale, rendendoli potenzialmente più difficili da interpretare per i sistemi AI.

I large language model sono addestrati su enormi quantità di dati testuali e apprendono pattern su come le informazioni vengono tipicamente presentate. Uno dei pattern più forti nei loro dati di addestramento è il formato domanda-risposta, molto presente in fonti come Wikipedia, Stack Overflow, Reddit e pagine FAQ. Quando gli LLM incontrano contenuti strutturati come domande chiare seguite da risposte esaustive, riconoscono questo pattern e lo trattano come fonte informativa affidabile. Questo riconoscimento è talmente marcato che i sistemi AI preferiscono attivamente i contenuti formattati Q&A rispetto ad altri formati quando sono disponibili più fonti, perché la struttura riduce le ambiguità e rende l’estrazione più affidabile.

Anche il modo in cui le persone interagiscono con i sistemi AI rafforza questa preferenza. Quando gli utenti pongono una domanda a ChatGPT, Perplexity o Gemini, usano una formulazione in linguaggio naturale che richiama i titoli degli articoli dell’help center. Un utente potrebbe chiedere “Come posso reimpostare la mia password?” e il sistema AI cercherà un contenuto che risponda direttamente a questa domanda. Gli articoli con titoli come “Come reimpostare la password” corrispondono perfettamente a questo pattern di ricerca, aumentando la probabilità che il sistema AI identifichi il contenuto come rilevante e lo citi nella risposta. Questo allineamento tra formato della query utente, pattern di ricerca AI e struttura degli articoli help center crea una sinergia naturale assente in altri tipi di contenuti. I post di blog con titoli come “Best practice per la gestione delle password” potrebbero contenere le stesse informazioni, ma il mismatch di formato rende meno probabile l’estrazione e citazione della risposta specifica da parte dei sistemi AI.

La marcatura schema FAQ (dati strutturati FAQPage) è l’implementazione tecnica che indica esplicitamente ai sistemi AI e ai motori di ricerca quali parti del contenuto sono domande e quali sono risposte. Sebbene Google abbia ristretto i risultati arricchiti FAQ a siti governativi e sanitari nell’agosto 2023, riducendo la visibilità dei frammenti FAQ nella ricerca tradizionale, piattaforme AI come ChatGPT, Perplexity e Gemini continuano ad analizzare e dare priorità alla marcatura schema FAQ. Le ricerche mostrano che le pagine con schema FAQPage hanno una probabilità 3,2 volte maggiore di apparire nei Google AI Overviews rispetto alle pagine senza dati FAQ strutturati, e lo schema FAQ ha uno dei tassi di citazione più alti tra tutti i tipi di schema nelle risposte AI. Questa differenza drammatica nella probabilità di citazione rende l’implementazione dello schema FAQ una delle attività SEO tecniche con il ROI più alto per la visibilità AI.

Il motivo per cui lo schema FAQ è così prezioso per i sistemi AI è che elimina l’onere interpretativo dagli algoritmi di elaborazione del linguaggio naturale. Invece che il sistema AI debba dedurre quale testo sia domanda e quale risposta, lo schema etichetta esplicitamente queste relazioni in formato leggibile dalla macchina. Questa chiarezza consente ai sistemi AI di estrarre risposte con maggiore sicurezza e citare le fonti più accuratamente. Quando un sistema AI incontra marcatura schema FAQ, può citare direttamente il testo della risposta senza preoccuparsi di catturare le informazioni corrette o perdere contesto importante. Questa affidabilità rende i contenuti con marcatura FAQ più propensi ad essere selezionati per la citazione, specialmente quando sono disponibili più fonti per la stessa domanda. Inoltre, lo schema FAQ aiuta i sistemi AI a comprendere la portata e la completezza delle risposte, permettendo di valutare se una risposta singola sia sufficiente o se occorra combinarne diverse.

I contenuti degli help center puntano naturalmente a keyword ad alta intenzione—query che indicano che gli utenti sono pronti ad agire o a risolvere un problema specifico. Diversamente dai contenuti blog che possono puntare a keyword di awareness come “cos’è la gestione password”, gli articoli help center mirano a keyword di decisione come “come posso reimpostare la password” o “perché la mia password non funziona”. Queste query ad alta intenzione hanno volumi di ricerca inferiori rispetto alle keyword di awareness, ma tassi di conversione molto superiori, poiché gli utenti che pongono queste domande stanno attivamente cercando di ottenere un risultato. Per la visibilità AI, le keyword ad alta intenzione sono particolarmente preziose perché rappresentano le tipologie di domande che gli utenti pongono ai sistemi AI.

Il vantaggio nel targeting keyword degli help center va oltre i singoli articoli e si estende all’intero knowledge base. Un help center ben organizzato che copre tutti gli aspetti di un prodotto o servizio crea un cluster tematico completo che segnala profonda competenza ai sistemi AI. Quando un sistema AI incontra più articoli che affrontano diversi aspetti dello stesso tema—come “Come configurare le integrazioni”, “Come risolvere errori di integrazione” e “Quali integrazioni sono supportate”—riconosce che il dominio ha una copertura autorevole e completa sull’argomento. Questa autorità tematica aumenta la probabilità che il sistema AI citi i contenuti dell’help center per query correlate, anche se la domanda specifica dell’utente non coincide perfettamente con un singolo articolo. L’effetto cluster implica che investire nei contenuti help center genera ritorni composti, dove ogni nuovo articolo rafforza l’autorità dei precedenti e aumenta la probabilità di citazione su tutta la knowledge base.

Il linking interno negli help center ha molteplici funzioni per la visibilità AI. Primo, crea un ecosistema connesso di contenuti che aiuta i sistemi AI a comprendere le relazioni tematiche e la gerarchia dei contenuti. Quando un articolo su “Come integrare con Slack” linka ad articoli correlati come “Come risolvere errori di integrazione” o “Elenco integrazioni supportate”, questi link segnalano ai sistemi AI che gli articoli sono tematicamente collegati e parte di una struttura di conoscenza più ampia. Questa interconnessione aiuta i sistemi AI a comprendere la portata della tua competenza e aumenta la probabilità che citino più articoli del tuo help center per domande complesse che richiedono prospettive multiple.

Secondo, il linking interno distribuisce equity e priorità di crawl all’interno dell’help center, assicurando che anche gli articoli meno promossi ricevano attenzione dai motori di ricerca e crawler AI. Un articolo che riceve link da altri articoli e dalla navigazione principale ottiene più priorità di crawl rispetto a un articolo isolato, aumentando la probabilità che venga indicizzato e citato dai sistemi AI. Terzo, il linking interno migliora l’esperienza utente aiutando i visitatori a scoprire informazioni correlate senza lasciare l’help center, riducendo le bounce rate e aumentando i metriche di engagement che segnalano qualità dei contenuti ai sistemi AI. La collocazione strategica dei link interni—usando anchor text descrittivi che includano keyword rilevanti—aiuta anche i sistemi AI a capire di cosa tratta ogni articolo collegato, migliorando la capacità di associare query utente ai contenuti più pertinenti.

I sistemi AI, in particolare Google AI Overviews, privilegiano fortemente i contenuti aggiornati di recente perché i segnali di freschezza indicano che l’informazione è attuale e affidabile. Gli help center che mantengono aggiornamenti regolari—aggiornando gli articoli ogni 3-6 mesi con nuove statistiche, esempi e dati attuali—inviando forti segnali di freschezza ai sistemi AI. Questo è fondamentalmente diverso dalla SEO tradizionale, dove la freschezza conta ma non è così critica quanto l’autorità tematica e i backlink. Per la visibilità AI, la freschezza dei contenuti può essere il fattore decisivo quando più fonti offrono informazioni simili, perché i sistemi AI puntano a fornire agli utenti dati il più possibile attuali e accurati.

L’implementazione dei segnali di freschezza negli help center dovrebbe includere timestamp di ultimo aggiornamento visibili sugli articoli, che fungono da indicatori espliciti di freschezza che i sistemi AI possono leggere. Inoltre, gli articoli dovrebbero essere aggiornati con statistiche attuali, esempi recenti e informazioni tempestive che riflettano lo stato attuale del prodotto o servizio. Quando un articolo su “Come usare la funzionalità X” viene aggiornato per riflettere cambi di prodotto o nuove capacità, i contenuti aggiornati diventano più preziosi per i sistemi AI rispetto ai contenuti obsoleti dei concorrenti. Questo crea un vantaggio competitivo continuo per gli help center che trattano la manutenzione dei contenuti come un processo costante. La combinazione di aggiornamenti regolari, timestamp visibili e dati attuali genera un potente segnale di freschezza che aumenta la probabilità di citazione nelle risposte AI.

Sebbene lo schema FAQ sia il tipo di dati strutturati principale per gli help center, implementare altri tipi di schema crea una struttura dati più completa che i sistemi AI possono sfruttare. Lo schema Article (o BlogPosting) fornisce metadati su data di pubblicazione, autore e struttura dell’articolo, aiutando i sistemi AI a valutare autorità e freschezza. Lo schema Organization sulla homepage dell’help center stabilisce l’identità aziendale e la competenza, fornendo contesto che aiuta i sistemi AI a capire chi c’è dietro i contenuti e se la fonte è credibile. Lo schema HowTo per articoli procedurali che guidano gli utenti passo-passo aiuta i sistemi AI a comprendere la sequenzialità delle istruzioni ed estrarre i passaggi nell’ordine corretto.

La stratificazione di più tipi di schema crea una struttura dati più ricca che i sistemi AI possono interpretare con maggiore precisione. Quando un articolo include schema FAQ per la struttura Q&A, schema Article per i metadati di pubblicazione e schema HowTo per i passaggi procedurali, il sistema AI riceve molteplici segnali sulla natura e qualità dei contenuti. Questa ridondanza migliora l’accuratezza perché i sistemi AI possono incrociare i diversi tipi di schema per verificare informazioni ed essere certi di estrarre il contenuto corretto. Inoltre, implementare breadcrumb schema sulla navigazione dell’help center aiuta i sistemi AI a comprendere la gerarchia dei contenuti e la relazione tra articoli e categorie. L’effetto cumulativo di una corretta implementazione schema su più livelli è molto superiore rispetto a qualsiasi tipo singolo di schema, creando un vantaggio composito per gli help center che adottano un approccio strutturato e completo ai dati.

Le diverse piattaforme AI mostrano pattern di citazione e preferenze di contenuto distinti, che influenzano la performance dei contenuti help center nel panorama AI. ChatGPT attribuisce grande importanza ai contenuti autorevoli, neutrali, in stile enciclopedico, con citazioni esterne e dati specifici. Gli articoli help center che includono citazioni a fonti autorevoli, affermazioni quantificate con numeri precisi e informazioni oggettive hanno maggiori probabilità di essere citati da ChatGPT. Nei dati di addestramento della piattaforma sono presenti ampie quantità di contenuti Wikipedia, da cui deriva la preferenza per informazioni neutrali, complete e ben referenziate. Gli help center che adottano questo tono e stile—trattando gli articoli come mini-enciclopedie e non come contenuto marketing—ottengono migliori citazioni su ChatGPT.

Perplexity AI mostra una preferenza diversa, favorendo contenuti conversazionali, basati su esperienze, con esempi pratici e insight dalla community. La piattaforma valorizza scenari reali, casi d’uso specifici ed esempi autentici che mostrano l’applicazione pratica delle informazioni. Gli articoli help center che includono esempi pratici, scenari clienti e indicazioni operative sono più facilmente citati da Perplexity. Inoltre, Perplexity attribuisce maggior peso a contenuti generati dalla community e discussioni, quindi articoli che fanno riferimento o coinvolgono feedback della community performano meglio su questa piattaforma. Google AI Overviews adotta un approccio bilanciato, valorizzando sia fonti autorevoli che informazioni fresche e aggiornate. La piattaforma enfatizza i segnali E-E-A-T (Esperienza, Competenza, Autorevolezza, Affidabilità), quindi gli articoli help center con credenziali autore, date di pubblicazione ed evidenze di competenza sono più citati.

Gemini e Grok rappresentano piattaforme AI emergenti con pattern di citazione in evoluzione. Gemini, essendo il sistema AI di Google, probabilmente condivide preferenze simili a Google AI Overviews, privilegiando contenuti freschi con forti segnali E-E-A-T. Grok, il sistema AI di Elon Musk, enfatizza informazioni in tempo reale e attualità, rendendo la freschezza particolarmente importante. Gli help center che mantengono informazioni attuali e aggiornano frequentemente gli articoli ottengono risultati migliori su Grok. L’implicazione strategica è che gli help center ottimizzati per tutte le principali piattaforme AI dovrebbero bilanciare molteplici caratteristiche: citazioni autorevoli per ChatGPT, esempi pratici per Perplexity, informazioni fresche per Google e Grok, segnali E-E-A-T per tutte le piattaforme. Questo approccio massimizza la probabilità di citazione su tutto il panorama AI invece che ottimizzare per una sola piattaforma.

| Aspetto | Help Center Tradizionale | Help Center AI-Optimizzato |

|---|---|---|

| Obiettivo Primario | Ridurre ticket di supporto | Ridurre ticket + ottenere citazioni AI |

| Struttura Contenuti | Formati vari (articoli, guide, FAQ) | Formato Q&A coerente, una domanda per articolo |

| Marcatura Schema | Minima o assente | Schema FAQ, Article e Organization completi |

| Lunghezza Risposte | Variabile, spesso oltre 100 parole | Ottimizzata 40-60 parole con contesto completo |

| Approccio Citazioni | Solo riferimenti interni | Citazioni esterne a fonti autorevoli |

| Freschezza Contenuti | Aggiornamento annuale o secondo necessità | Aggiornamento mensile con statistiche ed esempi |

| Tono | Focalizzato sul prodotto, talvolta promozionale | Neutrale, informativo, educativo |

| Linking Interno | Cross-linking minimo | Link interni strategici tra articoli correlati |

| Attribuzione Autore | Spesso anonima | Chiare credenziali autore e segnali di competenza |

| Visibilità Timestamp | Nascosta o non presente | Date di ultimo aggiornamento ben visibili |

| Ottimizzazione Mobile | Design responsive base | Ottimizzato per voice search e assistenti AI mobile |

| Probabilità Citazione AI | Bassa (contenuti non strutturati) | 3,2x superiore (con schema FAQ) |

| Idoneità Featured Snippet | Moderata | Alta (formato strutturato + schema) |

| Compatibilità Voice Search | Limitata | Ottimizzata per query conversazionali |

Gli help center che raggiungono la massima visibilità AI condividono alcune caratteristiche fondamentali che li distinguono dalla documentazione di supporto tradizionale. Una domanda per articolo è il principio di base: ogni articolo dovrebbe affrontare una sola domanda specifica invece di coprire più argomenti correlati. Questo approccio focalizzato rende più facile per i sistemi AI abbinare le query degli utenti agli articoli pertinenti ed estrarre risposte complete senza ambiguità. Quando un articolo cerca di rispondere a “Come reimposto la password, cambio l’email e aggiorno il profilo?” in un unico pezzo, i sistemi AI fanno fatica a stabilire quale risposta corrisponda a quale domanda, riducendo la probabilità di citazione. Suddividere in tre articoli distinti—ognuno con una domanda specifica—migliora notevolmente la visibilità AI.

Risposte chiare e complete che siano autonome senza richiedere contesto circostante sono essenziali per la citazione AI. Le risposte degli help center dovrebbero essere scritte assumendo che un sistema AI possa estrarre e presentare solo quella risposta all’utente, senza paragrafi di contorno. Significa che ogni risposta deve includere informazioni sufficienti per essere compresa in modo indipendente. Ad esempio, una risposta che dice “Clicca il pulsante in fondo al modulo” è incompleta perché non specifica quale pulsante o quale modulo. Una risposta completa sarebbe “Clicca il pulsante blu Invia in fondo al modulo impostazioni account per salvare le modifiche.” Questo approccio auto-contenuto assicura che anche quando i sistemi AI estraggono risposte fuori contesto, queste rimangano chiare e utili.

Formattazione strutturata con header, punti elenco ed enfasi in grassetto aiuta sia i lettori umani che i sistemi AI a comprendere l’organizzazione dei contenuti. Gli articoli dovrebbero usare header H2 e H3 per suddividere in sezioni logiche, punti elenco per elencare passaggi o funzionalità e grassetto per evidenziare termini chiave e informazioni importanti. Questa formattazione ha molteplici scopi: migliora la leggibilità per chi cerca risposte rapide, aiuta i sistemi AI a comprendere la gerarchia dei contenuti e incrementa la probabilità di apparire nei featured snippet, che alimentano i dati dei Google AI Overviews. La combinazione di struttura chiara e formattazione corretta crea contenuti che performano bene su tutti i canali di visibilità—ricerca tradizionale, featured snippet e risposte AI.

Gli help center creano autorità tematica fornendo copertura esaustiva di argomenti specifici legati al proprio prodotto o servizio. Quando un help center contiene articoli che trattano ogni aspetto di una funzionalità—come usarla, come risolverne i problemi, come integrarla con altri strumenti e domande frequenti—l’insieme segnala ai sistemi AI una profonda competenza in quell’area. Questa autorità tematica aumenta la probabilità che i sistemi AI citino i contenuti help center per query correlate, anche se la domanda dell’utente non coincide con un singolo articolo. L’effetto cluster fa sì che ogni nuovo articolo rafforzi l’autorità dei precedenti e aumenti la probabilità di citazione su tutta la knowledge base.

Costruire autorità tematica richiede una pianificazione strategica su quali argomenti coprire in modo completo. Invece di pubblicare articoli help casuali su funzionalità sparse, gli help center di successo identificano i core topic e creano cluster di articoli esaustivi su ciascuno. Ad esempio, un tool di project management può creare un cluster su “Gestione Task” che includa “Come creare un task”, “Come assegnare task ai membri”, “Come impostare scadenze”, “Come segnare task come completati” e “Come risolvere problemi relativi ai task”. Questa copertura completa segnala competenza e rende più probabile che i sistemi AI citino più articoli del cluster rispondendo a domande sulla gestione delle attività. L’approccio strategico all’autorità tematica migliora anche la performance SEO tradizionale, poiché i motori di ricerca premiano la copertura completa con ranking più alti.

Misurare il successo dell’ottimizzazione help center per la visibilità AI richiede metriche diverse dalla SEO tradizionale. Mentre la SEO classica si concentra su ranking e traffico organico, il successo della visibilità AI si misura in citazioni nelle risposte generate dall’AI. La sfida è che le citazioni AI non generano traffico diretto come i ranking di ricerca; piuttosto, costruiscono autorevolezza e brand awareness tra chi legge risposte AI senza visitare i siti sorgente. Per tracciare le citazioni AI occorre monitorare menzioni di brand e prodotto su ChatGPT, Perplexity, Google AI Overviews, Gemini e Grok per vedere dove e come i contenuti help center vengono citati.

Le metriche chiave per misurare la visibilità AI degli help center includono: frequenza di citazione sulle principali piattaforme AI (quanto spesso i contenuti help center appaiono nelle risposte AI), contesto della citazione (se le citazioni sono positive, neutre o negative e se includono il nome del brand), apparizioni in featured snippet (quali articoli help center appaiono in posizione zero su Google), traffico organico all’help center (performance SEO tradizionale che spesso migliora con la visibilità AI), segnali di freschezza contenuti (frequenza di aggiornamento e visibilità timestamp), validazione schema (percentuale di articoli help center con marcatura FAQ corretta) e copertura linking interno (grado di interconnessione tra articoli tramite link interni strategici). La metrica più importante è la frequenza di citazione nelle risposte AI, che indica direttamente se i tuoi contenuti sono riconosciuti e citati dai sistemi AI. Tracciare questa metrica richiede monitoraggio manuale (cercando brand e prodotti sulle piattaforme AI) oppure l’uso di tool specializzati di monitoraggio visibilità AI che tracciano citazioni cross-piattaforma. L’unione dei dati di citazione AI con le metriche SEO tradizionali offre una visione completa delle performance help center sia sulla ricerca classica che AI-driven.

Implementare l’ottimizzazione help center per la visibilità AI richiede un approccio sistematico che abbracci struttura dei contenuti, implementazione tecnica e manutenzione continua. Inizia con un audit dei contenuti esistenti per individuare quali articoli performano bene in ricerca tradizionale e dove ci sono lacune tematiche. Usa questo audit per prioritizzare quali articoli ottimizzare per primi, focalizzandoti su quelli ad alto traffico e sulle keyword ad alta intenzione. Per ogni articolo, assicurati che rispetti il principio “una domanda per articolo”, abbia una risposta chiara e completa, e includa una formattazione corretta con header e punti elenco.

Implementa la marcatura schema FAQ su tutti gli articoli help center usando il formato JSON-LD. Usa il Rich Results Test di Google per validare lo schema prima della pubblicazione, assicurandoti che tutte le proprietà richieste siano presenti e corrette. Testa lo schema sia su desktop che mobile per verificarne la resa su tutti i dispositivi. Dopo l’implementazione, monitora l’help center nel report Rich Results di Google Search Console per tracciare la validazione schema e identificare eventuali errori da correggere. Stabilisci un piano di aggiornamento contenuti che preveda il refresh degli articoli help center ogni 3-6 mesi con dati attuali, statistiche aggiornate ed esempi recenti. Includi timestamp visibili di ultimo aggiornamento su tutti gli articoli per segnalare freschezza ai sistemi AI. Quando aggiorni, dai priorità agli articoli sulle keyword ad alta intenzione e a quelli già citati dai sistemi AI, poiché questi aggiornamenti avranno il massimo impatto sulla visibilità AI.

Costruisci link interni strategicamente identificando articoli correlati e collegandoli con anchor text descrittivo. Crea una sezione “Articoli Correlati” al termine di ogni articolo che suggerisca altri contenuti rilevanti. Usa la navigazione e la struttura a categorie dell’help center per rafforzare le relazioni tematiche e facilitare l’organizzazione sia per utenti che sistemi AI. Ottimizza per più piattaforme AI scrivendo contenuti equilibrati che soddisfino le preferenze dei diversi sistemi: citazioni autorevoli per ChatGPT, esempi pratici per Perplexity, informazioni fresche per Google AI Overviews e segnali E-E-A-T per tutte le piattaforme. Questo approccio massimizza la probabilità di citazione su tutto lo spettro AI invece di ottimizzare solo per una piattaforma.

Gli help center si sono evoluti da repository di supporto clienti spesso trascurati ad asset fondamentali per la visibilità AI e l’autorità del brand. L’allineamento tra struttura Q&A degli help center e il modo in cui i sistemi AI cercano e citano i contenuti crea un vantaggio naturale difficilmente eguagliabile da altri tipi di contenuto. Implementando la corretta marcatura schema FAQ, mantenendo una struttura coerente, aggiornando regolarmente gli articoli con informazioni fresche e costruendo autorità tematica tramite una copertura completa, gli help center diventano potenti motori per ottenere citazioni nelle risposte AI su ChatGPT, Perplexity, Gemini, Grok e Google AI Overviews.

I dati sono chiari: le pagine con schema FAQ hanno una probabilità 3,2 volte maggiore di apparire nei Google AI Overviews, e la marcatura FAQ ha uno dei tassi di citazione più alti tra tutti i tipi di dati strutturati. Considerando che solo una piccola percentuale di siti implementa una vera ottimizzazione help center per la visibilità AI, chi la adotta per primo ottiene un vantaggio competitivo significativo. L’investimento nell’ottimizzazione help center paga due volte: prima con migliori performance SEO e riduzione dei ticket di supporto, poi con maggiore visibilità e autorevolezza nelle risposte AI che raggiungono milioni di utenti ogni giorno.

Il futuro della ricerca è sempre più guidato dall’AI, e gli help center sono destinati a diventare l’asset di contenuto più prezioso in questo nuovo scenario. Considerando l’ottimizzazione help center una priorità strategica e applicando le best practice di questa guida, i brand possono assicurarsi che la propria competenza venga riconosciuta e citata dai sistemi AI, costruendo autorevolezza e visibilità nei canali dove gli utenti scoprono sempre più informazioni.

Tieni traccia di dove e come i sistemi AI citano i tuoi contenuti dell'help center su ChatGPT, Perplexity, Gemini e Google AI Overviews con monitoraggio in tempo reale.

Scopri come condurre una ricerca efficace sui prompt per la visibilità AI. Scopri la metodologia per comprendere le query degli utenti negli LLM e monitorare il...

Scopri come le startup possono migliorare la loro visibilità nelle risposte generate dall’IA su ChatGPT, Perplexity, Gemini e altre piattaforme di IA attraverso...

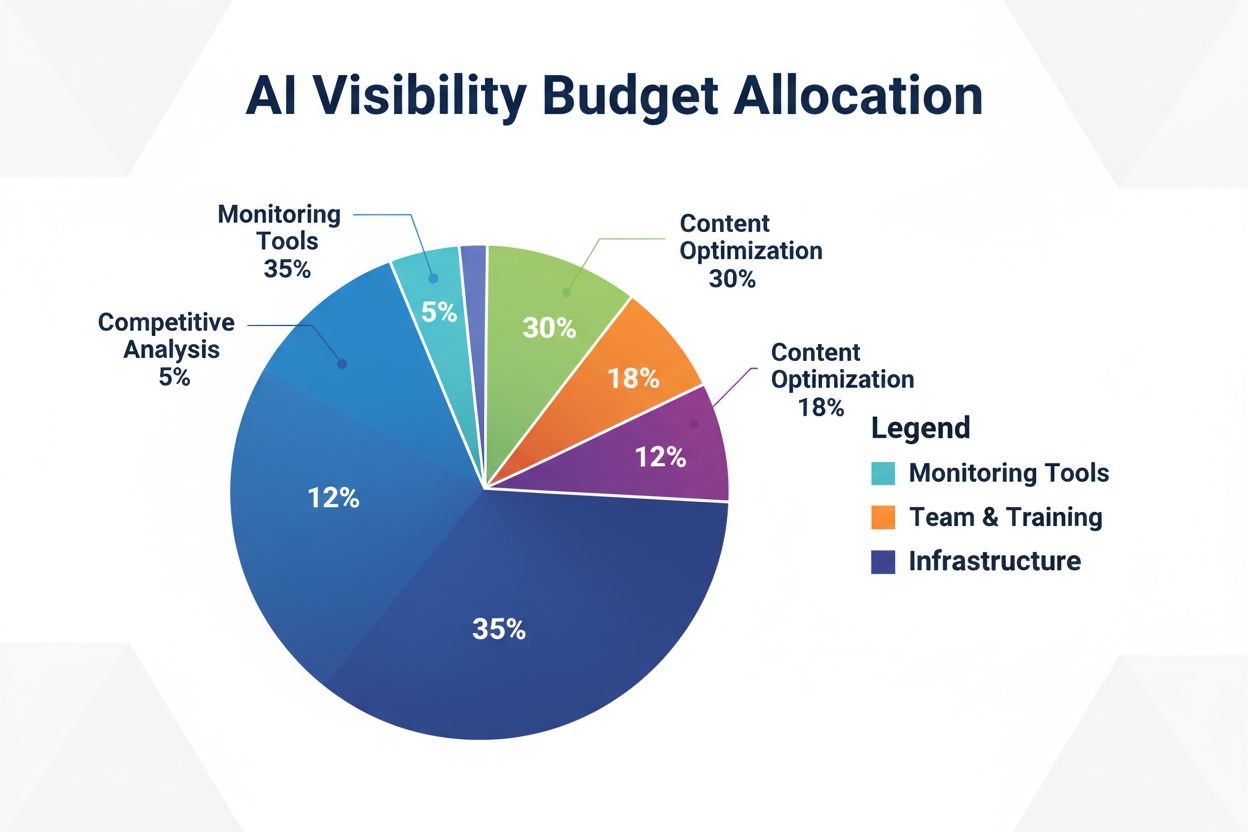

Scopri come allocare strategicamente il tuo budget per la visibilità AI tra strumenti di monitoraggio, ottimizzazione dei contenuti, risorse del team e analisi ...