Come Condurre un Audit di Visibilità AI: Metodologia Completa

Scopri la metodologia completa passo dopo passo per condurre un audit di visibilità AI. Scopri come misurare le menzioni del marchio, le citazioni e la visibili...

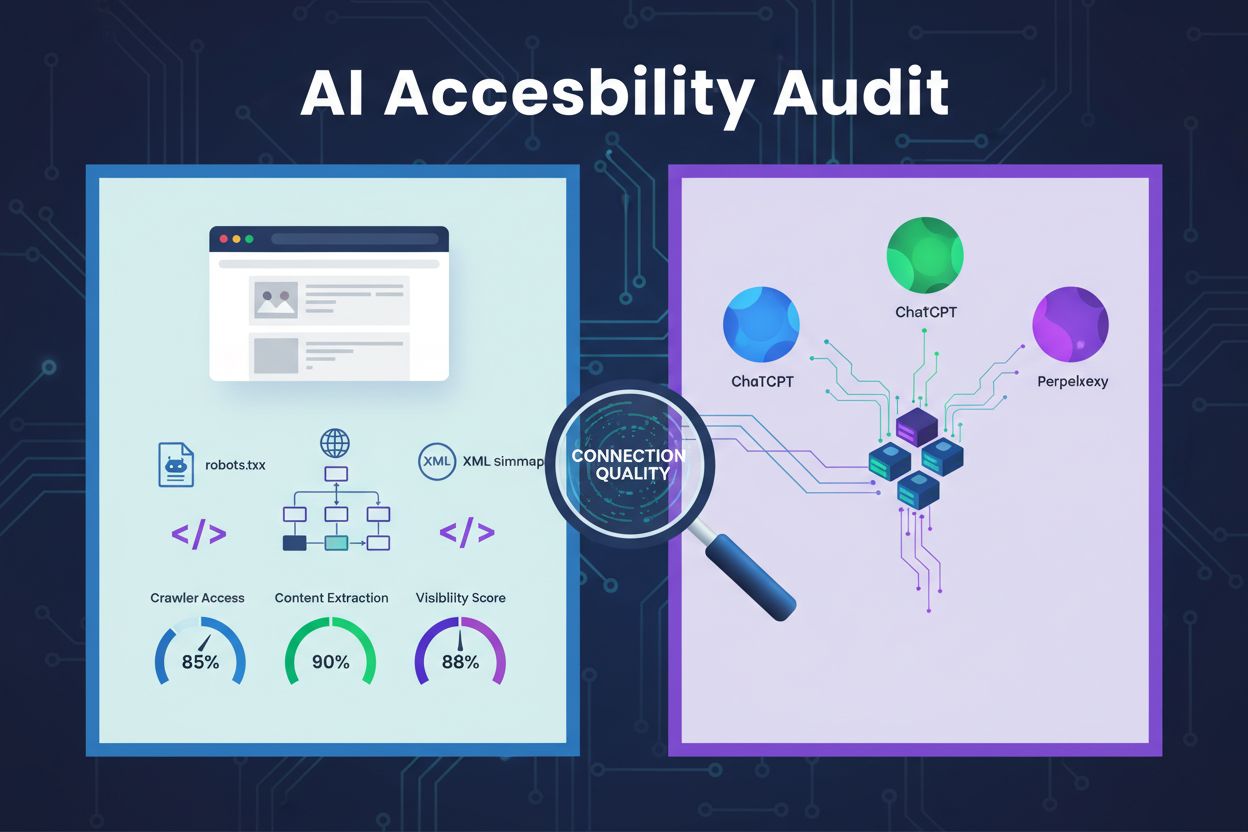

Una revisione tecnica dell’architettura del sito web, della configurazione e della struttura dei contenuti per determinare se i crawler AI possono accedere, comprendere ed estrarre efficacemente i contenuti. Valuta la configurazione di robots.txt, le sitemap XML, la crawlabilità del sito, il rendering JavaScript e la capacità di estrazione dei contenuti per garantire la visibilità sulle piattaforme di ricerca basate su AI come ChatGPT, Claude e Perplexity.

Una revisione tecnica dell'architettura del sito web, della configurazione e della struttura dei contenuti per determinare se i crawler AI possono accedere, comprendere ed estrarre efficacemente i contenuti. Valuta la configurazione di robots.txt, le sitemap XML, la crawlabilità del sito, il rendering JavaScript e la capacità di estrazione dei contenuti per garantire la visibilità sulle piattaforme di ricerca basate su AI come ChatGPT, Claude e Perplexity.

Un audit di accessibilità AI è una revisione tecnica dell’architettura, della configurazione e della struttura dei contenuti del tuo sito web per determinare se i crawler AI possono accedere, comprendere ed estrarre efficacemente i tuoi contenuti. A differenza dei tradizionali audit SEO focalizzati sulle classifiche delle parole chiave e sui backlink, gli audit di accessibilità AI esaminano le basi tecniche che permettono ai sistemi AI come ChatGPT, Claude e Perplexity di scoprire e citare i tuoi contenuti. Questo audit valuta componenti critiche tra cui la configurazione di robots.txt, le sitemap XML, la crawlabilità del sito, il rendering JavaScript e la capacità di estrazione dei contenuti per garantire che il tuo sito sia pienamente visibile nell’ecosistema di ricerca potenziato dall’AI.

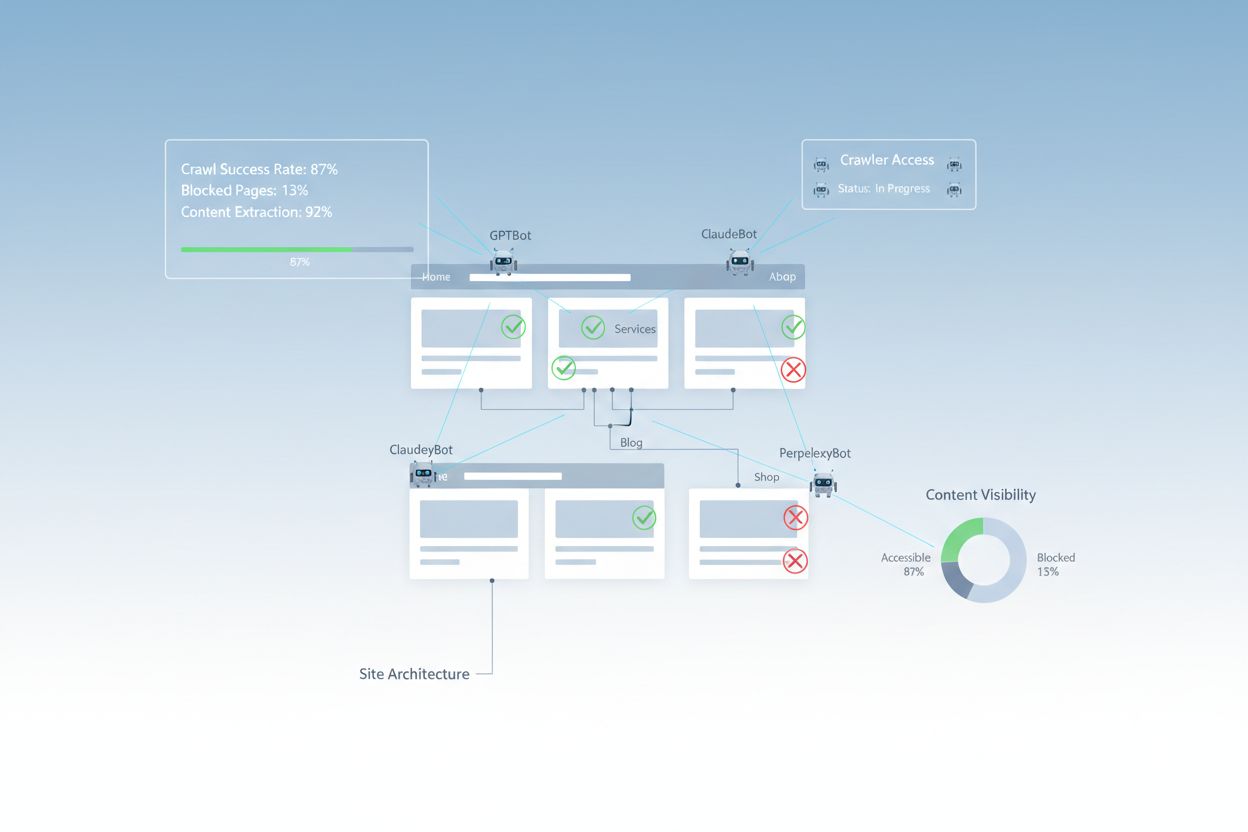

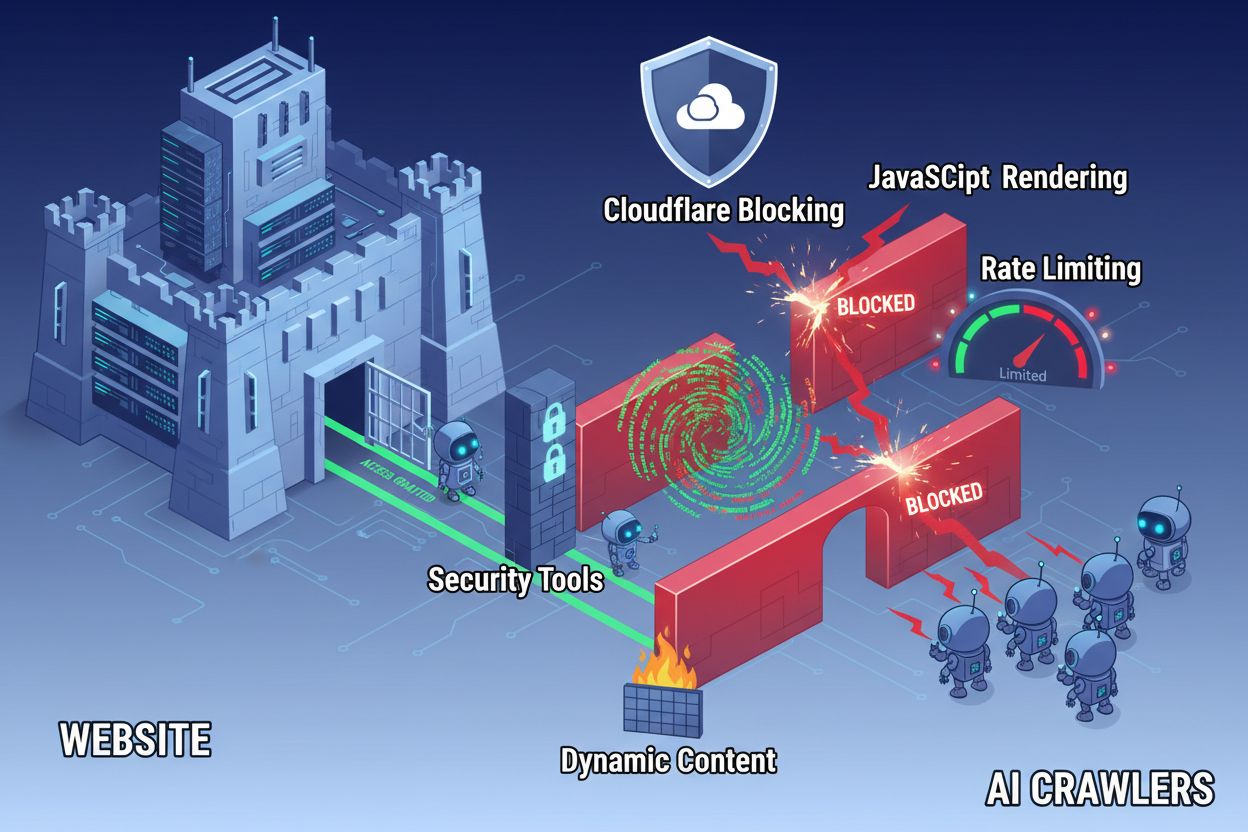

Nonostante i progressi della tecnologia web, i crawler AI incontrano notevoli barriere nell’accedere ai siti web moderni. La sfida principale è che molti siti contemporanei si basano fortemente sul rendering JavaScript per visualizzare dinamicamente i contenuti, ma la maggior parte dei crawler AI non può eseguire codice JavaScript. Questo significa che circa il 60-90% dei contenuti dei siti moderni rimane invisibile ai sistemi AI, anche se viene visualizzato perfettamente nei browser degli utenti. Inoltre, strumenti di sicurezza come Cloudflare bloccano i crawler AI di default, trattandoli come potenziali minacce invece che come bot di indicizzazione legittimi. Le ricerche dimostrano che il 35% dei siti enterprise blocca involontariamente i crawler AI, impedendo che contenuti preziosi vengano scoperti e citati dai sistemi AI.

Barriere comuni che impediscono l’accesso dei crawler AI:

Un audit di accessibilità AI completo esamina molteplici elementi tecnici e strutturali che influenzano il modo in cui i sistemi AI interagiscono con il tuo sito web. Ogni componente svolge un ruolo distinto nel determinare se i tuoi contenuti diventano visibili sulle piattaforme di ricerca basate su AI. Il processo di audit prevede test di crawlabilità, verifica dei file di configurazione, valutazione della struttura dei contenuti e monitoraggio del reale comportamento dei crawler. Valutando sistematicamente questi componenti, puoi identificare barriere specifiche e implementare soluzioni mirate per migliorare la tua visibilità AI.

| Componente | Scopo | Impatto sulla Visibilità AI |

|---|---|---|

| Configurazione Robots.txt | Controlla quali crawler possono accedere a specifiche sezioni del sito | Critico - Una configurazione errata blocca completamente i crawler AI |

| Sitemap XML | Guida i crawler verso le pagine e la struttura dei contenuti più importanti | Alto - Aiuta i sistemi AI a individuare e prioritizzare i contenuti |

| Crawlabilità del sito | Garantisce che le pagine siano accessibili senza autenticazione o navigazione complessa | Critico - Le pagine bloccate sono invisibili ai sistemi AI |

| Rendering JavaScript | Determina se i contenuti dinamici sono visibili ai crawler | Critico - Il 60-90% dei contenuti può essere ignorato senza pre-rendering |

| Estrazione dei contenuti | Valuta la facilità con cui i sistemi AI possono analizzare e comprendere i contenuti | Alto - Una struttura scadente riduce la probabilità di citazione |

| Configurazione strumenti di sicurezza | Gestisce firewall e regole di protezione che influenzano l’accesso dei crawler | Critico - Regole troppo restrittive bloccano i bot AI legittimi |

| Implementazione schema markup | Fornisce un contesto leggibile dalle macchine sui contenuti | Medio - Migliora la comprensione AI e la probabilità di citazione |

| Struttura di linking interna | Stabilisce relazioni semantiche tra le pagine | Medio - Aiuta l’AI a comprendere autorità e rilevanza dei temi |

Il tuo file robots.txt è il principale meccanismo di controllo su quali crawler possono accedere al tuo sito. Situato alla radice del dominio, questo semplice file di testo contiene direttive che indicano ai crawler se possono accedere a specifiche sezioni del sito. Per l’accessibilità AI, una configurazione corretta di robots.txt è fondamentale perché regole errate possono bloccare completamente i principali crawler AI come GPTBot (OpenAI), ClaudeBot (Anthropic) e PerplexityBot (Perplexity). La chiave è consentire esplicitamente questi crawler mantenendo la sicurezza bloccando i bot malevoli e proteggendo le aree sensibili.

Esempio di configurazione robots.txt per i crawler AI:

# Consenti tutti i crawler AI

User-agent: GPTBot

User-agent: ChatGPT-User

User-agent: ClaudeBot

User-agent: Claude-Web

User-agent: PerplexityBot

User-agent: Google-Extended

Allow: /

# Blocca le aree sensibili

Disallow: /admin/

Disallow: /private/

Disallow: /api/

# Sitemap

Sitemap: https://yoursite.com/sitemap.xml

Sitemap: https://yoursite.com/ai-sitemap.xml

Questa configurazione consente esplicitamente ai principali crawler AI di accedere ai tuoi contenuti pubblici, proteggendo al contempo le sezioni amministrative e private. Le direttive Sitemap aiutano i crawler a individuare rapidamente le pagine più importanti.

Una sitemap XML funge da mappa per i crawler, elencando gli URL che desideri siano indicizzati e fornendo metadati su ciascuna pagina. Per i sistemi AI, le sitemap sono particolarmente preziose perché aiutano i crawler a comprendere la struttura del sito, a prioritizzare i contenuti rilevanti e a scoprire pagine che altrimenti potrebbero sfuggire alla scansione tradizionale. A differenza dei motori di ricerca tradizionali che possono dedurre la struttura del sito tramite i link, i crawler AI beneficiano enormemente di indicazioni esplicite su quali pagine sono più importanti. Una sitemap ben strutturata e con metadati appropriati aumenta la probabilità che i tuoi contenuti vengano scoperti, compresi e citati dai sistemi AI.

Esempio di struttura sitemap XML per l’ottimizzazione AI:

<?xml version="1.0" encoding="UTF-8"?>

<urlset xmlns="http://www.sitemaps.org/schemas/sitemap/0.9">

<!-- Contenuti ad alta priorità per i crawler AI -->

<url>

<loc>https://yoursite.com/about</loc>

<lastmod>2025-01-03</lastmod>

<priority>1.0</priority>

</url>

<url>

<loc>https://yoursite.com/products</loc>

<lastmod>2025-01-03</lastmod>

<priority>0.9</priority>

</url>

<url>

<loc>https://yoursite.com/blog/ai-guide</loc>

<lastmod>2025-01-02</lastmod>

<priority>0.8</priority>

</url>

<url>

<loc>https://yoursite.com/faq</loc>

<lastmod>2025-01-01</lastmod>

<priority>0.7</priority>

</url>

</urlset>

L’attributo priority segnala ai crawler AI quali pagine sono più importanti, mentre lastmod indica la freschezza dei contenuti. Questo aiuta i sistemi AI a distribuire efficacemente le risorse di scansione e a comprendere la gerarchia dei tuoi contenuti.

Oltre ai file di configurazione, esistono diverse barriere tecniche che possono impedire ai crawler AI di accedere efficacemente ai tuoi contenuti. Il rendering JavaScript rimane la sfida più significativa, poiché i moderni framework web come React, Vue e Angular generano contenuti in modo dinamico nel browser, lasciando i crawler AI con HTML vuoto. Cloudflare e strumenti di sicurezza simili spesso bloccano i crawler AI di default, trattando i loro volumi elevati di richieste come potenziali attacchi. Limitazioni di frequenza possono impedire un’indicizzazione completa, mentre architetture di sito complesse e caricamento dinamico dei contenuti complicano ulteriormente l’accesso dei crawler. Fortunatamente, esistono numerose soluzioni per superare queste barriere.

Soluzioni per migliorare l’accesso dei crawler AI:

I sistemi AI non hanno solo bisogno di accedere ai tuoi contenuti—devono anche comprenderli. L’estrazione dei contenuti si riferisce a quanto efficacemente i crawler AI possono analizzare, comprendere ed estrarre informazioni significative dalle tue pagine. Questo processo dipende fortemente dalla struttura HTML semantica, che utilizza una gerarchia corretta di heading, testi descrittivi e organizzazione logica per trasmettere significato. Quando i tuoi contenuti sono ben strutturati con heading chiari (H1, H2, H3), paragrafi descrittivi e flusso logico, i sistemi AI possono più facilmente identificare le informazioni chiave e comprendere il contesto. Inoltre, lo schema markup fornisce metadati leggibili dalle macchine che comunicano esplicitamente ai sistemi AI di cosa trattano i tuoi contenuti, migliorando notevolmente la comprensione e la probabilità di citazione.

Una struttura semantica corretta include anche l’uso di elementi HTML semantici come <article>, <section>, <nav> e <aside> invece dei generici <div>. Questo aiuta i sistemi AI a comprendere la funzione e l’importanza delle diverse sezioni di contenuto. Se combinato con dati strutturati come FAQ schema, Product schema o Organization schema, i tuoi contenuti diventano molto più accessibili ai sistemi AI, aumentando la probabilità di essere citati nelle risposte AI generate.

Dopo aver implementato le migliorie, è necessario verificare che i crawler AI possano effettivamente accedere ai tuoi contenuti e monitorare le prestazioni nel tempo. I log del server forniscono prove dirette dell’attività dei crawler, mostrando quali bot hanno visitato il sito, quali pagine hanno accesso e se hanno riscontrato errori. Google Search Console offre insight su come i crawler di Google interagiscono con il tuo sito, mentre strumenti di monitoraggio della visibilità AI tengono traccia di come i tuoi contenuti appaiono sulle diverse piattaforme AI. AmICited.com monitora specificamente come i sistemi AI fanno riferimento al tuo brand su ChatGPT, Perplexity e Google AI Overviews, fornendo visibilità su quali pagine vengono citate e con quale frequenza.

Strumenti e metodi per monitorare l’accesso dei crawler AI:

Ottimizzare il tuo sito per l’accesso dei crawler AI richiede un approccio strategico e continuativo. Invece di trattare l’accessibilità AI come un progetto una tantum, le organizzazioni di successo implementano processi di monitoraggio e miglioramento continuo. La strategia più efficace combina una corretta configurazione tecnica con l’ottimizzazione dei contenuti, assicurando che sia l’infrastruttura che i contenuti siano pronti per l’AI.

Cosa fare per l’accessibilità AI:

Cosa non fare per l’accessibilità AI:

La strategia di accessibilità AI di maggior successo tratta i crawler come partner nella distribuzione dei contenuti, non come minacce da bloccare. Garantendo che il sito sia tecnicamente solido, correttamente configurato e semanticamente chiaro, massimizzi la probabilità che i sistemi AI scoprano, comprendano e citino i tuoi contenuti nelle risposte agli utenti.

Gli audit di accessibilità AI si concentrano sulla struttura semantica, sui contenuti leggibili dalle macchine e sulla citabilità per i sistemi AI, mentre gli audit SEO tradizionali enfatizzano le parole chiave, i backlink e il posizionamento nei motori di ricerca. Gli audit AI esaminano se i crawler riescono ad accedere e comprendere i tuoi contenuti, mentre gli audit SEO si focalizzano sui fattori di ranking nei risultati di Google.

Controlla i log del server per individuare user agent di crawler AI come GPTBot, ClaudeBot e PerplexityBot. Usa Google Search Console per monitorare l’attività di scansione, testa il tuo file robots.txt con strumenti di validazione e utilizza piattaforme specializzate come AmICited per tracciare come i sistemi AI fanno riferimento ai tuoi contenuti sulle diverse piattaforme.

Le barriere più comuni includono limitazioni nel rendering JavaScript (i crawler AI non possono eseguire JavaScript), blocco da parte di Cloudflare e strumenti di sicurezza (il 35% dei siti enterprise blocca i crawler AI), limitazioni di frequenza che impediscono l’indicizzazione completa, architetture di sito complesse e caricamento dinamico dei contenuti. Ogni barriera richiede soluzioni differenti.

La maggior parte delle aziende trae beneficio dal consentire i crawler AI, poiché aumentano la visibilità del brand nei risultati di ricerca AI e nelle interfacce conversazionali. Tuttavia, la decisione dipende dalla tua strategia di contenuto, dal posizionamento competitivo e dagli obiettivi aziendali. Puoi usare robots.txt per consentire selettivamente alcuni crawler e bloccarne altri in base alle tue necessità specifiche.

Esegui un audit completo ogni trimestre o quando apporti modifiche significative all’architettura del sito, alla strategia di contenuto o alla configurazione della sicurezza. Monitora continuamente l’attività dei crawler tramite i log del server e strumenti specializzati. Aggiorna robots.txt e le sitemap ogni volta che lanci nuove sezioni di contenuto o modifichi la struttura degli URL.

Robots.txt è il tuo principale meccanismo di controllo dell’accesso dei crawler AI. Una configurazione corretta consente esplicitamente i principali crawler AI (GPTBot, ClaudeBot, PerplexityBot) proteggendo al contempo le aree sensibili. Un robots.txt configurato male può bloccare completamente i crawler AI, rendendo i tuoi contenuti invisibili ai sistemi AI indipendentemente dalla loro qualità.

Sebbene l’ottimizzazione tecnica sia importante, puoi migliorare la visibilità AI anche attraverso l’ottimizzazione dei contenuti—utilizzando una struttura HTML semantica, implementando lo schema markup, migliorando la link interna e assicurando la completezza dei contenuti. Tuttavia, barriere tecniche come il rendering JavaScript e il blocco da parte di strumenti di sicurezza richiedono solitamente soluzioni tecniche per una piena accessibilità AI.

Utilizza l’analisi dei log del server per tracciare l’attività dei crawler, Google Search Console per le statistiche di scansione, i validator robots.txt per verificare la configurazione, i validator di schema markup per i dati strutturati e piattaforme specializzate come AmICited per monitorare le citazioni AI. Molti strumenti SEO come Screaming Frog offrono anche capacità di simulazione dei crawler per testare l’accessibilità AI.

Traccia come ChatGPT, Perplexity, Google AI Overviews e altri sistemi AI fanno riferimento al tuo brand con AmICited. Ottieni insight in tempo reale sulla tua visibilità nella ricerca AI e ottimizza la tua strategia di contenuto.

Scopri la metodologia completa passo dopo passo per condurre un audit di visibilità AI. Scopri come misurare le menzioni del marchio, le citazioni e la visibili...

Scopri cosa sono gli Audit Competitivi AI, perché sono importanti per il posizionamento competitivo e come analizzare la visibilità dei concorrenti su ChatGPT, ...

Scopri come eseguire un audit dell'accesso dei crawler AI al tuo sito web. Scopri quali bot possono vedere i tuoi contenuti e risolvi i blocchi che impediscono ...