URL canonici e AI: prevenire problemi di contenuti duplicati

Scopri come gli URL canonici prevengono i problemi di contenuti duplicati nei sistemi di ricerca AI. Scopri le migliori pratiche per implementare i canonici, mi...

La logica di deduplicazione AI si riferisce ai processi e agli algoritmi automatizzati che i sistemi di intelligenza artificiale utilizzano per identificare, analizzare ed eliminare informazioni ridondanti o duplicate provenienti da più fonti. Questi sistemi impiegano tecniche di apprendimento automatico, elaborazione del linguaggio naturale e confronto di similarità per riconoscere contenuti identici o altamente simili attraverso diversi archivi di dati, garantendo la qualità dei dati, riducendo i costi di archiviazione e migliorando l’accuratezza delle decisioni.

La logica di deduplicazione AI si riferisce ai processi e agli algoritmi automatizzati che i sistemi di intelligenza artificiale utilizzano per identificare, analizzare ed eliminare informazioni ridondanti o duplicate provenienti da più fonti. Questi sistemi impiegano tecniche di apprendimento automatico, elaborazione del linguaggio naturale e confronto di similarità per riconoscere contenuti identici o altamente simili attraverso diversi archivi di dati, garantendo la qualità dei dati, riducendo i costi di archiviazione e migliorando l'accuratezza delle decisioni.

La logica di deduplicazione AI è un processo algoritmico sofisticato che identifica ed elimina record duplicati o quasi duplicati da grandi insiemi di dati utilizzando tecniche di intelligenza artificiale e apprendimento automatico. Questa tecnologia rileva automaticamente quando più voci rappresentano la stessa entità—che si tratti di una persona, un prodotto, un documento o un’informazione—nonostante variazioni di formattazione, ortografia o presentazione. Lo scopo principale della deduplicazione è mantenere l’integrità dei dati e prevenire la ridondanza che può distorcere le analisi, aumentare i costi di archiviazione e compromettere l’accuratezza delle decisioni. Nell’attuale mondo guidato dai dati, in cui le organizzazioni elaborano milioni di record ogni giorno, una deduplicazione efficace è diventata essenziale per l’efficienza operativa e per ottenere informazioni affidabili.

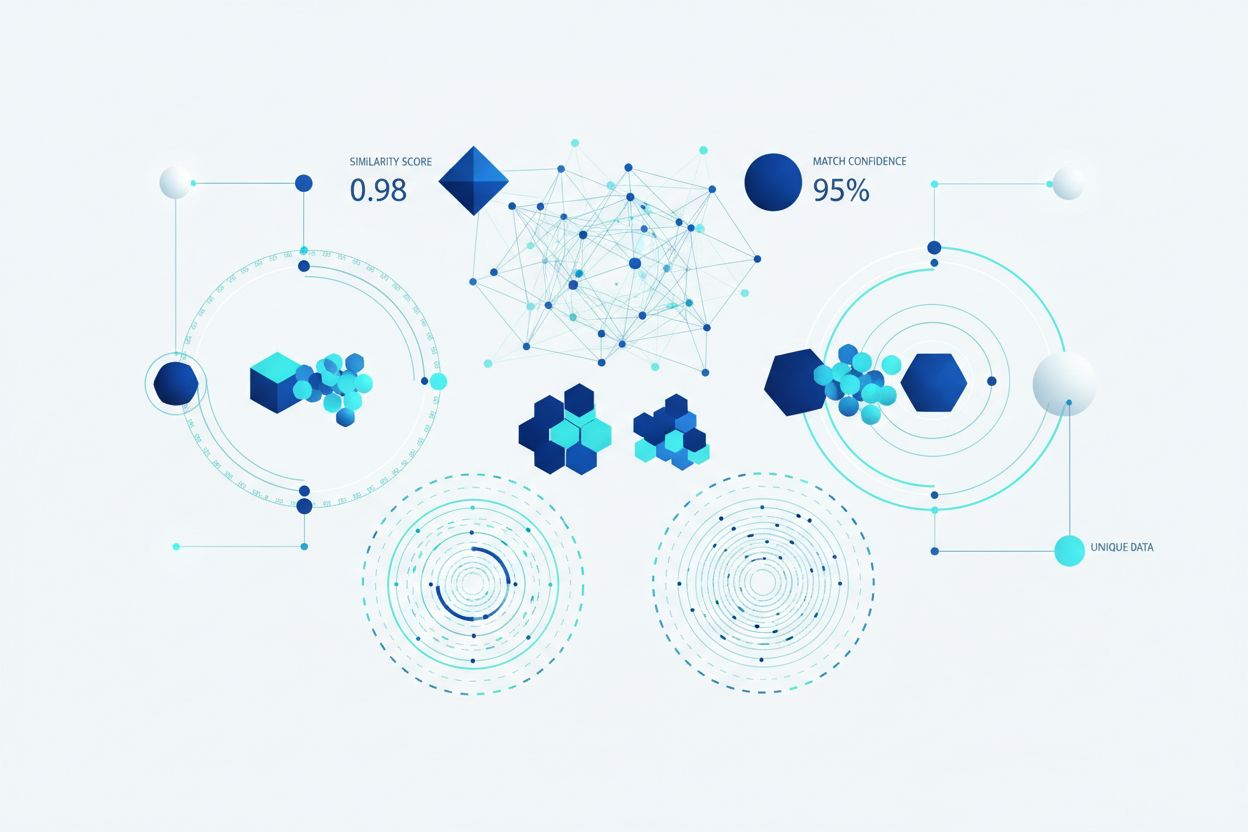

La deduplicazione AI impiega molteplici tecniche complementari per identificare e raggruppare record simili con notevole precisione. Il processo inizia analizzando attributi dei dati—come nomi, indirizzi, email e altri identificatori—e confrontandoli rispetto a soglie di similarità predefinite. I sistemi di deduplicazione moderni utilizzano una combinazione di matching fonetico, algoritmi di similarità delle stringhe e analisi semantica per individuare duplicati che i sistemi tradizionali basati su regole potrebbero non rilevare. Il sistema assegna punteggi di similarità alle potenziali corrispondenze, raggruppando i record che superano la soglia configurata in gruppi rappresentanti la stessa entità. Gli utenti mantengono il controllo sul livello di inclusività della deduplicazione, potendo regolare la sensibilità in base al caso d’uso specifico e alla tolleranza per i falsi positivi.

| Metodo | Descrizione | Ideale per |

|---|---|---|

| Similarità Fonetica | Raggruppa stringhe che suonano simili (es. “Smith” vs “Smyth”) | Variazioni di nomi, confusioni fonetiche |

| Similarità Ortografica | Raggruppa stringhe simili nell’ortografia | Refusi, leggere variazioni ortografiche |

| Similarità TFIDF | Applica l’algoritmo term frequency-inverse document frequency | Matching di testo generico, similarità tra documenti |

Il motore di deduplicazione processa i record in più passaggi, identificando dapprima le corrispondenze ovvie e poi esaminando progressivamente le variazioni più sottili. Questo approccio a livelli garantisce una copertura completa mantenendo l’efficienza computazionale, anche quando si elaborano dataset con milioni di record.

La deduplicazione AI moderna sfrutta embeddings vettoriali e analisi semantica per comprendere il significato dei dati invece di confrontare solo le caratteristiche superficiali. L’Elaborazione del Linguaggio Naturale (NLP) permette ai sistemi di comprendere contesto e intenzione, consentendo di riconoscere che “Roberto”, “Bob” e “Rob” si riferiscono alla stessa persona nonostante le forme diverse. Gli algoritmi di fuzzy matching calcolano la distanza di modifica tra stringhe, identificando record che differiscono solo di pochi caratteri—fondamentale per cogliere refusi ed errori di trascrizione. Il sistema analizza anche metadati come timestamp, date di creazione e cronologia delle modifiche per fornire segnali di fiducia aggiuntivi nella determinazione dei duplicati. Le implementazioni avanzate incorporano modelli di apprendimento automatico addestrati su dataset etichettati, migliorando continuamente la precisione man mano che elaborano nuovi dati e ricevono feedback sulle decisioni di deduplicazione.

La logica di deduplicazione AI è diventata indispensabile praticamente in ogni settore che gestisce grandi operazioni di dati. Le organizzazioni sfruttano questa tecnologia per mantenere dataset puliti e affidabili che alimentano analisi accurate e decisioni informate. Le applicazioni pratiche coprono numerose funzioni aziendali critiche:

Queste applicazioni dimostrano come la deduplicazione abbia un impatto diretto su conformità, prevenzione delle frodi e integrità operativa in settori diversi.

I benefici finanziari e operativi della deduplicazione AI sono sostanziali e misurabili. Le organizzazioni possono ridurre significativamente i costi di archiviazione eliminando dati ridondanti, con alcune implementazioni che raggiungono riduzioni del 20-40% nei requisiti di storage. Una migliore qualità dei dati si traduce direttamente in analisi e decisioni più affidabili, poiché le analisi basate su dati puliti producono intuizioni e previsioni più attendibili. Ricerche indicano che i data scientist spendono circa l’80% del loro tempo nella preparazione dei dati, con i record duplicati che rappresentano una delle principali cause di questo onere—l’automazione della deduplicazione libera tempo analitico per attività a maggior valore. Studi mostrano che il 10-30% dei record nei database tipici sono duplicati, una fonte significativa di inefficienza ed errore. Oltre alla riduzione dei costi, la deduplicazione rafforza la conformità e l’aderenza normativa assicurando una registrazione accurata e prevenendo invii duplicati che potrebbero causare audit o sanzioni. I guadagni in efficienza operativa si estendono a prestazioni di query più rapide, minore carico computazionale e maggiore affidabilità dei sistemi.

Nonostante la sua sofisticazione, la deduplicazione AI presenta sfide e limiti che le organizzazioni devono gestire con attenzione. I falsi positivi—identificare erroneamente come duplicati record distinti—possono causare perdita di dati o unione di record che dovrebbero rimanere separati, mentre i falsi negativi permettono ai duplicati reali di sfuggire al rilevamento. La deduplicazione diventa esponenzialmente più complessa quando si gestiscono dati multi-formato provenienti da sistemi, lingue e strutture diversi, ciascuno con convenzioni di formattazione e standard di codifica propri. Questioni di privacy e sicurezza sorgono quando la deduplicazione richiede l’analisi di informazioni personali sensibili, rendendo necessarie robuste crittografie e controlli di accesso per proteggere i dati durante il matching. L’accuratezza dei sistemi di deduplicazione resta fondamentalmente limitata dalla qualità dei dati in ingresso: se i dati sono di scarsa qualità, anche gli algoritmi più avanzati possono essere confusi da record incompleti o corrotti.

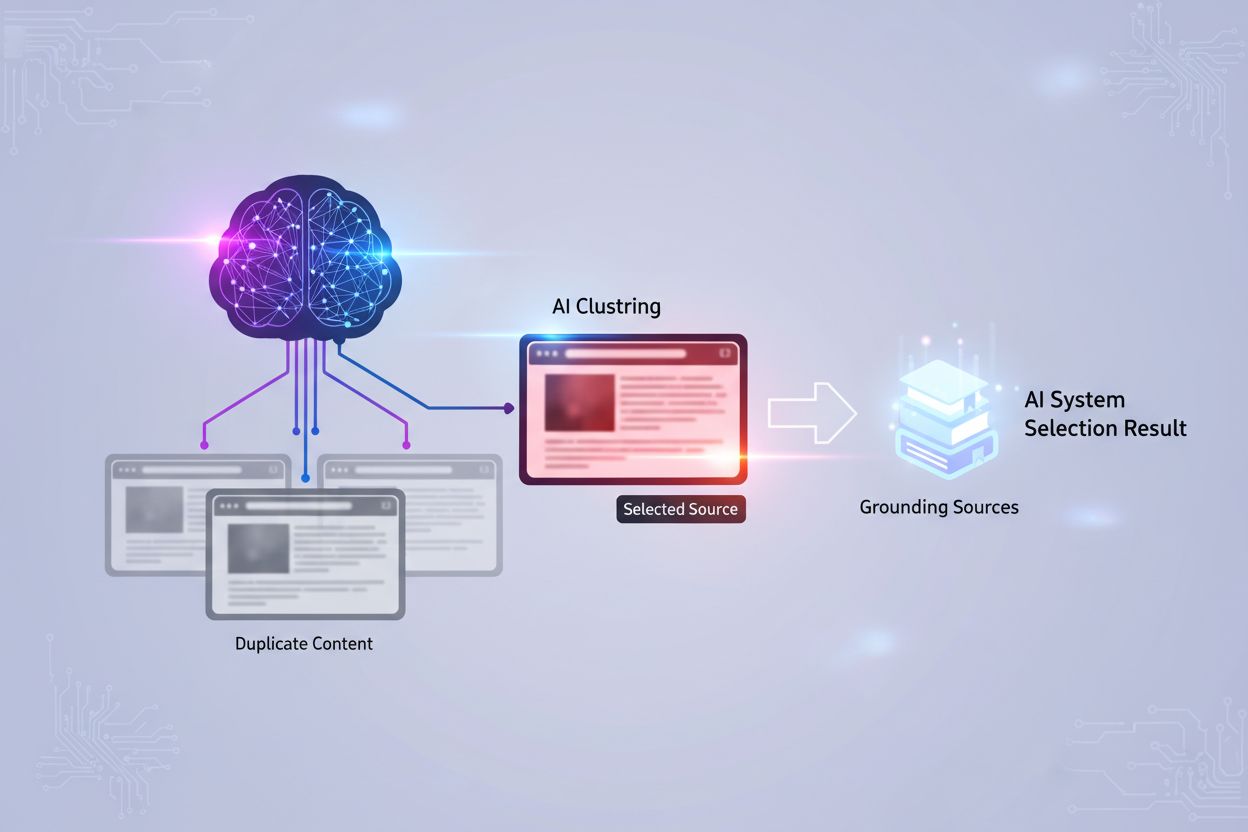

La deduplicazione AI è diventata un componente fondamentale nelle moderne piattaforme di monitoraggio delle risposte AI e nei sistemi di ricerca che aggregano informazioni da più fonti. Quando i sistemi AI sintetizzano risposte da numerosi documenti e fonti, la deduplicazione garantisce che la stessa informazione non venga contata più volte, evitando di gonfiare artificialmente i punteggi di fiducia e distorcere le classifiche di rilevanza. L’attribuzione delle fonti diventa più significativa quando la deduplicazione elimina le fonti ridondanti, consentendo agli utenti di vedere la reale diversità delle prove a sostegno di una risposta. Piattaforme come AmICited.com utilizzano la logica di deduplicazione per fornire un tracciamento trasparente e accurato delle fonti identificando quando più fonti contengono essenzialmente le stesse informazioni e consolidandole in modo appropriato. Questo impedisce che le risposte AI appaiano supportate da un consenso più ampio di quanto non sia realmente, mantenendo l’integrità dell’attribuzione delle fonti e della credibilità delle risposte. Filtrando le fonti duplicate, la deduplicazione migliora la qualità dei risultati di ricerca dell’AI e assicura che gli utenti ricevano prospettive realmente diverse, invece di varianti delle stesse informazioni ripetute su più fonti. La tecnologia rafforza infine la fiducia nei sistemi AI fornendo rappresentazioni più pulite e oneste delle prove alla base delle risposte generate dall’intelligenza artificiale.

La deduplicazione AI e la compressione dei dati riducono entrambe il volume di dati, ma funzionano in modo diverso. La deduplicazione identifica e rimuove record esatti o quasi duplicati, mantenendo una sola istanza e sostituendo le altre con riferimenti. La compressione dei dati, invece, codifica i dati in modo più efficiente senza rimuovere i duplicati. La deduplicazione opera a livello macro (interi file o record), mentre la compressione opera a livello micro (singoli bit e byte). Per le organizzazioni con molti dati duplicati, la deduplicazione offre solitamente risparmi di archiviazione maggiori.

L'AI utilizza molteplici tecniche sofisticate per individuare duplicati non esatti. Gli algoritmi fonetici riconoscono nomi che suonano simili (ad es. 'Smith' vs 'Smyth'). Il fuzzy matching calcola la distanza di modifica per trovare record che differiscono solo di pochi caratteri. Gli embeddings vettoriali convertono il testo in rappresentazioni matematiche che catturano il significato semantico, consentendo al sistema di riconoscere contenuti parafrasati. Modelli di apprendimento automatico addestrati su set di dati etichettati apprendono gli schemi di ciò che costituisce un duplicato in contesti specifici. Queste tecniche lavorano insieme per identificare duplicati nonostante variazioni di ortografia, formattazione o presentazione.

La deduplicazione può ridurre significativamente i costi di archiviazione eliminando i dati ridondanti. Le organizzazioni ottengono tipicamente riduzioni del 20-40% nei requisiti di archiviazione dopo aver implementato una deduplicazione efficace. Questi risparmi si sommano nel tempo man mano che i nuovi dati vengono continuamente deduplicati. Oltre alla riduzione diretta dei costi di archiviazione, la deduplicazione riduce anche le spese associate alla gestione dei dati, alle operazioni di backup e alla manutenzione dei sistemi. Per le grandi aziende che elaborano milioni di record, questi risparmi possono raggiungere centinaia di migliaia di euro all'anno, rendendo la deduplicazione un investimento ad alto ritorno.

Sì, i moderni sistemi di deduplicazione AI possono funzionare su diversi formati di file, anche se ciò richiede una elaborazione più sofisticata. Il sistema deve prima normalizzare i dati da vari formati (PDF, documenti Word, fogli di calcolo, database, ecc.) in una struttura comparabile. Le implementazioni avanzate utilizzano il riconoscimento ottico dei caratteri (OCR) per i documenti scansionati e parser specifici per il formato per estrarre contenuti significativi. Tuttavia, la precisione della deduplicazione può variare a seconda della complessità del formato e della qualità dei dati. Le organizzazioni ottengono in genere i migliori risultati quando la deduplicazione viene applicata a dati strutturati in formati coerenti, sebbene la deduplicazione cross-formato sia sempre più possibile con le moderne tecniche AI.

La deduplicazione migliora i risultati di ricerca dell'AI garantendo che le classifiche di rilevanza riflettano una reale diversità delle fonti piuttosto che variazioni delle stesse informazioni. Quando più fonti contengono contenuti identici o quasi identici, la deduplicazione le consolida, evitando un'inflazione artificiale dei punteggi di fiducia. Questo offre agli utenti rappresentazioni più pulite e oneste delle prove a sostegno delle risposte generate dall'AI. La deduplicazione migliora anche le prestazioni di ricerca riducendo il volume di dati che il sistema deve elaborare, consentendo risposte alle query più rapide. Filtrando le fonti ridondanti, i sistemi AI possono concentrarsi su prospettive e informazioni realmente diverse, offrendo infine risultati di qualità superiore e più affidabili.

I falsi positivi si verificano quando la deduplicazione identifica erroneamente come duplicati dei record distinti e li unisce. Ad esempio, unendo record per 'John Smith' e 'Jane Smith' che sono persone diverse ma condividono il cognome. I falsi positivi sono problematici perché comportano una perdita permanente di dati: una volta che i record vengono uniti, recuperare le informazioni originali distinte diventa difficile o impossibile. In applicazioni critiche come la sanità o i servizi finanziari, i falsi positivi possono avere conseguenze gravi, tra cui storie cliniche errate o transazioni fraudolente. Le organizzazioni devono calibrare attentamente la sensibilità della deduplicazione per minimizzare i falsi positivi, spesso accettando alcuni falsi negativi (duplicati non rilevati) come compromesso più sicuro.

La deduplicazione è essenziale per le piattaforme di monitoraggio dei contenuti AI come AmICited, che tracciano come i sistemi AI fanno riferimento a brand e fonti. Quando si monitora le risposte AI su più piattaforme (GPTs, Perplexity, Google AI), la deduplicazione impedisce che la stessa fonte venga conteggiata più volte se appare in sistemi o formati diversi. Questo garantisce un'attribuzione accurata e previene metriche di visibilità gonfiate. La deduplicazione aiuta anche a identificare quando i sistemi AI attingono da un numero limitato di fonti pur dando l'impressione di una diversità di prove. Consolidando le fonti duplicate, le piattaforme di monitoraggio forniscono informazioni più chiare su quali fonti uniche stanno effettivamente influenzando le risposte AI.

I metadati — informazioni sui dati come date di creazione, orari di modifica, informazioni sull'autore e proprietà dei file — svolgono un ruolo cruciale nel rilevamento dei duplicati. I metadati aiutano a stabilire il ciclo di vita dei record, rivelando quando i documenti sono stati creati, aggiornati o consultati. Queste informazioni temporali aiutano a distinguere tra versioni legittime di documenti in evoluzione e veri duplicati. Le informazioni sull'autore e le associazioni dipartimentali forniscono contesto sull'origine e lo scopo del record. I modelli di accesso indicano se i documenti sono attivamente utilizzati o obsoleti. I sistemi di deduplicazione avanzati integrano l'analisi dei metadati con quella dei contenuti, utilizzando entrambi i segnali per determinare in modo più accurato i duplicati e identificare quale versione conservare come fonte autorevole.

AmICited traccia come i sistemi AI come GPTs, Perplexity e Google AI fanno riferimento al tuo brand su più fonti. Garantisci un'attribuzione accurata delle fonti e previeni che contenuti duplicati distorcano la visibilità del tuo brand nell'AI.

Scopri come gli URL canonici prevengono i problemi di contenuti duplicati nei sistemi di ricerca AI. Scopri le migliori pratiche per implementare i canonici, mi...

Scopri come gestire e prevenire i contenuti duplicati quando utilizzi strumenti di IA. Scopri tag canonici, reindirizzamenti, strumenti di rilevamento e best pr...

Scopri come la ripubblicazione dei contenuti genera problemi di contenuto duplicato che danneggiano la visibilità nella ricerca AI più gravemente rispetto alla ...