Come configurare robots.txt per i crawler AI: guida completa

Scopri come configurare robots.txt per controllare l'accesso dei crawler AI, inclusi GPTBot, ClaudeBot e Perplexity. Gestisci la visibilità del tuo brand nelle ...

Configurazione di robots.txt con regole user-agent specificatamente rivolte ai crawler AI. Il robots.txt specifico per l’AI consente ai proprietari di siti web di controllare come i sistemi di intelligenza artificiale, i grandi modelli linguistici e i bot di addestramento AI accedono e utilizzano i loro contenuti. Distingue tra diversi tipi di crawler AI—crawler di addestramento, crawler di ricerca e fetcher attivati dall’utente—permettendo un controllo granulare sulla visibilità dei contenuti ai sistemi AI. Questa configurazione è diventata fondamentale poiché i crawler AI rappresentano ora circa l'80% del traffico bot su molti siti web.

Configurazione di robots.txt con regole user-agent specificatamente rivolte ai crawler AI. Il robots.txt specifico per l'AI consente ai proprietari di siti web di controllare come i sistemi di intelligenza artificiale, i grandi modelli linguistici e i bot di addestramento AI accedono e utilizzano i loro contenuti. Distingue tra diversi tipi di crawler AI—crawler di addestramento, crawler di ricerca e fetcher attivati dall'utente—permettendo un controllo granulare sulla visibilità dei contenuti ai sistemi AI. Questa configurazione è diventata fondamentale poiché i crawler AI rappresentano ora circa l'80% del traffico bot su molti siti web.

La configurazione di robots.txt specifica per l’AI si riferisce alla pratica di creare regole mirate all’interno del proprio file robots.txt che si rivolgono specificamente ai crawler di intelligenza artificiale e ai bot di addestramento, distinti dai tradizionali crawler dei motori di ricerca come Googlebot. Mentre il robots.txt convenzionale si è storicamente concentrato sulla gestione di Googlebot, Bingbot e altri indicizzatori di ricerca, l’emergere di grandi modelli linguistici e sistemi di addestramento AI ha creato una categoria completamente nuova di traffico bot che richiede strategie di gestione separate. Secondo dati recenti del novembre 2025, i crawler AI rappresentano ora circa l’80% di tutto il traffico bot su molti siti di editori, spostando radicalmente l’importanza della configurazione di robots.txt da semplice strumento SEO a meccanismo critico di protezione dei contenuti. La distinzione è fondamentale perché i crawler di addestramento AI operano secondo modelli di business diversi dai motori di ricerca: raccolgono dati per addestrare modelli proprietari invece che per generare traffico di referral, rendendo il tradizionale compromesso di consentire i crawler in cambio di visibilità nella ricerca non più applicabile. Per gli editori, ciò significa che le decisioni su robots.txt influiscono ora direttamente sulla visibilità dei contenuti ai sistemi AI, sul potenziale utilizzo non autorizzato di contenuti proprietari nei dataset di addestramento e sulle implicazioni complessive di traffico e ricavi derivanti dalla scoperta AI.

I crawler AI si suddividono in tre distinte categorie operative, ciascuna con caratteristiche, impatti sul traffico e considerazioni strategiche differenti per gli editori. I crawler di addestramento sono progettati per raccogliere grandi volumi di dati testuali per lo sviluppo di modelli di machine learning; operano tipicamente con elevati requisiti di banda, generano notevole carico sul server e non forniscono traffico di referral in cambio—esempi sono GPTBot di OpenAI e ClaudeBot di Anthropic. I crawler di ricerca e citazione funzionano in modo simile ai motori di ricerca tradizionali indicizzando i contenuti e fornendo attribuzione; generano volumi di traffico moderati e possono portare traffico di referral tramite citazioni e link—questa categoria include OAI-SearchBot di OpenAI e il crawler AI Overviews di Google. I crawler attivati dall’utente operano su richiesta quando gli utenti finali richiedono esplicitamente l’analisi AI di una pagina web, come la capacità di ChatGPT di navigare nel web o le funzioni di analisi documentale di Claude; questi generano volumi di traffico inferiori ma rappresentano un coinvolgimento diretto degli utenti con i tuoi contenuti. La categorizzazione è strategicamente importante perché i crawler di addestramento presentano le maggiori preoccupazioni di protezione dei contenuti senza benefici commerciali, i crawler di ricerca offrono un compromesso con potenziale di referral, e i crawler attivati dall’utente sono generalmente in linea con l’intenzione dell’utente e possono aumentare la visibilità dei contenuti.

| Categoria Crawler | Scopo | Volume di traffico | Potenziale referral | Rischio contenuti | Esempi |

|---|---|---|---|---|---|

| Addestramento | Sviluppo modelli | Molto Alto | Nessuno | Molto Alto | GPTBot, ClaudeBot |

| Ricerca/Citazione | Indicizzazione & attribuzione contenuti | Moderato | Moderato | Moderato | OAI-SearchBot, Google AI |

| Attivato Utente | Analisi on-demand | Basso | Basso | Basso | ChatGPT Web Browse, Claude |

Le principali aziende AI che gestiscono crawler includono OpenAI, Anthropic, Google, Meta, Apple e Amazon, ciascuna con stringhe user-agent distinte che consentono di identificarle nei log del server e nella configurazione di robots.txt. OpenAI gestisce diversi crawler: GPTBot (user-agent: GPTBot/1.0) per la raccolta di dati di addestramento, OAI-SearchBot (user-agent: OAI-SearchBot/1.0) per l’indicizzazione di ricerca e citazione, e ChatGPT-User (user-agent: ChatGPT-User/1.0) per la navigazione web attivata dall’utente. Il principale crawler di Anthropic è ClaudeBot (user-agent: Claude-Web/1.0 o anthropic-ai) utilizzato per addestramento e sviluppo della knowledge base. Google gestisce Google-Extended (user-agent: Google-Extended/1.1) per Gemini e altri prodotti AI, mentre Meta utilizza facebookexternalhit per l’analisi dei contenuti, Apple gestisce AppleBot per Siri e funzionalità di ricerca, e Amazon usa Amazonbot per Alexa e funzionalità di ricerca. Per identificare questi crawler nei log del server, esamina l’intestazione User-Agent nelle richieste HTTP: la maggior parte dei crawler AI legittimi include il nome dell’azienda e il numero di versione in questo campo. Per una maggiore sicurezza, puoi verificare la legittimità dei crawler controllando l’indirizzo IP richiedente rispetto agli intervalli IP pubblicati da ciascuna azienda; OpenAI pubblica i propri intervalli IP, così come Google e altri grandi provider, permettendo di distinguere tra crawler autentici e user-agent falsificati.

La sintassi di base per le regole robots.txt specifiche per AI segue il formato standard di robots.txt con corrispondenza user-agent e direttive allow/disallow mirate a specifici crawler. Per bloccare il GPTBot di OpenAI dalla raccolta dati di addestramento consentendo invece il loro crawler di ricerca, la struttura del tuo robots.txt sarà la seguente:

User-agent: GPTBot

Disallow: /

User-agent: OAI-SearchBot

Allow: /

Per un controllo più granulare, puoi applicare regole specifiche per percorso che bloccano alcune sezioni consentendone altre—ad esempio, bloccare i crawler AI dall’accesso ai contenuti a pagamento o alle sezioni di contenuti generati dagli utenti:

User-agent: GPTBot

Disallow: /premium/

Disallow: /user-content/

Allow: /public-articles/

User-agent: ClaudeBot

Disallow: /

Puoi raggruppare più user-agent sotto un unico set di regole per applicare restrizioni identiche a più crawler, riducendo la complessità della configurazione. Il test e la validazione della configurazione robots.txt sono fondamentali; strumenti come il tester robots.txt di Google Search Console e validatori di terze parti possono verificare che le regole siano sintatticamente corrette e interpretate come previsto dai crawler. Ricorda che robots.txt è consultivo e non vincolante: i crawler conformi rispetteranno queste regole, ma attori malevoli o bot non conformi potrebbero ignorarle del tutto, rendendo necessari ulteriori meccanismi di enforcement a livello server per i contenuti sensibili.

La decisione di bloccare o consentire i crawler AI comporta compromessi fondamentali tra protezione dei contenuti e visibilità, che variano notevolmente in base al modello di business e alla strategia dei contenuti. Bloccare completamente i crawler di addestramento come GPTBot elimina il rischio che i tuoi contenuti vengano usati per addestrare modelli AI proprietari senza compenso, ma significa anche che i tuoi contenuti non appariranno nelle risposte AI generate, riducendo potenzialmente la scoperta e il traffico da parte degli utenti che interagiscono con sistemi AI. Al contrario, consentire i crawler di addestramento aumenta la possibilità che i tuoi contenuti vengano incorporati nei dataset di training AI, potenzialmente senza attribuzione o compenso, ma può aumentare la visibilità se tali sistemi AI in futuro citano o richiamano i tuoi contenuti. La decisione strategica dovrebbe considerare il vantaggio competitivo dei tuoi contenuti—ricerche proprietarie, analisi originali e dati unici meritano blocchi più severi, mentre contenuti educativi evergreen o informazioni comuni possono beneficiare di una maggiore visibilità AI. Tipologie di editori diverse affrontano scelte differenti: le testate giornalistiche potrebbero consentire i crawler di ricerca per ottenere traffico da citazioni bloccando quelli di addestramento, gli editori educativi potrebbero optare per un accesso più ampio per aumentare la diffusione, e le aziende SaaS potrebbero bloccare tutti i crawler AI per proteggere la documentazione proprietaria. Monitorare l’impatto delle decisioni di blocco tramite log del server e analisi del traffico è essenziale per verificare se la configurazione raggiunge gli obiettivi di business desiderati.

Sebbene robots.txt offra un meccanismo chiaro per comunicare le policy sui crawler, è fondamentalmente consultivo e non legalmente vincolante: i crawler conformi rispetteranno le regole, ma attori non conformi potrebbero ignorarle, rendendo necessari ulteriori livelli tecnici di enforcement. La verifica e la whitelist IP rappresentano il metodo di enforcement più affidabile; mantenendo una lista di indirizzi IP legittimi pubblicati da OpenAI, Google, Anthropic e altre grandi aziende AI, puoi verificare che le richieste dichiarate come provenienti da questi crawler abbiano effettivamente origine dalle loro infrastrutture. Le regole firewall e il blocco a livello server forniscono il meccanismo di enforcement più solido, consentendo di rifiutare le richieste da specifici user-agent o intervalli IP a livello di rete prima che consumino risorse del server. Per i server Apache, la configurazione .htaccess può far rispettare le restrizioni ai crawler:

<IfModule mod_rewrite.c>

RewriteEngine On

RewriteCond %{HTTP_USER_AGENT} GPTBot [NC]

RewriteRule ^.*$ - [F,L]

</IfModule>

I meta tag nella sezione head del tuo HTML offrono un controllo granulare, a livello di pagina, sull’accesso dei crawler senza modificare robots.txt:

<meta name="robots" content="noindex, noimageindex, nofollowbyai">

Il controllo regolare dei log del server per l’attività dei crawler consente di identificare nuovi crawler, verificare che le regole vengano rispettate e rilevare user-agent falsificati che tentano di aggirare le restrizioni. Strumenti come Knowatoa e Merkle forniscono validazione e monitoraggio automatizzati della configurazione robots.txt e del comportamento dei crawler, offrendo visibilità su quali crawler stanno accedendo al tuo sito e se stanno rispettando le tue direttive.

La manutenzione continua della configurazione robots.txt specifica per AI è fondamentale poiché il panorama dei crawler AI è in rapida evoluzione, con nuovi crawler che emergono regolarmente e quelli esistenti che modificano le proprie stringhe user-agent e i pattern di comportamento. La tua strategia di monitoraggio dovrebbe includere:

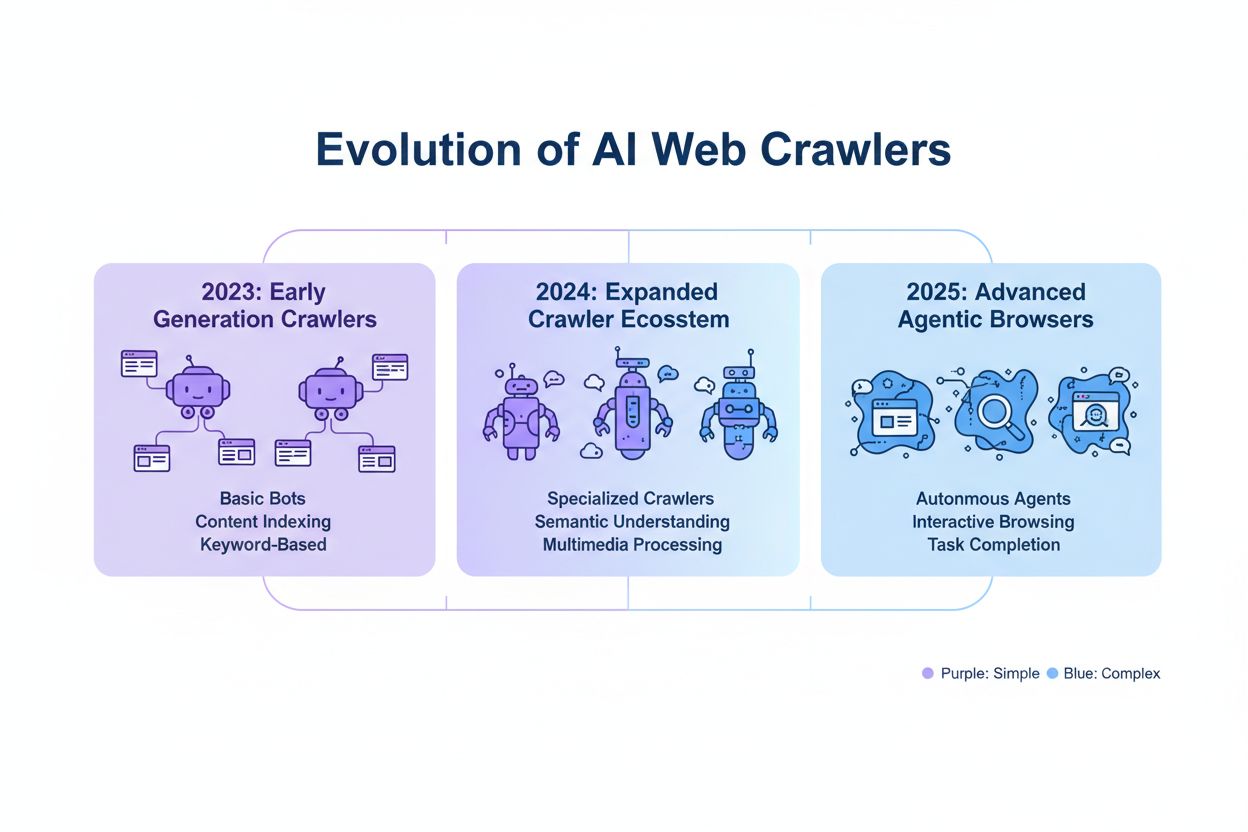

L’evoluzione rapida della tecnologia dei crawler AI significa che una configurazione robots.txt adatta sei mesi fa potrebbe non riflettere più le tue esigenze o il panorama delle minacce attuali, rendendo la revisione e l’adattamento regolari essenziali per mantenere una protezione dei contenuti efficace.

La prossima generazione di crawler AI presenta nuove sfide che la configurazione tradizionale di robots.txt potrebbe non essere in grado di affrontare efficacemente. I crawler agentici su browser come ChatGPT Atlas e Google Project Mariner operano come browser web completi invece che semplici client HTTP, eseguendo JavaScript, simulando interazioni utente e comportandosi in modo indistinguibile dagli utenti umani—questi crawler potrebbero non identificarsi con stringhe user-agent distintive, rendendo inefficace il blocco tramite robots.txt. Molti crawler emergenti stanno adottando stringhe user-agent Chrome standard per evitare il rilevamento e il blocco, oscurando deliberatamente la propria identità per aggirare le regole robots.txt e altri controlli di accesso. Questa tendenza sta portando a uno spostamento verso il blocco basato su IP come necessità emergente, dove gli editori devono mantenere whitelist di IP legittimi dei crawler e bloccare tutto il traffico proveniente da fonti sospette, cambiando fondamentalmente il modello di enforcement da user-agent matching a controllo di accesso a livello di rete. User-agent falsificati e tecniche di aggiramento stanno diventando sempre più comuni, con attori malevoli che si spacciano per crawler legittimi o utilizzano stringhe user-agent generiche per sfuggire al rilevamento. Il futuro della gestione dei crawler AI richiederà probabilmente un approccio multilivello che combini configurazione robots.txt, verifica IP, regole firewall e potenzialmente analisi comportamentale per distinguere i crawler legittimi dagli attori malevoli. Rimanere informati sulle tecnologie emergenti dei crawler e partecipare alle discussioni di settore su etica e standard dei crawler è essenziale per gli editori che vogliono mantenere strategie di protezione dei contenuti efficaci.

Implementare una configurazione efficace di robots.txt specifica per AI richiede un approccio completo che bilanci la protezione dei contenuti con gli obiettivi strategici di visibilità. Inizia con una policy chiara di protezione dei contenuti che definisca quali categorie di contenuti richiedono il blocco (ricerche proprietarie, contenuti premium, contenuti generati dagli utenti) rispetto a quelli che possono essere esposti ai crawler AI (articoli pubblici, contenuti educativi, informazioni comuni). Implementa una strategia di blocco a livelli che distingua tra crawler di addestramento (tipicamente da bloccare), crawler di ricerca (tipicamente da consentire con monitoraggio) e crawler attivati dall’utente (tipicamente da consentire), invece di applicare un approccio di blocco/consenso totale a tutti i crawler AI. Combina robots.txt con enforcement a livello server implementando regole firewall e verifica IP per i contenuti più sensibili, riconoscendo che robots.txt da solo è insufficiente per una protezione forte. Integra la gestione dei crawler AI nella tua strategia SEO e di contenuti considerando come le decisioni di blocco influiscono sulla tua visibilità nelle risposte AI generate, nelle citazioni e nelle funzionalità di ricerca AI—questa integrazione garantisce che la tua configurazione robots.txt supporti e non ostacoli i tuoi obiettivi di business. Stabilisci una cadenza di monitoraggio e manutenzione con revisioni settimanali dei log, verifica IP mensile e audit completi trimestrali per assicurarti che la configurazione rimanga efficace con l’evoluzione del panorama dei crawler. Usa strumenti come AmICited.com per monitorare la visibilità dei tuoi contenuti nei sistemi AI e comprendere l’impatto delle tue decisioni di blocco su scoperta e citazione AI. Per i diversi tipi di editori: le testate giornalistiche dovrebbero tipicamente consentire i crawler di ricerca bloccando quelli di addestramento per massimizzare il traffico da citazioni; gli editori educativi dovrebbero considerare un accesso più ampio per aumentare la diffusione; le aziende SaaS dovrebbero implementare blocchi rigorosi per la documentazione proprietaria. Quando il blocco tramite robots.txt si rivela insufficiente a causa di user-agent falsificati o crawler non conformi, passa a regole firewall e blocco basato su IP per far rispettare le policy di protezione dei tuoi contenuti a livello di rete.

I crawler di addestramento come GPTBot e ClaudeBot raccolgono dati per lo sviluppo dei modelli e non forniscono traffico di referral, rendendoli un rischio elevato per la protezione dei contenuti. I crawler di ricerca come OAI-SearchBot e PerplexityBot indicizzano i contenuti per la ricerca AI e possono inviare traffico di referral tramite citazioni. La maggior parte degli editori blocca i crawler di addestramento consentendo invece quelli di ricerca per bilanciare la protezione dei contenuti con la visibilità.

Google afferma ufficialmente che bloccare Google-Extended non influisce sul posizionamento nei motori di ricerca né sull'inclusione nei Google AI Overviews. Tuttavia, alcuni webmaster hanno espresso preoccupazioni, quindi monitora le tue prestazioni di ricerca dopo aver implementato i blocchi. AI Overviews in Google Search segue le regole standard di Googlebot, non quelle di Google-Extended.

Sì, robots.txt è consultivo e non vincolante. I crawler ben educati delle principali aziende generalmente rispettano le direttive di robots.txt, ma alcuni crawler le ignorano. Per una protezione più forte, implementa il blocco a livello di server tramite .htaccess o regole firewall e verifica i crawler legittimi utilizzando gli intervalli di indirizzi IP pubblicati.

Rivedi e aggiorna la tua blocklist almeno trimestralmente. Emergeranno regolarmente nuovi crawler AI, quindi controlla i log del server ogni mese per identificare nuovi crawler che visitano il tuo sito. Segui risorse della community come il progetto ai.robots.txt su GitHub per aggiornamenti su nuovi crawler e stringhe user-agent.

Dipende dalle tue priorità aziendali. Bloccare i crawler di addestramento protegge i tuoi contenuti dall'essere incorporati nei modelli AI senza compenso. Bloccare i crawler di ricerca può ridurre la tua visibilità nelle piattaforme di scoperta AI come la ricerca ChatGPT o Perplexity. Molti editori scelgono un blocco selettivo che prende di mira i crawler di addestramento consentendo invece quelli di ricerca e citazione.

Controlla i log del server per le stringhe user-agent dei crawler e verifica che quelli bloccati non accedano alle tue pagine. Usa strumenti di analisi per monitorare i pattern di traffico dei bot. Testa la tua configurazione con Knowatoa AI Search Console o Merkle robots.txt Tester per convalidare che le tue regole funzionino come previsto.

I crawler agentici basati su browser come ChatGPT Atlas e Google Project Mariner operano come browser web completi piuttosto che semplici client HTTP. Spesso utilizzano stringhe user-agent Chrome standard, rendendoli indistinguibili dal normale traffico browser. In questi casi diventa necessario il blocco basato su IP per controllare l'accesso a questi crawler avanzati.

Il robots.txt specifico per AI controlla l’accesso ai tuoi contenuti, mentre strumenti come AmICited monitorano come le piattaforme AI citano e fanno riferimento ai tuoi contenuti. Insieme offrono visibilità e controllo completi: robots.txt gestisce l’accesso dei crawler e gli strumenti di monitoraggio tracciano l’impatto dei tuoi contenuti attraverso i sistemi AI.

AmICited traccia come i sistemi AI come ChatGPT, Claude, Perplexity e Google AI Overviews citano e fanno riferimento al tuo brand. Combina la configurazione di robots.txt con il monitoraggio della visibilità AI per capire l’impatto dei tuoi contenuti sulle piattaforme AI.

Scopri come configurare robots.txt per controllare l'accesso dei crawler AI, inclusi GPTBot, ClaudeBot e Perplexity. Gestisci la visibilità del tuo brand nelle ...

Discussione della community sulla configurazione di robots.txt per i crawler AI come GPTBot, ClaudeBot e PerplexityBot. Esperienze reali di webmaster e speciali...

Scopri come i Web Application Firewall offrono un controllo avanzato sui crawler AI oltre robots.txt. Implementa regole WAF per proteggere i tuoi contenuti dall...