A/B Testing per la Visibilità dell'AI: Metodologia e Best Practice

Diventa esperto nell'A/B testing per la visibilità dell'AI con la nostra guida completa. Scopri gli esperimenti GEO, la metodologia, le best practice e casi di ...

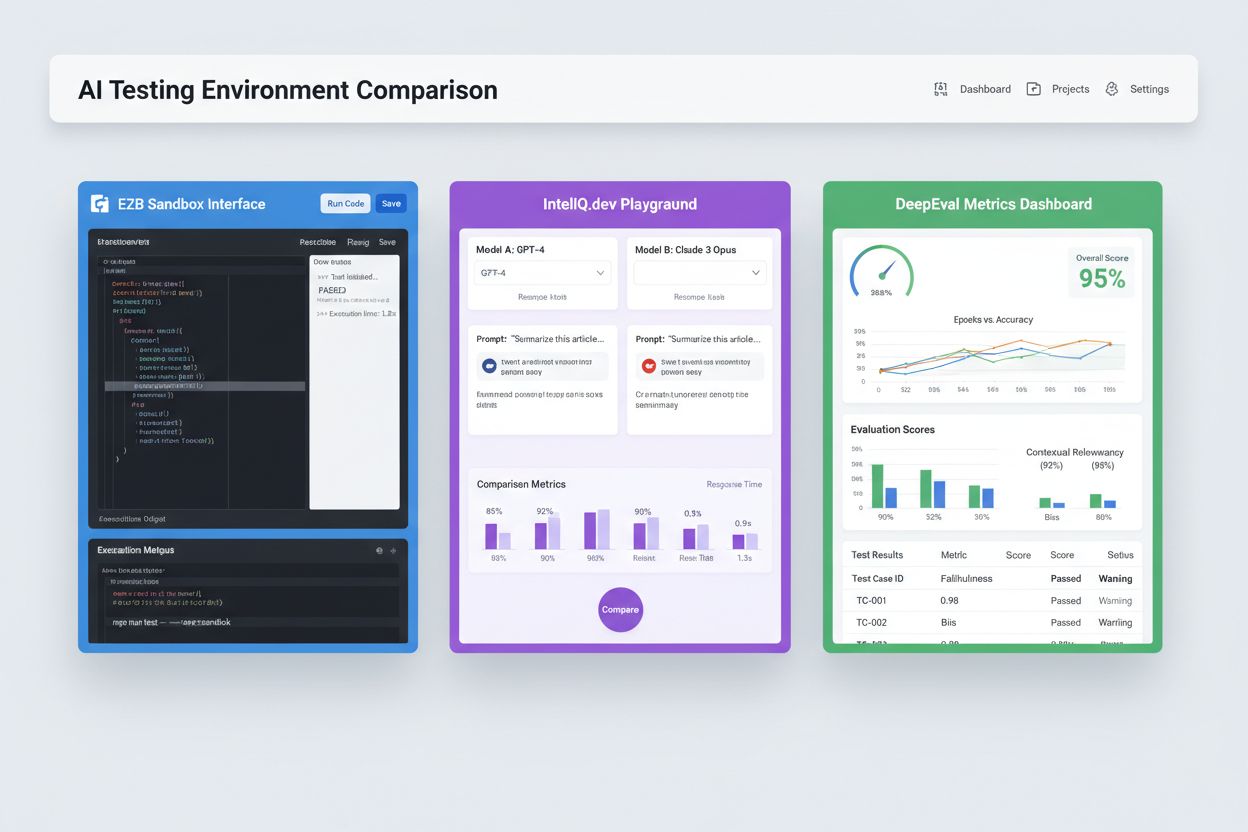

Ambienti sandbox isolati progettati per validare, valutare e fare il debug di modelli e applicazioni di intelligenza artificiale prima della messa in produzione. Questi spazi controllati permettono di testare le prestazioni dei contenuti IA su diverse piattaforme, misurare metriche e garantire affidabilità senza influenzare i sistemi live o esporre dati sensibili.

Ambienti sandbox isolati progettati per validare, valutare e fare il debug di modelli e applicazioni di intelligenza artificiale prima della messa in produzione. Questi spazi controllati permettono di testare le prestazioni dei contenuti IA su diverse piattaforme, misurare metriche e garantire affidabilità senza influenzare i sistemi live o esporre dati sensibili.

Un Ambiente di Test per l’IA è uno spazio computazionale controllato e isolato progettato per validare, valutare e fare il debug di modelli e applicazioni di intelligenza artificiale prima dell’implementazione nei sistemi di produzione. Funziona come una sandbox dove sviluppatori, data scientist e team QA possono eseguire in sicurezza modelli IA, testare diverse configurazioni e misurare le prestazioni secondo metriche predefinite senza impattare i sistemi live o esporre dati sensibili. Questi ambienti replicano le condizioni di produzione mantenendo la completa separazione, consentendo ai team di individuare problemi, ottimizzare il comportamento dei modelli e garantire affidabilità in diversi scenari. L’ambiente di test rappresenta un passaggio cruciale nella qualità del ciclo di sviluppo IA, colmando il divario tra prototipazione sperimentale e deployment aziendale.

Un Ambiente di Test per l’IA completo comprende diversi livelli tecnici interconnessi che collaborano per offrire funzionalità di test avanzate. Il livello di esecuzione del modello gestisce l’inferenza e il calcolo effettivi, supportando diversi framework (PyTorch, TensorFlow, ONNX) e tipi di modelli (LLM, computer vision, time-series). Il livello di gestione dei dati gestisce dataset di test, fixtures e generazione di dati sintetici mantenendo isolamento e conformità dei dati. Il framework di valutazione include motori di metriche, librerie di asserzioni e sistemi di scoring che confrontano gli output dei modelli con i risultati attesi. Il livello di monitoraggio e logging cattura tracce di esecuzione, metriche di prestazione, dati di latenza e log di errori per l’analisi post-test. Il livello di orchestrazione gestisce i workflow di test, l’esecuzione parallela, l’allocazione delle risorse e il provisioning degli ambienti. Di seguito una tabella comparativa delle componenti architetturali chiave nei diversi tipi di ambienti di test:

| Componente | Test LLM | Computer Vision | Time-Series | Multi-Modale |

|---|---|---|---|---|

| Runtime Modello | Inferenza Transformer | Inferenza accelerata GPU | Elaborazione sequenziale | Esecuzione ibrida |

| Formato Dati | Testo/token | Immagini/tensori | Sequenze numeriche | Media misti |

| Metriche di Valutazione | Similarità semantica, allucinazione | Accuratezza, IoU, F1-score | RMSE, MAE, MAPE | Allineamento cross-modale |

| Requisiti di Latenza | 100-500ms tipico | 50-200ms tipico | <100ms tipico | 200-1000ms tipico |

| Metodo di Isolamento | Container/VM | Container/VM | Container/VM | Firecracker microVM |

Gli Ambienti di Test IA moderni devono supportare ecosistemi di modelli eterogenei, consentendo ai team di valutare applicazioni su diversi provider LLM, framework e target di deployment simultaneamente. Il test multipiattaforma permette alle organizzazioni di confrontare gli output di modelli come GPT-4 di OpenAI, Claude di Anthropic, Mistral e alternative open-source come Llama all’interno dello stesso contesto di test, facilitando decisioni informate sulla scelta del modello. Piattaforme come E2B offrono sandbox isolati in grado di eseguire codice generato da qualsiasi LLM, supportando Python, JavaScript, Ruby e C++ con accesso completo al filesystem, terminale e installazione di pacchetti. IntelIQ.dev consente il confronto side-by-side di molteplici modelli IA tramite interfacce unificate, permettendo di testare prompt controllati e template policy-aware su diversi provider. Gli ambienti di test devono gestire:

Gli Ambienti di Test IA rispondono a molteplici esigenze organizzative in ambito sviluppo, QA e compliance. I team di sviluppo li utilizzano per validare il comportamento dei modelli durante lo sviluppo iterativo, testando variazioni di prompt, ottimizzando parametri e risolvendo output inattesi prima dell’integrazione. I team data science sfruttano questi ambienti per valutare le prestazioni su dataset di validazione, confrontare architetture e misurare metriche come accuratezza, precision, recall e F1-score. Il monitoraggio in produzione prevede test continui dei modelli distribuiti rispetto a metriche baseline, individuando degrado di prestazione e attivando pipeline di retraining quando vengono superate soglie di qualità. Team compliance e sicurezza usano gli ambienti di test per validare la conformità normativa dei modelli, prevenire bias eccessivi e gestire correttamente dati sensibili. Applicazioni aziendali includono:

Il panorama del testing IA comprende piattaforme specializzate per diversi scenari e scale organizzative. DeepEval è un framework open-source per la valutazione LLM che offre oltre 50 metriche di ricerca tra cui correttezza delle risposte, similarità semantica, rilevamento allucinazioni e scoring di tossicità, con integrazione nativa Pytest per flussi CI/CD. LangSmith (di LangChain) offre osservabilità, valutazione e deployment completi con tracing integrato, versionamento dei prompt e gestione dei dataset per applicazioni LLM. E2B fornisce sandbox sicuri e isolati su microVM Firecracker, supportando esecuzione di codice con avvio sotto i 200ms, sessioni fino a 24 ore e integrazione con i principali provider LLM. IntelIQ.dev punta su test privacy-first con crittografia end-to-end, controlli di accesso basati sui ruoli e supporto a molteplici modelli IA tra cui GPT-4, Claude e alternative open-source. La tabella seguente confronta le funzionalità principali:

| Strumento | Focus Principale | Metriche | Integrazione CI/CD | Supporto Multi-Modello | Modello di Prezzo |

|---|---|---|---|---|---|

| DeepEval | Valutazione LLM | 50+ metriche | Pytest nativo | Limitato | Open-source + cloud |

| LangSmith | Osservabilità & valutazione | Metriche personalizzate | API-based | Ecosistema LangChain | Freemium + enterprise |

| E2B | Esecuzione codice | Metriche di prestazione | GitHub Actions | Tutti i LLM | Pay-per-use + enterprise |

| IntelIQ.dev | Test privacy-first | Metriche personalizzate | Workflow builder | GPT-4, Claude, Mistral | Abbonamento |

Gli Ambienti di Test IA aziendali devono implementare controlli di sicurezza rigorosi per proteggere i dati sensibili, mantenere la conformità normativa e prevenire accessi non autorizzati. Isolamento dei dati significa che i dati di test non devono mai fuoriuscire verso API esterne o servizi terzi; piattaforme come E2B utilizzano microVM Firecracker per garantire isolamento totale dei processi senza accesso kernel condiviso. Standard di crittografia: è necessaria la crittografia end-to-end per dati a riposo e in transito, con supporto per HIPAA, SOC 2 Type 2 e requisiti GDPR. Controlli di accesso: permessi basati sui ruoli, audit logging e workflow di approvazione per i casi di test sensibili devono essere applicati. Best practice includono: mantenere dataset di test separati dai dati di produzione, implementare masking dei dati per informazioni personali (PII), usare dati sintetici per test realistici senza rischi di privacy, condurre audit di sicurezza regolari sull’infrastruttura di test e documentare tutti i risultati per la conformità. Le organizzazioni dovrebbero inoltre implementare meccanismi di rilevamento bias per identificare comportamenti discriminatori, utilizzare strumenti di interpretabilità come SHAP o LIME per comprendere le decisioni del modello, e istituire il decision logging per tracciare come i modelli arrivano a determinati output per la responsabilità normativa.

Gli Ambienti di Test IA devono integrarsi senza soluzione di continuità nelle pipeline di continuous integration e continuous deployment esistenti, per abilitare quality gate automatizzati e cicli di iterazione rapida. L’integrazione nativa CI/CD permette che l’esecuzione dei test venga attivata automaticamente su commit di codice, pull request o intervalli programmati tramite piattaforme come GitHub Actions, GitLab CI o Jenkins. L’integrazione Pytest di DeepEval consente agli sviluppatori di scrivere casi di test come normali test Python eseguiti nei flussi CI, con risultati riportati accanto ai test unitari tradizionali. La valutazione automatizzata può misurare metriche di performance dei modelli, confrontare output rispetto alle versioni baseline e bloccare i deployment se le soglie di qualità non vengono raggiunte. La gestione degli artefatti implica l’archiviazione di dataset di test, checkpoint di modello e risultati delle valutazioni nei sistemi di versionamento o repository di artefatti per riproducibilità e audit trail. I pattern di integrazione includono:

Il panorama degli Ambienti di Test IA è in rapida evoluzione per rispondere a nuove sfide in complessità, scala ed eterogeneità dei modelli. Il testing agentico sta diventando sempre più importante poiché i sistemi IA superano la semplice inferenza a modello singolo per abbracciare workflow multi-step in cui gli agenti usano strumenti, prendono decisioni e interagiscono con sistemi esterni—richiedendo nuovi framework di valutazione per misurare completamento dei task, sicurezza e affidabilità. La valutazione distribuita consente test su larga scala avviando migliaia di istanze di test concorrenti su infrastrutture cloud, fondamentale per reinforcement learning e training di grandi modelli. Il monitoraggio in tempo reale sta passando dalla valutazione batch al testing continuo in produzione, per rilevare degrado di prestazioni, drift dei dati e bias emergenti nei sistemi live. Piattaforme di osservabilità come AmICited stanno emergendo come strumenti essenziali per monitoraggio e visibilità IA completa, offrendo dashboard centralizzati che tracciano prestazioni, pattern di utilizzo e metriche di qualità su interi portafogli IA. I futuri ambienti di test incorporeranno sempre più rimedi automatizzati, dove i sistemi non solo rilevano i problemi ma avviano automaticamente pipeline di retraining o aggiornamenti modello, e valutazione cross-modale, permettendo il test simultaneo di modelli di testo, immagini, audio e video in framework unificati.

Un Ambiente di Test per l'IA è una sandbox isolata dove puoi testare in sicurezza modelli, prompt e configurazioni senza influenzare sistemi o utenti live. La messa in produzione è l'ambiente reale dove i modelli servono utenti reali. Gli ambienti di test ti permettono di individuare problemi, ottimizzare le prestazioni e validare cambiamenti prima che arrivino in produzione, riducendo i rischi e garantendo la qualità.

Sì, gli Ambienti di Test IA moderni supportano il test multi-modello. Piattaforme come E2B, IntelIQ.dev e DeepEval consentono di testare lo stesso prompt o input su diversi provider LLM (OpenAI, Anthropic, Mistral, ecc.) simultaneamente, permettendo il confronto diretto di output e metriche di prestazione.

Gli Ambienti di Test IA aziendali implementano diversi livelli di sicurezza tra cui isolamento dei dati (containerizzazione o microVM), crittografia end-to-end, controlli di accesso basati sui ruoli, audit logging e certificazioni di conformità (SOC 2, GDPR, HIPAA). I dati non lasciano mai l'ambiente isolato se non vengono esplicitamente esportati, proteggendo le informazioni sensibili.

Gli Ambienti di Test abilitano la conformità fornendo tracciabilità di tutti gli audit delle valutazioni modello, supportando il mascheramento dei dati e la generazione di dati sintetici, applicando controlli di accesso e mantenendo la completa separazione dei dati di test dai sistemi di produzione. Questa documentazione e controllo aiutano le organizzazioni a soddisfare requisiti normativi come GDPR, HIPAA e SOC 2.

Le metriche chiave dipendono dal tuo caso d'uso: per gli LLM, monitora accuratezza, similarità semantica, tasso di allucinazione e latenza; per i sistemi RAG, misura precision/recall contestuale e fedeltà; per i modelli di classificazione, monitora precision, recall e F1-score; per tutti i modelli, monitora degrado delle prestazioni nel tempo e indicatori di bias.

I costi variano in base alla piattaforma: DeepEval è open-source e gratuito; LangSmith offre un piano gratuito con soluzioni a pagamento a partire da 39$/mese; E2B utilizza una tariffazione pay-per-use basata sul tempo di esecuzione della sandbox; IntelIQ.dev offre prezzi in abbonamento. Molte piattaforme prevedono anche prezzi aziendali per deployment su larga scala.

Sì, la maggior parte degli ambienti di test moderni supporta l'integrazione CI/CD. DeepEval si integra nativamente con Pytest, E2B funziona con GitHub Actions e GitLab CI, e LangSmith fornisce integrazione basata su API. Questo consente test automatici a ogni commit di codice e enforcement delle regole di deployment.

Il test end-to-end tratta l'intera applicazione IA come una black box, testando l'output finale rispetto ai risultati attesi. Il test a livello di componente valuta singole parti (chiamate LLM, retriever, uso di strumenti) separatamente usando tracing e strumentazione. Il test a livello di componente offre maggiori dettagli su dove si verificano i problemi, mentre il test end-to-end valida il comportamento complessivo del sistema.

AmICited traccia come i sistemi IA fanno riferimento al tuo brand e ai tuoi contenuti su ChatGPT, Claude, Perplexity e Google AI. Ottieni visibilità in tempo reale sulla tua presenza IA con monitoraggio e analisi completi.

Diventa esperto nell'A/B testing per la visibilità dell'AI con la nostra guida completa. Scopri gli esperimenti GEO, la metodologia, le best practice e casi di ...

Scopri cos'è un Centro di Eccellenza per la Visibilità dell’IA, le sue principali responsabilità, capacità di monitoraggio e come consente alle organizzazioni d...

Scopri cosa sono le finestre di contesto nei modelli linguistici di intelligenza artificiale, come funzionano, il loro impatto sulle prestazioni del modello e p...

Consenso Cookie

Usiamo i cookie per migliorare la tua esperienza di navigazione e analizzare il nostro traffico. See our privacy policy.