Frequenza di scansione

La frequenza di scansione indica quanto spesso i motori di ricerca e i crawler AI visitano il tuo sito. Scopri cosa influenza la frequenza di scansione, perché ...

La profondità di scansione si riferisce a quanto in profondità nella struttura gerarchica di un sito web i crawler dei motori di ricerca possono arrivare durante una singola sessione di scansione. Misura il numero di clic o passaggi richiesti dalla homepage per raggiungere una determinata pagina, influenzando direttamente quali pagine vengono indicizzate e con quale frequenza vengono scansionate all’interno del crawl budget assegnato al sito.

La profondità di scansione si riferisce a quanto in profondità nella struttura gerarchica di un sito web i crawler dei motori di ricerca possono arrivare durante una singola sessione di scansione. Misura il numero di clic o passaggi richiesti dalla homepage per raggiungere una determinata pagina, influenzando direttamente quali pagine vengono indicizzate e con quale frequenza vengono scansionate all'interno del crawl budget assegnato al sito.

La profondità di scansione è un concetto fondamentale della SEO tecnica che si riferisce a quanto in profondità nella struttura gerarchica di un sito web i crawler dei motori di ricerca possono navigare durante una singola sessione di scansione. Più precisamente, misura il numero di clic o passaggi necessari dalla homepage per raggiungere una determinata pagina all’interno della struttura dei link interni del tuo sito. Un sito web con alta profondità di scansione significa che i bot dei motori di ricerca possono accedere e indicizzare molte pagine in tutto il sito, mentre un sito con bassa profondità di scansione indica che i crawler potrebbero non raggiungere le pagine più profonde prima di esaurire le risorse assegnate. Questo concetto è fondamentale perché determina direttamente quali pagine vengono indicizzate, con quale frequenza vengono scansionate e, in ultima analisi, la loro visibilità nelle pagine dei risultati dei motori di ricerca (SERP).

L’importanza della profondità di scansione è aumentata negli ultimi anni a causa della crescita esponenziale dei contenuti web. Con l’indice di Google che contiene oltre 400 miliardi di documenti e il crescente volume di contenuti generati dall’AI, i motori di ricerca affrontano limiti senza precedenti alle risorse di scansione. Questo significa che i siti web con una scarsa ottimizzazione della profondità di scansione possono vedere le loro pagine importanti non indicizzate o scansionate raramente, con un impatto significativo sulla visibilità organica. Comprendere e ottimizzare la profondità di scansione è quindi essenziale per qualsiasi sito che desideri massimizzare la propria presenza sui motori di ricerca.

Il concetto di profondità di scansione nasce dal modo in cui operano i crawler dei motori di ricerca (detti anche spider o bot). Quando Googlebot o altri bot visitano un sito, seguono un processo sistematico: partono dalla homepage e seguono i link interni per scoprire altre pagine. Il crawler assegna a ogni sito una quantità finita di tempo e risorse, nota come crawl budget. Questo budget è determinato da due fattori: limite di capacità di scansione (quanto il crawler può gestire senza sovraccaricare il server) e domanda di scansione (quanto il sito è importante e frequentemente aggiornato). Più le pagine sono nascoste in profondità nella struttura, meno probabilità hanno di essere raggiunte dai crawler prima che il budget venga esaurito.

Storicamente le strutture dei siti erano relativamente semplici, con i contenuti importanti a 2-3 clic dalla homepage. Tuttavia, con la crescita esponenziale di e-commerce, portali di news e siti ricchi di contenuti, molte organizzazioni hanno creato strutture profondamente annidate con pagine a 5, 6 o anche 10+ livelli di profondità. Ricerche di seoClarity e altre piattaforme SEO hanno dimostrato che le pagine a profondità 3 e oltre generalmente performano peggio nei risultati organici rispetto a quelle più vicine alla homepage. Questo divario di performance esiste perché i crawler danno priorità alle pagine più vicine alla radice, e queste pagine accumulano anche più link equity (potere di ranking) tramite il linking interno. La relazione tra profondità di scansione e tassi di indicizzazione è particolarmente evidente nei grandi siti con migliaia o milioni di pagine, dove il crawl budget diventa un fattore critico.

L’ascesa dei motori di ricerca AI come Perplexity, ChatGPT e Google AI Overviews ha aggiunto una nuova dimensione all’ottimizzazione della profondità di scansione. Questi sistemi AI utilizzano i propri crawler specializzati (come PerplexityBot e GPTBot) che possono seguire pattern e priorità diversi rispetto ai motori di ricerca tradizionali. Tuttavia, il principio fondamentale rimane lo stesso: le pagine facilmente accessibili e ben integrate nella struttura del sito hanno maggiori probabilità di essere scoperte, scansionate e citate come fonti nelle risposte generate dall’AI. Questo rende l’ottimizzazione della profondità di scansione rilevante non solo per la SEO tradizionale, ma anche per la visibilità nelle ricerche AI e la generative engine optimization (GEO).

| Concetto | Definizione | Prospettiva | Misurazione | Impatto sulla SEO |

|---|---|---|---|---|

| Profondità di Scansione | Quanto in profondità i crawler navigano nella gerarchia del sito in base ai link interni e alla struttura degli URL | Punto di vista del crawler | Numero di clic/passi dalla homepage | Influenza la frequenza e la copertura dell’indicizzazione |

| Profondità di Clic | Numero di clic necessari a un utente per raggiungere una pagina dalla homepage tramite il percorso più breve | Punto di vista dell’utente | Clic letterali richiesti | Influenza l’esperienza utente e la navigazione |

| Profondità della Pagina | Posizione di una pagina nella struttura gerarchica del sito | Vista strutturale | Livello di annidamento dell’URL | Influenza la distribuzione del link equity |

| Crawl Budget | Risorse totali (tempo/banda) assegnate per scansionare un sito web | Assegnazione delle risorse | Pagine scansionate al giorno | Determina quante pagine vengono indicizzate |

| Efficienza di Scansione | Quanto efficacemente i crawler navigano e indicizzano i contenuti del sito | Vista dell’ottimizzazione | Pagine indicizzate vs crawl budget usato | Massimizza l’indicizzazione nei limiti del budget |

Comprendere come funziona la profondità di scansione richiede di esaminare la meccanica con cui i crawler dei motori di ricerca navigano i siti web. Quando Googlebot o un altro crawler visita il tuo sito, inizia dalla homepage (profondità 0) e segue i link interni per scoprire altre pagine. Ogni pagina collegata dalla homepage è a profondità 1, quelle collegate da queste sono a profondità 2 e così via. Il crawler non segue necessariamente un percorso lineare; scopre invece più pagine a ogni livello prima di passare a quello successivo. Tuttavia, il percorso del crawler è limitato dal crawl budget, che determina quante pagine può visitare in un certo periodo.

La relazione tecnica tra profondità di scansione e indicizzazione è regolata da diversi fattori. In primo luogo, la prioritizzazione della scansione gioca un ruolo cruciale: i motori di ricerca non scansionano tutte le pagine allo stesso modo. Danno priorità alle pagine considerate più importanti, fresche e rilevanti. Le pagine con più link interni, maggiore autorità e aggiornamenti recenti sono scansionate più spesso. In secondo luogo, la stessa struttura degli URL influenza la profondità di scansione. Una pagina a /category/subcategory/product/ ha una maggiore profondità di scansione rispetto a una a /product/, anche se entrambe sono collegate dalla homepage. In terzo luogo, catene di redirect e link interrotti rappresentano ostacoli che sprecano il crawl budget. Una catena di redirect costringe il crawler a seguire più redirect prima di arrivare alla pagina finale, consumando risorse che potrebbero essere utilizzate per altre pagine.

L’implementazione tecnica dell’ottimizzazione della profondità di scansione prevede diverse strategie chiave. L’architettura del linking interno è fondamentale: collegando strategicamente le pagine importanti dalla homepage e da pagine autorevoli, si riduce la loro profondità effettiva e si aumenta la probabilità che vengano scansionate frequentemente. Le sitemap XML offrono ai crawler una mappa diretta della struttura del sito, consentendo loro di scoprire le pagine più efficientemente senza dover seguire esclusivamente i link. La velocità del sito è un altro fattore critico: pagine più veloci si caricano prima, permettendo ai crawler di accedere a più contenuti nel budget assegnato. Infine, robots.txt e i tag noindex permettono di controllare quali pagine i crawler dovrebbero privilegiare, evitando che sprechino risorse su pagine di scarso valore come contenuti duplicati o pagine amministrative.

Le implicazioni pratiche della profondità di scansione vanno ben oltre i meri indicatori tecnici SEO: influiscono direttamente sui risultati di business. Per i siti e-commerce, una scarsa ottimizzazione della profondità di scansione significa che le pagine prodotto sepolte in profondità nelle gerarchie di categoria potrebbero non essere indicizzate o esserlo raramente. Ciò si traduce in minore visibilità organica, meno impressioni prodotto nei risultati di ricerca e, in definitiva, perdita di vendite. Uno studio di seoClarity ha rilevato che le pagine con maggiore profondità di scansione avevano tassi di indicizzazione molto più bassi, con le pagine a profondità 4+ scansionate fino al 50% in meno rispetto a quelle a profondità 1-2. Per grandi retailer con migliaia di SKU, ciò può significare milioni di euro di ricavi organici persi.

Per i siti ricchi di contenuti come testate giornalistiche, blog e knowledge base, l’ottimizzazione della profondità di scansione incide direttamente sulla scoperta dei contenuti. Gli articoli pubblicati in profondità nelle strutture di categoria possono non finire mai nell’indice di Google, generando traffico organico nullo indipendentemente dalla loro qualità o rilevanza. Questo è particolarmente problematico per i siti di news dove la freschezza è cruciale: se i nuovi articoli non vengono scansionati e indicizzati rapidamente, perdono la finestra per posizionarsi su temi di tendenza. Gli editori che ottimizzano la profondità di scansione appiattendo la struttura e migliorando il linking interno vedono aumenti drastici delle pagine indicizzate e del traffico organico.

La relazione tra profondità di scansione e distribuzione del link equity ha implicazioni di business significative. Il link equity (detto anche PageRank o potere di ranking) fluisce tramite i link interni dalla homepage verso l’esterno. Le pagine più vicine alla homepage accumulano più link equity, risultando più competitive per le keyword. Ottimizzando la profondità di scansione e mantenendo le pagine importanti entro 2-3 clic dalla homepage, le aziende possono concentrare il link equity sulle pagine di maggior valore: tipicamente pagine prodotto, servizi o contenuti pilastro. Questa distribuzione strategica del link equity può migliorare notevolmente il posizionamento per keyword ad alto valore.

Inoltre, l’ottimizzazione della profondità di scansione influisce sull’efficienza del crawl budget, sempre più importante per i siti di grandi dimensioni. I siti con milioni di pagine affrontano forti limiti di budget. Ottimizzando la profondità di scansione, eliminando contenuti duplicati, correggendo link interrotti e rimuovendo catene di redirect, i siti possono assicurarsi che i crawler concentrino il budget su contenuti di valore anziché disperderlo su pagine di scarsa utilità. Questo è particolarmente critico per siti enterprise e grandi piattaforme e-commerce dove la gestione del crawl budget può fare la differenza tra avere l'80% delle pagine indicizzate e il 40%.

L’emergere di motori di ricerca AI e sistemi AI generativi ha introdotto nuove variabili nell’ottimizzazione della profondità di scansione. ChatGPT, alimentato da OpenAI, utilizza il crawler GPTBot per scoprire e indicizzare contenuti web. Perplexity, motore di ricerca AI leader, impiega PerplexityBot per scandagliare il web alla ricerca di fonti. Google AI Overviews (ex SGE) utilizza i crawler di Google per raccogliere informazioni per i riassunti AI. Anche Claude, l’assistente AI di Anthropic, effettua crawling dei contenuti web per training e retrieval. Ognuno di questi sistemi ha pattern di scansione, priorità e limiti di risorse diversi rispetto ai motori di ricerca tradizionali.

Il punto chiave è che i principi della profondità di scansione valgono anche per i motori di ricerca AI. Le pagine facilmente accessibili, ben collegate e strutturalmente prominenti hanno più probabilità di essere scoperte dai crawler AI e citate come fonti nelle risposte AI. Ricerche di AmICited e altre piattaforme di monitoraggio AI mostrano che i siti con una profondità di scansione ottimizzata ottengono tassi di citazione più alti nei risultati AI. Questo perché i sistemi AI danno priorità a fonti autorevoli, accessibili e frequentemente aggiornate – tutte caratteristiche che correlano con una profondità superficiale e una buona struttura di link interni.

Ci sono però alcune differenze nel comportamento dei crawler AI rispetto a Googlebot. I crawler AI possono essere più aggressivi nei pattern di scansione, consumando più banda. Potrebbero anche avere preferenze diverse per tipi di contenuti e freschezza. Alcuni sistemi AI danno maggiore priorità ai contenuti aggiornati di recente rispetto ai motori di ricerca tradizionali, rendendo l’ottimizzazione della profondità di scansione ancora più cruciale per la visibilità AI. Inoltre, i crawler AI potrebbero non rispettare determinate direttive come robots.txt o i tag noindex nello stesso modo dei motori di ricerca tradizionali, anche se la situazione sta evolvendo con l’allineamento alle best practice SEO.

Per le aziende focalizzate su visibilità nelle ricerche AI e generative engine optimization (GEO), ottimizzare la profondità di scansione ha un duplice effetto: migliora la SEO tradizionale e aumenta la probabilità che i sistemi AI scoprano, scansionino e citino i contenuti. Questo rende l’ottimizzazione della profondità di scansione una strategia fondamentale per chi mira alla visibilità su piattaforme sia tradizionali sia AI-powered.

Ottimizzare la profondità di scansione richiede un approccio sistematico che coinvolga sia aspetti strutturali che tecnici del sito. Le seguenti best practice sono state efficaci su migliaia di siti web:

Per i grandi siti enterprise con migliaia o milioni di pagine, l’ottimizzazione della profondità di scansione diventa sempre più complessa e cruciale. Questi siti affrontano severi vincoli di crawl budget, rendendo essenziale implementare strategie avanzate. Un approccio è l’allocazione del crawl budget, cioè decidere strategicamente quali pagine meritano risorse di scansione in base al valore di business. Le pagine ad alto valore (prodotto, servizio, contenuti pilastro) vanno mantenute a profondità superficiali e collegate frequentemente, mentre quelle a basso valore (archivi, duplicati, contenuti sottili) vanno messe in noindex o de-prioritarie.

Un’altra strategia avanzata è il linking interno dinamico, che sfrutta dati e insight per identificare le pagine che necessitano di ulteriori link interni per migliorare la loro profondità di scansione. Strumenti come Internal Link Analysis di seoClarity identificano pagine troppo profonde con pochi link, evidenziando opportunità di migliorare l’efficienza della scansione. Inoltre, l’analisi dei file di log permette di vedere esattamente come i crawler navigano il sito, rivelando colli di bottiglia e inefficienze nella struttura della profondità di scansione. Analizzando il comportamento dei crawler, puoi individuare pagine scansionate in modo inefficiente e ottimizzarne l’accessibilità.

Per i siti multilingua e internazionali, l’ottimizzazione della profondità di scansione è ancora più importante. I tag hreflang e una struttura URL corretta per le versioni in diverse lingue possono influire sull’efficienza della scansione. Assicurando che ogni versione linguistica abbia una struttura di profondità ottimizzata, massimizzi l’indicizzazione su tutti i mercati. Allo stesso modo, l’indicizzazione mobile-first richiede che l’ottimizzazione della profondità di scansione tenga conto sia della versione desktop che di quella mobile del sito, assicurando che i contenuti importanti siano accessibili su entrambe le piattaforme.

L’importanza della profondità di scansione sta evolvendo con l’avanzamento delle tecnologie di ricerca. Con l’ascesa dei motori di ricerca AI e dei sistemi AI generativi, l’ottimizzazione della profondità di scansione interessa un pubblico sempre più vasto oltre ai professionisti SEO tradizionali. Man mano che i sistemi AI diventano più sofisticati, potrebbero sviluppare pattern e priorità di scansione differenti, rendendo l’ottimizzazione della profondità ancora più critica. Inoltre, il crescente volume di contenuti generati dall’AI mette sotto pressione l’indice di Google, aumentando l’importanza della gestione del crawl budget.

Guardando al futuro, ci aspettiamo diversi trend che influenzeranno l’ottimizzazione della profondità di scansione. Primo, gli strumenti di ottimizzazione della scansione guidati dall’AI diventeranno più sofisticati, utilizzando il machine learning per identificare le strutture di profondità ottimali per diversi tipi di siti. Secondo, il monitoraggio in tempo reale della scansione diventerà standard, permettendo ai proprietari dei siti di vedere esattamente come i crawler navigano il proprio sito e di intervenire immediatamente. Terzo, le metriche di profondità di scansione saranno sempre più integrate nelle piattaforme SEO e negli strumenti di analytics, facilitando la comprensione e l’ottimizzazione anche per i marketer meno tecnici.

La relazione tra profondità di scansione e visibilità nelle ricerche AI diventerà probabilmente un focus chiave per i professionisti SEO. Con sempre più utenti che si affidano ai motori di ricerca AI, le aziende dovranno ottimizzare non solo per la ricerca tradizionale, ma anche per la scoperta AI. Ciò significa che l’ottimizzazione della profondità di scansione sarà parte di una strategia GEO più ampia, che abbraccia SEO tradizionale e visibilità AI. Le organizzazioni che padroneggeranno l’ottimizzazione della profondità in anticipo avranno un vantaggio competitivo nel panorama della ricerca AI-powered.

Infine, il concetto di profondità di scansione potrebbe evolvere con i progressi della tecnologia di ricerca. I motori del futuro potrebbero usare metodi diversi per scoprire e indicizzare i contenuti, riducendo l’importanza della profondità tradizionale. Tuttavia, il principio di fondo – che i contenuti facilmente accessibili e ben strutturati hanno maggiori probabilità di essere scoperti e posizionati – resterà probabilmente valido a prescindere dalle evoluzioni tecnologiche. Investire oggi nell’ottimizzazione della profondità di scansione è quindi una strategia solida per mantenere la visibilità su tutte le piattaforme di ricerca, attuali e future.

La profondità di scansione misura quanto in profondità i bot dei motori di ricerca navigano la gerarchia del tuo sito in base ai link interni e alla struttura degli URL, mentre la profondità di clic misura quanti clic sono necessari per un utente per raggiungere una pagina dalla homepage. Una pagina può avere una profondità di clic di 1 (collegata nel footer) ma una profondità di scansione di 3 (annidata nella struttura dell'URL). La profondità di scansione è dal punto di vista del motore di ricerca, mentre la profondità di clic è dal punto di vista dell'utente.

La profondità di scansione non influisce direttamente sulle classifiche, ma determina in modo significativo se le pagine vengono indicizzate o meno. Le pagine nascoste in profondità nella struttura del sito hanno meno probabilità di essere scansionate all'interno del crawl budget assegnato, il che significa che potrebbero non essere indicizzate o aggiornate frequentemente. Questa riduzione dell'indicizzazione e della freschezza può danneggiare indirettamente le classifiche. Le pagine più vicine alla homepage ricevono tipicamente più attenzione dai crawler e più equity dei link, offrendo loro migliori potenzialità di posizionamento.

La maggior parte degli esperti SEO consiglia di mantenere le pagine importanti entro 3 clic dalla homepage. Questo assicura che siano facilmente individuabili sia dai motori di ricerca che dagli utenti. Per siti più grandi con migliaia di pagine, una certa profondità è necessaria, ma l'obiettivo dovrebbe essere mantenere le pagine critiche il più superficiali possibile. Le pagine a profondità 3 e oltre generalmente performano peggio nei risultati di ricerca a causa della minore frequenza di scansione e della distribuzione dell'equity dei link.

La profondità di scansione influisce direttamente sull'utilizzo efficace del crawl budget. Google assegna a ogni sito uno specifico crawl budget basato sul limite di capacità di scansione e sulla domanda di scansione. Se il tuo sito ha una profondità di scansione eccessiva, con molte pagine nascoste in profondità, i crawler possono esaurire il budget prima di raggiungere tutte le pagine importanti. Ottimizzando la profondità di scansione e riducendo i livelli di pagine non necessari, ti assicuri che i contenuti più preziosi vengano scansionati e indicizzati all'interno del budget assegnato.

Sì, è possibile migliorare l'efficienza della scansione senza ristrutturare l'intero sito. Il linking interno strategico è l'approccio più efficace: collega le pagine importanti e profonde dalla homepage, dalle pagine di categoria o dai contenuti ad alta autorità. Aggiornare regolarmente la sitemap XML, correggere i link interrotti e ridurre le catene di redirect aiuta anche i crawler a raggiungere le pagine più efficientemente. Queste tattiche migliorano la profondità di scansione senza richiedere modifiche architetturali.

I motori di ricerca AI come Perplexity, ChatGPT e Google AI Overviews utilizzano crawler specializzati (PerplexityBot, GPTBot, ecc.) che possono avere pattern di scansione diversi rispetto a Googlebot. Questi crawler AI rispettano comunque i principi della profondità di scansione: le pagine facilmente accessibili e ben collegate hanno maggiori probabilità di essere scoperte e utilizzate come fonti. Ottimizzare la profondità di scansione è utile sia per i motori di ricerca tradizionali che per quelli AI, migliorando la visibilità su tutte le piattaforme di ricerca.

Strumenti come Google Search Console, Screaming Frog SEO Spider, seoClarity e Hike SEO forniscono analisi e visualizzazione della profondità di scansione. Google Search Console mostra statistiche e frequenza di scansione, mentre i crawler SEO specializzati visualizzano la struttura gerarchica del sito e identificano le pagine con profondità eccessiva. Questi strumenti aiutano a individuare opportunità di ottimizzazione e a monitorare i miglioramenti nell'efficienza della scansione nel tempo.

Inizia a tracciare come i chatbot AI menzionano il tuo brand su ChatGPT, Perplexity e altre piattaforme. Ottieni informazioni utili per migliorare la tua presenza AI.

La frequenza di scansione indica quanto spesso i motori di ricerca e i crawler AI visitano il tuo sito. Scopri cosa influenza la frequenza di scansione, perché ...

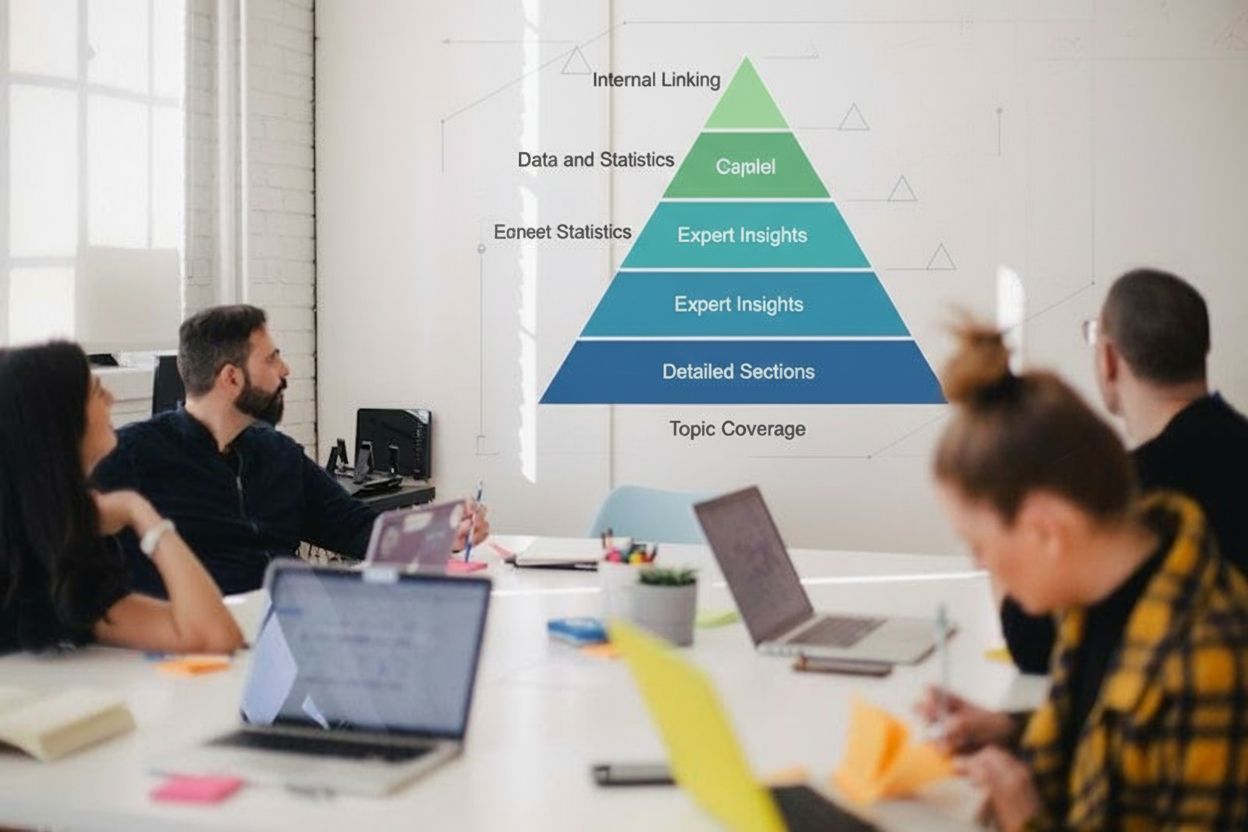

La profondità dei contenuti è la copertura completa di un argomento con sezioni dettagliate, approfondimenti di esperti e dati. Scopri come la profondità dei co...

Scopri strategie comprovate per aumentare la frequenza con cui i crawler AI visitano il tuo sito web, migliorando la visibilità dei contenuti su ChatGPT, Perple...