Impatto dei crawler AI sulle risorse del server: cosa aspettarsi

Scopri come i crawler AI influenzano le risorse del server, la banda e le prestazioni. Approfondisci statistiche reali, strategie di mitigazione e soluzioni inf...

Un approccio strategico che consente ai proprietari di siti web di permettere selettivamente ad alcuni crawler AI l’accesso, mentre ne bloccano altri in base agli obiettivi aziendali, agli accordi di licenza dei contenuti e alla valutazione del valore. Piuttosto che applicare politiche generalizzate, l’accesso differenziale valuta ogni crawler individualmente per determinare se porta traffico, rispetta i termini di licenza o è in linea con gli obiettivi di monetizzazione. Gli editori utilizzano strumenti come robots.txt, header HTTP e controlli specifici delle piattaforme per implementare politiche di accesso granulari. Questo metodo bilancia le opportunità di innovazione con la protezione dei contenuti e una compensazione equa.

Un approccio strategico che consente ai proprietari di siti web di permettere selettivamente ad alcuni crawler AI l’accesso, mentre ne bloccano altri in base agli obiettivi aziendali, agli accordi di licenza dei contenuti e alla valutazione del valore. Piuttosto che applicare politiche generalizzate, l’accesso differenziale valuta ogni crawler individualmente per determinare se porta traffico, rispetta i termini di licenza o è in linea con gli obiettivi di monetizzazione. Gli editori utilizzano strumenti come robots.txt, header HTTP e controlli specifici delle piattaforme per implementare politiche di accesso granulari. Questo metodo bilancia le opportunità di innovazione con la protezione dei contenuti e una compensazione equa.

L’esplosione dei crawler AI ha interrotto radicalmente il rapporto consolidato da decenni tra proprietari di siti web e bot. Per anni, Internet ha funzionato secondo uno scambio semplice: i motori di ricerca come Google indicizzavano i contenuti e indirizzavano traffico alle fonti originali, generando una relazione simbiotica che premiava la creazione di contenuti di qualità. Oggi una nuova generazione di crawler AI—including GPTBot, ClaudeBot, PerplexityBot e decine di altri—opera secondo regole diverse. Questi bot estraggono contenuti non per indicizzarli e renderli scopribili, ma per alimentarli direttamente nei modelli AI che generano risposte senza rimandare gli utenti alla fonte originale. L’impatto è netto: secondo dati Cloudflare, GPTBot di OpenAI mantiene un rapporto crawl-to-referral di circa 1.700:1, mentre ClaudeBot di Anthropic arriva a 73.000:1, ovvero per ogni visitatore rimandato al sito dell’editore, migliaia di pagine vengono scansionate per dati di training. Questo scambio sbilanciato ha costretto gli editori a riconsiderare le politiche di accesso dei crawler, passando dalla scelta binaria “consenti tutto” o “blocca tutto” a una strategia più sfumata: accesso differenziale dei crawler. Invece di applicare politiche generalizzate, gli editori più accorti ora valutano ogni crawler singolarmente, ponendosi domande critiche su valore, licenza e allineamento con obiettivi aziendali.

Comprendere le diverse tipologie di crawler AI è essenziale per attuare una strategia di accesso differenziale efficace, poiché ognuna svolge funzioni distinte con impatti diversi sul tuo business. I crawler AI si suddividono in tre categorie principali: crawler per il training (GPTBot, ClaudeBot, anthropic-ai, CCBot, Bytespider) che raccolgono contenuti per addestrare modelli; crawler di ricerca (OAI-SearchBot, PerplexityBot, Google-Extended) che indicizzano i contenuti per risultati di ricerca AI; e agenti attivati dall’utente (ChatGPT-User, Claude-Web, Perplexity-User) che recuperano contenuti solo su richiesta esplicita degli utenti. La proposta di valore varia notevolmente tra queste categorie. I crawler per il training tipicamente generano traffico minimo verso il tuo sito—estraggono valore senza beneficio reciproco—rendendoli candidati ideali per il blocco. I crawler di ricerca, invece, possono generare traffico di riferimento significativo e conversioni di abbonati, analogamente ai motori di ricerca tradizionali. Gli agenti attivati dall’utente si collocano a metà, attivandosi solo quando l’utente interagisce con i sistemi AI. The Atlantic, uno dei maggiori editori digitali, ha implementato un sofisticato sistema di valutazione dei crawler, monitorando sia il volume di traffico che le conversioni di abbonati per ogni bot. La loro analisi ha rivelato che mentre alcuni crawler generano valore concreto, altri producono praticamente zero traffico pur consumando larghezza di banda. Questo approccio data-driven consente agli editori di prendere decisioni informate invece di basarsi su supposizioni.

| Tipo di Crawler | Esempi | Scopo Primario | Valore Tipico di Traffico | Accesso Raccomandato |

|---|---|---|---|---|

| Training | GPTBot, ClaudeBot, anthropic-ai, CCBot, Bytespider | Dataset per training modelli | Molto basso (rapporto 1.700:1 fino a 73.000:1) | Spesso bloccato |

| Ricerca | OAI-SearchBot, PerplexityBot, Google-Extended | Indicizzazione ricerca AI | Medio-alto | Spesso consentito |

| Attivato Utente | ChatGPT-User, Claude-Web, Perplexity-User | Richieste dirette utente | Variabile | Caso per caso |

Implementare l’accesso differenziale ai crawler richiede una combinazione di strumenti tecnici e decisioni strategiche, con vari metodi disponibili a seconda delle capacità tecniche e delle esigenze di business. Lo strumento più basilare è robots.txt, un semplice file di testo nella root del sito che comunica le preferenze di accesso ai crawler tramite direttive User-agent. Anche se robots.txt è volontario e solo il 40-60% dei bot AI lo rispetta, rimane la prima linea di difesa e non comporta costi di implementazione. Per chi cerca un’applicazione più solida, il robots.txt gestito di Cloudflare crea e aggiorna automaticamente le direttive per i crawler, aggiungendole al file esistente senza bisogno di manutenzione manuale. Oltre a robots.txt, diversi meccanismi di enforcement offrono un controllo aggiuntivo:

L’approccio più efficace combina più livelli: robots.txt per i crawler rispettosi, regole WAF per enforcement, e strumenti di monitoraggio per valutare l’efficacia e individuare nuove minacce.

Implementare l’accesso differenziale dei crawler significa andare oltre l’aspetto tecnico per sviluppare una strategia aziendale coerente con il modello di ricavo e il posizionamento competitivo. L’approccio di The Atlantic offre un framework pratico: ogni crawler viene valutato su due metriche principali—volume di traffico e conversioni abbonati—chiedendosi se il crawler genera valore sufficiente da giustificare l’accesso ai contenuti. Per un editore con valore abbonato annuo di 80€, un crawler che genera 1.000 abbonati vale 80.000€ l’anno, cambiando radicalmente la decisione di accesso. Tuttavia, traffico e conversioni rappresentano solo una parte dell’equazione. Gli editori devono considerare anche:

Gli editori più strategici implementano politiche di accesso a più livelli: consentono i crawler di ricerca che generano traffico, bloccano quelli di training che non lo fanno e negoziano accordi di licenza con le aziende AI di maggior valore. Questo approccio massimizza visibilità e ricavi, proteggendo al contempo la proprietà intellettuale.

Nonostante i notevoli vantaggi, l’accesso differenziale ai crawler è più complesso nella pratica, con diverse sfide fondamentali che ne limitano l’efficacia e richiedono una gestione continua. La limitazione più critica è che robots.txt è volontario: i crawler che lo rispettano lo fanno per scelta, non per obbligo. La ricerca indica che robots.txt ferma solo il 40-60% dei bot AI, un altro 30-40% viene intercettato dal blocco degli user agent, lasciando un 10-30% di crawler che operano senza restrizioni. Alcune aziende AI e attori malevoli ignorano deliberatamente le direttive robots.txt, ritenendo l’accesso ai contenuti più prezioso della conformità. Inoltre, continuano ad evolversi le tecniche di elusione dei crawler: bot sofisticati mascherano gli user agent per sembrare browser legittimi, usano IP distribuiti per evitare il rilevamento e si servono di browser headless che imitano il comportamento umano. Il dilemma Google-Extended esemplifica la complessità: bloccare Google-Extended impedisce ai tuoi contenuti di essere usati per il training di Gemini AI, ma le AI Overviews di Google (che appaiono nei risultati di ricerca) usano le regole standard di Googlebot, quindi non puoi escluderti dalle AI Overviews senza sacrificare la visibilità nella ricerca. Monitoraggio ed enforcement richiedono inoltre risorse significative—tracciare nuovi crawler, aggiornare le policy e validarne l’efficacia richiede attenzione costante. Infine, il quadro normativo è ancora incerto: sebbene la legge sul copyright protegga teoricamente i contenuti, farla rispettare contro le aziende AI è costoso e dagli esiti imprevedibili, lasciando gli editori con il solo controllo tecnico ma senza certezza legale.

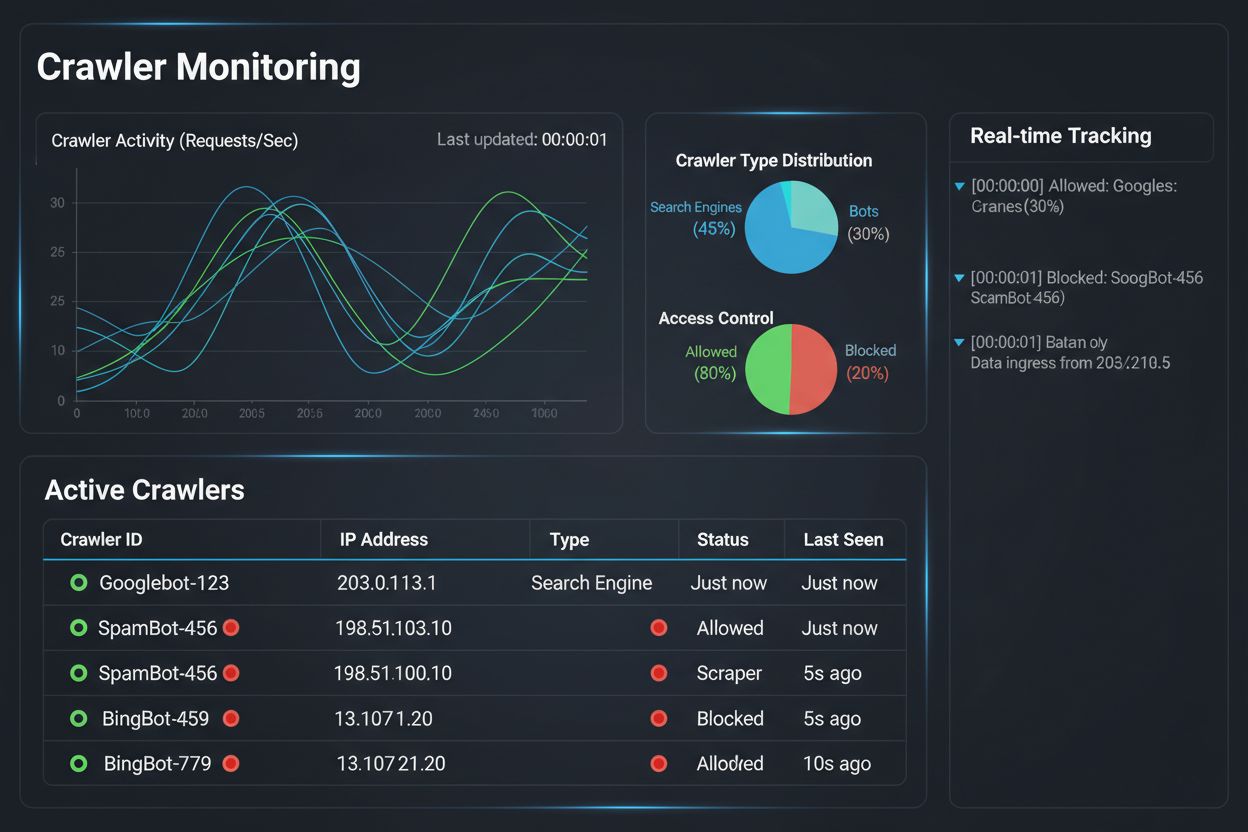

Implementare una strategia di accesso differenziale ai crawler è solo metà del lavoro; l’altra metà consiste nel capire l’effettivo impatto delle proprie policy tramite monitoraggio e misurazione completi. Qui entra in gioco AmICited.com come elemento essenziale della tua strategia di gestione dei crawler. AmICited è specializzata nel monitorare come i sistemi AI citano e fanno riferimento al tuo brand tra GPT, Perplexity, Google AI Overviews e altre piattaforme AI—offrendo visibilità su quali crawler stanno effettivamente usando i tuoi contenuti e come questi appaiono nelle risposte AI. Invece di affidarti ai log del server e alle supposizioni, la dashboard di AmICited mostra esattamente quali sistemi AI hanno acceduto ai tuoi contenuti, con quale frequenza e, soprattutto, se i tuoi contenuti vengono citati o semplicemente assorbiti nei dati di training senza attribuzione. Queste informazioni guidano direttamente le tue decisioni di accesso differenziale: se un crawler accede ai tuoi contenuti ma non li cita mai nelle risposte AI, bloccarlo diventa una decisione aziendale chiara. AmICited offre anche benchmarking competitivo, mostrando come la visibilità dei tuoi contenuti nei sistemi AI si confronta con quella dei concorrenti, aiutandoti a capire se le tue policy di accesso sono troppo restrittive o permissive. Gli alert in tempo reale ti avvisano quando nuovi sistemi AI iniziano a fare riferimento ai tuoi contenuti, permettendoti di intervenire rapidamente sulle policy. Combinando le capacità di monitoraggio di AmICited con gli strumenti di enforcement di Cloudflare, gli editori ottengono visibilità e controllo totali: vedono quali crawler accedono ai contenuti, ne misurano l’impatto aziendale e adattano le policy di conseguenza. Questo approccio data-driven trasforma la gestione dei crawler da adempimento tecnico a funzione strategica di business.

Il panorama dell’accesso differenziale ai crawler si sta evolvendo rapidamente, con nuovi standard e modelli di business che stanno ridefinendo il rapporto tra editori e aziende AI. La proposta IETF sulle preferenze AI rappresenta uno sviluppo importante, stabilendo modalità standardizzate per i siti web di comunicare le proprie preferenze riguardo a training, inferenza e uso in ricerca da parte delle AI. Invece di affidarsi a robots.txt—uno standard di 30 anni fa pensato per i motori di ricerca—questo nuovo framework offre un controllo esplicito e granulare su come i sistemi AI possono usare i contenuti. Parallelamente, stanno prendendo piede modelli di business basati su permessi, con l’iniziativa Pay Per Crawl di Cloudflare che inaugura un quadro in cui le aziende AI pagano gli editori per l’accesso ai contenuti, trasformando i crawler da minacce a fonti di ricavo. Questo passaggio dal blocco alla licenza rappresenta un cambiamento radicale nell’economia di Internet: invece di lottare per l’accesso, editori e aziende AI negoziano una compensazione equa. Anche gli standard di autenticazione e verifica dei crawler stanno avanzando, con metodi crittografici che consentono agli editori di confermare l’identità dei crawler e prevenire richieste mascherate. Guardando avanti, sono attesi quadri normativi più stringenti sull’uso dei dati di training AI, che potrebbero imporre consenso esplicito e compensazione per l’utilizzo dei contenuti. La convergenza di questi trend—standard tecnici, modelli di licenza, meccanismi di autenticazione e pressione regolatoria—fa pensare che l’accesso differenziale ai crawler evolverà da strategia difensiva a funzione aziendale sofisticata, dove gli editori gestiscono, monitorano e monetizzano attivamente l’accesso dei crawler AI. Gli editori che implementano oggi monitoraggio e policy strategiche saranno meglio posizionati per cogliere queste nuove opportunità.

Bloccare tutti i crawler elimina i tuoi contenuti dai sistemi AI, rimuovendo sia rischi che opportunità. L’accesso differenziale ti permette di valutare ogni crawler singolarmente, bloccando quelli che non portano valore e permettendo quelli che generano traffico o rappresentano opportunità di licenza. Questo approccio sfumato massimizza sia la visibilità che i ricavi, proteggendo la proprietà intellettuale.

Puoi monitorare l’attività dei crawler tramite i log del server, la dashboard di analytics di Cloudflare o strumenti specializzati come AmICited.com. AmICited traccia specificamente quali sistemi AI accedono ai tuoi contenuti e come appare il tuo brand nelle risposte AI, fornendo insight a livello aziendale oltre ai log tecnici.

No. Bloccare i crawler AI per il training come GPTBot, ClaudeBot e CCBot non influisce sul posizionamento su Google o Bing. I motori di ricerca tradizionali usano crawler diversi (Googlebot, Bingbot) che operano indipendentemente. Blocca questi ultimi solo se vuoi scomparire del tutto dai risultati di ricerca.

Sì, questo è l’approccio più strategico per molti editori. Puoi permettere ai crawler focalizzati sulla ricerca come OAI-SearchBot e PerplexityBot (che portano traffico) bloccando quelli per il training come GPTBot e ClaudeBot (che tipicamente non lo fanno). Così mantieni la visibilità nei risultati di ricerca AI proteggendo i tuoi contenuti dall’essere assorbiti nei dataset di training.

Sebbene i principali crawler di OpenAI, Anthropic e Google rispettino robots.txt, alcuni bot lo ignorano deliberatamente. Se un crawler non lo rispetta, servono metodi aggiuntivi come regole WAF, blocco IP o le funzionalità di gestione dei bot di Cloudflare. Ecco perché strumenti di monitoraggio come AmICited sono essenziali: mostrano quali crawler stanno effettivamente rispettando le tue politiche.

Rivedi le tue politiche almeno trimestralmente, poiché le aziende AI introducono regolarmente nuovi crawler. Anthropic ha fuso i bot 'anthropic-ai' e 'Claude-Web' in 'ClaudeBot', dando al nuovo bot accesso temporaneo illimitato ai siti che non avevano aggiornato le regole. Il monitoraggio regolare con strumenti come AmICited ti aiuta a rimanere aggiornato sui cambiamenti.

Googlebot è il crawler di ricerca di Google che indicizza i contenuti per i risultati di ricerca. Google-Extended è un token di controllo che determina specificamente se i tuoi contenuti vengono usati per il training di Gemini AI. Puoi bloccare Google-Extended senza influenzare il ranking di ricerca, ma nota che le AI Overviews di Google (che appaiono nei risultati di ricerca) usano le regole standard di Googlebot, quindi non puoi escluderti dalle AI Overviews senza sacrificare la visibilità nella ricerca.

Sì, modelli di licenza emergenti come Pay Per Crawl di Cloudflare permettono agli editori di far pagare le aziende AI per l’accesso ai contenuti. Questo trasforma i crawler da minacce a fonti di ricavo. Tuttavia, è necessaria una negoziazione con le aziende AI e possono essere coinvolti accordi legali. Il monitoraggio di AmICited ti aiuta a individuare quali crawler rappresentano le opportunità di licenza più preziose.

Traccia quali sistemi AI stanno accedendo ai tuoi contenuti e come appare il tuo brand nelle risposte generate dall’AI. Ottieni insight in tempo reale sul comportamento dei crawler e misura l’impatto aziendale delle tue politiche di accesso differenziale.

Scopri come i crawler AI influenzano le risorse del server, la banda e le prestazioni. Approfondisci statistiche reali, strategie di mitigazione e soluzioni inf...

Guida di riferimento completa ai crawler e bot AI. Identifica GPTBot, ClaudeBot, Google-Extended e oltre 20 altri crawler AI con user agent, frequenze di scansi...

Scopri come utilizzare robots.txt per controllare quali bot IA accedono ai tuoi contenuti. Guida completa al blocco di GPTBot, ClaudeBot e altri crawler IA con ...