Edge SEO

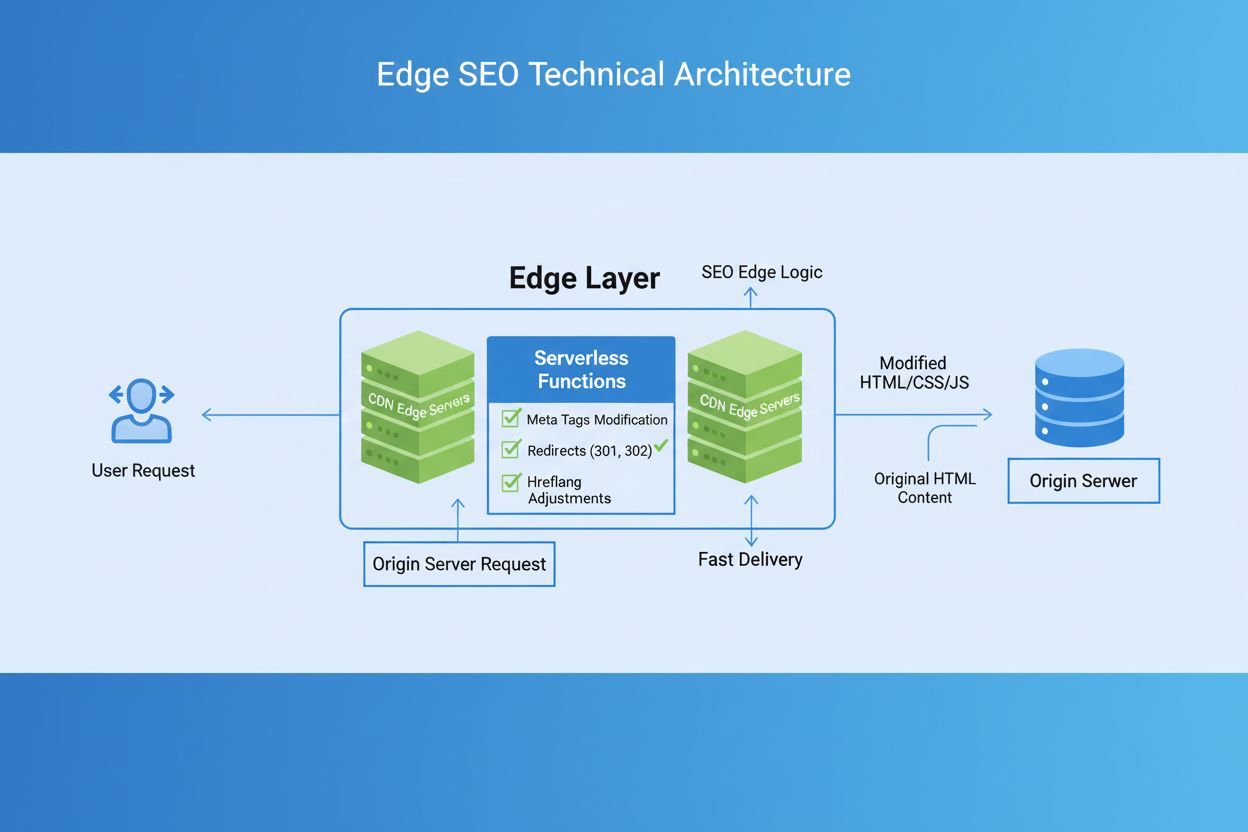

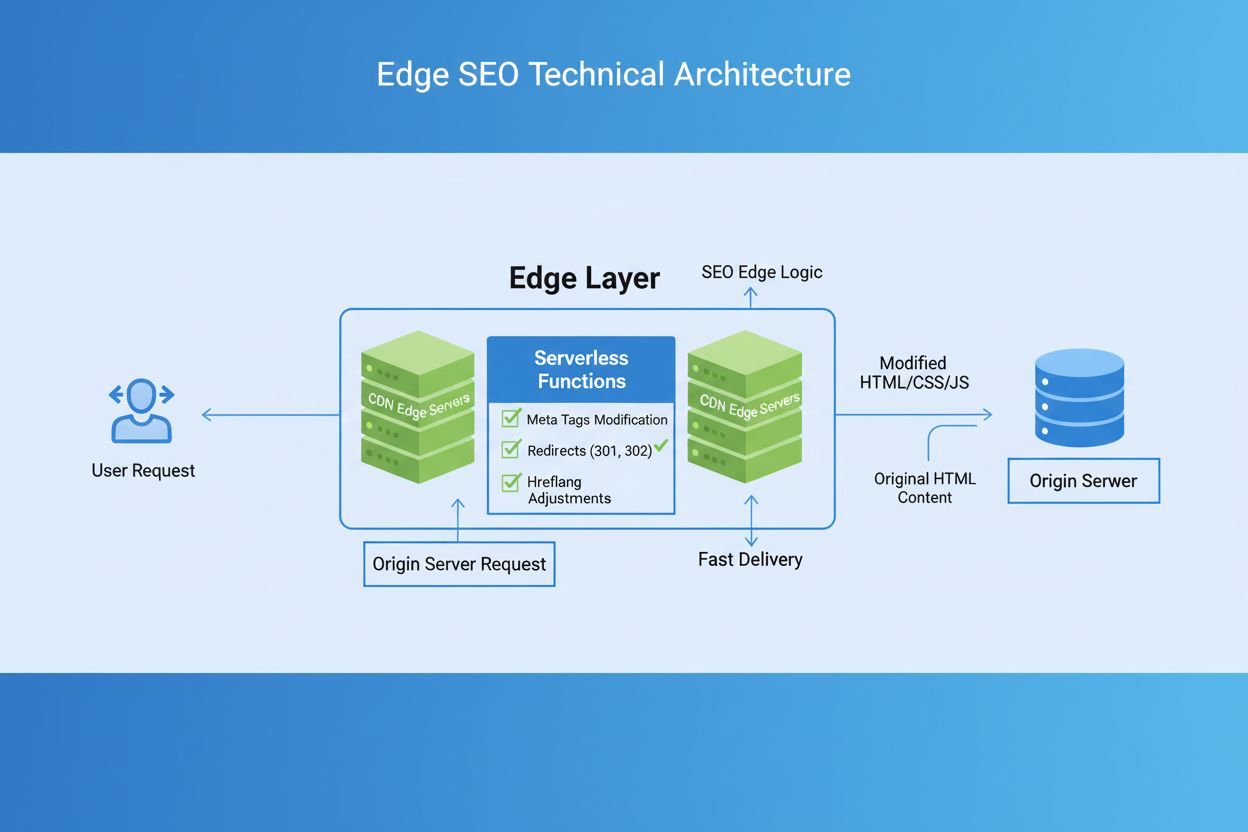

Edge SEO è la pratica di implementare modifiche tecniche SEO al network edge utilizzando funzioni serverless sui CDN. Scopri come migliora le prestazioni, conse...

L’elaborazione Edge AI si riferisce al deployment di algoritmi di intelligenza artificiale direttamente su dispositivi locali o server edge, consentendo l’elaborazione e l’analisi dei dati in tempo reale senza dipendere costantemente dall’infrastruttura cloud. Questo approccio riduce la latenza, migliora la privacy dei dati e permette decisioni immediate per applicazioni come il monitoraggio del brand, dispositivi IoT e sistemi autonomi.

L'elaborazione Edge AI si riferisce al deployment di algoritmi di intelligenza artificiale direttamente su dispositivi locali o server edge, consentendo l'elaborazione e l'analisi dei dati in tempo reale senza dipendere costantemente dall'infrastruttura cloud. Questo approccio riduce la latenza, migliora la privacy dei dati e permette decisioni immediate per applicazioni come il monitoraggio del brand, dispositivi IoT e sistemi autonomi.

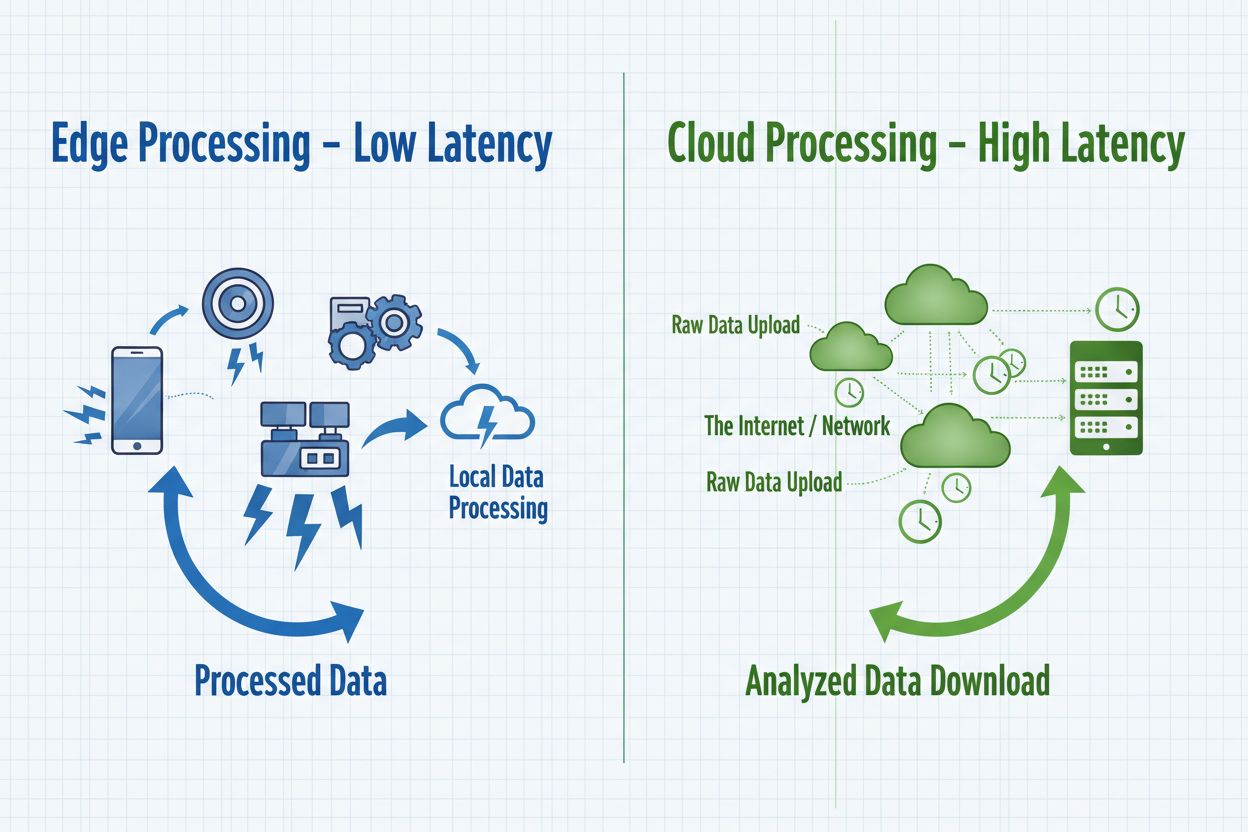

Elaborazione Edge AI rappresenta un cambiamento di paradigma nel deployment dell’intelligenza artificiale, dove i compiti computazionali vengono eseguiti direttamente sui dispositivi edge—come smartphone, sensori IoT, telecamere e sistemi embedded—invece di fare affidamento esclusivamente su server cloud centralizzati. Questo approccio elabora i dati alla fonte, consentendo analisi e decisioni immediate senza trasmettere informazioni grezze a data center remoti. A differenza della tradizionale cloud AI, che invia i dati a server remoti per l’elaborazione e restituisce risultati dopo una latenza di rete, l’Edge AI porta l’intelligenza ai margini delle reti dove i dati vengono generati. L’elaborazione avviene su hardware locale con modelli di machine learning embedded, consentendo ai dispositivi di operare autonomamente e prendere decisioni in tempo reale. L’Edge AI combina reti neurali leggere, algoritmi ottimizzati e acceleratori hardware specializzati per offrire capacità AI entro vincoli di risorse rigorosi. Questo modello di intelligenza distribuita cambia radicalmente il modo in cui le organizzazioni affrontano la privacy dei dati, la reattività dei sistemi e i costi infrastrutturali. Elaborando localmente le informazioni sensibili, l’Edge AI elimina la necessità di trasmettere dati potenzialmente riservati attraverso le reti, rispondendo alle crescenti preoccupazioni sulla privacy nei settori regolamentati.

Edge AI e cloud AI rappresentano approcci complementari al deployment dell’intelligenza artificiale, ciascuno con vantaggi distinti adatti a diversi casi d’uso ed esigenze organizzative. Cloud AI eccelle nella gestione di enormi dataset, nell’addestramento di modelli complessi e nell’esecuzione di compiti computazionalmente intensivi che beneficiano della potenza di elaborazione centralizzata e della scalabilità illimitata. Tuttavia, le soluzioni cloud introducono una latenza intrinseca quando i dati viaggiano attraverso le reti, rendendole inadatte ad applicazioni che richiedono risposte immediate. Edge AI dà priorità a velocità e reattività elaborando localmente le informazioni, abilitando decisioni sotto il millisecondo fondamentali per sistemi autonomi e applicazioni di monitoraggio in tempo reale. La scelta tra questi approcci dipende dai requisiti specifici: la cloud AI è adatta per elaborazioni batch, addestramento modelli e applicazioni in cui sono accettabili lievi ritardi, mentre l’Edge AI serve applicazioni in tempo reale, operazioni sensibili alla privacy e scenari con connettività di rete inaffidabile. Le organizzazioni adottano sempre più architetture ibride che sfruttano entrambi i paradigmi—utilizzando i dispositivi edge per l’elaborazione immediata e l’infrastruttura cloud per l’addestramento dei modelli, l’analisi e l’archiviazione a lungo termine. Comprendere queste differenze fondamentali aiuta le organizzazioni a progettare soluzioni che bilanciano prestazioni, sicurezza ed efficienza operativa.

| Aspetto | Edge AI | Cloud AI |

|---|---|---|

| Latenza | Tempi di risposta sotto il millisecondo; elaborazione locale immediata | 50-500ms+ dovuti a trasmissione di rete ed elaborazione server |

| Banda | Trasmissione dati minima; elaborazione locale | Elevati requisiti di banda; trasmissione continua di dati grezzi |

| Sicurezza & Privacy | I dati restano locali; minore esposizione a violazioni | I dati viaggiano sulle reti; archiviazione centralizzata crea punto singolo di vulnerabilità |

| Potenza Computazionale | Limitata dall’hardware del dispositivo; modelli leggeri ottimizzati | Scalabilità illimitata; gestisce modelli complessi e grandi dataset |

| Scalabilità | Scalabilità orizzontale su dispositivi distribuiti | Scalabilità verticale con infrastruttura server; gestione centralizzata |

I sistemi Edge AI comprendono quattro componenti tecnici essenziali che lavorano insieme per offrire elaborazione intelligente ai margini della rete. Il motore di inferenza esegue modelli di machine learning pre-addestrati sui dispositivi edge, effettuando predizioni e classificazioni senza necessità di connessione cloud. Questi motori utilizzano framework ottimizzati come TensorFlow Lite, ONNX Runtime e PyTorch Mobile che comprimono i modelli affinché rientrino nei limiti di memoria dei dispositivi mantenendo livelli di accuratezza accettabili. Gli acceleratori hardware—tra cui GPU, TPU e chip AI specializzati—forniscono la potenza computazionale necessaria per eseguire reti neurali in modo efficiente su dispositivi con risorse limitate. I dispositivi edge impiegano tecniche di ottimizzazione dei modelli come quantizzazione, pruning e distillazione della conoscenza per ridurre le dimensioni e i requisiti computazionali dei modelli senza degradare significativamente le prestazioni. Il livello di gestione dati gestisce la raccolta locale, la pre-elaborazione e la trasmissione selettiva degli insight rilevanti ai sistemi cloud per aggregazione e analisi a lungo termine. Infine, il modulo di connettività gestisce connessioni di rete intermittenti, consentendo ai dispositivi di operare offline sincronizzando i dati quando la connettività è disponibile.

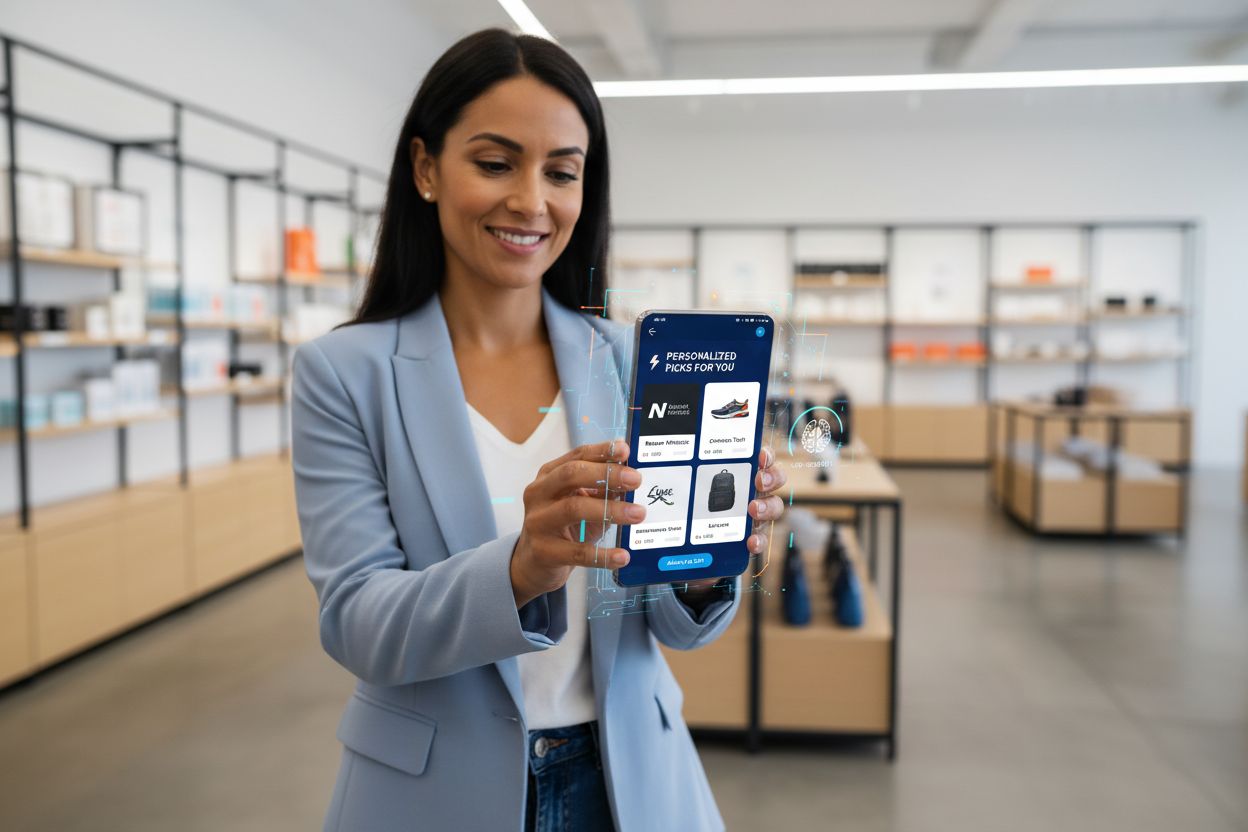

L’Elaborazione Edge AI abilita capacità senza precedenti nelle raccomandazioni di brand in tempo reale e nel monitoraggio degli output IA, supportando direttamente la necessità delle organizzazioni di tracciare e verificare le decisioni AI nel punto di esecuzione. Le applicazioni retail sfruttano l’Edge AI per offrire raccomandazioni di prodotto personalizzate istantaneamente durante la navigazione dei clienti, analizzando i pattern di comportamento localmente senza trasmettere dati sensibili di shopping a server esterni. Il monitoraggio in tempo reale degli output IA diventa possibile quando l’inferenza avviene sui dispositivi edge, consentendo alle organizzazioni di rilevare immediatamente anomalie, predizioni distorte o drift dei modelli prima che le raccomandazioni raggiungano i clienti. Questa elaborazione localizzata crea tracciabilità e log delle decisioni che supportano i requisiti di conformità e permettono ai brand di capire esattamente perché sono state generate determinate raccomandazioni. I sistemi di monitoraggio Edge AI possono segnalare pattern sospetti—come raccomandazioni che favoriscono in modo sproporzionato certi prodotti o demografie—consentendo interventi rapidi e aggiustamenti ai modelli. Per la sicurezza del brand e la gestione della reputazione, il monitoraggio IA basato su edge assicura che i sistemi automatici operino entro parametri definiti e siano allineati ai valori del brand prima del rilascio al cliente. La possibilità di monitorare gli output IA in tempo reale all’edge trasforma il modo in cui le organizzazioni mantengono il controllo qualità sulle decisioni algoritmiche, supportando iniziative di trasparenza e costruendo fiducia nel cliente attraverso una governance IA verificabile.

L’Elaborazione Edge AI offre vantaggi sostanziali su più dimensioni che affrontano sfide organizzative critiche negli ambienti digitali moderni. Riduzione della latenza è il beneficio principale, consentendo applicazioni che richiedono risposte immediate—veicoli autonomi che prendono decisioni di navigazione in frazioni di secondo, robot industriali che reagiscono a pericoli, o dispositivi medici che rilevano condizioni critiche del paziente. Maggiore privacy emerge come vantaggio secondario, poiché i dati sensibili restano sui dispositivi locali invece di transitare sulle reti o essere archiviati in cloud centralizzati, rispondendo a GDPR, HIPAA e altri requisiti normativi. Ottimizzazione della banda riduce la congestione di rete e i costi associati elaborando i dati localmente e trasmettendo solo insight rilevanti invece di flussi di dati grezzi. Funzionalità offline permette ai dispositivi edge di continuare a operare e prendere decisioni intelligenti anche quando la connettività di rete viene meno, fondamentale per località remote e applicazioni mission-critical. Maggiore affidabilità deriva dall’elaborazione distribuita—i guasti su singoli dispositivi edge non si propagano sull’intera infrastruttura, e l’elaborazione locale continua indipendentemente dalla disponibilità dei servizi cloud. Efficienza dei costi si ottiene grazie alla riduzione delle spese cloud, poiché le organizzazioni elaborano i dati localmente invece di pagare per infrastrutture cloud continue e trasmissione dati. Vantaggi di scalabilità si manifestano in modo diverso rispetto ai sistemi cloud; l’Edge AI scala orizzontalmente su dispositivi distribuiti senza richiedere espansione infrastrutturale centralizzata, rendendolo ideale per deployment IoT su migliaia di dispositivi.

L’Elaborazione Edge AI trasforma le operazioni in settori diversi abilitando decisioni intelligenti nel punto di generazione dei dati. Stabilimenti produttivi adottano l’Edge AI per manutenzione predittiva, analizzando localmente vibrazioni e pattern termici dell’equipaggiamento per prevedere guasti, riducendo downtime e costi di manutenzione. Operatori sanitari utilizzano l’Edge AI in dispositivi di imaging medico che eseguono analisi preliminari localmente, accelerando la diagnosi e proteggendo la privacy del paziente mantenendo i dati sensibili in sede. Ambienti retail implementano l’Edge AI per gestione inventario, analisi del comportamento cliente e raccomandazioni personalizzate fornite istantaneamente senza latenza cloud. Veicoli autonomi dipendono completamente dall’Edge AI, elaborando localmente i dati dei sensori di telecamere, lidar e radar per prendere decisioni di navigazione e sicurezza in millisecondi. Sistemi smart home sfruttano l’Edge AI per riconoscere comandi vocali, rilevare minacce di sicurezza e automatizzare routine senza trasmettere audio o video ai server cloud. Le applicazioni di sicurezza e videosorveglianza usano l’Edge AI per rilevare anomalie, identificare minacce e generare allarmi localmente, riducendo i falsi positivi tramite filtri intelligenti prima di inviare le segnalazioni ai centri di monitoraggio. Le operazioni agricole impiegano l’Edge AI su sensori IoT per monitorare condizioni del suolo, pattern meteorologici e stato delle colture, prendendo decisioni di irrigazione e fertilizzazione localmente e minimizzando i costi di trasmissione dati in aree rurali con connettività limitata.

Nonostante i vantaggi sostanziali, l’Elaborazione Edge AI affronta importanti sfide tecniche e operative che le organizzazioni devono affrontare in fase di implementazione. Il consumo energetico resta un vincolo critico, poiché l’esecuzione di reti neurali su dispositivi alimentati a batteria consuma energia rapidamente, limitando la durata del deployment e richiedendo ottimizzazione attenta dei modelli per bilanciare accuratezza ed efficienza. Limitazioni computazionali restringono la complessità dei modelli deployabili sui dispositivi edge; le organizzazioni devono scegliere tra modelli semplificati con accuratezza ridotta o tempi di inferenza più lunghi su hardware con risorse limitate. La complessità nella gestione dei modelli cresce notevolmente in ambienti distribuiti, poiché aggiornare i modelli su migliaia di dispositivi richiede versioning robusto, capacità di rollback e meccanismi per assicurare la coerenza sull’intero parco macchine. L’eterogeneità dei dati rappresenta una sfida quando i dispositivi edge operano in ambienti diversi con caratteristiche di dati variabili, potenzialmente causando scarse performance di modelli addestrati su dataset centralizzati rispetto ai dati locali. Difficoltà di debug e monitoraggio emergono dalla natura distribuita dei sistemi edge, rendendo difficile diagnosticare guasti, comprendere il comportamento dei modelli e raccogliere metriche di performance su dispositivi geograficamente dispersi. Vulnerabilità di sicurezza sui dispositivi edge creano superfici d’attacco, poiché dispositivi compromessi potrebbero eseguire codice malevolo o manipolare i modelli locali, richiedendo misure di sicurezza robuste e aggiornamenti regolari. La complessità di integrazione con l’infrastruttura cloud esistente richiede pianificazione architetturale accurata per garantire che i sistemi edge comunichino efficacemente con pipeline centralizzate di analisi e addestramento modelli.

L’intersezione tra Elaborazione Edge AI e monitoraggio dell’IA genera potenti capacità per le organizzazioni che desiderano mantenere il controllo sulle decisioni algoritmiche su larga scala. Gli approcci tradizionali di monitoraggio IA hanno difficoltà con sistemi basati su cloud dove latenza e costi di trasmissione dati limitano la visibilità in tempo reale sugli output dei modelli; il monitoraggio edge supera questo limite consentendo analisi locale delle predizioni prima che impattino i clienti. Sistemi di verifica degli output deployati su dispositivi edge possono validare immediatamente le predizioni rispetto alle regole di business, rilevare anomalie e segnalare decisioni che richiedono revisione umana prima dell’esecuzione. Questo approccio di monitoraggio localizzato supporta iniziative di sicurezza del brand garantendo che raccomandazioni, decisioni sui contenuti e interazioni con i clienti generate dall’IA siano allineate ai valori organizzativi e ai requisiti di conformità. I sistemi di monitoraggio edge generano tracciabilità dettagliata che documenta perché sono state prese determinate decisioni, supportando requisiti di trasparenza e consentendo analisi post-hoc del comportamento algoritmico. Meccanismi di rilevamento bias operanti all’edge possono identificare quando i modelli producono risultati sproporzionati tra gruppi demografici, consentendo interventi rapidi prima che raccomandazioni distorte raggiungano i clienti. La combinazione di edge AI e monitoraggio crea un ciclo di feedback in cui i log locali delle decisioni informano il riaddestramento dei modelli, assicurando che i sistemi migliorino costantemente mantenendo il controllo sul loro comportamento. Le organizzazioni che implementano monitoraggio edge IA ottengono visibilità senza precedenti sulle decisioni algoritmiche, trasformando l’IA da una “scatola nera” a un sistema trasparente e auditabile che supporta sia l’ottimizzazione delle performance che una governance IA responsabile.

L’Elaborazione Edge AI si trova all’avanguardia dell’evoluzione tecnologica, con trend emergenti che stanno ridefinendo il modo in cui le organizzazioni deployano e gestiscono l’intelligenza distribuita. Il federated learning rappresenta un approccio trasformativo in cui i dispositivi edge addestrano modelli in modo collaborativo senza trasmettere dati grezzi ai server centralizzati, abilitando il machine learning privacy-preserving su larga scala. L’espansione delle reti 5G accelererà enormemente l’adozione Edge AI fornendo connettività affidabile e a bassa latenza che consente sincronizzazione fluida tra dispositivi edge e infrastruttura cloud mantenendo i vantaggi dell’elaborazione locale. Lo sviluppo di hardware specializzato continua ad avanzare, con produttori che creano chip IA sempre più efficienti ottimizzati per applicazioni edge specifiche, migliorando i parametri di prestazioni per watt fondamentali per dispositivi alimentati a batteria. Le proiezioni di mercato indicano una crescita esplosiva, con il mercato globale dell’Edge AI previsto a raggiungere 15,7 miliardi di dollari entro il 2030, con un tasso di crescita annuo composto del 38,3% dal 2023 al 2030. TinyML (machine learning su microcontrollori) emerge come un trend significativo, abilitando capacità IA su dispositivi con memoria e potenza di calcolo minime, ampliando le applicazioni Edge AI a casi d’uso prima irrealizzabili. Tecnologie di containerizzazione e orchestrazione come Kubernetes si stanno adattando agli ambienti edge, consentendo alle organizzazioni di gestire deployment edge distribuiti con gli stessi strumenti e processi usati per l’infrastruttura cloud. La convergenza di questi trend suggerisce un futuro in cui l’elaborazione intelligente avviene in modo fluido su reti distribuite, con dispositivi edge che gestiscono decisioni in tempo reale mentre i sistemi cloud forniscono addestramento, aggregazione e analisi a lungo termine.

Il deployment efficace dell’Elaborazione Edge AI richiede una pianificazione attenta su più dimensioni per garantire che i sistemi offrano le prestazioni e il valore attesi. La selezione del modello rappresenta la prima decisione critica, richiedendo alle organizzazioni di valutare i modelli pre-addestrati disponibili, verificarne l’accuratezza sui casi d’uso target e determinare se sia necessario lo sviluppo di modelli personalizzati. Le strategie di ottimizzazione devono bilanciare l’accuratezza del modello rispetto ai vincoli dei dispositivi, impiegando tecniche come quantizzazione, pruning e ricerca architetturale per creare modelli che si adattino alle limitazioni hardware mantenendo prestazioni accettabili. La scelta dell’hardware dipende dai requisiti applicativi specifici, dalle esigenze computazionali e dai vincoli energetici; le organizzazioni devono valutare opzioni che vanno dai processori generici ad acceleratori IA specializzati. I meccanismi di deployment richiedono processi robusti per distribuire i modelli su dispositivi edge, gestire le versioni e ripristinare versioni precedenti in caso di problemi. I sistemi di monitoraggio e osservabilità devono tracciare le prestazioni dei modelli, rilevare drift dei dati, identificare anomalie e generare alert quando i sistemi si discostano dal comportamento atteso. L’indurimento della sicurezza protegge i dispositivi edge da accessi non autorizzati, furto di modelli e manipolazioni malevole tramite crittografia, autenticazione e aggiornamenti di sicurezza regolari. La pianificazione dell’integrazione assicura che i sistemi edge comunichino efficacemente con l’infrastruttura cloud per aggiornamenti modelli, analisi e archiviazione dati a lungo termine, creando architetture ibride coese che sfruttano i vantaggi di entrambi i paradigmi. Le organizzazioni che implementano Edge AI dovrebbero stabilire metriche di successo chiare, effettuare pilot su scala limitata prima del rollout completo e mantenere flessibilità per adattare le strategie in base ai dati di performance reali.

Edge AI elabora i dati localmente sui dispositivi con tempi di risposta immediati (latenza sotto il millisecondo), mentre Cloud AI invia i dati a server remoti per l'elaborazione, introducendo ritardi di rete. Edge AI dà priorità a velocità e privacy, mentre Cloud AI offre potenza computazionale illimitata per compiti complessi.

L’Edge AI mantiene i dati sensibili sui dispositivi locali invece di trasmetterli attraverso le reti o archiviarli su server cloud centralizzati. Questo approccio riduce l’esposizione a violazioni, supporta la conformità a GDPR e HIPAA, e garantisce che le informazioni personali rimangano sotto il controllo dell’organizzazione.

L’Edge AI raggiunge tempi di risposta sotto il millisecondo elaborando i dati localmente, rispetto ai 50-500ms o più dei sistemi basati su cloud. Questa drastica riduzione della latenza consente applicazioni in tempo reale come veicoli autonomi, robotica industriale e dispositivi medici che richiedono decisioni immediate.

Sì, i sistemi Edge AI possono operare completamente offline poiché l’elaborazione avviene localmente sui dispositivi. Questa funzionalità offline è fondamentale per località remote con connettività inaffidabile e applicazioni mission-critical dove i guasti di rete non possono interrompere le operazioni.

L’Edge AI gira su dispositivi diversi tra cui smartphone, sensori IoT, apparecchiature industriali, telecamere di sicurezza, smartwatch, veicoli autonomi e sistemi embedded. I dispositivi edge moderni spaziano da microcontrollori con risorse minime a potenti computer a scheda singola con acceleratori IA specializzati.

L’Edge AI elabora i dati localmente e trasmette solo insight rilevanti invece di flussi di informazioni grezze. Questa trasmissione selettiva riduce drasticamente il consumo di banda, abbassando i costi di rete e migliorando le prestazioni di sistema minimizzando la trasmissione di dati attraverso le reti.

L’Edge AI consente il monitoraggio in tempo reale delle raccomandazioni e decisioni generate dall’IA nel punto di esecuzione, permettendo alle organizzazioni di rilevare immediatamente anomalie, verificare la sicurezza del brand e assicurarsi che gli output algoritmici siano allineati ai valori organizzativi prima di raggiungere i clienti.

Le principali sfide includono consumo energetico su dispositivi alimentati a batteria, limitazioni computazionali che richiedono ottimizzazione dei modelli, complessità nella gestione di sistemi distribuiti, vulnerabilità di sicurezza sui dispositivi edge e difficoltà di integrazione con l’infrastruttura cloud esistente.

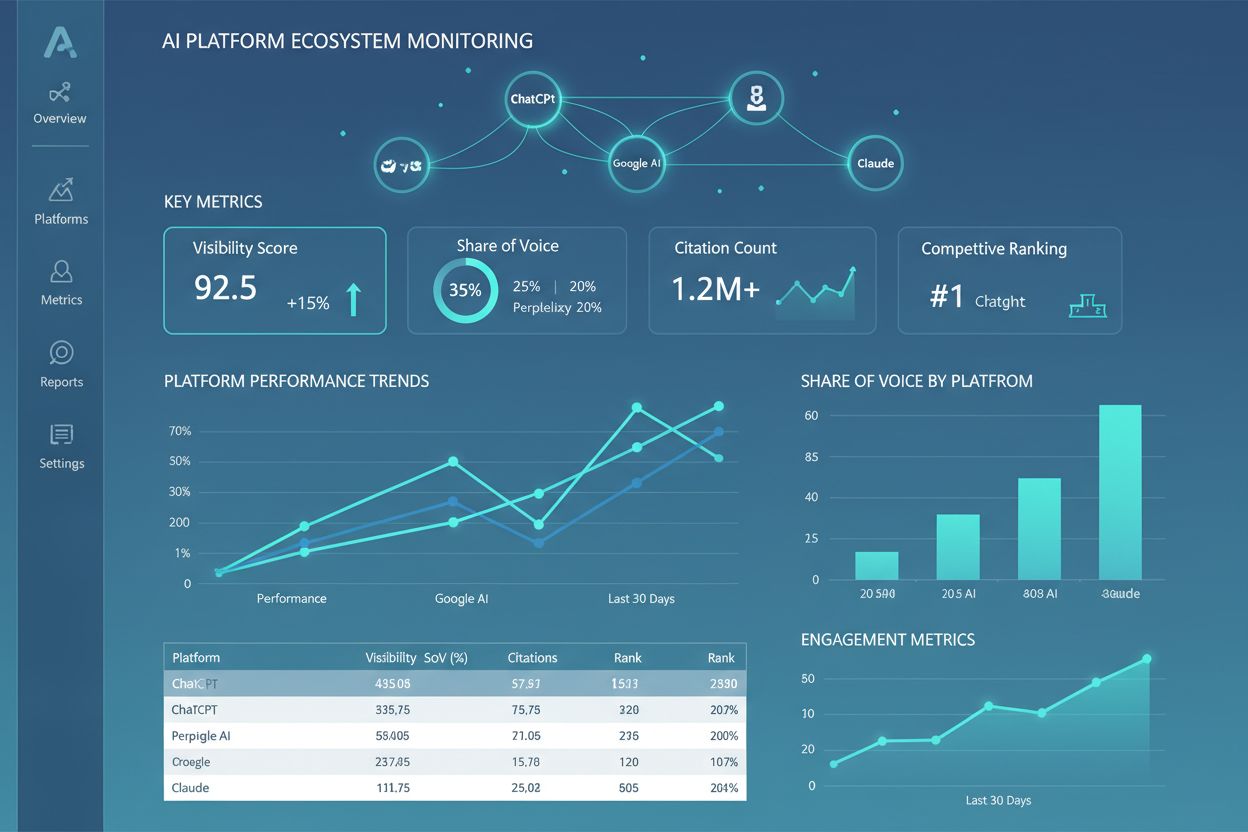

L'elaborazione Edge AI consente l’analisi istantanea degli output IA e delle citazioni del brand. AmICited traccia come il tuo brand appare nei contenuti generati dall’IA su GPT, Perplexity e Google AI Overviews con precisione in tempo reale.

Edge SEO è la pratica di implementare modifiche tecniche SEO al network edge utilizzando funzioni serverless sui CDN. Scopri come migliora le prestazioni, conse...

Scopri i componenti essenziali, i framework e gli strumenti necessari per costruire uno stack tecnologico di ricerca AI moderno. Approfondisci sistemi di recupe...

Scopri cos’è un Ecosistema delle Piattaforme di IA, come i sistemi AI interconnessi lavorano insieme e perché è importante gestire la presenza del tuo brand su ...