Trasparenza negli sforzi di visibilità dell'IA: migliori pratiche di divulgazione

Scopri le migliori pratiche essenziali per la trasparenza e la divulgazione dell'IA. Esplora metodi comportamentali, verbali e tecnici di divulgazione per costr...

Requisiti normativi per le istituzioni finanziarie volti a divulgare in modo trasparente l’utilizzo dell’intelligenza artificiale nei processi decisionali, nella gestione del rischio e nelle applicazioni rivolte ai clienti. Comprende le aspettative normative di SEC, CFPB, FINRA e altri enti in merito alla documentazione della governance dell’IA, delle performance dei modelli e degli impatti su consumatori e mercati.

Requisiti normativi per le istituzioni finanziarie volti a divulgare in modo trasparente l'utilizzo dell'intelligenza artificiale nei processi decisionali, nella gestione del rischio e nelle applicazioni rivolte ai clienti. Comprende le aspettative normative di SEC, CFPB, FINRA e altri enti in merito alla documentazione della governance dell'IA, delle performance dei modelli e degli impatti su consumatori e mercati.

Divulgazione dell’IA Finanziaria si riferisce ai requisiti normativi e alle migliori pratiche per le istituzioni finanziarie di divulgare in modo trasparente l’utilizzo dell’intelligenza artificiale nei processi decisionali, nella gestione del rischio e nelle applicazioni rivolte ai clienti. Comprende le aspettative normative di SEC, CFPB, FINRA e altri enti in merito alla documentazione della governance dell’IA, delle prestazioni dei modelli e dei potenziali impatti su consumatori e mercati. Nel dicembre 2024, il Comitato Consultivo degli Investitori (IAC) della SEC ha avanzato una raccomandazione formale affinché l’agenzia emetta linee guida che richiedano agli emittenti di divulgare informazioni sull’impatto dell’intelligenza artificiale sulle loro aziende. L’IAC ha citato una “mancanza di coerenza” nelle attuali divulgazioni sull’IA, che “può essere problematica per gli investitori che cercano informazioni chiare e comparabili.” Solo il 40% delle aziende dell’S&P 500 fornisce divulgazioni relative all’IA e solo il 15% divulga informazioni sulla supervisione del consiglio sull’IA, nonostante il 60% delle aziende dell’S&P 500 consideri l’IA un rischio materiale.

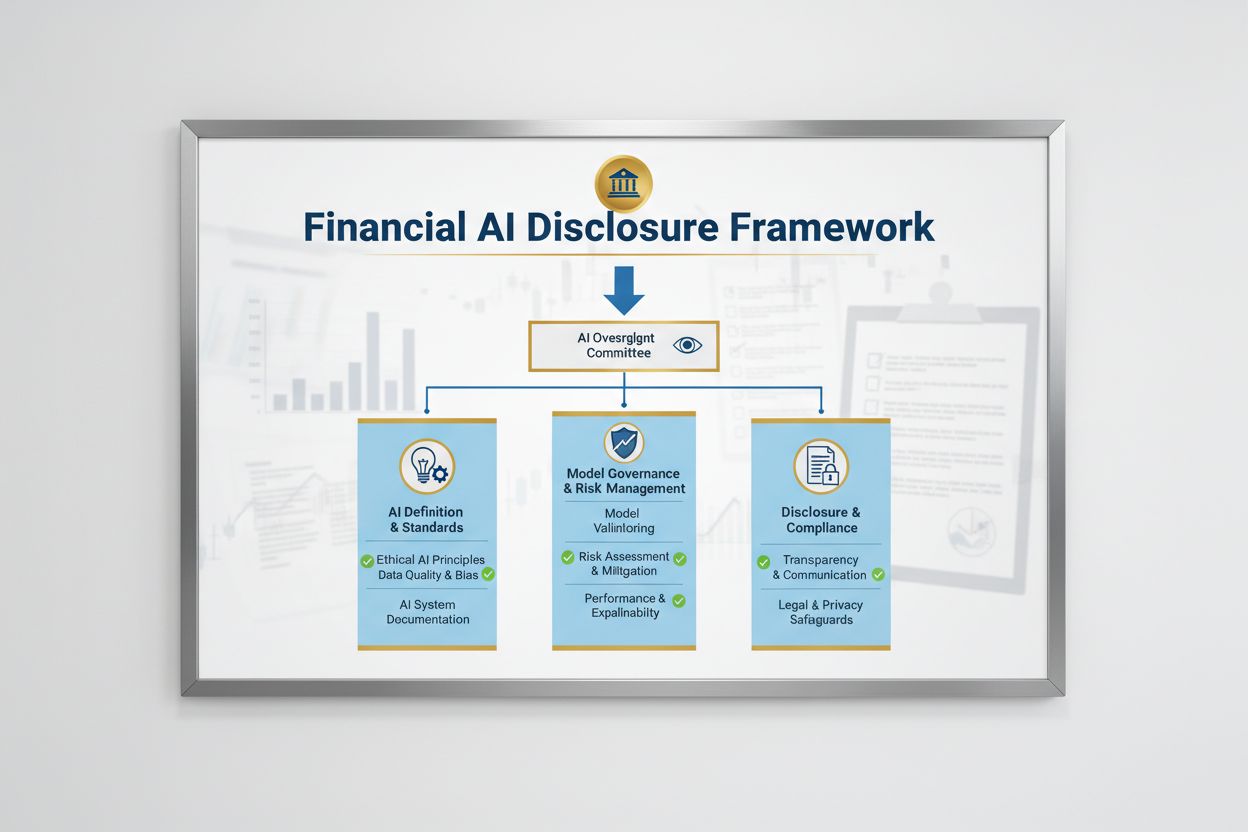

Il panorama normativo per la Divulgazione dell’IA Finanziaria è modellato da molteplici agenzie federali che applicano leggi esistenti e neutrali rispetto alla tecnologia ai sistemi IA. Il Comitato Consultivo degli Investitori della SEC ha proposto un quadro iniziale con tre pilastri chiave: (1) richiedere agli emittenti di definire cosa intendono per “Intelligenza Artificiale”, (2) divulgare i meccanismi di supervisione del consiglio per il deployment dell’IA, e (3) riportare i deployment materiali dell’IA e i loro effetti sulle operazioni interne e sui prodotti rivolti ai consumatori. Oltre alla SEC, CFPB, FINRA, OCC e Federal Reserve hanno tutti emanato linee guida che sottolineano che le leggi esistenti sulla tutela del consumatore—including prestito equo, privacy dei dati e norme anti-frode—si applicano ai sistemi IA indipendentemente dalla tecnologia utilizzata. Queste agenzie adottano un approccio neutrale rispetto alla tecnologia, il che significa che gli obblighi di conformità previsti dall’Equal Credit Opportunity Act (ECOA), dal Fair Credit Reporting Act (FCRA), dal Gramm-Leach-Bliley Act (GLBA) e dagli standard UDAAP (Unfair or Deceptive Acts or Practices) rimangono invariati quando è coinvolta l’IA.

| Regolatore | Area di Interesse | Requisito Chiave |

|---|---|---|

| SEC | Divulgazione agli investitori, conflitti di interesse | Definire l’IA, divulgare la supervisione del consiglio, riportare i deployment materiali |

| CFPB | Prestito equo, tutela del consumatore | Garantire che i modelli IA rispettino l’ECOA, fornire avvisi di azione avversa |

| FINRA | Operazioni dei broker-dealer, comunicazioni con i clienti | Stabilire policy di governance IA, supervisionare l’uso dell’IA in tutte le funzioni |

| OCC/Federal Reserve/FDIC | Governance dei modelli bancari, rischio operativo | Validare i modelli IA, documentare i controlli, valutare l’affidabilità |

| FTC | Pratiche ingannevoli, gestione dei dati | Monitorare le affermazioni relative all’IA, prevenire l’uso scorretto dei dati |

Una Divulgazione dell’IA Finanziaria efficace richiede una chiara supervisione a livello di consiglio d’amministrazione sul deployment e la gestione dei rischi dell’intelligenza artificiale. La raccomandazione dell’IAC della SEC sottolinea che gli investitori hanno un interesse legittimo a comprendere se esistano linee di autorità chiare riguardo il deployment della tecnologia IA sulle operazioni interne e sulle linee di prodotto. Le istituzioni finanziarie devono istituire strutture di governance che assegnino la responsabilità della supervisione dell’IA al Consiglio di Amministrazione o a un comitato designato, garantendo che i rischi legati all’IA siano gestiti ai massimi livelli dell’organizzazione. Questo quadro di governance dovrebbe includere policy e procedure documentate per lo sviluppo, il testing, la validazione e il deployment dell’IA, con reportistica periodica al consiglio sulle performance dei modelli, i rischi individuati e le azioni di remediation. Senza una chiara responsabilità del consiglio, le istituzioni finanziarie rischiano controlli normativi e possibili azioni sanzionatorie per supervisione inadeguata dei sistemi IA materiali.

Le istituzioni finanziarie devono divulgare separatamente gli effetti materiali del deployment dell’IA sulle operazioni interne e sui prodotti rivolti ai consumatori. Per le operazioni interne, le divulgazioni dovrebbero riguardare l’impatto dell’IA sul capitale umano (come riduzioni della forza lavoro o esigenze di upskilling), sulla precisione della rendicontazione finanziaria, sui processi di governance e sui rischi di cybersecurity. Per le questioni rivolte ai consumatori, le istituzioni dovrebbero divulgare investimenti in piattaforme guidate dall’IA, integrazione dell’IA nei prodotti e servizi, impatti normativi derivanti dall’uso dell’IA e come l’IA influenzi strategie di pricing o benchmark di business. La SEC raccomanda di integrare queste divulgazioni nelle voci di disclosure esistenti del Regulation S-K (come Items 101, 103, 106 e 303) su base informata dalla materialità, piuttosto che istituire nuove categorie di disclosure. Questo approccio consente alle istituzioni finanziarie di sfruttare i quadri di disclosure esistenti fornendo agli investitori informazioni chiare e comparabili sul ruolo dell’IA nelle operazioni e nella direzione strategica dell’organizzazione.

Dati di alta qualità sono fondamentali per un deployment responsabile dell’IA nei servizi finanziari, eppure molte istituzioni faticano a implementare quadri di governance dei dati che soddisfino le aspettative normative. Le istituzioni finanziarie devono assicurarsi che i dati utilizzati per addestrare, testare e validare i modelli IA siano puliti, completi, standardizzati e comprensivi, con documentazione chiara sulle fonti dati, la loro provenienza e ogni limitazione nota. Le misure di sicurezza dei dati devono prevenire il “data poisoning”—la manipolazione dei dati di training per compromettere l’integrità dei modelli—e tutelare contro accessi non autorizzati o divulgazione di informazioni sensibili. Il Gramm-Leach-Bliley Act (GLBA) offre protezioni di base per i dati finanziari dei consumatori, ma molti regolatori e associazioni dei consumatori sostengono che tali tutele siano insufficienti nel contesto IA, soprattutto per l’espansione della raccolta e dell’utilizzo dei dati per il training dei modelli. Le istituzioni finanziarie devono inoltre affrontare questioni di proprietà intellettuale, assicurandosi di avere le necessarie autorizzazioni per l’utilizzo dei dati nello sviluppo IA e di rispettare i diritti di proprietà intellettuale di terze parti. Implementare solidi quadri di governance dei dati, inclusi principi di minimizzazione dei dati, controlli di accesso e audit regolari, è essenziale per dimostrare la conformità alle aspettative normative.

Le autorità di regolamentazione hanno chiarito che i modelli IA utilizzati nei processi decisionali finanziari devono essere testati per bias e potenziali risultati discriminatori, indipendentemente dall’accuratezza o dalle performance complessive del modello. Il problema della “scatola nera”—dove sistemi IA complessi producono risultati difficili o impossibili da spiegare—genera rischi di conformità significativi, specialmente nelle applicazioni rivolte ai consumatori come concessione del credito, pricing e rilevamento frodi. Le istituzioni finanziarie devono implementare processi per individuare e mitigare i bias durante l’intero ciclo di vita del modello, inclusi test di bias durante lo sviluppo, la validazione e il monitoraggio continuo. La conformità al prestito equo richiede che le istituzioni siano in grado di spiegare le ragioni specifiche di decisioni avverse (come i rifiuti di credito) e dimostrare che i loro modelli IA non hanno impatti sproporzionati su categorie protette. I test per “alternative meno discriminatorie”—metodi che raggiungono gli stessi obiettivi di business riducendo il bias—sono sempre più richiesti dai regolatori. Molte istituzioni stanno adottando tecniche di IA spiegabile (xAI), come l’analisi dell’importanza delle feature e gli alberi decisionali, per migliorare trasparenza e responsabilità nelle decisioni guidate dall’IA.

Le istituzioni finanziarie che utilizzano l’IA in applicazioni rivolte ai consumatori devono rispettare le leggi esistenti sulla tutela del consumatore, inclusi i requisiti per le notifiche di azione avversa, le informative sulla privacy dei dati e il trattamento equo. Quando un sistema IA viene utilizzato per prendere o influenzare significativamente decisioni su credito, assicurazioni o altri prodotti finanziari, i consumatori hanno diritto a comprendere perché sono stati rifiutati o hanno ricevuto condizioni meno favorevoli. Il CFPB ha sottolineato che i creditori soggetti all’Equal Credit Opportunity Act (ECOA) non possono utilizzare modelli “scatola nera” quando non sono in grado di fornire ragioni specifiche e accurate per le decisioni avverse. Inoltre, lo standard UDAAP (Unfair or Deceptive Acts or Practices) si applica ai sistemi guidati dall’IA che possono danneggiare i consumatori attraverso raccolta dati opaca, violazioni della privacy o indirizzamento verso prodotti non idonei. Le istituzioni finanziarie devono assicurare che i sistemi IA utilizzati nel servizio clienti, nelle raccomandazioni di prodotto e nella gestione dei conti siano trasparenti sull’uso dell’IA e forniscano chiare informative su come i dati dei consumatori vengono raccolti, utilizzati e protetti.

La maggior parte delle istituzioni finanziarie si affida a fornitori terzi per sviluppare, implementare o mantenere i sistemi IA, creando importanti obblighi di gestione del rischio di terze parti (TPRM). Le Linee Guida Interagenzia sulle Relazioni con Terze Parti delle autorità bancarie federali sottolineano che le istituzioni finanziarie rimangono responsabili delle performance e della conformità dei sistemi IA di terze parti, anche quando l’istituzione non ha sviluppato direttamente il modello. Un TPRM efficace per l’IA richiede una due diligence robusta prima di coinvolgere un fornitore, inclusa la valutazione delle pratiche di governance dei dati del fornitore, dei processi di validazione dei modelli e della capacità di fornire trasparenza sulle operazioni del modello. Le istituzioni finanziarie devono anche monitorare il rischio di concentrazione—l’impatto sistemico potenziale se un piccolo numero di fornitori IA subisce interruzioni o fallimenti. I rischi della supply chain, inclusa l’affidabilità delle fonti dati e la stabilità delle infrastrutture di terzi, devono essere valutati e documentati. I contratti con i fornitori IA dovrebbero includere requisiti chiari su sicurezza dei dati, monitoraggio delle performance dei modelli, segnalazione degli incidenti e possibilità di audit o test del sistema IA. In particolare, le istituzioni finanziarie di dimensioni minori potrebbero avere difficoltà con la competenza tecnica necessaria per valutare sistemi IA complessi, creando la necessità di standard di settore o programmi di certificazione per facilitare la valutazione dei fornitori.

Le istituzioni finanziarie che operano a livello transfrontaliero affrontano un mosaico sempre più complesso di regolamenti sull’IA, con l’AI Act dell’Unione Europea che rappresenta il quadro normativo più completo finora. L’AI Act dell’UE classifica i sistemi IA utilizzati nel credit scoring, nella prevenzione delle frodi e nell’antiriciclaggio come “ad alto rischio”, richiedendo ampia documentazione, test di bias, supervisione umana e conformità. Anche OCSE e G7 hanno emanato principi e raccomandazioni per una governance responsabile dell’IA nei servizi finanziari, enfatizzando trasparenza, equità, responsabilità e supervisione umana. Molti di questi standard internazionali hanno portata extraterritoriale, il che significa che le istituzioni finanziarie che servono clienti in UE, UK o altre giurisdizioni regolate potrebbero dover rispettare tali standard anche se hanno sede altrove. Gli sforzi di armonizzazione normativa sono in corso, ma permangono differenze significative tra le giurisdizioni, creando sfide di conformità per le istituzioni finanziarie globali. Un allineamento proattivo con gli standard internazionali più stringenti—come l’AI Act UE e i principi OCSE—può aiutare le istituzioni a prepararsi agli sviluppi normativi futuri e ridurre il rischio di enforcement in più giurisdizioni.

Le istituzioni finanziarie dovrebbero implementare pratiche di documentazione e governance complete per dimostrare la conformità alle aspettative di Divulgazione dell’IA Finanziaria. Le best practice chiave includono:

Adottando queste pratiche, le istituzioni finanziarie possono ridurre il rischio normativo, costruire fiducia negli stakeholder e posizionarsi come leader nel deployment responsabile dell’IA nel settore dei servizi finanziari.

La Divulgazione dell'IA Finanziaria si riferisce ai requisiti normativi per le istituzioni finanziarie di divulgare in modo trasparente l'utilizzo dell'intelligenza artificiale nei processi decisionali, nella gestione del rischio e nelle applicazioni rivolte ai clienti. Comprende le aspettative normative di SEC, CFPB, FINRA e altri enti in merito alla documentazione della governance dell'IA, delle performance dei modelli e degli impatti su consumatori e mercati. Nel dicembre 2024, il Comitato Consultivo degli Investitori della SEC ha raccomandato che le istituzioni finanziarie definiscano l'uso dell'IA, divulghino i meccanismi di supervisione del consiglio e riportino i deployment materiali dell'IA.

Le istituzioni finanziarie devono divulgare l'uso dell'IA per proteggere investitori, consumatori e l'integrità del mercato. I regolatori hanno rilevato che solo il 40% delle aziende dell'S&P 500 fornisce divulgazioni relative all'IA, creando inconsistenze e lacune informative per gli investitori. I requisiti di divulgazione garantiscono che gli stakeholder comprendano come l'IA incida sulle decisioni finanziarie, sulla gestione del rischio e sui risultati per i consumatori. Inoltre, le leggi vigenti sulla tutela del consumatore—including le normative sul prestito equo e sulla privacy dei dati—si applicano ai sistemi IA, rendendo la divulgazione essenziale per la conformità normativa.

Il Comitato Consultivo degli Investitori della SEC ha raccomandato tre pilastri chiave per la divulgazione dell'IA: (1) richiedere agli emittenti di definire cosa intendono per 'Intelligenza Artificiale', (2) divulgare i meccanismi di supervisione del consiglio per il deployment dell'IA, e (3) riportare i deployment materiali dell'IA e i loro effetti sulle operazioni interne e sui prodotti rivolti ai consumatori. Queste raccomandazioni mirano a fornire agli investitori informazioni chiare e comparabili su come l'IA incide sulle operazioni e sulla direzione strategica delle istituzioni finanziarie.

La Divulgazione dell'IA Finanziaria si concentra specificamente sui requisiti normativi per una comunicazione trasparente sull'uso dell'IA verso stakeholder esterni (investitori, regolatori, consumatori), mentre la governance generale dell'IA si riferisce ai processi e ai controlli interni per la gestione dei sistemi IA. La divulgazione rappresenta la componente esterna della governance dell'IA, assicurando che gli stakeholder abbiano accesso a informazioni materiali su deployment, rischi e impatti dell'IA. Entrambi sono essenziali per un deployment responsabile dell'IA nei servizi finanziari.

Le divulgazioni sul deployment dell'IA dovrebbero riguardare sia le operazioni interne che gli impatti sulle attività rivolte ai consumatori. Per le operazioni interne, le istituzioni dovrebbero divulgare gli impatti su capitale umano, rendicontazione finanziaria, governance e rischi di cybersecurity. Per i prodotti rivolti ai consumatori, le divulgazioni dovrebbero coprire investimenti in piattaforme guidate dall'IA, integrazione dell'IA nei prodotti, impatti normativi e come l'IA influisce su strategie di pricing o business. Le divulgazioni dovrebbero essere integrate nelle voci di disclosure regolamentari esistenti (come la SEC Regulation S-K) su base informata dalla materialità.

Le leggi sul prestito equo, tra cui l'Equal Credit Opportunity Act (ECOA) e il Fair Credit Reporting Act (FCRA), si applicano ai sistemi IA utilizzati nelle decisioni di credito indipendentemente dalla tecnologia impiegata. Le istituzioni finanziarie devono essere in grado di spiegare le ragioni specifiche di decisioni avverse (come rifiuti di credito) e dimostrare che i loro modelli IA non hanno impatti sproporzionati su categorie protette. I regolatori si aspettano che le istituzioni testino i modelli IA per il bias, adottino 'alternative meno discriminatorie' dove appropriato e mantengano documentazione sui test e la validazione dell'equità.

La maggior parte delle istituzioni finanziarie si affida a fornitori terzi per i sistemi IA, creando importanti obblighi di gestione del rischio di terze parti (TPRM). Le istituzioni finanziarie restano responsabili delle performance e della conformità dei sistemi IA di terze parti, anche quando non hanno sviluppato il modello. Un TPRM efficace per l'IA richiede una due diligence robusta, monitoraggio continuo, valutazione delle pratiche di governance dei dati dei fornitori e documentazione delle performance dei modelli. Le istituzioni devono anche monitorare il rischio di concentrazione—l'impatto sistemico potenziale se un piccolo numero di fornitori IA subisce interruzioni.

L'AI Act dell'Unione Europea rappresenta il quadro normativo più completo per l'IA, classificando i sistemi IA finanziari come 'ad alto rischio' e richiedendo ampia documentazione, test di bias e supervisione umana. Anche l'OCSE e il G7 hanno emanato principi per una governance responsabile dell'IA. Molti di questi standard internazionali hanno portata extraterritoriale, il che significa che le istituzioni finanziarie che servono clienti in giurisdizioni regolate potrebbero dover rispettare tali standard. Un allineamento proattivo con gli standard internazionali può aiutare le istituzioni a prepararsi agli sviluppi normativi futuri e ridurre il rischio di enforcement.

Traccia come la tua istituzione finanziaria viene menzionata nelle risposte AI su GPTs, Perplexity e Google AI Overviews. Assicurati che il tuo brand mantenga visibilità e accuratezza nei contenuti finanziari generati dall'IA.

Scopri le migliori pratiche essenziali per la trasparenza e la divulgazione dell'IA. Esplora metodi comportamentali, verbali e tecnici di divulgazione per costr...

Scopri come concedere in licenza i contenuti alle aziende di IA, comprendere le strutture di pagamento, i diritti di licenza e le strategie di negoziazione per ...

Scopri cos'è la sicurezza del marchio AI, perché è importante per la tua azienda e come proteggere la reputazione del tuo marchio da contenuti negativi generati...