Cos'è Google MUM e come influisce sulla visibilità della ricerca AI?

Discussione della community che spiega Google MUM e il suo impatto sulla ricerca AI. Gli esperti condividono come questo modello AI multimodale influisce sull'o...

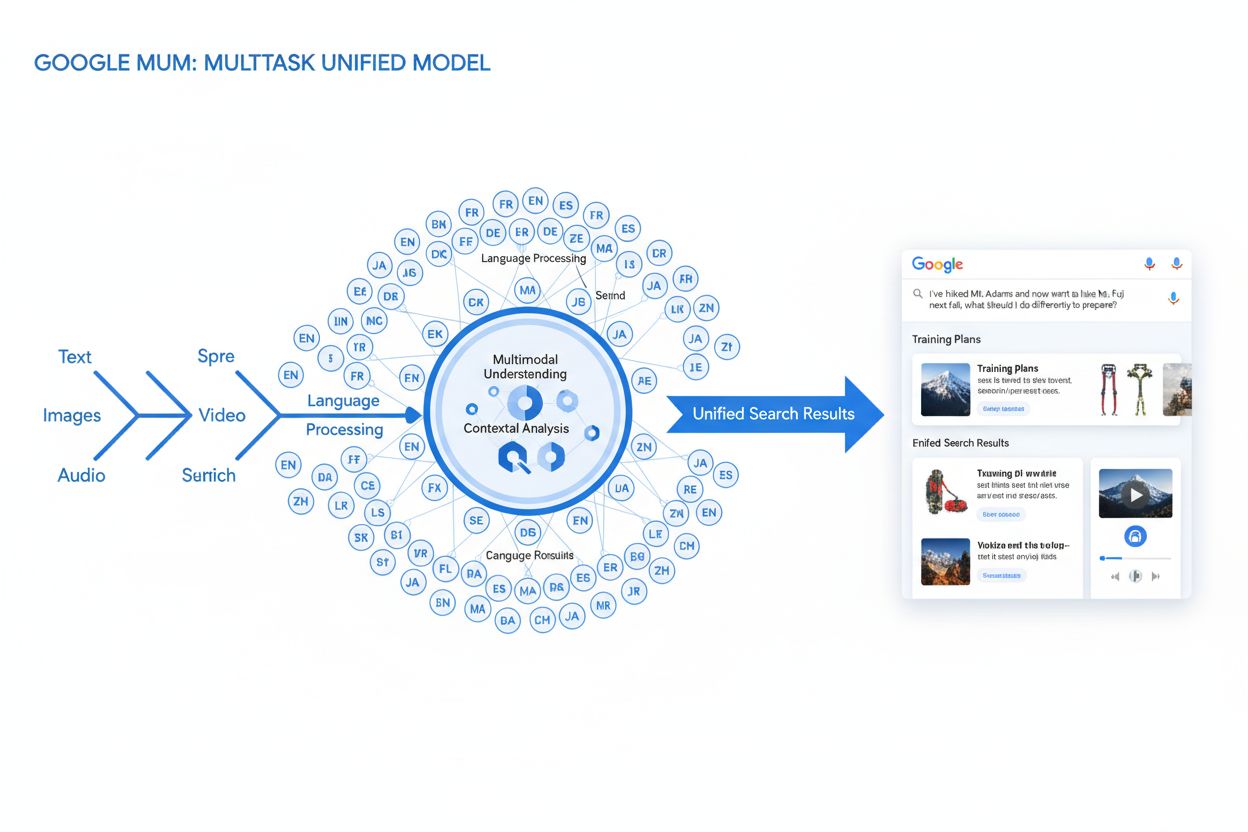

MUM (Modello Multitasking Unificato) è il modello AI multimodale avanzato di Google che elabora testo, immagini, video e audio simultaneamente in oltre 75 lingue per offrire risultati di ricerca più completi e contestuali. Lanciato nel 2021, MUM è 1.000 volte più potente di BERT e rappresenta un cambiamento fondamentale nel modo in cui i motori di ricerca comprendono e rispondono a query utente complesse.

MUM (Modello Multitasking Unificato) è il modello AI multimodale avanzato di Google che elabora testo, immagini, video e audio simultaneamente in oltre 75 lingue per offrire risultati di ricerca più completi e contestuali. Lanciato nel 2021, MUM è 1.000 volte più potente di BERT e rappresenta un cambiamento fondamentale nel modo in cui i motori di ricerca comprendono e rispondono a query utente complesse.

MUM (Modello Multitasking Unificato) è il modello di intelligenza artificiale multimodale avanzato di Google progettato per rivoluzionare il modo in cui i motori di ricerca comprendono e rispondono a query utente complesse. Annunciato a maggio 2021 da Pandu Nayak, Google Fellow e Vicepresidente della Ricerca, MUM rappresenta un cambiamento fondamentale nella tecnologia di recupero delle informazioni. Basato sul framework T5 text-to-text e composto da circa 110 miliardi di parametri, MUM è 1.000 volte più potente di BERT, il precedente modello di elaborazione del linguaggio naturale di Google. A differenza degli algoritmi di ricerca tradizionali che elaborano il testo in isolamento, MUM elabora simultaneamente testo, immagini, video e audio comprendendo informazioni in più di 75 lingue nativamente. Questa capacità multimodale e multilingue permette a MUM di comprendere query complesse che in passato richiedevano più ricerche, trasformando la ricerca da un semplice esercizio di corrispondenza di parole chiave a un sistema intelligente e consapevole del contesto. MUM non solo comprende il linguaggio ma lo genera, rendendolo capace di sintetizzare informazioni da fonti e formati diversi per fornire risposte complete e sfumate che coprono tutte le sfaccettature dell’intento dell’utente.

Il percorso di Google verso MUM rappresenta anni di innovazione incrementale nell’elaborazione del linguaggio naturale e nell’apprendimento automatico. L’evoluzione è iniziata con Hummingbird (2013), che ha introdotto la comprensione semantica per interpretare il significato delle query invece di limitarsi a corrispondere le parole chiave. È seguito RankBrain (2015), che utilizzava il machine learning per comprendere le keyword long-tail e i nuovi modelli di ricerca. Neural Matching (2018) ha portato questo approccio oltre, utilizzando reti neurali per abbinare le query ai contenuti pertinenti a un livello semantico più profondo. BERT (Bidirectional Encoder Representations from Transformers), lanciato nel 2019, ha segnato un traguardo importante grazie alla comprensione del contesto all’interno di frasi e paragrafi, migliorando la capacità di Google di interpretare il linguaggio sfumato. Tuttavia, BERT presentava limiti significativi—elaborava solo testo, aveva un supporto multilingue limitato e non riusciva a gestire la complessità delle query che richiedevano la sintesi di informazioni su più formati. Secondo le ricerche di Google, gli utenti emettono in media otto query separate per rispondere a domande complesse, come confrontare due destinazioni di trekking o valutare opzioni di prodotto. Questa statistica ha evidenziato una lacuna nella tecnologia di ricerca che MUM è stato progettato appositamente per colmare. Il Helpful Content Update (2022) e il framework E-E-A-T (2023) hanno ulteriormente affinato il modo in cui Google dà priorità ai contenuti autorevoli e affidabili. MUM si basa su tutte queste innovazioni, introducendo capacità che superano i limiti precedenti e rappresentando non solo un miglioramento incrementale, ma un cambio di paradigma nel modo in cui i motori di ricerca elaborano e distribuiscono le informazioni.

La base tecnica di MUM risiede nell’architettura Transformer, in particolare nel framework T5 (Text-to-Text Transfer Transformer) sviluppato precedentemente da Google. Il framework T5 tratta tutti i compiti di elaborazione del linguaggio naturale come problemi text-to-text, convertendo input e output in rappresentazioni testuali unificate. MUM estende questo approccio incorporando capacità di elaborazione multimodale, che gli consentono di gestire testo, immagini, video e audio simultaneamente all’interno di un unico modello unificato. Questa scelta architetturale è significativa perché permette a MUM di comprendere relazioni e contesti tra diversi tipi di media in modi che i modelli precedenti non potevano. Ad esempio, quando elabora una query sul trekking sul Monte Fuji abbinata a un’immagine di specifici scarponi, MUM non analizza testo e immagine separatamente—li elabora insieme, comprendendo come le caratteristiche dello scarpone siano collegate al contesto della query. I 110 miliardi di parametri del modello gli forniscono la capacità di memorizzare ed elaborare enormi quantità di conoscenza su linguaggio, concetti visivi e le loro relazioni. MUM è addestrato su 75 lingue diverse e molti compiti diversi simultaneamente, il che gli consente di sviluppare una comprensione più completa delle informazioni e della conoscenza del mondo rispetto ai modelli addestrati su una sola lingua o un solo compito. Questo approccio multitasking significa che MUM impara a riconoscere schemi e relazioni che si trasferiscono tra lingue e domini, rendendolo più robusto e generalizzabile dei modelli precedenti. L’elaborazione simultanea di più lingue durante l’addestramento permette a MUM di effettuare transfer di conoscenza tra lingue, ossia comprendere informazioni scritte in una lingua e applicare tale comprensione a query in un’altra lingua, abbattendo efficacemente le barriere linguistiche che prima limitavano i risultati di ricerca.

| Attributo | MUM (2021) | BERT (2019) | RankBrain (2015) | Framework T5 |

|---|---|---|---|---|

| Funzione Principale | Comprensione multimodale delle query e sintesi delle risposte | Comprensione contestuale testuale | Interpretazione keyword long-tail | Apprendimento transfer text-to-text |

| Modalità di Input | Testo, immagini, video, audio | Solo testo | Solo testo | Solo testo |

| Supporto Linguistico | Oltre 75 lingue nativamente | Supporto multilingue limitato | Principalmente inglese | Principalmente inglese |

| Parametri del Modello | ~110 miliardi | ~340 milioni | Non dichiarato | ~220 milioni |

| Confronto Potenza | 1.000x più potente di BERT | Baseline | Predecessore di BERT | Fondamento per MUM |

| Capacità | Comprensione + generazione | Solo comprensione | Riconoscimento pattern | Trasformazione testo |

| Impatto sulle SERP | Risultati arricchiti multiformato | Migliori snippet e contesto | Rilevanza migliorata | Tecnologia fondamentale |

| Gestione Query Complesse | Query complesse multi-step | Contesto di una singola query | Varianti long-tail | Compiti di trasformazione testo |

| Trasferimento di Conoscenza | Cross-lingua e cross-modale | Solo all’interno della lingua | Transfer limitato | Transfer cross-task |

| Applicazione nel Mondo Reale | Ricerca Google, AI Overviews | Ranking Ricerca Google | Ranking Ricerca Google | Fondamento tecnico di MUM |

L’elaborazione delle query da parte di MUM coinvolge molteplici passaggi sofisticati che collaborano per fornire risposte complete e contestuali. Quando un utente invia una query di ricerca, MUM inizia con una pre-elaborazione agnostica alla lingua, comprendendo la query in una delle oltre 75 lingue supportate senza bisogno di traduzione. Questa comprensione nativa preserva le sfumature linguistiche e il contesto regionale che potrebbero andare persi con la traduzione. Successivamente, MUM impiega il sequence-to-sequence matching, analizzando l’intera query come una sequenza di significati invece che come parole chiave isolate. Questo permette a MUM di comprendere le relazioni tra i concetti—ad esempio, riconoscendo che una query su “prepararsi per il Monte Fuji dopo aver scalato il Monte Adams” implica confronto, preparazione e adattamento contestuale. Contemporaneamente, MUM effettua analisi multimodale degli input, elaborando qualsiasi immagine, video o altro media inclusi nella query. Il modello esegue poi una elaborazione simultanea della query, valutando più possibili intenti utente in parallelo invece di restringersi a una sola interpretazione. Ciò significa che MUM può riconoscere che una query sul trekking sul Monte Fuji può riguardare la preparazione fisica, la scelta dell’attrezzatura, le esperienze culturali o la logistica di viaggio—e propone informazioni rilevanti per tutte queste interpretazioni. La comprensione semantica basata su vettori converte la query e i contenuti indicizzati in vettori ad alta dimensionalità che rappresentano il significato semantico, consentendo il recupero basato sulla similarità concettuale anziché sulle parole chiave. MUM applica quindi filtri dei contenuti tramite knowledge transfer, utilizzando machine learning addestrato su log di ricerca, dati di navigazione e pattern comportamentali degli utenti per dare priorità a fonti autorevoli e di alta qualità. Infine, MUM genera una composizione SERP arricchita multimediale, che combina snippet testuali, immagini, video, domande correlate ed elementi interattivi in un’unica esperienza di ricerca visivamente stratificata. Tutto questo processo avviene in pochi millisecondi, permettendo a MUM di offrire risultati che rispondono non solo alla query esplicita ma anche a possibili domande successive e bisogni informativi correlati.

Le capacità multimodali di MUM segnano una rottura fondamentale rispetto ai sistemi di ricerca basati solo su testo. Il modello può elaborare e comprendere simultaneamente informazioni provenienti da testo, immagini, video e audio, estraendo significato da ciascuna modalità e sintetizzandolo in risposte coerenti. Questa capacità è particolarmente potente per le query che beneficiano di un contesto visivo. Ad esempio, se un utente chiede “Posso usare questi scarponi da trekking per il Monte Fuji?” mostrando un’immagine dei propri scarponi, MUM comprende le caratteristiche dello scarpone—materiale, suola, altezza, colore—e collega tale comprensione visiva alle conoscenze sul terreno, clima e requisiti del Monte Fuji, fornendo una risposta contestuale. La dimensione multilingue di MUM è altrettanto trasformativa. Con il supporto nativo per oltre 75 lingue, MUM può effettuare transfer di conoscenza tra lingue, ossia apprendere da fonti in una lingua e applicare tale conoscenza a query in un’altra. Questo abbatte un’importante barriera che prima limitava i risultati di ricerca ai contenuti nella lingua dell’utente. Se le informazioni più complete sul Monte Fuji sono disponibili principalmente in fonti giapponesi—incluse guide locali, dati climatici stagionali e approfondimenti culturali—MUM può comprendere tali contenuti in giapponese e proporre informazioni rilevanti anche a utenti di lingua inglese. Secondo i test di Google, MUM è riuscito a elencare 800 varianti di vaccini COVID-19 in più di 50 lingue in pochi secondi, dimostrando la scala e la velocità delle sue capacità di elaborazione multilingue. Questa comprensione multilingue è particolarmente preziosa per utenti in mercati non anglofoni e per query su argomenti con molte informazioni in più lingue. La combinazione di elaborazione multimodale e multilingue consente a MUM di proporre le informazioni più pertinenti indipendentemente dal formato o dalla lingua originale, creando una vera esperienza di ricerca globale.

MUM trasforma radicalmente il modo in cui i risultati di ricerca vengono mostrati ed esperiti dagli utenti. Invece della tradizionale lista di link blu che ha dominato la ricerca per decenni, MUM crea SERP arricchite e interattive che combinano più formati di contenuto in un’unica pagina. Gli utenti possono ora vedere snippet testuali, immagini ad alta risoluzione, caroselli video, domande correlate ed elementi interattivi senza uscire dalla pagina dei risultati. Questo cambiamento ha profonde implicazioni per il modo in cui gli utenti interagiscono con la ricerca. Invece di effettuare più ricerche per raccogliere informazioni su un argomento complesso, gli utenti possono esplorare diversi aspetti e sotto-temi direttamente nella SERP. Ad esempio, una query su “prepararsi per il Monte Fuji in autunno” potrebbe mostrare confronti di altitudine, previsioni meteo, raccomandazioni per l’attrezzatura, guide video e recensioni utente—tutto organizzato in modo contestuale su una sola pagina. L’integrazione di Google Lens alimentata da MUM permette di cercare usando immagini invece di parole chiave, trasformando gli elementi visivi delle foto in strumenti di scoperta interattivi. I pannelli “Cose da Sapere” suddividono le query complesse in sotto-temi digeribili, guidando l’utente tra i diversi aspetti con snippet pertinenti per ciascuno. Immagini zoomabili e ad alta risoluzione compaiono direttamente nei risultati, consentendo confronti visivi e riducendo gli ostacoli nelle prime fasi decisionali. La funzionalità “Raffina e amplia” suggerisce concetti correlati per aiutare l’utente sia ad approfondire sia a esplorare temi adiacenti. Questi cambiamenti segnano il passaggio dalla ricerca come semplice meccanismo di recupero a una esperienza interattiva ed esplorativa che anticipa le esigenze dell’utente e fornisce informazioni complete all’interno dell’interfaccia di ricerca stessa. Le ricerche indicano che questa esperienza SERP più ricca riduce il numero medio di ricerche necessarie per rispondere a domande complesse, anche se ciò può significare che gli utenti consumano informazioni direttamente nei risultati senza fare clic sui siti web.

Per le organizzazioni che monitorano la loro presenza nei sistemi AI, MUM rappresenta un’evoluzione cruciale nel modo in cui le informazioni vengono scoperte e mostrate. Con l’integrazione crescente di MUM nella Ricerca Google e la sua influenza su altri sistemi AI, comprendere come brand e domini compaiono nei risultati alimentati da MUM diventa essenziale per mantenere la visibilità. L’elaborazione multimodale di MUM significa che i brand devono ottimizzare su più formati di contenuto, non solo sul testo. Un brand che prima si affidava al posizionamento su keyword specifiche ora deve assicurarsi che i propri contenuti siano individuabili tramite immagini, video e dati strutturati. La capacità del modello di sintetizzare informazioni da fonti diverse fa sì che la visibilità di un brand dipenda non solo dal proprio sito web ma anche da come le sue informazioni appaiono nell’ecosistema web più ampio. Le capacità multilingue di MUM creano nuove opportunità e sfide per i brand globali. Contenuti pubblicati in una lingua possono ora essere scoperti da utenti che cercano in lingue diverse, ampliando la portata potenziale. Tuttavia, ciò significa anche che i brand devono assicurarsi che le informazioni siano accurate e coerenti tra le lingue, poiché MUM può mostrare dati provenienti da più fonti linguistiche per una singola query. Per piattaforme di monitoraggio AI come AmICited, tracciare l’impatto di MUM è fondamentale perché rappresenta come i sistemi AI moderni recuperano e presentano le informazioni. Monitorando dove appare un brand nelle risposte AI—sia in Google AI Overviews, Perplexity, ChatGPT o Claude—capire la tecnologia sottostante di MUM aiuta a spiegare perché certi contenuti emergono e come ottimizzare la visibilità. Il passaggio verso una ricerca multimodale e multilingue richiede che i brand adottino un monitoraggio completo che tenga conto della presenza su diversi formati e lingue, non solo sul ranking delle keyword tradizionali. Le organizzazioni che comprendono le capacità di MUM possono ottimizzare meglio la strategia dei contenuti per mantenere la visibilità in questo nuovo panorama di ricerca.

Sebbene MUM rappresenti un progresso significativo, introduce anche nuove sfide e limitazioni che le organizzazioni devono affrontare. Tassi di click-through più bassi rappresentano una delle maggiori preoccupazioni per editori e creatori di contenuti, poiché gli utenti possono ora consumare informazioni complete direttamente nei risultati di ricerca senza visitare i siti web. Questo cambiamento rende i tradizionali metriche di traffico meno affidabili come indicatori di successo. Requisiti SEO tecnici più elevati significano che, per essere compresi da MUM, i contenuti devono essere ben strutturati con schema markup appropriato, HTML semantico e relazioni chiare tra entità. I contenuti privi di questa base tecnica potrebbero non essere indicizzati o compresi correttamente dall’elaborazione multimodale di MUM. La saturazione delle SERP crea sfide per la visibilità, poiché più formati di contenuto competono per l’attenzione in una singola pagina. Anche contenuti di qualità possono ottenere meno click se le informazioni sono già sufficienti nella SERP. Il rischio di risultati fuorvianti esiste quando MUM mostra informazioni da fonti che possono contraddirsi o quando il contesto va perso nella sintesi. La dipendenza dai dati strutturati implica che contenuti non strutturati o mal formattati potrebbero non essere compresi o mostrati da MUM. Le sfide di nuance linguistica e culturale possono emergere quando MUM trasferisce conoscenza tra lingue, rischiando di perdere il contesto culturale o le variazioni regionali di significato. I requisiti di risorse computazionali per far funzionare MUM su larga scala sono considerevoli, anche se Google ha investito in miglioramenti di efficienza per ridurre l’impatto ambientale. Bias e problemi di equità richiedono attenzione costante per evitare che MUM perpetui i pregiudizi presenti nei dati di addestramento o svantaggi certi punti di vista o comunità.

L’arrivo di MUM richiede cambiamenti fondamentali nel modo in cui le organizzazioni affrontano SEO e strategia dei contenuti. L’ottimizzazione tradizionale basata sulle keyword perde efficacia quando MUM può comprendere intento e contesto al di là della corrispondenza esatta delle parole. Una strategia di contenuto basata sugli argomenti diventa più importante rispetto a quella basata sulle keyword, con la necessità di creare cluster di contenuti completi che affrontino i temi da più angolazioni. La creazione di contenuti multimediali non è più opzionale—le organizzazioni devono investire in immagini, video e contenuti interattivi di alta qualità che completino i testi. L’implementazione di dati strutturati diventa critica, poiché il markup schema aiuta MUM a comprendere la struttura e le relazioni dei contenuti. Costruzione di entità e ottimizzazione semantica aiutano a stabilire autorità tematica e migliorano la comprensione delle relazioni tra i contenuti da parte di MUM. La strategia di contenuto multilingue acquisisce importanza poiché le capacità di transfer tra lingue di MUM permettono ai contenuti di essere scoperti in mercati linguistici diversi. La mappatura dell’intento utente diventa più sofisticata, richiedendo di capire non solo l’intento primario ma anche le domande correlate e i sotto-temi che gli utenti potrebbero esplorare. La freschezza e accuratezza dei contenuti diventano cruciali poiché MUM sintetizza informazioni da più fonti—contenuti obsoleti o imprecisi potrebbero essere declassati. L’ottimizzazione cross-platform si estende oltre Google Search e include come i contenuti appaiono nei sistemi AI come Google AI Overviews, Perplexity e altre interfacce di ricerca potenziate dall’AI. I segnali E-E-A-T (Esperienza, Competenza, Autorevolezza, Affidabilità) diventano sempre più importanti poiché MUM dà priorità ai contenuti provenienti da fonti autorevoli. Le organizzazioni che adattano le loro strategie per allinearsi alle capacità di MUM—puntando su contenuti completi, multimodali, ben strutturati e che dimostrano autorità—manterranno visibilità in questo panorama di ricerca in evoluzione.

MUM non rappresenta una destinazione finale ma una tappa nell’evoluzione della ricerca alimentata dall’AI. Google ha indicato che MUM continuerà ad espandere le sue capacità, con elaborazione di video e audio sempre più sofisticata. L’azienda sta attivamente ricercando come ridurre l’impronta computazionale di MUM mantenendo o migliorando le prestazioni, affrontando le preoccupazioni sulla sostenibilità dei modelli AI su larga scala. L’integrazione di MUM con altre tecnologie Google suggerisce sviluppi futuri in cui la comprensione di MUM alimenterà non solo la ricerca ma anche Google Assistant, Google Lens e altri prodotti. La concorrenza con altri sistemi AI come ChatGPT di OpenAI, Claude di Anthropic e il motore di ricerca AI di Perplexity significa che MUM continuerà probabilmente a evolversi per mantenere il vantaggio competitivo di Google. Lo scrutinio normativo sui sistemi AI potrà influenzare lo sviluppo di MUM, in particolare per quanto riguarda bias, equità e trasparenza. L’adattamento dei comportamenti utente modellerà l’evoluzione di MUM—man mano che gli utenti si abitueranno a esperienze di ricerca più ricche e interattive, cresceranno le aspettative sulla qualità e completezza delle risposte. L’ascesa dell’AI generativa fa prevedere che le capacità di sintesi e generazione di informazioni di MUM diventeranno sempre più centrali, potenzialmente permettendo a MUM di generare contenuti originali oltre a recuperare e organizzare quelli esistenti. La standardizzazione dell’AI multimodale suggerisce che l’approccio di MUM all’elaborazione simultanea di più formati diventerà la norma nei sistemi AI. Privacy e gestione dei dati influenzeranno il modo in cui MUM utilizza i dati degli utenti e i segnali comportamentali per personalizzare e migliorare i risultati. Le organizzazioni dovrebbero prepararsi a un’evoluzione continua, costruendo strategie di contenuto flessibili e adattabili che privilegiano qualità, completezza ed eccellenza tecnica invece di tattiche specifiche che potrebbero diventare obsolete. Il principio fondamentale—creare contenuti che rispondano genuinamente all’intento utente su più formati e lingue—rimarrà valido indipendentemente da come si svilupperanno le capacità specifiche di MUM.

Mentre BERT (2019) si concentrava sulla comprensione del linguaggio naturale nelle query testuali, MUM rappresenta un'evoluzione significativa. MUM è costruito sul framework T5 text-to-text ed è 1.000 volte più potente di BERT. A differenza dell'elaborazione solo testuale di BERT, MUM è multimodale—elabora simultaneamente testo, immagini, video e audio. Inoltre, MUM supporta nativamente oltre 75 lingue, mentre BERT al lancio aveva un supporto multilingue limitato. MUM può sia comprendere sia generare linguaggio, rendendolo capace di gestire query complesse e multi-step che BERT non poteva affrontare efficacemente.

Multimodale si riferisce alla capacità di MUM di elaborare e comprendere informazioni provenienti da più tipi di input contemporaneamente. Invece di analizzare il testo separatamente da immagini o video, MUM elabora tutti questi formati insieme in modo unificato. Questo significa che quando cerchi qualcosa come 'scarponi da trekking per il Monte Fuji', MUM può comprendere la tua query testuale, analizzare immagini degli scarponi, guardare recensioni video ed estrarre descrizioni audio—tutto contemporaneamente. Questo approccio integrato consente a MUM di fornire risposte più ricche e contestuali che tengono conto delle informazioni tra tutti questi diversi tipi di media.

MUM è addestrato su oltre 75 lingue, il che rappresenta un grande passo avanti nell'accessibilità globale della ricerca. Questa capacità multilingue significa che MUM può trasferire conoscenza tra le lingue—se informazioni utili su un argomento esistono in giapponese, MUM può comprenderle e mostrare risultati rilevanti anche a utenti di lingua inglese. Ciò abbatte le barriere linguistiche che prima limitavano i risultati di ricerca ai contenuti nella lingua dell'utente. Per brand e creatori di contenuti, significa che i loro contenuti possono essere visibili in più mercati linguistici e che gli utenti di tutto il mondo possono accedere a informazioni indipendentemente dalla lingua di pubblicazione originale.

T5 (Text-to-Text Transfer Transformer) è il modello di Google basato su transformer su cui è costruito MUM. Il framework T5 tratta tutti i compiti NLP come problemi text-to-text, cioè converte input e output in formato testuale per un'elaborazione unificata. MUM estende le capacità di T5 incorporando l'elaborazione multimodale (gestione di immagini, video e audio) e scalando a circa 110 miliardi di parametri. Questa base permette a MUM di comprendere e generare linguaggio mantenendo l'efficienza e la flessibilità che hanno reso T5 di successo.

MUM cambia radicalmente il modo in cui i contenuti vengono scoperti e visualizzati nei risultati di ricerca. Invece delle tradizionali liste di link blu, MUM crea SERP arricchite con più formati di contenuto—immagini, video, snippet testuali ed elementi interattivi—tutto in un'unica pagina. Questo significa che i brand devono ottimizzare su più formati, non solo sul testo. Contenuti che prima richiedevano agli utenti di cliccare attraverso più pagine possono ora emergere direttamente nei risultati di ricerca. Tuttavia, ciò può anche significare tassi di click-through più bassi per alcuni contenuti, poiché gli utenti possono consumare informazioni direttamente nella SERP. I brand devono ora concentrarsi sulla visibilità all'interno dei risultati e assicurarsi che i loro contenuti siano strutturati con markup schema per essere compresi correttamente da MUM.

MUM è fondamentale per le piattaforme di monitoraggio AI perché rappresenta il modo in cui i sistemi AI moderni comprendono e recuperano informazioni. Man mano che MUM diventa sempre più presente nella Ricerca Google e influenza altri sistemi AI, monitorare dove appaiono brand e domini nei risultati alimentati da MUM diventa essenziale. AmICited traccia come i brand vengono citati e appaiono nei sistemi AI incluso la ricerca potenziata da MUM di Google. Comprendere le capacità multimodali e multilingue di MUM aiuta le organizzazioni a ottimizzare la presenza su diversi formati di contenuto e lingue, garantendo visibilità quando sistemi AI come MUM recuperano e mostrano le loro informazioni agli utenti.

Sì, MUM può elaborare immagini e video con una comprensione sofisticata. Quando carichi un'immagine o includi un video in una query, MUM non si limita a riconoscere oggetti—estrae contesto, significato e relazioni. Ad esempio, se mostri a MUM una foto di scarponi da trekking e chiedi 'posso usare questi per il Monte Fuji?', MUM comprende le caratteristiche dello scarpone dall'immagine e collega tale comprensione alla tua domanda per fornire una risposta contestuale. Questa comprensione multimodale è una delle funzionalità più potenti di MUM, che gli permette di rispondere a domande che richiedono conoscenze visive combinate con quelle testuali.

Inizia a tracciare come i chatbot AI menzionano il tuo brand su ChatGPT, Perplexity e altre piattaforme. Ottieni informazioni utili per migliorare la tua presenza AI.

Discussione della community che spiega Google MUM e il suo impatto sulla ricerca AI. Gli esperti condividono come questo modello AI multimodale influisce sull'o...

Scopri il Multitask Unified Model (MUM) di Google e il suo impatto sui risultati di ricerca AI. Comprendi come MUM elabora query complesse su più formati e ling...

Scopri come i sistemi di ricerca AI multimodale elaborano insieme testo, immagini, audio e video per offrire risultati più accurati e contestualmente rilevanti ...