Cloaking

Il cloaking è una tecnica SEO black-hat che mostra contenuti diversi ai motori di ricerca rispetto agli utenti. Scopri come funziona, i rischi, i metodi di rile...

Lo spam dei motori di ricerca si riferisce a tattiche di manipolazione deliberata utilizzate per influenzare artificialmente il posizionamento nei motori di ricerca tramite tecniche ingannevoli che violano le linee guida dei motori di ricerca. Queste pratiche includono keyword stuffing, cloaking, link farm e testo nascosto, progettate per ingannare gli algoritmi invece di offrire un reale valore agli utenti.

Lo spam dei motori di ricerca si riferisce a tattiche di manipolazione deliberata utilizzate per influenzare artificialmente il posizionamento nei motori di ricerca tramite tecniche ingannevoli che violano le linee guida dei motori di ricerca. Queste pratiche includono keyword stuffing, cloaking, link farm e testo nascosto, progettate per ingannare gli algoritmi invece di offrire un reale valore agli utenti.

Lo spam dei motori di ricerca, noto anche come spamdexing, si riferisce alla manipolazione deliberata degli indici dei motori di ricerca tramite tecniche ingannevoli progettate per aumentare artificialmente la posizione di un sito web nei risultati. Il termine comprende una vasta gamma di pratiche non etiche che violano le linee guida dei motori di ricerca, tra cui keyword stuffing, cloaking, link farm, testo nascosto e sneaky redirect. Queste tattiche mirano a ingannare gli algoritmi di ricerca piuttosto che fornire reale valore agli utenti, minando fondamentalmente l’integrità dei risultati. Quando i motori di ricerca rilevano spam su un sito, solitamente impongono penalità che vanno dalla riduzione del posizionamento alla completa rimozione dagli indici di ricerca, rendendo il sito invisibile ai potenziali visitatori.

Lo spam dei motori di ricerca esiste dai primi tempi di Internet, quando gli algoritmi dei motori erano meno sofisticati e più facili da manipolare. Negli anni ‘90 e nei primi anni 2000, le tecniche di spamdexing si sono diffuse poiché i webmaster hanno scoperto che potevano aumentare artificialmente i posizionamenti ripetendo semplicemente parole chiave e manipolando i link. Con l’evoluzione dei motori di ricerca, soprattutto dopo l’introduzione di PageRank da parte di Google e aggiornamenti come Panda (2011) e Penguin (2012), il rilevamento e la penalizzazione dello spam sono diventati sempre più sofisticati. L’emergere di SpamBrain, il sistema anti-spam basato su AI introdotto da Google nel 2022, ha segnato un importante passaggio verso il rilevamento dello spam guidato dal machine learning. Oggi i motori di ricerca impiegano algoritmi avanzati che analizzano centinaia di fattori di ranking, rendendo le tattiche di spam tradizionali in gran parte inefficaci, ma creando nuove opportunità per tentativi di manipolazione più sofisticati.

Il keyword stuffing rimane una delle tattiche di spam più riconoscibili e consiste nella ripetizione innaturale di parole chiave all’interno dei contenuti, dei meta tag e di elementi nascosti, gonfiando artificialmente la densità delle parole chiave senza fornire informazioni coerenti o di valore per i lettori. Il cloaking rappresenta un approccio ancora più ingannevole, mostrando contenuti diversi ai crawler dei motori di ricerca rispetto a quelli visualizzati dagli utenti, spesso utilizzando JavaScript o tecniche lato server per distinguere tra bot e visitatori umani. Link farm e Private Blog Network (PBN) costituiscono un’altra importante categoria di spam, creando reti di siti di bassa qualità progettate solo per generare backlink artificiali verso siti target. Queste reti sfruttano il fatto che i motori di ricerca storicamente attribuivano grande peso ai backlink come segnale di ranking, anche se gli algoritmi moderni sono ora abili nell’identificare e svalutare questi schemi artificiali.

I sneaky redirect manipolano il comportamento degli utenti inviandoli verso URL diversi rispetto a quelli analizzati dai motori di ricerca, spesso reindirizzando gli utenti verso contenuti irrilevanti o dannosi dopo il click nei risultati. Testo e link nascosti consistono nel posizionare contenuti con colori identici allo sfondo, caratteri minuscoli o fuori schermo—rendendoli invisibili ai visitatori ma visibili ai crawler. Comment spam e forum spam sfruttano piattaforme di contenuti generati dagli utenti pubblicando automaticamente link e contenuti promozionali su blog, forum e social. Il content scraping consiste nel copiare contenuti da altri siti senza autorizzazione o modifiche, ripubblicandoli per aumentare artificialmente il volume di contenuti e catturare traffico di ricerca. Ognuna di queste tattiche rappresenta un tentativo di manipolare gli algoritmi di ricerca invece di guadagnare posizionamenti con metodi legittimi.

| Aspetto | Spam dei Motori di Ricerca (Black Hat) | SEO Legittima (White Hat) | Gray Hat SEO |

|---|---|---|---|

| Obiettivo Primario | Manipolare gli algoritmi tramite inganni | Offrire valore agli utenti e guadagnare posizionamenti naturalmente | Sfruttare le zone grigie delle linee guida |

| Qualità dei Contenuti | Bassa qualità, ripetizione parole chiave o contenuti copiati | Alta qualità, originali, focalizzati sull’utente | Qualità mista con alcune tattiche dubbie |

| Link Building | Link artificiali da farm, PBN o siti hackerati | Link naturali ottenuti tramite contenuti di qualità | Link acquistati o scambi di link |

| Metodi Tecnici | Cloaking, testo nascosto, sneaky redirect | HTML pulito, meta tag corretti, dati strutturati | Redirect JavaScript, doorway page |

| Esperienza Utente | Scarsa; contenuti pensati per algoritmi, non utenti | Ottima; contenuti progettati per la soddisfazione dell’utente | Moderata; compromessi sull’esperienza utente |

| Penalità dei Motori di Ricerca | Azioni manuali, deindicizzazione, perdita di ranking | Nessuna; miglioramento continuo del ranking | Rischio penalità se rilevato |

| Sostenibilità nel Tempo | Insostenibile; penalità inevitabili | Sostenibile; costruisce autorità duratura | Rischioso; dipende dalla probabilità di rilevamento |

| Tempi di Recupero | Da mesi ad anni; alcuni benefici persi per sempre | N/A; nessuna penalità da cui recuperare | Da settimane a mesi se scoperto |

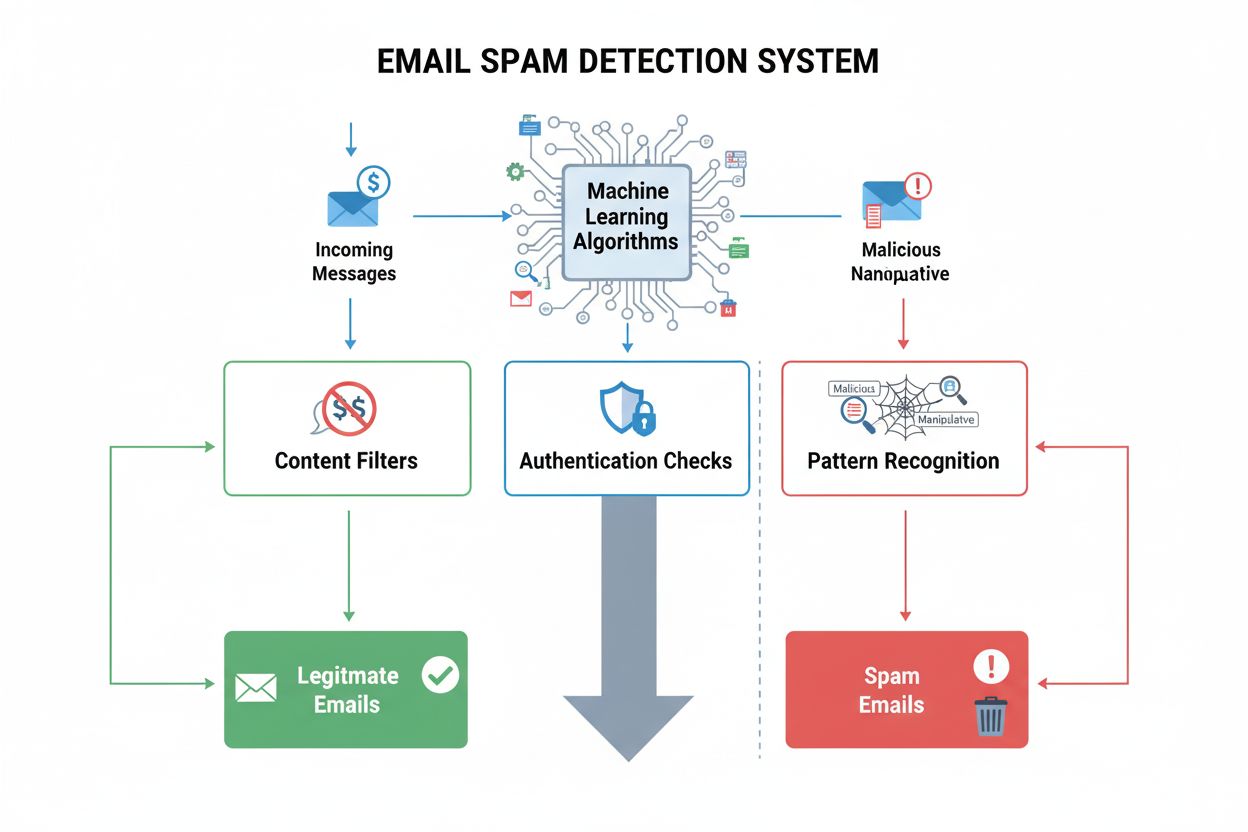

SpamBrain rappresenta un cambiamento fondamentale nel contrasto allo spam dei motori di ricerca tramite intelligenza artificiale e machine learning. Introdotto da Google nel 2022, SpamBrain analizza schemi su miliardi di siti per identificare le caratteristiche dello spam con una precisione senza precedenti. Il sistema opera in modo continuo, esaminando sia fattori on-page (qualità dei contenuti, distribuzione delle parole chiave, elementi strutturali) sia segnali off-page (profili di link, storia del dominio, pattern di comportamento utente). I modelli di machine learning di SpamBrain sono addestrati su enormi set di dati di siti spam e legittimi, permettendo al sistema di riconoscere nuove varianti di spam prima che diventino diffuse. Il sistema AI è in grado di identificare tentativi sofisticati che potrebbero eludere i sistemi di rilevamento basati su regole, inclusi schemi coordinati di link, manipolazione dei contenuti e sfruttamento di siti hackerati. Google ha dichiarato che i miglioramenti apportati da SpamBrain hanno ridotto del 45% la presenza di contenuti di bassa qualità o non originali nei risultati di ricerca dalla sua implementazione, dimostrando l’efficacia del rilevamento dello spam guidato dall’AI.

La proliferazione dello spam nei motori di ricerca degrada direttamente la qualità e l’utilità dei risultati per gli utenti finali. Quando contenuti spam ottengono un buon posizionamento, gli utenti si trovano davanti a informazioni irrilevanti, di bassa qualità o fuorvianti invece che a fonti autorevoli che rispondono realmente alle loro domande. Questo peggioramento della qualità mina la fiducia degli utenti nei motori di ricerca e costringe le piattaforme a investire ingenti risorse nel rilevamento e nella rimozione dello spam. La presenza di spam crea anche un panorama competitivo sleale, dove le aziende legittime faticano a competere con siti che adottano pratiche non etiche, almeno temporaneamente. I motori di ricerca rispondono alla proliferazione dello spam con periodici aggiornamenti anti-spam—importanti miglioramenti ai loro sistemi di rilevamento dello spam annunciati e tracciati separatamente dagli aggiornamenti algoritmici principali. L’aggiornamento anti-spam di Google del dicembre 2024, ad esempio, è stato applicato globalmente a tutte le lingue e ha richiesto fino a una settimana per essere completato, a testimonianza della portata e frequenza delle attività di contrasto allo spam. La continua corsa agli armamenti tra spammer e motori di ricerca richiede risorse computazionali e ingegneristiche notevoli, che altrimenti potrebbero essere dedicate al miglioramento della qualità della ricerca.

I siti web che si rendono responsabili di spam nei motori di ricerca possono subire una vasta gamma di conseguenze, dalle penalità algoritmiche alle azioni manuali e alla completa deindicizzazione. Le azioni manuali rappresentano la risposta più diretta di Google allo spam: revisori umani identificano le violazioni e applicano penalità specifiche tramite Google Search Console. Queste azioni notificano ai proprietari le violazioni riscontrate—come link innaturali, keyword stuffing o cloaking—e generalmente causano forti perdite di posizionamento o la rimozione dai risultati di ricerca. Le penalità algoritmiche si verificano quando i sistemi automatici di Google rilevano schemi di spam e riducono la visibilità di un sito senza intervento umano. Queste penalità possono essere temporanee, durare finché lo spam non viene rimosso e il sito ricrawlato, oppure permanenti in caso di violazioni gravi o ripetute. Nei casi estremi, i siti vengono completamente deindicizzati, non apparendo più nei risultati di ricerca di Google e perdendo ogni visibilità organica. Il recupero dalle azioni manuali richiede una bonifica completa, documentazione dettagliata delle modifiche e l’invio di una richiesta di riconsiderazione tramite Search Console. Tuttavia, anche dopo il recupero, i siti non possono riottenere i benefici di ranking generati dai link spam: tali vantaggi sono persi in modo permanente.

L’emergere di sistemi di ricerca alimentati dall’intelligenza artificiale come ChatGPT, Perplexity, Google AI Overviews e Claude introduce nuove dimensioni al problema dello spam nei motori di ricerca. Questi sistemi si affidano ai contenuti web per generare risposte, rendendoli vulnerabili allo spam e ai contenuti di bassa qualità che possono influenzare i risultati. A differenza dei motori di ricerca tradizionali che mostrano elenchi ordinati di risultati, i sistemi AI sintetizzano informazioni in risposte in linguaggio naturale, potenziando l’impatto dei contenuti spam se influenzano i dati di addestramento o le modalità di recupero delle informazioni. Organizzazioni come AmICited sono nate per affrontare questa sfida, offrendo piattaforme di monitoraggio delle risposte AI che tracciano dove brand e domini compaiono nelle risposte generate. Questa capacità di monitoraggio è cruciale perché lo spam presente nelle risposte AI può danneggiare la reputazione e la visibilità del brand in modi differenti rispetto ai risultati tradizionali. Con la crescente diffusione dei sistemi AI nell’accesso alle informazioni, l’importanza di monitorare e prevenire lo spam in questi nuovi paradigmi di ricerca aumenta in modo esponenziale. La sfida per i sistemi AI è distinguere tra fonti autorevoli e contenuti spam nel decidere quali informazioni includere nelle risposte generate.

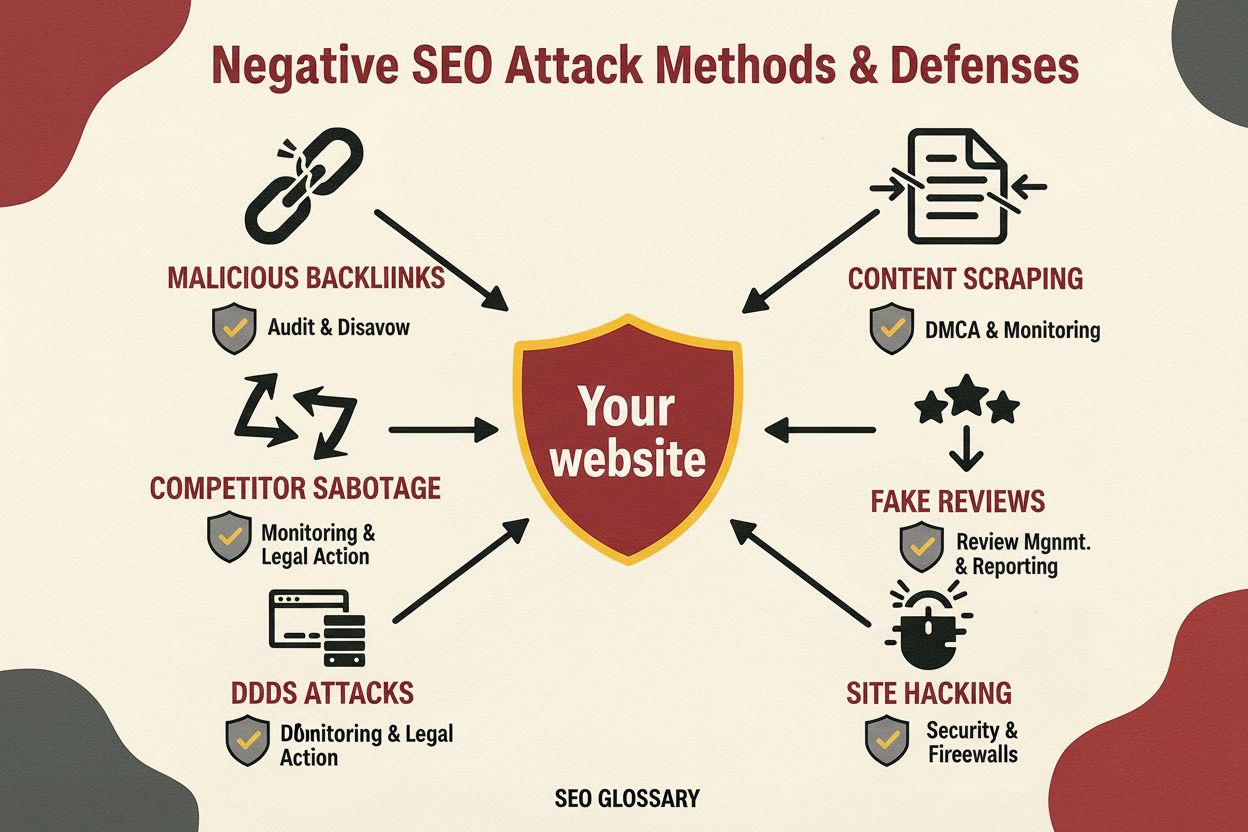

Le organizzazioni che puntano a una visibilità sostenibile nei motori di ricerca devono adottare strategie complete per evitare tattiche di spam e rispettare le linee guida dei motori. La strategia di contenuti dovrebbe privilegiare la creazione di contenuti originali, di alta qualità e focalizzati sull’utente, integrando naturalmente le parole chiave senza ripetizioni o manipolazioni artificiali. Le attività di link building devono puntare a ottenere backlink naturali tramite la qualità dei contenuti, relazioni di settore e outreach legittimo, evitando l’acquisto di link o la partecipazione a schemi. La SEO tecnica deve concentrarsi su HTML pulito, meta tag corretti, implementazione di dati strutturati e redirect trasparenti che trattano motori di ricerca e utenti allo stesso modo. Audit regolari dei contenuti, dei link e degli aspetti tecnici del sito aiutano a identificare problemi di spam prima che scattino penalità. Gli strumenti di monitoraggio dovrebbero tracciare posizionamenti, profili di backlink e visibilità per individuare cambiamenti insoliti che potrebbero indicare problemi di spam o attacchi della concorrenza. L’ottimizzazione dell’esperienza utente assicura che i contenuti siano creati prima di tutto per i visitatori umani, con l’ottimizzazione per i motori di ricerca come obiettivo secondario. Le organizzazioni dovrebbero anche stabilire chiare policy interne che vietano le tattiche di spam e informare il team sui rischi e le conseguenze delle manipolazioni.

Il futuro del rilevamento dello spam nei motori di ricerca dipenderà sempre di più da sistemi avanzati di intelligenza artificiale e machine learning, capaci di identificare tentativi sofisticati di manipolazione in tempo reale. SpamBrain e sistemi AI simili continueranno ad evolversi per individuare nuove varianti di spam più velocemente di quanto gli spammer umani possano svilupparle, generando una corsa agli armamenti sempre più rapida tra rilevamento ed evasione. L’integrazione dei sistemi di ricerca AI nelle esperienze di ricerca mainstream richiederà nuovi approcci al rilevamento dello spam, adattati alle modalità con cui questi sistemi recuperano e sintetizzano le informazioni. I motori di ricerca probabilmente implementeranno analisi più sofisticate del comportamento degli utenti per identificare lo spam sulla base delle interazioni reali, invece di affidarsi solo a segnali tecnici. Il monitoraggio cross-platform diventerà essenziale man mano che le tattiche di spam si evolvono per colpire più sistemi di ricerca contemporaneamente—motori tradizionali, chatbot AI e nuovi paradigmi di ricerca. L’ascesa dei contenuti generati dall’AI crea nuove sfide, poiché sistemi automatici possono produrre contenuti plausibili ma di bassa qualità o fuorvianti su larga scala. Organizzazioni come AmICited avranno un ruolo sempre più critico nell’aiutare i brand a monitorare la propria visibilità su sistemi di ricerca diversi e a rilevare minacce spam prima che impattino sulla visibilità. In definitiva, la prevenzione più efficace dello spam combinerà rilevamento algoritmico avanzato, competenza umana, meccanismi di feedback degli utenti e collaborazione di settore per mantenere la qualità della ricerca e la fiducia degli utenti.

Lo spam dei motori di ricerca viola le linee guida dei motori di ricerca e utilizza tattiche ingannevoli per manipolare il posizionamento, mentre la SEO legittima segue pratiche white-hat che offrono un reale valore agli utenti. La SEO legittima si concentra sulla creazione di contenuti di qualità, ottenendo backlink naturali e migliorando l'esperienza utente, mentre tattiche di spam come il keyword stuffing e il cloaking cercano di ingannare gli algoritmi. Le linee guida di Google proibiscono esplicitamente le tattiche di spam e i siti che le utilizzano rischiano penalità manuali o la completa deindicizzazione dai risultati di ricerca.

Google utilizza **SpamBrain**, un sistema di prevenzione dello spam basato sull'intelligenza artificiale che monitora continuamente i siti web per individuare violazioni delle politiche anti-spam. SpamBrain impiega algoritmi di apprendimento automatico per identificare schemi associati allo spam, inclusi profili di link innaturali, keyword stuffing, cloaking e altre tecniche ingannevoli. Il sistema analizza sia fattori on-page che off-page, segnali di comportamento degli utenti e metriche di qualità dei contenuti per distinguere tra contenuti legittimi e spam. Google effettua anche revisioni manuali e riceve segnalazioni dagli utenti tramite Search Console per identificare e penalizzare siti spam.

Le principali tattiche di spam dei motori di ricerca includono **keyword stuffing** (sovraccaricare le pagine di parole chiave), **cloaking** (mostrare contenuti diversi ai motori di ricerca e agli utenti), **sneaky redirect** (reindirizzare gli utenti verso pagine diverse rispetto a quelle viste dai motori), **link farm** (reti di siti di bassa qualità creati solo per generare link), **testo e link nascosti** (contenuti invisibili agli utenti ma visibili ai crawler) e **comment spam** (spam automatico pubblicato nei commenti e nei forum). Ogni tattica cerca di manipolare gli algoritmi di ricerca tramite l'inganno invece di offrire valore reale all'utente.

Google impone diverse penalità per lo spam dei motori di ricerca, che vanno dalla perdita di posizionamento fino alla completa deindicizzazione. I siti possono ricevere **azioni manuali** tramite Google Search Console che indicano specifiche violazioni, oppure essere colpiti da aggiornamenti algoritmici anti-spam che riducono automaticamente la visibilità. Nei casi più gravi, i siti possono essere completamente rimossi dall'indice di Google, rendendoli invisibili nei risultati. Il recupero richiede l'identificazione e la rimozione di tutti gli elementi di spam, seguiti da una richiesta di riconsiderazione tramite Search Console. Il processo di recupero può richiedere mesi e alcuni benefici di ranking ottenuti tramite link spam non possono essere recuperati.

Lo spam dei motori di ricerca rappresenta una sfida significativa per i sistemi di ricerca basati su intelligenza artificiale come **ChatGPT**, **Perplexity** e **Google AI Overviews**. Questi sistemi si affidano ai contenuti web per generare risposte e i contenuti spam possono inquinare i dati di addestramento o influenzare i risultati. Piattaforme come AmICited monitorano dove appaiono brand e domini nelle risposte AI, aiutando le organizzazioni a capire se contenuti spam o di bassa qualità stanno influenzando la loro visibilità. Man mano che i sistemi AI diventano più diffusi, il rilevamento dello spam diviene sempre più cruciale per garantire risposte accurate e affidabili agli utenti.

Sì, i siti web possono recuperare dalle penalità per spam, ma il processo richiede una bonifica completa. I proprietari devono identificare tutti gli elementi di spam—compresi keyword stuffing, link innaturali, cloaking e contenuti nascosti—e rimuoverli totalmente. Dopo la pulizia, dovrebbero inviare una richiesta di riconsiderazione tramite Google Search Console con documentazione dettagliata delle modifiche apportate. Il recupero richiede solitamente diversi mesi perché i sistemi di Google necessitano di tempo per ricrawlare e rivalutare il sito. Tuttavia, i benefici di ranking ottenuti tramite link spam non possono essere recuperati e i siti devono concentrarsi sulla costruzione di autorità legittima tramite contenuti di qualità e acquisizione naturale di link.

Monitorare lo spam dei motori di ricerca è fondamentale perché i contenuti spam possono danneggiare la reputazione e la visibilità di un brand sulle piattaforme di ricerca. I competitor possono utilizzare tattiche di spam contro il tuo brand oppure il tuo sito potrebbe essere compromesso e usato per spam. Strumenti come **AmICited** aiutano le organizzazioni a tracciare le menzioni del proprio brand nei sistemi di ricerca AI e nei motori di ricerca tradizionali, identificando se contenuti spam o di bassa qualità stanno comparendo al posto di informazioni legittime sul brand. Questo monitoraggio consente di rilevare in modo proattivo problemi di spam e mantenere l'integrità del marchio nei risultati di ricerca e nelle risposte AI.

Inizia a tracciare come i chatbot AI menzionano il tuo brand su ChatGPT, Perplexity e altre piattaforme. Ottieni informazioni utili per migliorare la tua presenza AI.

Il cloaking è una tecnica SEO black-hat che mostra contenuti diversi ai motori di ricerca rispetto agli utenti. Scopri come funziona, i rischi, i metodi di rile...

La Negative SEO è la pratica di utilizzare tecniche non etiche per danneggiare il posizionamento dei concorrenti. Scopri le tattiche di attacco, i metodi di ril...

Il rilevamento dello spam identifica contenuti indesiderati e manipolativi utilizzando algoritmi di ML e analisi comportamentale. Scopri come i sistemi di IA fi...