AIが考える高品質コンテンツとは:従来指標を超えて

AIシステムが従来のSEO指標を超えてコンテンツ品質をどのように評価するかを解説。セマンティックな理解、事実の正確性、LLMやAIオーバービューで重視される品質シグナルについて学びましょう。...

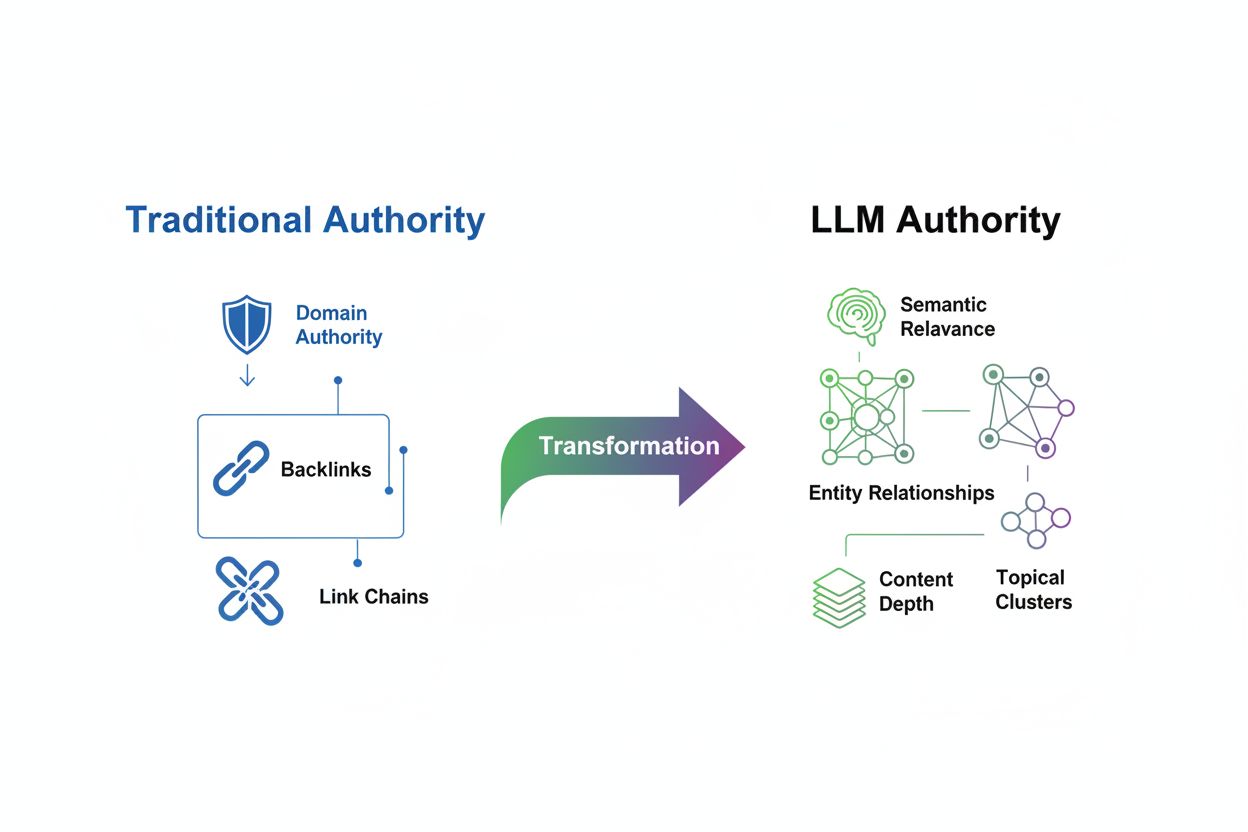

トピカルオーソリティ の評価は、ラージランゲージモデル(LLM)の時代において根本的な変化を遂げています。従来のSEOが被リンクやキーワード密度を主なオーソリティシグナルとして重視していたのに対し、現代のLLMはセマンティックな関連性・文脈的な深さ・エンティティの関係性といった全く異なる観点からコンテンツを評価します。この変化は単なるアルゴリズムの小さな更新に留まらず、「どの情報源を可視化し信頼すべきか」を検索エンジンやAIが判断する仕組みそのものの再設計です。旧来のモデルは量やリンク数を重視しましたが、新たなパラダイムではセマンティックな豊かさとトピックの網羅性が重視されます。この変化を理解しないまま従来のオーソリティ施策を続けていると、従来のSEO指標が高水準でもAI生成回答からは消えてしまうリスクがあります。LLMは外部リンクの蓄積よりも、深さ・一貫性・セマンティックな明瞭さを通じてオーソリティを認識する ―この本質的な転換を理解したブランドが、今後の可視性を獲得していきます。

トピカルオーソリティとは、特定分野における専門性・深さ・一貫性を、検索エンジンやAIが認めるレベルでウェブサイトが示している状態です。従来のオーソリティ指標が外部の被リンクによる評価に大きく依存していたのに対し、LLMベースの評価は、ドメインが選択したトピックをどれだけ包括的かつ首尾一貫してカバーしているかを重視します。セマンティックな関連性がこの新たな評価方法の中核であり、LLMは「ユーザーの意図を満たしているか」「トピックを多角的に扱っているか」「関連する概念間の論理的なつながりがあるか」を見ています。違いは決定的です――50本の薄いキーワード詰め込み記事を持つサイトは従来の指標では評価されても、LLMの文脈ではトピカルオーソリティが低い可能性があり、逆に10本の深く研究された相互リンク記事を持つ競合がAI回答で優位に立つこともあります。

| オーソリティシグナル | 従来SEO | LLM評価 |

|---|---|---|

| 主な指標 | 被リンク数・ドメインオーソリティ | セマンティックな深さ・トピックのカバー範囲 |

| コンテンツ手法 | キーワード最適化・量重視 | 包括的・相互リンクされたコンテンツクラスター |

| エンティティ認識 | ほとんど重視されない | 関係性理解のために重要 |

| 内部リンク | 二次的扱い | 専門性を示すために不可欠 |

| 測定対象 | ドメイン単位(DA, DR, DP) | トピック単位の可視性・引用頻度 |

ラージランゲージモデルは、従来の検索アルゴリズムとは根本的に異なる高度な仕組みでオーソリティを評価します。LLMは単に被リンクを数えたりキーワード出現頻度を見たりするのではなく、パターン認識によって数十億の文書間で概念の関連性を理解します。モデルはエンティティの関係性――人・組織・製品・概念間のつながり――を分析し、その情報源が本当にトピックを理解しているのか、表面的に言及しているだけなのかを見極めます。セマンティックな豊かさも重要で、LLMは説明の深さ・多様な視点・論理的な流れを重視します。さらに、一貫性のある複数コンテンツがあれば、そのドメインが関連するサブトピック全体で知識を持つと認識され、オーソリティ評価が高まります。

LLMがオーソリティを認識する主な仕組み:

LLM時代においては、コンテンツの深さが量以上に圧倒的な価値を持ちます。1本の5,000字超の包括的なガイドで多角的・実例・実践的洞察を網羅した方が、500字程度の薄い記事を10本出すより遥かに高く評価されます。これは従来の「量産型コンテンツが有利」という常識を根本から覆すものです。LLMが重視するのはセマンティックカバレッジ――トピックのあらゆる側面をどれだけ扱っているか――であり、単なるキーワードの繰り返しではありません。多面的な視点からトピックを掘り下げ、関連質問や広い概念までつなげることで、いわゆるトピッククラスター――専門性を示す相互リンクされたコンテンツ群――が形成されます。たとえば「リタイアメントプランニング」で権威を築く金融サービス企業なら、「投資戦略」「税金」「医療費」「社会保障」「遺産計画」なども深く解説し、単に「退職計画の立て方」を何本も出すだけでは不十分です。この「深さ」こそがLLMから「本当にトピックを理解している」と認知され、AI回答で引用されやすくなる最大の要素です。

効果的なトピッククラスターを作るには、ユーザーとLLMの双方に「専門性」を示す戦略的・階層的なコンテンツ設計が必須です。この戦略の要はピラーページ――主題全体を網羅する包括的リソースで、全関連コンテンツのハブとなります。これを支えるのがクラスター記事で、特定サブトピックを深掘りし、戦略的な内部リンクでピラーと結びつけます。

効果的なトピッククラスター&内部リンク戦略の手順:

コアピラーとなるトピックを特定:自社が本当に専門性を持ち、かつ市場ニーズもある広めの分野を選びます。十分に専門性を示せつつ、複数のサポート記事を展開できるテーマが理想。例:「ERP導入」など。

関連サブトピック・質問をマッピング:SEMrush・AnswerThePublic・Googleの「他の人はこちらも質問」などでサブトピックや疑問を洗い出し、ピラーとの関係性をビジュアルで整理。

ピラーページを作成:3,000~5,000字以上の包括ガイドで主題全体を俯瞰します。サブトピックの概要・定義・クラスター記事へのリンクを組み込み、見出しや構成も明快に。

クラスターコンテンツを展開:1,500~2,500字程度でサブトピックごとに深掘り記事を8~15本作成。それぞれがピラーへ文脈的なアンカーテキストでリンク。

戦略的な内部リンク設計:クラスター記事同士も関連があれば相互リンクし、専門的なネットワークを形成。関連キーワード・エンティティ名を含む記述的なアンカーテキストを活用。「関連記事」やナビゲーションウィジェットも設置。

一貫性維持と定期更新:定期的にクラスター全体を見直し、情報のギャップや新トピックを追加。既存記事も最新状態にアップデート。

エンティティ最適化は、従来のキーワード最適化からの根本的なパラダイムシフトです。今後はキーワードよりも、LLMが意味理解の根拠とするエンティティ(人・組織・製品・場所・概念など)を明確に定義・一貫して参照することが重要です。コンテンツ全体にエンティティを明示的に定義し続けることで、LLMのナレッジグラフに「自社の位置付け」を教え込むことになります。Schema.orgの構造化データマークアップは技術的な基盤となり、コンテンツで扱うエンティティや相互の関係性を検索エンジンやLLMに明示できます。

実践的なエンティティ最適化ガイド:

主要エンティティを明確に定義:主に扱うエンティティ(例:「Googleアナリティクス」「コンバージョン率最適化」「A/Bテスト」など)を特定し、見出し・本文内で具体的に記述。曖昧な表現を避け、人物・製品・概念を明示。

構造化データマークアップの活用:Schema.orgでエンティティや関係性を定義。ブログ記事にはArticleスキーマ、企業情報にはOrganization、製品にはProduct、著者情報にはPersonなどを実装。LLMの情報抽出を助けます。

エンティティを権威ある外部情報と結びつける:Wikipedia・DBpedia・Google Knowledge Graphなど信頼性の高い外部リファレンスへリンク。これによりエンティティ参照の信頼性が増し、LLMも広い文脈で理解。

一貫したエンティティ記述:全コンテンツ・ウェブサイト・SNS・業界プラットフォームで同じ用語や表記を統一。一貫性がLLMに「同一エンティティである」と認識させ、知識ベースを強化。

GoogleのE-E-A-Tフレームワーク――経験・専門性・権威性・信頼性――は、LLMが中心となった今、意味合いが進化しています。従来は被リンク重視でしたが、AI時代ではコンテンツ分析・著者情報・一貫性パターンへと評価軸がシフトしています。

経験は、その組織や著者がトピックに直接携わった事例・顧客実績・体験談・詳細なプロセス解説などで示します。単なる専門性アピールではなく、実際の問題解決事例を具体的に提示。著者の経歴や、実際のクライアント・ユーザーの声を明示しましょう。

専門性は、深い知識・複雑な事例・最新研究への言及・表面的でない洞察によって伝わります。LLMは高度な話題や業界の議論・最新のベストプラクティスへの理解も評価します。

権威性は、業界で定番リソースとして一貫して高品質な情報発信を続けることで醸成され、他の権威ある情報源から引用されたり講演や論文・業界評価などでも裏付けられます。LLMは「どの情報源が頻繁に引用されるか」「権威クエリでどの情報源が使われるか」を追跡しています。

信頼性は、透明性・正確性・責任性で築きます。全コンテンツに公開日と更新日を明記し、出典も明示、利益相反も開示、誤りは速やかに修正。著者の資格や所属も掲載し、正当性を証明。LLMは誤情報検出にも長け、正確性重視の情報源を優遇しつつあります。

トピカルオーソリティ指標の追跡には、従来のSEO指標から「LLMがどのように専門性を認識しているか」を示す新たな指標へフォーカスを移す必要があります。ドメインオーソリティやドメインレーティングは依然従来検索で有効ですが、LLM可視性との相関は-0.08~-0.21程度と極めて低いことがSearch Atlasの21,767ドメイン分析でも明らかになっています。

主なトピカルオーソリティ測定指標・ツール:

LLM可視性スコア:ChatGPT・Gemini・Perplexityなど主要LLM回答で、あなたのコンテンツがどれだけ頻繁かつ目立って登場するかを計測。Search AtlasのLLM Visibility機能で引用頻度・可視化率を複数モデル横断で測定。

トピック単位のトラフィック:個別キーワードではなくトピッククラスターごとにオーガニック流入を追跡。Googleアナリティクスでトピック別にセグメントし、関連クエリ全体での可視性向上を確認。

コンテンツ網羅性指標:コアトピックに関連する全サブトピック・質問への対応状況を評価。ClearscopeやMarketMuseでカバー範囲やギャップを可視化。

内部リンク強度:クラスター記事がピラーや他のクラスターと論理的につながっているかを分析。Screaming Frogなどで内部リンク構造を可視化・最適化。

エンティティ一貫性トラッキング:主要エンティティが全コンテンツで一貫して言及・定義されているかを確認。Googleサーチコンソールで検索結果のエンティティ連携もチェック。

トピカルオーソリティを目指す多くの組織が、気づかぬうちに非効率な手法で効果を損ねています。主な落とし穴を知り、無駄なリソース消費を避けましょう。

よくある失敗例:

薄いコンテンツの量産:300~500字程度の表層的な記事ばかりを多数公開。LLMはこうした「深さ不足」を低評価し、少数でも包括的なリソースを好みます。

内部リンク構造の不備:関連記事同士を結ばず、「こちら」など汎用アンカーばかりでリンク。これではLLMがコンテンツ間の関係性を理解できません。

エンティティ言及の不一致:同じ概念を記事ごとに異なる用語(例:「コンバージョン率最適化」「CRO」「コンバージョン改善」など)で表現し、知識の断片化を招く。

コンテンツギャップの放置:トピックの一部だけに偏り、重要なサブトピックをカバーしない。LLMは網羅性の欠如を認識し、より包括的な競合を評価します。

コンテンツの更新軽視:古い記事を放置しつつ新記事を追加し冗長化。どれが現時点での専門性リソースかが曖昧になり、評価が下がります。

トピカルオーソリティ構築は、計画・実行・継続的な最適化が求められる体系的プロセスです。下記ロードマップを参考に進めましょう。

LLMが認識するトピカルオーソリティ構築のロードマップ:

現状トピカルオーソリティ監査:既存コンテンツを分析し、強み・ギャップ・未対応サブトピック・薄い/古い記事をマッピング。SEMrushのTopic ResearchやAhrefsで競合のカバー範囲もチェック。

コアとなるトピックピラーを定義:自社の専門性と市場ニーズのある3~5分野を選定。十分に専門性を示せ、複数サポート記事を展開できるテーマを選び「なぜ自社が語るべきか」も明文化。

包括的なコンテンツマップ作成:ピラーページとクラスター記事の関係性をビジュアル化。既存・新規・統合/削除すべきコンテンツを整理。

ピラーページの作成/刷新:各コアトピックごとに3,000~5,000字超のピラーページを公開。主要エンティティの定義・全クラスター記事へのリンク・構造化データも組み込む。

クラスター記事と内部リンク構築:各ピラーごとに8~15本のサブトピック深掘り記事を作成。記述的なアンカーで内部リンクを張り、相互リンクも意識。

エンティティ最適化とスキーママークアップ:全コンテンツでSchema.org実装、エンティティや関係性を明示。記述や外部権威情報へのリンクも統一。

トピカルオーソリティを構築したら、それがAIシステムでどの程度可視化・引用されているか追跡することが不可欠です。AmICitedは、ブランドのLLM横断でのプレゼンスや引用状況をモニタリングできる専門プラットフォームで、AIが自社コンテンツをどのように「認知・参照」しているかを可視化します。従来SEOツールがGoogle順位に特化していたのに対し、AmICitedはLLM可視性――ChatGPT・Gemini・Perplexity等でブランドがどれだけ頻繁/目立って登場するか――を計測します。

AI領域でのオーソリティ監視に有効な主な機能:

クロスプラットフォーム引用トラッキング:LLM複数にわたるブランド言及・引用を一括監視。どのプラットフォームで強く認知されているか、可視性のギャップはどこかを把握。

競合ベンチマーク:自社と競合のLLM可視性を比較。誰がより頻繁に引用されているか、競合のコンテンツ戦略から機会を見出す。

引用文脈分析:単なる引用回数だけでなく「どんな文脈で」「どのトピックで」引用されているか、ポジティブ/正確な引用かも把握。

可視性トレンド監視:トピカルオーソリティ施策の実装後、LLM可視性がどのように推移するかを時系列で追跡。新規/更新コンテンツや構造変更の効果も測定。

オーソリティシグナル分析:LLMの引用パターンや競合分析から、どのギャップを埋めるべきか・拡充すべきトピックや最適化すべきエンティティを提案。

AmICitedと従来SEOツールを併用すれば、従来検索とAI発見の両面からオーソリティ状況を俯瞰できます。2025年以降、LLM主導の検索が情報発見の主流となる中、両軸で最適化・監視するブランドこそが、会話型AI時代の競争優位を維持できるのです。

トピカルオーソリティは、ある分野をどれだけ包括的かつ一貫してカバーしているかを測るものであり、キーワード順位は個別の検索語句への対応に焦点を当てます。LLMは、セマンティックな深さ・エンティティの関係・コンテンツのつながりからトピカルオーソリティを評価します。特定キーワードで順位が高くても、真のトピカルオーソリティがないサイトもありますが、トピカルオーソリティを築けば、複数の関連クエリやAI回答全体での可視性が向上します。

トピカルオーソリティ構築は長期的な戦略であり、初期の成果が出るまで3~6ヶ月、強い認知を得るまで6~12ヶ月かかるのが一般的です。期間は現状・コンテンツ品質・競合状況・戦略の継続性によって左右されます。LLMは長期的なパターンからオーソリティを認識するため、スピードよりも一貫性と深さが重要です。

はい、十分可能です。従来のオーソリティ指標は多くの被リンクを持つ大手ドメインに有利でしたが、LLMはセマンティックな深さやコンテンツ品質でトピカルオーソリティを評価します。特定分野に10本の包括的かつ相互につながる記事を持つ小規模ブランドは、100本の薄い記事を持つ大手出版社を上回ることもあります。量を追うのではなく、深さ・一貫性・エンティティ最適化に注力しましょう。

被リンクは従来のGoogle順位には依然有効ですが、LLMの可視性とは弱い相関しかありません。伝統的なオーソリティ指標とLLM可視性の相関は-0.08~-0.21程度という研究もあります。被リンクはSEOには依然重要ですが、LLMはセマンティック関連性・コンテンツの深さ・エンティティ関係を優先します。自然に引用される優れたコンテンツを作ることに注力しましょう。

トピカルオーソリティの兆候:関連する複数のクエリでAI回答に登場する、複数LLMで一貫して引用される、トピッククラスター全体で順位が付く、ピラー/クラスターコンテンツで高いエンゲージメントがある、業界内で定番リソースとして認知される、など。AmICitedでLLM引用を、Search Atlasでトピック単位の可視性を追跡しましょう。

両方必要ですが、優先度は異なります。トピカルオーソリティはAI時代の発見・長期的な可視性にますます重要で、従来SEOはGoogle順位に不可欠です。トピカルオーソリティ(セマンティック深度・エンティティ最適化・コンテンツクラスター)を強化する戦略は、従来SEOにも効果的です。まずトピカルオーソリティを土台にし、結果的にSEO効果も得ましょう。

滞在時間、スクロール深度、再訪問などのエンゲージメントは、LLMに「本当に価値あるコンテンツ」と認識させる重要なシグナルです。ユーザーがあなたのコンテンツをじっくり読み、関連ページも巡回すれば、それだけ包括的かつ権威あると判断されます。LLMはこうした行動パターンを内容の質・関連性の指標と見なし、ユーザー体験の最適化がトピカルオーソリティ構築に不可欠となります。

LLMは、あなたが様々なエンティティ(人・組織・製品・概念など)をどのようにつなげて解説しているかを分析します。関連エンティティを一貫して取り上げ、その関係性を説明すれば、LLMは「包括的に理解している」とみなします。スキーママークアップでエンティティ関係を明示するのも有効です。例えば「リタイアメントプランニング」と「社会保障」「投資戦略」「税最適化」などを結びつけて解説すれば、トピック全体を理解している証拠となります。

AIシステムが従来のSEO指標を超えてコンテンツ品質をどのように評価するかを解説。セマンティックな理解、事実の正確性、LLMやAIオーバービューで重視される品質シグナルについて学びましょう。...

LLMOとは何か、どのように機能するのか、そしてAIでの可視性がなぜ重要なのかを解説します。ChatGPT、Perplexity、その他のAIシステムでブランドが言及されるための最適化手法を紹介。...

戦略的なバックリンク獲得のためにLLMソースサイトを特定・ターゲットする方法を解説。どのAIプラットフォームが最も多くソースを引用しているかを知り、2025年のAI検索での可視性向上に向けてリンクビルディング戦略を最適化しましょう。...