AI可視性監査テンプレート:ダウンロード可能なチェックリスト

AI可視性監査テンプレートおよびチェックリストの完全版。ChatGPT、Perplexity、Google AI Overviewsなど、複数のプラットフォームでブランドを監査。ツールやタイムライン、ダウンロード可能なリソースを含むステップバイステップガイド。...

AIによる可視性のためにコンテンツを監査し、更新の優先順位を付ける方法を学びましょう。ChatGPT、Perplexity、Google AI概要のための実践的な戦略と完全なフレームワークを解説します。

ChatGPT、Claude、PerplexityのようなAI検索エンジンの台頭は、オンラインでのコンテンツ発見と消費の構造を根本から変えつつあります。Googleでの従来のSEO順位は、もはやAI搭載検索結果での可視性を保証しません。なぜなら、これらのシステムは精度・権威性・回答の完全性といった全く異なる観点でコンテンツを評価し、被リンクの数には左右されないからです。今や私たちは、ランキング経済から引用経済への変革期にあり、AIエンジンは複数のプラットフォームや会話で引用・参照・言及されるコンテンツを高く評価します。この変化により、従来十分に最適化されたコンテンツであっても、AIによる発見の新しい基準を満たさなければ見えなくなってしまうことも。包括的なコンテンツ監査はもはや“あれば良い”施策ではなく、急速に進化する検索環境下で可視性と関連性を保つために不可欠なものとなっています。

AI検索エンジンは従来の検索アルゴリズムとは根本的に異なるフレームワークでコンテンツを評価します。キーワード密度や被リンク数よりも、正確性の検証・情報源の権威性・回答の包括性を優先します。AIエンジンがあなたのコンテンツに出会ったとき、その情報が事実に基づいているか、著者が真の専門性を持っているか、ユーザーの意図に完全に応えているかを評価します。これがいわゆる引用フレームワークです。従来の被リンクは単にドメインを指し示すだけですが、AI引用はコンテンツが直接引用・参照されるか、あるいはAI生成の回答として要約・統合されることです。そのため、コンテンツの質と引用されやすさが何より重要となります。E-E-A-Tシグナル(経験・専門性・権威性・信頼性)はこの文脈でさらに重要性を増しており、AIシステムはこれらの指標をもとに引用に値するかどうかを判断します。また、コンテンツ構造も極めて重要です。AIエンジンは明確な階層構造、直接的な回答セクション、構造化データを好み、情報を抽出・検証しやすくします。要するに、従来のSEOが順位獲得を目的とするのに対し、AI最適化はAIシステムが積極的に引用・参照したいと考える“信頼できる情報源”になることを目指します。

| 要素 | 従来のSEO | AI検索最適化 |

|---|---|---|

| キーワード密度 | 重要 | 重要度低下 |

| 被リンク | 重要 | 権威シグナルがより重要 |

| コンテンツ構造 | 補助的 | 抽出のために必須 |

| 回答の質 | 二次的 | 最優先 |

| 著者の資格 | 任意 | 重要 |

| コンテンツの鮮度 | 中程度 | 最優先 |

| スキーママークアップ | 助けになる | 必須 |

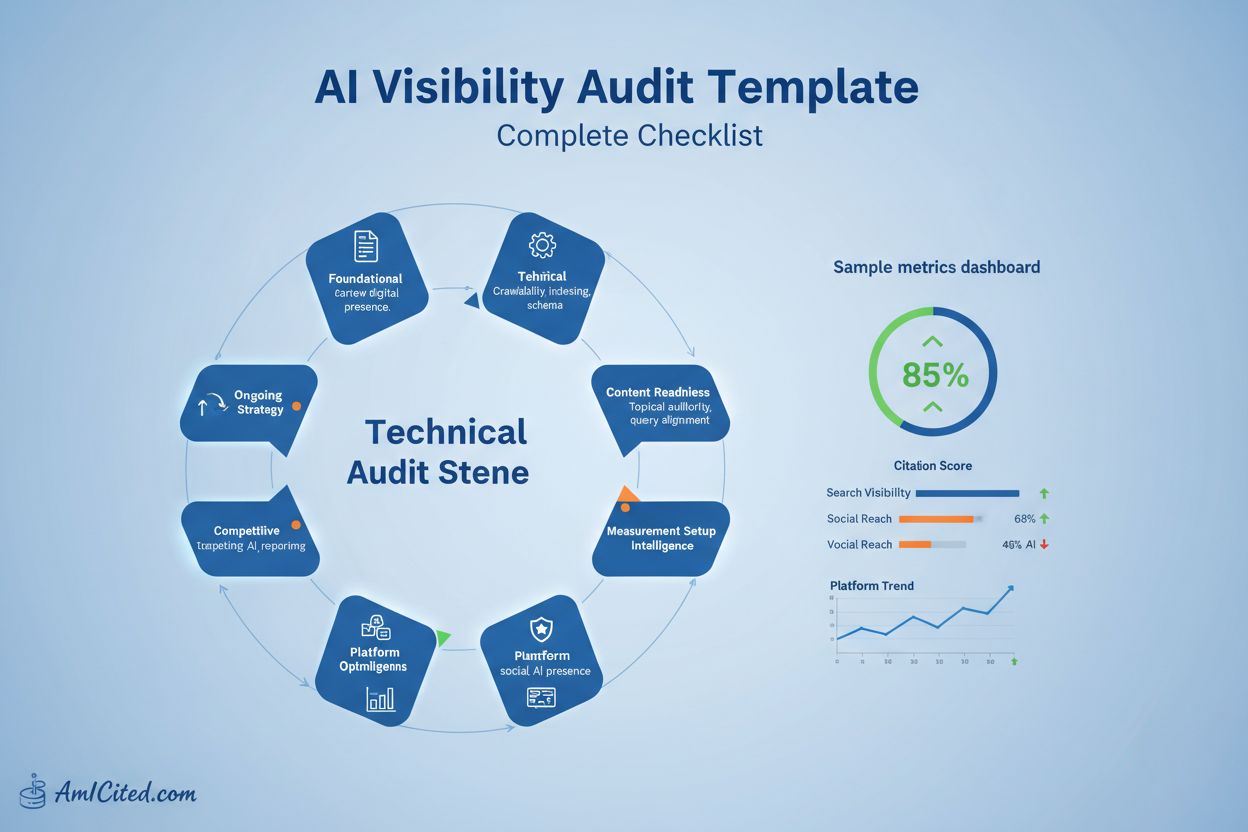

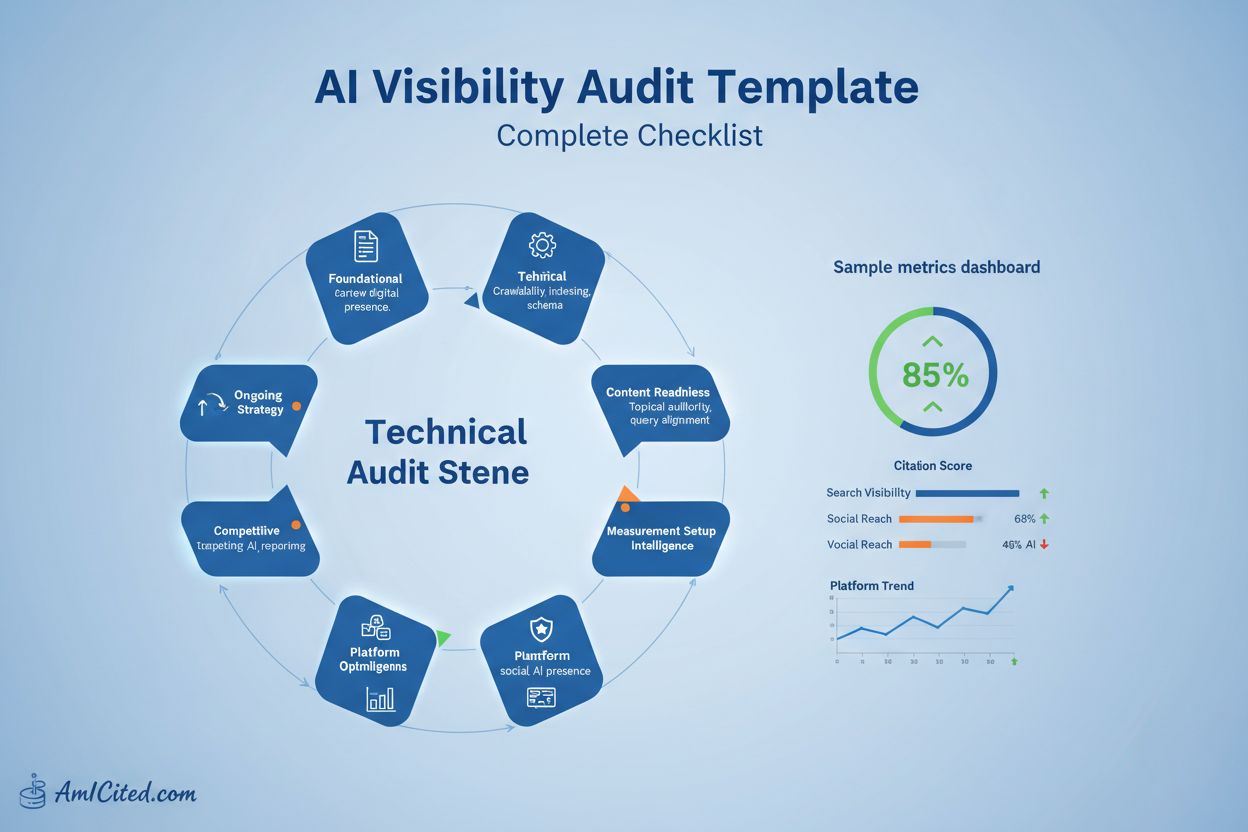

体系的な監査アプローチによって、重要な抜け漏れを防ぎ、効果の薄い改善にリソースを浪費するのを防ぎます。場当たり的な最適化ではなく、5フェーズフレームワークに沿った方法論が、AIシステムの評価・引用の観点と一致した戦略的な監査を実現します。以下がその流れです。

この体系的な方法は、戦略的価値を理解しないまま場当たり的に改善を重ねるという陥りがちなミスを防ぎます。順番通りに進めることで、データに基づくロードマップが作成でき、コンテンツのAI発見性を最大化しつつ、ビジネス目標と整合性を取ることができます。

効果的なコンテンツ監査の土台は、既存コンテンツの完全なインベントリーです。そのためには、全デジタル資産を系統的にクロール・データ収集する必要があります。Screaming Frog、SEMrush、Ahrefsなどのツールを使い、サイト全体をクロールしてすべてのコンテンツを把握し、監査の指標となる必要なメタデータを抽出します。このベースラインデータが、改善後の効果測定や全体傾向の分析の参照点となります。抽出した情報は、スプレッドシートやコンテンツ管理システムで整理・並べ替え・分析できるように管理します。目的は、最適化判断を下す前に、現状を網羅的に把握する“唯一の真実の情報源”を作ることです。

インベントリー収集で集めるべき主要メタデータ:

インベントリーが完成したら、次は各コンテンツをスコアリングします。これはAI発見性に関連する多次元的な基準を用いて行います。直感や単一指標に頼らず、トピック関連性・回答の完全性・権威シグナル・事実の正確性・構造的最適化など、複数の観点で評価するスコアリングフレームワークを作成しましょう。この多次元評価により、単一要素の過大評価を防ぎます(例:順位は良いが引用は弱い、権威はあるが回答が不完全など)。最近ではAI支援によるスコアリングも広く使われ、数百~数千のコンテンツを一貫した基準で評価し、外れ値を人間が確認できます。ここで大切なのはベンチマークです。業界やコンテンツタイプごとに“良い状態”を定義し、絶対値でなく相対評価すること。主観的な意見を、時系列で追跡・比較可能な客観指標へと変換できます。

| 観点 | 測定内容 | AI検索影響度 | 優先度 |

|---|---|---|---|

| SEO可視性 | 順位・表示回数・クリック数 | 高 | 最重要 |

| トピック深度 | 網羅性 | 高 | 最重要 |

| コンテンツ鮮度 | 最終更新日・データ新しさ | 高 | 最重要 |

| E-E-A-Tシグナル | 著者資格・専門性 | 高 | 最重要 |

| ユーザー体験 | 読みやすさ・構造・フォーマット | 中 | 高 |

| コンバージョン対応 | CTA明確さ・価値提案 | 中 | 高 |

スコア付け・ランキングが終わったら、コンテンツギャップと信頼性リスクの両方を特定します。ギャップ分析では、オーディエンスが求めているが十分にカバーできていないトピック、競合が上位表示しているが自社は弱い領域、さらに動画・インタラクティブツール・データビジュアライゼーションなど未対応のフォーマットまで洗い出します。トピックギャップだけでなく、証拠ギャップ(根拠のない主張)、カスタマージャーニーギャップ(各段階に対応したコンテンツの不足)、フォーマットギャップ(形式変更で効果が上がるトピック)にも注目しましょう。同時に、情報の陳腐化、検証されていない主張、著者資格の欠如、事実誤認など、AIシステムの信頼性を損なうリスクも洗い出します。このフェーズによって、監査が点検から戦略プランニングツールへと変わります。

評価すべきギャップのカテゴリ:

すべてのコンテンツ改善が同じ価値をもたらすわけではありません。だからこそ、優先順位付けが限られたリソースの効果的活用に不可欠です。インパクト×工数マトリクスを作成し、各コンテンツ改善案を“AI可視性やビジネス目標へのインパクト(高~低)”と“実施工数(低~高)”の2軸でプロットします。これで、すぐに取り組むべきクイックウィン(高インパクト×低工数)と、戦略的プロジェクト(高インパクト×高工数)が明確になります。クイックウィンは、既存コンテンツへの構造化データ追加、回答の明確化、著者資格の明記など。戦略的プロジェクトは大幅なリライト、新シリーズの立ち上げ、インタラクティブツールの開発などです。この優先順位はビジネス戦略と連動させましょう。B2Bならリード獲得コンテンツを優先、出版社ならAI引用ポテンシャルの高い話題を優先するなど。データドリブンな優先順位付けで、“やるべき”ことに集中できます。

| 優先度 | インパクト | 工数 | 例 | 目安期間 |

|---|---|---|---|---|

| クイックウィン | 高 | 低 | メタ更新、FAQ追加 | 1~2週間 |

| 戦略的プロジェクト | 高 | 高 | 統合・大規模リライト | 4~8週間 |

| メンテナンス | 中 | 低 | リンク更新、小規模リフレッシュ | 継続実施 |

| 今後の機会 | 中~高 | 高 | 新規コンテンツ・ツール | 8週間以上 |

優先順位が決まったら、次はAIシステムが発見・引用しやすいようにコンテンツを最適化します。まずは構造化データ(Schema.orgマークアップ)を導入し、AIエンジンがコンテンツの文脈・主張・関係性を理解しやすくします。特にFAQ、HowTo、データ重視型コンテンツでは必須です。明確な見出し階層、記事冒頭の直接的な回答セクション、AIが抽出・引用しやすい簡潔な要約を意識しましょう。引用されやすい統計や知見を盛り込み(データ、意外な発見、専門家コメントなど)、AIが回答生成時に参照しやすくします。複雑な情報はスキャンしやすいように小分けし、説明的なサブヘッド、箇条書き、番号付きリストなどで要点を整理。主張には必ず根拠や引用を添えましょう。“AIが自然と引用したくなるほど、構造化され明快なコンテンツ”を目指します。

AI発見性のための最適化チェックリスト:

E-E-A-Tシグナル(経験・専門性・権威性・信頼性)は、AIによる信頼の“通貨”となっています。意図的に権威シグナルをコンテンツ全体に組み込みましょう。まずは著者資格の明示。簡潔な著者プロフィールで、そのトピックに関する資格・経験・認定を示します。主張にはデータ・調査・権威ある情報源の引用を必ず添え、AIシステムが裏付けのない主張を見抜くことを意識します。戦略的な内部リンクで関連トピック同士の結びつきを強化し、トピッククラスターを構築することで、該当分野の“知識ハブ”であることをアピールできます。常に同じ権威ある情報源を引用し、コンテンツ同士を体系的に連携させることで、AIに「この分野の信頼できる発信元」とシグナルを送れます。専門家のコメント、ケーススタディ、実事例も積極的に盛り込みましょう。これらの権威シグナルはAI引用だけでなく、読者の信頼獲得やブランド価値向上にも直結します。

権威構築の具体的な施策:

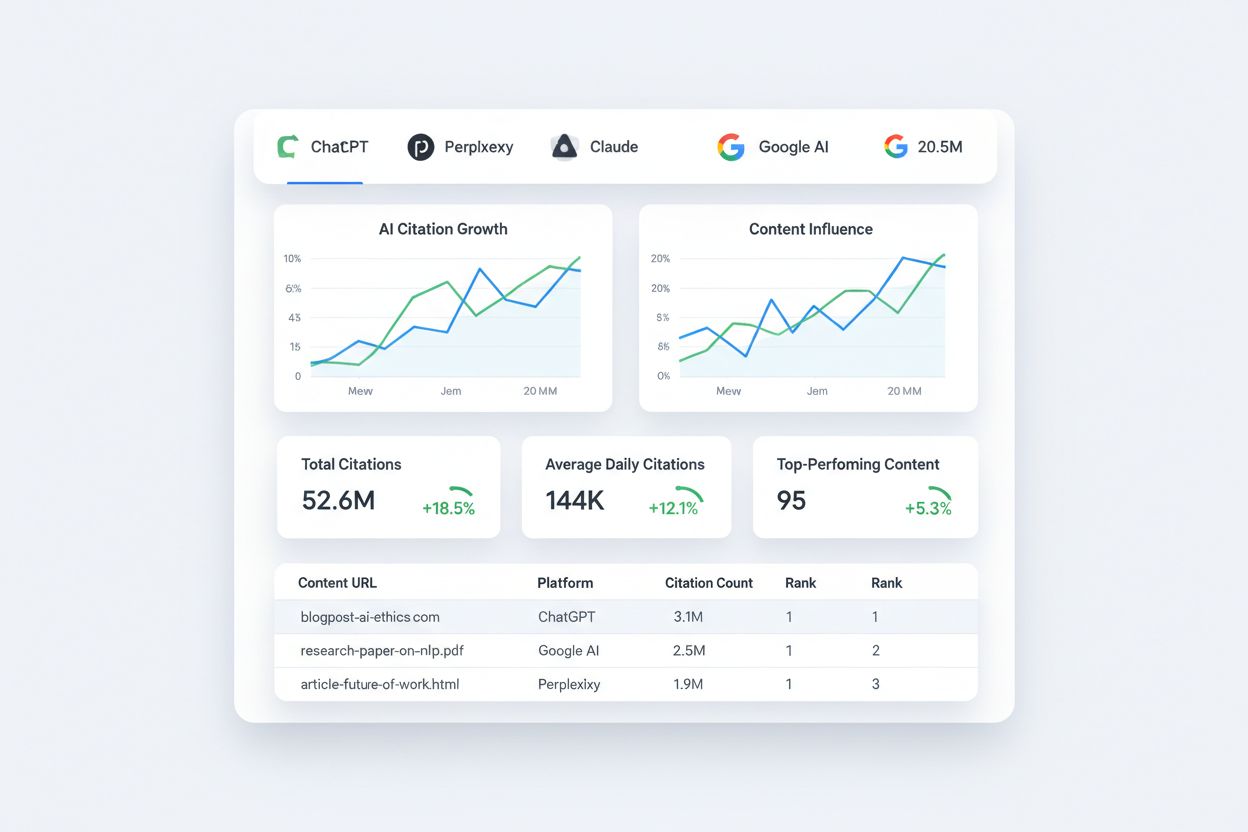

監査の価値を最大化するには、改善効果を継続的に追跡し、次の最適化に活かすフィードバックループを作ることが大切です。AI引用を各プラットフォームでモニタリングしましょう(Semrush・Ahrefs・専用AIモニタリングツール等)。従来型SEO指標(オーガニックトラフィック・キーワード順位・CTR)も必ず追跡し、AI最適化が従来検索の可視性を損なっていないかを確認します。月次トラッキングサイクルを設け、主要指標のレビュー、傾向分析、効果的な戦略の見直しを定期的に実施。これにより、監査が一過性プロジェクトで終わらず、継続的な改善プロセスとなります。

月次で追跡すべき主な指標:

多くの組織が、典型的な落とし穴にはまり、せっかくの監査効果を台無しにしています。最大の失敗は自動化頼みで、データ収集にはツールが不可欠ですが、文脈や戦略価値の評価には人間の判断が不可欠です。もう一つの重大なミスはコンテンツの鮮度軽視。定期的なリフレッシュサイクルがなければ、どんなに最適化されたコンテンツも権威を失います。多くのチームは技術的SEO基盤を省略し、コンテンツ最適化だけで十分と考えがちですが、表示速度やリンク切れ、クロール性の問題があれば優れたコンテンツも効果を発揮できません。AI最適化を優先するあまりユーザー体験を犠牲にするのも要注意。AI用の構造化は大切ですが、人間にとって読みにくい内容では両方の目的を達成できません。そして、監査を“一度きりのプロジェクト”として扱うことも避けましょう。継続的なモニタリングと改善が必須です。

避けるべき監査の落とし穴:

監査結果を30-60-90日実行計画に落とし込み、具体的なフェーズと担当者を設定することで、着実な進捗と柔軟な戦略調整を両立できます。

実施ロードマップ例:

1~30日:基礎固めとクイックウィン

31~60日:戦略的最適化とギャップ対応

61~90日:全体最適化と効果測定

各フェーズの担当(コンテンツリーダー、SEOスペシャリスト、アナリティクス担当など)を明確化し、既存のワークフローやコンテンツカレンダーに統合して“別プロジェクト扱い”にならないようにします。週次で進捗をチェックし、リソースや初期結果に合わせて柔軟に調整しつつ、90日後のゴール達成を目指しましょう。

AIモデルは頻繁に更新され、トレーニングデータも変化するため、月次での引用モニタリングが不可欠です。最適化の効果を評価するため、包括的な監査は四半期ごとに実施しましょう。定期的なモニタリングにより、AIアルゴリズムの変化に対応し、ChatGPT、Perplexity、Google AI概要など各プラットフォームでの引用パフォーマンスを維持できます。

従来のSEOはキーワード最適化や被リンクを通じて検索結果での順位獲得を目指しますが、AIコンテンツ監査は回答の質、権威性シグナル、コンテンツ構造によるAIエンジンからの引用獲得を重視します。現代の検索最適化では両方の戦略が補完関係にありますが、AI監査は順位要因よりも引用価値に重点を置きます。

まずはユーザーベースと引用影響力が最大のChatGPT、Perplexity、Claudeから始めましょう。GoogleのAI概要も従来の検索結果に表示されるため重要です。ターゲットユーザーが最も利用しているプラットフォームに注力し、主要なAIエンジン全体で引用パターンをモニタリングしましょう。

引用に値するコンテンツは、明確で正確な回答と裏付けとなる証拠、専門家の信頼性を備えています。コンテンツが答えるべき質問をAIエンジンに投げてテストしましょう。包括的な内容にもかかわらず引用されない場合は、構造、権威性シグナル、回答の明瞭さを改善する必要があります。

FAQスキーマ、Articleスキーマ、Authorスキーマが最も重要な構造化データタイプです。高速な表示速度、モバイル最適化、明確なコンテンツ階層もAIによる発見性を支えます。技術基盤がAIエンジンによるコンテンツの理解・抽出を効果的にします。

既に検索エンジンから信頼を得ている高パフォーマンスの既存コンテンツはAI最適化に最適です。構造化データの追加、回答の明確化、権威性シグナルの強化、内部リンクの向上を行いましょう。新規コンテンツは競合が一貫して引用されていないトピックに注力してください。

各プラットフォームでのAI引用、オーガニックトラフィックの成長、キーワード順位の改善、コンバージョン指標を追跡します。最適化前後のパフォーマンスを比較し、月次でモニタリングして傾向を把握し、効果のある施策に基づいて戦略を調整します。Semrush、Ahrefs、専門的なAIモニタリングツールを活用しましょう。

最大のミスは監査を一度きりのプロジェクトとして扱い、継続的な取り組みにしないことです。自動化に頼りすぎて人的判断を省略したり、コンテンツの鮮度を軽視したり、技術的SEO基盤を省略したり、ユーザー体験を犠牲にしてAI最適化に偏ることもよくある失敗です。コンテンツ監査は継続的なモニタリングと改善が不可欠です。

ChatGPT、Perplexity、Google AI概要のようなAIエンジンがあなたのブランドをどのように引用するかを追跡しましょう。AI検索での存在感をリアルタイムで把握し、コンテンツ戦略を最適化します。

AI可視性監査テンプレートおよびチェックリストの完全版。ChatGPT、Perplexity、Google AI Overviewsなど、複数のプラットフォームでブランドを監査。ツールやタイムライン、ダウンロード可能なリソースを含むステップバイステップガイド。...

ChatGPT、Google AIオーバービュー、Perplexityに引用されやすいAI最適化チェックリストの作り方を学びましょう。なぜチェックリストが最も引用されやすいコンテンツ形式なのか、そしてAIによる可視性を最大化するための構造化方法を解説します。...

戦略的なウェブサイト最適化によって、AIによる引用が月間47件以上増加した実際のビフォーアフター事例を紹介。ChatGPT、Perplexity、Google AI Overviewsで可視性を高めた具体的な変更点を学べます。...

クッキーの同意

閲覧体験を向上させ、トラフィックを分析するためにクッキーを使用します。 See our privacy policy.