LLMメタアンサー

LLMメタアンサーとは何か、ChatGPT、Perplexity、Google AI OverviewsなどのAI生成回答で可視性を高めるためのコンテンツ最適化方法を解説します。LLMOのベストプラクティスを紹介。...

AIシステムに引用されるLLMメタアンサーの作成方法を学びましょう。構造化テクニックや回答密度の戦略、引用されやすいコンテンツフォーマットを発見し、AI検索結果での可視性を高めましょう。

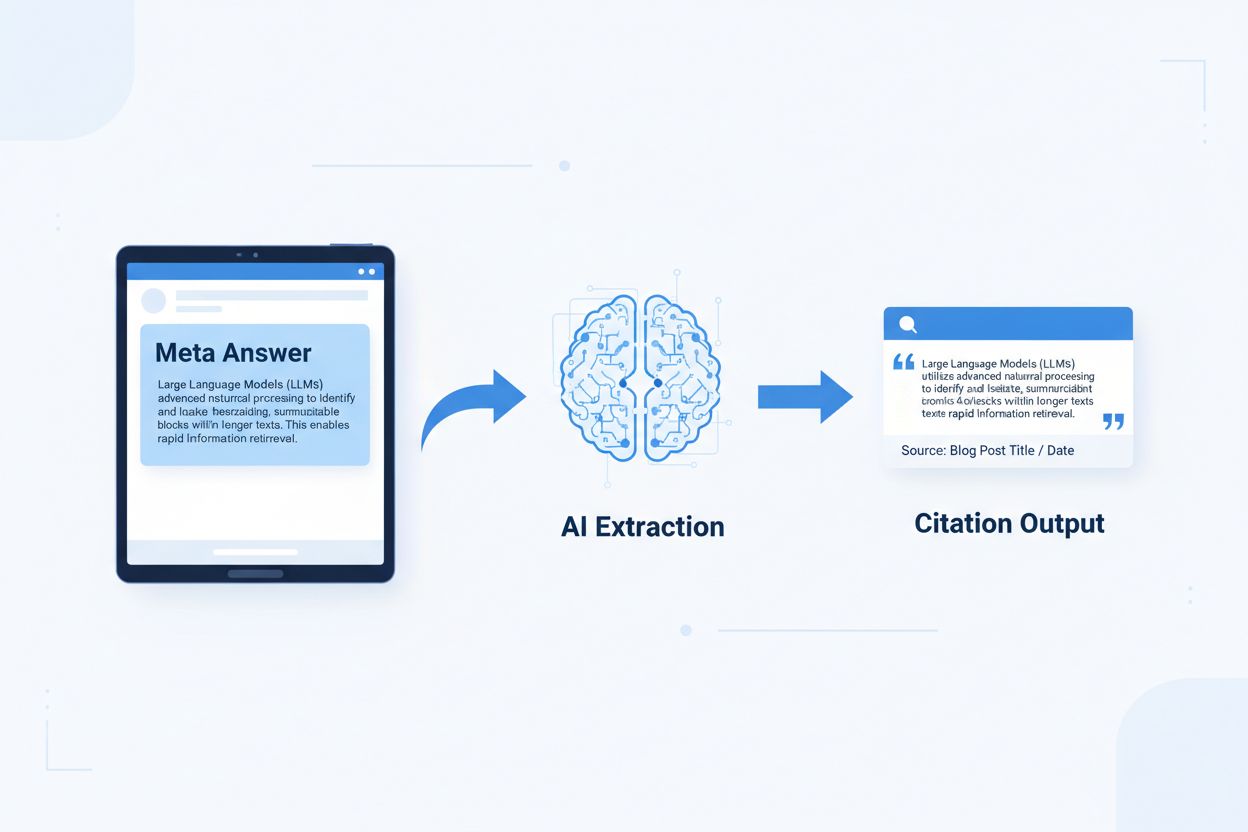

LLMメタアンサーは、追加の文脈を必要とせず、言語モデルが直接抽出・引用できるようAI最適化された独立型コンテンツブロックです。 従来のウェブコンテンツがナビゲーションや見出し、周囲の文脈に依存して意味を伝えていたのに対し、メタアンサーは切り出しても意味が完結する独立したインサイトとして機能します。この違いは重要です。なぜなら現代のAIシステムは人間のようにウェブサイト全体を読むのではなく、コンテンツをチャンク(塊)に分割し、関連性を評価し、回答の根拠となるパッセージを抽出するからです。構造化されたメタアンサーに出会うと、AIは情報が完全で検証可能かつ文脈に依存しないため、自信をもって引用できます。Onelyの調査によれば、AI引用最適化されたコンテンツは従来型フォーマットよりもLLM出力で3~5倍多く言及されることが判明しており、AI生成回答でのブランド可視性に直接影響します。この変化はコンテンツ評価の根本的な転換を意味します。従来の検索順位争いではなく、メタアンサーはAI回答への組み込みを競う時代なのです。AmICited.comのような引用モニタリングプラットフォームは、こうしたAIでの言及を重要な指標として追跡し、引用可能なコンテンツを備えた組織がAI経由のトラフィックやブランド権威を定量的に伸ばしていることを明らかにしています。結論は明快—メタアンサーとして構造化されたコンテンツは引用頻度が上がり、AIファーストな情報環境でブランド可視性を高められます。

引用されやすいコンテンツにはAIシステムに「これは完全で引用可能な回答だ」と伝える特定の構造要素が必要です。 最も効果的なメタアンサーは、明確なトピック文(主張)、根拠となる証拠、独立した結論を一つの論理単位にまとめています。これらの要素が組み合わさることで、AIシステムが「抽出可能な知識」と認識する情報—すなわち、元ページを見なくても独立して価値を持つ情報—が成立します。こうした構造手法は、情報を複数ページに分散し内部リンクで文脈形成する従来のウェブコンテンツとは本質的に異なります。

| 引用されやすい要素 | AIシステムが好む理由 |

|---|---|

| 主張を含むトピック文 | 最初の20トークンで回答の核心価値を即座に示し、AIが関連性を評価しやすい |

| 証拠(データ・事例) | 検証可能な裏付けを提供し、引用の正確性への信頼を高める |

| 具体的な数値や統計 | 定量的な主張は引用されやすく、曖昧さを減らす |

| 定義や説明 | 独立した理解が可能になり、AIが外部文脈なしで抽出できる |

| 実用的な結論 | 回答の完結を示し、AIに「ここで終わり」と知らせる |

| 出典明記 | 信頼性を構築し、AIは明確な出典のあるコンテンツを好む |

AI抽出最大化のための実践ヒント:

AI抽出に最適なチャンクサイズは256~512トークン、つまり2~4つの良く構成された段落が目安です。 この範囲はAIが意味ある情報を文脈を失わずに抽出できる「スイートスポット」です。256トークン未満では文脈が不足し、512トークン超では要約や切り捨てが発生しやすく、直接引用性が低下します。段落単位のチャンク分割(各段落が一つの完結した思考単位)は、機械的なトークン分割よりも意味的一貫性を保ち、AIが関連性を評価する論理の流れを維持できます。

良いチャンクは意味の境界を守る:

✓ GOOD: "引用されやすいコンテンツには特定の構造要素が必要です。

最も効果的なメタアンサーは明確なトピック文、証拠、独立した結論を

一つの論理単位で組み合わせます。これらが合わさることでAIは

抽出可能な知識と認識します。"

✗ BAD: "引用されやすいコンテンツにはAIシステムに『これは完全で

引用可能な回答だ』と伝える特定の構造要素が必要です。

最も効果的なメタアンサーは、明確なトピック文、証拠、独立した結論を

一つの論理単位にまとめています。これらの要素が組み合わさることで、

AIシステムが『抽出可能な知識』と認識する情報—すなわち、元ページを

見なくても独立して価値を持つ情報—が成立します。こうした構造手法は、

情報を複数ページに分散し内部リンクで文脈形成する従来のウェブコンテンツ

とは本質的に異なります。"

良い例は意味的な一貫性を保ち、自然な結論で終わります。悪い例は複数のアイデアを混在させ、AIが途中で切るか無関係な文脈ごと抽出することを強いるものです。オーバーラップ戦略(一つのチャンクの最後の文が次のチャンクの内容を予告する)は、抽出性を損なわずにAIに内容の関係性を理解させるのに有効です。実践的なチャンク最適化チェックリスト: 各チャンクは単一の質問に答えているか?周囲の段落を読まずに理解できるか?256~512トークンか?意味的な区切りで終わっているか?

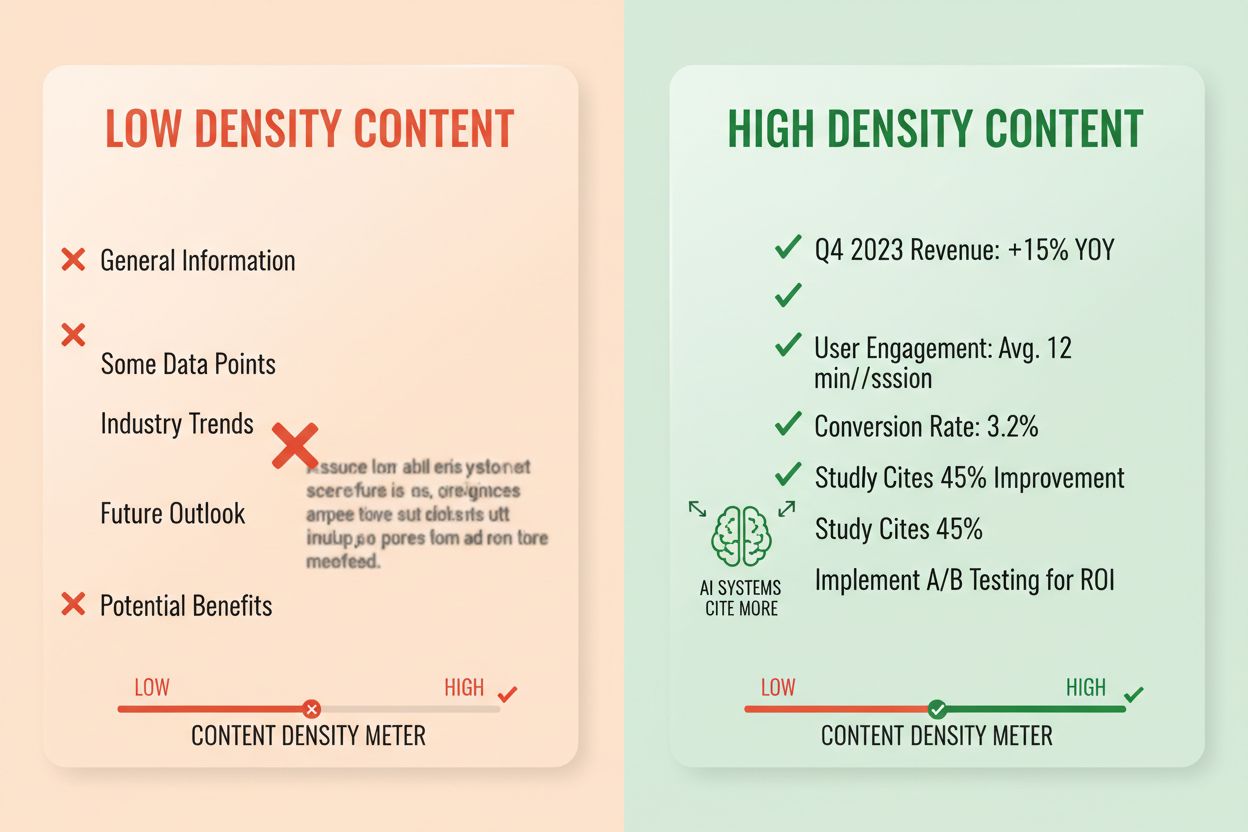

回答密度とは、実用的な情報が全体の文量に占める割合を示し、高密度コンテンツは低密度より2~3倍多くAIに引用されます。 回答密度80%の段落は主張・証拠・実用的インサイトが大半を占め、40%のものは無駄や繰り返し、文脈説明が多くを占めます。AIは密度を暗黙的に判断し、すべての文がユーザー質問への回答に貢献しているパッセージを優先的に抽出・引用します。高密度要素には具体的統計、手順説明、比較データ、定義、実践的提案などが含まれます。低密度パターンは長い前置き、繰り返し、修辞的質問、主張に直結しないストーリーテリングなどです。

測定法: 質問に直接答える文と、文脈や移行的な文をカウントします。高密度の段落例:

「引用されやすいコンテンツはAIで3~5倍多く言及されます(統計)。これはAIが独立した完結回答を抽出するためです(説明)。回答優先フォーマットと意味的チャンク分割で密度を最大化しましょう(アクション)。」

低密度例:「多くの組織はAIでの可視性に苦労しています。デジタル環境は急速に変化しています。コンテンツ戦略も大きく進化しました。引用されやすいコンテンツの重要性が増しています……」後者は主張を薄める周辺的説明が多いです。

実際のインパクト統計: 回答密度70%以上のコンテンツはAI出力で月平均4.2回引用、40%未満は1.1回。既存コンテンツを高密度化した組織は60日で引用が平均156%増加。高密度例:「AI抽出に最適なチャンクは256~512トークン(主張)。この範囲なら文脈を保持しつつ切り捨てを防げます(証拠)。段落ベースのチャンクで意味的一貫性を維持しましょう(アクション)。」低密度例:「チャンク分割はAIにとって重要です。コンテンツの整理方法は色々あります。小さいチャンクを好む人もいれば、大きい方が良い人もいます。最適な方法はニーズ次第です。」高密度の方が実践的アドバイスを明確に伝えます。

特定のコンテンツ構造はAIに「抽出・引用用に整理されている」とシグナルを送り、引用確率を大幅に高めます。 FAQセクションは質問と回答を明示的に組み合わせるため、AIが関連パッセージを容易に特定・抽出できます。比較表は複数オプションを一目で評価でき、ユーザーの比較質問時に特定行だけをAIが引用できます。手順解説は明確な意味境界を作り、「どうやって…?」系質問で頻繁に引用されます。定義リストは用語と説明を組で示し、技術系でAIが正確な定義を抽出するのに役立ちます。要約ボックスは重要ポイントを際立たせ、リスト記事は複雑な話題を引用しやすい単位に分割します。

AI抽出性を最大化する構造要素:

実例:「回答密度とは?」というFAQとその定義・説明は直接引用ソースになります。2章の「引用されやすい要素 | AIシステムが好む理由」のような比較表は、比較質問時に引用されます。「意味的チャンク実装方法」などの番号付きガイドは引用しやすい手順コンテンツになります。これらはAIが情報を解析・抽出する方式—明確なQ&A、構造的比較、独立した手順—と合致しているため有効です。

セマンティックHTML5マークアップはAIに構造を伝え、抽出精度と引用確率を40~60%向上させます。 正しい見出し階層(H1:主要トピック、H2:サブトピック、H3:補足ポイント)はAIにコンテンツの関係性や抽出境界を伝えます。<article>や<section>、<aside>などのセマンティック要素はコンテンツの役割を明示します。特にschema.orgの構造化データ(JSON-LD形式)は、AIに「どんな情報が含まれているか」を明示的に伝え、自信をもって引用させます。

FAQ用JSON-LD例:

{

"@context": "https://schema.org",

"@type": "FAQPage",

"mainEntity": [{

"@type": "Question",

"name": "回答密度とは?",

"acceptedAnswer": {

"@type": "Answer",

"text": "回答密度は実用情報が全体文量に占める割合を示します。高密度なコンテンツは低密度より2~3倍多くAIに引用されます。"

}

}]

}

記事メタデータ用JSON-LD例:

{

"@context": "https://schema.org",

"@type": "Article",

"headline": "LLMメタアンサーの作成",

"author": {"@type": "Organization", "name": "AmICited"},

"datePublished": "2024-01-15",

"articleBody": "..."

}

メタコンテンツ(meta descriptionやOpen Graphタグ)は、AIが解析前にコンテンツの目的を理解する手助けになります。高速なページ表示やモバイル最適化、正しいaltテキストなどのパフォーマンス・アクセシビリティ向上も、AIによる完全なクロール・インデックス化を間接的に支援します。技術実装チェックリスト: HTMLはセマンティックかつ正しく構造化されているか?schema.orgマークアップは実装済みか?meta descriptionは内容を正確に要約しているか?モバイル最適化・高速化は万全か?画像に正しいaltタグは付与されているか?

引用トラッキングはコンテンツパフォーマンス測定の必須項目となりましたが、多くの組織はAI回答での自社コンテンツ露出頻度を把握できていません。 検索テストでは、主要LLM(ChatGPT、Claude、Gemini)にターゲット質問を投げ、回答でどのソースが引用されたか記録します。コンテンツ監査では既存コンテンツを引用対応基準で評価し、ギャップと最適化機会を特定します。パフォーマンス指標は引用頻度・引用文脈(どう使われたか)・引用増加率を追跡します。反復的な最適化では、構造変更をテストし、引用頻度への影響を測定し、有効なパターンを全体に展開します。

| トラッキングツール | 主な機能 | 最適用途 |

|---|---|---|

| AmICited.com | 主要LLM全体でのAI引用モニタリング | 全面的な引用可視化・競合分析 |

| Otterly.AI | AIコンテンツ検出・引用追跡 | 自社コンテンツがAI出力で出現する箇所の特定 |

| Peec AI | AIシステムでのコンテンツパフォーマンス | 引用頻度・傾向測定 |

| ZipTie | AI生成コンテンツ監視 | AI回答でのブランド言及追跡 |

| PromptMonitor | LLM出力分析 | AIが自社コンテンツをどう利用しているかの把握 |

AmICited.comは最も優れた総合ソリューションです。 ChatGPT、Claude、Geminiなど主要LLM横断でリアルタイム監視・競合ベンチマーク・詳細な引用文脈分析を提供します。単なる引用有無だけでなく、直接引用・パラフレーズ・補足証拠としての利用状況まで可視化します。測定手法: 上位20本のコンテンツで引用頻度のベースラインを確立→5~10本に引用最適化→30~60日間で引用変化を測定→成功パターンを全体に展開。引用頻度・増加率・文脈・シェアを追跡しましょう。

ミス1:回答を文脈に埋もれさせる。 多くの制作者は背景説明や問題提起を先に述べ、回答本体を後回しにしがちです。AIは最初の50~100トークンで関連性を判断するため、回答が冒頭にないと次のソースに移ります。問題例:「回答密度とは?」という質問に「コンテンツ戦略は大きく進化しました…」から始まる段落は不適切。解決策: 回答優先でインサイトから始め、後で文脈を補足。

ミス2:外部文脈を必要とする回答。 「前述の通り」や「上記の方法で」など、独立抽出できない記述は失格です。問題例:「先ほど説明したアプローチに従い…」は、該当アプローチがチャンク内にないため抽出不可。解決策: すべての回答を自己完結型にし、必要なら少し繰り返してでも文脈を含める。

ミス3:複数の回答を1チャンクに混在。 複数質問を1段落で扱うと、AIは途中で切るか無関係情報ごと抽出することに。問題例:「回答密度とは?」「どう測る?」「なぜ重要?」を1つの600語段落で解説→抽出困難。解決策: 質問や概念ごとに短く焦点化したチャンクを用意。

ミス4:曖昧な表現で具体的データがない。 「多く」「いくつか」「しばしば」「一般的に」などは自信度を下げます。問題例:「多くの組織が改善を実感」は、「コンテンツ再構成で引用が156%増加」の方が引用されやすい。解決策: 可能な限り具体的なデータ・数値(なければ「40~60%」など)を用いる。

ミス5:構造マークアップを省略。 見出しやschema.orgがないとAIによる抽出難度が上がります。問題例: 見出しもセマンティックHTMLもschemaなしの段落は、独立した回答と認識されにくい。解決策: HTML5のセマンティック構造・正しい見出し・schema.orgを必ず追加。

ミス6:回答が短すぎる/長すぎる。 150トークン未満は文脈不足、700超は切り捨てられる。問題例: 100語の回答は証拠不足、1000語では分割される。解決策: 256~512トークン(2~4段落)を目指し、主張・証拠・結論をその範囲でまとめる。

エンティティ一貫性—同じ概念には常に同じ用語を使う—はAI引用率を高め、「専門知識の証」となります。 例えば「回答密度」と定義したら、以降も「情報密度」「コンテンツ密度」など別表現にせず統一しましょう。AIは一貫性を専門性指標とみなし、用語が正確・一貫しているコンテンツを好んで引用します。製品名・手法名・技術用語にもこの原則を徹底しましょう。

第三者言及や独自調査は引用頻度を劇的に高めます。 権威ある外部ソースの参照(出典明記)は信頼性の証となり、独自調査や自社データは唯一無二の引用ソースになります。自社リサーチ統計やクライアント事例など独自インサイトは、AIに「ここでしか得られない情報」と認識されます。独自調査公開組織は引用率が3~4倍高い傾向。戦略: 業界で独自調査を実施→詳細な手法付きで公開→メタアンサー内で言及。

鮮度シグナル—公開日・更新日・最新事例—はAIに新しさを伝える要素です。 30日以内に更新されたコンテンツは特に変化の多い領域で引用優先度が上がります。schema.orgで公開日・更新日を明記しましょう。戦略: 定期的なコンテンツリフレッシュを実施、上位記事は30~60日ごとに統計や事例・説明追加で更新。

E-E-A-Tシグナル(経験・専門性・権威性・信頼性)はAIの引用判断に作用します。 専門家執筆・権威あるドメインでの公開・資格情報の明記は引用優先度を高めます。著者プロフィールに資格を記載、権威あるサイトで公開、業界誌からの被リンクを獲得しましょう。戦略: 専門家著者を起用、著者情報に資格明記、業界権威メディアからの被リンク獲得。

生成ブランド密度—ブランド化されたインサイト比率—は、AIが自社か競合どちらを引用するかを左右します。 独自フレームワーク・手法・ブランド化したノウハウが含まれると、コンテンツは唯一性を持ち引用率が高まります。「ベストプラクティス」など汎用的内容より「AmICitedの引用最適化フレームワーク」のようなブランド化されたものが引用されやすいです。高いブランド密度の組織は2~3倍多く引用されます。戦略: 独自フレームワーク・手法・用語を開発し、全コンテンツで一貫使用。メタアンサーの基礎に据える。

LLMメタアンサーはAIによる抽出と引用に特化して設計されており、強調スニペットはGoogle検索結果の表示最適化を目的としています。メタアンサーは独立した完結性と意味的な一貫性を重視し、強調スニペットは簡潔さやキーワード一致を重視します。両者は共存できますが、メタアンサーには異なる構造最適化が必要です。

最適な長さは256~512トークン、2~4段落または約200~400語に相当します。この範囲はAIが十分な文脈を持って自信をもって抽出できると同時に、切り捨てを防ぎます。短すぎる回答は文脈が不足し、長すぎる回答はAIが要約や分割を強いられます。

はい、ただし再構成が必要です。既存コンテンツを回答優先の書式、一貫した意味、独立した完結性の観点から監査しましょう。重要なインサイトを冒頭に移動し、相互参照を削除し、各セクションが外部文脈なしで完全な質問に答えるように調整できます。

パフォーマンス上位のコンテンツは30~60日ごとに新しい統計や事例、説明追加で更新しましょう。AIシステムは直近30日以内に更新されたコンテンツを優先し、特に情報が頻繁に変化するトピックで顕著です。schema.orgのマークアップに公開日や更新日を含めてください。

回答密度は引用頻度と直接相関します。回答密度70%以上のコンテンツはAI出力で月平均4.2回引用され、40%未満では1.1回です。高密度コンテンツは無駄なく実用的な情報を提供するため、AIに引用されやすくなります。

AmICited.comのような引用モニタリングプラットフォームを利用しましょう。ChatGPT、Claude、Geminiなど主要LLMで引用を追跡できます。ターゲット質問をAIシステムに入力し、どのソースが引用されているか手動で検証することも可能です。最初に引用頻度を測定し、最適化を施し、30~60日間で変化を追跡しましょう。

基本構造は全プラットフォームで共通ですが、プラットフォームごとの最適化も可能です。ChatGPTは網羅的で根拠のあるコンテンツを好みます。Perplexityは最新情報と明確な引用を重視。Google AI Overviewsは構造化データやE-E-A-T指標を優先します。バリエーションをテストし、各プラットフォームで引用状況をモニターしましょう。

AmICitedは全主要AIプラットフォームでのコンテンツ引用をリアルタイムでモニタリングし、メタアンサーがどこでどう使われているか、競合とのシェアまで可視化します。引用文脈(直接引用、パラフレーズ、補足証拠など)も明らかにし、データに基づいた最適化判断を可能にします。

ChatGPT、Perplexity、Google AI Overviews、その他のAIシステムで、どこであなたのコンテンツが引用されているかを正確に確認できます。引用傾向を追跡し、競合状況を把握し、AmICitedでコンテンツ戦略を最適化しましょう。

LLMメタアンサーとは何か、ChatGPT、Perplexity、Google AI OverviewsなどのAI生成回答で可視性を高めるためのコンテンツ最適化方法を解説します。LLMOのベストプラクティスを紹介。...

戦略的なバックリンク獲得のためにLLMソースサイトを特定・ターゲットする方法を解説。どのAIプラットフォームが最も多くソースを引用しているかを知り、2025年のAI検索での可視性向上に向けてリンクビルディング戦略を最適化しましょう。...

独自の調査データとオリジナル統計がどのようにLLMから引用を集める磁石になるのかを解説します。AIの可視性を高め、ChatGPT、Perplexity、Google AI Overviewなどからより多く引用されるための戦略を学びましょう。...

クッキーの同意

閲覧体験を向上させ、トラフィックを分析するためにクッキーを使用します。 See our privacy policy.