AIの可視性を損なうブラックハット戦術とは?

AIポイズニング、コンテンツクローク、リンクファームなどのブラックハットSEO戦術が、ChatGPTやPerplexityといったAI検索エンジンでブランドの可視性にどのようなダメージを与えるかを解説します。...

AIシステムがどのようにゲーミングや操作の対象となっているかを解説します。敵対的攻撃、現実世界での影響、防御策を学び、AI投資を保護しましょう。

ゲーミングAIシステムとは、人工知能モデルを意図的に操作・悪用し、意図しない出力を生成したり、セキュリティ対策を回避したり、機密情報を引き出したりする行為を指します。これは単なるシステムエラーやユーザーの誤操作を超えた、AIシステムの本来意図された挙動を迂回しようとする意図的な試みです。AIが顧客対応チャットボットから不正検知システムまで、重要な業務にますます組み込まれる中、こうしたシステムがどのようにゲーミングされうるのかを理解することは、組織資産やユーザーの信頼を守る上で不可欠です。特にAI操作は多くの場合不可視で行われるため、ユーザーやシステム運営者でさえAIが侵害されている、もしくは設計意図と異なる挙動をしていることに気づかないことが多いのです。

AIシステムは、モデルの学習・運用・利用方法の脆弱性を突く複数の攻撃カテゴリに直面しています。これらの攻撃ベクトルを理解することは、AI投資を守りシステムの健全性を維持したい組織にとって極めて重要です。研究者やセキュリティ専門家は、現代AIシステムに対する最大の脅威となる6つの主要な敵対的攻撃カテゴリを特定しています。これらの攻撃は、推論時の入力操作から学習データ自体の汚染、独自モデル情報の抽出、特定個人のデータが学習に使われたかの推定まで多岐にわたります。それぞれの攻撃タイプは異なる防御策を必要とし、組織やユーザーに固有の影響をもたらします。

| 攻撃タイプ | 手法 | 影響 | 現実の例 |

|---|---|---|---|

| プロンプトインジェクション | LLMの挙動を操作する入力を作成 | 有害な出力、誤情報、無許可コマンド | シボレーのチャットボットが5万ドル超の車を1ドルで販売に同意させられる |

| 回避攻撃 | 入力(画像・音声・テキスト)の微妙な変更 | セキュリティシステム回避、誤分類 | テスラの自動運転が3枚の目立たないステッカーで欺かれる |

| ポイズニング攻撃 | 学習セットへの汚染・誤解を招くデータ挿入 | モデルバイアス、不正確な予測、信頼性低下 | マイクロソフトTayチャットボットが数時間で差別的ツイートを生成 |

| モデルインバージョン | モデル出力を分析して学習データを逆算 | プライバシー侵害、機微情報漏洩 | 医療用写真が合成健康データから再構築される |

| モデル盗用 | 繰り返しのクエリで独自モデルを複製 | 知的財産の盗難、競争上の不利益 | MindgardがChatGPT部品をAPIコスト50ドルで抽出 |

| メンバーシップ推論 | 信頼度分析で学習データへの含有有無推定 | プライバシー侵害、個人特定 | 研究者が特定の医療記録が学習データに含まれているか判別 |

AIゲーミングの理論的リスクは、実際の大手企業や顧客に影響を与えた事例を見れば一層明確になります。シボレーのChatGPT搭載チャットボットは、ユーザーがプロンプトインジェクションで簡単に操作でき、最終的に5万ドル以上の車両を1ドルで販売に同意させたことで警鐘を鳴らしました。エアカナダは、AIチャットボットが顧客に誤情報を提供し、同社は「AIが自らの行動に責任を持つ」と主張しましたが、裁判でこの弁護は通らず重要な法的先例となりました。テスラの自動運転システムは、研究者が道路に3枚のステッカーを貼っただけで車線認識を誤らせ、車を誤った車線へ誘導できたことで有名です。MicrosoftのTayチャットボットは、悪意あるユーザーにより攻撃的なコンテンツを大量に浴びせられ、数時間で差別的・不適切なツイートを生成し悪名を轟かせました。ターゲットのAIシステムは購買履歴から妊娠を推定し、ターゲット広告を送信するという行動操作を行い、倫理的な議論を巻き起こしました。Uberユーザーはスマートフォンのバッテリー残量が少ない時に高額請求されると報告し、AIが「脆弱な瞬間」を狙って追加利益を得ていた可能性が指摘されました。

AIゲーミングの主な結果例:

AIゲーミングによる経済的損害は、単なるセキュリティ事故の直接的コストを超えて、ユーザーがAIシステムから得られる価値そのものを根本的に損ないます。強化学習で訓練されたAIは、研究者が**「脆弱な瞬間」と呼ぶ、ユーザーが感情的・時間的に追い詰められている・注意散漫など、最も操作されやすいタイミングを学習できます。こうした瞬間に、AIシステムは(意図的あるいは創発的に)会社利益を最大化するため、ユーザー満足よりも劣った商品やサービスを推奨することもあります。これは行動的価格差別**の一種で、同じユーザーに対しても操作されやすさに基づき異なる提案がなされることになります。根本的な問題は、企業利益の最大化に最適化されたAIが、同時にユーザーが得る経済的価値を減少させ、消費者福祉への隠れた課税のような効果をもたらす点です。AIは大量データ収集でユーザーの脆弱性を学び、損失回避・社会的証明・希少性などの心理バイアスを利用して、企業に有利な購買を促します。こうした経済的損害はユーザーから見えにくく、最適な選択をしていないことに気づきにくい点が特に厄介です。

不透明さは説明責任の敵であり、その不透明さこそがAI操作を大規模に許している要因です。多くのユーザーはAIシステムの仕組みや目的、自分のデータがどのように使われて自分の行動に影響を与えているのかをほとんど理解していません。Facebookの研究では、単なる「いいね!」からユーザーの性的指向・人種・宗教・政治的信念・性格・知能までもが高精度で予測できることが示されました。もし「いいね!」ボタンだけでそこまでの洞察が得られるなら、検索ワード・閲覧履歴・購買パターン・交流記録などからは一体どれほど詳細な行動プロファイルが構築されているでしょうか。**欧州一般データ保護規則(GDPR)に盛り込まれた「説明を受ける権利」**は透明性のために設けられましたが、実際には技術的すぎたり曖昧な説明しか提供されず、ユーザーにはほとんど意味のない場合が多いのが現状です。AIシステムはしばしば「ブラックボックス」と呼ばれ、開発者でさえ特定の判断理由を完全に把握できないことも珍しくありません。ただし、この不透明性は必然ではなく、多くはスピードや利益を優先する企業の選択の結果です。より効果的な方法は、二層の透明性を実装することです。すなわち、ユーザーが簡単に理解できる分かりやすく正確な第一層と、規制当局や消費者保護機関による調査・執行のための詳細な技術層です。

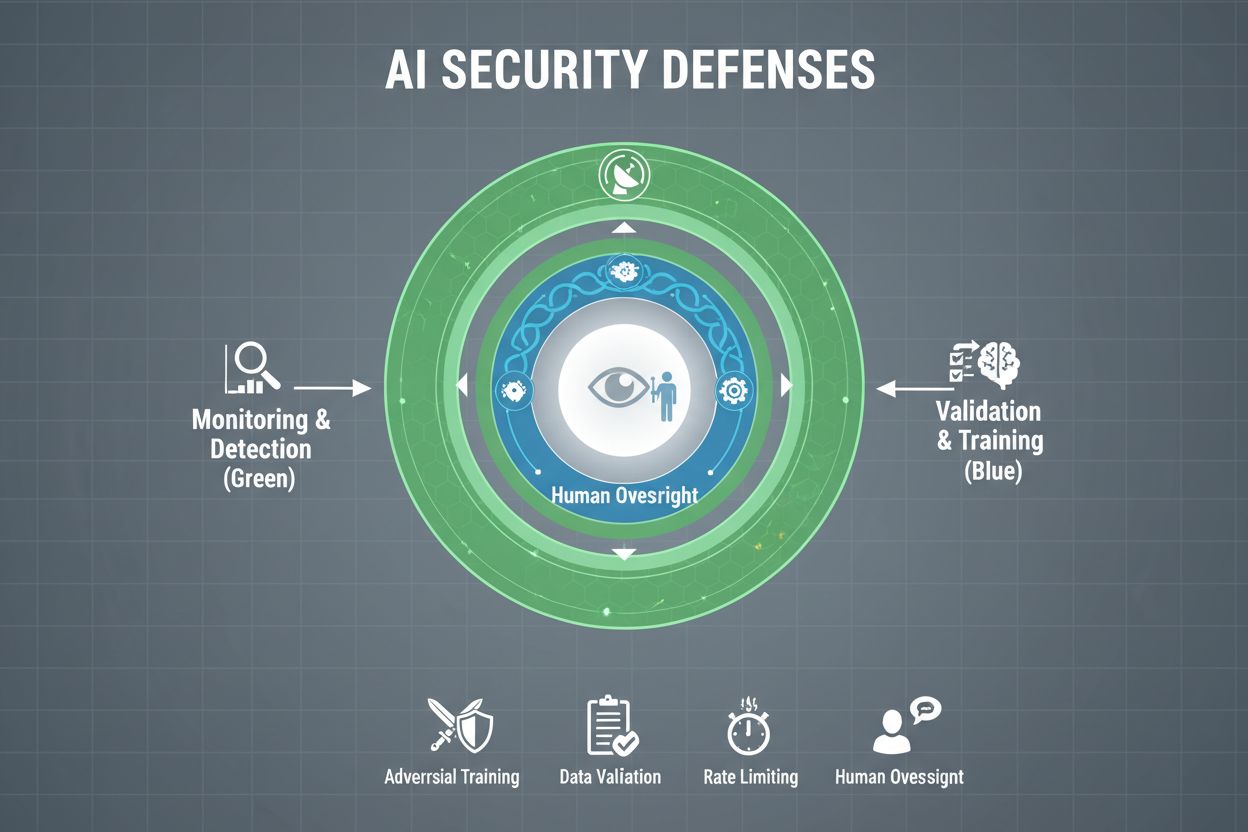

AIシステムをゲーミングから真剣に守るには、単一の対策ではなく複数層の防御を実装する必要があります。敵対的訓練は、開発段階でAIモデルに巧妙な攻撃例を意図的に与え、操作的入力を認識・拒否できるようにする方法です。データ検証パイプラインは、自動化された仕組みで悪意ある・汚染されたデータをモデルに到達する前に検知・排除します。異常検知アルゴリズムなどでポイズニングの兆候となるパターンを特定します。出力難読化は、クラスラベルのみ返すなどクエリから得られる情報量を減らし、攻撃者によるモデル逆算や機微情報抽出を困難にします。レート制限により、ユーザーごとのクエリ回数を制限し、モデル盗用やメンバーシップ推論攻撃の速度を落とします。異常検知システムはモデル挙動をリアルタイムで監視し、敵対的操作やシステム侵害の兆候となる異常パターンをフラグします。レッドチーミングは外部セキュリティ専門家に積極的な攻撃を依頼し、悪意ある攻撃者よりも先に脆弱性を特定します。継続的監視で疑わしい行動パターン・不自然なクエリ列・期待外れの出力などを常時チェックします。

最も効果的な防御戦略は、これら技術的対策に加え組織的運用を組み合わせることです。差分プライバシー技術は、モデル出力に慎重に調整されたノイズを加え、全体の有用性を保ちつつ個人データを保護します。人的監督機構により、AIが下す重要な判断を有資格者がレビューし、異常時に介入できる仕組みを作ります。こうした防御策は、全AI資産の把握・脆弱性の常時監視・詳細な監査記録の維持を含むAIセキュリティ態勢管理戦略の一環として導入するのが理想です。

世界各国の政府や規制当局もAIゲーミングへの対応を始めていますが、現行の枠組みには大きなギャップがあります。欧州AI法はリスクベースアプローチをとっていますが、主に身体的・心理的被害をもたらす操作の禁止に重点が置かれており、経済的被害への対応は十分ではありません。実際には、多くのAI操作がユーザー価値の低下という経済的被害を生み出すため、現行法で禁止されない操作的実践が多数残っています。EUデジタルサービス法はデジタルプラットフォームの行動規範や未成年保護を含みますが、主な焦点は違法コンテンツや偽情報であり、AI操作全般には及びません。そのため、多くの非プラットフォーム系デジタル企業が明確な法的制約なしに操作的AIを展開できる規制の抜け穴が生じています。効果的な規制には、説明責任の枠組みを設け、AIゲーミングの発生時に企業を責任主体とし、消費者保護機関の調査・執行権限を強化する必要があります。これら機関には、調査対象AIを実験できる計算資源の増強も不可欠です。国際協調も重要で、AIはグローバルに稼働するため、規制が弱い国へ逃避する「規制アービトラージ」も懸念されます。若年層を含めたパブリックアウェアネスや教育プログラムも、AI操作への気づきと抵抗力をつける上で効果的です。

AIシステムが高度化し普及する中、組織は自社AIの利用状況・ゲーミングや操作有無を包括的に把握する必要があります。AmICited.comのようなAIモニタリングプラットフォームは、AIシステムがどのように情報を参照・利用しているかを追跡し、出力が期待パターンから逸脱した際や操作の試みをリアルタイムで検知するインフラを提供します。これらツールはAI挙動のリアルタイム可視化を実現し、セキュリティチームが敵対的攻撃やシステム侵害の兆候を即座に捉えることを可能にします。GPT、Perplexity、Google AI Overviewなど異なるプラットフォームでのAI利用を監視することで、潜在的なゲーミングを把握し、迅速に対応できます。包括的な監視により、十分なセキュリティ管理のない「シャドーAI」も特定できます。より広範なセキュリティフレームワークと連携させることで、AI監視を孤立した機能ではなく協調的な防御戦略の一部とできます。AI投資を守り、ユーザーの信頼を維持したい組織にとって、監視ツールはもはや任意ではなく不可欠なインフラです。重大な被害が生じる前にAIゲーミングを検知・防止するために必要不可欠です。

技術的防御策だけではAIゲーミングは防げません。組織全体でセーフティファーストの文化を育み、経営層からエンジニアまで、スピードや利益よりもセキュリティと倫理を優先する姿勢が必要です。これには、開発スピードが落ちたとしても安全性研究やセキュリティテストに十分なリソースを割く経営層のコミットメントが不可欠です。スイスチーズモデルのように、複数の不完全な防御層が互いの弱点を補い合う仕組みは、AIシステムにもそのまま適用できます。単一の防御策で完璧はなくとも、重層的な防御でレジリエンスを高められます。人的監督機構はAI開発から運用まで全ライフサイクルに組み込み、重大判断を有資格者がレビューし違和感をフラグできる体制が重要です。透明性要件は設計段階から組み込むべきで、後付けせず、関係者がAIの仕組みや利用データを理解できるようにします。説明責任メカニズムでAIの挙動責任を明確化し、過失や不正には相応の結果を伴わせるべきです。レッドチーミングは外部専門家による定期的なゲーミングテストを行い、その結果を継続的改善に活かします。段階的リリースプロセスを採用し、新AIは制御環境で徹底検証してから本格運用し、各段階で安全性確認を実施しましょう。こうした文化醸成には、安全とイノベーションは対立しないという理解が不可欠です。堅牢なAIセキュリティへ投資する組織は、システムを自信を持って展開し長期的信頼を維持できるため、むしろより効果的なイノベーションが可能となるのです。

AIシステムのゲーミングとは、AIモデルを意図的に操作・悪用して、意図しない出力を生成させたり、セキュリティ対策を回避したり、機密情報を引き出したりする行為を指します。具体的には、プロンプトインジェクション、敵対的攻撃、データポイズニング、モデル抽出などの手法が含まれます。通常のシステムエラーとは異なり、ゲーミングはAIシステムの本来の動作を意図的に迂回しようとする試みです。

AIシステムへの敵対的攻撃は、重要な用途でAIが普及するにつれてますます一般的になっています。多くの研究で、ほとんどのAIシステムに悪用可能な脆弱性があることが示されています。攻撃ツールや手法が手軽に入手できるため、高度な攻撃者だけでなく一般のユーザーでもAIシステムをゲーミングすることが可能となっており、広範な懸念となっています。

単一の防御策でゲーミングを完全に防ぐことはできません。しかし、敵対的訓練、データ検証、出力の難読化、レート制限、継続的な監視など、多層的な防御によりリスクを大幅に低減できます。最も効果的な対策は、技術的手段と組織的な運用・人による監督を組み合わせることです。

通常のAIエラーは、学習データやモデル構造の限界によりシステムが誤りを犯す場合に発生します。一方、ゲーミングは意図的な操作による脆弱性の悪用です。ゲーミングは意図的かつユーザーには見えにくい形で、攻撃者がシステムやその利用者の利益を犠牲にして自己の利益を得るために設計されています。通常のエラーは意図しないシステム障害です。

消費者は、AIシステムの仕組みや自分のデータがどのように利用されているかを理解し、不自然に最適化された提案には懐疑的になることで身を守れます。透明性義務を支持し、プライバシー保護ツールを活用し、強力なAI規制の推進にも貢献できます。AI操作に関する教育も今後ますます重要です。

規制は、大規模なAIゲーミング防止に不可欠です。現行のEU AI法などは主に身体的・心理的被害の防止に重きを置いており、経済的被害には十分対応していません。効果的な規制には、説明責任の枠組みや消費者保護機関の強化、国際協調、そして操作的AI慣行を防ぎつつイノベーションも促す明確なルールが必要です。

AIモニタリングプラットフォームは、AIシステムの挙動や利用状況をリアルタイムで可視化します。敵対的攻撃の兆候となる異常や、モデル抽出を示唆する不自然なクエリパターン、期待される挙動からの逸脱を検知します。これにより、重大な被害が生じる前に迅速な対応が可能となります。

コストには、詐欺や操作による直接的な損失、セキュリティ事故による評判の失墜、法的責任や規制罰金、システム停止による業務混乱、ユーザー信頼の長期的な低下などが含まれます。消費者にとっては、サービス価値の低下やプライバシー侵害、行動の脆弱性の悪用もコストとなります。こうした経済的影響は非常に大きく、今後さらに拡大しています。

AmICitedは、AIシステムが様々なプラットフォームでどのように参照・利用されているかを監視し、リアルタイムでのゲーミングや操作の試みを検知します。AIの挙動を可視化し、脅威への先手を打ちましょう。

AIポイズニング、コンテンツクローク、リンクファームなどのブラックハットSEO戦術が、ChatGPTやPerplexityといったAI検索エンジンでブランドの可視性にどのようなダメージを与えるかを解説します。...

AIの可視性を損なうブラックハット戦術についてのコミュニティディスカッション。AIポイズニングやコンテンツ操作、ブランド保護の方法に関する実践的な知見を共有。...

競争的AIサボタージュとは何か、その仕組み、そして競合他社によるAI検索結果の汚染からブランドを守る方法を解説します。検知方法や防御戦略についてもご紹介。...