JavaScriptレンダリングはAI検索の可視性にどのように影響するか?

JavaScriptレンダリングがChatGPT、Perplexity、ClaudeなどのAI検索エンジンでのウェブサイトの可視性にどのように影響するかを学びましょう。AIクローラーがJavaScriptを苦手とする理由と、AIによる発見性を高めるためのコンテンツ最適化方法を紹介します。...

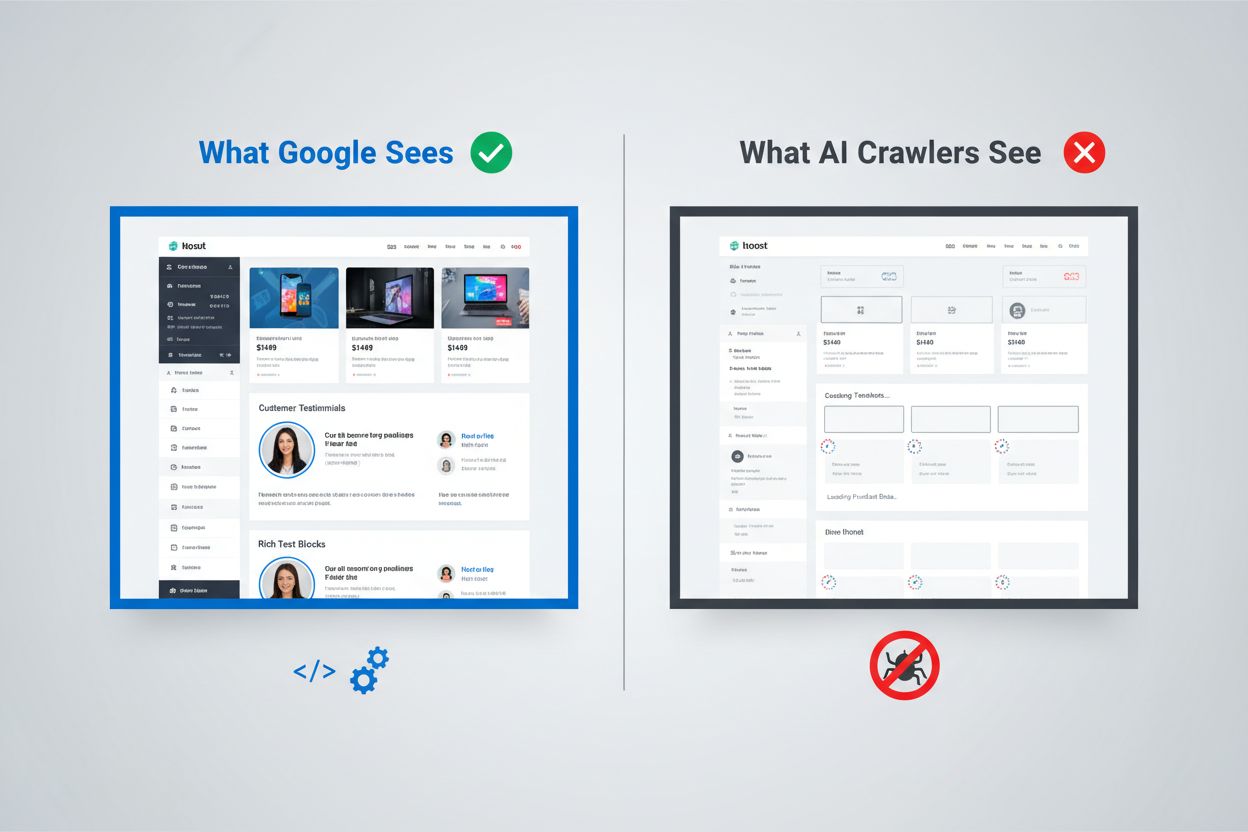

デジタルの世界は根本的に変化していますが、ほとんどの組織はまだ追いついていません。Googleの高度なレンダリングパイプラインはJavaScriptを実行し、動的に生成されたコンテンツもインデックス化できますが、ChatGPT、Perplexity、ClaudeなどのAIクローラーは全く異なる制約下で動作します。これが重大な可視性ギャップを生み出します。人間のユーザーやGoogle検索エンジンには問題なく見えるコンテンツが、トラフィックや購買意思決定にますます影響を与えるAIシステムには完全に見えない可能性があるのです。この違いを理解することは単なる技術的な好奇心ではなく、デジタルエコシステム全体で可視性を維持するために不可欠になりつつあります。リスクは大きく、解決策は多くの組織が思う以上に複雑です。

GoogleのJavaScriptレンダリングはウェブインデックスのために構築された最も高度なシステムの1つです。検索エンジン大手は2段階レンダリングシステムを採用しており、まずページの静的HTMLコンテンツをクロールし、後からWeb Rendering Service (WRS) を通じてヘッドレスChromeブラウザで再レンダリングします。この2回目のプロセスでGoogleはJavaScriptを実行し、完全なDOM(ドキュメントオブジェクトモデル)を構築し、完全にレンダリングされたページ状態を取得します。この過程にはレンダリングキャッシュも含まれ、Googleは以前にレンダリングしたページを再利用してリソースを節約します。全システムは現代的なウェブアプリケーションの複雑さに対応しつつ、数十億ページをクロールできるよう設計されています。Googleはこの能力のために膨大な計算リソースを投入し、数千台のヘッドレスChromeインスタンスでJavaScript中心のウェブを処理しています。Google検索に依存する組織にとって、クライアントサイドレンダリングのコンテンツが可視化される可能性があるのは、Googleが非常に高価なインフラを作り上げているからに他なりません。

AIクローラーは経済的・アーキテクチャ的に根本的に異なる制約下で動作しているため、JavaScriptの実行は現実的ではありません。リソース制約が主な理由です。JavaScriptを実行するには、ブラウザエンジンの起動、メモリ管理、リクエスト間の状態維持が必要で、これは大規模運用では非常に高価です。多くのAIクローラーは1〜5秒のタイムアウトウィンドウで動作しており、超高速でコンテンツを取得・処理できなければリクエストを中断します。コストと効果から見ても、AIシステムにとってJavaScript実行は得策ではありません。静的HTMLのまま大量のコンテンツを処理した方が効率的です。さらに、大規模言語モデルのトレーニングデータ処理パイプラインでは通常、CSSやJavaScriptは取り除かれ、意味のあるHTMLだけが使われます。アーキテクチャの哲学も根本的に異なります。Googleがレンダリングをインデックスシステムの中核に据えたのは検索の関連性がレンダリングされたコンテンツの理解に依存するからですが、AIシステムはレンダリングの深さよりもカバレッジの幅を優先します。これは簡単に克服できる制限ではなく、システムの経済的な構造そのものに組み込まれています。

AIクローラーがページをリクエストすると、JavaScriptは全く実行されず、生のHTMLファイルだけが返されます。これは多くの場合、人間のユーザーが目にするものとは全く異なるコンテンツしか見えないことを意味します。特に**React、Vue、Angularで構築されたシングルページアプリケーション(SPA)**は問題が顕著です。これらはごくわずかなHTMLだけを出力し、ページのコンテンツはすべてJavaScriptに依存しています。たとえばReact製のECサイトをAIクローラーがリクエストすると、<div id="root"></div> のような空のタグしか含まれておらず、商品情報や価格、説明文は一切含まれていません。つまりページの骨組みだけで中身はありません。情報量の多いサイトの場合、製品カタログ、ブログ記事、価格表、動的コンテンツセクションなどはAIクローラーからはまったく見えません。実際によくある例として、SaaSプラットフォームの機能比較テーブルが完全に見えない、ECサイトの商品レコメンドがインデックスされない、ニュースサイトの記事が空白になる、といったことが起こります。AIクローラーが受け取るHTMLはアプリケーションの殻だけで、実際のコンテンツはJavaScriptバンドル内にあり、決して実行されません。つまり、ブラウザでは完璧に表示されるページがAIシステムにはほぼ空に見えてしまう、という状況が生まれるのです。

このレンダリングギャップによるビジネスへの影響は技術的な問題にとどまらず、収益、可視性、競争力に直結します。AIクローラーがコンテンツを見られないと、次のような重要なビジネス機能が損なわれます:

結果として、コンテンツやユーザー体験に多大な投資をしている組織ほど、重要なユーザー層・システムから見えなくなるという逆転現象が起こりかねません。この問題は自然に解消されるものではなく、意識的な対策が必要です。

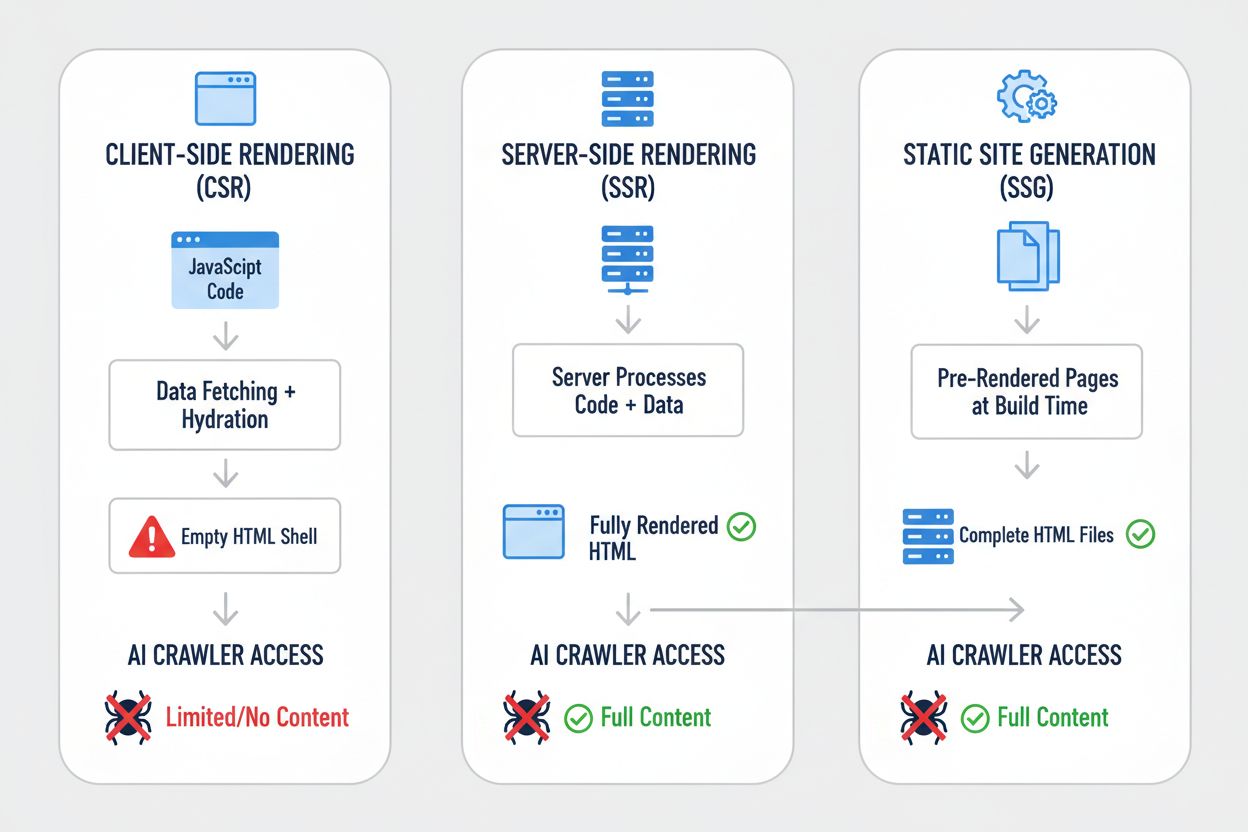

レンダリング戦略によって、AIクローラー視点で何が見えるかは劇的に変わります。どの方法を採用するかが、AIシステムに見える・インデックスされるコンテンツを根本から左右します。主な手法の比較を見てみましょう:

| 戦略 | AIに見えるもの | AI可視性への影響 | 複雑さ | 適しているケース |

|---|---|---|---|---|

| サーバーサイドレンダリング(SSR) | 全コンテンツを含む完全なHTML | フル可視性—AIに全て見える | 高 | 情報量の多いサイト、SEO重視アプリ |

| 静的サイト生成(SSG) | 事前にレンダリングされたHTMLファイル | 優れた可視性—静的HTML | 中 | ブログ、ドキュメント、マーケティングサイト |

| クライアントサイドレンダリング(CSR) | 空のHTMLシェル、最小限の内容 | 低可視性—骨組みだけ | 低 | リアルタイムダッシュボード、インタラクティブツール |

| ハイブリッド(SSR + CSR) | 初期HTML+クライアント側拡張 | 良好な可視性—コアは見える | 非常に高 | 動的機能が多い複雑なアプリ |

| プリレンダリングサービス | キャッシュ済みのレンダリングHTML | 良好(サービス品質次第) | 中 | 既存CSRサイトのクイック対応 |

| APIファースト+マークアップ | 構造化データ+HTMLコンテンツ | 適切に構築すれば優れた可視性 | 高 | 最新Webアプリ、ヘッドレスCMS |

各戦略は、開発の複雑さ・パフォーマンス・ユーザー体験・AI可視性の間で異なるトレードオフを持ちます。重要なのは、AIシステムへの可視性は静的HTMLにどれだけコンテンツが含まれるかと強く相関するという点です(それがビルド時でもリクエスト時でもキャッシュでも)。可視性をユーザー体験やパフォーマンスだけでなく、AIクローラーの観点からも評価すべきです。

サーバーサイドレンダリング(SSR)は、すべてのリクエスター(人間のブラウザもAIクローラーも)に完全なHTMLを返すため、AI可視性のゴールドスタンダードとされています。SSRではサーバーがアプリケーションコードを実行し、クライアントに送信する前に完全なHTMLレスポンスを生成します。そのためAIクローラーは初回リクエストで完全なページを取得できます。Next.js、Nuxt.js、SvelteKit などのモダンフレームワークによって、SSR導入のハードルは下がり、ハイドレーション(サーバーでレンダリングされたHTMLをクライアント側で引き継ぐ処理)も自動化されています。AI可視性以外にも、SSRはCore Web Vitals改善、First Contentful Paint短縮、回線が遅いユーザーへのパフォーマンス向上など多くの利点があります。トレードオフはサーバー負荷増加と、サーバー・クライアント間での状態管理の複雑化です。特にAI可視性が重要な情報量の多いサイトやEC、SaaSではSSR投資が最も合理的な選択肢です。SSRインフラへの投資は、検索エンジン、AIクローラー、ユーザー体験、パフォーマンスなど複数面でリターンがあります。

静的サイト生成(SSG)は、ビルド時にページをプリレンダリングし、静的HTMLファイルとして即座に配信できるようにするアプローチです。Hugo、Gatsby、Astro などのツールにより、API連携やインクリメンタルな静的再生成も可能になり、パワフルかつ柔軟になっています。SSGで生成されたページをAIクローラーがリクエストすると、すべてのコンテンツが含まれた静的HTMLを受け取るため、可視性は完璧です。パフォーマンス面でも静的ファイルは最速で、インフラ要件も最小限です。唯一の制約は、頻繁に変わらないコンテンツに向いている点で、更新時には再ビルド・再デプロイが必要になります。ブログ、ドキュメント、マーケティングページ、情報量の多いアプリには最適な選択肢です。AI可視性・パフォーマンス・インフラコストの観点から非常に魅力的ですが、リアルタイムパーソナライズや頻繁な更新が必要な場合は、インクリメンタル静的再生成など追加対応が必要です。

クライアントサイドレンダリング(CSR)はAI可視性の観点では大きな欠点があるにもかかわらず、開発体験とインタラクティブ性の高さから依然として人気があります。CSRではサーバーは最小限のHTMLしか返さず、ブラウザ側でJavaScriptによってページを構築します。つまりAIクローラーはほとんど何も見えません。React、Vue、AngularなどはCSRをデフォルトとし、多くの組織がこのパターンに依存しています。開発者にとってはリッチな体験やリアルタイム更新、スムーズなナビゲーションが魅力です。ただし、その柔軟性の代償としてAI可視性が大きく損なわれます。どうしてもCSRが必要なリアルタイムダッシュボードや協調ツール、複雑なインタラクティブアプリでは、Prerender.ioのようなプリレンダリングサービスで静的HTMLスナップショットをクローラー用に用意したり、重要コンテンツのみSSR化するハイブリッド対応が考えられます。CSRは「見えなくても仕方ない」ではなく、可視性のトレードオフを理解した上で意図的に選択することが肝要です。

実践的な対応には、現状把握から実装、継続的なモニタリングまで体系的なアプローチが必要です。まずは監査:Screaming FrogやSemrush、カスタムスクリプトなどでAIクローラーのように自サイトをクロールし、生のHTMLで何が見えているかを確認しましょう。監査結果に基づいてレンダリング改善を実施します。SSRへの移行、適切なセクションでのSSG導入、重要ページのプリレンダリングなどが該当します。徹底的なテストも重要です。curlコマンドで取得したHTMLとブラウザでの表示を比較し、AIクローラー視点での可視性を確認しましょう。継続的なモニタリングも不可欠です。大規模・複雑なサイトでは、まずは価値の高いページ(商品ページ・価格ページ・主要コンテンツ)から優先的に対応し、その後全体に拡大するのが現実的です。Lighthouse、PageSpeed Insights、カスタム監視ソリューションなどでレンダリングパフォーマンスや可視性指標を追跡しましょう。こうした投資は検索・AI可視性、サイト全体のパフォーマンスなど多方面で利益をもたらします。

レンダリング戦略のテスト・監視には、AIクローラーが実際に何を見ているかを把握できる具体的な手法が必要です。一番簡単なのはcurlで生のHTMLを取得する方法です:

curl -s https://example.com | grep -i "product\|price\|description"

これでAIクローラーが受け取る内容がそのまま確認できます。もし重要なコンテンツがここに表示されなければ、AIシステムにも見えていません。Chrome DevTools を使ったブラウザテストも有効です。Networkタブで初期HTMLレスポンスと最終的なレンダリング状態を比較しましょう。継続的な監視には、シンセティックモニタリングで定期的にAIクローラーとしてページを取得し、可視性が劣化した場合にアラートを出す仕組みも有効です。「初期HTMLで可視なコンテンツの割合」「コンテンツ可視化までの時間」などの指標を追跡しましょう。一部の組織では競合比較ダッシュボードを実装し、AIクローラーの可視性を競合と比較することで、誰がAI対応最適化しているかを把握しています。重要なのは、こうしたモニタリングを継続的かつ実行可能なものにすることです。可視性の問題は、トラフィック減少で数ヶ月後に気付くのではなく、即座に発見・修正できる体制が理想です。

AIクローラーの能力の将来は不透明ですが、現状の制限が近い将来大きく変わるとは考えにくい状況です。OpenAIはCometやAtlasブラウザのようなJavaScript実行が可能な高度なクローラーを試験していますが、これは実験段階であり、トレーニングデータ収集に大規模導入はされていません。根本的な経済性は変わらず、大規模にJavaScriptを実行するのは高コストであり、トレーニングデータパイプラインも深さより幅を重視しています。仮に将来AIクローラーがJavaScript実行能力を得ても、現時点での最適化は無駄にはなりません。サーバーサイドレンダリングされたコンテンツはユーザーにも高速でSEOにも有利だからです。今からAI可視性を最適化するのが賢明な選択です。レンダリング戦略の主要項目としてAI可視性を扱い、後回しにしないことが競争優位につながります。今対応する組織は、AIシステムがますます重要になる時代で先行者利益を得られるでしょう。

AI可視性のモニタリングと改善効果の継続的把握には、適切なツールと指標が不可欠です。AmICited.com は、あなたのコンテンツがAI生成回答でどのように表示されるかを追跡し、さまざまなAIシステムでの可視性を監視できる実用的なソリューションを提供します。どのページがAI生成コンテンツで引用・参照されているかを把握することで、レンダリング最適化の実際の効果を可視化できます。どのコンテンツがAIに見えていて、どれが見えていないかを把握できるため、最適化の成果を具体的なデータで確認できます。SSR、SSG、プリレンダリングなどを導入する際も、AmICited.comを使えばAI可視性の実際の改善度(引用・参照の増加)を測定できます。このフィードバックループは、レンダリング改善投資の正当化や追加最適化が必要なページ特定に不可欠です。AIクローラーの技術的可視性モニタリングと、AI回答でどれだけ自社コンテンツが実際に引用されているかのビジネスメトリクスを組み合わせることで、AI可視性のパフォーマンスを総合的に把握できます。

いいえ。ChatGPTやほとんどのAIクローラーはJavaScriptを実行できません。初回ページロード時の生のHTMLしか見えません。ページロード後にJavaScriptで挿入されたコンテンツはAIシステムには完全に見えないままであり、GoogleのようにヘッドレスChromeブラウザでJavaScriptをレンダリングするわけではありません。

GoogleはヘッドレスChromeブラウザを使ってJavaScriptをレンダリングしています。これは本物のブラウザの動作に近く、リソースを大量に消費しますが、Googleはこれを大規模に実行できるインフラを持っています。Googleの2段階レンダリングシステムは、最初に静的HTMLをクロールし、その後JavaScriptを実行してページを再レンダリングし、完全なDOMを取得します。

ブラウザでJavaScriptを無効にしてサイトを読み込む、またはcurlコマンドで生のHTMLを確認します。重要なコンテンツが欠落していれば、AIクローラーにも見えません。また、Screaming Frogの「テキストのみ」モードなどを使い、AIクローラーとして自分のサイトをクロールできます。

いいえ。静的サイト生成、プリレンダリングサービス、またはハイブリッド手法も使えます。最適な解決策はコンテンツの種類と更新頻度によって異なります。SSRは動的コンテンツに、SSGは安定したコンテンツに、プリレンダリングサービスは既存のCSRサイトに最適です。

GoogleはJavaScriptに対応できるため、Googleのランキングには直接影響しません。ただし、AIクローラー向けの最適化はサイト全体の品質やパフォーマンス、ユーザー体験を向上させるので、間接的にGoogleのランキングにも良い影響を与える可能性があります。

AIプラットフォームのクロール頻度によります。ChatGPT-Userはユーザーリクエスト時にオンデマンドでクロールし、GPTBotは訪問頻度が低く間隔も長いです。変更がAIの回答に反映されるまで数週間かかる場合がありますが、AmICited.comのようなツールで進捗をモニタリングできます。

プリレンダリングサービスは最小限のコード変更で簡単に導入・保守できます。一方SSRは動的コンテンツに対してより高度な制御とパフォーマンスを提供します。技術リソース、更新頻度、アプリケーションの複雑さに応じて選びましょう。

はい。robots.txtを使ってGPTBotなど特定のAIクローラーをブロックできます。ただし、その場合コンテンツはAI生成の回答に現れなくなり、AI検索ツールやアシスタントからの可視性やトラフィックが減少する可能性があります。

JavaScriptレンダリングがChatGPT、Perplexity、ClaudeなどのAI検索エンジンでのウェブサイトの可視性にどのように影響するかを学びましょう。AIクローラーがJavaScriptを苦手とする理由と、AIによる発見性を高めるためのコンテンツ最適化方法を紹介します。...

JavaScriptがAIクローラーの可視性にどのように影響するかを解説。AIボットがJavaScriptをレンダリングできない理由、隠れるコンテンツ、従来の検索とAIプラットフォーム両方に最適化する方法を学びましょう。...

動的レンダリングがAIクローラー、ChatGPT、Perplexity、Claudeの可視性にどのような影響を与えるかを解説。なぜAIシステムはJavaScriptをレンダリングできないのか、そしてAI検索に最適化する方法を紹介します。...

クッキーの同意

閲覧体験を向上させ、トラフィックを分析するためにクッキーを使用します。 See our privacy policy.