プロンプトライブラリ開発

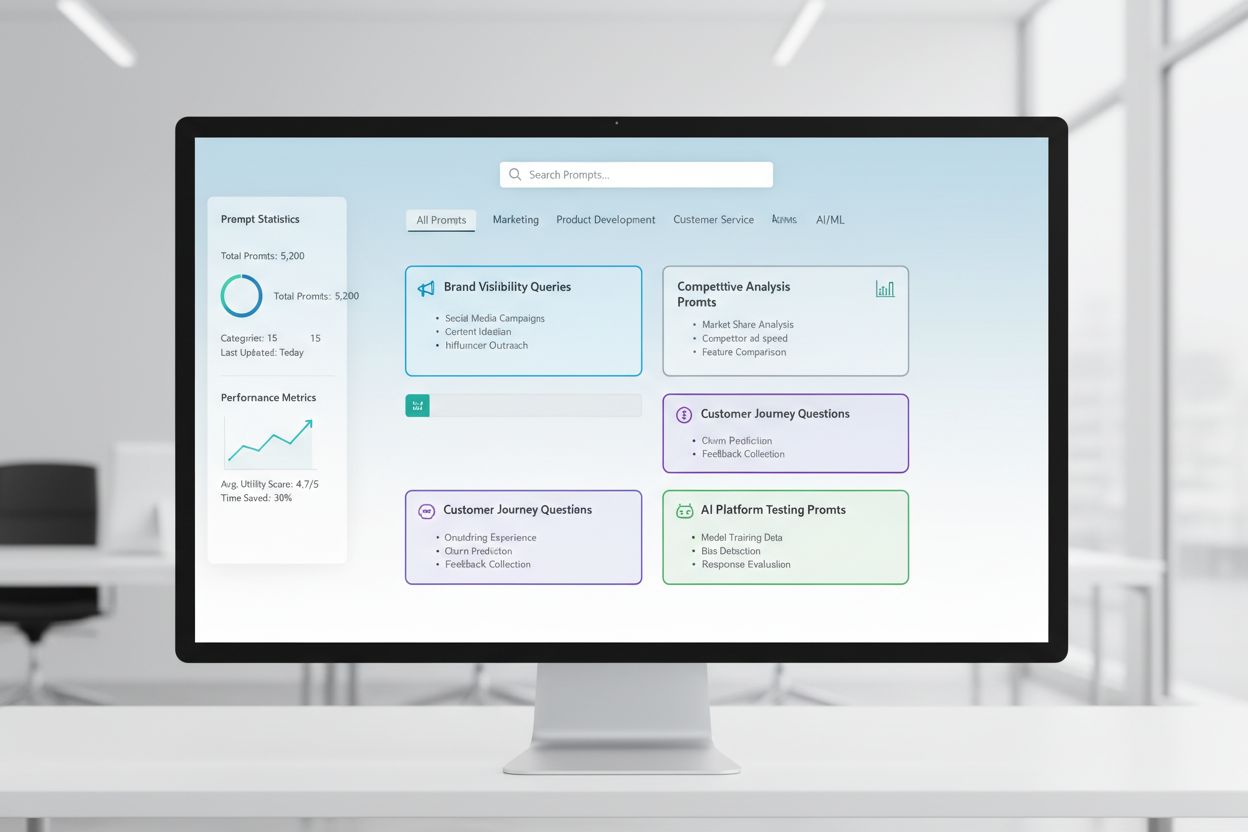

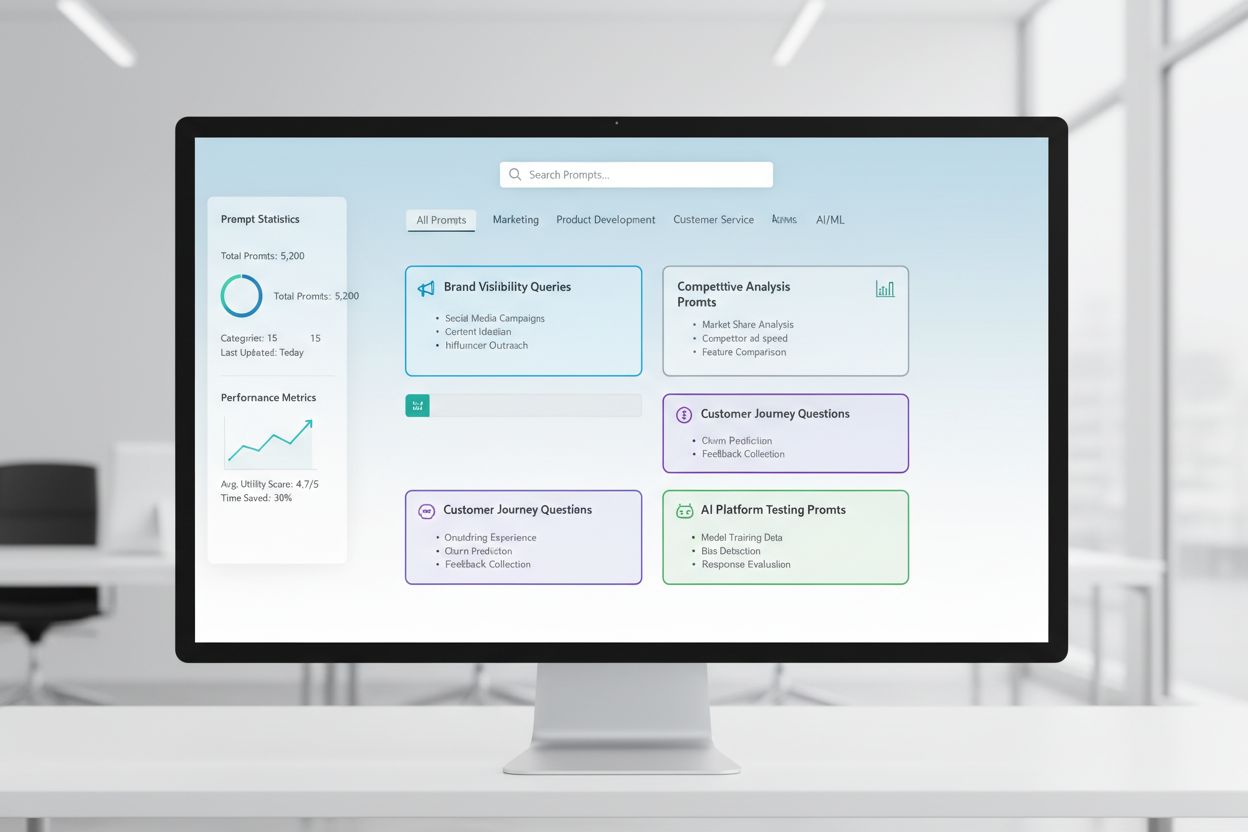

プロンプトライブラリ開発とは何か、そして組織がChatGPT、Claude、Gemini、PerplexityなどのAIプラットフォーム上でブランドの可視性をテスト・監視するためにクエリコレクションをどのように構築しているかをご紹介します。...

手動AI可視性テストのためのプロンプトライブラリの構築と活用方法を学びましょう。ChatGPT、Perplexity、Google AIなどで自社ブランドがAIシステムでどのように参照されるかをテストするDIYガイド。

プロンプトライブラリは、AIシステムが特定の質問やシナリオにどう反応するかを体系的に評価するために厳選・整理されたテストプロンプトの集まりです。手動AIテストの文脈では、これらのライブラリは基礎的なツールキットとなり、ブランド言及や引用、コンテンツの正確性、文脈理解など、異なるAIモデルがそれぞれどのように扱うかを把握するためのプロンプトのリポジトリとなります。AI可視性テストはプロンプトライブラリに大きく依存しており、これによって複数プラットフォームや時期をまたいだ一貫した再現性のあるテストが可能となり、自社コンテンツがAI生成回答にどのように(あるいはされないか)現れているかを追跡できます。場当たり的なテストではなく、よく構造化されたプロンプトライブラリによって、ブランド直接検索から間接的な文脈参照まで、ビジネスに重要なシナリオを体系的に網羅できます。この構造化されたアプローチが、手動テストを行き当たりばったりから戦略的かつデータ駆動型の手法へと進化させ、AIの挙動パターンを明らかにし、AI領域での実際の可視性を把握する助けとなります。

手動AI可視性テストとは、あらかじめ決めたプロンプトをAIシステムに直接投げかけ、その回答を詳細に分析し、自社のコンテンツやブランド、引用がどのように表示・省略されているかを把握する実践的なプロセスです。バックグラウンドで継続実行される自動モニタリングシステムとは異なり、手動テストは「何を」「いつ」「どのように」テストするかを自分でコントロールできるため、探索的なテストやイレギュラー事例の理解、意外なAI挙動の調査に非常に有用です。手動テストは意図的かつ調査的で、追加質問やバリエーションのテスト、「なぜ」その回答になるのかの背景理解が可能です。一方、自動モニタリングは長期間にわたる一貫した大規模追跡に優れています。手動テストは特にAI可視性の観点で重要であり、ブランドが誤って帰属されていないか、引用が正確だが不十分でないか、文脈が正確に理解されているかなど、自動システムでは見落としやすいニュアンスを捉えることができます。両者の比較は以下の通りです:

| 項目 | 手動テスト | 自動モニタリング |

|---|---|---|

| コスト | 初期投資低いが工数多 | 初期設定高いが継続工数低 |

| スピード | 1件ごと遅いが即時洞察 | 設定に時間要・継続追跡は高速 |

| 柔軟性 | 非常に高い・探索容易 | 固定的・事前パラメータ必須 |

| 精度 | 質的評価に強いが人為的バイアスあり | 定量指標に一貫性・バラツキ少 |

| 習熟度 | 低・誰でもすぐ可能 | 高・技術的設定が必要 |

なぜ起きているか知りたい場合は手動テスト、何が起きているか大規模に追跡したい場合は自動モニタリングが有効です。

堅牢なプロンプトライブラリは、AI可視性戦略の重要な観点ごとに構造化され、各要素がテスト目的を持ちます。AIシステムがあなたのコンテンツをどう発見・表示するか、さまざまな側面を網羅できるよう設計しましょう。必須要素は以下の通りです:

テスト戦略を構築する際は、AI可視性のコアであるブランド言及、引用の正確性、文脈理解を狙ったプロンプトが必要です。最も効果的なテストプロンプトは、実際のユーザー行動を模倣しつつ、測定したい変数を切り分けてくれます。ブランド言及のテストプロンプトでは、直接検索・間接参照・比較文脈のバリエーションを用意しましょう。引用の正確性テストは、自然に引用を誘発するプロンプトと、引用元が正しく帰属されているかを確認する派生パターンが必要です。以下は応用可能な例です:

「[あなたの業界]の最新動向は何ですか?

情報源を引用してください。」

「[自社製品]と[競合製品]を比較してください。

それぞれの主な違いや優位点は何ですか?」

「[あなたの専門分野]について説明してください。

この分野の主要な専門家や企業は誰ですか?」

これらのプロンプトは、情報提供・比較・権威ソースの特定など、可視性が最も重要となるシーンでAIの回答を自然に引き出せる設計です。具体性(広いvs狭い)、制約条件(最新情報のみ、用途指定)、引用要件(出典付き、リンク付き、著者名付き)を変えることでバリエーションを作成できます。重要なのは、単にコンテンツが現れるかだけでなく、どのように・どの文脈で現れるかまで検証できる現実的なシナリオを作ることです。

AI可視性戦略は、ChatGPT、Perplexity、Google AI Overviews、Claudeなど各AIプラットフォームが持つ根本的な違い(学習データ、検索手法、回答生成アプローチ)を考慮しなければなりません。クロスプラットフォームテストは不可欠で、あるシステムで目立つ結果が別のシステムではまったく異なることも多く、こうした特性を把握することが包括的な可視性戦略の鍵です。例えばPerplexityはリアルタイム検索で新しい情報や明示的な引用が多く、ChatGPTは学習データのカットオフに依存します。Google AI Overviewsは検索結果に統合され、会話型AIとは異なる可視性ルールやソース優先度を持ちます。実務的には、全プラットフォームで共通のコアプロンプトを定期的に実行し、コンテンツがどこで現れるか、プラットフォーム差異で可視性がどう変わるかを追跡しましょう。クロスプラットフォーム視点により、可視性課題が全体的なものか(全プラットフォーム共通)特定プラットフォーム固有かを見極め、それに応じた最適化戦略を考えることができます。

効果的なテスト記録は、生のテストデータを実用的なインテリジェンスへと変換します。どのような記録システムを使うかで、テスト活動が将来的に価値を増すか、単発的なデータで終わるかが決まります。最も実用的なのは、実施したプロンプト内容、テスト日、テストプラットフォーム、AIの全回答、コンテンツの表示状況や提示方法の分析を構造化して記録できるスプレッドシートやドキュメントシステムの利用です。結果追跡には、プロンプトカテゴリ(ブランド・競合・業界など)、テストプラットフォーム、コンテンツ出現有無、引用の正確性(該当時)、回答内ポジション(最初の言及、補足証拠など)、回答の質や関連性に関する定性メモなどのカラムを設けましょう。データだけでなく、よく使うテストシナリオ用のテンプレートも作成し、記録の一貫性を保つことでトレンドや変化を発見しやすくなります。成功例だけでなく失敗や異常も記録しましょう。これらはAIシステムの仕組みや可視性戦略の改善点を示す重要な手がかりです。このようなテスト手法の継続記録を保つことで、可視性の変遷やAIシステム変更による影響、どの最適化施策が成果を生んだかを後から検証できる歴史データが蓄積されます。

手動のAI可視性テストは、結果を誤らせたり誤った結論につながりやすい系統的なエラーに陥りやすいです。最も多いのはプロンプト表現の不統一で、毎回微妙に異なる言い回しで同一概念をテストしてしまい、AIシステムの変更による影響か、テスト方法の違いによるものか判別不能になります。これを避けるには、各プロンプトを一意に確定し、全テストで同じ文言を使用しましょう。バリエーションを試す場合は明確な命名規則で別プロンプトとして管理します。もう一つ重大なのがサンプル数・頻度不足で、一度だけテストして結論づけてしまうことですが、AIの回答はタイミングやシステム負荷などで変動します。週次・隔週・月次など定期的にテストし、各プロンプトを複数回試してパターンを把握しましょう。確証バイアスも危険で、曖昧な結果を自分の期待に合わせて解釈しがちです。複数メンバーで独立して結果を確認し、「コンテンツが現れた」とする客観基準をドキュメント化しましょう。さらに孤立したテストも避け、必ずテスト日・時刻・既知のAIシステム更新情報を記録しましょう。結果の意味を解釈するためには文脈把握が必須です。最後に手法の記録不足も再現性や説明責任を損ないます。どのようにテストし、何を測定し、どう解釈したかを詳細に記録しておきましょう。

組織規模やAI可視性戦略の高度化に伴い、個人の場当たり的なテストから構造化されたチームテスト体制に拡大し、作業負担を分散しつつ一貫性と品質を維持していく必要があります。スケーリング成功の鍵は、明確なテスト手順と役割分担の策定です。各プラットフォーム・プロンプトカテゴリ・分析責任者を割り当て、重複作業を防ぎつつ全体カバレッジを確保しましょう。共用のテストカレンダーで、誰が・いつ・何をテストしたか可視化し、無駄な重複防止と網羅性を両立します。テストチェックリストや運用手順書を作成し、どのメンバーでも一貫した実施・記録ができるようにしましょう。記録方法や回答で注目すべきポイント、異常・注目点のフラグ方法も明記します。コラボレーションツール(共有スプレッドシート、プロジェクト管理システム、専用テストプラットフォームなど)は、メンバー間の連携や記録集約に役立ちます。複数人でテスト担当をローテーションすることで、手法の属人化を防ぎ、組織全体でノウハウを共有しましょう。定期的なチームミーティングでテスト結果をレビューし、所見を共有、戦略をアップデートすることで、拡大したテスト活動も戦略的・統一的に維持できます。

高度なAI可視性戦略では、手動vs自動は対立概念ではなく相互補完的なものと認識され、それぞれ異なる局面で力を発揮します。手動テストは調査・探索ツールとして、ニュアンスや仮説検証、AIの仕組みや可視性変動の深い理解に活用。AmICitedのような自動モニタリングツールは、複数AIプラットフォームでの長期間かつ大規模な追跡、変化・トレンド・異常の検知など、手動では困難な継続監視を担います。現実的な統合戦略は、手動テストでフレームワークや「重要なもの」「異常」を発見し、自動モニタリングでそれら主要指標を常時追跡・変化時にアラートすることです。たとえば新しいプロンプトカテゴリを手動テストで検証し、有効性が確認できたら自動モニタリングに追加し、継続追跡を自動化します。AmICited等のモニタリングツールは、繰り返し・大量のテスト運用を自動化し、チームが分析・戦略・最適化といった高付加価値業務に集中できる環境を作ります。理想的なワークフローは、手動テストでプロンプトライブラリとテスト戦略を構築・検証し、特定課題を深掘り、主要可視性指標は自動モニタリングで常時追跡、異常やトレンドから次の手動テスト対象を決めるというものです。この統合アプローチで、手動テストだけの部分最適に陥らず、深い調査力と大規模な一貫性の両輪による包括的な可視性戦略を実現できます。

プロンプトライブラリは、AIシステムを複数の観点から体系的に評価するために設計された、厳選され組織化されたテストプロンプトのコレクションです。単一のプロンプトテンプレートとは異なり、ライブラリにはカテゴリ別(ブランド言及、競合比較、引用など)に整理された多数のプロンプトが含まれており、単発的なチェックではなく包括的なテストを行うことができます。プロンプトライブラリはバージョン管理・ドキュメント化され、チーム内での再利用や拡張も想定して設計されています。

頻度はリソースや業界の変化の速さによって異なります。多くの組織では、主要プロンプトの週1回または隔週でのテストで大きな変化を捉え、月1回の全プロンプトライブラリによる深堀りテストを行うと効果的です。動きの速い業界や大規模コンテンツ公開直後は週1回に増やしましょう。手動テストとAmICitedのような自動モニタリングツールを併用して、手動テスト間も継続的に追跡できるようにしましょう。

はい、コアとなるプロンプトはプラットフォームをまたいで同一に使うことで、一貫性と比較性を確保できます。ただし、各AIシステム(ChatGPT、Perplexity、Google AI Overviewsなど)でインターフェースや引用方法、回答形式が異なるため、プラットフォーム固有のバリエーションも必要になる場合があります。コアプロンプトはすべてのプラットフォームで同一にテストし、そのうえで各システムの特性や制約に合わせたバリエーションを作成してください。

あなたのコンテンツが現れるかどうか(有無)、回答内での位置(最初の言及、補足情報など)、引用の正確性(引用がある場合)、回答の質を追跡しましょう。また、テスト日、プラットフォーム、使用プロンプト、コンテンツの提示状況に関する定性的な所見も記録しましょう。これらの指標を蓄積することで、可視性の傾向や最適化努力の効果を深く理解できます。

ブランドの直接検索、競合比較、業界トピック、引用の正確性、文脈理解など可視性の主要な観点をすべてカバーできていれば網羅的と言えます。指標としては、定期的にテストする20〜30のコアプロンプトに加え、特定の調査目的の追加プロンプトを用意するのが目安です。手動テストから新たな気づきが頻繁に得られるなら、さらにプロンプトを増やすべきでしょう。結果が予測可能になってきたら、十分にカバーできている可能性が高いです。

小規模組織や初期テストでは、本ガイドのDIY手法で社内リソースから始められます。しかしテスト規模が拡大すると専任リソースが有用になります。複数製品を持つ場合や競争の激しい業界、頻繁なテストが必要な場合は、プロンプトライブラリ管理や定期テスト実施を担当する人材の配置や採用を検討しましょう。あるいは社内テストとAmICitedのような自動モニタリングツールを併用して作業を分散させるのも有効です。

手動テストは調査型・柔軟性重視で、テスト内容や深掘りの仕方を自分でコントロールできます。AmICitedのような自動モニタリングツールは、複数のAIプラットフォームで可視性を大規模・継続的に追跡し、変化を通知します。理想的には両者を組み合わせ、手動テストで戦略や疑問点を深掘りし、自動モニタリングで主要指標を常時追跡しましょう。

API(OpenAI、Anthropicなど)を使ってプロンプトをAIシステムに自動送信し、回答をプログラムで取得することができます。ただし、文脈やニュアンスの理解には人間の判断が必要なため、分析作業は多くの場合手動になります。スプレッドシートやデータベースでドキュメント化や結果管理を自動化することも可能です。繰り返し作業はAmICitedのような自動モニタリングツールに任せ、手動テストは深い分析や調査に集中するのが現実的です。

手動テストは価値がありますが、自動モニタリングにより全AIプラットフォームでの継続的な可視性を確保できます。AmICitedはAIシステムがリアルタイムであなたのブランドをどのように参照しているか追跡します。

プロンプトライブラリ開発とは何か、そして組織がChatGPT、Claude、Gemini、PerplexityなどのAIプラットフォーム上でブランドの可視性をテスト・監視するためにクエリコレクションをどのように構築しているかをご紹介します。...

ChatGPT、Perplexity、Google AI 全体でブランドを追跡するための効果的なプロンプトライブラリの作成と整理方法を学びましょう。AI可視性モニタリングのベストプラクティスを含むステップバイステップガイドです。...

AIエンジンにおいて自社ブランドのプレゼンスをプロンプトテストで検証する方法を学びましょう。ChatGPT、Perplexity、Google AIなど、さまざまなAIでの可視性を監視する手動・自動の手法を紹介します。...

クッキーの同意

閲覧体験を向上させ、トラフィックを分析するためにクッキーを使用します。 See our privacy policy.