AIボットによるウェブサイトのクロール許可方法:robots.txt&llms.txt完全ガイド

GPTBot、PerplexityBot、ClaudeBotなどのAIボットによるサイトクロールの許可方法を解説します。robots.txt・llms.txtの設定やAI向け最適化の方法もわかります。...

GPTBotやClaudeBotのようなAIクローラー向けにXMLサイトマップを最適化する方法を学びましょう。AI生成の回答やLLMのインデックス化での可視性を高めるためのサイトマップのベストプラクティスをマスターしましょう。

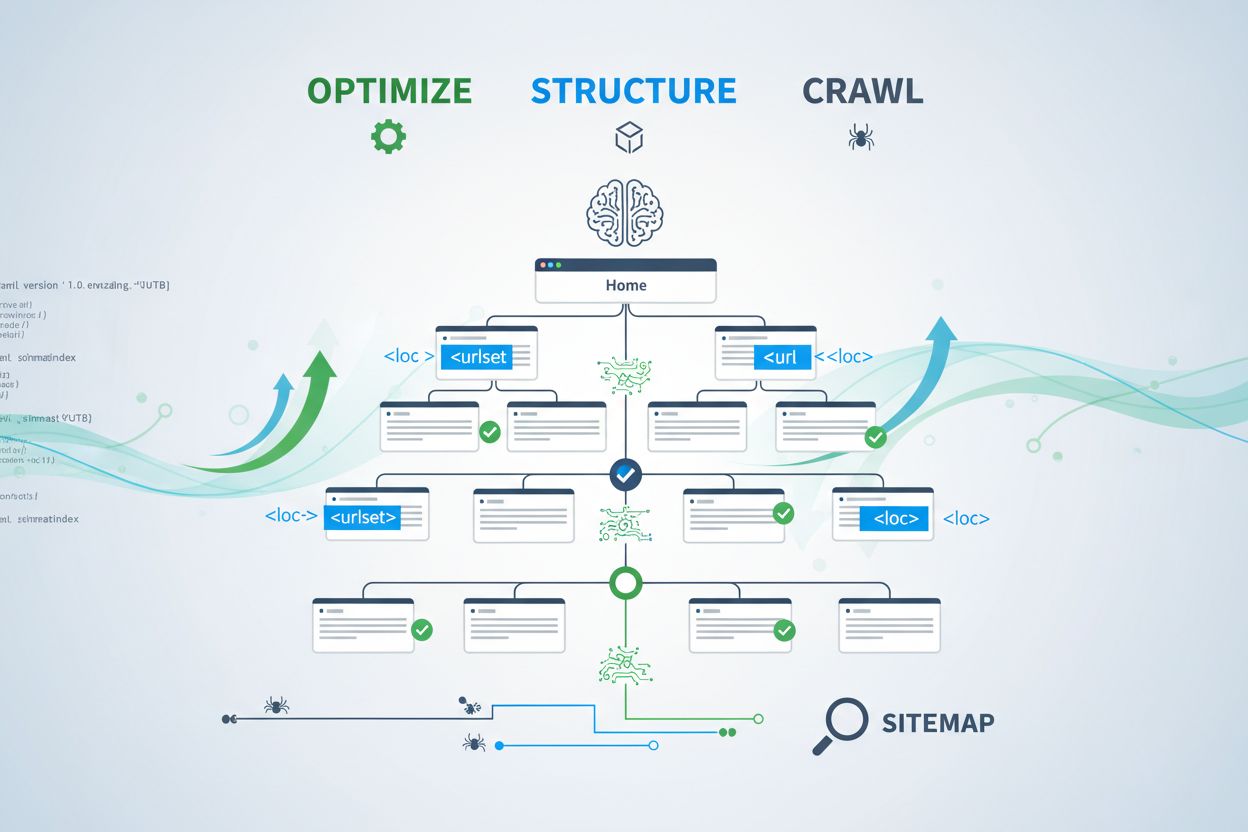

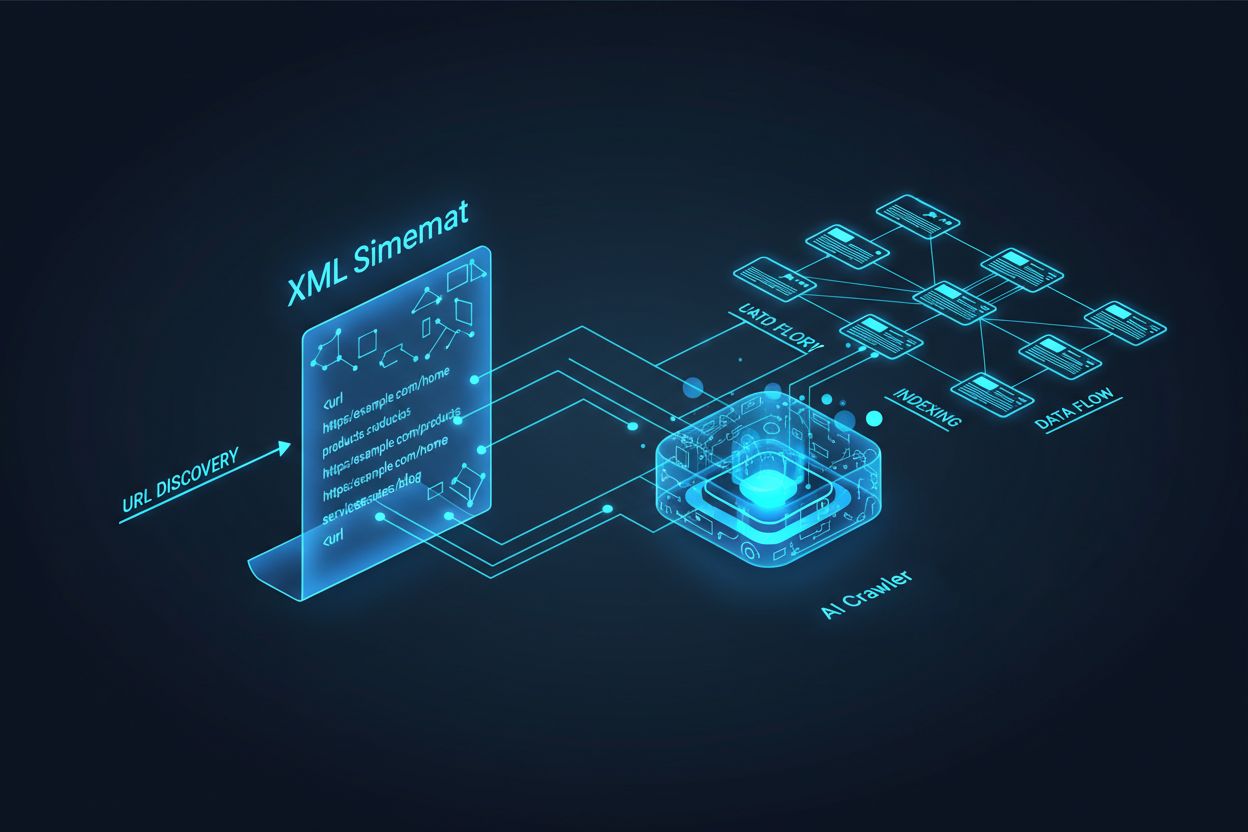

GPTBot、ClaudeBot、PerplexityBotなどのAIクローラーは、従来の検索エンジンボットとは根本的に異なる動作をします。Googlebotが検索結果ランキングのためにページをインデックス化するのに対し、AIクローラーは会話型検索やAI生成回答を支える大規模言語モデルの知識抽出のためにコンテンツを収集します。適切に最適化されたXMLサイトマップがなければ、どんなに優れたコンテンツでもこれら重要なシステムには見つけてもらえません。サイトマップは、AIシステムにあなたの最も価値あるコンテンツの場所と構造を伝える「ロードマップ」として機能するのです。

従来型検索クローラーとAIクローラーの違いを理解することは、なぜサイトマップ最適化が今まで以上に重要なのかを知る上で不可欠です。Googleのような従来型検索エンジンは特定キーワードで個別ページのランキングを重視しますが、AIクローラーは知識の獲得と意味理解を優先します。両者の主な違いは以下の通りです。

| 側面 | 従来型クローラー(Googlebot) | AIクローラー(GPTBot, ClaudeBot) |

|---|---|---|

| 主目的 | 検索結果でページをランキング | LLMの学習やリアルタイム回答のための知識抽出 |

| 重視点 | メタデータ、内部リンク、ランキングシグナル | コンテンツ構造、意味、事実の密度 |

| クロール優先度 | PageRankや鮮度に基づく | 権威性、トピック関連性、知識価値に基づく |

| 引用インパクト | ブルーリンクによるトラフィック誘導 | AI生成回答へのコンテンツ掲載可否を左右 |

| JavaScript処理 | JavaScriptの実行・レンダリング | JavaScriptは省略しがち。サーバーレンダリングHTMLを優先 |

この本質的な違いにより、「従来SEOだけ」ではもはや十分ではありません。あなたのサイトマップは従来の検索エンジンにもAIシステムにも同時に価値あるコンテンツへの道筋を示す必要があるのです。

XMLサイトマップは、あなたのウェブサイトの設計図として機能し、どのページが存在しどう体系的につながっているかをクローラーに明示します。AIシステムにとっては、サイトマップは従来検索以上に重要な役割を果たします。AIクローラーはサイトマップを使ってサイトのトピック構成を把握し、優先すべきコンテンツを識別し、どのページを深く分析するかを判断します。包括的かつ整理されたサイトマップがあれば、AIは効率的にあなたの知識資産を発見・評価できます。一方、古い・不完全なサイトマップでは、AIが重要ページを永遠に見落とす「死角」を生み出してしまうのです。つまり、サイトマップに載っていないページは、どんなに価値があってもAIに引用される可能性が著しく低くなります。

AIクローラー向けに効果的なサイトマップを作成するには、単にすべてのURLを羅列するだけでは不十分です。サイトマップにはユーザーやAIシステムに本当に価値のあるページのみを厳選して含める必要があります。主なベストプラクティスは以下の通りです。

よく整理されたサイトマップは「品質フィルター」となり、AIに「厳選された価値あるURLのみ掲載」と伝えます。この戦略的なアプローチで、AI生成回答で引用される確率を大きく高められます。

AI検索システムで最も強力なランキング要因の一つが「鮮度」です。AIクローラーが引用ソースを選ぶ際、コンテンツの新しさを重視します。XMLサイトマップのlastmodタイムスタンプこそが、AIに「いつページが更新されたか」を伝える主なシグナルです。古い・欠落したタイムスタンプでは、権威あるコンテンツでも新しい競合情報に負けてしまいます。逆に、実際の更新を反映した正確なlastmodは、「この情報は最新で信頼できる」とAIに印象付けます。価格、規制、業界動向など時事性の高い分野では特に重要です。CMSによる自動タイムスタンプ更新で、全コンテンツの変更が即座にサイトマップに反映され、AI生成回答での可視性を最大化できます。

サイトマップはクローラーを誘導し、robots.txtはクローラーのアクセス範囲を制御します。両者は連携してAIでの可視性を最大化しなければなりません。よくあるミスは「包括的なサイトマップを作ったのにrobots.txtでAIクローラーをブロック」してしまうこと。これでは矛盾が生じ、可視性が大きく低下します。robots.txtでは、GPTBot、ClaudeBot、PerplexityBotなど主要AIクローラーのアクセスを明示的に許可しましょう。一方、管理画面やログインページ、重複コンテンツなどインデックス不要なページのみをブロックするのが理想です。サイトマップとrobots.txtのルールが一致しているか—つまりサイトマップ掲載ページがrobots.txtでもアクセス許可されているか—定期的に監査してください。両ファイルのミス構成が潜在的なAI可視性ロスを生む原因となります。

AI最適化で最も効果的なのは、サイトマップと構造化データを補完的に運用する戦略です。サイトマップで「重要」と打ち出したページに、関連するスキーママークアップ(構造化データ)を実装すれば、ページの目的や価値をAIクローラーに一貫して伝えることができます。たとえばサイトマップで優先したハウツーガイドにはHowToスキーマを、商品ページにはProductスキーマ(価格・在庫・レビュー付き)を加えましょう。こうした整合性が「AIが信頼できるデータ像」を形成します。逆に、サイトマップと構造化データが矛盾・乖離していると、AIクローラーはページの本来の目的を判断できず、引用可能性が下がります。サイトマップ戦略とスキーマ実装をセットで見直すことで、AI回答への選定率を大幅に高められます。

コンテンツの種類ごとに、AI可視性を最大化するサイトマップ戦略は異なります。ブログ記事、商品ページ、サービス説明、FAQなど、それぞれ目的が違い、最適化の視点も違います。

| コンテンツタイプ | サイトマップ戦略 | 推奨スキーママークアップ | 優先付けポイント |

|---|---|---|---|

| ブログ記事・コラム | 公開日・更新日を正確に記載し掲載 | Article, NewsArticle, BlogPosting | 最新・定番記事を優先、lastmodは定期更新 |

| 商品ページ | 在庫更新も反映、専用商品サイトマップも検討 | Product, Offer, AggregateRating | 売れ筋・新商品を優先、価格更新も頻繁に |

| サービスページ | サービス更新日も記載 | Service, LocalBusiness, ProfessionalService | 主要サービスを優先、提供可否・料金も最新に |

| FAQページ | 内容の更新日を記載し掲載 | FAQPage, Question, Answer | 充実したFAQを優先、情報更新時は回答も更新 |

| 動画コンテンツ | 動画サイトマップにサムネイル・再生時間付きで掲載 | VideoObject, Video | 字幕追加、再生数・エンゲージメントも更新 |

| 画像コンテンツ | 画像サイトマップにキャプション付きで掲載 | ImageObject, Product(商品画像用) | altテキスト最適化、説明的キャプションを追加 |

このような差別化戦略により、各コンテンツタイプごとにAI発見性を最大化できます。自社のコンテンツ構成に合わせ、最適なサイトマップ戦略の設計が重要です。

2024年後半に提案されたllms.txt規格は、AIシステムによるウェブサイト構造理解を支援する実験的アプローチです。XMLサイトマップと異なり、llms.txtはMarkdown形式で、最重要ページやリソースを人間にも読みやすい目次としてリスト化します。概念的には有望ですが、現時点ではAI可視性への影響は限定的で、主要AIクローラー(GPTBotやClaudeBot)は依然としてXMLサイトマップをURL発見や鮮度シグナルの主たる手段としています。llms.txtはXMLサイトマップの「代替」ではなく「補助」として活用し、まずはXMLサイトマップのタイムスタンプ精度や戦略的コンテンツ選別の完成度向上を優先しましょう。

善意で作成されたサイトでも、AIでの可視性を密かに制限する重大なサイトマップミスが多発しています。以下を理解し、回避することがAI生成回答での存在感拡大には不可欠です。

これらのミスを修正するだけでも、AIでの可視性は即座に向上します。まずは現状のサイトマップをこのチェックリストと照合し、問題点を洗い出しましょう。

最適化されたサイトマップを維持するには、継続的な監視と検証が不可欠です。以下のツールを活用してください。Google Search Consoleはサイトマップ検証やインデックス済みURL数の確認ができます。Screaming Frog SEO Spiderは全サイトをクロールし、サイトマップとの突合や漏れ・リンク切れの発見に役立ちます。XMLサイトマップバリデータは構文チェックとプロトコル適合性の確認に便利です。大規模サイトならSemrushやAhrefsなどSEOプラットフォームのサイトマップ解析機能も有効です。監査は理想的には月1回、また大規模なコンテンツ変更や新規セクション公開時にも実施しましょう。カレンダーリマインダーを設定し、定期見直しを習慣化してください。

AIクローラーがどうサイトマップと相互作用しているか把握するには、積極的な監視と分析が必要です。サーバーログには、どのAIクローラーがどれだけ頻繁にどのページをクロールしているかの貴重なデータが残ります。ログ分析から傾向を割り出し、サイトマップ最適化に反映しましょう。AmICited.comのようなツールで、ChatGPTやClaude、Perplexity、GoogleのAI Overviewsによる引用頻度をモニタリングすれば、サイトマップの効果を直接測定できます。Google Analyticsの設定を工夫すれば、AIからのリファラルトラフィックも追跡可能です。これらデータとサイトマップ構造を突き合わせることで、AIに最も響くコンテンツタイプやトピックが明確になり、戦略の継続的改善が可能です。

基本的な最適化に加え、さらにAI可視性を高める高度な戦略も有効です。コンテンツタイプごとに専用サイトマップ(ブログ用、商品用、動画用など)を用意すれば、タイプ固有の最適化が適用できます。動的サイトマップ生成で、コンテンツ変更と同時にリアルタイム更新すれば、AIクローラーは常に最新状態を認識できます。大規模サイトでは階層型や戦略的優先順位のサイトマップが、AIクローラーのリソースを最重要コンテンツに集中させます。一部企業は「AI専用サイトマップ」を作成し、最高権威・引用価値の高いページのみを抽出してAIに強調するケースも増えています。CMSとの統合で、最適化が自動化される仕組みも推奨です。これら高度なアプローチは技術的ハードルがあるものの、複雑なコンテンツ資産を持つ大規模組織には大きな効果をもたらします。

AIクローラーの世界は急速に進化しており、新たなクローラーやllms.txtのような標準が次々登場しています。将来対応型のサイトマップ戦略には、柔軟なシステム設計と業界動向へのアンテナが不可欠です。新たなクローラー要件にも対応しやすいサイトマップ生成システムを構築しましょう。主要AI企業の発表を定期確認し、robots.txtやサイトマップ戦略も随時アップデートしてください。AI可視性とコンテンツコントロールのバランスも長期的に検討を。AIクローラーをブロックする選択肢もありますが、ブランドの可視性確保の観点ではAI引用の重要性が今後さらに高まる見通しです。自社でAIクローラー対策やコンテンツ利用方針を明確に定め、サイトマップを「進化し続ける生きたドキュメント」として運用することで、検索・発見の仕組みが変わる中でもコンテンツが常にAIに発見・引用される状態を維持できます。

新しいコンテンツを公開したり、既存ページに大きな変更を加えた際には、必ずサイトマップを更新してください。理想的には、自動生成されたサイトマップを実装し、変更が即座に反映されるようにしましょう。頻繁にコンテンツが変わるサイトは毎日、静的なサイトは月に1回程度の見直しで十分です。

GPTBotやClaudeBotなど主要なAIクローラーの多くはrobots.txtの指示に従いますが、すべてがそうするとは限りません。最善の方法は、robots.txtでAIクローラーを明示的に許可することです。サーバーログを監視して、クローラーが想定通りに動作しているか確認しましょう。

XMLサイトマップは、lastmodタイムスタンプのようなメタデータ付きで全URLを列挙する機械可読ファイルです。llms.txtは、AIシステムに人間が読める目次を提供するために設計された新しいMarkdownベースの標準です。現時点ではAIでの可視性向上にはXMLサイトマップの方が重要で、llms.txtは補助的な役割と考えてください。

サーバーログで「GPTBot」「ClaudeBot」「PerplexityBot」「Google-Extended」などのユーザーエージェントを確認してください。また、AmICited.comのようなツールを使えば、AIシステムによるあなたのコンテンツの引用頻度をモニタリングでき、それがクロールやインデックス化の指標になります。

はい。ブログ、商品、動画、画像などタイプごとにサイトマップを分けることで、タイプごとの最適化戦略を適用できます。AIクローラーにもコンテンツ構造がより明確に伝わり、大規模サイトではクロール効率も向上します。

XMLサイトマップは1ファイルあたり最大50,000 URLまでにしましょう。それ以上の大規模サイトは、サイトマップインデックスで複数のファイルに整理してください。AIクローラーは大規模サイトマップも処理できますが、論理的なセクションに分けることでクロール効率や管理性が向上します。

lastmodタイムスタンプはAIクローラーにコンテンツの新しさを伝えるシグナルです。AIシステムでは最新性が強いランキング要因なので、正確なタイムスタンプによって引用競争力が高まります。自動でタイムスタンプを更新し、コンテンツ更新時のみ新しい値にしましょう。手動で偽のタイムスタンプを設定するのは避けてください。

はい。適切に管理されていないサイトマップはAIでの可視性に大きな悪影響を与えます。リンク切れ、古いURL、不正確なタイムスタンプ、不完全なカバレッジは、AIによる引用チャンスを減らします。定期的な監査と保守がAIでの可視性維持に不可欠です。

ChatGPT、Claude、Perplexity、Google AI Overviewsによるあなたのコンテンツの引用頻度を追跡。実際のAI引用データを基にサイトマップ戦略を最適化しましょう。

GPTBot、PerplexityBot、ClaudeBotなどのAIボットによるサイトクロールの許可方法を解説します。robots.txt・llms.txtの設定やAI向け最適化の方法もわかります。...

GPTBot、ClaudeBot、PerplexityBotなどのAIクローラーをサーバーログで特定・監視する方法を解説。ユーザーエージェント文字列、IP検証、実践的な監視戦略を網羅した完全ガイド。...

セマンティックHTML、サイトアーキテクチャ、コンテンツ整理、ChatGPTやPerplexityなどのAI検索エンジン向け技術要件を含む、最適なAIクローラーインデックスのためのウェブサイト構造方法を学びましょう。...

クッキーの同意

閲覧体験を向上させ、トラフィックを分析するためにクッキーを使用します。 See our privacy policy.