AIランキングの透明性

AIランキングの透明性とは何か、なぜコンテンツ制作者やユーザーにとって重要なのか、Perplexity、Google、ChatGPTなどのAIプラットフォームがどのように情報源選択アルゴリズムを開示しているのかを学びましょう。...

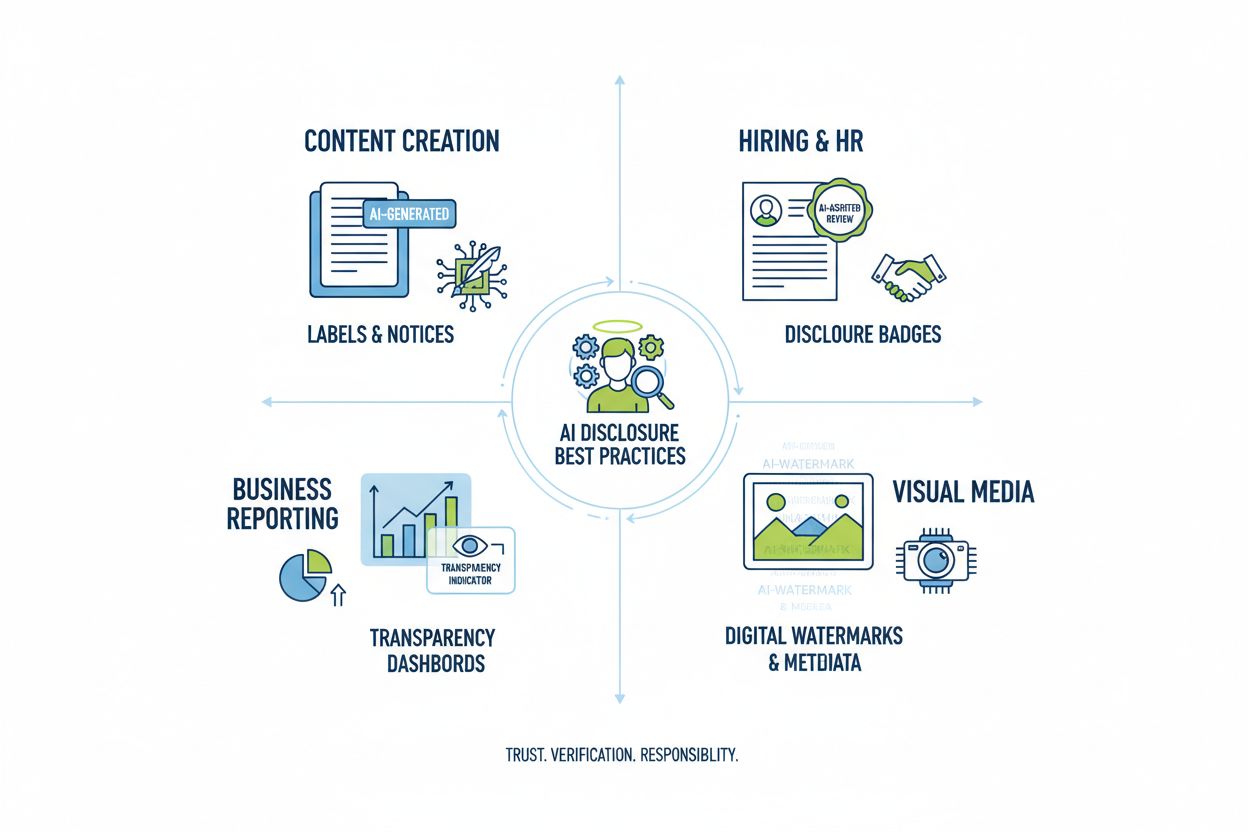

AIの透明性と開示のベストプラクティスを学びましょう。信頼構築と進化するAI規制への対応のため、行動的・言語的・技術的な開示手法を紹介します。

AIの透明性は、コンテンツ制作から採用判断、金融アドバイスに至るまでAIシステムが影響を及ぼす時代において、極めて重要な課題となっています。AI生成コンテンツがデジタルプラットフォーム上で急増するなか、組織はこれら技術の利用時期や方法を開示するよう、法的義務だけでなく、信頼と信用を維持するための必須要件として圧力を受けています。とりわけブランドやコンテンツ制作者にとっては、消費者が人間の専門知識による情報か、アルゴリズムによる生成かを知りたがる傾向が強まっているため、リスクは高まっています。透明な開示がなければ、組織は長年かけて築いた信頼を損ない、評判悪化や規制違反、オーディエンスの信頼喪失に直面する危険があります。透明性と信用性の関係は相互依存的です――AI利用を積極的に開示する組織は、誠実さとステークホルダーへの敬意を示し、AIが主流となる社会で「正直な存在」として自らを位置付けることができます。

AI生成コンテンツの増加により、深刻な信頼のパラドックスが生まれました。すなわち、オーディエンスは人間作成の本物と高度なAI生成の代替品を見分けるのに苦労しているにもかかわらず、AI利用の透明性は業界間で一貫していません。この混乱は、創作者と消費者の間の根本的な契約――オーディエンスがコンテンツの出所を知る権利――を損ないます。AI生成コンテンツが開示なく提示されれば、この暗黙の合意が破られ、「本物 vs. 偽物」という二項対立が単なる真正性問題を超え、欺瞞や操作、インフォームド・コンセントの問題にまで及びます。さらに、AI生成コンテンツの中には人間の作品と品質・スタイルで見分けがつかないものもあり、視覚やスタイルの手がかりも信頼できない場合があります。透明性が重要なのは、このパラドックスを解消し、オーディエンスが内容の信頼性を判断しやすくするためです。明確な開示を受け入れる組織は、疑念を自信に変え、隠し事がないことと誠実なコミュニケーションを示します。

AI開示を巡る規制環境は急速に変化しており、各国で組織が慎重に対応すべき要件が導入・検討されています。EU AI法は、AI生成または大量にAIで編集されたコンテンツに可視的またはメタデータレベルでの開示を義務付け、特に高リスクAIシステムや開発者に透明性報告義務を課しています。米国ではFTCがAI利用に合わせた利用規約やプライバシーポリシーの更新を怠ることが欺瞞的取引と見なされる可能性を警告し、カリフォルニア州のAIフロンティアモデル法は開示・報告義務や安全対策を強化しています。著作権や知的財産も複雑さを増す要素で、学習データに著作物が含まれるかやAIの学習経緯の開示が求められます。さらにGDPRやCCPAでは、個人データを扱うAIシステムに自動意思決定の開示や、AI処理に関する情報提供が義務付けられています。以下の表は主要地域の主な規制要件をまとめたものです:

| 管轄 | 規制 | 主な要件 | 施行時期 |

|---|---|---|---|

| 欧州連合 | EU AI法 | 高リスクAIの開示、透明性報告、AI生成コンテンツのメタデータラベリング | 段階的 (2024-2026) |

| 米国(連邦) | FTCガイドライン | プライバシーポリシー更新、AI利用開示、欺瞞的行為の回避 | 順次 |

| カリフォルニア州 | AIフロンティアモデル法 | 標準化された開示、報告義務、安全対策 | 2025年 |

| 欧州連合 | GDPR | 自動意思決定の開示、AI処理に関する情報提供 | 順次 |

| 米国(複数州) | CCPA等 | AIシステムでのデータ利用開示、オプトアウト機能 | 州ごとに異なる |

| 国際 | 著作権 | 学習データの出所開示、AI生成物の著作権対応 | 新興分野 |

複数の法域で活動する組織は、最も厳格な基準を満たす開示体制を構築すべきです。なぜなら、一つの基準を満たせば他の基準もクリアできる場合が多いためです。

行動的シグナルは、AI開示の中で最も微妙かつ強力な手法であり、提示方法・スタイル・声・創造的選択など、オーディエンスが無意識にコンテンツの真正性を評価する際の要素です。これには、文体のパターンや声の一貫性、ビジュアル構成の選択、アバターやペルソナの特徴、そして「クリエイター忠実性」(本物の人間らしさや意思決定の痕跡)が含まれます。例えば、AI生成テキストには文構造や語彙、論理展開に独特の傾向があり、AI画像には光や解剖学、背景ディテールなどに微妙な不自然さが現れることがあります。クリエイター忠実性という概念が重要です――オーディエンスは特定の制作者に期待する「らしさ」を持っており、それからの逸脱がAI利用のシグナルとなります。ただし、この手法だけでは不十分です。なぜならAIは人間を模倣する精度が急速に向上しており、オーディエンスがAI鑑定の専門家になることは困難だからです。したがって、行動的シグナルは明示的な開示方法を補完するものとして活用し、透明性の二次的な層として役立てるべきです。

言語的開示戦略は、コンテンツの出所やAI関与を明確に伝えるための、言語ベースの直接的な開示手法です。これらは開示の記録を明文化し、オーディエンスにAI利用の事実を誤解なく伝えるために必須です。主な手法は以下の通りです:

どの手法を選ぶかは文脈次第です。ラベルはSNSやビジュアル向け、ウォーターマークは動画・音声向け、バイラインは報道・創作向け、開示フィールドは長文向け、謝辞は複雑なプロジェクトで有効です。コンテンツ形式とオーディエンス期待に合わせて最適な方法を選び、分かりやすく、かつ体験を妨げない形で開示しましょう。

技術的シグナルとメタデータは、AI関与の情報を機械可読かつ標準化された形で記録し、AI生成コンテンツの自動検出・検証・追跡を可能にします。これらの手法は埋め込みデータや暗号技術を活用し、改ざん困難なコンテンツ出所や履歴を恒久的に記録します。IPTC規格はAI特有のメタデータ項目を導入し、画像ファイル内に利用AIシステム・処理内容・人的修正などの情報を構造化して埋め込めます。C2PA(Content Provenance and Authenticity連合)は、暗号署名やコンテンツ認証で改ざん不可能な証跡を作り、コンテンツの出所や加工履歴を閲覧者が遡れるようにする業界標準です。これらの技術的アプローチは、人が読む開示では不十分な点――消せない・改ざんできない・自動検出できる――を補完します。組織は重要コンテンツにC2PA認証導入、画像・メディアへのIPTCメタデータ埋め込み、デジタルソースタイプの詳細文書化などに取り組むべきです。技術的シグナルの強みは恒久性と検証性ですが、利用者やプラットフォーム側がこれを正しく理解・尊重する運用も課題となります。

AI開示を成功させるには、制作フロー全体に透明性を制度化し、開示を「後付け」ではなく、コンテンツガバナンスの基本要素として組み込むことが不可欠です。構造化コンテンツフレームワークを導入し、調査・下書き・編集・公開の各段階でAI関与を記録し、開示情報がCMS(コンテンツマネジメントシステム)内で自然に流れるようにします。自動化・ワークフロー統合も重要です:CMSにAI開示必須項目やAI利用記録の自動プロンプト、公開前の開示チェックを組み込み、開示を品質管理の一環とすることで、後回しや漏れを防げます。さらに、「どこまでが開示対象か」(例:調査AI利用も開示?校正AIは?)を明確に定義したポリシー策定と、チーム全体への教育・文書化も不可欠です。開示をコンテンツモデルやワークフローに根付かせることで、透明性を「負担」ではなく「標準業務」に変え、組織・利用者双方を守る仕組みが整います。

AIの用途によって、開示方法は文脈・オーディエンス期待・規制要件に応じて最適化が必要です。コンテンツ制作(記事・SNS・広告文)は、AI利用ラベルやバイライン修正、使用AI・人的監督の説明欄を明記。特にニュースや論説は、信頼確保のため出所説明が必須です。採用・人事では、応募者がAIによる選考やスクリーニングを受ける際、AI判断の仕組みや人による再確認の有無を詳細に開示する必要があります。レポート・分析(金融レポート、市場調査、データ分析)は、AIが関与した分析を明示し、技術的開示やメタデータで結果へのAI寄与を記録します。ビジュアルコンテンツ(画像・動画・グラフィック)は、視覚的ウォーターマークとメタデータ開示が必須で、特に報道写真や商品画像など信頼性が購買や判断に直結するケースで重要です。顧客対応(チャットボット、自動応答、カスタマーサービス)は、やり取りの冒頭でAI関与を明示し、希望すれば人間対応に切り替えられるようにしましょう。組織は自社のAI利用状況を用途別に監査し、利用の影響度・敏感さに応じて開示方法を調整する必要があります。

AI開示の未来は、業界全体の標準化と相互運用可能なフレームワークの発展にかかっています。C2PA、IPTCメタデータ規格、NISTのAIリスク管理フレームワークなどの新興規格は基盤となりますが、広範な普及には、テクノロジープラットフォーム・制作者・規制当局・業界団体の連携が不可欠です。EU AI法などの規制は、具体的な開示フォーマット・情報カテゴリを要求し、業界横断的な共通基準の採用を促しています。PRSAの倫理的AIガイドラインや各種透明性報告フレームワークも普及しつつありますが、現状では自主的運用が主流です。今後は、食品の栄養表示ラベルのように、開示標準が法的義務となり、個別対応から共通化へと進むでしょう。モニタリング・可視化プラットフォーム(AmICited.comなど)は、AI回答で自社ブランドやコンテンツがどのように参照され、適切な帰属・開示がなされているかを追跡できるため、今後さらに重要性が高まります。AIが高度かつ広範に普及する今後、AI開示をモニタリング・検証・監査する能力が、デジタル情報社会の信頼維持に不可欠となります。堅牢な開示体制とモニタリング能力に今から投資する組織こそ、変化する規制環境を乗り越え、AI時代においてもオーディエンスの信頼を勝ち取ることができるでしょう。

行動的開示は、AI利用を示すためにプレゼンテーションの選択(スタイル、声、アバターなど)を用います。言語的開示は、明示的な表現、ラベル、ウォーターマークを使います。技術的開示は、機械可読なメタデータや暗号署名を埋め込みます。それぞれ異なる対象や状況に適しているため、包括的な透明性のためには複数の方法を組み合わせて活用すべきです。

法的要件は管轄ごとに異なります。EU AI法は高リスクAIシステムでの開示を義務付けています。FTCは、AI利用が消費者の意思決定に影響する場合に開示を要求します。カリフォルニア州のAIフロンティアモデル法など州法では報告義務があります。著作権法もAI生成コンテンツの開示を求めます。組織は自国の要件に詳しい法律顧問に相談してください。

AI生成画像には、視覚的なウォーターマークとメタデータ開示の両方を含めるべきです。ウォーターマークは目立ちすぎず明確にAI生成を示す表示が望ましいです。メタデータにはIPTCデジタルソースタイプ情報やC2PA認証情報(可能な場合)を含めましょう。キャプションや開示欄には、特にニュースや商品、販促用の場合、明確にAI生成である旨を記載してください。

IPTC規格は、画像やメディアファイルでのAI利用を記録するための構造化メタデータ項目を提供します。これにより、AI生成コンテンツの自動検出と追跡が可能になります。IPTCのデジタルソースタイプには「学習済みアルゴリズムメディア」「合成コンポジット」「アルゴリズムメディア」などがあります。これらは、AI利用の恒久的かつ検証可能な記録を作成し、容易に削除・改ざんできない点で重要です。

企業はAI利用の全ケースを特定する監査を実施し、該当する規制に沿った開示ポリシーを策定、コンテンツ管理フローに開示を組み込み、チームに開示要件を教育し、定期的に遵守状況を監視しましょう。地域ごとに規制要件が大きく異なるため、当該地域のAI規制に詳しい法務専門家との相談も不可欠です。

影響には、規制違反による罰金(FTC罰則、州法違反)、評判の失墜や信頼喪失、著作権侵害や欺瞞的行為による法的責任、関係者からの訴訟などがあります。AI利用を開示しない組織は、長年築いた信頼を損なうリスクがあり、積極的な開示は長期的な信頼への投資です。

関係者ごとに必要な情報レベルは異なります。一般ユーザーにはシンプルかつ明確なAI関与の説明が必要です。規制当局には詳細な技術資料と遵守証明が求められます。ジャーナリストや制作者にはAIツールや人的監督の具体情報、顧客にはAIが体験にどう影響するかを理解できる開示が重要です。対象者に応じて開示の形式・詳細を調整しましょう。

C2PA(Content Provenance and Authenticity連合)はコンテンツ検証のための暗号認証を提供します。IPTC規格は画像へのメタデータ埋め込みを可能にします。CMSにもAI開示欄が増えています。AmICited.comのようなモニタリングプラットフォームはAI参照・可視性を追跡します。PRSAやNISTなどの業界ガイドラインもあり、これらの導入は規制強化に伴い加速中です。

GPTs、Perplexity、Google AI Overviews でAIシステムがあなたのブランドをどのように参照しているかを追跡。AI生成回答において、あなたのコンテンツが適切に帰属・可視化されることを確認しましょう。

AIランキングの透明性とは何か、なぜコンテンツ制作者やユーザーにとって重要なのか、Perplexity、Google、ChatGPTなどのAIプラットフォームがどのように情報源選択アルゴリズムを開示しているのかを学びましょう。...

AI可視性モニタリングの未来を、透明性基準から規制遵守まで探ります。ブランドがAI主導の情報環境に備え、AI可視性戦略を早期に導入することで競争優位を獲得する方法を学びましょう。...

プロアクティブな監視、早期警告システム、戦略的な対応プロトコルでAI可視性危機を防ぐ方法をご紹介。AI時代のブランドを守りましょう。...