なぜ一部のAIクローラーはrobots.txtを無視するのか:ステルスクローリングの問題

ステルスクローラーがrobots.txtの指示を回避する仕組みや、クローラーの回避技術、そして無断AIスクレイピングからコンテンツを守るための解決策を解説します。...

robots.txtを超えてWebアプリケーションファイアウォールがAIクローラーに対して高度な制御を提供する方法を学びましょう。WAFルールを実装して、無許可のAIスクレイピングからコンテンツを守り、AmICitedでAIによる引用も監視できます。

robots.txtだけでは十分な防御策にならないことが、AI主導のコンテンツ消費時代でますます明らかになっています。従来の検索エンジンは一般的にrobots.txtの指示を守りますが、現代のAIクローラーは根本的に異なるインセンティブや制御方式で動作しており、単純なテキストベースのポリシーではコンテンツ保護に不十分です。Cloudflareの分析によれば、AIクローラーは現在ウェブサイトへの全ボットトラフィックの約80%を占めており、トレーニングクローラーは膨大なコンテンツを消費しながらリファラルトラフィックはほとんど返しません—OpenAIのクローラーはクロール対リファラルの比率が400:1、Anthropicは最大38,000:1に達します。パブリッシャーやコンテンツ所有者にとって、この非対称な関係は重大なビジネス上の脅威であり、AIモデルが自社コンテンツを学習することでオーガニックトラフィックが直接減少し、知的財産の価値も低下します。

**Webアプリケーションファイアウォール(WAF)**は、ユーザーとウェブサーバーの間に設置されるリバースプロキシで、全てのHTTPリクエストをリアルタイムで検査し、設定可能なルールに基づいて不要なトラフィックをフィルタリングします。robots.txtがクローラーの自主的な遵守に依存するのに対し、WAFはインフラレベルで防御を強制するため、AIクローラーのアクセス制御においてはるかに効果的です。以下は、WAFと従来のセキュリティアプローチの違いを示した比較です:

| 機能 | robots.txt | 従来型ファイアウォール | 最新型WAF |

|---|---|---|---|

| 強制レベル | 助言/任意 | IPベースのブロック | アプリケーション認識型検査 |

| AIクローラー検出 | ユーザーエージェントのみ | ボット認識限定的 | 振る舞い分析+フィンガープリント |

| リアルタイム適応 | 静的ファイル | 手動更新必要 | 脅威インテリジェンス継続更新 |

| 粒度の制御 | パスレベルのみ | 広範なIPレンジ | リクエストレベルのポリシー |

| 機械学習 | なし | なし | 高度なボット分類 |

WAFはデバイスフィンガープリント, 振る舞い分析, 機械学習などを使い、ボットの意図や高度さをプロファイリングすることで、単純な許可/拒否ルールよりも遥かにきめ細かな制御が可能です。

AIクローラーは3つの異なるカテゴリに分類され、それぞれ異なる脅威と対策が必要です。トレーニングクローラー(GPTBot, ClaudeBot, Google-Extended など)は大規模言語モデルの開発用データセット構築のため体系的にウェブコンテンツを収集し、AIクローラートラフィック全体の約80%を占めますが、パブリッシャーへのリファラル価値はゼロです。検索・引用クローラー(OAI-SearchBot, PerplexityBot など)はAI検索体験のためのインデックス作成を行い、引用を通じて僅かなリファラルトラフィックをもたらす場合もありますが、従来検索エンジンよりはるかに少量です。ユーザー起動型フェッチャーはユーザーがAIアシスタント経由で特定コンテンツをリクエストした時のみ作動し、体系的なクロールパターンではなく一回限りのリクエストが中心のため、トラフィック量はごくわずかです。脅威の例:

最新WAFは、単なるユーザーエージェント文字列の一致を超えた高度な技術的検出手法を用いてAIクローラーを高精度で識別・分類します。振る舞い分析によってリクエストパターン(クロール速度、リクエスト順序、レスポンス処理の特徴など)を調べ、人間ユーザーとボットの違いを見抜きます。デバイスフィンガープリント技術は、HTTPヘッダー、TLS署名、ブラウザ特性を分析し、ユーザーエージェントの偽装による回避を見抜きます。機械学習モデルは数百万件のリクエストを学習し、新たなクローラーの特徴や新手のボット戦術をリアルタイムで検出、手動ルール更新不要で新規脅威に適応できます。さらに、WAFは主要AI企業が公開する公式IPレンジとリクエスト元IPを照合することで、クローラーの正当性を確認できます—OpenAIはhttps://openai.com/gptbot.json、Amazonはhttps://developer.amazon.com/amazonbot/ip-addresses/で認証IPを公開しており、正規発信元からのクローラーだけを通過させることが可能です。

効果的なAIクローラー向けWAFルールの実装には、ユーザーエージェントブロック、IP認証、振る舞いポリシーを組み合わせた多層アプローチが必要です。以下は、既知のトレーニングクローラーをブロックしつつ正当な検索機能は許可する基本的なWAFルール設定例です:

# WAFルール: AIトレーニングクローラーをブロック

Rule Name: Block-AI-Training-Crawlers

Condition 1: HTTP User-Agent matches (GPTBot|ClaudeBot|anthropic-ai|Google-Extended|Meta-ExternalAgent|Amazonbot|CCBot|Bytespider)

Action: Block (return 403 Forbidden)

# WAFルール: 検証済み検索クローラーを許可

Rule Name: Allow-Verified-Search-Crawlers

Condition 1: HTTP User-Agent matches (OAI-SearchBot|PerplexityBot)

Condition 2: Source IP in verified IP range

Action: Allow

# WAFルール: 疑わしいボットトラフィックにレートリミット

Rule Name: Rate-Limit-Suspicious-Bots

Condition 1: Request rate exceeds 100 requests/minute

Condition 2: User-Agent contains bot indicators

Condition 3: No verified IP match

Action: Challenge (CAPTCHA) or Block

ルールの優先順位を慎重に設計し、より具体的なルール(正規クローラーのIP認証など)が広範なブロックルールより先に実行されるようにしましょう。クローラーのユーザーエージェントやIPレンジは頻繁に変わるため、ルールの有効性を定期的にテスト・監視することも重要です。多くのWAFプロバイダーはAIクローラー管理専用の事前構築ルールセットを提供しており、実装の手間を減らしつつ包括的な保護を実現できます。

IP認証と許可リスト化(Allowlisting)は、正規AIクローラーと偽装リクエストを見分ける最も信頼性の高い方法です。ユーザーエージェントは簡単に偽装できますが、IPアドレスの大規模な偽装は困難です。主要AI企業はJSON形式で公式IPレンジを公開しており、手動保守なしで自動認証が可能です—OpenAIはGPTBot、OAI-SearchBot、ChatGPT-User向けに個別にIPリストを提供、AmazonもAmazonbot向けに包括的なリストを管理しています。WAFルールをこれら認証済みIPレンジからのリクエストだけ許可するよう設定すれば、ユーザーエージェント偽装による回避を効果的に防げます。.htaccessやファイアウォールルールによるサーバーレベルのブロックとIP認証+ユーザーエージェント一致を併用すれば、WAF設定に依存しない多重防御が可能です。また、一部クローラーは<meta name="robots" content="noarchive">のようなHTMLメタタグを尊重しているため、ページ単位で学習利用を防ぎたいパブリッシャーには補完的な制御手段となります。

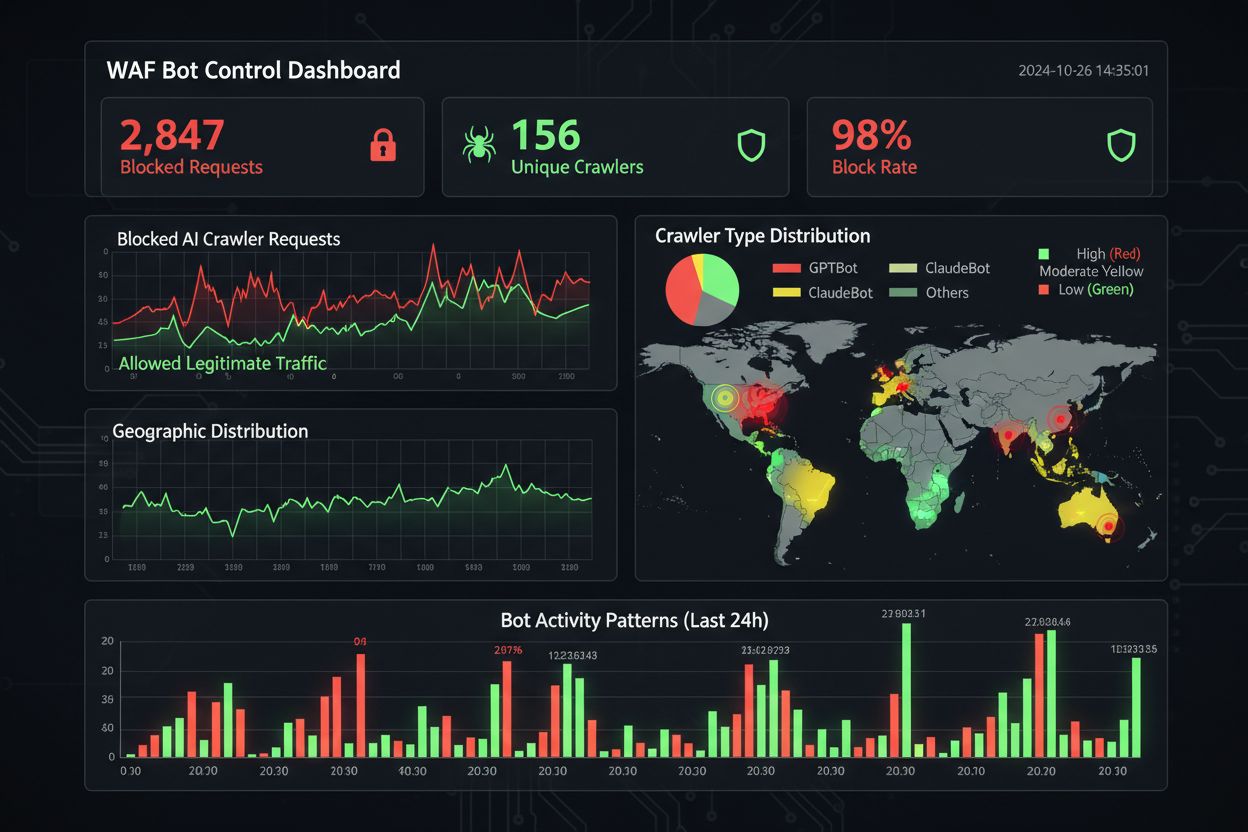

効果的な監視とコンプライアンス遵守のためには、クローラーの活動を継続的に可視化し、ブロックルールが意図通り機能しているか検証する必要があります。サーバーアクセスログを定期的に分析し、どのクローラーがアクセスしているか、ブロック済みクローラーがリクエストを送っていないかをチェックしましょう—Apacheは通常/var/log/apache2/access.log、Nginxは/var/log/nginx/access.logにあり、grepで疑わしいパターンを素早く絞り込めます。アナリティクスプラットフォームも、ボットトラフィックと人間の訪問者を区別する機能を強化しており、ブロックによるバウンス率やコンバージョン追跡、SEO指標への影響も測定できます。Cloudflare Radarなどのツールは、グローバルなAIボットトラフィック傾向の可視化や、未ブロックの新興クローラーの特定に役立ちます。コンプライアンス観点では、WAFログが監査証跡を生成し、顧客データや知的財産保護の適切なセキュリティ措置を講じている証拠となり、GDPRやCCPAなどのデータ保護規制において重要です。四半期ごとのブロックリスト見直しは不可欠で、新規AIクローラーや既存クローラーのユーザーエージェント更新に対応できます。コミュニティ主導のai.robots.txtプロジェクト(GitHub)

は新たな脅威の追跡に役立つリソースです。

コンテンツ保護とビジネス目標のバランスには、どのクローラーをブロックし、どれを許可するかを慎重に分析する必要があります。過度なブロックは新興のAI活用型流入チャネルでの可視性低下を招く可能性もあるためです。GPTBotやClaudeBotのようなトレーニングクローラーをブロックすることは知的財産保護に有効ですが、これらはリファラルトラフィックを送らないため、直接的なトラフィック影響はありません。一方、OAI-SearchBotやPerplexityBotなどの検索クローラーをブロックすると、AI検索結果での可視性が低下し、ユーザーが引用元や情報源を積極的に求める場面での流入が減る可能性があり、コンテンツ戦略やターゲットによりトレードオフが生じます。検索クローラーは許可しつつトレーニングクローラーのみブロックしたり、AI企業にコンテンツ利用料を求める従量課金モデルを導入したりするなど、代替アプローチを模索するパブリッシャーも増えています。AmICited.comのようなツールを使えば、自社コンテンツがAI生成回答で引用されているかを追跡でき、ブロック方針の判断材料になります。最適なWAF設定はビジネスモデルによって異なり、ニュースメディアはトレーニングクローラーを優先的にブロックしつつ検索クローラーは許可、SaaS企業は価格や機能分析を防ぐため全AIクローラーをブロック、などが考えられます。WAFルール導入後もトラフィックや収益指標を定期的にモニタリングし、実際のビジネス成果と保護戦略が整合しているか確認しましょう。

AIクローラー管理向けのWAFソリューション比較では、エンタープライズグレードのプラットフォームと基本的なサービスを区別するいくつかの重要な機能を評価すべきです。CloudflareのAI Crawl Controlは、WAFと統合され既知AIクローラー用の事前定義ルールや特定クローラー単位でのブロック・許可・従量課金型の設定が可能です(WAFルールは他セキュリティレイヤーより優先実行)。AWS WAF Bot Controlは、基本保護レベルとターゲット保護レベルを提供し、後者はブラウザ調査・フィンガープリント・行動ヒューリスティックで自己申告しない高度なボットも検知、オプションでトラフィック統計の機械学習分析も利用できます。Azure WAFも管理ルールセットを通じて類似の機能を持ちますが、AI向け特化度はCloudflareやAWSほど高くありません。さらに、DataDomeなどの専門ベンダーによる高度なAIクローラー特化型ボット管理ソリューションもありますが、コストは高めです。既存インフラや予算、求める高度さに応じて選択しましょう—Cloudflare利用中なら統合が容易、AWSユーザーは既存WAF内でBot Controlを活用できます。

AIクローラー管理のベストプラクティスは、単一ソリューションに依存せず複数の制御手段を組み合わせた多重防御アプローチを重視します。四半期ごとのブロックリスト見直しで新規クローラーやユーザーエージェントの更新に対応し、サーバーログ分析でブロック済みクローラーの回避状況を検証、WAF設定も定期的にテストしてルールの実行順序が適切か確認しましょう。WAF技術の未来は、リアルタイムで新手のクローラー戦術に適応するAI搭載型脅威検出や、より広範なセキュリティエコシステム統合による状況認識型保護の方向へ進化します。データスクレイピングやAI学習データの規制が厳格化するにつれ、WAFはオプションではなく必須のコンプライアンスツールとなっていくでしょう。ブラウザベースAIエージェントやヘッドレスブラウザクローラーといった新たな脅威が一般化する前に、今から包括的なAIクローラー向けWAFルールを導入してください—無防備によるトラフィック損失・分析精度低下・法的リスクのコストは、堅牢な防御基盤への投資を大きく上回ります。

robots.txtはクローラーが自発的に指示に従うことを期待するための助言ファイルですが、WAFルールはインフラレベルで強制され、クローラーの遵守有無に関係なく全てのリクエストに適用されます。WAFはリアルタイムの検出とブロックが可能ですが、robots.txtは静的で、非準拠のクローラーには簡単に回避されます。

はい、多くのAIクローラーはトレーニングデータの収集を最大化する設計のため、robots.txtの指示を無視します。大手企業による善良なクローラーは一般的にrobots.txtを守りますが、悪意あるクローラーや新興クローラーの中には守らないものもあります。これがWAFルールがより確実な保護を提供する理由です。

サーバーのアクセスログ(通常 /var/log/apache2/access.log や /var/log/nginx/access.log)でボット識別子を含むユーザーエージェント文字列を確認してください。Cloudflare RadarのようなツールはAIクローラーの世界的なトラフィックパターンの可視化を提供し、アナリティクスプラットフォームでもボットトラフィックと人間の訪問者を区別する機能が増えています。

GPTBotのようなトレーニングクローラーのブロックは、リファラルトラフィックを送らないので直接的なSEO影響はありません。ただし、OAI-SearchBotのような検索クローラーのブロックは、AI検索結果での可視性が低下する可能性があります。GoogleのAI Overviewsは標準のGooglebotルールに従うため、Google-Extendedのブロックは通常の検索インデックスに影響しません。

CloudflareのAI Crawl Control、AWS WAF Bot Control、Azure WAFはいずれも効果的なソリューションです。CloudflareはAI専用機能が充実しており、事前定義ルールや従量課金型のオプションも提供。AWSは高度な機械学習検出、Azureは管理ルールセットで堅実な制御が可能です。既存インフラや予算に応じて選択してください。

最低でも四半期ごとにWAFルールを見直し・更新してください。新たなAIクローラーが定期的に登場し、既存クローラーもユーザーエージェント文字列を更新します。GitHub上のコミュニティ管理ai.robots.txtプロジェクトで新たな脅威を監視し、サーバーログを毎月確認して新規クローラーのアクセスを特定しましょう。

はい、これは一般的な戦略です。GPTBotやClaudeBotなどのトレーニングクローラーをブロックし、OAI-SearchBotやPerplexityBotなどの検索クローラーは許可するようWAFルールを設定できます。これによりコンテンツのモデル学習利用は防ぎつつ、AI検索での可視性は維持できます。

WAFの価格はプロバイダーにより異なります。Cloudflareは月額20ドルからAI Crawl Control機能付きWAFを提供。AWS WAFはWeb ACLおよびルールごとに課金(基本的な保護で月額5〜10ドル程度)。Azure WAFはApplication Gatewayに含まれます。導入コストは、コンテンツを守り正確な分析を維持する価値に比べごく小さいものです。

AmICitedはAIクローラーの活動を追跡し、あなたのコンテンツがChatGPT、Perplexity、Google AI Overviews、その他AIプラットフォームでどのように引用されているかを監視します。AIでの存在感を可視化し、どのクローラーがあなたのコンテンツにアクセスしているかを把握しましょう。

ステルスクローラーがrobots.txtの指示を回避する仕組みや、クローラーの回避技術、そして無断AIスクレイピングからコンテンツを守るための解決策を解説します。...

AIボットによるサイトクローリングを許可するかについてのコミュニティディスカッション。robots.txtの設定やllms.txtの実装、AIクローラー管理の実体験。...

robots.txtを使って、どのAIボットがあなたのコンテンツにアクセスできるかをコントロールする方法を学びましょう。GPTBot、ClaudeBot、その他のAIクローラーをブロックするための実践的な例と設定戦略を網羅した完全ガイドです。...

クッキーの同意

閲覧体験を向上させ、トラフィックを分析するためにクッキーを使用します。 See our privacy policy.