AI検索エンジン向け重複コンテンツの対処方法

AIツール使用時の重複コンテンツ管理と防止方法を解説。カノニカルタグやリダイレクト、検出ツール、独自性維持のベストプラクティスを学び、サイト内のコンテンツをユニークに保ちましょう。...

従来のSEOにおける重複コンテンツの取り扱いはよく理解されています:カノニカル、リダイレクト、パラメータ処理など。

しかし、AIシステムは重複コンテンツをどう扱うのでしょうか?ルールが異なるように思えます。

私が気付いたこと:

疑問点:

同じ問題に直面している方、いませんか?

良い質問ですね。AIは重複コンテンツをGoogleとは非常に異なる方法で扱います。

Googleのアプローチ:

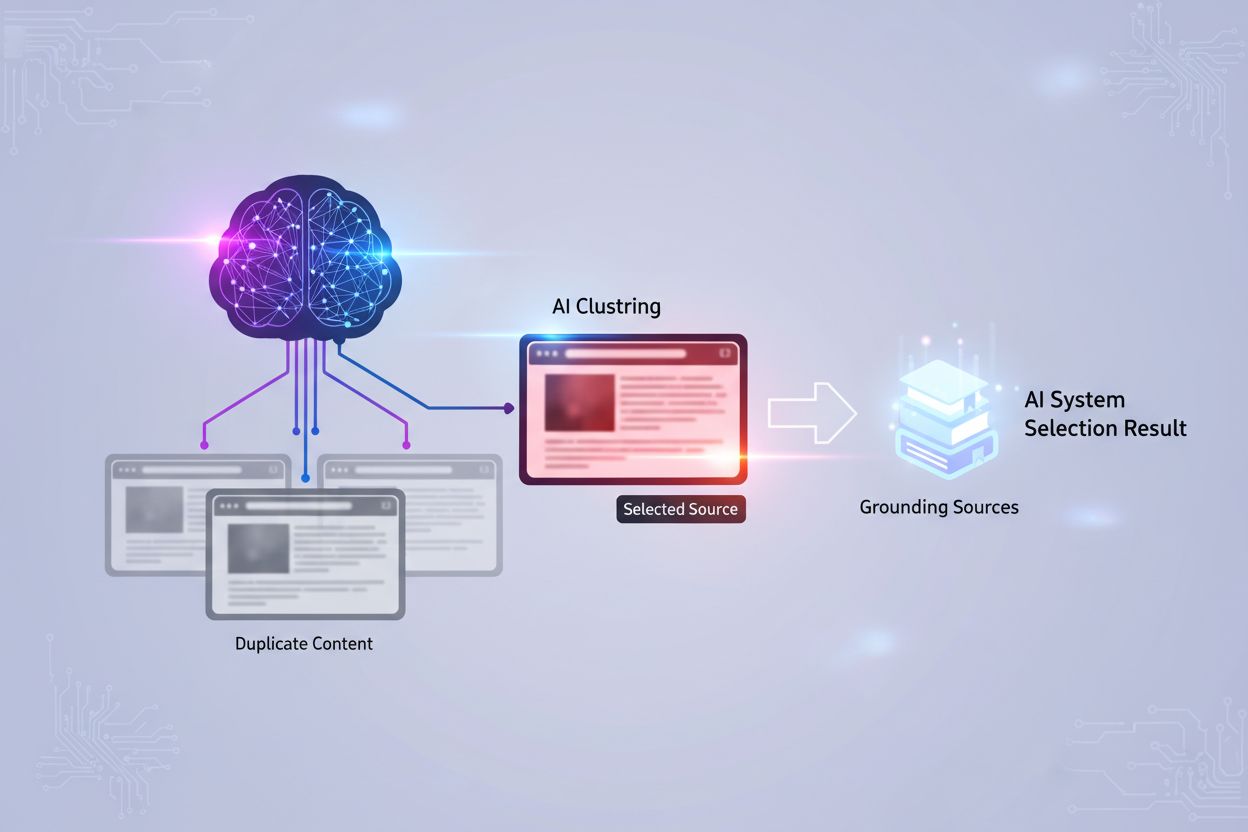

AIのアプローチ(システムにより異なる):

| AIシステム | 重複処理 |

|---|---|

| 学習型(ChatGPT) | 学習データにあったものをそのまま、複数バージョンが存在しうる |

| 検索型(Perplexity) | 現在の検索に基づいたリアルタイム重複排除 |

| ハイブリッド(Google AI) | インデックスシグナルとAIの理解のミックス |

核心的な問題:

Webデータで学習したAIモデルは、あなたのサイトとスクレイパーサイト両方からコンテンツを取り込んでいるかもしれません。どちらがオリジナルかを本質的には知りません。

AIにとって実際に重要なのは:

カノニカルタグだけではAIの帰属問題は解決しません。

AIがあなたのコンテンツをオリジナルとして認識しやすくする技術的施策:

1. 明確な著者シグナル:

- 著者名を目立つ位置に表示

- 著者のスキーママークアップ

- 著者プロフィール/バイオへのリンク

- 全コンテンツで著者の一貫性

2. 公開日の明示:

- ページ上に公開日を明記

- スキーマでDatePublished

- 必要に応じて更新日も

3. エンティティの明確化:

- 組織スキーマ

- エンティティ情報が明確なaboutページ

- Web全体で一貫したNAP

4. llms.txtの実装:

- サイトの内容をAIに明示的に伝える

- 主要なコンテンツを特定

- 所有権・帰属を明記

5. コンテンツ独自性シグナル:

- 独自メタデータ付きのオリジナル画像

- 他にない独自データポイント

- 一人称視点

重要なポイント:

カノニカルタグだけではなく、AIに「これがオリジナル!」と一貫して明確に伝えることが大切です。

実際の経験からの事例:

直面した問題:

自社の製品ドキュメントが引用されていたが、再掲載した第三者サイトに帰属されていた(許可はしている)。

分かったこと:

解決策:

オリジナルコンテンツへの明確な所有権シグナル

独自コンテンツの追加

リンク構造

結果:

2ヶ月後、AIは重複ではなくオリジナルのドキュメントを引用するようになりました。

スクレイパーサイト視点で補足:

なぜスクレイパーサイトがあなたより引用されることがあるのか:

できること:

技術対策:

帰属保護:

積極的なシグナル:

厳しい現実:

AIが一度スクレイパーの内容で学習すると、それを元に戻すことはできません。今後のAIの取得において権威性シグナルを強化していくしかありません。

エンタープライズでのAI向け重複コンテンツ対策:

主な課題:

当社のアプローチ:

| コンテンツタイプ | 戦略 |

|---|---|

| 言語バリエーション | hreflang + コンテンツ内での言語シグナル明示 |

| 地域バリエーション | 独自の地域事例、地元著者シグナル |

| パートナーコンテンツ | 明確な帰属、異なる視点の提示 |

| UGC | モデレーション+独自の編集コメント |

発見:

明確なシグナルを与えれば、AIはコンテンツの関係性を意外とよく理解します。ポイントは「関係性を明文化」すること。

例:

カノニカルタグだけでなく、

といった人間向けの明記がAIの理解にも役立ちます。

AIクローラー制御の選択肢:

現在のAIクローラーのユーザーエージェント:

| クローラー | 会社 | robots.txt制御 |

|---|---|---|

| GPTBot | OpenAI | robots.txtを尊重 |

| Google-Extended | Google AI | robots.txtを尊重 |

| Anthropic-AI | Anthropic | robots.txtを尊重 |

| CCBot | Common Crawl | robots.txtを尊重 |

| PerplexityBot | Perplexity | robots.txtを尊重 |

重複コンテンツをAIからブロックする場合:

# AIクローラーからプリント版をブロック

User-agent: GPTBot

Disallow: /print/

Disallow: /*?print=

User-agent: Google-Extended

Disallow: /print/

Disallow: /*?print=

注意点:

llms.txtアプローチ:

ブロックではなく、llms.txtでカノニカルコンテンツをAIに指示する方法も:

# llms.txt

Primary content: /docs/

Canonical documentation: https://yoursite.com/docs/

これはまだ発展途上ですが、ブロックよりもエレガントな方法です。

コンテンツ戦略の観点から重複防止:

最良の重複コンテンツ対策は「重複を作らない」こと:

例えば:

コンテンツ独自性のための戦術:

| 戦術 | 効果 |

|---|---|

| 独自データポイント | 自分のデータならコピーされない |

| 一人称体験 | あなた特有のもの |

| 専門家のコメント | 特定の人物への帰属 |

| オリジナル画像 | 所有権メタデータ付き |

| 独自フレームワーク | あなた独自の手法 |

マインドセット:

「誰にも気づかれずコピペできるコンテンツ」は差別化不足。明らかに「あなたのもの」と分かる内容を作りましょう。

このディスカッションで、AIにおける重複コンテンツの考え方が完全に変わりました。私のアクションアイテムをまとめます:

技術的実装:

著者シグナルの強化

所有権の明示

AIクローラーの選択的制御

コンテンツ独自性監査

戦略的アプローチ:

皆さん、貴重なご意見ありがとうございました。従来の重複コンテンツ対策よりもずっと奥が深いですね。

Get personalized help from our team. We'll respond within 24 hours.

あなたのコンテンツページがどのAIプラットフォームで引用されているかを監視。AIでの可視性に影響する重複コンテンツの問題を特定します。

AIツール使用時の重複コンテンツ管理と防止方法を解説。カノニカルタグやリダイレクト、検出ツール、独自性維持のベストプラクティスを学び、サイト内のコンテンツをユニークに保ちましょう。...

コンテンツの再掲載が、従来の検索よりもAI検索での重複コンテンツ問題を深刻化させる理由、その技術的対策やベストプラクティスを解説します。...

カノニカルURLがAI検索システムにおける重複コンテンツ問題をどのように防ぐかを学びましょう。AIでの可視性向上と正しいコンテンツ帰属のためのカノニカル実装のベストプラクティスもご紹介します。...

クッキーの同意

閲覧体験を向上させ、トラフィックを分析するためにクッキーを使用します。 See our privacy policy.