Perplexityが私たちのシェアを奪っている。実際に引用されるにはどうすればいい?

Perplexity AIによってウェブサイトが引用されるためのコミュニティディスカッション。コンテンツマーケターによるPerplexity最適化戦略と引用獲得の実体験。...

私はPerplexityを徹底的に使って、その仕組みをリバースエンジニアリングしようとしています。これは従来の検索ともChatGPTとも明らかに異なります。

私が観察したこと:

私のアーキテクチャ予想:

私が理解したいこと:

Perplexityのアーキテクチャについて詳しく研究した方、ぜひご意見ください。

Danielさん、あなたのアーキテクチャ予想はかなり近いです。詳細を補足します。

4段階のパイプライン:

| ステージ | 機能 | 技術 |

|---|---|---|

| クエリ処理 | 意図認識・エンティティ抽出 | NLP + トークナイズ |

| 情報取得 | 関連ドキュメントをウェブインデックスから検索 | セマンティック検索 + API |

| 回答生成 | 取得した内容から合成 | LLM(GPT-4, Claude) |

| 精緻化 | ファクトチェック、フォーマット、追加入力提案 | ポストプロセッシング |

ステージ1: クエリ処理

単なるキーワード抽出ではありません:

例: “量子コンピューティングの最新動向” →

ステージ2: 情報取得

単なるキーワード一致でなく、セマンティック検索を使います。“人工ニューラルネットワーク"のドキュメントが"ディープラーニング"検索でヒットすることも、意味が近いからです。

セマンティック検索の部分が興味深いですね。つまり、単なるキーワード一致ではなく、埋め込みで概念的に関連した内容を探しているのですか?

また、回答生成は複数ソースを同時に使うのか、それとも順番に処理していますか?

埋め込みベースの取得:

その通りです。プロセスは以下の通りです:

複数ソース同時処理:

Perplexityはソースを順番でなく並列で処理します:

取得ドキュメント(5~10ソース)

↓

関連パッセージの並列抽出

↓

関連度によるパッセージ順位付け

↓

結合した文脈+クエリ → LLM

↓

引用付きの合成回答

引用メカニズム:

LLMが各主張を生成する際、ソース帰属を維持します。そのため引用がインラインで現れ、どの発言がどのソースに支えられているかモデルが追跡しています。

矛盾解決:

ソース間で意見が異なる場合、Perplexityは多くの場合:

LLM層はさらに分析に値します。

モデル選択:

Perplexityは複数のLLMを使用:

LLMが引用付き回答を生成する仕組み:

LLMは単なるコピペではなく、以下を行います:

変換例:

ソース1:「量子コンピューターは重ね合わせ状態にあるキュービットを使う」 ソース2:「主要企業はIBM、Google、IonQ」 ソース3:「最新の成果では1000キュービット超のプロセッサ」

Perplexityの出力: 「量子コンピューターは重ね合わせ状態で動作するキュービットを活用しています[1]。業界リーダーのIBM、Google、IonQ[2]は、最近1000キュービット超のプロセッサなどの成果を上げています[3]。」

この合成は新しい文章を作りつつ、正確に引用元を維持します。

コンテンツ制作者向けに—引用されやすくするためのポイント:

ソース選択要素:

| 要素 | 重み | 最適化方法 |

|---|---|---|

| 関連性 | 非常に高い | 質問に直接回答する |

| 信頼性 | 高い | 著者情報・組織の信頼性 |

| 新しさ | 高い | 更新日・新規性を明示 |

| 明瞭さ | 高い | 構造化・抜き出しやすいフォーマット |

| ドメインオーソリティ | 中程度 | サイトの評判を構築 |

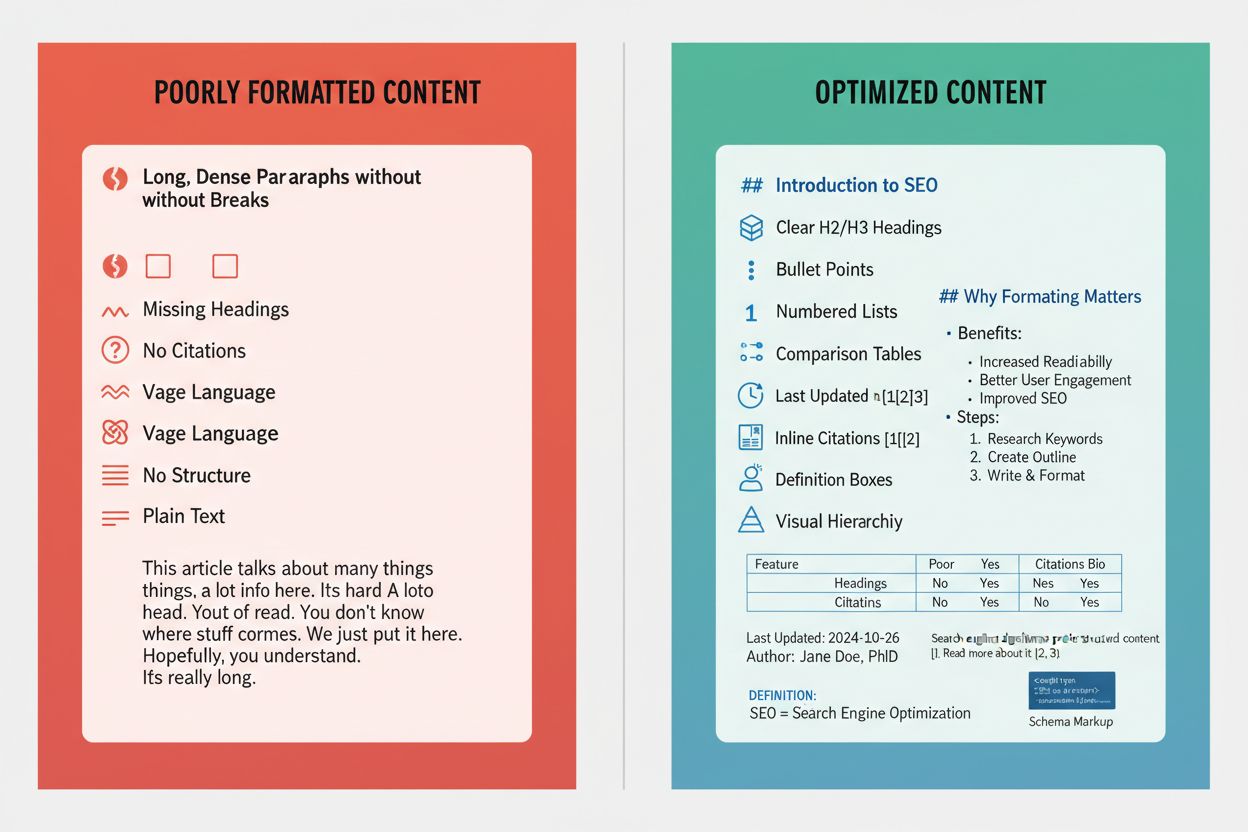

引用されやすいフォーマット:

Perplexityは以下から情報を抽出しやすいです:

引用されにくいもの:

クイック検索とプロ検索の技術的な違い:

クイック検索:

プロ検索:

分解処理:

プロ検索は複雑なクエリをサブクエリに分割:

「HIPAA準拠の医療系スタートアップ向け最適CRM」は

などに分割し、それぞれで異なるソースを取得、統合します。

Perplexityにおける幻覚(ハルシネーション)防止策:

幻覚を減らす仕組み:

制限点:

それでも以下の場合は幻覚が発生します:

ChatGPTとの比較:

| 項目 | Perplexity | ChatGPT |

|---|---|---|

| リアルタイム取得 | あり | 限定的(プラグイン) |

| 引用必須 | 常に | 任意 |

| 知識カットオフ | なし(ライブ) | トレーニング時点 |

| 幻覚リスク | 低い | 高い |

引用必須メカニズムがPerplexity最大の幻覚対策です。

コンテキストメモリシステムについて:

セッション内では:

Perplexityは会話履歴を記憶します:

例: Q1:「量子コンピューティングの最新動向は?」 Q2:「これを従来型と比較すると?」

Q2の「これ」がQ1の量子コンピューティングを指すと理解します。

アテンションメカニズム:

どの過去文脈が新しいクエリに関連するかはアテンション重みで判断。すべてが引き継がれるわけでなく、文脈的に重要な部分のみ。

制限:

記憶はセッション単位のみ。会話を閉じればコンテキストは失われます。セッションをまたぐパーソナライズはありません。

これは技術的というよりプライバシー上の選択です。

Perplexityのアーキテクチャを理解する上で「フォーカスモード」は過小評価されています:

利用可能なフォーカス:

| フォーカス | ソースプール | 最適用途 |

|---|---|---|

| すべて | 全ウェブ | 一般的な質問 |

| アカデミック | 論文 | 科学的質問 |

| Redditのみ | コミュニティ意見 | |

| YouTube | 動画コンテンツ | ハウツー・チュートリアル |

| ニュース | ニュースサイト | 時事 |

| ライティング | (なし) | 取得せず生成のみ |

ここから分かること:

フォーカスモードで、Perplexityは取得ソースを特定プールに限定できる=

最適化のコツ:

学術引用を狙うなら論文DBにインデックスされていること。 一般引用ならウェブで発見可能なコンテンツを重視。

このスレッドで理解の隙間が埋まりました。私の最新アーキテクチャ図はこちらです:

Perplexity ライブ検索パイプライン:

ユーザークエリ

↓

ステージ1: クエリ処理

├── NLPトークナイズ

├── 意図分類

├── エンティティ抽出

├── クエリ再構成(複数サブクエリ)

↓

ステージ2: 情報取得

├── セマンティック検索(埋め込みベース)

├── ウェブインデックスAPIコール

├── ソースフィルタリング(フォーカスモード)

├── パッセージ抽出

├── 関連度ランキング

↓

ステージ3: 回答生成

├── コンテキストウィンドウ構築

├── LLM合成(GPT-4/Claude)

├── インライン引用トラッキング

├── 矛盾解決

↓

ステージ4: 精緻化

├── ソースを元にファクトチェック

├── 一貫性評価

├── フォローアップ提案生成

├── 引用フォーマット

↓

最終出力(回答+引用+提案)

主なインサイト:

コンテンツ最適化のために:

Perplexityで引用されるには

皆さん、技術的な深堀りありがとうございました。

Get personalized help from our team. We'll respond within 24 hours.

Perplexityがライブ検索回答であなたのドメインを引用した際にモニタリング。プラットフォームがあなたのコンテンツをどのように発見し利用しているか理解しましょう。

Perplexity AIによってウェブサイトが引用されるためのコミュニティディスカッション。コンテンツマーケターによるPerplexity最適化戦略と引用獲得の実体験。...

Perplexityのライブサーチ技術がどのようにリアルタイムでウェブから情報を取得し、出典付きの回答を生成するかを理解しましょう。Perplexityの検索機能の技術的プロセスを学べます。...

Perplexityの引用で最大限に取り上げてもらうためのコンテンツフォーマット方法を学びましょう。引用されやすいコンテンツ、スキーママークアップ、引用戦略でAI検索を制覇しましょう。...

クッキーの同意

閲覧体験を向上させ、トラフィックを分析するためにクッキーを使用します。 See our privacy policy.