AI検索にプリレンダリングは必要?ReactサイトがAIに全く認識されない理由

AI検索の可視性向上のためのプリレンダリングについてのコミュニティディスカッション。開発者たちがJavaScriptフレームワークやAIクローラーによるアクセス経験を共有します。...

ChatGPT、Perplexity、ClaudeなどのAI検索エンジン向けにSPAを最適化する方法をご紹介。サーバーサイドレンダリング、プリレンダリング、構造化データ、URL最適化などの技術的戦略を通じて、AI生成回答での可視性を向上させましょう。

シングルページアプリケーション(SPA)をAI検索向けに最適化するには、サーバーサイドレンダリングやプリレンダリングを実装し、クリーンなHTML構造を確保し、構造化データマークアップを使用し、ハッシュフラグメントのないSEOフレンドリーなURLを作成し、robots.txtファイルでAIクローラーを許可してください。ChatGPT、Perplexity、ClaudeなどのAIシステムはJavaScriptのレンダリングが苦手なため、静的HTML版を通じてコンテンツをアクセス可能にすることが、AI生成回答での可視性向上に不可欠です。

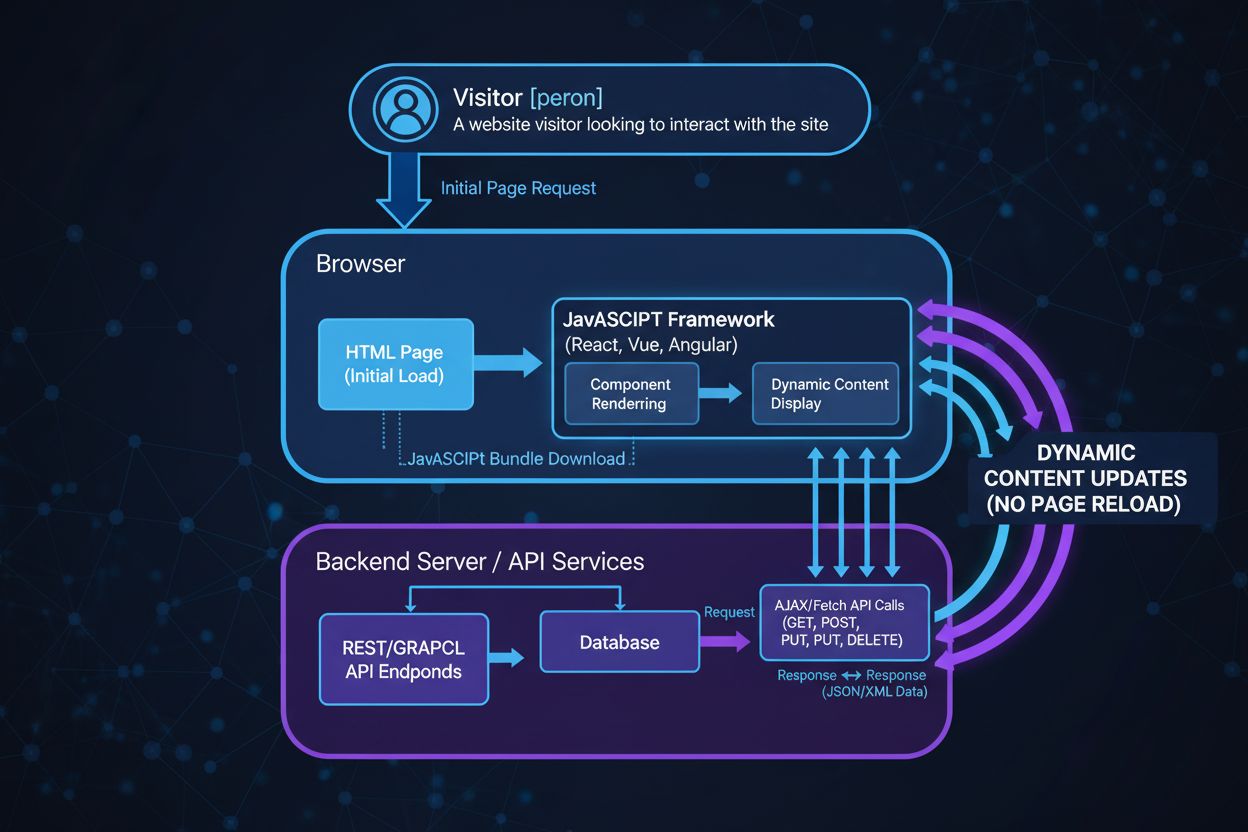

**シングルページアプリケーション(SPA)**は、ReactやVue.js、Angularなどのフレームワークによって、ページの再読み込みを伴わない高速でインタラクティブなユーザー体験を実現しました。しかし、このユーザーにとって魅力的なアーキテクチャは、ChatGPT、Perplexity、ClaudeなどのAI検索エンジンや大型言語モデルにとって大きな課題となります。従来の検索エンジンはJavaScriptのレンダリング機能が進化していますが、多くのAIクローラーはJavaScriptを実行・解釈できないため、SPAの初期HTMLシェルしか認識できず、動的にロードされるコンテンツがまったく見えません。

根本的な問題は、SPAがサーバーからプリレンダリングされたHTMLを返すのではなく、クライアント(ユーザーのブラウザ)側でコンテンツをレンダリングする点にあります。AIクローラーがSPAを訪問すると、ほぼHTMLとJavaScriptの命令のみが返されるため、AIシステムはこれを処理できず、実際のコンテンツを認識できません。つまり、AI検索結果に引用される機会を大きく失い、価値あるコンテンツがAIから完全に隠された状態になるのです。

**サーバーサイドレンダリング(SSR)**は、SPAのコンテンツをAIクローラーに認識させる最も確実な方法です。SSRでは、アプリケーションの完全なHTMLがサーバー上でレンダリングされ、クライアントに送信されます。つまり、AIクローラーがページをリクエストすると、JavaScript実行後の人間のユーザーと同じく、すべてのコンテンツが含まれたHTMLを即座に取得できます。Next.js(React用)、Nuxt.js(Vue用)、Remixなどのフレームワークには、SSR機能が組み込まれており、導入も容易です。

SSRは、サーバー上でJavaScriptフレームワークを仮想DOMに対して実行し、その結果をHTML文字列に変換し、クライアントに送る前にページに注入します。ユーザーのブラウザに届くと、SPAのJavaScriptが実行され、インタラクティブな体験が提供されますが、AIクローラーはJavaScript不要の静的HTMLを取得できるので、ChatGPTのGPTBot、PerplexityのPerplexityBot、ClaudeのClaudeBotなどもすぐにコンテンツを認識できます。

SSRの主なメリットは、すべてのクローラーへのコンテンツ可視性の保証、ユーザーの初回表示速度の向上、すべての検索システムにおける一貫したインデックス化などです。ただし、SSRは実装の複雑化や、サーバー・クライアント両対応のコード設計、インフラコスト増加などの課題も伴います。それでも、AI検索最適化には最も安定した推奨策です。

SSRの全面導入が難しい場合、動的レンダリングやプリレンダリングも有効な代替策です。動的レンダリングは、ユーザーエージェントに応じて異なるバージョンを返し、AIクローラーや検索エンジンにはプリレンダ済みの静的HTMLを、一般ユーザーにはインタラクティブなSPAを提供します。このハイブリッド方式なら、動的アプリのままクローラー向けに完全なコンテンツを返せます。

プリレンダリングは、ビルド時やオンデマンドでSPAページの静的HTMLスナップショットを生成し、クローラー用にキャッシュします。Prerender.ioのようなサービスを使えば、AIクローラーからのリクエストを検知してプリレンダ済みのHTMLを自動的に返せます。この方法はアプリ本体に手を加えず、ミドルウェアとして導入できるため、実装負担も軽減されます。AIクローラーは、キャッシュされたHTMLを即座に認識・解析できるため、コンテンツのAI可視性が大幅に向上します。

プリレンダリングの効果は高く、導入前は25%未満だったインデックス率が80%前後に上昇した事例や、クロール予算の増加、AIシステムでの引用率向上が報告されています。GPTBot、PerplexityBot、ClaudeBotなどのAIクローラーでも、コンテンツが引用されるようになります。ただし、頻繁に更新されるページでは、プリレンダの再生成が必要なため、負荷や鮮度維持に注意が必要です。

| レンダリング方式 | 最適な用途 | 複雑さ | コスト | AIクローラー対応 |

|---|---|---|---|---|

| サーバーサイドレンダリング(SSR) | 動的・頻繁な更新コンテンツ | 高 | 中〜高 | 優秀 |

| プリレンダリング | 静的または更新頻度が低いページ | 低 | 低〜中 | 優秀 |

| 動的レンダリング | 混在コンテンツ | 中 | 中 | 優秀 |

| クライアントサイドのみ | 単純な静的サイト | 低 | 低 | 不十分 |

レンダリング戦略以外にも、AI検索最適化のために不可欠なテクニカルSEO施策があります。まずクリーンでセマンティックなHTML構造が基本です。正しい見出し階層(H1, H2, H3)、<article>, <section>, <nav>などのセマンティックタグを使い、過剰な入れ子や無意味なdivを避けましょう。AIクローラーはHTML構造からコンテンツ階層や重要度を解析するため、整理されたマークアップは解釈精度の向上に直結します。

URL構造も、従来のSEOとAI検索の両面で重要です。**ハッシュフラグメント(#)**付きURLは、AIクローラーからは1ページとみなされ区別されません。History APIやpushState()を使い、/products/red-shoesのようなクリーンで意味のあるURLを生成し、各SPAビューに固有で説明的なURLを割り当てましょう。これによりAIクローラーによるサイト構造の理解と、ユーザー体験・シェアの利便性が向上します。

構造化データマークアップ(Schema.org)はAIシステムにとってますます重要です。JSON-LD形式で商品、記事、FAQ、ハウツー、レビューなどのコンテンツタイプを明示しましょう。AIクローラーは構造化データから主要情報を迅速に抽出・理解します。例えば、適切なSchema.orgマークアップを付与した商品ページは、AI回答で正確に引用されやすくなります。

内部リンク構造もSPAでは特に重要です。JavaScriptのonclickイベントではなく、必ず<a>タグとhref属性を使いナビゲーションを実装しましょう。AIクローラーはリンクをたどってページを発見しますが、JSベースのナビゲーションでは発見できません。重要ページには高権威セクションから多く内部リンクを集め、ユーザー・クローラー双方に明確な導線を作りましょう。

SPAではメタタグの動的更新が欠かせません。アプリ内の各ビューごとにユニークでキーワードを含むタイトルタグやメタディスクリプションをJavaScriptで更新し、AIクローラーが各URLへアクセスした際に適切なメタ情報を取得できるようにしましょう。AIシステムはメタ情報をコンテキストや関連性の判断に活用します。

Open GraphタグやTwitter CardメタデータもAIシステムにとって重要性が増しています。og:title、og:description、og:image、og:urlなどを全ページに組み込み、シェア時やAIによる認識時に正確な文脈が伝わるようにしましょう。

カノニカルタグはSPAでの重複コンテンツ対策に有効です。異なるURLパターンで同様の内容が生成される場合は、優先バージョンをカノニカルで指定し、AIクローラーがどれを引用すべきか判断しやすくします。

Google Search Consoleに適切なXMLサイトマップを提出し、AIクローラーからもアクセス可能にしましょう。SPA内の重要なすべてのURLと最終更新日を記載し、クローラーによる効率的なコンテンツ発見とサイト構造の理解をサポートします。大規模SPAでは、しっかり構造化したサイトマップがクロール・インデックス化の要です。

サイトマップにはpriorityやchangefreq属性も付与し、更新頻度の高いページにはchangefreqを高く、重要ページにはpriorityを高く設定しましょう。クロール予算の配分が最適化され、重要・頻繁に更新されるコンテンツが優先的にクロールされます。

自サイトにどのAIクローラーが来訪し、どのコンテンツを取得しているかを把握することも最適化に不可欠です。サーバーログでGPTBot(OpenAI)、PerplexityBot(Perplexity)、ClaudeBot(Anthropic)などのユーザーエージェントを監視しましょう。Google Search Consoleの情報も参考になり、AIクローラーにも類似パターンが見られます。

クロール予算効率として、クロールされたページ数とインデックス化されたページ数の比率(80〜90%が理想)を追跡しましょう。この比率が低い場合は、コンテンツの質やアクセシビリティの問題が疑われます。定期的なサイト監査で、AIクローラーが人間ユーザーと同じコンテンツへアクセスできているか確認しましょう。

テクニカルな最適化だけでなく、コンテンツ戦略もAI検索での可視性に大きく影響します。AIシステムは包括的で構造化されたコンテンツを好み、ユーザーの質問に直接答える内容を優先して引用します。明確な見出し、箇条書き、簡潔な段落で情報を整理し、AIクローラーが抜き出しやすい構成を心がけましょう。

独自性と権威性のある情報を盛り込みましょう。オリジナルの調査データ、専門的な見解、独自の視点は、AI生成回答で引用されやすくなります。競合と差別化した価値あるコンテンツを意識してください。

会話調や質問形式の構成も効果的です。AIシステムは自然言語パターンを学習しているため、会話トーンやよくある質問形式で書かれたコンテンツはAI回答に選ばれやすくなります。FAQやハウツー、定義ページを積極的に作成しましょう。

AI検索での可視性は、AI生成回答内でのブランドやドメインの言及を追跡することで測定できます。AIクローラーの活動分析ツールを使えば、どのページが多く参照・引用されているかを把握し、AIシステムに評価されるコンテンツ特性を横展開できます。

AI経由のトラフィックは、従来の検索トラフィックと分けて分析しましょう。多くの解析プラットフォームでリファラーごとにセグメントできるため、ChatGPTやPerplexityなどAIからの流入を特定できます。そのデータをコンテンツ別パフォーマンスと照らし合わせ、どのトピックやコンテンツタイプがAI流入を獲得しているかを分析しましょう。

定期的なテクニカル監査も忘れずに。JavaScriptを一時的に無効化したり、クローラーシミュレーションツールを使って、AIクローラーが実際にコンテンツを見られるか検証しましょう。プリレンダリングやSSRがすべてのクローラーに正確な内容を返せているかも定期的に確認してください。

クライアントサイドレンダリングへの過度な依存は最大の失敗です。JavaScript実行なしでは何も見えないSPAは、AIクローラーには空のシェルしか見えません。SSRやプリレンダリング、プログレッシブエンハンスメントで、重要コンテンツを初期HTMLで必ず提供しましょう。

モバイル最適化の怠慢もAI検索可視性を損ないます。多くのAIクローラーはモバイルユーザーエージェントを使用するため、SPAが完全にレスポンシブで、モバイルでも全コンテンツが正しく表示されることを確認してください。

内部リンク構造の無視はクローラーの発見性を妨げます。<a>タグによる適切な内部リンクがなければ、AIクローラーはごく一部のページしか発見できません。すべての重要ページがどこかからリンクされるよう、サイト全体を連結したネットワークにしましょう。

コンテンツの定期更新を怠ると、AIシステムから「古いサイト」と見なされます。更新スケジュールを維持し、重要ページを定期的にリフレッシュしましょう。AIクローラーは新鮮なコンテンツを優先してクロール・引用するため、継続的な更新がAI生成回答での掲載率向上につながります。

ChatGPTやPerplexityなどのAI検索エンジンによるAI生成回答で、あなたのコンテンツがどのように表示されているかを追跡できます。AI検索での可視性をリアルタイムで把握し、プレゼンスを最適化しましょう。

AI検索の可視性向上のためのプリレンダリングについてのコミュニティディスカッション。開発者たちがJavaScriptフレームワークやAIクローラーによるアクセス経験を共有します。...

SSRとCSRのレンダリング戦略がAIクローラーの可視性、ChatGPTやPerplexityでのブランド引用、そしてAI検索での存在感にどのように影響するかをご紹介します。...

シングルページアプリケーション(SPA)とは何か、どのように機能するのか、その利点と欠点、そして従来のマルチページアプリケーションとの違いを、現代のウェブ開発において学びましょう。...

クッキーの同意

閲覧体験を向上させ、トラフィックを分析するためにクッキーを使用します。 See our privacy policy.