AI対応コンテンツの品質管理

包括的な4ステップフレームワークでAIコンテンツの品質管理をマスターしましょう。AI生成コンテンツの正確性、ブランド整合性、コンプライアンスを確保しつつ、AIでの可視性もモニタリングする方法を学べます。...

AIコンテンツ品質基準値とは何か、どのように測定されるのか、なぜChatGPT、Perplexity、その他のAI回答生成器でAI生成コンテンツの監視に重要なのかを学びます。

AIコンテンツの品質基準値とは、AIが生成したコンテンツが正確性、関連性、一貫性、倫理的安全性の最低基準を満たしているかどうかを判断する定量的なベンチマークです。定量的な指標と定性的な評価基準を組み合わせ、コンテンツが特定の文脈で公開または利用に適しているかを保証します。

AIコンテンツ品質基準値とは、AIが生成したコンテンツが公開、配布、または特定用途での利用に必要な最低条件を満たしているかどうかを判断する事前に定められたベンチマークや基準です。生成AI時代において、組織は自動化によるスピードや効率と、ブランドの信頼性・正確性・ユーザー信頼を両立させる必要があり、その制御装置として基準値が機能します。基準値は品質ゲートとして機能し、ChatGPTやPerplexityなどのAI回答エンジンをはじめとする様々なAIプラットフォームで、定められた基準を満たすコンテンツのみがユーザーに届くことを保証します。

品質基準値は単なる数値ではなく、科学的根拠に基づいたベンチマークであり、複数の側面からコンテンツのパフォーマンスを評価するフレームワークによって策定されます。技術的指標、人間による判断、ビジネス目標が交差する地点にあり、AIドリブンなコンテンツエコシステムにおける包括的な品質保証システムとなります。

正確性はあらゆる品質基準値システムの基盤です。この側面では、AIが生成したコンテンツの情報が事実に基づき信頼できる情報源と照合可能かを測定します。医療、金融、ジャーナリズムなど重要な分野では正確性基準が特に厳格で、95〜99%の正確性を求められることもあります。AIシステムはハルシネーション(もっともらしいが事実無根の情報)を生み出す場合があるため、正確性の評価は極めて重要です。

正確性の評価は、AI出力をグラウンドトゥルースデータや専門家の検証、既存の知識ベースと比較することで行われます。たとえば、ブランドがAI回答にどのように表示されるかを監視する際、正確性基準値は引用や参照が事実に基づき、正しく帰属されていることを保証します。多くの組織では一般コンテンツに対して85〜90%、専門領域では95%以上の正確性スコアを基準としています。

関連性は、AI生成コンテンツがユーザーの実際の意図や質問にどれだけ的確に応えているかを測定します。文法的に完璧で事実も正しくとも、ユーザーの問いに直接答えていなければ失格です。関連性基準値は、コンテンツの構成・トーン・情報階層が検索意図と合致しているかを評価します。

最新のAIコンテンツスコアリングシステムでは、関連性を多角的に分析します:トピックの網羅性(質問の全側面を扱っているか)、ターゲット層への適正(適切な難易度か)、ユーザージャーニーの段階との整合性(調査・比較・決断など)。関連性基準値は文脈により70〜85%が一般的で、一部の周辺情報が許容される場合もあります。

一貫性とは、コンテンツの構造的な質や論理的な流れを指します。AIは自然な文章構成、トーンの一貫性、論理的なアイデア展開を伴ったテキストを生成する必要があります。可読性は、人間がどれだけ容易に理解できるかを示し、Flesch-KincaidやGunning Fog Indexなどの可読性スコアで測定されます。

一貫性の基準値はターゲット層に応じた最低可読性スコアを指定することが多いです。一般向けではFlesch Reading Easeで60〜70、専門向けでは40〜50でも許容されます。一貫性評価では段落構成、つなぎの質、見出しやフォーマットの明確さも評価対象です。

独自性は、AI生成コンテンツが既存資料の単なるコピーや言い換えではなく、適切な帰属を伴うことを保証します。ブランドボイス維持や著作権リスク回避の観点から極めて重要です。基準値としては85〜95%の独自性スコアが求められ、つまりコンテンツの85〜95%が唯一または大幅に書き直されている必要があります。

盗用検出ツールは既存ソースとの一致率を測定しますが、業界用語や事実情報など正当な再利用も考慮が必要です。許容範囲の言い換えと問題あるコピーの区別がポイントとなります。

ブランドボイスの一貫性は、AI生成コンテンツが自社固有のトーンやスタイル、メッセージガイドラインを維持しているかを測定します。これはブランド認知や信頼維持に不可欠で、AI生成回答が検索エンジンや回答プラットフォームに表示される場合も例外ではありません。

ブランドボイスの基準値は定性的ですが、語彙選択、文構造パターン、感情トーン、ブランドメッセージ原則の順守など具体的な基準で運用できます。多くの組織では80〜90%のブランドボイス整合性を求め、柔軟性を持たせつつも核心的なアイデンティティは維持します。

倫理的安全性は、差別的ステレオタイプ、攻撃的表現、バイアスを含む前提、有害または悪用されかねないコンテンツの不在を指します。AIが社会的バイアスを助長したり有害な内容を生成しないよう、組織の責任が強く意識されています。

倫理的安全性の基準値は二値的(あるいは95〜100%必須)で、小さなバイアスや有害表現でもブランドの信頼を損ね倫理原則に違反することがあるためです。自動バイアス検出ツール、多様な評価者による人間レビュー、異なる属性文脈でのテストなどが用いられます。

現代の品質基準値システムでは複数の自動指標を活用し、大規模なAIコンテンツ評価を実現しています。例:

| 指標タイプ | 測定内容 | 基準値範囲 | ユースケース |

|---|---|---|---|

| BLEU/ROUGEスコア | 参照テキストとのNグラム重複 | 0.3-0.7 | 機械翻訳、要約 |

| BERTScore | 埋め込みによる意味的類似度 | 0.7-0.9 | 一般コンテンツ品質 |

| パープレキシティ | 言語モデルの予測信頼度 | 低いほど良い | 流暢性評価 |

| 可読性スコア | テキストの理解難易度 | 60-70(一般向け) | アクセシビリティ評価 |

| 盗用検出 | 独自性パーセンテージ | 85-95%独自 | 著作権順守 |

| トキシシティスコア | 有害言語の検出 | <0.1(0-1スケール) | 安全性保証 |

| バイアス検出 | ステレオタイプ・公平性評価 | >0.9の公平性 | 倫理順守 |

これらの自動指標により定量的かつスケーラブルな評価が可能ですが、BLEUやROUGEといった従来指標はLLM出力の意味的ニュアンスに弱く、BERTScoreは意味をより捉えやすい一方で領域固有の課題を見落とす場合があります。

より高度な手法として、大規模言語モデル自身を評価者として使う方法があり、その推論力を活用します。LLM-as-a-Judgeと呼ばれるこの手法では、G-EvalやDAG(Deep Acyclic Graph)といった枠組みを利用し、自然言語による評価基準でコンテンツ品質を判断します。

G-Evalは連鎖的思考による評価ステップを生成し、最終スコアを割り当てます。たとえば一貫性評価では:(1)一貫性基準の定義、(2)評価手順の生成、(3)手順の適用、(4)1〜5のスコア付与、と進みます。この方法は従来指標より人間判断との相関(Spearman相関0.8〜0.95)が高い傾向にあります。

DAGベース評価は、各ノードが特定の評価基準、エッジが判断手順を表す決定木をLLMで運用します。これは「特定セクションが正しい順序で含まれている」等、明確かつ決定的な要件がある場合に有効です。

自動化が進む現在でも、人間評価は創造性・感情的共鳴・文脈適合性など微妙な品質判断で不可欠です。品質基準値システムでは多層的な人間レビューを組み込みます。

評価者は特定基準や採点ガイドラインを用いたルーブリックに沿って評価し、評価者間の一貫性(Cohen’s KappaやFleiss’ Kappa)は0.70超を目安に品質基準値の信頼性を確保します。

品質基準値は一律ではありません。用途や業界、文脈ごとに最適化される必要があります。簡単なFAQは包括的ガイドより低スコアでも許容され、基準値が適切に設定されていれば問題ありません。

分野ごとの標準例:

多数の指標を追うより、効果的な品質基準値システムは5つのコア指標に注力します:用途特有のカスタム指標1〜2個+コンテンツアーキテクチャに合致した汎用指標3〜4個。これで網羅性と運用性を両立します。

例:AI回答でブランド表示を追跡するモニタリングシステムの場合

品質基準値は0〜100のスケールで運用されますが、解釈には文脈が必要です。スコア78が「悪い」とは限らず、組織の基準次第です。多くの組織は固定値ではなく範囲で基準を設けます。

このような柔軟な品質管理により基準を維持しつつ運用性を確保します。公開最低基準80、レビュー基準70など、リスク許容度やコンテンツ種別により異なります。

自社ブランドやドメイン、URLがChatGPTやPerplexityなどのAI回答に表示される場合、品質基準値はブランド保護の観点で極めて重要です。質の低い引用や誤った情報、誤帰属はブランドに損害を与え、ユーザーを誤解させます。

ブランドモニタリングの基準値例:

AI回答モニタリング用の品質基準値システムを実装する際は:

この体系的アプローチにより、自社ブランドがすべてのAIプラットフォームで品質基準を維持し、信頼と正確な情報提供を実現します。

AIコンテンツ品質基準値は単なるスコアではなく、AI生成コンテンツが正確性、関連性、一貫性、独自性、ブランド整合性、倫理的安全性という組織の基準を満たすための包括的フレームワークです。自動指標、LLM評価、人間判断を組み合わせることで、コンテンツ生産の拡大とともに品質を保つ信頼性ある基準値を構築できます。自社でコンテンツを生成する場合も、AI回答エンジンでのブランド表示を監視する場合も、適切な品質基準値の理解と実装は、信頼維持・ブランド保護・ユーザーへの最適な情報提供に不可欠です。

AI生成回答における自社コンテンツの表示状況を追跡し、すべてのAIプラットフォームで品質基準が維持されていることを確認しましょう。

包括的な4ステップフレームワークでAIコンテンツの品質管理をマスターしましょう。AI生成コンテンツの正確性、ブランド整合性、コンプライアンスを確保しつつ、AIでの可視性もモニタリングする方法を学べます。...

AI検索の引用で求められるコンテンツ品質要件についてのコミュニティディスカッション。ChatGPTやPerplexityなどのAIプラットフォームで引用されるために、コンテンツが満たすべき品質しきい値を理解する。...

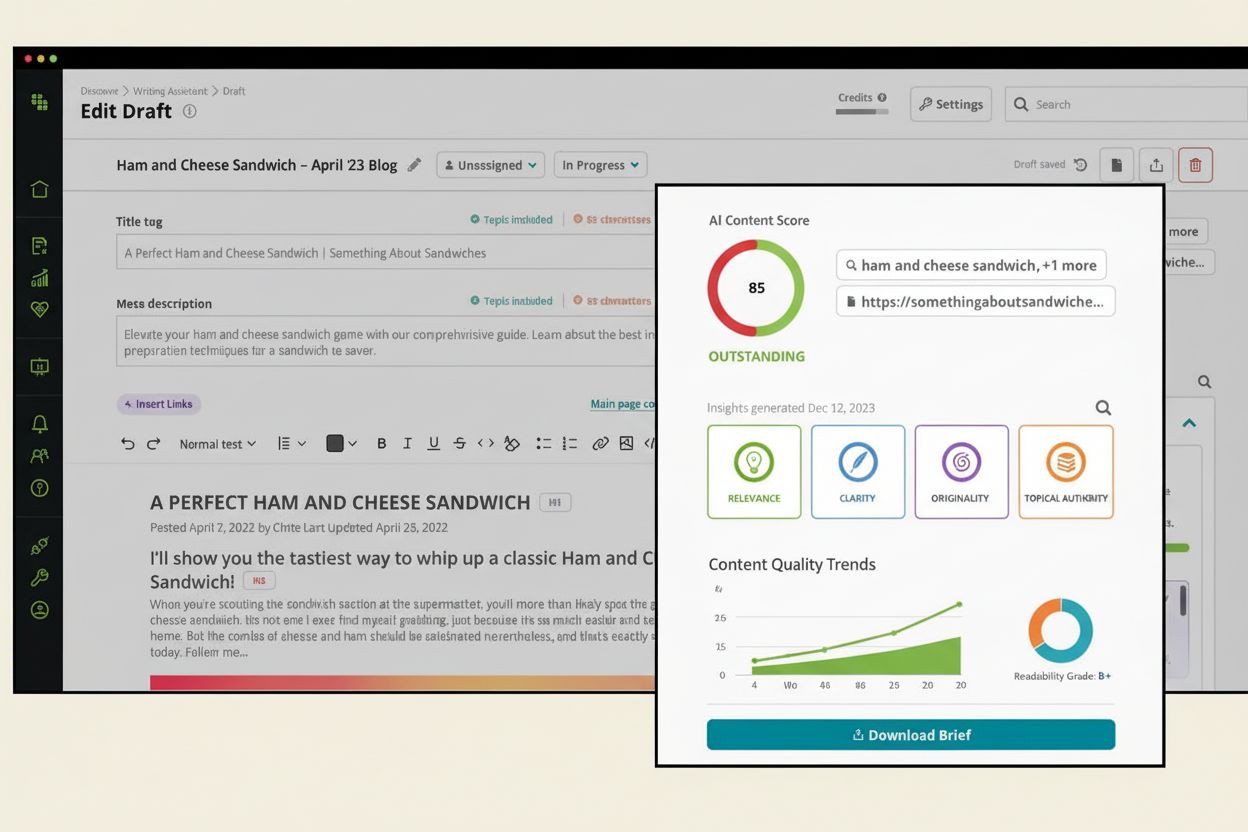

AIコンテンツスコアとは何か、AIシステム向けにコンテンツ品質をどのように評価するのか、またChatGPT、PerplexityなどAIプラットフォームでの可視性においてなぜ重要なのかを解説します。...

クッキーの同意

閲覧体験を向上させ、トラフィックを分析するためにクッキーを使用します。 See our privacy policy.