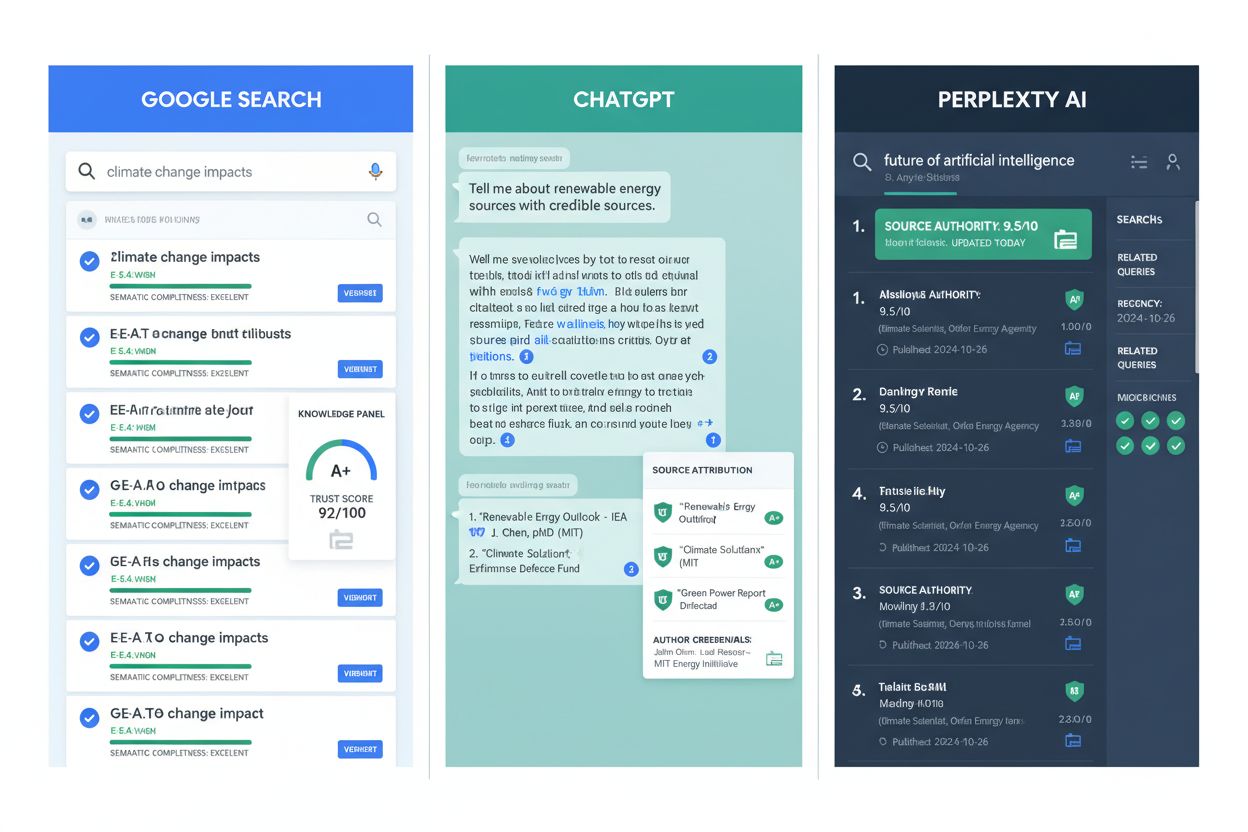

AIエンジンが最も信頼する情報源とは?ChatGPT、Perplexity、Google AIにおける引用パターン

AIエンジンが最も頻繁に引用する情報源を解説。ChatGPT、Google AI Overviews、Perplexityが情報源の信頼性をどう評価し、各業界での引用パターンがAIでの可視性最適化にどう役立つかを学びましょう。...

ChatGPT、Perplexity、Google AIなどのAIエンジンが、どのように情報源の信頼性を評価しているかを解説します。E-E-A-T、ドメインオーソリティ、引用頻度、その他AIが生成する回答で引用される情報源を決定する重要な信頼性シグナルについて学びましょう。

AIエンジンは、ドメインオーソリティ、E-E-A-T(経験・専門性・権威性・信頼性)、引用頻度、コンテンツの正確性、情報源の透明性、トレーニングデータの質など、複数の相互に関連したシグナルを通じて信頼性を評価します。これらの要因が、AIシステムが生成する回答でどの情報源を引用するかを決定します。

AI検索エンジンやアンサー生成エンジンは、オンラインで情報が発見・評価される方法を根本的に変えました。従来の検索エンジンが複数の結果を表示し、ユーザー自身に信頼できる情報源を選ばせるのに対し、AIエンジンは回答を生成する前に信頼性判断を行う必要があります。このため、特定の信頼性基準を満たした情報源のみが引用される、より厳格なフィルタリング機構が生まれました。AIプラットフォームでは、参照する情報源の質がその評判を左右するため、信頼性評価は単なる順位付けの好みではなく、運用上の必須要件となっています。不確かな情報を引用すれば、ユーザーの信頼は失われ、プラットフォーム全体への信頼性が損なわれます。

AIエンジンは、生成する回答で引用に値するかどうかを決めるために、4つの相互に関連した特性で情報源の信頼性を評価します。これらのシグナルは従来のSEO概念から発展し、AIの文脈ではさらに高度かつ相互に連動して機能しています。

正確性は信頼性評価の基盤です。コンテンツは、根拠やデータ、信頼できる研究で裏付けられた検証可能な事実を反映していなければなりません。AIシステムは、記載内容が複数の情報源で裏付けられるか、業界で確立された知識と整合しているかを分析します。常に事実に基づいた情報を提供する情報源は、時間とともにより強い信頼性シグナルを構築します。

権威性は、その情報が公認機関や有力出版社、専門知識を有する個人から発信されていることを示します。これは単なるブランド認知ではなく、検証可能な資格や職業経験、実績も含みます。AIエンジンは、学術資格、専門認定、講演、メディア掲載、他の権威ある情報源からの引用など、複数のチャネルで権威性を認識します。

透明性は、情報源が自らを明確に示し、情報の出所を適切に明記し、主張の根拠を追跡可能にしていることを求めます。著者名、公開日、出典、利益相反の開示などが含まれます。透明性の高い情報源は、AIシステムが情報を検証し、主張がなされた文脈を理解する助けとなります。

継続的な一貫性は、単発の正確性ではなく、信頼できるコンテンツの積み重ねによる信頼性を示します。AIエンジンは、複数の記事や更新、期間を通じて質の維持がなされているかどうかを評価します。継続的にこれらの特性を示す情報源は、断続的で疑わしいコンテンツが混在するものより強い権威性シグナルを構築します。

ドメインオーソリティは、ウェブサイトが検索結果で上位表示される、またAIシステムに引用される可能性を数値化した指標です。主にバックリンクの質と量に基づく100点満点のスケールで測定され、ドメインオーソリティは従来型検索エンジンとAIシステム双方が重視する価値観と強い相関を持ちます。調査によれば、AIの概要表示ではドメインオーソリティが70以上の情報源が圧倒的に引用されており、AIシステムが学習データの分析を通じて信頼できると見なしているため、高DAドメインがAIの引用を独占しています。

| 信頼性要素 | AIによる引用への影響 | 一般的なDAスコア範囲 |

|---|---|---|

| 主要ニュースメディア | 27-49%の引用頻度 | 80-95 |

| 有力出版社 | 15-25%の引用頻度 | 70-85 |

| 業界専門家 | 10-20%の引用頻度 | 60-75 |

| 新興の権威 | 5-15%の引用頻度 | 40-60 |

| 低権威情報源 | <5%の引用頻度 | <40 |

ドメインオーソリティとAIによる引用の関係は偶然ではありません。AIシステムは、権威性の高いドメインが自然と頻繁に登場し多く引用される大量のインターネットコンテンツで訓練されています。この学習データの土台により、AIエンジンは高いドメインオーソリティを信頼性と直結させて学習します。新たなクエリを評価するときも、同様の重み付けパターンが適用されるため、ドメインオーソリティはAI生成回答で引用されるかどうかを予測する上で最も信頼できる指標のひとつとなっています。

E-E-A-Tは、AIエンジンが多面的に情報源の信頼性を評価するための統合フレームワークです。4つの要素は独立しているのではなく、相互に作用し、AIシステムがインターネット全体で検証できる包括的な信頼プロファイルを形成します。

**経験(Experience)**は、理論的な理解以上に、ケーススタディや独自調査、実際の事例などの一次的な知識によって示されます。自らの経験や実績を示す情報源は、他者の情報をまとめているだけのものよりも強い経験シグナルを築きます。具体的な成果を示すケーススタディ、専門家による実体験の証言、独自調査の公開などがこれに該当します。

**専門性(Expertise)**は、表層的な解説を超えた、包括的なカバレッジや技術的な正確さ、洞察力によって示されます。専門性シグナルは、基礎知識と本質的な熟達の違いを明らかにします。AIシステムは、トピックの複雑な側面や例外、関連概念や影響まで網羅した詳細なコンテンツを通じて専門性を認識します。

**権威性(Authoritativeness)**は、同業者からの認知、他の専門家やメディアからの引用や登壇、業界からの評価によって築かれます。これは「自分が自分をどう評価するか」ではなく、「業界があなたをどう扱うか」です。AIシステムは、他の権威ある情報源があなたの仕事を引用・参照しているか、業界イベントに招待されているか、メディアで専門性が取り上げられているかを確認します。

**信頼性(Trustworthiness)**は、著者の明確な身元開示や正確な情報、適切な出典、安全なインフラ、連絡先の明示など、透明性を前提に全てのシグナルの土台となります。信頼性を欠けば、いかに高い専門性を主張しても説得力がありません。検証可能な著者情報、利益相反の明確な開示、訂正やアップデートへの積極的な姿勢などが信頼性に該当します。

AIエンジンが信頼性をどのように定義するかは、クエリ入力の遥か以前、トレーニングデータの選定段階で決定的に形作られます。多くの大規模言語モデルは、書籍や学術誌、百科事典やリファレンス、主要ニュースメディアのアーカイブ、政府公報や技術マニュアルなど、膨大なテキストコーパスに晒されています。このトレーニングデータの基盤が、特定のタイプの情報源を信頼できるものとAIに学習させています。

同様に重要なのは、トレーニングデータから意図的に除外される情報源の種類です。AI開発者は、スパムサイトやリンクファーム、低品質ブログやコンテンツファーム、既知の誤情報ネットワークや操作されたコンテンツなどをフィルタリングします。この選別プロセスは、モデルが公開利用時に認識できる信頼と権威のシグナルの基準を決定するため、極めて重要です。人間のレビュアーは従来の検索品質評価と同様の基準を適用し、アルゴリズムによる判別や自動フィルタはスパムや低品質信号、不正・盗用・操作コンテンツを排除します。

トレーニングデータの選別を理解することは、AIがなぜ特定の情報源を繰り返し引用し、他の情報源を一切引用しないのかを説明する鍵となります。AIシステムは、すべての情報源に対して一から信頼性評価をしているわけではなく、学習データで高権威情報源が頻繁に現れたパターンを応用しているのです。AIエンジンで信頼を築くには、どのような情報源が学習データで重視されたかを理解し、それと同様の信頼性シグナルを示す必要があります。

AIエンジンは、情報源を単独で評価しているわけではありません。複数の信頼できる文書に掲載されるコンテンツは追加的な重みを獲得し、AI生成回答で引用・要約される可能性が高まります。このクロスリファレンスの仕組みにより、繰り返される信頼性シグナルが特に価値を持ちます。複数の権威ある情報源が同じ情報や専門家を引用している場合、AIシステムはこれを強力な信頼シグナルと認識します。この原則は従来の検索のPageRankにも通じ、AIのより複雑なランキングモデルにも影響しています。

引用頻度は、合意形成や検証の代理指標となります。複数の権威ある情報源で情報が登場すれば、AIシステムはその情報が精査・検証された証拠とみなします。逆に、たとえ単一の権威ある情報源であっても、その主張が他に現れなければ、AIは引用に慎重になる場合があります。これにより、他の権威ある出版社と関係を築き、自然に引用されるコンテンツを作成するインセンティブが生まれます。

信頼できる文書間の相互リンクは、AIシステムが分析できる信頼性のネットワークを作り出します。特定の情報源を引用するかどうかを評価する際、AIエンジンはその情報源が他の信頼できる情報源からどのように参照されているか、その文脈や主張の裏付けがなされているかを確認します。このネットワーク分析により、AIは本当に権威ある情報源と、単に権威を主張するだけの情報源を区別します。

コンテンツの鮮度はAIでの可視性において重要であり、特にGoogleのコアランキングシステムに組み込まれた新しさ要素を基盤とするGoogle AI Overviewsでは顕著です。積極的に管理され、最近更新されたコンテンツほどAIで表示されやすくなります。これは、規制や速報、新しい研究結果など、変化するトピックに特に当てはまります。AIシステムは、情報の質が時間の経過とともに低下することを認識しています。

時間依存性の高いトピックでは、新しさが主要な信頼シグナルとなります。同じトピックを複数の情報源が扱う場合、AIエンジンはより最近のコンテンツを優先する傾向があり、これは現状や最新情報を反映している可能性が高いためです。特に、規制変更や科学的発見、市場動向、技術革新など、正確さがタイミングに依存する分野で重要となります。定期的にコンテンツを更新する情報源は、精度と関連性へのコミットメントを示し、静的なままのコンテンツよりも強い信頼シグナルを築きます。

ただし、鮮度が全てのコンテンツタイプに常に必要というわけではありません。安定したトピックに関するエバーグリーンコンテンツは、数年更新がなくても信頼価値を維持できます。重要なのは、状況が変わったり新情報が出た際に適切に更新することです。分野の大きな変化にもかかわらず古い情報を維持し続ける情報源は、AIによって現実を反映していないと判断され、信頼シグナルを失います。

AIシステムのランキングは一律ではありません。**技術的な質問では学術的・専門サイトが重視され、ニュース系の質問ではジャーナリスティックなコンテンツが優先されます。**この適応性により、エンジンはユーザーの意図に合わせて信頼シグナルを調整し、文脈に沿った信頼性評価を可能にしています。例えば、医療系の質問に対するAIの情報源の重み付けと、ビジネス戦略の質問での重み付けは、同じ権威ある情報源であっても異なる場合があります。

文脈的な重み付けは、特定のクエリやユーザーの意図に応じて信頼シグナルが評価されることを意味します。ある情報源が特定のクエリには非常に信頼される一方で、別のクエリにはあまり適していないこともあります。例えば、科学的な質問には学術誌が高い信頼重みを持ちますが、実用的なノウハウ系の質問では現場経験が重視されることもあります。AIシステムは、クエリごとにどのタイプの情報源が最適かを評価します。

この文脈的アプローチにより、専門分野に特化した情報源は、一般的な権威情報源と十分に競争できます。特定分野のニッチな専門家は、その分野の質問においては大手よりも上位に表示されることもあり、AIが専門性の価値を正しく認識している証です。つまり、すべての分野で最も権威ある情報源になる必要はなく、特定領域で本物の専門性を示すことが信頼構築の鍵となります。

学習やクエリ時のランキングを経ても、AIエンジンには回答の正確性にどれほど自信があるかを判断する仕組みが必要です。内部信頼指標は、主張が正確である確率を推定し、どの情報源を引用するかや、モデルが断定を控えるかを左右します。これらの信頼スコアは表には出ませんが、AI生成回答でユーザーが目にする内容に大きく影響します。

信頼スコアリングは、モデルが生成する各主張に内部確率を付与することで機能します。高い信頼スコアは「より確信がある」ことを示し、低い場合は「情報源によると」「一部の情報源は~と示唆」など、断定を避ける表現や外部情報源の明示的な引用を引き起こす可能性があります。このため、情報源はAIがためらわずに引用できるほど強い信頼シグナルを構築する必要があります。

閾値調整はすべてのクエリで一定ではありません。情報が乏しい、または低品質な場合、AIエンジンは断定的な回答を控えたり、外部情報源の引用を増やす傾向があります。つまり、権威ある情報源が少ないニッチな話題では、信頼される数少ない情報源となることで引用の大きな機会を得られます。一方、競争が激しいトピックでは、突出した信頼シグナルが求められます。

情報源間の整合性も信頼スコアリングに大きく影響します。複数の情報源が一致した主張をしている場合、AIはそれをより重視し、高い自信を持って回答します。逆に、主張が分かれる場合は、AIは断定を避けることがあります。このように、他の信頼できる情報源と整合することで、独自主張よりも強い信頼シグナルを得やすくなります。

高度なスコアリングと安全策があっても、大規模な信頼性評価には限界があります。情報源の偏りにより、権威性シグナルが大手英語圏出版社や西洋メディアに偏りがちです。こうしたドメインは重視されがちですが、これに依存し過ぎると、特定クエリに最適な地域・非英語の専門知識が見落とされることもあります。この地理的・言語的バイアスのため、過小評価されている地域の権威情報源は、たとえ専門性が高くてもAIに引用されにくい状況にあります。

知識の変化も根本的な課題です。真実は固定的ではなく、科学的合意は変化し、規制も変わり、新しい研究で過去の前提が覆ることもあります。去年正しかったことが翌年には古くなるため、アルゴリズムによる信頼シグナルも安定的とは限りません。AIエンジンには、信頼マーカーを継続的に更新・再調整する仕組みが求められます。特に、過去データで学習したAIは現状を反映しきれないリスクがあります。

ブラックボックス性も透明性の課題です。AI企業は、トレーニングデータの全容や信頼シグナルの重み付けをほとんど公開しません。ユーザーにとっては、なぜ特定の情報源が頻繁に引用されるのか理解しづらく、出版社やマーケターにとっては、AIの優先事項に合わせて戦略を最適化するのが難しくなります。この不透明さゆえに、AI信頼要素を理解するには、公式情報よりも実際のAI引用パターンを分析する必要があります。

AIエンジンがどのように信頼を評価するかを理解することで、AI生成回答での可視性向上に向けたロードマップが描けます。透明性を最優先し、正確な情報源の明記や専門性の立証、主張の出所が追跡しやすい構成を徹底しましょう。これが信頼性を示し、AIシステムが情報を検証しやすくなります。専門性をアピールし、本物の専門家や現場経験のある実践者によるコンテンツを前面に出しましょう。他人の要約よりもオリジナル性を重視しましょう。鮮度を保ち、特に時事性の高いトピックでは定期的な更新を行いましょう。**他の信頼あるドメインから引用・被リンクを獲得し、信頼シグナルを強化しましょう。**AIプラットフォームで自社コンテンツの表示状況をモニタリングし、誤りやギャップ、新たな機会に応じて適応することも重要です。

今後目指すべきは、透明性・専門性・継続的な管理を兼ね備えたコンテンツ作りです。AIが信頼をどう定義するかを学ぶことで、ブランド戦略を最適化し、信頼を構築し、AIが真っ先に参照する情報源となるチャンスを高めることができます。

ChatGPT、Perplexity、Google AI、その他のAI検索エンジンにおいて、あなたのドメインがAI生成回答でどれくらい登場しているかを追跡できます。AIにおける可視性や信頼性指標をリアルタイムで把握しましょう。

AIエンジンが最も頻繁に引用する情報源を解説。ChatGPT、Google AI Overviews、Perplexityが情報源の信頼性をどう評価し、各業界での引用パターンがAIでの可視性最適化にどう役立つかを学びましょう。...

ChatGPT、Perplexity、Google AI OverviewsなどのAI検索エンジン向けに信頼シグナルを構築する方法を学びましょう。E-E-A-Tの原則、権威シグナル、AIシステムから引用されるための戦略を解説します。...

AIシステムが著者の資格、引用、検証を通じて情報源の信頼性をどのように評価するのか学びましょう。技術的な仕組み、主要因、AIプラットフォームで情報源の信頼性を高めるためのベストプラクティスについて理解しましょう。...

クッキーの同意

閲覧体験を向上させ、トラフィックを分析するためにクッキーを使用します。 See our privacy policy.