AIクローラーアクセス監査:正しいボットがあなたのコンテンツを見ているか?

AIクローラーがあなたのウェブサイトにアクセスできているかを監査する方法を学びましょう。どのボットがあなたのコンテンツを見ているのかを確認し、ChatGPT・Perplexity・その他AI検索エンジンでAIによる可視性を妨げている要因を修正しましょう。...

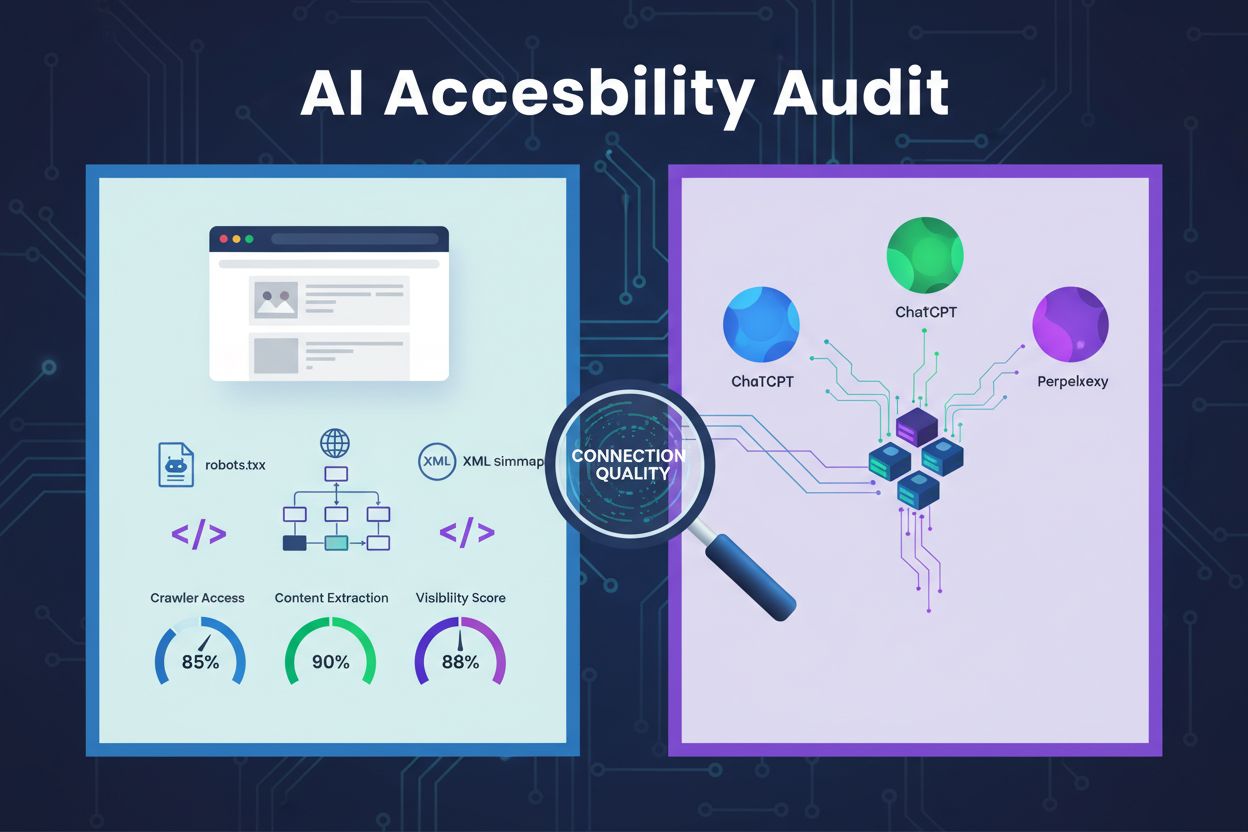

AIクローラーがウェブサイトのアーキテクチャ、設定、コンテンツ構造に効果的にアクセスし、理解し、コンテンツを抽出できるかどうかを判断するための技術的レビュー。robots.txtの設定、XMLサイトマップ、サイトのクロール可能性、JavaScriptレンダリング、コンテンツ抽出能力を評価し、ChatGPT、Claude、PerplexityなどのAI検索プラットフォームでの可視性を確保します。

AIクローラーがウェブサイトのアーキテクチャ、設定、コンテンツ構造に効果的にアクセスし、理解し、コンテンツを抽出できるかどうかを判断するための技術的レビュー。robots.txtの設定、XMLサイトマップ、サイトのクロール可能性、JavaScriptレンダリング、コンテンツ抽出能力を評価し、ChatGPT、Claude、PerplexityなどのAI検索プラットフォームでの可視性を確保します。

AIアクセシビリティ監査は、あなたのウェブサイトのアーキテクチャ、設定、コンテンツ構造について、AIクローラーがあなたのコンテンツに効果的にアクセスし、理解し、抽出できるかを判断するための技術的レビューです。従来のSEO監査がキーワード順位やバックリンクに重点を置くのに対し、AIアクセシビリティ監査は、ChatGPT、Claude、PerplexityなどのAIシステムがコンテンツを発見し引用できるようにするための技術基盤に着目します。この監査では、robots.txtの設定、XMLサイトマップ、サイトのクロール可能性、JavaScriptレンダリング、コンテンツ抽出能力などの重要な要素を評価し、AI検索エコシステムに対してウェブサイトが十分に可視化されているかを確認します。

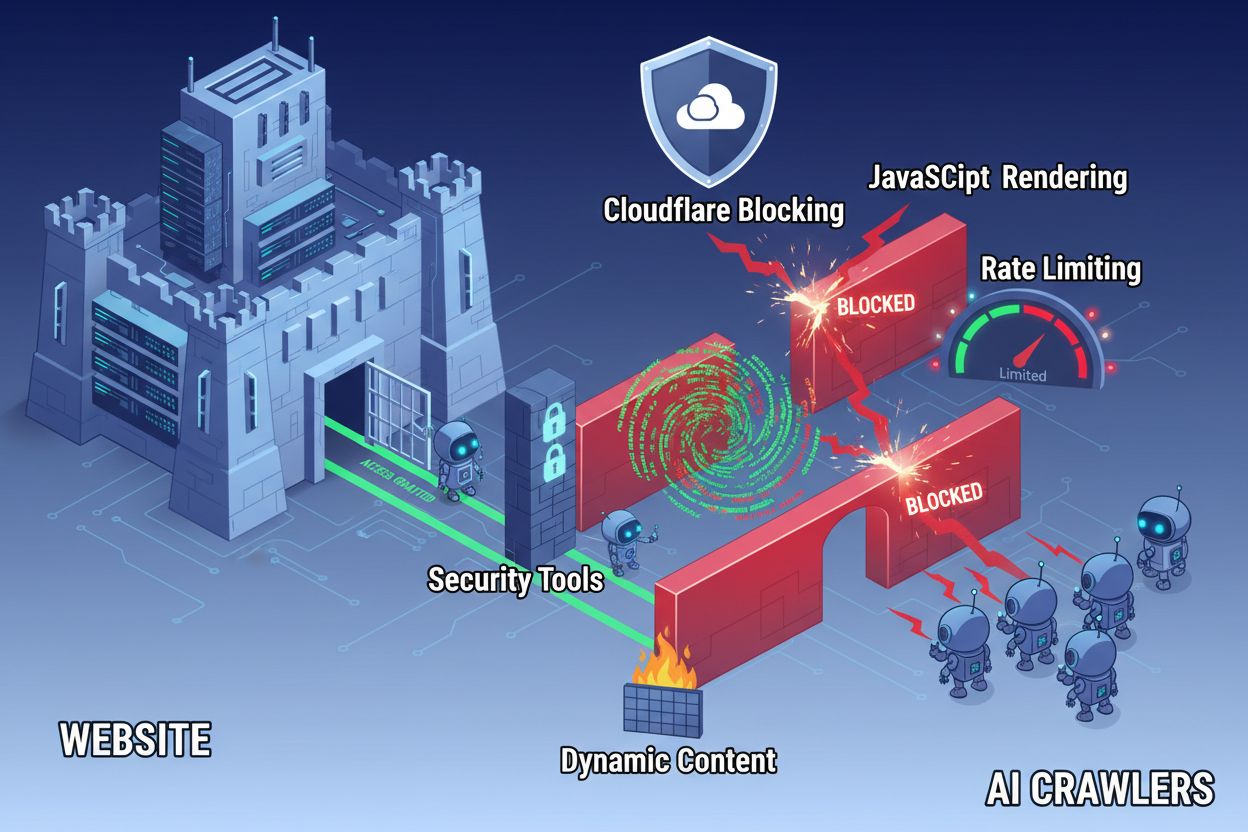

ウェブ技術の進歩にもかかわらず、AIクローラーは現代のウェブサイトにアクセスする際に大きな障壁に直面します。最大の課題は、多くの現代的なウェブサイトがJavaScriptレンダリングに大きく依存してコンテンツを動的に表示していることですが、ほとんどのAIクローラーはJavaScriptコードを実行できません。つまり、現代ウェブサイトの約60~90%のコンテンツは、ユーザーのブラウザ上では表示されていても、AIシステムからは見えないままです。さらに、CloudflareのようなセキュリティツールはデフォルトでAIクローラーを脅威と見なしてブロックし、正規のインデックス用ボットとして扱いません。調査によると、企業サイトの35%が意図せずAIクローラーをブロックしており、AIシステムによるコンテンツ発見や引用を妨げています。

AIクローラーのアクセスを妨げる一般的な障壁:

包括的なAIアクセシビリティ監査は、AIシステムがウェブサイトとどのように相互作用するかに影響する複数の技術的・構造的要素を調査します。各要素は、コンテンツがAI検索プラットフォームで可視化されるかどうかに固有の役割を果たします。監査プロセスでは、クロール可能性のテスト、設定ファイルの検証、コンテンツ構造の評価、実際のクローラー挙動の監視が含まれます。これらの要素を体系的に評価することで、具体的な障壁を特定し、AI可視性を高めるための解決策を実施できます。

| 構成要素 | 目的 | AI可視性への影響 |

|---|---|---|

| robots.txt設定 | 特定のサイトセクションへのクローラーアクセスを制御 | 重要 - 設定ミスでAIクローラーを完全にブロックする |

| XMLサイトマップ | 重要ページやコンテンツ構造をクローラーに案内 | 高 - AIシステムがコンテンツを優先的に発見できる |

| サイトのクロール可能性 | 認証や複雑なナビなしでページにアクセス可能か | 重要 - ブロックされたページはAIシステムから見えない |

| JavaScriptレンダリング | 動的コンテンツがクローラーに見えるかどうか | 重要 - プリレンダリングがなければ60~90%のコンテンツが見逃される可能性 |

| コンテンツ抽出 | AIシステムがコンテンツを解析・理解しやすいか | 高 - 構造が悪いと引用確率が下がる |

| セキュリティツール設定 | クローラーアクセスに影響するファイアウォール・保護ルール管理 | 重要 - 厳しすぎるルールで正規AIボットもブロックされる |

| スキーママークアップ実装 | コンテンツの機械可読な文脈を提供 | 中 - AIの理解と引用の可能性を高める |

| 内部リンク構造 | ページ間のセマンティックな関係性を構築 | 中 - AIがトピックの権威性や関連性を理解しやすくなる |

robots.txtファイルは、どのクローラーがあなたのウェブサイトにアクセスできるかを制御する主要なメカニズムです。ドメイン直下に配置されたこのシンプルなテキストファイルには、クローラーに特定のサイトセクションへのアクセス可否を指示するディレクティブが記述されます。AIアクセシビリティの観点では、GPTBot(OpenAI)、ClaudeBot(Anthropic)、PerplexityBot(Perplexity)など主要AIクローラーを誤ってブロックしないよう、適切なrobots.txt設定が不可欠です。ポイントは、これらのクローラーを明示的に許可しつつ、悪意のあるボットや機密領域は保護することです。

AIクローラー向けrobots.txt設定例:

# すべてのAIクローラーを許可

User-agent: GPTBot

User-agent: ChatGPT-User

User-agent: ClaudeBot

User-agent: Claude-Web

User-agent: PerplexityBot

User-agent: Google-Extended

Allow: /

# 機密領域のブロック

Disallow: /admin/

Disallow: /private/

Disallow: /api/

# サイトマップ

Sitemap: https://yoursite.com/sitemap.xml

Sitemap: https://yoursite.com/ai-sitemap.xml

この設定では、主要なAIクローラーによる公開コンテンツへのアクセスを明示的に許可しつつ、管理用やプライベート領域を保護します。Sitemapディレクティブは重要ページの効率的な発見を助けます。

XMLサイトマップはクローラーのためのロードマップとして機能し、インデックス化してほしいURLと各ページのメタデータをリストします。AIシステムにとってサイトマップは特に有用で、クローラーがサイト構造を理解し、重要コンテンツを優先的に発見し、通常のクロールでは見落とされがちなページも把握できます。従来の検索エンジンはリンクで構造を推測できますが、AIクローラーはどのページが重要か明示的な案内から大きな恩恵を受けます。メタデータ付きの整理されたサイトマップは、AIシステムによる発見・理解・引用の可能性を高めます。

AI最適化向けXMLサイトマップ構造例:

<?xml version="1.0" encoding="UTF-8"?>

<urlset xmlns="http://www.sitemaps.org/schemas/sitemap/0.9">

<!-- AIクローラー向け高優先度コンテンツ -->

<url>

<loc>https://yoursite.com/about</loc>

<lastmod>2025-01-03</lastmod>

<priority>1.0</priority>

</url>

<url>

<loc>https://yoursite.com/products</loc>

<lastmod>2025-01-03</lastmod>

<priority>0.9</priority>

</url>

<url>

<loc>https://yoursite.com/blog/ai-guide</loc>

<lastmod>2025-01-02</lastmod>

<priority>0.8</priority>

</url>

<url>

<loc>https://yoursite.com/faq</loc>

<lastmod>2025-01-01</lastmod>

<priority>0.7</priority>

</url>

</urlset>

priority属性はAIクローラーにページの重要度を伝え、lastmodはコンテンツの新しさを示します。これによりAIシステムはクロールリソースを有効に配分し、コンテンツ階層を理解できます。

設定ファイル以外にも、AIクローラーによるコンテンツアクセスを妨げる技術的障壁が複数存在します。JavaScriptレンダリングは最大の課題であり、React、Vue、Angularなどの現代的ウェブフレームワークはコンテンツをブラウザで動的に描画するため、AIクローラーには空のHTMLしか届きません。Cloudflareや同様のセキュリティツールは高リクエスト数を攻撃と見なしてAIクローラーをデフォルトでブロックしがちです。レート制限は網羅的なインデックス化を妨げ、複雑なサイトアーキテクチャや動的コンテンツのロードもアクセス性を低下させます。幸い、これらの障壁を克服する手段はいくつも存在します。

AIクローラーアクセス向上のための解決策:

AIシステムは単にコンテンツにアクセスするだけでなく、それを理解する必要があります。コンテンツ抽出とは、AIクローラーがページから意味のある情報をどれだけ効果的に解析・把握し抽出できるかを指します。これはセマンティックなHTML構造に大きく依存しており、適切な見出し階層、説明的なテキスト、論理的な配置によって意味が伝達されます。H1、H2、H3などの見出し、わかりやすい段落、論理的な流れで構成されたコンテンツは、AIシステムが主要情報や文脈を把握しやすくします。さらに、スキーママークアップで機械可読なメタデータを明示することで、AIの理解力や引用率が大きく向上します。

適切なセマンティック構造には、汎用的な<div>タグではなく、<article>, <section>, <nav>, <aside>などのセマンティックHTML要素を用いることも含まれます。これによりAIシステムは各セクションの役割や重要度を理解しやすくなります。FAQスキーマ、商品スキーマ、組織スキーマなどの構造化データを組み合わせることで、AIシステムからのアクセス性がさらに向上し、AIによる回答や引用の対象になりやすくなります。

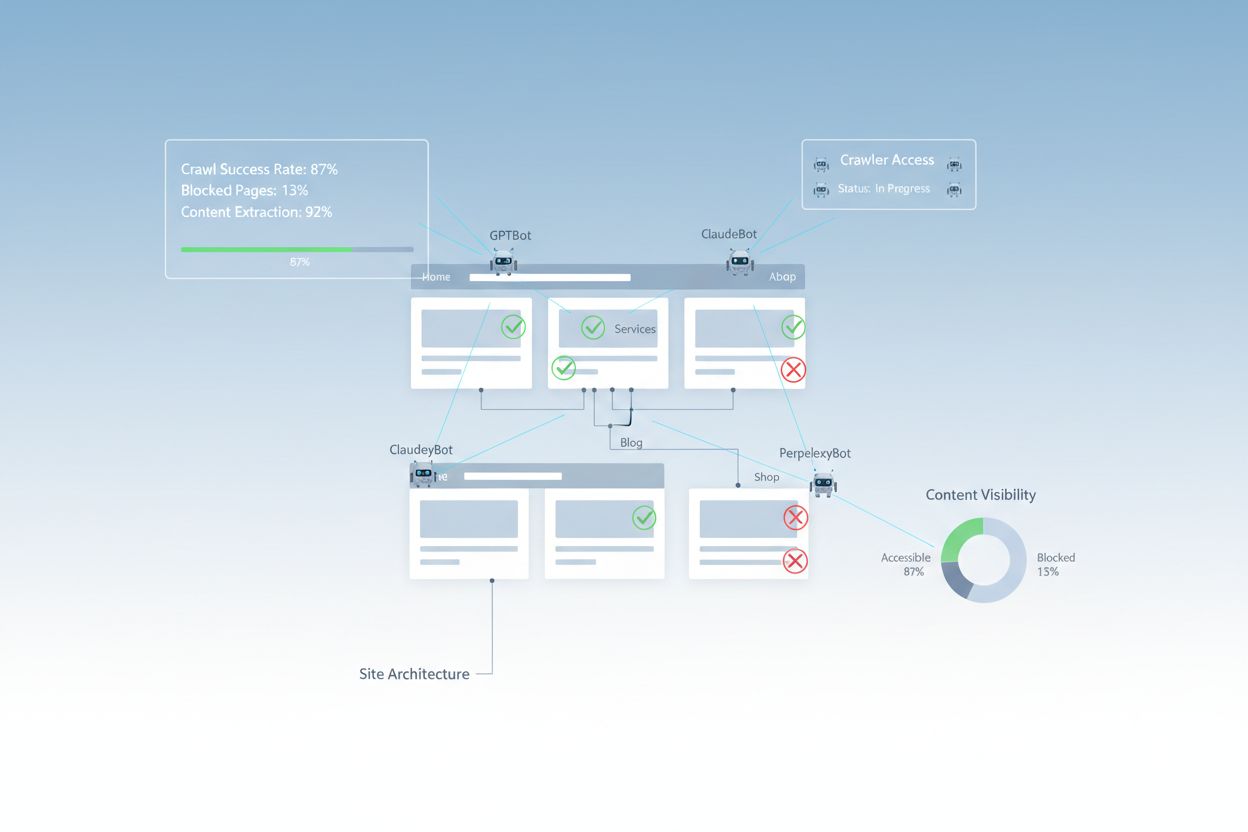

改善策を実施した後は、実際にAIクローラーがあなたのコンテンツにアクセスできているかを検証し、そのパフォーマンスを継続的にモニタリングする必要があります。サーバーログはクローラー活動の直接的な証拠となり、どのボットがどのページにアクセスし、エラーが発生したかを確認できます。Google Search ConsoleはGoogleクローラーとのやりとりを可視化し、AI可視性モニタリングツールは主要AIプラットフォームでコンテンツがどのように表示されているかを追跡します。AmICited.comはChatGPT、Perplexity、Google AIオーバービューでAIシステムがあなたのブランドをどのように参照しているかを専門的に監視し、どのページがどれだけ引用されているかを可視化します。

AIクローラーアクセスの監視・検証手法:

ウェブサイトをAIクローラーに最適化するには、戦略的かつ継続的な取り組みが求められます。AIアクセシビリティを単発のプロジェクトとせず、継続的な監視・改善プロセスとして実装するのが成功の鍵です。最も効果的な戦略は、適切な技術設定とコンテンツ最適化を組み合わせ、インフラもコンテンツもAI対応に仕上げることです。

AIアクセシビリティのDo:

AIアクセシビリティのDon’t:

最も成功するAIアクセシビリティ戦略は、クローラーをブロックすべき脅威ではなく、コンテンツ流通のパートナーとして捉えることです。ウェブサイトを技術的に健全に保ち、適切に構成し、セマンティックで分かりやすくすることで、AIシステムがあなたのコンテンツを発見・理解・引用する可能性を最大化できます。

AIアクセシビリティ監査は、AIシステム向けのセマンティック構造、機械可読コンテンツ、引用価値に重点を置きますが、従来のSEO監査はキーワード、バックリンク、検索順位に重点を置きます。AI監査はクローラーがコンテンツにアクセスし理解できるかを調べ、SEO監査はGoogle検索結果でのランキング要因に焦点を当てます。

サーバーログでGPTBot、ClaudeBot、PerplexityBotなどのAIクローラーのユーザーエージェントを確認してください。Google Search Consoleでクロール活動をモニターし、robots.txtファイルを検証ツールでテストし、AmICitedのような専門プラットフォームでAIシステムが異なるプラットフォームであなたのコンテンツをどのように参照しているかを追跡しましょう。

最も一般的な障壁は、JavaScriptレンダリング制限(AIクローラーはJavaScriptを実行できない)、Cloudflareやセキュリティツールによるブロック(企業サイトの35%がAIクローラーをブロック)、包括的なインデックスを妨げるレート制限、複雑なサイトアーキテクチャ、動的コンテンツのロードです。それぞれの障壁には異なる解決策が必要です。

ほとんどのビジネスはAIクローラーを許可することで、AI検索結果や会話型インターフェースでブランドの可視性が高まるメリットがあります。ただし、この判断はコンテンツ戦略や競争ポジション、ビジネス目標によって異なります。robots.txtを使って特定のクローラーのみを許可し、他はブロックするなど、ニーズに合わせて選択できます。

サイトのアーキテクチャやコンテンツ戦略、セキュリティ設定に大きな変更があった場合や、四半期ごとに包括的な監査を実施してください。サーバーログや専門ツールでクローラー活動を継続的に監視しましょう。新しいコンテンツセクションの公開やURL構造の変更時にはrobots.txtやサイトマップも更新してください。

robots.txtはAIクローラーアクセスを制御する主要な仕組みです。主要なAIクローラー(GPTBot、ClaudeBot、PerplexityBot)を明示的に許可しつつ、機密領域を保護するのが適切な設定です。設定ミスによりAIクローラーが完全にブロックされ、どんなに高品質なコンテンツでもAIシステムから見えなくなる場合があります。

技術的な最適化も重要ですが、セマンティックHTML構造やスキーママークアップの実装、内部リンクの強化、コンテンツの充実化など、コンテンツ最適化によってもAI可視性を改善できます。しかし、JavaScriptレンダリングやセキュリティツールによるブロックなど、技術的な障壁には技術的な解決策が必要です。

サーバーログ分析でクローラー活動を追跡し、Google Search Consoleでクロール統計を確認、robots.txtバリデータで設定を検証し、スキーママークアップバリデータで構造化データを確認、AmICitedのような専門プラットフォームでAI引用をモニターしましょう。Screaming Frogなど多くのSEOツールにもAIアクセシビリティテスト用クローラーシミュレーション機能があります。

AmICitedでChatGPT、Perplexity、Google AIオーバービュー、その他AIシステムがあなたのブランドをどのように参照しているかを追跡しましょう。AI検索可視性のリアルタイムインサイトを取得し、コンテンツ戦略を最適化できます。

AIクローラーがあなたのウェブサイトにアクセスできているかを監査する方法を学びましょう。どのボットがあなたのコンテンツを見ているのかを確認し、ChatGPT・Perplexity・その他AI検索エンジンでAIによる可視性を妨げている要因を修正しましょう。...

ChatGPT、Perplexity、GoogleのAIなどのAIクローラーにコンテンツを認識させる方法を学びましょう。AI検索での可視性を高めるための技術要件、ベストプラクティス、監視戦略を紹介します。...

ChatGPT・Claude・PerplexityなどのAIクローラーがあなたのウェブサイトのコンテンツにアクセスできるかをテストする方法を学びます。AIクロール監視のためのテスト手法・ツール・ベストプラクティスを紹介します。...

クッキーの同意

閲覧体験を向上させ、トラフィックを分析するためにクッキーを使用します。 See our privacy policy.