AIクローラー向けrobots.txtの設定方法:完全ガイド

GPTBot、ClaudeBot、PerplexityなどのAIクローラーのアクセスを制御するためのrobots.txt設定方法を解説。AI生成回答でのブランド露出を管理しましょう。...

AIクローラーを特にターゲットにしたユーザーエージェントルールを含むrobots.txtの設定。AI固有のrobots.txtにより、ウェブサイト所有者は人工知能システム、大規模言語モデル、AIトレーニングボットがコンテンツにどのようにアクセスし使用するかを制御できます。トレーニングクローラー、検索クローラー、ユーザートリガー型フェッチャーなど、異なるタイプのAIクローラーを区別し、AIシステムへのコンテンツの可視性を細かく制御できます。AIクローラーが多くのウェブサイトへのボットトラフィックの約80%を占めるようになった今、この設定は重要になっています。

AIクローラーを特にターゲットにしたユーザーエージェントルールを含むrobots.txtの設定。AI固有のrobots.txtにより、ウェブサイト所有者は人工知能システム、大規模言語モデル、AIトレーニングボットがコンテンツにどのようにアクセスし使用するかを制御できます。トレーニングクローラー、検索クローラー、ユーザートリガー型フェッチャーなど、異なるタイプのAIクローラーを区別し、AIシステムへのコンテンツの可視性を細かく制御できます。AIクローラーが多くのウェブサイトへのボットトラフィックの約80%を占めるようになった今、この設定は重要になっています。

AI固有のrobots.txt設定とは、GooglebotなどのGooglebotなどの従来の検索エンジンクローラーとは別に、人工知能クローラーやトレーニングボットを特にターゲットとするrobots.txtファイル内のターゲットルールを作成する慣行を指します。従来のrobots.txtは歴史的にGooglebot、Bingbot、その他の検索インデクサーの管理に焦点を当ててきましたが、大規模言語モデルとAIトレーニングシステムの出現により、別の管理戦略を必要とするボットトラフィックの全く新しいカテゴリが生まれました。2025年11月の最新データによると、AIクローラーは現在、多くのパブリッシャーウェブサイトへのすべてのボットトラフィックの約80%を占めており、robots.txt設定の重要性は「あればよい」SEOツールから重要なコンテンツ保護メカニズムへと根本的に変化しています。この区別が重要な理由は、AIトレーニングクローラーは検索エンジンとは異なるビジネスモデルで運営されているからです—参照トラフィックを促進するためではなく、独自のモデルをトレーニングするためにデータを収集しており、クローラーを許可して検索可視性を得るという従来のトレードオフはもはや適用されません。パブリッシャーにとって、これはrobots.txtの決定がAIシステムへのコンテンツの可視性、トレーニングデータセットでの独自コンテンツの潜在的な不正使用、AI発見の全体的なトラフィックと収益への影響に直接影響することを意味します。

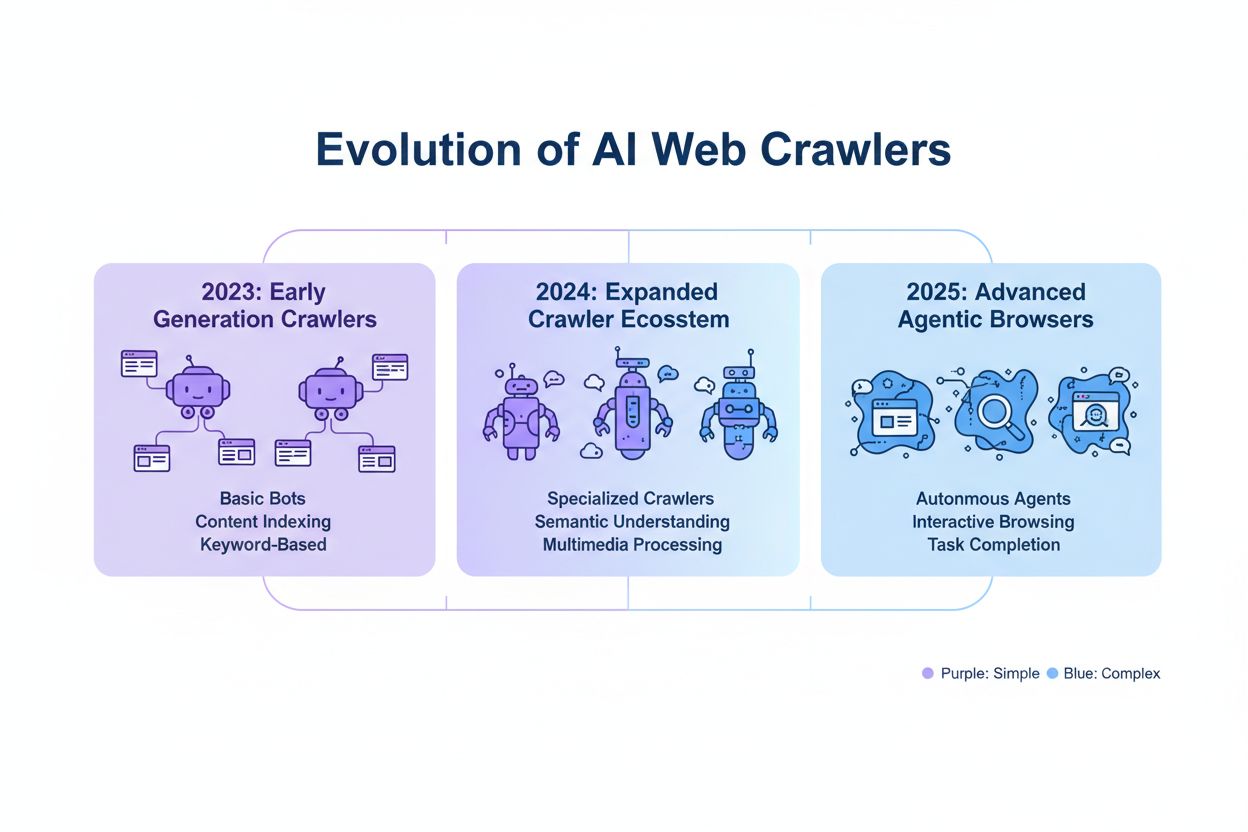

AIクローラーは3つの異なる運用カテゴリに分類され、それぞれ異なる特性、トラフィックへの影響、パブリッシャーにとっての戦略的考慮事項があります。トレーニングクローラーは機械学習モデル開発用の大量のテキストデータを収集するように設計されています;通常、高帯域幅要件で動作し、サーバーに大きな負荷をかけ、見返りに参照トラフィックはゼロです—例としてOpenAIのGPTBotとAnthropicのClaudeBotがあります。検索・引用クローラーは、取得と帰属のためにコンテンツをインデックスすることで従来の検索エンジンと同様に機能します;適度なトラフィック量を生成し、引用やリンクを通じて参照トラフィックを促進できます—このカテゴリにはOpenAIのOAI-SearchBotとGoogleのAIオーバービュークローラーが含まれます。ユーザートリガー型クローラーは、エンドユーザーがWebページのAI分析を明示的に要求したときにオンデマンドで動作します。例えば、ChatGPTのウェブブラウジング機能やClaudeのドキュメント分析機能など;これらは低いトラフィック量を生成しますが、コンテンツとの直接的なユーザーエンゲージメントを表します。この分類は戦略的に重要です。なぜなら、トレーニングクローラーは最小限のビジネス利益で最も高いコンテンツ保護懸念を提示し、検索クローラーは参照の可能性がある中間地点を提供し、ユーザートリガー型クローラーは通常ユーザーインテントに合致しコンテンツの可視性を高めることができるからです。

| クローラーカテゴリ | 目的 | トラフィック量 | 参照可能性 | コンテンツリスク | 例 |

|---|---|---|---|---|---|

| トレーニング | モデル開発 | 非常に高い | なし | 非常に高い | GPTBot、ClaudeBot |

| 検索/引用 | コンテンツインデックスと帰属 | 適度 | 適度 | 適度 | OAI-SearchBot、Google AI |

| ユーザートリガー | オンデマンド分析 | 低い | 低い | 低い | ChatGPT Web Browse、Claude |

クローラーを運用している主要AI企業には、OpenAI、Anthropic、Google、Meta、Apple、Amazonがあり、それぞれサーバーログとrobots.txt設定で識別を可能にする異なるユーザーエージェント文字列を持っています。OpenAIは複数のクローラーを運用しています:GPTBot(ユーザーエージェント:GPTBot/1.0)はトレーニングデータ収集用、OAI-SearchBot(ユーザーエージェント:OAI-SearchBot/1.0)は検索・引用インデックス用、ChatGPT-User(ユーザーエージェント:ChatGPT-User/1.0)はユーザートリガー型ウェブブラウジング用です。Anthropicの主要クローラーはClaudeBot(ユーザーエージェント:Claude-Web/1.0またはanthropic-ai)で、トレーニングとナレッジベース開発に使用されます。GoogleはGoogle-Extended(ユーザーエージェント:Google-Extended/1.1)をGeminiや他のAI製品用に運用し、MetaはコンテンツA分析にfacebookexternalhitを使用し、AppleはSiriと検索機能用にAppleBotを運用し、AmazonはAlexaと検索機能用にAmazonbotを使用しています。サーバーログでこれらのクローラーを識別するには、HTTPリクエストのUser-Agentヘッダーを調べます—ほとんどの正当なAIクローラーは、このフィールドに会社名とバージョン番号を含みます。セキュリティ強化のために、各企業が公開しているIP範囲に対して要求元のIPアドレスをチェックすることでクローラーの正当性を検証できます;OpenAIはクローラーIP範囲を公開しており、Googleや他の主要プロバイダーも同様で、正当なクローラーと偽装ユーザーエージェントを区別できます。

AI固有のrobots.txtルールの基本構文は、特定のクローラーをターゲットにしたユーザーエージェントマッチングとallow/disallowディレクティブを使用した標準的なrobots.txtフォーマットに従います。OpenAIのGPTBotからのトレーニングデータ収集をブロックしながら検索クローラーを許可するには、robots.txtを次のように構造化します:

User-agent: GPTBot

Disallow: /

User-agent: OAI-SearchBot

Allow: /

より細かい制御のために、特定のセクションをブロックしながら他を許可するパス固有のルールを適用できます—例えば、ペイウォールコンテンツやユーザー生成コンテンツセクションへのAIクローラーアクセスをブロックします:

User-agent: GPTBot

Disallow: /premium/

Disallow: /user-content/

Allow: /public-articles/

User-agent: ClaudeBot

Disallow: /

単一のルールセットの下に複数のユーザーエージェントをグループ化して、複数のクローラーに同じ制限を適用し、設定の複雑さを軽減できます。robots.txt設定のテストと検証は重要です;Google Search Consoleのrobots.txtテスターやサードパーティのバリデーターを使用して、ルールが構文的に正しく、クローラーに意図通りに解釈されることを確認できます。robots.txtは強制的ではなく勧告的であることを覚えておいてください—準拠するクローラーはこれらのルールを尊重しますが、悪意のあるアクターや非準拠のボットは完全に無視する可能性があり、機密コンテンツには追加のサーバーレベルの強制メカニズムが必要です。

AIクローラーをブロックするか許可するかの決定には、ビジネスモデルとコンテンツ戦略によって大きく異なるコンテンツ保護と可視性の間の根本的なトレードオフが含まれます。GPTBotのようなトレーニングクローラーを完全にブロックすると、補償なしにコンテンツが独自のAIモデルのトレーニングに使用されるリスクが排除されますが、AIが生成する回答にコンテンツが表示されないことも意味し、AIシステムとやり取りするユーザーからの発見とトラフィックが減少する可能性があります。逆に、トレーニングクローラーを許可すると、帰属や補償なしにコンテンツがAIトレーニングデータセットに組み込まれる可能性が高まりますが、それらのAIシステムが最終的にコンテンツを引用または参照する場合、可視性が向上する可能性があります。戦略的決定では、コンテンツの競争優位性を考慮する必要があります—独自のリサーチ、オリジナル分析、ユニークなデータはより厳格なブロッキングが必要ですが、エバーグリーンの教育コンテンツや汎用情報は、より広いAI可視性から恩恵を受ける可能性があります。異なるパブリッシャータイプは異なる計算に直面します:ニュース組織はトレーニングクローラーをブロックしながら引用トラフィックを得るために検索クローラーを許可するかもしれませんし、教育パブリッシャーはリーチを拡大するためにより広いアクセスを許可するかもしれませんし、SaaS企業は独自のドキュメントを保護するためにすべてのAIクローラーをブロックするかもしれません。サーバーログとトラフィックアナリティクスを通じてブロッキング決定の影響を監視することは、設定が意図したビジネス成果を達成しているかどうかを検証するために不可欠です。

robots.txtはクローラーポリシーを伝達する明確なメカニズムを提供しますが、根本的に勧告的であり法的に強制力がありません—準拠するクローラーはルールを尊重しますが、非準拠のアクターは完全に無視する可能性があり、追加の技術的な強制レイヤーが必要です。IP検証とホワイトリストは最も信頼性の高い強制方法を表します;OpenAI、Google、Anthropic、その他の主要AI企業が公開する正当なIPアドレスのリストを維持することで、これらのクローラーからのものと主張するリクエストが実際にそのインフラストラクチャから発信されていることを検証できます。ファイアウォールルールとサーバーレベルのブロッキングは最も強力な強制メカニズムを提供し、特定のユーザーエージェントまたはIP範囲からのリクエストがサーバーリソースを消費する前にネットワークレベルで拒否できます。Apacheサーバーの場合、.htaccess設定でクローラー制限を強制できます:

<IfModule mod_rewrite.c>

RewriteEngine On

RewriteCond %{HTTP_USER_AGENT} GPTBot [NC]

RewriteRule ^.*$ - [F,L]

</IfModule>

HTMLヘッドセクションのメタタグは、robots.txtを変更せずにページレベルでの細かいクローラーアクセス制御を提供します:

<meta name="robots" content="noindex, noimageindex, nofollowbyai">

クローラーアクティビティのサーバーログの定期チェックにより、新しいクローラーを特定し、ルールが尊重されているかを検証し、制限を回避しようとする偽装ユーザーエージェントを検出できます。KnowatoaやMerkleなどのツールは、robots.txt設定とクローラー行動の自動検証とモニタリングを提供し、どのクローラーがサイトにアクセスしているか、ディレクティブを尊重しているかの可視性を提供します。

AI固有のrobots.txt設定の継続的なメンテナンスは重要です。AIクローラーの状況は急速に進化しており、新しいクローラーが定期的に出現し、既存のクローラーがユーザーエージェント文字列と行動パターンを変更しているからです。モニタリング戦略には以下を含める必要があります:

AIクローラー技術の急速な進化は、6ヶ月前に適切だったrobots.txt設定が、現在のニーズや現在の脅威状況をもはや反映していない可能性があることを意味し、効果的なコンテンツ保護を維持するために定期的な確認と適応が不可欠です。

次世代のAIクローラーは、従来のrobots.txt設定では効果的に対処できない可能性のある新しい課題を提示しています。ChatGPT AtlasやGoogle Project Marinerのようなエージェンティックブラウザクローラーは、単純なHTTPクライアントではなく、フル機能のウェブブラウザとして動作し、JavaScriptをレンダリングし、ユーザーインタラクションを実行し、人間のユーザーと区別がつかない動作をします—これらのクローラーは独特のユーザーエージェント文字列で自身を識別しない可能性があり、robots.txtベースのブロッキングは効果がありません。多くの新興クローラーは、検出とブロッキングを回避するために標準的なChromeユーザーエージェント文字列を採用しており、robots.txtルールやその他のアクセス制御を回避するために意図的に身元を隠しています。この傾向により、パブリッシャーが正当なクローラーIPアドレスのホワイトリストを維持し、疑わしいソースからの他のすべてのトラフィックをブロックする必要がある新たな必需品としてのIPベースのブロッキングへのシフトが促進されており、ユーザーエージェントマッチングからネットワークレベルのアクセス制御へと強制モデルが根本的に変化しています。偽装ユーザーエージェントと回避技術はますます一般的になっており、悪意のあるアクターが正当なクローラーになりすましたり、検出を回避するために汎用ユーザーエージェント文字列を使用したりしています。AIクローラー管理の将来は、robots.txt設定、IP検証、ファイアウォールルール、そして潜在的に正当なクローラーと悪意のあるアクターを区別するための行動分析を組み合わせた多層的アプローチが必要になる可能性が高いです。効果的なコンテンツ保護戦略を維持しようとするパブリッシャーにとって、新興クローラー技術について情報を得続け、クローラーの倫理と標準に関する業界の議論に参加することが不可欠です。

効果的なAI固有のrobots.txt設定を実装するには、コンテンツ保護と戦略的可視性目標のバランスを取る包括的なアプローチが必要です。どのコンテンツカテゴリがブロッキングを必要とするか(独自のリサーチ、プレミアムコンテンツ、ユーザー生成コンテンツ)と、どのコンテンツがAIクローラーに安全に公開できるか(公開記事、教育コンテンツ、汎用情報)を定義する明確なコンテンツ保護ポリシーから始めます。すべてのAIクローラーに一括で許可またはブロックするアプローチではなく、トレーニングクローラー(通常ブロック)、検索クローラー(通常モニタリングしながら許可)、ユーザートリガー型クローラー(通常許可)を区別する階層化されたブロッキング戦略を実装します。robots.txtだけでは強力なコンテンツ保護には不十分であることを認識し、最も機密性の高いコンテンツにはファイアウォールルールとIP検証を実装してrobots.txtとサーバーレベルの強制を組み合わせます。ブロッキング決定がAI生成回答、引用、AI搭載検索機能での可視性にどのように影響するかを考慮して、AIクローラー管理をより広いSEOとコンテンツ戦略に統合します—この統合により、robots.txt設定が全体的なビジネス目標を損なうのではなく支援することを確保します。週次ログレビュー、月次IP検証、四半期ごとの包括的監査を含むモニタリングとメンテナンスのケイデンスを確立し、クローラー環境が進化するにつれて設定が効果的であり続けることを確保します。AmICited.comのようなツールを使用してAIシステム全体でのコンテンツの可視性を監視し、AI発見と引用に対するブロッキング決定の影響を理解します。異なるパブリッシャータイプ向け:ニュース組織は通常、引用トラフィックを最大化するためにトレーニングクローラーをブロックしながら検索クローラーを許可すべきです;教育パブリッシャーはリーチを拡大するためにより広いアクセスを許可することを検討すべきです;SaaS企業は独自のドキュメントに対して厳格なブロッキングを実装すべきです。偽装ユーザーエージェントや非準拠クローラーによりrobots.txtブロッキングが不十分であることが判明した場合は、ファイアウォールルールとIPベースのブロッキングにエスカレートして、ネットワークレベルでコンテンツ保護ポリシーを強制してください。

GPTBotやClaudeBotのようなトレーニングクローラーはモデル開発用のデータを収集し、参照トラフィックはゼロであるため、コンテンツ保護のリスクが高いです。OAI-SearchBotやPerplexityBotのような検索クローラーはAI搭載検索用にコンテンツをインデックスし、引用を通じて参照トラフィックを送る可能性があります。ほとんどのパブリッシャーは、コンテンツ保護と可視性のバランスを取りながら、トレーニングクローラーをブロックし検索クローラーを許可します。

Googleは公式に、Google-Extendedをブロックしても検索ランキングやAIオーバービューへの掲載には影響しないと述べています。ただし、一部のウェブマスターは懸念を報告しているため、ブロックを実装した後は検索パフォーマンスを監視してください。Google検索のAIオーバービューはGoogle-Extendedではなく、標準のGooglebotルールに従います。

はい、robots.txtは強制力のある規則ではなく、勧告的なものです。主要企業の行儀の良いクローラーは一般的にrobots.txtディレクティブを尊重しますが、一部のクローラーは無視します。より強力な保護のために、.htaccessやファイアウォールルールを介したサーバーレベルのブロッキングを実装し、公開されているIPアドレス範囲を使用して正当なクローラーを検証してください。

少なくとも四半期ごとにブロックリストを確認し更新してください。新しいAIクローラーは定期的に出現するため、サーバーログを毎月チェックして、サイトにアクセスしている新しいクローラーを特定してください。ai.robots.txt GitHubプロジェクトなどのコミュニティリソースを追跡して、新興クローラーとユーザーエージェント文字列の更新を確認してください。

これはビジネスの優先事項によります。トレーニングクローラーをブロックすると、補償なしにコンテンツがAIモデルに組み込まれることからコンテンツを保護できます。検索クローラーをブロックすると、ChatGPT検索やPerplexityなどのAI搭載発見プラットフォームでの可視性が低下する可能性があります。多くのパブリッシャーは、トレーニングクローラーをターゲットにしながら検索・引用クローラーを許可する選択的ブロッキングを選択しています。

サーバーログでクローラーのユーザーエージェント文字列を確認し、ブロックされたクローラーがコンテンツページにアクセスしていないことを確認してください。アナリティクスツールを使用してボットトラフィックパターンを監視してください。Knowatoa AI Search ConsoleやMerkle robots.txt Testerなどの設定をテストして、ルールが意図通りに機能していることを検証してください。

ChatGPT AtlasやGoogle Project Marinerのようなエージェンティックブラウザクローラーは、単純なHTTPクライアントではなく、フル機能のウェブブラウザとして動作します。標準的なChromeユーザーエージェント文字列を使用することが多く、通常のブラウザトラフィックと区別がつきません。これらの高度なクローラーへのアクセスを制御するには、IPベースのブロッキングが必要になります。

AI固有のrobots.txtはコンテンツへのアクセスを制御し、AmICitedのようなツールはAIプラットフォームがコンテンツをどのように参照し引用するかを監視します。一緒に、完全な可視性と制御を提供します:robots.txtがクローラーアクセスを管理し、モニタリングツールがAIシステム全体でのコンテンツの影響を追跡します。

AmICitedは、ChatGPT、Claude、Perplexity、Google AIオーバービューなどのAIシステムがブランドをどのように引用し参照するかを追跡します。robots.txtの設定とAI可視性モニタリングを組み合わせて、AIプラットフォーム全体でのコンテンツの影響を理解しましょう。

GPTBot、ClaudeBot、PerplexityなどのAIクローラーのアクセスを制御するためのrobots.txt設定方法を解説。AI生成回答でのブランド露出を管理しましょう。...

GPTBot、PerplexityBot、ClaudeBotなどのAIボットによるサイトクロールの許可方法を解説します。robots.txt・llms.txtの設定やAI向け最適化の方法もわかります。...

GPTBot、ClaudeBot、PerplexityBotなどのAIクローラー向けrobots.txt設定に関するコミュニティディスカッション。ウェブマスターやSEOスペシャリストによる、AIクローラーアクセスのブロックと許可の実体験を共有。...