BERTとは何か、2024-2025年でも重要か?

BERTの概要、アーキテクチャ、用途、現在の関連性について学びます。BERTと最新の代替技術を比較し、なぜNLPタスクに不可欠であり続けるのかを理解しましょう。...

BERTアップデートは、Googleが2019年10月に発表した検索アルゴリズムの改良で、双方向のトランスフォーマーモデル(Bidirectional Encoder Representations from Transformers)を用いて検索クエリにおける自然言語理解を強化します。これにより、Googleは会話的で複雑な検索フレーズの文脈や前置詞、意味をより正確に理解できるようになり、全検索クエリの約10%に影響を与えました。

BERTアップデートは、Googleが2019年10月に発表した検索アルゴリズムの改良で、双方向のトランスフォーマーモデル(Bidirectional Encoder Representations from Transformers)を用いて検索クエリにおける自然言語理解を強化します。これにより、Googleは会話的で複雑な検索フレーズの文脈や前置詞、意味をより正確に理解できるようになり、全検索クエリの約10%に影響を与えました。

BERTアップデートは、2019年10月25日に発表されたGoogle検索アルゴリズムの大規模な改良で、検索エンジンによる自然言語の理解方法を根本的に変えました。BERTとはBidirectional Encoder Representations from Transformers(双方向エンコーダー表現 from トランスフォーマー)の略で、ニューラルネットワークに基づく自然言語処理技術です。これによりGoogleは検索クエリにおける単語の文脈、ニュアンス、意味を把握できるようになりました。BERTは単語を個別または左から右へ順番に分析するのではなく、双方向からテキストを同時に処理し、各単語が周囲のすべての単語とどのように関係するかを一度に考慮します。これにより、Googleは複雑で会話的なクエリの文脈的意味をより深く理解できるようになりました。Googleの検索担当副社長Pandu Nayakによる公式発表によれば、このアップデートは過去5年間で最大級の検索技術の進歩であり、全検索クエリの約10%(米国だけでも1日約5億6千万件)に影響を及ぼしています。BERTアップデートは、特に長文や自然な会話調の検索クエリで、前置詞や単語間の文脈的関係がユーザー意図の理解に不可欠となる場合に、検索結果を大きく改善することを目的としています。

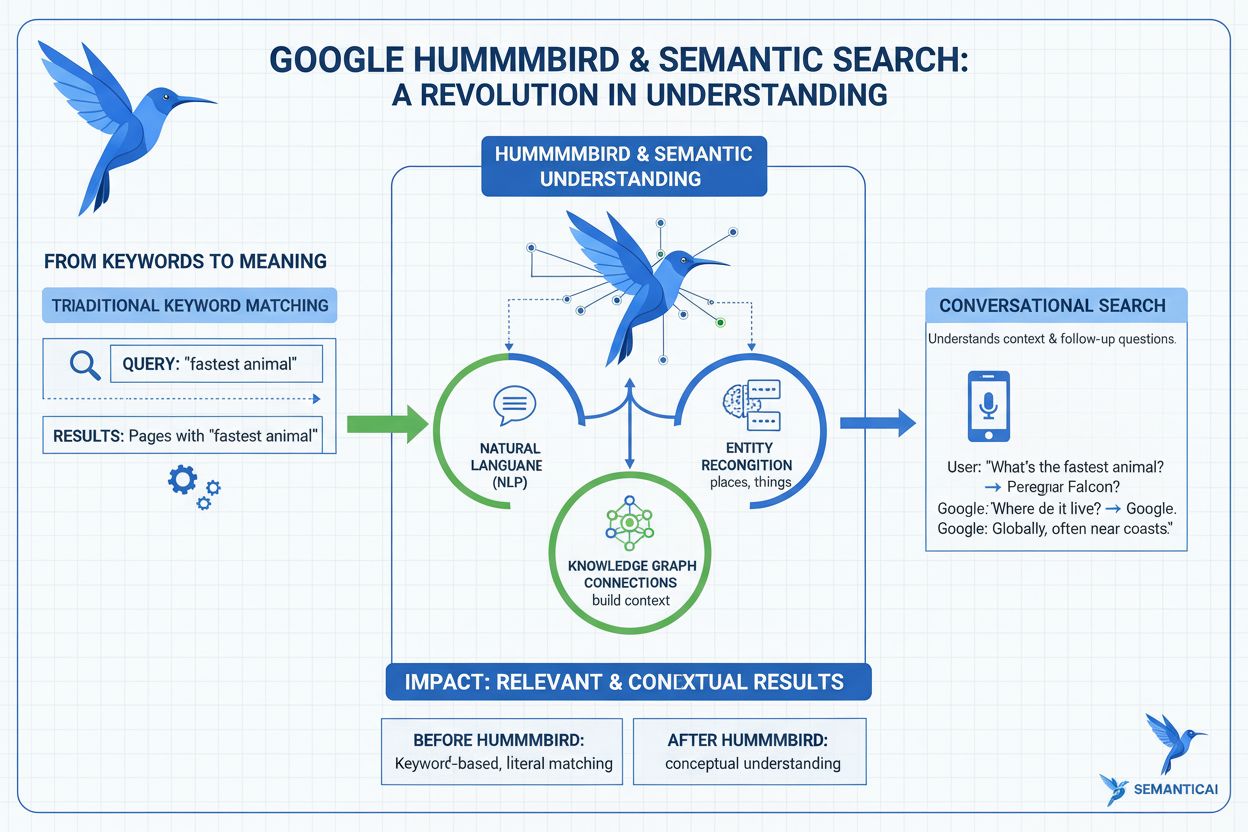

BERTの開発は、Googleにおける長年の自然言語処理と機械学習研究の集大成です。Googleの研究者は2018年10月にBERTをオープンソースのフレームワークとして公開し、それ以前のトランスフォーマー型ニューラルネットワークの進歩を基盤としました。この技術は、単なるキーワード一致から意味理解(セマンティックサーチ)への転換を目指すGoogleの長期的な取り組みの一部であり、その流れは2013年のHummingbirdアップデートや2015年のRankBrainへと続きました。ただし、RankBrainは未知のクエリを類似クエリにマッチングするアプローチでしたが、BERTは根本的に異なり、テキストを双方向から「読む」方式を導入しました。このブレークスルーは、機械学習の進展と、Googleが世界規模で検索結果に活用できるCloud TPU(テンソルプロセッシングユニット)といった強力な計算基盤の普及によって実現されました。Google AIの研究チームは、従来のアルゴリズムでは「for」「to」「no」などの小さな単語の重要性を理解できず、ユーザー意図を誤解することが多い課題を認識していました。BERTの双方向学習手法は、文章の中のすべての単語の完全な文脈を考慮できるため、この問題を解決しました。

BERTは高度なニューラルネットワークアーキテクチャによって、従来のアルゴリズムとは本質的に異なるアプローチで言語を処理します。最大の革新は双方向処理であり、テキストを左から右、右から左へ順次読むのではなく、文中のすべての単語を同時に分析し、それぞれの単語の意味を周囲の単語との関係から理解します。これはトランスフォーマーモデルのアテンションメカニズムによって実現され、単語同士の重要度や関連性を動的に重み付けします。ユーザーが検索クエリを入力すると、BERTはテキストをトークン(単語や語句)に分割し、複数層のトランスフォーマーエンコーダーで処理します。各層で単語間の関係や文脈理解が洗練されていきます。双方向性が重要であり、BERTは単語の前後の文脈両方を考慮して意味を把握します。例えば「do estheticians stand a lot at work(エステティシャンは仕事中よく立つのか)」というクエリでは、「stand」が「スタンドアローン」ではなく職務上の立ち仕事(動詞)を意味しているとBERTは文脈から判断します。こうした双方向処理により、多義語や曖昧な単語の意味の区別、前置詞の重要性、従来見逃されていた微妙な言語ニュアンスも正確に理解できるようになりました。BERTは大量のラベルなしテキストデータで事前学習され、手動のアノテーションを必要とせずに言語パターンや意味的関係を学習しています。

BERTアップデートは、検索結果に対して特に複雑かつ会話的なクエリで実質的な効果をもたらしました。Googleの公式発表では実際の事例がいくつか紹介されています。例えば「2019 Brazil traveler to USA need a visa(2019年 ブラジルから米国への旅行者 ビザ必要)」というクエリでは、BERT導入前はキーワード一致に偏り、アメリカ人がブラジルを訪れる場合の情報ばかり表示されていましたが、BERT導入後は「to」が示す方向性を正しく理解し、ブラジル人が米国に渡航する場合のビザ情報を返すようになりました。また「do estheticians stand a lot at work」では、「stand」が職務上の立ち仕事を意味していることをBERTが理解し、無関係な「スタンドアローン」に関する検索結果が減りました。こうした改善により、ユーザーは**「キーワード語(keyword-ese)」と呼ばれる不自然なキーワードの羅列ではなく、自然な会話体で検索できるようになり、Googleはその意図をより正確に把握できるようになりました。特に音声検索**では長文かつ会話的なクエリが多いため、BERTの恩恵が大きくなります。また、強調スニペットにもBERTモデルが適用され、ユーザーの質問に最も正確かつ簡潔に答えるコンテンツ部分を特定し、より適切なポジションゼロ結果が表示されるようになりました。

| アルゴリズム | リリース年 | 主な目的 | 処理方法 | 影響クエリ比率 | 主な革新点 |

|---|---|---|---|---|---|

| RankBrain | 2015 | 未知クエリの理解 | 順序的パターンマッチング | 約15% | 類似性マッチによる未見クエリ対応 |

| BERT | 2019 | 文脈的言語理解 | 双方向トランスフォーマー分析 | 約10% | 双方向同時処理による完全な文脈把握 |

| MUM | 2021(限定展開) | マルチモーダル・多言語理解 | マルチタスク統合モデル | 拡大中 | BERTの1000倍の処理力、画像・動画・テキスト対応 |

| Hummingbird | 2013 | 自然言語検索 | セマンティックキーワード分析 | 約90% | セマンティックサーチ・会話的検索導入 |

| Panda | 2011 | コンテンツ品質評価 | コンテンツ評価 | 可変 | 低品質・薄いコンテンツのペナルティ |

BERTアップデートは、従来のキーワード最適化重視のSEOからセマンティックSEOとユーザー意図重視への大きな転換を促しました。BERTは自然で文脈に合った高品質なコンテンツを評価するため、SEO担当者は戦略の見直しを迫られました。特にキーワード詰め込みや不自然なキーワード配置はさらに効果が薄くなり、BERTは自然な言語表現と人工的なキーワード挿入を区別できるようになっています。コンテンツ制作者は特定のキーワードフレーズの最適化ではなく、明確で文法的に正しい、ユーザーの質問に実直に答えるコンテンツ作成に注力する必要があります。またトピッククラスターや包括的な内容の網羅性も重要となり、単一キーワードではなく関連語や概念を自然に盛り込んだ深い解説が求められます。強調スニペットの競争も激化し、BERTがより役立つ明快な回答を持つページを選びやすくなりました。加えて、これまで見過ごされがちだった前置詞や小さな接続詞も意味理解上重要となり、正しく自然に使われていることが求められます。ロングテールキーワードや会話的フレーズの価値も増し、BERTはこうした自然言語パターンの理解に優れています。ただし、BERTは従来のSEO基礎(被リンク、サイト速度、モバイル最適化、技術的SEO)を置き換えるものではありません。BERTの登場で、コンテンツの品質・明瞭さ・意味的関連性がかつてないほど重要となったのです。

BERTはGoogle検索向けに開発されましたが、その原理や基盤技術は他のAIシステムの自然言語処理にも影響を与えています。ChatGPT、Claude、Perplexity、Google AI Overviewsなどは、いずれも類似のトランスフォーマー型アーキテクチャや双方向処理を用いてユーザーのクエリ理解や回答生成を行っています。そのため、BERTの自然言語処理手法を理解することは、さまざまなAIプラットフォームで自社コンテンツの露出状況を把握する上でも重要です。Google AI Overviews(旧SGE)では、BERTの文脈理解が、どの情報源が引用されるかやコンテンツの要約方法に影響します。アルゴリズムが意味を理解できるため、クエリと完全一致していなくても、ユーザー意図に合致した内容が選ばれやすくなります。Perplexity AIでは、出典明示や会話的検索が重視され、BERT的な処理が複雑な質問への最適な回答源特定に役立っています。ChatGPTやClaudeもBERTに似たトランスフォーマーアーキテクチャを、より大規模に展開し、ユーザーリクエストの微妙なニュアンス理解や適切なレスポンス生成を実現しています。つまり、BERTの原則に沿ったコンテンツ(明確・文脈適合・自然な文章・ユーザー意図重視)は、これらAIプラットフォームでも引用・掲載されやすくなります。AmICitedを活用してAI検索でのブランド露出を監視する企業や制作者にとって、BERTの意味重視アプローチを理解することは、AIシステムに選ばれるコンテンツ最適化のカギとなります。

2019年の導入以来、BERTは進化を続け、Googleの検索アルゴリズム開発に大きな影響を与えています。BERTはMUM(Multitask Unified Model、2021年5月発表)の基盤となり、GoogleはMUMを「BERTの1,000倍強力」と説明しています。MUMはBERTの能力を拡張し、複数タイプのコンテンツ(テキスト・画像・動画)を同時に処理し、個々の言語ごとに別途学習せずとも異言語間で情報を理解できるようになりました。これはAIによる包括的な情報理解への大きな飛躍です。今後の検索における自然言語処理の進化は、意味理解・ユーザー意図認識・文脈関連性重視の傾向がさらに強まることを示唆しています。AIの高度化とともに、キーワード一致と意味理解の差はより明確になり、今後のアルゴリズム更新は高品質で自然なコンテンツを一層評価する方向へ進むと予想されます。生成AIが検索結果に登場する時代には、BERTのようなアルゴリズムがコンテンツをどう解釈しているかを知ることが、適切な引用・露出確保の上で不可欠になります。また、音声検索や会話型AIの拡大により、BERTの自然言語処理能力は今後も重要性を保ち続けます。BERTの原則は検索以外にも応用されており、コンテンツのモデレーションや感情分析など多様な自然言語処理タスクで利用が進んでいます。AIシステムで自社ブランドの露出を監視する組織にとって、BERTや関連技術への理解は、なぜ特定のコンテンツがAI回答に選ばれ、他が選ばれないのかを説明する助けとなります。今後の検索は、ユーザー意図・文脈・意味理解の一層高度な把握へと進化し、BERTが築いた基盤の上に発展していくでしょう。

BERT対応および最新の検索結果での可視性維持のため、コンテンツ制作者は以下の実証的な施策を実践しましょう。自然かつ会話的な文章で執筆する:人間らしく読みやすい表現を使い、キーワード詰め込みではなく明快なコミュニケーションを心がけましょう。ユーザー意図を重視する:ユーザーがそのトピックを検索する真の目的を理解し、それに直接応えるコンテンツを作成しましょう。包括的なトピックカバー:個別キーワード狙いではなく、トピック全体を深く掘り下げ、関連概念や用語も自然に取り入れましょう。明確な構造を持たせる:見出し・小見出し・箇条書き・論理的な流れで、読者と検索エンジン双方が内容の組織と意味を理解しやすくします。質問に直接答える:FAQやよくある質問への明確な回答を含めると、BERTによる質問型クエリとのマッチ精度が高まります。文法の正確さを維持:BERTは文法の正誤も判別できるため、正しい文法と構文を重視しましょう。前置詞や接続詞も自然に使う:「for」「to」「by」「with」などの小さな単語も自然に使い、意味の伝達に貢献させましょう。人間のためのコンテンツ作成を優先:BERTは本当にユーザーの役に立つ内容を評価します。アルゴリズム向けではなく、読者ファーストの価値あるコンテンツを目指しましょう。構造化データを実装する:スキーママークアップで検索エンジンに意味や文脈を伝え、BERTの自然言語理解を補完しましょう。ロングテールや会話的キーワードのパフォーマンスを監視する:より自然な長文検索での効果測定を行い、BERTの改善が発揮される領域を把握しましょう。

+++

BERTはBidirectional Encoder Representations from Transformers(双方向エンコーダー表現 from トランスフォーマー)の略です。Googleの研究者が2018年10月にBERTをオープンソースの機械学習フレームワークとして発表し、2019年10月25日にGoogleが検索ランキングへ正式に導入しました。このアップデートは直近5年で最も大きなGoogle検索の改善の一つとなり、検索エンジンによる自然言語クエリの処理と理解方法を根本的に変えたものです。

RankBrain(2015年)は、未知の検索クエリを既存の類似クエリにマッチさせることでGoogleの理解を助けていましたが、BERTはテキストを双方向から読み取り、単語を前後の文脈すべてと同時に分析します。これにより、BERTは文脈や前置詞、細かな意味の違いをRankBrainよりも正確に理解できるため、「for」や「to」などの小さな単語で意味が大きく変わる長文・会話的クエリに特に有効です。

Googleによると、BERTは米国の英語検索クエリ全体の約10%、つまり1日約5億6千万件に影響を与えています。また、このアップデートは世界24カ国の複数言語の強調スニペットにも影響を及ぼしており、検索結果の関連性と精度を向上させるグローバルな意義を持ちます。

モバイル最適化のようにBERT専用の最適化手法はありません。その代わり、BERTは自然で高品質なコンテンツやユーザーの質問に明確に答える内容を評価します。文法的に正しく、文脈に合った内容でユーザー意図を的確に満たすことに集中しましょう。自然な言語を使い、トピックを網羅的に解説し、実際に役立つ情報を提供することが、BERTの重視する意味理解に沿う最良の方法です。

BERTは双方向処理を用いて、テキストを左右両方向から同時に読み、各単語が文中の他のすべての単語とどう関係するかを理解します。これにより、クエリ全体の文脈や細かな意味が把握できます。例えば「Brazil traveler to USA needs visa(ブラジルから米国に渡航する人 ビザ必要)」の場合、「to」がブラジルから米国への方向性を示していることをBERTは理解し、より適切な結果を返します。

Googleは検索ランキングだけでなく強調スニペットにもBERTモデルを適用しています。BERTは、どのコンテンツ部分がユーザーの質問に最も正確かつ簡潔に答えているかを理解し、より適切なスニペット選出を実現します。つまり、よく構成された明確な回答を持つページがポジションゼロ(強調スニペット)に選ばれやすくなり、BERTによって関連性と回答の質をより正確に評価できるようになっています。

BERTは音声検索の精度を大きく向上させます。音声検索は入力が会話的かつ自然な傾向が強いため、BERTの自然言語理解や長文・文脈把握の強みが発揮されます。ユーザーは「キーワード語」ではなく自然な質問をそのまま話しても、BERTが意図をより正確に理解して適切な検索結果を返します。

いいえ、BERTは従来のSEO基礎要素を置き換えるものではなく、あくまで補完的な存在です。被リンク、サイト速度、モバイル最適化、技術的SEOは引き続き重要なランキング要素です。BERTは主にコンテンツの意味やユーザー意図の理解を向上させるもので、他のランキングシグナルと組み合わさって機能します。総合的なSEO戦略が必要なのは変わらず、BERTの登場でコンテンツの品質や自然言語の明確さがより重視されるようになりました。

ChatGPT、Perplexity、その他のプラットフォームでAIチャットボットがブランドを言及する方法を追跡します。AI存在感を向上させるための実用的なインサイトを取得します。

BERTの概要、アーキテクチャ、用途、現在の関連性について学びます。BERTと最新の代替技術を比較し、なぜNLPタスクに不可欠であり続けるのかを理解しましょう。...

GPT-4などの大規模言語モデル時代において、BERT最適化が依然として重要かどうかに関するコミュニティの議論。SEOとAI検索における変化を理解する。...

ハミングバード・アップデートとは何か、2013年にセマンティック検索をどのように革新したのか、そしてAIによるモニタリングやブランドの検索可視性においてなぜ重要なのかを解説します。...

クッキーの同意

閲覧体験を向上させ、トラフィックを分析するためにクッキーを使用します。 See our privacy policy.