クロールバジェット

クロールバジェットは、検索エンジンが一定期間内にあなたのウェブサイトをクロールするページ数です。インデックスやSEOパフォーマンスを向上させるためのクロールバジェット最適化方法を学びましょう。...

クローキングは、検索エンジンと人間のユーザーに異なるコンテンツを表示し、検索順位を操作しアルゴリズムや訪問者を欺くことを目的としたブラックハットSEOの手法です。この行為は検索エンジンのガイドラインに違反し、インデックス削除を含む重大なペナルティを受ける可能性があります。

クローキングは、検索エンジンと人間のユーザーに異なるコンテンツを表示し、検索順位を操作しアルゴリズムや訪問者を欺くことを目的としたブラックハットSEOの手法です。この行為は検索エンジンのガイドラインに違反し、インデックス削除を含む重大なペナルティを受ける可能性があります。

クローキングとは、ウェブサイトが検索エンジンクローラーと人間のユーザーに異なるコンテンツやURLを提示する欺瞞的なブラックハットSEO手法です。クローキングの主な目的は、ボットには最適化されたキーワードリッチなコンテンツを見せ、実際の訪問者には全く異なる、または質の低いコンテンツを表示することで検索順位を操作することです。この行為は検索エンジンのガイドライン、特にGoogleのウェブマスターガイドラインに明確に違反しており、SEO業界でも最も重大な違反行為の一つとされています。“クローキング"という言葉自体が、ウェブページの本来の内容を隠蔽または偽装し、検索アルゴリズムには実際よりも関連性が高いように見せかける行為を指します。実装時には、サーバー側でリクエストが検索エンジンクローラーか人間のブラウザかを識別し、それに応じて異なるレスポンスを返す条件分岐が行われます。

クローキングは2000年代初頭、検索エンジンアルゴリズムが未熟で検出能力も限られていた時代に広く普及した初期のブラックハットSEO手法の一つです。当時の実践者は、Googlebotにはキーワードを詰め込んだ最適化コンテンツを提供し、訪問者には見やすいクリーンなページを表示することで、実際に価値あるコンテンツを作らなくても高順位を得られることを発見しました。この手法は特にスパマーやアダルトサイト、ギャンブルサイトなどが短期間で順位を上げるために多用しました。しかし、検索エンジンの進化や検出アルゴリズムの高度化により、クローキングは次第にリスクが高い手法となりました。2010年代半ばには、Googleは高度なクロールシミュレーションや機械学習モデルを導入し、クローキングの識別能力を大幅に向上させました。2012年にカリフォルニア大学サンディエゴ校の研究者が行った画期的な調査では、クローキングされた検索結果の約35%が純粋なユーザーエージェントクローキングを利用していたことが明らかになりました。今日では、ペナルティの厳格化と検出技術の進歩によりクローキングは大幅に減少しましたが、AI特化型クローキングなど新たな変種も登場しています。

クローキングは、サーバー側での識別と条件付きコンテンツ配信によって動作し、検索エンジンクローラーと人間ユーザーを区別するために複数の技術的シグナルを利用します。最も一般的な識別方法はユーザーエージェント解析で、リクエスト時に送信されるユーザーエージェント文字列を解析し、GooglebotやBingbot、Slurpなど既知の検索エンジンボットを特定します。もう一つの代表的手法はIPベース識別で、訪問者のIPアドレスを主要検索エンジンの既知IPレンジと照合します。サーバーはHTTPヘッダー(Accept-LanguageやRefererなどのヘッダーやリクエストメタデータ)も参照し、ルーティング判断を行うこともあります。クローラーかユーザーかを判定後、条件分岐により異なるコンテンツバージョンを配信します。例えば、クローキングサイトはGooglebotにはキーワード満載で最適化メタデータ付きのページを、同じURLへアクセスした人間には画像ギャラリーや全く無関係な内容を配信することがあります。高度な実装ではJavaScriptベースクローキングも利用され、ユーザーには最小限のコンテンツだけを最初に表示し、検索エンジンにはプリレンダリングされた最適化HTMLを返します。リダイレクト型クローキングもあり、HTTPリダイレクトやmeta-refreshタグを使ってクローラーとユーザーを別々のページに誘導します。

ユーザーエージェントクローキングは最も一般的な手法で、研究によればクローキング検出サイトの約35%を占めます。この手法は、ブラウザやクローラーが送信するユーザーエージェント文字列を検知し、その内容が既知の検索エンジンボットかどうかで配信コンテンツを分けます。たとえば、ユーザーエージェントに"Googlebot"が含まれていれば最適化ページを、それ以外(Chrome、Firefox、Safari等)には別バージョンを配信します。IPベースクローキングは、訪問者のIPアドレスを検索エンジンのIP帯と照合し、一致した場合のみ最適化コンテンツを配信し、それ以外には別内容を提供します。この手法は、競合他社のIPだけ異なる内容を見せるなど、特に悪質です。隠しテキスト・リンクは、CSSやJavaScriptを使ってユーザーから見えないキーワード満載のテキストやリンクを検索エンジンには見せる手法です。テキスト色と背景色を揃えたり、画面外へ配置したり、display:noneプロパティを使ったりします。HTTPアクセプトランゲージクローキングは、HTTPリクエストの言語ヘッダーを参照してクローラーとユーザーを区別し、言語シグナルに応じてローカライズや最適化コンテンツを配信します。ドアウェイページは、特定検索クエリ用にキーワード最適化した薄いページを作成し、ユーザーを全く別のページへリダイレクトします。**CNAMEクローキング(DNSクローキング)**は、DNSレコードを偽装してサードパーティドメインをファーストパーティドメインのように見せかけ、トラッキング等のデータ収集を正規サイトの一部として偽装します。リファラー基準クローキングは、参照元ウェブサイトによって表示内容を切り替え、検索結果から来たユーザーと直接訪問や他サイトからの訪問で異なる内容を見せます。

| 項目 | クローキング | プリレンダリング | フレキシブルサンプリング | プログレッシブエンハンスメント | パーソナライズ |

|---|---|---|---|---|---|

| 意図 | 操作・欺瞞 | 正当な最適化 | 透明なアクセス | UX向上 | ユーザー重視のカスタマイズ |

| クローラー向け内容 | 異なる/最適化済み | ユーザーと同じ | 全コンテンツ閲覧可 | コアコンテンツ閲覧可 | 基本内容は同一 |

| ユーザー向け内容 | 異なる/劣化 | クローラーと同じ | クローラーと同じ | 体験向上版 | カスタマイズだが透明 |

| 検索エンジン遵守 | ガイドライン違反 | 準拠 | 準拠 | 準拠 | 準拠 |

| 検出リスク | 高/不可避 | なし | なし | 低 | なし |

| ペナルティリスク | 深刻(インデックス削除) | なし | なし | なし | なし |

| 用途 | スパム・操作 | JavaScriptサイト | 有料コンテンツ | 動的コンテンツ | ユーザー嗜好 |

| 回復難易度 | 数ヶ月〜数年 | 該当なし | 該当なし | 該当なし | 該当なし |

厳しいペナルティや検出リスクが知られているにも関わらず、一部のサイト運営者がクローキングを用いる理由はいくつかあります。技術的制限の即席対策が主な動機で、JavaScriptやFlash、画像中心のレイアウトに依存したサイトは、ユーザーにはビジュアルデザインを、クローラーにはテキストベースのバージョンを見せるためにクローキングを使うことがあります。JavaScriptレンダリングの最適化や構造改善を行う代わりに、クローキングは一時的な"近道"となります。順位操作も大きな動機で、検索エンジンにはキーワード詰め込みの最適化コンテンツを、ユーザーには異なる内容を提供することで、正当な最適化をせずに上位表示を狙います。悪意ある活動の隠蔽もあり、ハッカーがサイトを乗っ取り、リダイレクトやマルウェア、フィッシングをサイト管理者やセキュリティスキャナから隠す目的でクローキングを使うことがあります。競争優位の追求で、検索エンジンにだけ最適化コンテンツを見せて競合より上位を狙う例もあります。ペナルティや検出技術への無知から、リスクを理解せずクローキングを導入するケースも少なくありません。カリフォルニア大学サンディエゴ校の2012年の研究では、クローキングサイトの約45%が3ヶ月後も活動を継続していたことから、検出回避できると信じている運営者も一定数存在することがわかります。

クローキングが発覚すると、検索エンジンは順位低下から完全なインデックス削除まで深刻なペナルティを科します。アルゴリズムペナルティは、検索エンジンの自動検出によって即座に発動し、該当ページやドメイン全体の順位が大幅に下落します。これらのペナルティは数日で発生し、クローキング削除後も数ヶ月継続することが多いです。手動対策はGoogleのスパムチームなど人間による審査によって発動し、アルゴリズム検出よりさらに厳しい制裁となります。Googleからクローキングの手動対策が下されると、Search Consoleに通知が届き、詳細な修正報告と再審査リクエストが必要です。完全なインデックス削除は最も深刻な影響で、Googleのインデックスからサイト全体が消去され、オーガニック流入がゼロになります。インデックス削除されたサイトは信頼回復が困難で、新ドメインへの移行が必要な場合もあります。ドメイン全体への影響として、単一ページだけでなくサイト全体の順位やキーワードが打撃を受けます。ブランドの信頼失墜も避けられず、欺かれたことを知ったユーザーの離脱や悪評、長期的な信用低下につながります。トラフィックの壊滅も深刻で、インデックス削除や順位暴落後、数週間で流入が80~95%減少することも珍しくありません。クローキングペナルティからの回復には通常6〜12ヶ月以上の継続的かつ適正な最適化作業が必要で、元の順位を完全に回復できないケースもあります。

クローキング検出には、検索エンジンとユーザーに提供されるコンテンツを比較するための様々なテストやツールが使われます。手動比較は、通常のブラウザでページを閲覧し、Google Search ConsoleのURL検査やFetch as Google機能でGooglebotの見え方を確認する方法です。この2つの表示に大きな差があれば、クローキングの可能性があります。自動クローキング検出ツール(SiteCheckerやDupliCheckerなど)は、複数のユーザーエージェントやIPアドレスからページを解析し、隠しテキストや不審なリダイレクト、コンテンツの不一致を検出します。サーバーログ解析では、サーバーが異なるユーザーエージェントやIPへのレスポンスパターンを分析し、クローキング特有の傾向を見つけます。SERPスニペット比較は、検索結果に表示されるメタディスクリプションやタイトルタグが実際のページに存在するかを確認し、不一致があればクローキングを疑います。クロール監視ツールは、検索エンジンのクロール状況や急なインデックス変化、ブロックリソース、不審なクローラー挙動を検出します。セキュリティ監査では、ハッキングによる不正クローキング(リダイレクト、マルウェア、隠しコンテンツ注入など)を特定します。Google Search Consoleの監視も有効で、手動対策通知やインデックス、カバレッジの問題からクローキング発生を早期発見できます。定期的なコンテンツ監査で、キャッシュ版と現行ページの比較から、クローラー用にだけ改変された内容を発見できます。

近年、新たな脅威としてAI特化型クローキングが登場しています。これは、ChatGPTやPerplexity、Claude、Google AI OverviewsなどAIクローラーや大規模言語モデルにだけ異なるコンテンツを配信する手法です。2025年のSPLXによる最新研究では、AI特化型クローキングがAIブラウザに誤情報を引用させ、AIの学習データを意図的に汚染、スケールの大きな誤情報を生み出すことが明らかになっています。この問題は、AmICitedのようなAI生成回答内でブランドやドメインの露出を監視するプラットフォームにとっても重大な課題です。AI特化型クローキングはAIクローラーのユーザーエージェントを検知し、不正・偽装コンテンツのみをAIに提供、通常ユーザーには正規内容を見せることで、AIの引用・推奨内容を操作できます。AIが研究・意思決定・生成に使われる機会が増える中、こうした不正は社会的にも深刻なリスクとなります。AI特化型クローキングの検出には、AIクローラーへの配信内容と人間ユーザーへの表示内容を比較する専門的な監視が不可欠です。AIモニタリングツール利用組織は、クローキングがAI引用や推奨の正確性を損なうリスクを認識し、厳格な検出・検証体制の導入が求められます。

組織はクローキングを防ぎ、検索エンジン遵守を維持するために包括的な戦略を導入すべきです。透明なコンテンツ配信により、全てのユーザーとクローラーに同一もしくは本質的に同等のコンテンツを提供し、差異がある場合も正当な理由と明示が必要です。適切なJavaScript実装では、プログレッシブエンハンスメントやサーバーサイドレンダリングを活用し、主要コンテンツをクローラーにも確実に認識させます。構造化データマークアップ(Schema.org等)は、コンテンツの視覚的表現に頼らず検索エンジンに内容を正確に伝え、クローキングの必要性を排除します。定期的なセキュリティ監査で、ハッキングによる不正クローキングを早期発見し即時修正します。コンプライアンス監視では、Google Search ConsoleやScreaming Frog、検出サービス等を用い、クローキング未発生を定期確認します。スタッフ研修で、開発者やコンテンツ担当者にクローキングリスクと技術的課題への適正な代替手法を教育します。ドキュメントとポリシー整備により、クローキング禁止や最適化手法の許可基準を明文化します。外部ベンダー審査を徹底し、第三者サービスやプラグインが意図せずクローキングを導入しないよう管理します。インシデント対応計画も重要で、発生時の迅速な特定と修正により、ペナルティ期間を最小限に抑えます。

今後のクローキング検出は、さらに高度な機械学習モデルが微妙なコンテンツ差異や欺瞞パターンを高精度で識別する方向へ進むと考えられます。検索エンジンは高度なクロールシミュレーション技術に多大な投資を続けており、ユーザーと同じようにページを完全レンダリングすることで、クローラーとユーザーに異なるコンテンツを出し分けることがほぼ不可能になります。AI活用の異常検出も進化し、サーバーレスポンスやユーザーエージェント処理、配信内容の不審なパターンを自動的に検出します。AI特化型クローキングという新たな脅威への対応として、AIクローラー専用の検出ツール開発も進むでしょう。ブロックチェーンベースの認証システムが導入されれば、コンテンツの真正性を暗号的に証明し、技術的にクローキングを不可能にできるかもしれません。行動分析の統合により、個々のページが一見ガイドライン準拠でも、クローキング的傾向を持つサイトを判別可能になります。AIが情報発見や意思決定の中心となるにつれ、クローキング検出・防止の重要性は格段に高まります。透明かつガイドライン遵守の配信を実践する組織は、従来の検索だけでなくAI検索でも競争優位を保てます。従来型SEOペナルティとAIモニタリング要件の融合により、クローキングは今後ますます成立しづらくなり、検出とペナルティも即時かつ厳格化が進むでしょう。

クローキングは意図的に検索エンジンに対してコンテンツを隠し、欺く意図を持っていますが、正当なパーソナライズは全てのユーザーとクローラーに同じ基礎コンテンツを提供し、特定のオーディエンスには追加要素を見せることがあります。パーソナライズは透明性がありガイドライン遵守ですが、クローキングは欺瞞的で違反行為です。検索エンジンはパーソナライズされた場合でも全コンテンツにアクセス・評価できますが、クローキングは意図的にそのアクセスを妨げます。

検索エンジンはクローラーに提供されるコンテンツと人間ユーザーが見るコンテンツを、高度なクロールシミュレーションや機械学習アルゴリズム、SERPスニペットと実際のページ内容の照合によって比較し、クローキングを検出します。ユーザーエージェントやIPアドレス、サーバーレスポンスを解析し、不一致を特定します。最新の検出システムは、急激な順位変動、隠しテキスト、不審なリダイレクト、メタデータと本文の不一致などをフラグ付けします。

現在最も一般的なのはユーザーエージェントクローキング(クローラー識別文字列の検出)、IPベースクローキング(訪問者IPアドレスによるコンテンツ切替)、隠しテキストやリンク(CSSやJavaScriptでコンテンツを隠す)、HTTPアクセプトランゲージクローキング(言語ヘッダの検出)です。調査によると、検出されたクローキングサイトの約35%が純粋なユーザーエージェントクローキングを使用しており、依然として最も多い手法です。

はい、回復は可能ですが多大な労力が必要です。サイト管理者は全てのクローキングコンテンツを削除し、ユーザーとクローラーに同一のコンテンツを提供、セキュリティ脆弱性も修正し、Googleへ修正内容の証拠を添えて再審査リクエストを送信します。回復には通常数ヶ月を要し、再発防止のため継続的な監視が必要です。全ページの監査、透明な最適化手法の実装、検索エンジンからの信頼回復が求められます。

クローキングはAmICitedのようなAIモニタリングプラットフォームにとって大きな脅威であり、AIクローラーに誤情報やミスリーディングな内容を引用させることができます。AI特化型クローキングは、OpenAIのAtlasなどAIブラウザにだけ異なるコンテンツを提供し、AIの学習データを汚染し誤情報を生み出します。この新たな脅威への対応には、高度な検出と真のコンテンツ引用の確保が必要です。

調査によると、約3%のウェブサイトがクローキング技術を利用していますが、検出方法によって率は異なります。検出されたクローキングサイトのうち約35%がユーザーエージェントクローキングを使用しています。しかし、2015年以降は検出技術の向上と厳罰化により、2025年時点ではクローキングの普及率は大きく減少しています。

実際のクローキングに正当な用途はありませんが、JavaScriptサイトのプリレンダリング、有料コンテンツのフレキシブルサンプリング、国際化対応のhreflangタグ、動的ページのプログレッシブエンハンスメントなど、ガイドラインに準拠した代替手法は存在します。これらは検索エンジンを欺かず、技術的課題を解決しつつもガイドラインを遵守します。

ChatGPT、Perplexity、その他のプラットフォームでAIチャットボットがブランドを言及する方法を追跡します。AI存在感を向上させるための実用的なインサイトを取得します。

クロールバジェットは、検索エンジンが一定期間内にあなたのウェブサイトをクロールするページ数です。インデックスやSEOパフォーマンスを向上させるためのクロールバジェット最適化方法を学びましょう。...

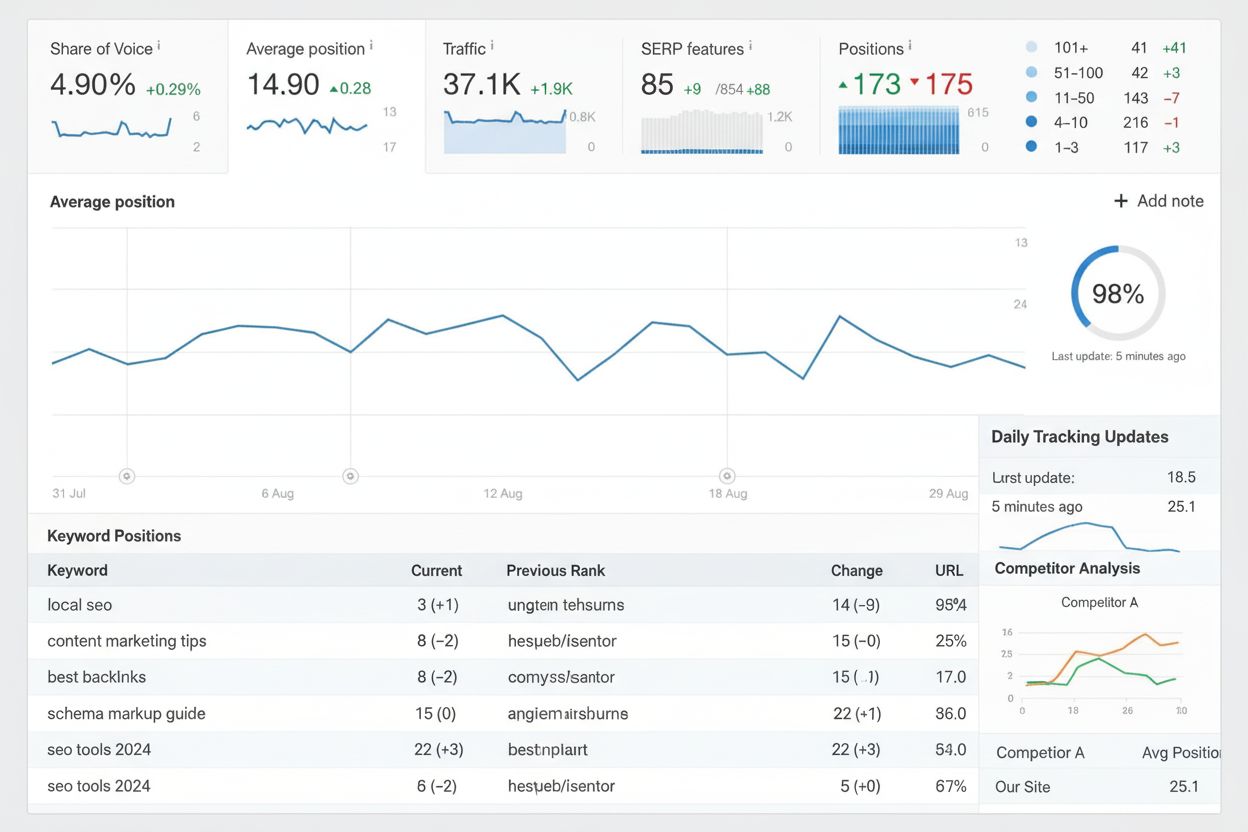

ランクトラッキングは、検索結果でのキーワード順位を時系列で監視します。その仕組みやSEOでの重要性、そしてランクトラッキングツールの効果的な活用方法を解説します。...

クロール可能性は、検索エンジンがウェブサイトのページにアクセスし、ナビゲートできる能力です。クローラーの仕組みやブロック要因、そして従来型・AI検索の可視性を最適化する方法を学びましょう。...