AIのクロールバジェットとは?AIボットのリソース配分を理解する

AIのクロールバジェットの意味、従来の検索クロールバジェットとの違い、そしてなぜAI生成回答やAI検索エンジンでブランドの可視性に重要なのかを解説します。...

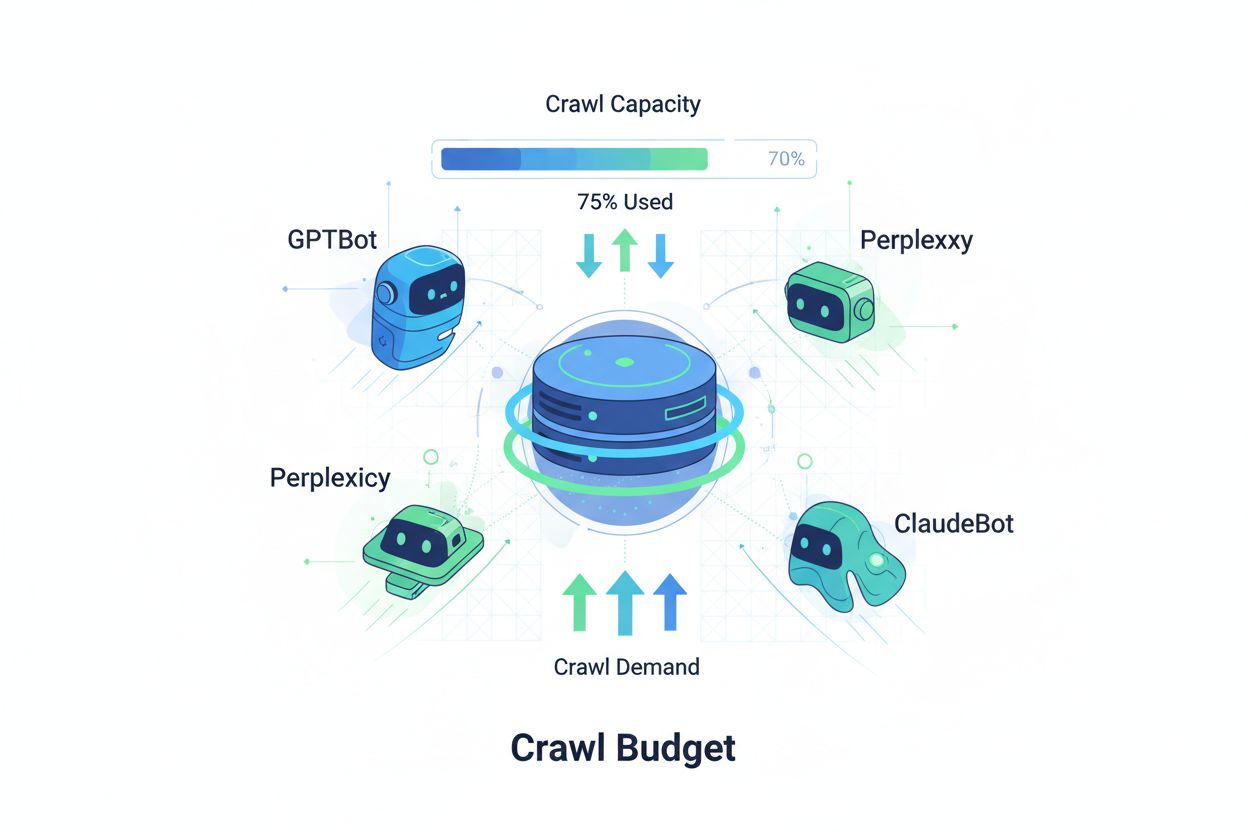

AIクローラーがクロール制限内でウェブサイトの最重要コンテンツに効率的にアクセスし、インデックスできるようにするための技術です。クロールバジェット最適化は、クロールキャパシティ(サーバーリソース)とクロールデマンド(ボットのリクエスト)のバランスを管理し、AIによる回答での可視性を最大化しつつ、運用コストやサーバー負荷を抑えます。

AIクローラーがクロール制限内でウェブサイトの最重要コンテンツに効率的にアクセスし、インデックスできるようにするための技術です。クロールバジェット最適化は、クロールキャパシティ(サーバーリソース)とクロールデマンド(ボットのリクエスト)のバランスを管理し、AIによる回答での可視性を最大化しつつ、運用コストやサーバー負荷を抑えます。

クロールバジェットとは、検索エンジンやAIボットがあなたのウェブサイトをクロールするために割り当てるリクエスト数や帯域幅などのリソース量を指します。従来は主にGoogleのクローリング動作に関連した概念でしたが、AI搭載ボットの登場により、クロールバジェット管理の考え方が根本的に変化しました。クロールバジェットの方程式は、クロールキャパシティ(ボットがクロール可能な最大ページ数)とクロールデマンド(ボットが実際にクロールしたいページ数)の2つの重要な変数で構成されます。AI時代においては、GPTBot(OpenAI)、Perplexity Bot、ClaudeBot(Anthropic)などのボットが従来の検索エンジンクローラーと同時にサーバーリソースを奪い合うため、このダイナミクスは飛躍的に複雑化しています。これらのAIボットはGooglebotとは異なる優先順位やクロールパターンで動作し、しばしば大幅に多くの帯域幅を消費し異なるインデックス目的を持つため、クロールバジェット最適化は選択肢ではなく、サイトパフォーマンス維持や運用コスト管理のために不可欠なものとなっています。

AIクローラーは、従来の検索エンジンボットとクロールパターン、頻度、リソース消費の点で大きく異なります。Googlebotはクロールバジェット制限を尊重し洗練されたスロットリング機構を備えていますが、AIボットはより攻撃的なクロール動作を示し、同じコンテンツを複数回リクエストしたり、サーバー負荷シグナルをあまり重視しないこともあります。OpenAIのGPTBotは特定のウェブサイトでGoogleのクローラーの12~15倍の帯域幅を消費するという研究もあり、特に大規模なコンテンツライブラリや頻繁に更新されるページで顕著です。この積極的な姿勢はAIの学習要件に由来し、ボットはモデル性能向上のために常に新しいコンテンツの取得を必要とし、検索エンジンがインデックス生成を目指すクロール哲学とは根本的に異なります。サーバーへの影響も大きく、AIボットトラフィックにより帯域コスト、CPU使用率、サーバー負荷が大幅に増加したと報告されています。さらに、複数のAIボットが同時にクロールすると、ユーザー体験の劣化やページ表示速度の低下、ホスティング費用の増加を招き、従来型とAI型クローラーの違いは技術的関心事ではなく重要なビジネス課題となっています。

| 特徴 | 従来クローラー(Googlebot) | AIクローラー(GPTBot, ClaudeBot) |

|---|---|---|

| クロール頻度 | 適応型、バジェットを尊重 | 攻撃的、継続的 |

| 帯域消費 | 中程度・最適化 | 高い・リソース集約型 |

| robots.txt遵守 | 厳格に遵守 | 遵守はまちまち |

| キャッシュ動作 | 高度なキャッシング | 頻繁な再リクエスト |

| ユーザーエージェント識別 | 明確、一貫性あり | 時に偽装あり |

| ビジネス目的 | 検索インデックス | モデル学習・データ取得 |

| コスト影響 | 最小限 | 顕著(12~15倍高い) |

クロールバジェットを理解するには、クロールキャパシティとクロールデマンドという2つの基礎要素を把握することが不可欠です。クロールキャパシティは、一定期間にサーバーが耐えられるクロール可能URL数の最大値で、以下の要素に左右されます。

一方のクロールデマンドは、ボットが実際にクロールしたいページ数を指し、コンテンツ特性やボットの優先順位で決まります。影響要素は以下の通りです。

最適化の課題は、クロールデマンドがキャパシティを上回るとボットがクロールページを選別し、重要な更新を見逃すリスクが生じる点です。逆にキャパシティがデマンドを大きく上回る場合は、サーバーリソースの浪費となります。目指すべきはクロール効率—重要ページのクロールを最大化しつつ、低価値ページへの無駄なクロールを最小化することです。AI時代の現在は、異なる優先順位を持つ複数種類のボットが同一サーバーリソースを奪い合うため、このバランス調整がより高度な戦略を必要とします。

クロールバジェットパフォーマンスの測定は、Google Search Consoleの「設定」にあるクロール統計から始めましょう。ここで日ごとのクロールリクエスト数、ダウンロードバイト数、レスポンスタイムが確認できます。クロール効率比率を出すには、成功クロール数(HTTP 200応答)を総クロールリクエスト数で割り、健康なサイトなら85-95%が目安です。基本式は:(成功クロール数 ÷ 総クロールリクエスト数) × 100 = クロール効率(%)。Google以外も実践的な監視には以下が重要です。

AIクローラー専用の監視にはAmICited.comなどのツールが有効で、GPTBotやClaudeBot、Perplexity Botの行動や優先ページ、再訪頻度など詳細なインサイトが得られます。加えて、AIボットによる異常なクロールスパイク時にカスタムアラートを設定すれば、想定外のリソース消費にも即座に対応できます。重要指標は1ページあたりクロールコストで、クロールによる総サーバーリソース消費をユニークなクロールページ数で割ることで、無駄なクロールが多いかどうかを把握できます。

AIボットのクロールバジェット最適化には、技術的施策と戦略的意思決定を組み合わせた多層的アプローチが必要です。主な最適化施策は以下の通りです。

どの施策を選ぶかはビジネスモデルとコンテンツ戦略に依存します。ECサイトなら競合によるデータ学習防止のため商品ページのAIクロールをブロックし、コンテンツ配信業者ならAI生成回答での可視性向上のためクロール許可が有効です。AIボットによるサーバー負荷が深刻な場合は、robots.txtでUser-agent: GPTBotやDisallow: /などユーザーエージェント単位のブロックが最も直接的な対策となります。ただし、これによりChatGPTなどAIアプリでの可視性を失います。より高度な戦略としては、パブリックコンテンツのみクロール許可し、センシティブや重複・アーカイブ領域はブロックする選択的制御が有効です。

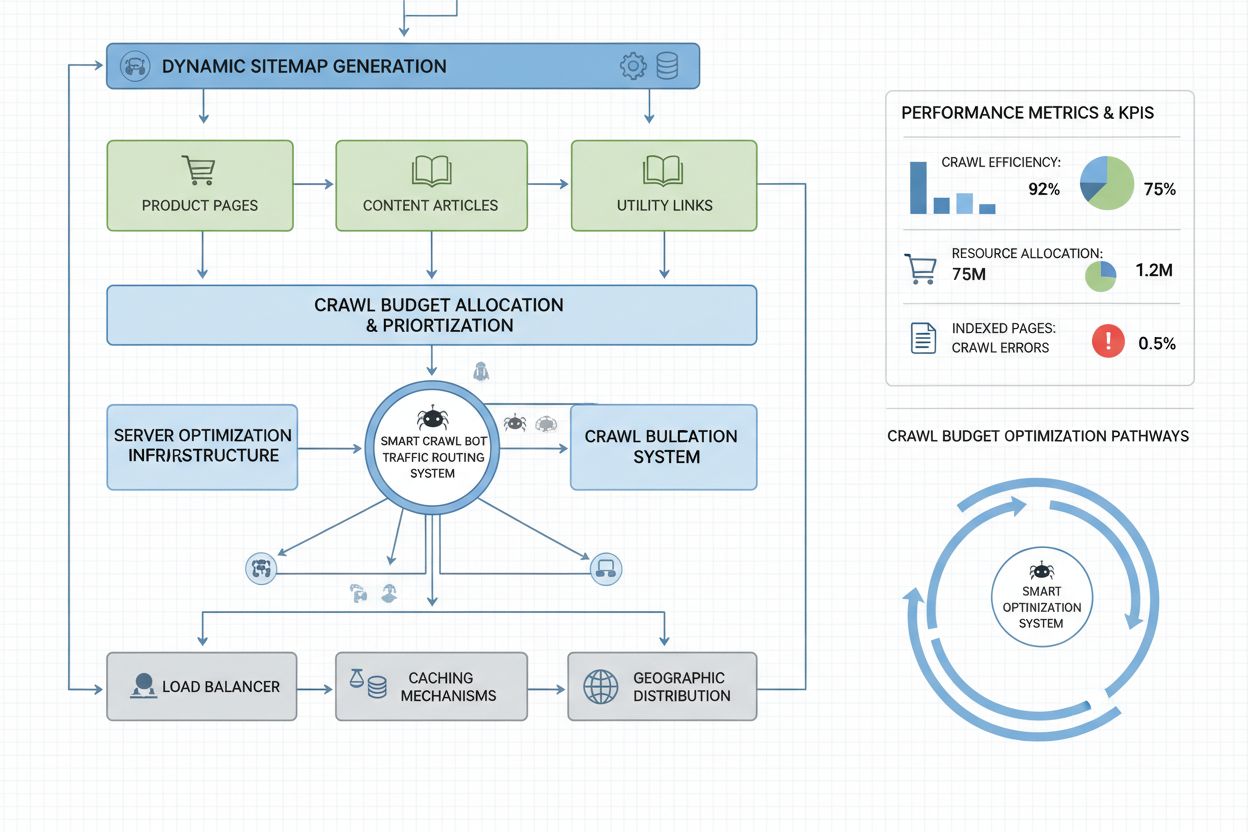

数百万ページ規模のエンタープライズサイトでは、robots.txtだけでは不十分で、より高度なクロールバジェット最適化戦略が求められます。動的サイトマップは重要な進化で、コンテンツの新鮮さ・重要度・クロール履歴に基づきリアルタイム生成されます。静的なXMLサイトマップで全ページを列挙するのではなく、動的サイトマップで最近更新されたページやアクセス数が多い・コンバージョンに寄与するページを優先して、ボットのクロールバジェットを本当に重要な箇所に集中させます。URLセグメント化でサイトを論理的なクロールゾーンに分割し、ニュースセクションでは積極的なサイトマップ更新、エバーグリーンコンテンツは更新頻度を抑えるなど最適化戦略を使い分けます。

サーバーサイド最適化としては、クロール認識型キャッシュ戦略でボットにはキャッシュ済みレスポンスを返し、ユーザーには最新コンテンツを提供することで、繰り返しボットリクエストによるサーバー負荷を軽減できます。CDN(コンテンツ配信ネットワーク)のボット別ルーティングにより、クローラートラフィックとユーザートラフィックを分離し、本来の訪問者用帯域を守ります。ユーザーエージェント別レートリミットでAIボットは制限しつつ、Googlebotや一般ユーザーには通常速度を維持することも可能です。さらに大規模運用では、複数リージョンへのクロールバジェット分散管理でサーバーの単一障害点をなくし、地理的にボットトラフィックを分散できます。機械学習型クロール予測で過去のクロールパターンからボットの次リクエストページを予測し、重点的にパフォーマンスやキャッシュを最適化することも有効です。こうしたエンタープライズレベル戦略でクロールバジェットを制約ではなく管理資源へと昇華し、何十億ページ規模でもボットとユーザー双方に最適なパフォーマンスを提供できます。

AIクローラーをブロックするか許可するかは、可視性・競争優位・運用コストに大きく影響する根本的なビジネス戦略の選択です。AIクローラーを許可すると、コンテンツがAI生成回答に掲載される資格を得て、ChatGPT・Claude・PerplexityなどAIアプリからのトラフィック獲得が期待できます。ブランドの新たな流通チャネルでの露出や、AIによる引用がSEOシグナルとしても活きるメリットもあります。ただし、これらのメリットの裏には、サーバー負荷・帯域消費の増加、競合AIモデルへの情報流出、AI回答での表現や帰属性のコントロール喪失といったコストも発生します。

AIクローラーをブロックすれば、これらのコストは排除できますが、可視性のメリットを失い、クロール許可の競合に市場シェアを奪われる可能性があります。最適な戦略はビジネスモデルごとに異なり、コンテンツ配信業者やニュースメディアはAI要約での拡散メリットが大きくクロール許可が有効、一方SaaSやECサイトは商品情報の競合学習防止のためブロックが有効です。教育機関や研究機関は知識拡散のため許可が一般的です。ハイブリッド戦略として、パブリックコンテンツのみクロール許可し、センシティブ領域やユーザー生成コンテンツ、独自情報はブロックする中間策も現実的です。さらにAmICited.com等で自サイトのAI引用状況を監視し、AI回答に掲載されていない場合はコストだけを負担している可能性があるため、ブロックがより魅力的な選択肢となります。

効果的なクロールバジェット管理には、ボット動作を可視化しデータ主導で最適化判断ができる専用ツールが不可欠です。ConductorやSitebulbはエンタープライズ向けのクローラー解析を提供し、検索エンジンのクロールシミュレーションやエラーページへの無駄なクロール、最適化ポイントの特定が可能です。Cloudflareはネットワークレベルでのボット管理を実現し、AIクローラーごとの細かなアクセス制御やレートリミットを設定できます。AIクローラーの監視には、AmICited.comが最も包括的なソリューションで、GPTBot・ClaudeBot・Perplexity BotなどのAIクローラーのアクセスページや再訪頻度、AI生成回答での引用有無などを詳細に可視化します。

サーバーログ解析もクロールバジェット最適化の基本で、Splunk・Datadog・ELK Stack等で生ログをパースし、ユーザーエージェント別トラフィックの把握やリソース消費量、クロール集中ページの特定ができます。ダッシュボードでクロール傾向の推移を追い、最適化施策の効果や新型ボット出現状況も把握できます。Google Search Consoleは従来クロールデータの必須情報を、Bing Webmaster Toolsもマイクロソフトクローラーのインサイトを提供します。最も高度な組織は、Google Search Consoleで従来ボット、AmICited.comでAIクローラー、サーバーログ解析で全ボット、Conductor等でシミュレーションと効率分析という多層監視体制を構築します。この多層アプローチで、全てのボットがサイトとどう相互作用しているか完全可視化し、推測ではなく包括的データに基づく最適化判断が可能となります。定期的な監視—理想は週次の指標レビュー—により、クロール急増やエラー増加、新たな攻撃的ボットの早期発見と即応ができ、クロールバジェット問題がパフォーマンスやコストに波及する前に対応できます。

GPTBotやClaudeBotなどのAIボットは、Googlebotとは異なる優先順位で動作します。Googlebotはクロールバジェット制限を守り、高度なスロットリングを実施しますが、AIボットはより攻撃的なクロール傾向を示し、12~15倍の帯域幅を消費することもあります。AIボットは検索インデックスではなくモデル学習のために継続的なコンテンツ取得を優先するため、クロール動作も根本的に異なり、最適化戦略も個別に必要となります。

調査によると、OpenAIのGPTBotはGoogleのクローラーの12~15倍の帯域幅を消費することがあります。特に大量のコンテンツを持つサイトでは顕著です。消費量はサイト規模やコンテンツの更新頻度、同時にクロールするAIボットの数によって異なり、複数のAIボットが同時にクロールするとサーバー負荷やホスティングコストが大きく増加します。

はい、robots.txtを使って特定のAIクローラーのみをブロックすることができます。従来のSEOには影響しません。ただし、AIクローラーをブロックするとChatGPT、Claude、PerplexityなどのAIアプリによるAI生成回答での可視性を失います。ビジネスモデルによって判断が分かれ、コンテンツ配信業者はクロール許可のメリットが大きく、ECサイトは競合の学習を防ぐためにブロックする場合があります。

クロールバジェット管理が不十分だと、重要なページがクロール・インデックスされず、新規コンテンツのインデックスも遅れます。また、サーバー負荷や帯域コストが増加し、ボットトラフィックによるユーザー体験の低下、従来検索やAI生成回答での可視性損失といった問題が発生します。特に数百万ページ規模の大規模サイトは影響を受けやすいです。

最適な結果を得るには週に一度クロールバジェット指標を監視し、大規模なコンテンツ公開時や予期せぬトラフィックスパイク時は毎日チェックしましょう。従来のクロールデータはGoogle Search Console、AIクローラーの追跡はAmICited.com、そしてサーバーログで包括的にボットの動きを把握できます。定期的な監視により、問題をパフォーマンスに影響が出る前に素早く特定できます。

robots.txtのAIボットへの有効性はまちまちです。Googlebotは厳格にrobots.txtを守りますが、AIボットはルール遵守が一貫していません。より確実な制御には、ユーザーエージェントごとのブロックやサーバーレベルでのレート制限、CloudflareのようなCDNベースのボット管理ツールの利用が有効です。

クロールバジェットはAIでの可視性に直結します。AIボットがクロールしていないコンテンツは、引用や参照ができません。重要ページがバジェット制約でクロールされないとAI生成回答に表示されません。クロールバジェットを最適化することで、AIボットによる発見率が上がり、ChatGPTやClaude、Perplexityなどで引用される可能性が高まります。

動的サイトマップを活用し、最新更新コンテンツやアクセス数の多いページ、コンバージョンに繋がるページを強調しましょう。robots.txtでアーカイブや重複ページなど価値の低いページをブロックします。クリーンなURL構造と戦略的な内部リンクでボットを重要コンテンツへ誘導し、AmICited.comのようなツールでAIボットのクロール実績を監視し戦略を洗練させましょう。

AIのクロールバジェットの意味、従来の検索クロールバジェットとの違い、そしてなぜAI生成回答やAI検索エンジンでブランドの可視性に重要なのかを解説します。...

クロールバジェットは、検索エンジンが一定期間内にあなたのウェブサイトをクロールするページ数です。インデックスやSEOパフォーマンスを向上させるためのクロールバジェット最適化方法を学びましょう。...

AIクロールバジェット管理についてのコミュニティディスカッション。GPTBot、ClaudeBot、PerplexityBot を可視性を損なわずにどう扱うか。...

クッキーの同意

閲覧体験を向上させ、トラフィックを分析するためにクッキーを使用します。 See our privacy policy.