プリレンダリング

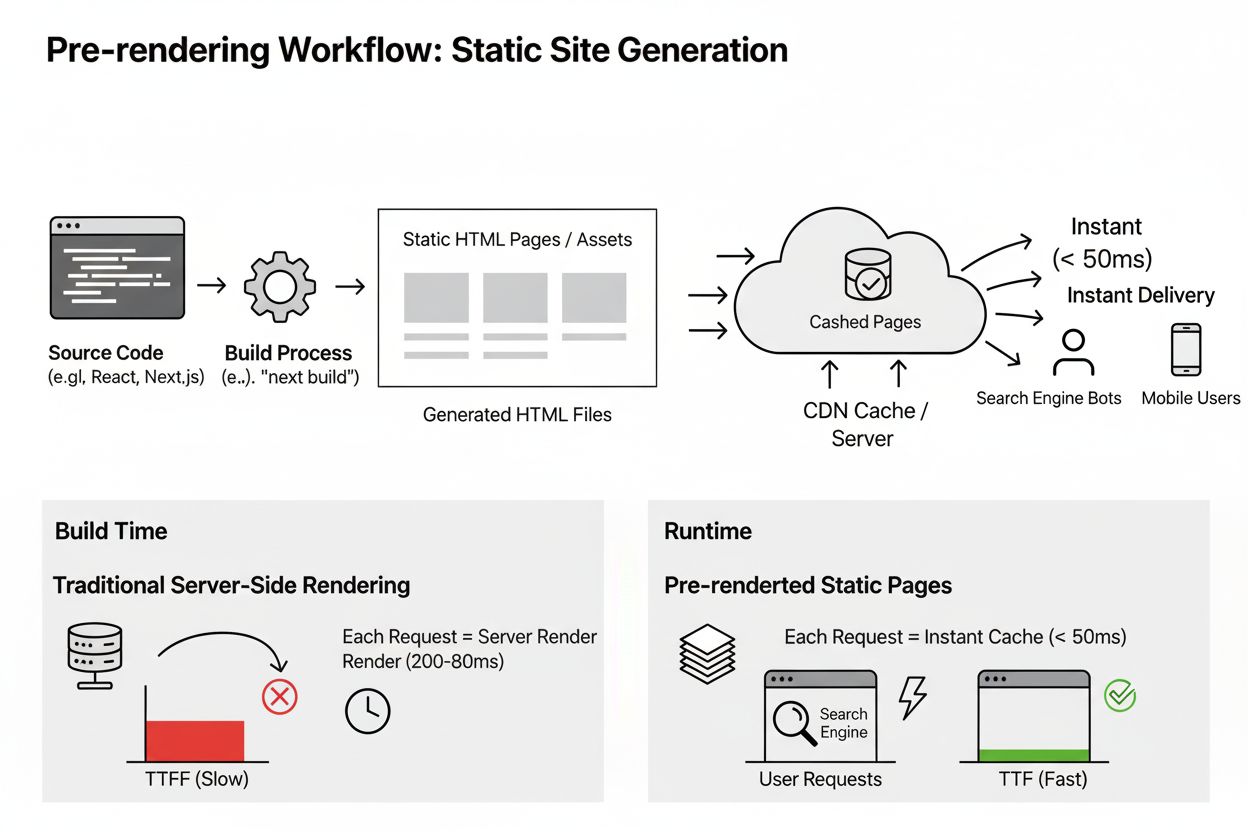

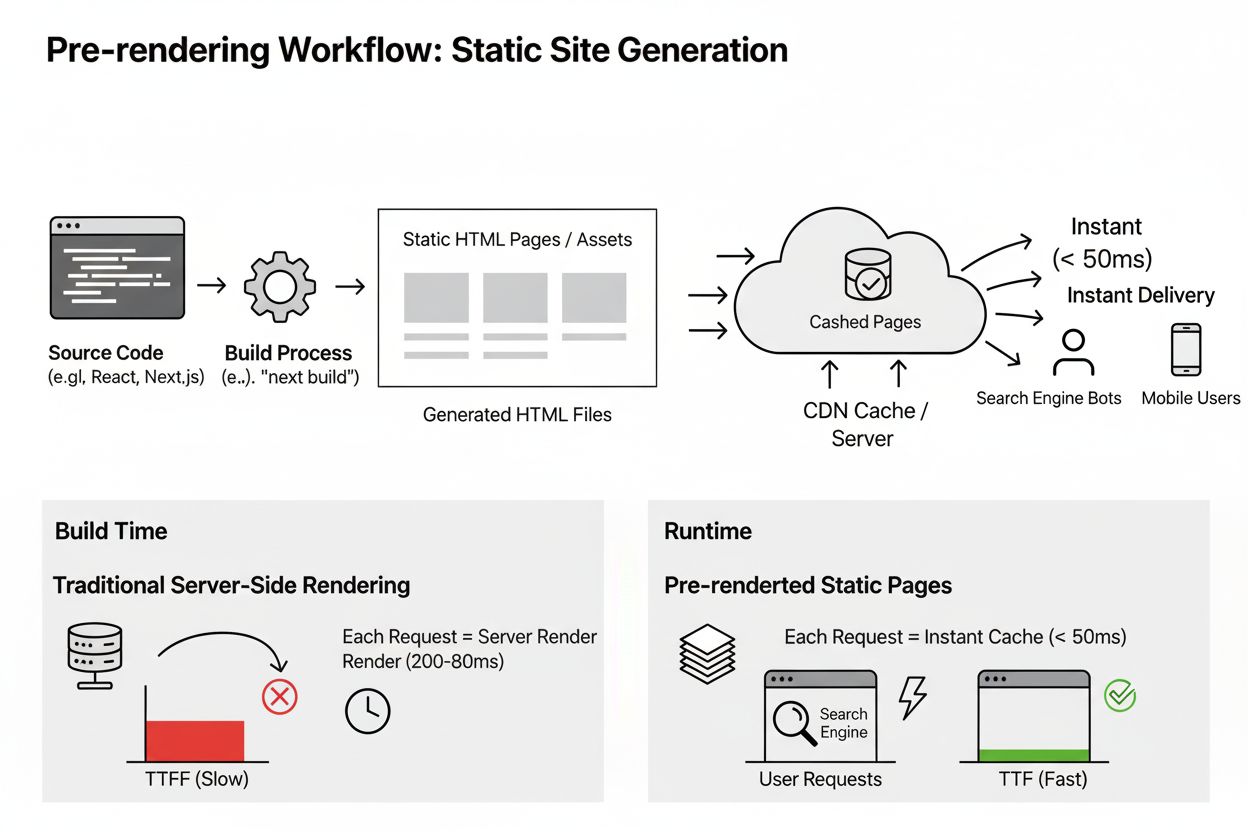

プリレンダリングは、即時配信とSEO向上のためにビルド時に静的HTMLページを生成します。この技術がAIインデックス、パフォーマンス、検索可視性にもたらす利点を学びましょう。...

ダイナミックレンダリングは、リクエストがユーザーか検索エンジンボットかを検出し、それに応じて同じコンテンツの異なるバージョンを配信するサーバーサイド技術です。ユーザーにはクライアントサイドでレンダリングされたJavaScriptを、ボットには完全にサーバーサイドでレンダリングされた静的HTMLを提供します。このアプローチにより、ユーザー体験を損なうことなくクロール性とインデックス化が最適化されます。

ダイナミックレンダリングは、リクエストがユーザーか検索エンジンボットかを検出し、それに応じて同じコンテンツの異なるバージョンを配信するサーバーサイド技術です。ユーザーにはクライアントサイドでレンダリングされたJavaScriptを、ボットには完全にサーバーサイドでレンダリングされた静的HTMLを提供します。このアプローチにより、ユーザー体験を損なうことなくクロール性とインデックス化が最適化されます。

ダイナミックレンダリングとは、ウェブサイトへのリクエストが人間のユーザーによるものか検索エンジンボットによるものかを検出し、それぞれに最適化したコンテンツを配信するサーバーサイドのコンテンツ配信手法です。ユーザーがページを訪れると、JavaScriptやインタラクティブ要素、動的機能がすべて含まれたクライアントサイドレンダリング版が提供されます。一方、検索エンジンボットやAIクローラーが同じページをリクエストすると、サーバーはユーザーエージェント識別によりこれを検出し、JavaScriptが多いコンテンツを静的かつ完全にレンダリングされたHTMLへ変換するレンダリングエンジンにリクエストをルーティングします。この静的版がボットに提供されることで、ボットがJavaScriptコードを実行する必要がなくなります。この手法は、検索エンジンが大規模にJavaScriptを処理する際の課題に対する実用的な解決策として登場し、ChatGPT、Perplexity、Claude、Google AI OverviewsといったAI搭載検索プラットフォームがウェブ上でクロール活動を拡大する中、ますます重要性を増しています。

ダイナミックレンダリングは、2018年のGoogle I/OカンファレンスでJohn MuellerがJavaScript関連のインデックス化課題へのワークアラウンドとしてSEOコミュニティに正式に紹介しました。当時、GoogleはGooglebotが技術的にはJavaScriptをレンダリング可能であると認めていましたが、ウェブ全体でそれを実行するには多大な計算リソースが必要となり、コンテンツの発見やインデックス化に遅延が生じると説明しました。Bingも2018年6月にWebmasterガイドラインを更新し、JavaScript処理の制約に悩む大規模サイト向けにダイナミックレンダリングを推奨しました。この手法は、リッチなユーザー体験を維持しつつ検索エンジンのアクセシビリティも確保できる現実的な中間解として、エンタープライズサイトやJavaScript中心のアプリケーションで普及しました。しかしGoogleの見解は2022年に大きく変化し、公式ドキュメントでダイナミックレンダリングはワークアラウンドであり長期的な解決策ではないと明記するに至りました。この変化は、サーバーサイドレンダリング(SSR)、静的レンダリング、ハイドレーションなど、より持続可能なレンダリング手法をGoogleが推奨する姿勢を反映しています。この再分類にもかかわらず、ダイナミックレンダリングはウェブ全体、特に大規模ECサイトやシングルページアプリケーション、代替アーキテクチャへ即時移行できないコンテンツ重視サイトで広く実装されています。

ダイナミックレンダリングのメカニズムは、ユーザーエージェント検出、コンテンツルーティング、レンダリングとキャッシュという3つの主要なコンポーネントの連携で成り立っています。ウェブサーバーにリクエストが届くと、まずそれが人間のユーザーからか自動化されたボットからかを識別します。これは、HTTPリクエストヘッダ内のユーザーエージェント文字列を調べることで行われ、そこにはクライアントの情報が含まれています。GooglebotやBingbot、PerplexityやClaudeなどのAIクローラーは、それぞれ特定のユーザーエージェント文字列で自身を識別します。ボットが検出されると、サーバーはリクエストをダイナミックレンダリングサービスやミドルウェアにルーティングし、通常は(ChromiumやPuppeteerのような)ヘッドレスブラウザを用いてページのJavaScriptをレンダリングし、静的HTMLへ変換します。このプロセスで全てのJavaScriptが実行され、動的コンテンツが読み込まれ、通常ユーザーのブラウザで生成される最終的なDOM(ドキュメントオブジェクトモデル)が作成されます。生成された静的HTMLはキャッシュされ、繰り返しのレンダリング負荷を避けつつボットに直接配信されます。人間のユーザーにはこのレンダリングパイプラインを経由せず、元のクライアントサイドレンダリング版が提供され、アニメーションやリアルタイム更新、動的機能を含む完全なインタラクティブ体験が保証されます。

| 項目 | ダイナミックレンダリング | サーバーサイドレンダリング(SSR) | 静的レンダリング | クライアントサイドレンダリング(CSR) |

|---|---|---|---|---|

| ユーザーへのコンテンツ配信 | クライアントサイドレンダリング(JavaScript) | サーバーサイドレンダリング(HTML) | 事前生成の静的HTML | クライアントサイドレンダリング(JavaScript) |

| ボットへのコンテンツ配信 | サーバーサイドレンダリング(HTML) | サーバーサイドレンダリング(HTML) | 事前生成の静的HTML | クライアントサイドレンダリング(JavaScript) |

| 実装の難易度 | 中 | 高 | 低 | 低 |

| リソース要件 | 中(ボットのみレンダリング) | 高(全リクエストにレンダリング) | 低(レンダリング不要) | 低(クライアントのみ) |

| ユーザー向けパフォーマンス | JavaScript依存 | 優秀 | 優秀 | 変動あり |

| ボット向けパフォーマンス | 優秀 | 優秀 | 優秀 | 悪い |

| クロールバジェットへの影響 | 良好(ボット処理高速化) | 良好(ボット処理高速化) | 最良(最速) | 悪い(遅いレンダリング) |

| SEO推奨度 | 一時的なワークアラウンド | 長期的に推奨 | 長期的に推奨 | SEOには非推奨 |

| 最適な用途 | JS多用・予算制約の大規模サイト | 最新Webアプリ | ブログ、ドキュメント、静的コンテンツ | SEO不要のユーザー向けアプリ |

| 保守負担 | 低〜中 | 高 | 低 | 低 |

ダイナミックレンダリングが存在する根本理由は、現代Web開発におけるJavaScriptの大規模レンダリングという重大な課題にあります。JavaScriptはリアルタイム更新、アニメーション、複雑な機能によるリッチなユーザー体験を実現しますが、検索エンジンクローラーにとっては大きな障壁となります。検索エンジンボットがReact、Vue、AngularなどのJavaScriptフレームワークで構築されたページに遭遇すると、最終的なレンダリングコンテンツを得るためにJavaScriptコードを実行しなければなりません。この実行は計算コストが高く、時間もかかります。GoogleのSearch AdvocateであるMartin Splitt氏は「GooglebotはJavaScriptを実行できるが、それに依存したくない」と公言しています。理由は、Googleが各ウェブサイトに割り当てるクロールバジェット(クロール用の時間や計算リソース)が有限だからです。Botifyによる6.2億件のGooglebotリクエストと4.13億ページの分析によれば、エンタープライズ規模の大規模サイトでは約51%のページがクロールされていません。JavaScriptがクロール処理を遅らせると、発見・インデックス化されるページ数が減ります。さらにクロールバジェットとは別にレンダーバジェットも存在し、クロールされたとしてもJavaScriptレンダリングが後回しにされ、インデックス化までに数時間〜数日かかる場合があります。これは在庫が頻繁に変わるECサイトや、毎日数百記事を公開するニュースサイトでは致命的で、タイムリーなインデックス化が可視性とトラフィックに直結します。

クロールバジェットはSEOで最も重要かつ誤解されがちな概念の一つです。Googleはクロールバジェットをクロールバジェット = クロールキャパシティ + クロール需要の式で算出します。クロールキャパシティはページの読み込み速度やサーバーエラー、クロール需要はページの人気や新鮮度シグナルで決まります。ウェブサイトがダイナミックレンダリングを導入すると、ボットが各ページ処理にかかる時間が短縮され、クロールキャパシティが直接向上します。研究によれば、レンダリング時間が3秒未満のページは、500〜1000msのページより約45%多く再クロールされ、1000ms超のページより約130%多くクロールされます。ボットにプリレンダリング済み静的HTMLを提供することで、クロール予算内でより多くのページを処理できるようになり、インデックス化率が向上します。数千〜数百万ページを持つ大規模サイトでは、これは50%がインデックスされるか80%以上がインデックスされるかの大きな差を生みます。また、ダイナミックレンダリングによりJavaScriptで読み込まれるコンテンツも即座にボットへ可視化されるため、二次的なレンダリングキューによる遅延を防げます。特に頻繁に内容が変わるコンテンツにとって、ボットが最新状態を即座に取得できることは極めて重要です。

AI搭載検索プラットフォーム(ChatGPT、Perplexity、Claude、Google AI Overviewsなど)の登場により、ダイナミックレンダリングの議論は新たな次元に入りました。これらのプラットフォームは独自のクローラーを動かし、Webコンテンツを処理してAI応答や要約を生成します。従来の検索エンジンが主にランキング目的でページをインデックスするのに対し、AIクローラーは内容を深く理解し、正確で文脈に合った応答を生成するためのアクセスを必要とします。この点でダイナミックレンダリングは特に重要となります。AIクローラーが効率的かつ完全にコンテンツへアクセスできるようにすることで、AI生成応答や要約にあなたのブランドやページが引用される可能性が高まります。AmICitedがこれらプラットフォームでAI応答内のブランド露出をモニタリングする際、AIクローラーがウェブサイトの内容に正常にアクセス・理解できたかどうかが引用可否の根本要因です。JavaScript中心でダイナミックレンダリングが未実装のサイトでは、AIクローラーが内容を取得できず、ブランドがAI応答に表示される可能性が下がります。逆に、適切にダイナミックレンダリングを実施しているサイトはAIクローラーに完全にアクセス可能なコンテンツを提供でき、引用・可視性の確率が上昇します。これはダイナミックレンダリングが単なるSEOだけでなく、**生成エンジン最適化(GEO)**戦略の中核技術となることを意味します。AmICitedを利用してAI検索可視性を追跡する組織は、ダイナミックレンダリングをAI全プラットフォームでの露出最大化に向けた土台の技術実装と位置付けるべきです。

ダイナミックレンダリングを実装するには、慎重な計画と技術的な実装が不可欠です。まずダイナミックレンダリングが必要なページを特定します。通常はホームページ、商品ページ、トラフィックが多い・頻繁に更新される重要コンテンツが対象です。すべてのページで必ずしも必要なわけではなく、JavaScriptが少ない静的ページは通常通りクロールされます。次にレンダリングソリューションの選定があります。代表的な選択肢はPrerender.io(有料・レンダリングとキャッシュを自動化)、Rendertron(GoogleのヘッドレスChromiumベースのオープンソース)、Puppeteer(Node.js用のヘッドレスChrome制御ライブラリ)、Nostra AIのCrawler Optimizationなどです。それぞれコスト、複雑さ、保守性に違いがあります。レンダリングツールを選んだら、ユーザーエージェント検出ミドルウェアをサーバーに設定し、ボットリクエストを適切に識別・ルーティングします。これはユーザーエージェント文字列を既知のボット識別子リストと照合し、ボットリクエストをレンダリングサービスへプロキシする形で行われます。キャッシュも重要で、プリレンダリング済みコンテンツは積極的にキャッシュし、動的コンテンツには適宜インバリデーションを設けます。最後に、Google Search ConsoleのURL検査ツールやモバイルフレンドリーテストで、ボットが正しくレンダリングされたコンテンツを受け取っているかを検証します。

ダイナミックレンダリングの主なメリットは、クロール性の向上が最も即効性のある利点です。JavaScript処理の負荷を排除することで、ボットはより多くのページを高速にクロールできます。インデックス化率の向上も自然に続き、より多くのページがクロールバジェット内で発見・登録されます。ボット処理の高速化により、レンダリング要求によるサーバー負荷も抑制されます(レンダリングは一度だけ実行し、キャッシュされるため)。ユーザー体験維持も他手法との大きな違いで、ユーザーにはリッチでインタラクティブなサイトがそのまま提供されます。SSRに比べ低コストで導入可能な点も、開発リソースの限られた組織には魅力です。一方で、複雑さや保守負担は大規模サイトや複雑な構造を持つサイトで増大します。キャッシュ管理も頻繁に内容が変わる場合は難しく、インバリデーション設計が必須です。ユーザー向けとボット向けバージョン間の不一致が発生するリスクもあり、これがインデックス化問題につながることも。レンダリング・キャッシュ基盤の運用コストも無視できません。そして最も重要なのは、Googleの公式見解としてダイナミックレンダリングは一時的なワークアラウンドとされており、将来的にはより持続可能な手法への移行を計画する必要があるという点です。

ダイナミックレンダリングの将来は、Web開発や検索エンジン進化の大きな潮流と密接に関係しています。JavaScriptフレームワークが現代Webを席巻する中、リッチなユーザー体験とボットアクセシビリティを両立する手法の必要性は依然として高いですが、業界は徐々により持続可能な手法へ移行しつつあります。サーバーサイドレンダリングはNext.js、Nuxt、Remixなどの登場で実装が容易になりつつあり、静的レンダリングやインクリメンタル静的再生成は変化の少ないコンテンツで抜群のパフォーマンスを発揮します。ハイドレーション(サーバーで初期レンダリングし、クライアントでインタラクティブ化)は中間解として導入が進んでいます。Googleの最新ガイダンスもこれらをダイナミックレンダリングより推奨しており、同社がダイナミックレンダリングを一時的な移行措置と見なしていることが分かります。AI搭載検索プラットフォームの進化もこの流れに拍車をかけています。クローリング能力や内容理解力が向上するほど、アクセシブルで構造化されたコンテンツの重要性が高まります。ダイナミックレンダリングはレガシーシステムや特定制約を持つ組織では今後も必要ですが、新規プロジェクトでは最初から持続可能なレンダリング戦略を優先すべきでしょう。現在AmICitedでAI検索可視性を監視している組織にとっても、ダイナミックレンダリングによる即効的なAI露出向上と並行して、より持続可能なレンダリング手法への移行計画を生成エンジン最適化戦略の一環として策定することが必須です。従来型SEO、パフォーマンス最適化、AI検索可視性の融合により、レンダリング戦略はもはや技術部門だけの課題ではなく、全ての検索プラットフォームでの発見性に直結する経営上の意思決定事項となっています。

いいえ、Googleは明確に、ダイナミックレンダリングはボットとユーザーに提供されるコンテンツが実質的に同じである限りクロークではないと述べています。クロークは、検索エンジンを欺くために全く異なるコンテンツを意図的に提供する場合を指しますが、ダイナミックレンダリングは同じコンテンツを異なる形式で提供します。ただし、ユーザーには猫、ボットには犬のように完全に異なるページを提供する場合はクロークと見なされ、Googleのポリシー違反となります。

ダイナミックレンダリングは、検索エンジンボットがJavaScriptを処理するために必要な計算リソースを削減し、割り当てられたクロールバジェット内でより多くのページをクロールできるようにします。JavaScriptが多いコンテンツの代わりにプリレンダリングされた静的HTMLを提供することで、ボットはページに素早くアクセスしインデックス化できます。研究によると、レンダリング時間が3秒未満のページは、それより遅いページに比べて約45%多く再クロールされ、インデックス化率が直接向上します。

サーバーサイドレンダリング(SSR)は、ユーザーとボットの両方にサーバー側でコンテンツをプリレンダリングし、全員にパフォーマンスを向上させますが、開発リソースが多く必要です。ダイナミックレンダリングはボットにのみプリレンダリングし、ユーザーには通常のクライアントサイドレンダリング版を提供するため、実装の負荷が比較的軽いです。ただし、Googleは現在、ダイナミックレンダリングよりもSSR、静的レンダリング、ハイドレーションなどの長期的なソリューションを推奨しています。ダイナミックレンダリングは一時的なワークアラウンドと見なされています。

ダイナミックレンダリングは、在庫が頻繁に更新されるECサイトや、シングルページアプリケーション、複雑なインタラクティブ機能を持つJavaScriptが多い大規模ウェブサイトに最適です。Googleがコンテンツの大部分をクロールできないクロールバジェットの課題を抱えるサイトが主な対象です。調査によると、エンタープライズ規模の大規模サイトでは、クロールバジェットの制約によりGoogleが約51%のページを見逃しています。

ChatGPT、Perplexity、Claudeなどのプラットフォームで使われるAIクローラーは、従来の検索エンジンボットと同様にWebコンテンツを処理し、最適なインデックス化のために完全にアクセス可能なHTMLコンテンツを必要とします。ダイナミックレンダリングは、これらのAIシステムがJavaScriptで生成されたコンテンツに効率的にアクセスし理解できるようサポートし、AIによる回答や要約にあなたのウェブサイトが登場する可能性を高めます。特にAmICitedのモニタリングでは、正しいレンダリングによってブランドがAI検索結果に表示されることが重要です。

代表的なダイナミックレンダリングソリューションには、Prerender.io(有料)、Rendertron(オープンソース)、Puppeteer、Nostra AIのCrawler Optimizationなどの専用プラットフォームがあります。これらのツールはボットのユーザーエージェントを検出し、ページの静的HTML版を生成・キャッシュして高速配信します。実装には通常、サーバーにレンダラーをインストールし、ユーザーエージェント検出ミドルウェアを設定し、Google Search ConsoleのURL検査ツールで動作確認します。

いいえ、ダイナミックレンダリングはユーザー体験に全く影響を与えません。訪問者は引き続き、すべてのインタラクティブ要素、アニメーション、動的機能を含むクライアントサイドレンダリング版のウェブサイトを受け取ります。ユーザーがボット用の静的HTML版を見ることはありません。この手法は、リッチでインタラクティブな体験を損なうことなく、ボットのクロール性を最適化するために設計されています。

Googleは2018年、JavaScriptレンダリングのスケール上の課題に対する実用的な解決策としてダイナミックレンダリングを推奨しました。しかし2022年には、ダイナミックレンダリングは一時的なワークアラウンドであり、長期的な解決策ではないと公式見解を更新しました。この推奨変更は、サーバーサイドレンダリング、静的レンダリング、ハイドレーションなど、より持続可能なアプローチをGoogleが好むようになったことを反映しています。ダイナミックレンダリングは特定の用途では有効ですが、単独ではなくパフォーマンス最適化戦略の一部として位置付けるべきです。

ChatGPT、Perplexity、その他のプラットフォームでAIチャットボットがブランドを言及する方法を追跡します。AI存在感を向上させるための実用的なインサイトを取得します。

プリレンダリングは、即時配信とSEO向上のためにビルド時に静的HTMLページを生成します。この技術がAIインデックス、パフォーマンス、検索可視性にもたらす利点を学びましょう。...

サーバーサイドレンダリング(SSR)は、サーバーがHTMLページ全体をレンダリングし、ブラウザに送信するWeb技術です。SSRがSEO、ページ速度、AIインデックス化を改善し、コンテンツの可視性を高める仕組みを解説します。...

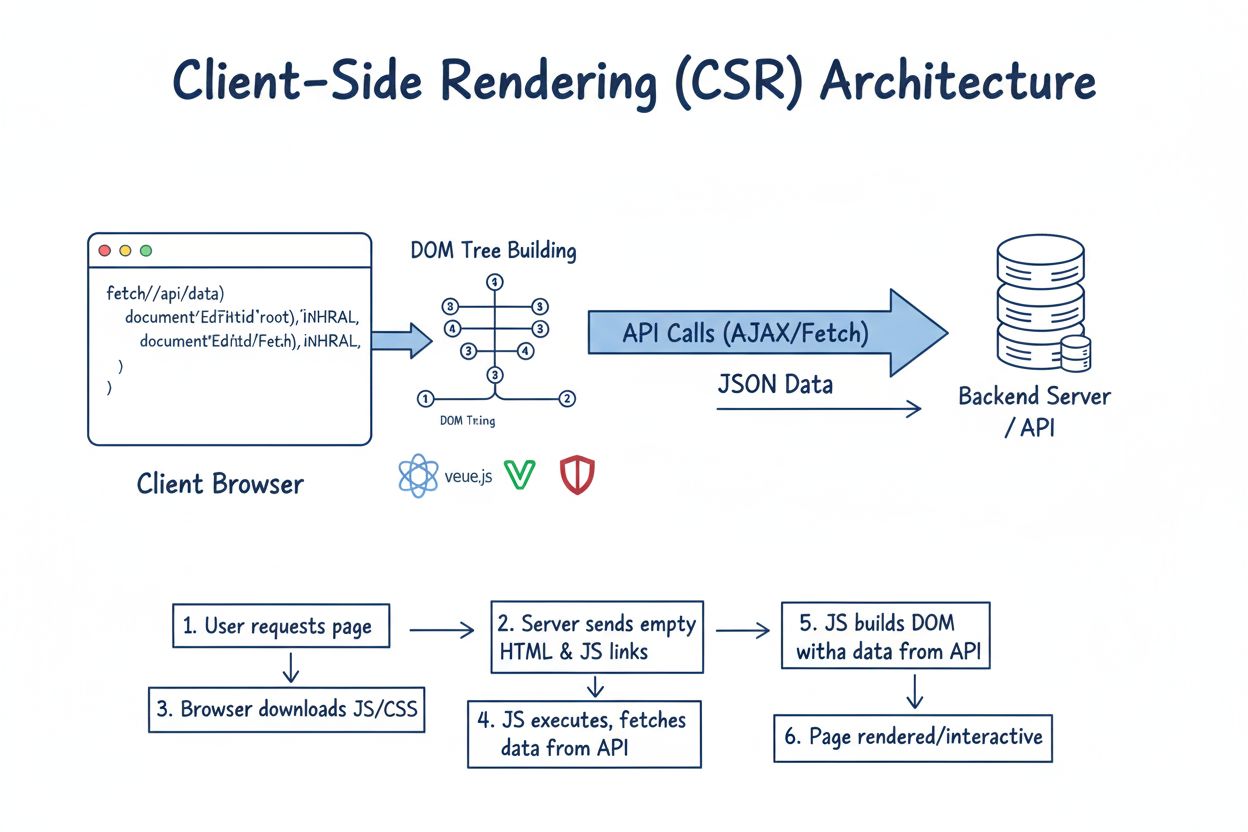

クライアントサイドレンダリング(CSR)とは何か、その仕組み、メリット・デメリット、2024年におけるSEOやAIインデックス化、ウェブアプリケーションパフォーマンスへの影響について学びましょう。...

クッキーの同意

閲覧体験を向上させ、トラフィックを分析するためにクッキーを使用します。 See our privacy policy.