AIインデックスカバレッジ

AIインデックスカバレッジとは何か、そしてそれがChatGPT、Google AI Overviews、Perplexityでのブランドの可視性にとってなぜ重要かを学びましょう。技術的要因、ベストプラクティス、モニタリング戦略を知り、AIインデックスカバレッジを向上させましょう。...

インデックスカバレッジとは、ウェブサイトのページが検索エンジンによって発見・クロールされ、インデックスに登録された割合とそのステータスのことです。どのページが検索結果に表示可能かを測定し、インデックス登録を妨げる技術的な問題を特定します。

インデックスカバレッジとは、ウェブサイトのページが検索エンジンによって発見・クロールされ、インデックスに登録された割合とそのステータスのことです。どのページが検索結果に表示可能かを測定し、インデックス登録を妨げる技術的な問題を特定します。

インデックスカバレッジとは、あなたのウェブサイトのうち、どれだけのページが検索エンジンによって発見・クロールされ、インデックスに登録されているかを測る指標です。この指標は、サイト内のどのページが検索結果に表示可能かを示し、インデックス登録を妨げている技術的な問題を特定します。つまりインデックスカバレッジは、「自分のウェブサイトのうち、検索エンジンが実際に発見し評価できているのはどれだけか?」という重要な問いに答えてくれます。この指標はウェブサイトの検索エンジン可視性を理解するうえで基本となり、Google Search Consoleなどのツールでインデックス済みページ、除外ページ、エラーページなどの詳細レポートが提供されています。適切なインデックスカバレッジがなければ、どんなに最適化されたコンテンツであっても検索エンジンやユーザーにとって「見えない」ままとなります。

インデックスカバレッジは単なる「数」ではなく、「正しい」ページがインデックスされていることが重要です。ウェブサイトに数千ページあったとしても、それが重複や薄いコンテンツ、robots.txtでブロックされたページばかりなら、実際のインデックスカバレッジは期待よりはるかに低くなります。「総ページ数」と「インデックス済みページ数」の違いを意識することが、効果的なSEO戦略の鍵です。インデックスカバレッジを定期的に監視する組織は、技術的な問題をオーガニックトラフィックに影響が出る前に特定・修正できるため、テクニカルSEOの中でも特に実践的な指標のひとつです。

インデックスカバレッジという概念は、検索エンジンが単純なクローラーから、1日数百万ページを処理できる高度なシステムへと進化する過程で生まれました。SEOの初期には、ウェブマスターが検索エンジンとのやり取りを把握する手段は限られていましたが、Google Search Console(旧Google Webmaster Tools、2006年開始)の登場により、クロールやインデックス登録の状況が可視化され大きな転換点となりました。インデックスカバレッジレポート(以前は「ページのインデックス登録」レポート)が、Googleがどのページをインデックスし、なぜ除外したのかを理解する主要なツールとなりました。

ウェブサイトが動的コンテンツやパラメータ、重複ページなどで複雑化するにつれ、インデックスカバレッジの問題はより一般的になりました。調査によれば、約40~60%のウェブサイトが重大なインデックスカバレッジ問題を抱えており、多くのページが未発見または意図的にインデックスから除外されています。JavaScript中心のウェブサイトやシングルページアプリケーションの増加も、検索エンジンがコンテンツをレンダリングしインデックス可能か判断する必要性から、問題をさらに複雑にしています。現在では、インデックスカバレッジの監視はオーガニック検索流入に依存する組織にとって不可欠とされ、業界専門家は最低でも月次での監査を推奨しています。

インデックスカバレッジとクロールバジェットの関係性も、サイト規模の拡大とともに重要度が増しています。クロールバジェットとは、Googlebotが一定期間中にあなたのサイトをクロールするページ数のことです。大規模サイトでサイト構造が悪かったり重複コンテンツが多いと、価値の低いページにクロールバジェットが浪費され、重要なページが未発見となりがちです。78%以上の企業が何らかのコンテンツ監視ツールを利用して検索エンジンやAIプラットフォームでの可視性を追跡しており、インデックスカバレッジが可視性戦略の基盤であると認識されています。

| 概念 | 定義 | 主な制御方法 | 使用ツール | 順位への影響 |

|---|---|---|---|---|

| インデックスカバレッジ | 検索エンジンにインデックス登録されたページの割合 | メタタグ、robots.txt、コンテンツ品質 | Google Search Console、Bing Webmaster Tools | 直接的―インデックス済みページのみが順位対象 |

| クロール可能性 | ボットがページにアクセス・ナビゲートできるか | robots.txt、サイト構造、内部リンク | Screaming Frog、ZentroAudit、サーバーログ | 間接的―クロール可能でなければインデックス不可 |

| インデックス可能性 | クロールされたページがインデックス追加される能力 | noindex指示、カノニカルタグ、コンテンツ | Google Search Console、URL検査ツール | 直接的―検索結果に出るか決定 |

| クロールバジェット | 一定期間でGooglebotがクロールするページ数 | サイトオーソリティ、ページ品質、クロールエラー | Google Search Console、サーバーログ | 間接的―どのページがクロールされるか影響 |

| 重複コンテンツ | 同一または類似コンテンツの複数ページ | カノニカルタグ、301リダイレクト、noindex | SEO監査ツール、手動レビュー | マイナス―順位分散の原因 |

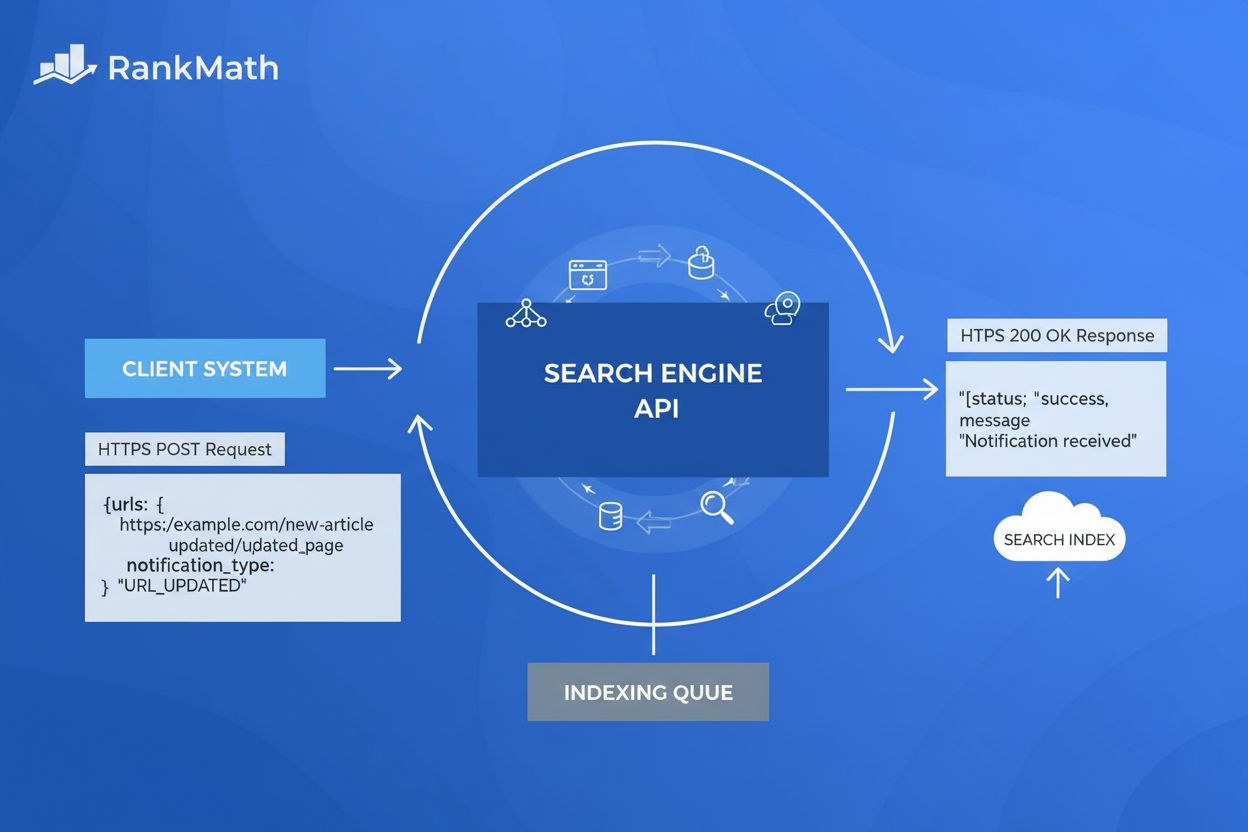

インデックスカバレッジは、「発見」「クロール」「インデックス」の3段階で処理されます。 発見フェーズでは、検索エンジンがXMLサイトマップ、内部リンク、外部バックリンク、Google Search Consoleによる直接送信など様々な手段でURLを見つけます。発見されたURLはクロールのためにキューに入り、Googlebotがページをリクエストして内容を解析します。最終的にインデックス段階で、Googleがページ内容を処理し、その関連性や品質を評価し、検索用インデックスに含めるかどうかを決定します。

Google Search Consoleのインデックスカバレッジレポートでは、ページが主に4つのステータスに分類されます:有効(インデックス済み)、警告あり有効(インデックス済みだが問題あり)、除外(意図的にインデックスされていない)、エラー(インデックス不可)。それぞれに該当する具体的な問題タイプがあり、なぜページがインデックスされないのか詳細に把握できます。たとえば、noindexメタタグがある、robots.txtでブロックされている、カノニカルタグのない重複、4xx/5xx HTTPステータスコードを返すなどが挙げられます。

インデックスカバレッジの技術的な仕組みを理解するには、いくつかの重要な要素の知識が必要です。robots.txtファイルは、サイトのルートディレクトリに設置されるテキストファイルで、検索エンジンクローラーに対し、どのディレクトリやファイルにアクセス可能/不可かを指示します。robots.txtの設定ミスはインデックスカバレッジ問題の代表例であり、重要なディレクトリを誤ってブロックしてしまうとGoogleがそのページを発見できなくなります。meta robotsタグはページのHTML head内に設置し、index、noindex、follow、nofollowといった指示でページ単位の制御を行います。カノニカルタグ(rel=“canonical”)は、重複ページがある場合にどのURLが正規版かを検索エンジンに示し、インデックスの膨張や順位分散を防ぎます。

オーガニック検索流入に依存するビジネスにとって、インデックスカバレッジは売上や可視性に直結します。重要なページがインデックスされなければ、検索結果に表示されず、潜在顧客もGoogle経由で見つけることができません。ECサイトで商品のページが「検出 - 現在未インデックス」に留まれば、売上損失となりますし、コンテンツマーケティングプラットフォームでは記事の多くがインデックスされてこそ広いオーディエンスに届きます。SaaS企業も、ドキュメントやブログ記事がインデックスされなければオーガニックリード獲得が困難です。

この影響は従来の検索領域にとどまりません。ChatGPTやPerplexity、Google AI Overviewsなどの生成AIプラットフォームの台頭により、インデックスカバレッジはAI可視性にも直結するようになりました。これらのシステムは多くの場合、インデックスされたウェブコンテンツをトレーニングデータや引用元として利用します。Googleで適切にインデックスされていないページは、AIの学習データセットやAI生成回答で引用される可能性が低下します。これにより、インデックスカバレッジの不備は従来検索とAI生成コンテンツの両方で可視性の損失につながるという「複合的な」問題となります。

インデックスカバレッジを積極的に監視する組織では、オーガニックトラフィックの実際の増加が見られます。典型的な事例としては、提出したURLのうち30~40%がnoindexタグ、重複、クロールエラーなどで除外されていることを発見。これらを修正(不要なnoindex削除、カノニカル化、クロールエラー修正)すると、インデックス済みページ数が20~50%増加し、それに比例してオーガニック可視性も向上します。何もしないコストは大きく、ページが未インデックスのままなら、その期間分のトラフィックやコンバージョンを失うことになります。

Google Search Consoleはインデックスカバレッジ監視の主要ツールであり、Googleのインデックス判断に関する最も信頼性の高いデータを提供します。インデックスカバレッジレポートでは、インデックス済みページ、警告付きページ、除外ページ、エラーページが表示され、それぞれの具体的な問題タイプも分かります。また、URL検査ツールも用意されており、個別ページのインデックス状況確認や新規・更新コンテンツのインデックスリクエストが可能です。これは特定ページのトラブルシューティングやGoogleのインデックス判断理由を把握するのに非常に有用です。

Bing Webmaster ToolsもIndex ExplorerやURL Submission機能で同様の管理が可能です。BingのシェアはGoogleほど高くありませんが、Bing検索を利用するユーザー層にリーチするには重要です。BingのインデックスカバレッジデータはGoogleと異なる場合があり、Bing特有のクロールやインデックスアルゴリズムの課題が明らかになることもあります。大規模サイトを運用する組織は、両方のプラットフォームを監視することが包括的なカバレッジ確保に役立ちます。

AIモニタリングとブランド可視性の観点では、AmICitedのようなプラットフォームがChatGPT、Perplexity、Google AI Overviews、Claudeにおけるブランドやドメインの掲載状況を追跡します。これらは従来のインデックスカバレッジとAI可視性を連携し、自社コンテンツがAI生成応答でどのように引用・表示されているかを把握できます。これは現代SEO戦略において不可欠な要素であり、AIシステムでの可視性がブランド認知やトラフィックに与える影響が増している今、重要性が高まっています。

Ahrefs、SEMrush、Screaming FrogなどのサードパーティSEO監査ツールも、独自にサイトをクロールしGoogleのインデックスカバレッジと比較することで追加の知見を得られます。自サイトのクロール結果とGoogleのレポートに差異がある場合、JavaScriptレンダリングやサーバー側の問題、クロールバジェットの制約などが疑われます。これらのツールはオーファンページ(内部リンクがないページ)の発見にも役立ち、インデックスカバレッジの改善ポイントを特定できます。

インデックスカバレッジの改善には、技術的・戦略的課題の両面から体系的なアプローチが必要です。まず、Google Search Consoleのインデックスカバレッジレポートで現状を監査しましょう。 noindexタグ、robots.txtブロック、重複コンテンツ、クロールエラーなど、主な問題タイプを特定し、優先順位をつけて対応します。インデックスされるべきなのに除外されているページは最優先で修正しましょう。

次に、robots.txtの設定ミスを修正します。 robots.txtファイルを見直し、重要なディレクトリやページが誤ってブロックされていないか確認します。例えば/admin/、/staging/、/temp/など非公開ディレクトリはブロックすべきですが、/blog/や/products/など公開コンテンツまでブロックしていないか注意しましょう。Google Search Consoleのrobots.txtテスターでブロック状況を確認できます。

三番目に、重複コンテンツには適切なカノニカル化を行います。 複数URLで同一コンテンツを配信している場合(例:カテゴリ経路の異なる商品ページ)、自己参照カノニカルタグをページごとに設置するか、301リダイレクトで単一バージョンに統合します。これによりインデックスの膨張を防ぎ、順位シグナルを正規ページに集中できます。

四番目に、不要なnoindexタグを削除します。 インデックス登録したいページにnoindex指示が残っていないかサイト全体を監査しましょう。特にステージング環境のnoindexが本番環境に残っているケースは要注意です。URL検査ツールで重要ページにnoindexがないことを確認してください。

五番目に、インデックス可能なURLのみを含むXMLサイトマップをGoogle Search Consoleに送信します。 サイトマップにはnoindexページ、リダイレクト、404ページを含めず、サイト規模が大きい場合はコンテンツタイプやセクションごとにサイトマップを分割すると管理やエラー特定がしやすくなります。

六番目に、クロールエラー(404、5xx、リダイレクトチェーンなど)を修正します。 Google Search Consoleで問題ページを洗い出し、ひとつずつ対応します。重要ページの404エラーはコンテンツ復元や301リダイレクトで代替ページに誘導しましょう。

インデックスカバレッジの今後は、検索技術の進化や生成AIシステムの台頭とともに変化しています。GoogleがCore Web Vitalsや**E-E-A-T(経験・専門性・権威性・信頼性)**の要件を強化する中で、インデックスカバレッジは今後ますますコンテンツの品質やユーザー体験指標に依存していきます。Core Web Vitalsが低かったり、薄いコンテンツは技術的にクロール可能でもインデックス登録が難しくなる可能性があります。

AI生成検索結果やアンサーエンジンの登場も、インデックスカバレッジの意味を変えつつあります。従来の検索順位はインデックス済みページに依存していましたが、AIシステムではインデックスされたコンテンツの引用方法や優先順位が異なる場合があります。今後組織は、Googleでインデックスされているかどうかだけでなく、AIプラットフォームで引用・参照されているかどうかも監視する必要があります。この「二重の可視性」要件により、インデックスカバレッジ監視の範囲はGoogle Search Consoleだけでなく、AIモニタリングプラットフォームにも広げる必要があります。

JavaScriptレンダリングや動的コンテンツの普及もインデックスカバレッジを複雑にし続けます。JavaScriptフレームワークやSPAの導入が進む中、検索エンジンがJSをレンダリングして内容を理解することが求められます。GoogleのJSレンダリング能力は向上していますが、依然として課題も残っています。今後はサーバーサイドレンダリングや動的レンダリングで、クロール時にJS実行を必要としない形で内容を提供することが推奨されるでしょう。

構造化データやスキーママークアップの統合もインデックスカバレッジ向上に重要性を増しています。検索エンジンは構造化データを利用してページ内容やコンテキストをより正確に理解し、インデックス登録の判断にも役立てます。記事、商品、イベント、FAQなど各種コンテンツタイプで包括的なスキーママークアップを実装することで、インデックスカバレッジとリッチリザルトでの可視性が向上する可能性があります。

最後に、インデックスカバレッジはページ単位からエンティティやトピック単位へと拡張していくと考えられます。単にページがインデックスされているかどうかだけでなく、ブランドや商品、トピックが検索エンジンのナレッジグラフやAIトレーニングデータに適切に反映されているかを監視する時代が来るでしょう。これはページ単位のインデックスからエンティティ単位の可視性への根本的なシフトであり、新たな監視アプローチや戦略が求められます。

+++

クロール可能性は、検索エンジンのボットがあなたのウェブサイトのページにアクセスし、ナビゲートできるかどうかを指し、robots.txtやサイト構造などで制御されます。一方、インデックス可能性は、クロールされたページが実際に検索エンジンのインデックスに追加されるかどうかを意味し、メタロボットタグ、カノニカルタグ、コンテンツの品質によって制御されます。ページはインデックス可能であるためにクロール可能でなければなりませんが、クロール可能だからといって必ずしもインデックスされるわけではありません。

ほとんどのウェブサイトでは、インデックスカバレッジを月に一度確認するだけで主要な問題を発見できます。しかし、サイト構造に大きな変更を加えた場合や、新しいコンテンツを定期的に公開する場合、または移行を行う場合は、週に一度または隔週でレポートを監視しましょう。Googleは重大な問題についてメール通知を送信しますが、タイムラグがあるため、最適な可視性を維持するには積極的な監視が不可欠です。

このステータスは、GoogleがURL(通常はサイトマップや内部リンク経由で)を発見したものの、まだクロールしていないことを示します。これはクロールバジェットの制限によって発生することがあり、Googleが他のページを優先してクロールしている場合に起こります。重要なページがこの状態に長期間とどまる場合、クロールバジェットの問題やサイトオーソリティの低下が原因となっていることがあります。

はい、XMLサイトマップをGoogle Search Consoleに送信することで、検索エンジンにページを発見させやすくし、クロールとインデックス登録の優先順位を高めることができます。インデックス可能なURLのみを含む適切に管理されたサイトマップは、Googleのクロールバジェットを重要なコンテンツに集中させ、発見までの時間を短縮することで、インデックスカバレッジを大幅に向上させます。

一般的な問題には、robots.txtによるページのブロック、重要なページへのnoindexメタタグ、適切なカノニカル化がされていない重複コンテンツ、サーバーエラー(5xx)、リダイレクトチェーン、薄いコンテンツなどがあります。また、404エラー、ソフト404、認証が必要なページ(401/403エラー)もインデックスカバレッジレポートによく現れ、可視性向上のために対策が必要です。

インデックスカバレッジは、ChatGPT、Perplexity、Google AI OverviewsなどのプラットフォームによるAI生成応答にあなたのコンテンツが表示されるかどうかに直接影響します。Googleで正しくインデックスされていないページは、AIシステムのトレーニングデータや引用対象に含まれる可能性が低くなります。インデックスカバレッジを監視することで、ブランドコンテンツが従来の検索と生成AI両方で発見・引用されやすくなります。

クロールバジェットとは、Googlebotが一定期間内にあなたのサイトでクロールするページ数のことです。クロールバジェットの効率が悪いサイトでは、多くのページが「検出 - 現在未インデックス」のままになります。クロールエラーの修正、重複URLの削除、robots.txtの戦略的活用によるクロールバジェットの最適化で、Googleが価値の高いコンテンツのインデックスに集中できるようにしましょう。

いいえ、すべてのページをインデックス登録する必要はありません。ステージング環境、重複した商品バリエーション、内部検索結果、プライバシーポリシーのアーカイブなどのページは、noindexタグやrobots.txtでインデックスから除外するのが一般的です。目指すべきは、ユーザーの意図に合致し、SEOの成果に貢献する高価値でユニークなコンテンツのみをインデックス登録することです。

ChatGPT、Perplexity、その他のプラットフォームでAIチャットボットがブランドを言及する方法を追跡します。AI存在感を向上させるための実用的なインサイトを取得します。

AIインデックスカバレッジとは何か、そしてそれがChatGPT、Google AI Overviews、Perplexityでのブランドの可視性にとってなぜ重要かを学びましょう。技術的要因、ベストプラクティス、モニタリング戦略を知り、AIインデックスカバレッジを向上させましょう。...

インデクサビリティとは、検索エンジンがページをインデックスに含める能力のことです。クロール可能性、技術的要素、コンテンツ品質が、あなたのページが検索結果に表示されるかどうかにどのように影響するかを学びましょう。...

インデックス API とは何か、Google への直接URL送信の仕組み、その動作が従来のサイトマップやクロール方式に比べてどのようにインデックス登録を加速させるのかを解説します。...

クッキーの同意

閲覧体験を向上させ、トラフィックを分析するためにクッキーを使用します。 See our privacy policy.