AIクエリボリューム推定

AIクエリボリューム推定とは何か、従来の検索ボリュームとの違い、そしてChatGPT、Perplexity、ClaudeなどのAIプラットフォーム全体でコンテンツの可視性を最適化するために重要な理由について解説します。...

推論とは、訓練済みのAIモデルが、訓練中に習得したパターンや知識を用いて、新しい入力データから出力、予測、または結論を生成するプロセスです。これは、AIシステムが学習した知能を実世界の問題解決に適用する運用フェーズを指します。

推論とは、訓練済みのAIモデルが、訓練中に習得したパターンや知識を用いて、新しい入力データから出力、予測、または結論を生成するプロセスです。これは、AIシステムが学習した知能を実世界の問題解決に適用する運用フェーズを指します。

推論とは、訓練済み人工知能モデルが、訓練段階で習得したパターンや知識を活用して、新しい入力データから出力や予測、結論を生成するプロセスです。AIシステムにおいて、推論は運用フェーズを指し、機械学習モデルが研究室から本番環境へ移行し、実世界の課題解決に活用されます。ChatGPT、Perplexity、Google AI Overviews、Claudeなどとやり取りする際、まさにAI推論が動作しており、モデルは入力を受け取り、膨大な訓練データセットから学んだパターンを基に知的な応答を生成しています。推論は訓練とは根本的に異なり、訓練がモデルに「何をすべきか」を教える段階であるのに対し、推論はモデルが実際に未知のデータに習得した知識を適用するフェーズです。

AIの訓練とAI推論の違いを理解することは、現代の人工知能システムの仕組みを把握するうえで非常に重要です。訓練段階では、データサイエンティストが膨大に精選されたデータセットをニューラルネットワークに投入し、モデルがパターンや関係性、意思決定ルールを反復最適化によって学習します。このプロセスは計算負荷が高く、しばしばGPUやTPUといった専用ハードウェア上で数週間から数ヶ月かかります。訓練が完了し、モデルが最適な重みやパラメータに収束すると、モデルは推論フェーズに入ります。この時点でモデルは「凍結」され、新しいデータから学習することはなく、学習済みのパターンを使って未知の入力に対し予測や出力を生成します。IBMやOracleの調査によれば、推論こそAIの本当のビジネス価値が発揮される場面であり、組織がAI機能を本番システムに大規模展開することを可能にします。AI推論市場は2025年に1,061億5,000万米ドルと評価され、2030年には2,549億8,000万米ドルへ成長すると見込まれており、推論能力への爆発的な需要を反映しています。

AI推論は複数段階のプロセスを経て、生データを知的な出力へと変換します。たとえばChatGPTのような大規模言語モデルにユーザーがクエリを送信すると、推論パイプラインはまず入力エンコーディングから始まり、テキストをニューラルネットワークで処理可能な数値トークンに変換します。モデルは次にプリフィルフェーズへ進み、すべての入力トークンをネットワーク全層で同時に処理し、ユーザーのクエリ内の文脈や関係性を理解します。このフェーズは計算負荷が高いものの、理解に不可欠です。続くデコードフェーズでは、モデルは出力トークンを一つずつ逐次生成し、各トークンが直前までの全トークンに依存します。この逐次生成が、AIチャットボットで見られるストリーミング出力の特徴を生んでいます。最後に、出力変換段階で予測されたトークンが人間が読めるテキストや画像、他の形式に変換され、ユーザーが理解・操作できる形で提供されます。これら一連の処理はリアルタイムアプリケーションではミリ秒単位で完了しなければならず、推論レイテンシの最適化はAIサービス提供者にとって極めて重要となっています。

AIシステムを運用する組織は、目的や性能要件に応じて3つの主要な推論アーキテクチャから選択します。バッチ推論は大量データをオフラインで一定間隔ごとに処理し、日次分析ダッシュボード生成や週次リスク評価、夜間のレコメンド更新などリアルタイム応答が不要な用途に最適です。この手法は大量の予測を一括処理するため効率的かつコストパフォーマンスに優れています。オンライン推論(ダイナミック推論とも呼ばれる)は、リクエスト時に即座に予測を生成し、チャットボット、検索エンジン、リアルタイム不正検知など対話型アプリケーションに不可欠です。オンライン推論は低レイテンシ・高可用性を維持するため、高度なインフラやキャッシュ戦略、モデル最適化技術が求められます。ストリーミング推論はセンサーやIoTデバイス、リアルタイムデータパイプラインから流れるデータを継続的に処理し、各データポイントごとに予測を行います。この手法は産業用設備の予知保全や自動運転車のリアルタイムセンサーデータ処理、都市の交通解析などに活用されます。各推論タイプごとにアーキテクチャ設計やハードウェア要件、最適化戦略が異なります。

| 側面 | バッチ推論 | オンライン推論 | ストリーミング推論 |

|---|---|---|---|

| レイテンシ要件 | 数秒〜数分 | ミリ秒単位 | リアルタイム(1秒未満) |

| データ処理 | 大規模データセットをオフライン処理 | 単一リクエストをオンデマンド処理 | 継続的なデータフロー |

| 主な用途 | 分析、レポート、レコメンド | チャットボット、検索、不正検知 | IoT監視、自律システム |

| コスト効率 | 高い(多くの予測で均等化) | 中(常時稼働インフラが必要) | 中〜高(データ量依存) |

| スケーラビリティ | 優秀(一括処理) | 良好(負荷分散が必要) | 優秀(分散処理) |

| モデル最適化の優先 | スループット | レイテンシとスループットのバランス | レイテンシと精度のバランス |

| ハードウェア要件 | 標準GPU/CPU | 高性能GPU/TPU | 専用エッジハードウェアまたは分散システム |

推論最適化は、AIモデルをより効率的かつ経済的に運用するために不可欠な分野となっています。量子化は、モデル重みの数値精度を標準の32ビット浮動小数点から8ビットや4ビット整数へ下げることで、モデルサイズを75〜90%削減しつつ、元の精度の95〜99%を維持可能です。これにより推論速度が向上し、メモリ要件も低減します。モデル剪定は、重要でないニューロンや接続、または層そのものを除去し、予測に大きく寄与しない冗長なパラメータを排除します。研究では、剪定によってモデルの複雑さを50〜80%削減しても精度低下がごくわずかで済むことが示されています。知識蒸留は、より小型で高速な「生徒モデル」をより大きく高精度な「教師モデル」の挙動に近づけて訓練し、リソース制約下でも十分な性能を維持したままの展開を可能にします。バッチ処理最適化は、複数の推論リクエストをまとめてGPU使用率とスループットを最大化します。キー・バリューキャッシュは、言語モデル推論のデコードフェーズで中間計算結果を保存し、冗長な再計算を回避します。NVIDIAの研究によれば、複数の最適化手法を組み合わせることで10倍の性能向上とインフラコスト60〜70%削減が可能です。これらの最適化は、同時に何千もの推論リクエストを処理する大規模展開で特に重要です。

ハードウェアアクセラレーションは、現代AI推論ワークロードのレイテンシやスループット要件達成の鍵となります。GPU(グラフィックス処理装置)は、その並列アーキテクチャがニューラルネットワーク計算に最適なため、最も広く使われている推論アクセラレータです。NVIDIA GPUは推論インフラの主流であり、専用CUDAコアによる大規模並列化を実現しています。TPU(テンソル処理装置)はGoogleが開発したニューラルネットワーク専用のカスタムASICであり、特定ワークロードでは一般的なGPUを上回る性能効率を発揮します。FPGA(フィールドプログラマブルゲートアレイ)は用途に合わせて再構成可能なカスタムハードウェアで、特殊な推論用途に柔軟に適応できます。ASIC(特定用途向け集積回路)はGoogleのTPUやCerebrasのWSE-3のように、特定の推論ワークロードに特化して設計されており、極めて高い性能を発揮しますが柔軟性は限定されます。ハードウェア選定は、モデル構造や必要レイテンシ、スループット、電力制約、TCO(総所有コスト)など多様な要因に依存します。モバイルやIoTセンサー上でのエッジ推論には、エッジアクセラレータや**ニューラルプロセッシングユニット(NPU)**が超低消費電力で効率的な推論を実現します。AIファクトリー(大規模知能製造インフラ)への世界的シフトにより、企業はデータセンターに何千ものGPUやTPUを導入し、AIサービス需要の急増に対応しています。

ChatGPT、Claude、Perplexityなどの生成AIシステムは、推論によってテキスト・コード・画像など人間らしいコンテンツを生成します。これらのシステムにプロンプトを入力すると、推論プロセスはまず入力を数値表現にトークン化し、ニューラルネットワークが処理可能な形にします。次に、プリフィルフェーズで全入力トークンを同時処理し、コンテキストや意図、ニュアンスを把握します。続いてデコードフェーズで、訓練データから学習したパターンを基に、これまでのすべてのトークンを参照しながら、出力トークンを一つずつ予測・生成します。この逐次トークン生成が、ユーザーがリアルタイムでストリーミング表示を体験できる理由です。推論プロセスは、正確・一貫性・文脈適合性を保ちつつ、低レイテンシを両立する必要があります。スペキュラティブデコーディングのような高度な推論最適化では、小型モデルが複数の将来トークンを予測し、大型モデルがそれを検証することで、レイテンシを大幅に削減します。大規模言語モデルの推論規模は膨大で、OpenAIのChatGPTは毎日数百万件の推論リクエストを処理し、それぞれ数百〜数千トークンを生成するため、莫大な計算インフラと最適化技術が不可欠です。

自社ブランドのAI生成応答やコンテンツ引用状況を重視する組織にとって、推論モニタリングの重要性が高まっています。Perplexity、Google AI Overviews、ClaudeなどのAIシステムが応答を生成する際、訓練済みモデルで推論を行い、出力にドメインやブランド、コンテンツを引用する場合があります。推論システムの仕組みを理解することで、適切なAI生成応答での自社露出を狙ったコンテンツ戦略最適化が可能です。AmICitedは複数プラットフォームにわたるAI推論出力を監視し、ブランドやドメインがどのように引用・参照されているかを可視化します。このモニタリングは、推論システムが学習データの質や関連性指標、モデルの最適化方針によってブランドを含めたり除外したりするため、極めて重要です。組織は推論モニタリングデータから、どのコンテンツが引用されているか、AI応答でブランドがどれだけ登場しているか、ドメインが正しく帰属されているかを把握できます。このインテリジェンスは、コンテンツ最適化、SEO戦略、AI時代のブランドポジショニングの意思決定に活用できます。推論が情報発見の主なインターフェースとなる中、AI生成出力での存在感把握は従来の検索エンジン最適化と同じくらい重要です。

推論システムを大規模展開するには、多くの技術的・運用的・戦略的課題に対応する必要があります。レイテンシ管理は永続的な課題で、ユーザーは双方向AIアプリに1秒未満の応答を期待する一方、数十億パラメータの複雑モデルは膨大な計算時間を要します。スループット最適化も同様に重要で、数千〜数百万の同時推論リクエストを、許容可能なレイテンシと精度でさばく必要があります。モデルドリフトは、現実世界のデータ分布が訓練データから乖離することで推論精度が低下する現象で、継続的なモニタリングや定期的な再訓練が不可欠です。解釈性・説明性も高まりつつあり、AI推論システムの判断根拠を把握・説明することが組織に求められます。規制対応も拡大しており、EU AI法のような規則はAI推論システムの透明性・バイアス検知・人間の監督を義務付けています。データ品質も根本的要素で、推論システムの性能は訓練データの質に依存し、質が悪ければバイアスや不正確、有害な推論を生みます。インフラコストも大きく、大規模推論展開にはGPUやTPU、ネットワーク、冷却設備などへの多額投資が必要です。人材不足も顕著で、推論最適化やモデル展開、MLOpsに長けたエンジニアやデータサイエンティストの確保が難しく、人件費上昇や展開遅延の要因となっています。

AI推論の将来は、運用・展開方法を大きく変革するいくつかの重要トレンドで急速に進化しています。エッジ推論(クラウドではなくローカルデバイス上での推論)は、モデル圧縮や専用エッジハードウェア、プライバシー要件の進展により加速しています。これにより、スマートフォンやIoTデバイス、自律システムでリアルタイムAIがクラウドレスで実現されます。マルチモーダル推論(テキスト・画像・音声・動画を同時処理・生成)は一般化しつつあり、新たな最適化やハードウェア要件が求められています。推論自体を多段階で実行し複雑な課題を解決する「推論型モデル」も登場し、OpenAIのo1のように推論も計算時間やトークン数でスケールする時代になりつつあります。分離型サービングアーキテクチャも普及しつつあり、別々のハードウェアクラスタがプリフィルとデコードフェーズを分担し、異なる計算特性に最適化します。スペキュラティブデコーディングなど高度な推論手法は標準化しつつあり、2〜3倍のレイテンシ短縮を実現します。エッジ推論と連合学習の組み合わせにより、プライバシーを守りつつリアルタイムAIをローカル展開可能となります。AI推論市場は**2030年まで年平均成長率19.2%**で拡大が見込まれ、企業の導入拡大や新用途、推論コスト最適化の経済的要請が推進力となっています。推論がAIインフラの主力ワークロードとなる中、最適化技術・専用ハードウェア・推論特化ソフトウェアの高度化が競争力の鍵となるでしょう。

AIの訓練は、大規模なデータセットを使ってモデルにパターンを認識させるプロセスです。一方、AI推論は、その訓練済みモデルが新しいデータに対して学習したことを適用し、予測や出力を生成する段階です。訓練は計算負荷が高く一度きりですが、推論は通常高速でリソース消費も少なく、本番環境で継続的に行われます。訓練は「試験勉強」、推論は「実際に試験を受ける」ことに例えられます。

推論レイテンシ(モデルが出力を生成するまでの時間)は、ユーザー体験やリアルタイムアプリケーションにとって非常に重要です。低レイテンシの推論は、チャットボットやリアルタイム翻訳、自動運転車、不正検知システムで即時応答を可能にします。高レイテンシでは時間に敏感なタスクで使い物になりません。企業は量子化やモデル剪定、GPUやTPUなど専用ハードウェアを使ってレイテンシを最適化し、サービスレベル合意を満たしています。

主な3つのタイプは、バッチ推論(大量データをオフラインで処理)、オンライン推論(リクエスト時に即座に予測)、ストリーミング推論(センサーやIoTデバイスからのデータを継続的に処理)です。バッチ推論は日次分析ダッシュボードなどに、オンライン推論はチャットボットや検索エンジンに、ストリーミング推論はリアルタイム監視システムに適しています。それぞれレイテンシ要件や用途が異なります。

量子化はモデルの重みの数値精度を32ビットから8ビット以下に下げ、モデルサイズや計算負荷を大幅に削減しつつ精度を維持します。剪定はニューラルネットワークから重要でないニューロンや接続を取り除き、複雑さを減らします。これらの手法により推論レイテンシを50〜80%削減し、ハードウェアコストも低減できます。最適化はエッジデバイスやモバイルへのモデル展開に不可欠です。

推論は生成AIシステムがテキスト・画像・コードなどを生み出す中核的なメカニズムです。ChatGPTにプロンプトを与えると、推論プロセスが入力をトークン化し、訓練済みニューラルネットワーク層で処理し、出力トークンを一つずつ生成します。プリフィルフェーズで入力トークンすべてを同時処理し、デコードフェーズで出力を逐次生成します。この推論能力が大規模言語モデルの即応性や実用性を支えています。

推論モニタリングは本番環境でAIモデルの精度やレイテンシ、出力品質を追跡します。AmICitedのようなプラットフォームはChatGPTやPerplexity、Google AI OverviewsなどでブランドやドメインがAI生成応答中にどこで現れるかを監視します。推論挙動を理解することで、自社のコンテンツがAI出力でどのように引用・表現されるかを把握できます。

一般的な推論アクセラレータには並列処理に適したGPU(グラフィックス処理装置)、ニューラルネットワーク最適化のTPU(テンソル処理装置)、カスタマイズ可能なFPGA(フィールドプログラマブルゲートアレイ)、特定用途向けのASIC(特定用途向け集積回路)があります。GPUは性能とコストのバランスで最も広く使われ、TPUは大規模推論に強みがあります。選択はスループット、レイテンシ、予算などに依存します。

世界のAI推論市場は2025年に1,061億5,000万米ドルと評価され、2030年には2,549億8,000万米ドルに達すると予測されており、年平均成長率(CAGR)は19.2%です。この急成長は企業によるAI導入増加を反映しており、AI利用企業は2023年の55%から2024年には78%に拡大しています。成長はヘルスケア、金融、小売、自律システムなど多様な業界でリアルタイムAIアプリケーション需要が牽引しています。

ChatGPT、Perplexity、その他のプラットフォームでAIチャットボットがブランドを言及する方法を追跡します。AI存在感を向上させるための実用的なインサイトを取得します。

AIクエリボリューム推定とは何か、従来の検索ボリュームとの違い、そしてChatGPT、Perplexity、ClaudeなどのAIプラットフォーム全体でコンテンツの可視性を最適化するために重要な理由について解説します。...

AIリーチ推定とは何か、その仕組みやChatGPT・Perplexity・Google AI Overviewsを含むAIプラットフォーム全体でのブランド可視性にとってなぜ重要なのかを解説します。AIリーチを向上させるツールや戦略もご紹介。...

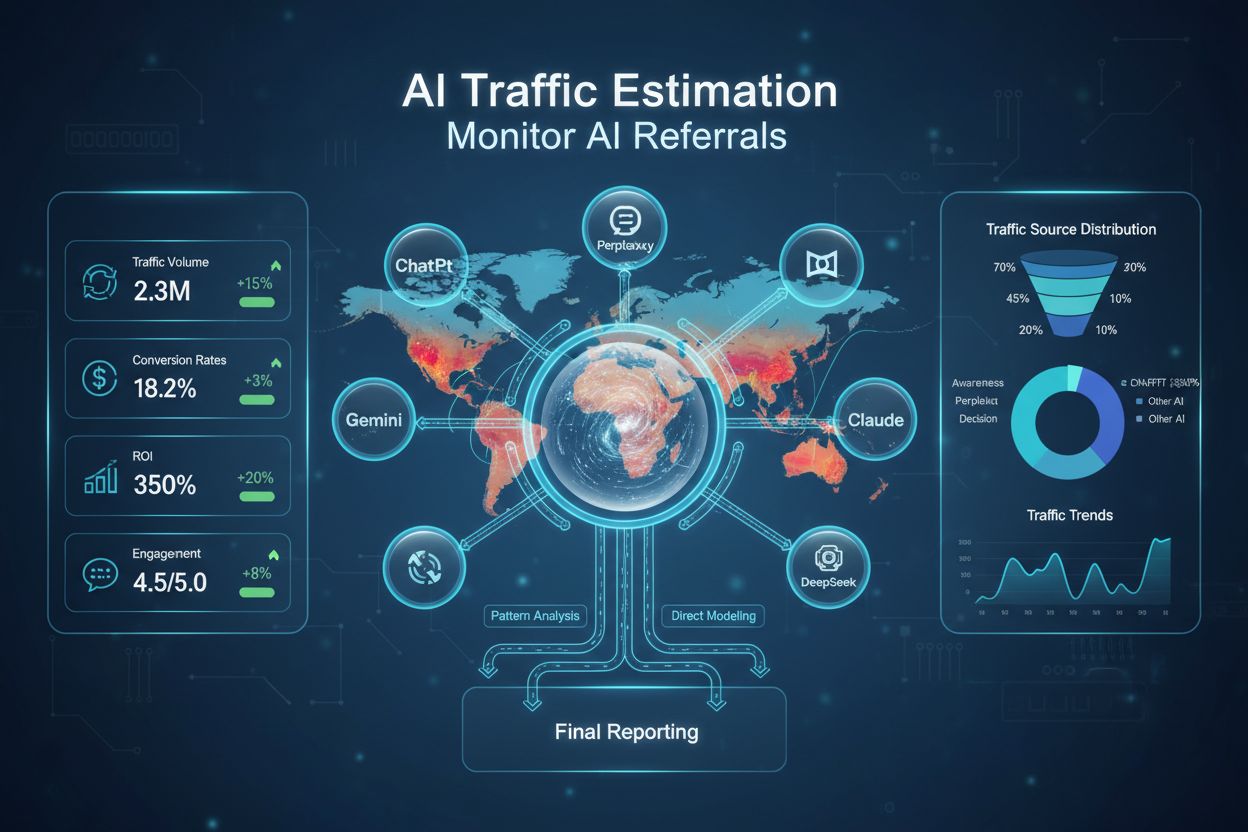

AIトラフィック推定がパターン分析と直接トラフィックモデリングを使って未計測のAIリファラルトラフィックをどのように算出するかを解説。ChatGPTやPerplexityなど各種AIプラットフォームからのトラフィックの測定方法・ツール・ベストプラクティスをご紹介します。...

クッキーの同意

閲覧体験を向上させ、トラフィックを分析するためにクッキーを使用します。 See our privacy policy.