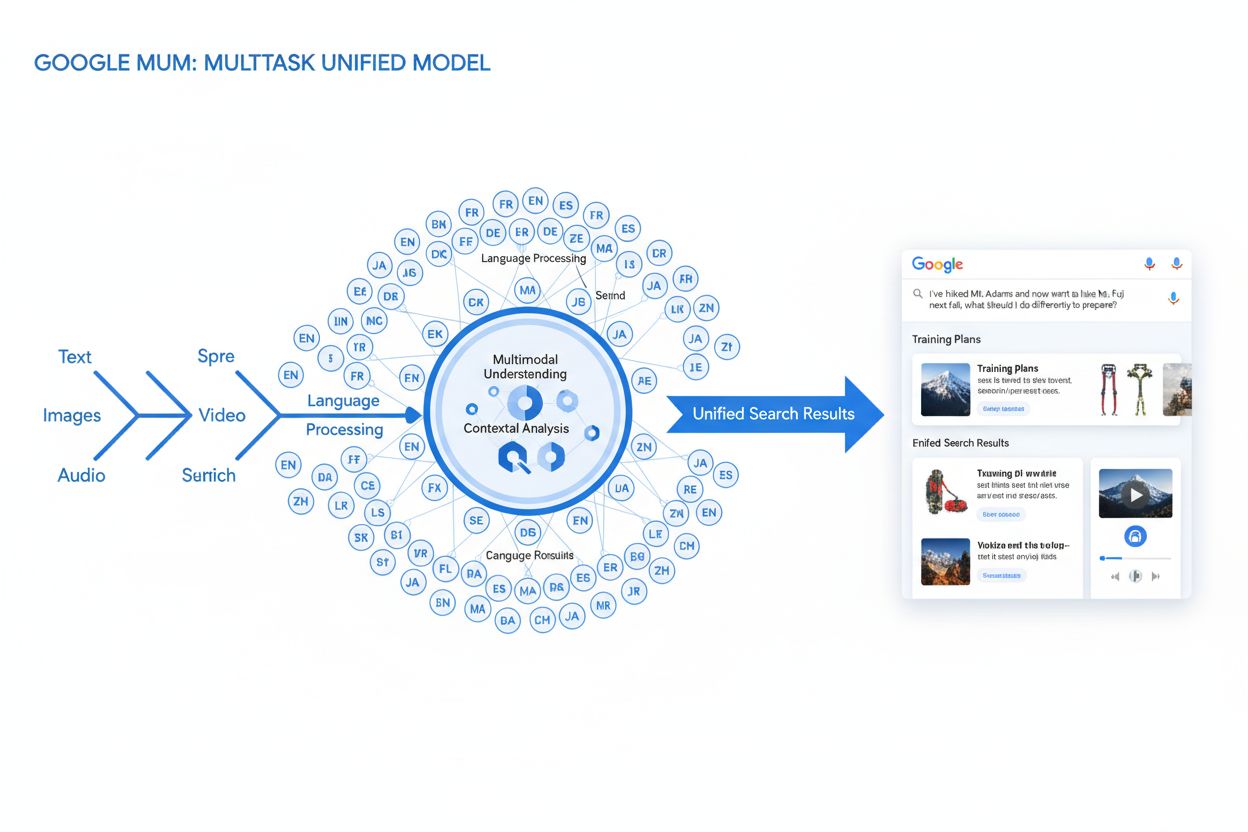

MUM(マルチタスク・ユニファイド・モデル)

MUMはGoogleのマルチタスク・ユニファイド・モデルであり、テキスト・画像・動画・音声を75以上の言語で処理するマルチモーダルAIです。検索の変革やAI可視性への影響について解説します。...

モデルパラメータは、AIモデル内の学習可能な変数であり、重みやバイアスなど、トレーニング中に自動的に調整されてモデルの予測精度を最適化し、モデルが入力データを処理して出力を生成する方法を定義します。

モデルパラメータは、AIモデル内の学習可能な変数であり、重みやバイアスなど、トレーニング中に自動的に調整されてモデルの予測精度を最適化し、モデルが入力データを処理して出力を生成する方法を定義します。

モデルパラメータとは、人工知能モデル内で学習可能な変数であり、トレーニングプロセスで自動的に調整されてモデルの予測精度を最適化し、モデルが入力データを処理して出力を生成する方法を定義します。これらのパラメータは機械学習システムの基本的な「調整ノブ」として機能し、AIモデルの具体的な挙動や意思決定パターンを決定します。ディープラーニングやニューラルネットワークの文脈では、パラメータは主に重みとバイアスで構成されます。これらはネットワーク内で情報の流れや、異なる特徴が予測にどれだけ強く影響するかを制御する数値です。トレーニングの目的は、これらのパラメータの予測誤差を最小化し、未知の新しいデータにも汎化できる最適な値を見つけることです。モデルパラメータを理解することは、ChatGPT、Claude、Perplexity、Google AI Overviewsのような現代のAIシステムがどのように機能し、なぜ同じ入力に対して異なる出力を生成するのかを理解する上で不可欠です。

機械学習における学習可能なパラメータという概念は、1950年代~1960年代の人工ニューラルネットワーク初期にさかのぼり、ネットワークが内部値を調整してデータから学習できることが初めて認識されました。しかし、パラメータの実用的な応用は1980年代に誤差逆伝播法が登場するまで限定的であり、それによってパラメータを効率的に調整して誤差を減らすアルゴリズムが提供されました。パラメータ数の爆発的増加は2010年代のディープラーニングの台頭とともに加速しました。初期の画像認識用畳み込みニューラルネットワークは数百万のパラメータを持っていましたが、現代の**大規模言語モデル(LLM)**は数千億~数兆のパラメータを持ちます。Our World in DataやEpoch AIの研究によれば、注目すべきAIシステムのパラメータ数は指数関数的に増加しており、GPT-3は1,750億、GPT-4oは約2,000億、GPT-4はMixture-of-Experts(MoE)アーキテクチャを考慮すると最大1.8兆とする推計もあります。この劇的なスケーリングはAIシステムの能力を根本的に変え、言語・画像・推論タスクでますます複雑なパターンを捉えられるようにしました。

モデルパラメータは、各パラメータが入力から出力への変換にどのように影響するかを表す数値として、数学的枠組みの中で動作します。単純な線形回帰モデルでは、パラメータはy = mx + bの傾き(m)と切片(b)であり、これらの値がデータに最も合致する直線を決定します。ニューラルネットワークでは状況は飛躍的に複雑になります。各層のニューロンは前の層からの入力を受け取り、それぞれに対応する重みパラメータを掛け合わせ、加重入力を合計し、バイアスパラメータを加え、活性化関数を通して出力を生成します。この出力が次の層のニューロンへの入力となり、パラメータ駆動の変換が連鎖的に発生します。トレーニング時には、モデルが勾配降下法や関連する最適化アルゴリズムを使って、各パラメータをどのように調整すれば損失関数(予測誤差の数学的尺度)が減少するか計算します。損失の各パラメータに対する勾配が、調整の方向と大きさを示します。誤差逆伝播法によって勾配がネットワーク内を逆伝播し、オプティマイザがすべてのパラメータを同時に協調して更新します。この繰り返しプロセスを複数のエポックで続け、トレーニングデータでの損失を最小化しつつ新しいデータへの汎化性も維持できるパラメータ値に収束させます。

| 観点 | モデルパラメータ | ハイパーパラメータ | 特徴量 |

|---|---|---|---|

| 定義 | トレーニング中に調整される学習可能な変数 | トレーニング前に設定される構成パラメータ | モデルが利用する入力データの特性 |

| 設定時期 | 最適化によって自動で学習 | 実務者が手動で設定 | 生データから抽出・設計 |

| 例 | ニューラルネットワークの重み・バイアス | 学習率、バッチサイズ、層数 | 画像の画素値、テキストの単語埋め込み |

| モデルへの影響 | 入力から出力へのマッピングを決定 | トレーニング過程や構造を制御 | モデルが学習する情報を提供 |

| 最適化手法 | 勾配降下法、Adam、AdaGrad | グリッドサーチ、ランダムサーチ、ベイズ最適化 | 特徴量エンジニアリング、特徴量選択 |

| 大規模モデルでの数 | 数十億~数兆(例:GPT-4oは2,000億) | 主要なハイパーパラメータは通常5~20 | データにより数千~数百万 |

| 計算コスト | トレーニング時に高い・推論速度にも影響 | 設定時の計算コストは最小 | データ収集・前処理に依存 |

| 移植性 | ファインチューニング・転移学習で転送可能 | 新タスクごとに再調整が必要 | 新しい領域では再設計が必要な場合あり |

モデルパラメータは、使用する機械学習モデルのアーキテクチャや種類によってさまざまな形態を取ります。画像認識に用いられる**畳み込みニューラルネットワーク(CNN)では、空間的パターン(エッジ、テクスチャ、形状など)を検出する畳み込みフィルター(カーネル)の重みがパラメータとなります。再帰型ニューラルネットワーク(RNN)や長短期記憶(LSTM)ネットワークでは、時間的な情報の流れを制御するパラメータや、情報の記憶・忘却を決定するゲートのパラメータを持ちます。現代の大規模言語モデルを支えるトランスフォーマーモデルでは、入力のどの部分に注目するかを決定するアテンション重み、フィードフォワードネットワークの重み、レイヤ正規化のパラメータなど、複数の構成要素にパラメータがあります。ナイーブベイズのような確率的モデルでは、条件付き確率分布を定義するパラメータが存在します。サポートベクターマシンでは、特徴空間内の決定境界の位置や向きを決定するパラメータがあります。GPT-4の一部バージョンで使われるMixture of Experts (MoE)**モデルでは、複数の専門サブネットワークのパラメータと、それぞれの入力をどの専門家が処理するかを決めるルーティングパラメータが含まれます。このようなアーキテクチャの多様性により、パラメータの性質や数はモデルごとに大きく異なりますが、「タスクを実行するためにモデルが学習する値」という原則は一貫しています。

重みとバイアスはニューラルネットワークにおける2つの基本的なパラメータであり、モデルが学習する仕組みの基盤です。重みはニューロン間の接続に割り当てられる数値で、あるニューロンの出力が次のニューロンの入力にどれだけ影響するか(強さと方向性)を決定します。例えば、1,000入力・500出力の全結合層では接続ごとに1つずつ、合計で50万個の重みパラメータがあります。トレーニング中、重みは特定の特徴が予測に与える影響を強めたり弱めたりするように調整されます。大きな正の重みは次のニューロンを強く活性化させ、負の重みは抑制的に働きます。バイアスは各層のニューロンごとに1つ追加されるパラメータで、活性化関数に入力される前の合計値に一定のオフセットを加えます。数学的には、加重入力の合計がゼロであっても、バイアスによってニューロンがゼロ以外の出力を生成できるようになり、モデルに重要な柔軟性を与えます。この柔軟性により、ニューラルネットワークは重みだけでは実現できない複雑な決定境界やパターンも学習できます。GPT-4oのような2,000億パラメータのモデルでは、その大部分がアテンション機構やフィードフォワードネットワークの重みであり、バイアスも小さくない割合を占めます。重みとバイアスが連携することで、現代AIが言語や画像・その他領域で高度なパターンを学習できるのです。

モデル内のパラメータ数は、複雑なパターンを学習する能力や全体的な性能に大きな影響を与えます。研究により、パラメータ数・トレーニングデータ量・モデル性能にはスケーリング則が成り立つことが示されています。パラメータ数が多いほど、より複雑な関数や微細なパターンを表現でき、困難なタスクでの性能向上につながります。1,750億パラメータのGPT-3は、より小型のモデルでは不可能だったfew-shot学習能力を示しました。2,000億パラメータのGPT-4oは、推論・コード生成・マルチモーダル理解などでさらに優れた性能を発揮します。ただし、パラメータ数と性能の関係は単純な線形ではなく、トレーニングデータの量と質に大きく依存します。パラメータ数が多すぎてデータが少ないと過学習し、一般化できなくなります。逆にパラメータが少なすぎると十分にパターンを捉えられず、トレーニングデータにも満足に適合できません。最適なパラメータ数は、タスクの複雑さ・データセットの規模と多様性・計算資源など複数要素に依存します。Epoch AIの研究では、Mixture-of-Expertsのように入力ごとに全パラメータがアクティブでない構造も含めると、現代AIシステムは数兆パラメータ級までスケールしており、これが著しい性能向上を支えています。

数十億パラメータの大規模モデルは高性能を実現する一方、トレーニングや運用の計算コストが非常に高くなります。そこでパラメータ効率の良いファインチューニング手法の研究が進み、すべてのパラメータを更新せずに事前学習済みモデルを新タスクに適応できるようになりました。代表的なLoRA(Low-Rank Adaptation)は、事前学習済みパラメータの大部分を固定し、ごく少数の追加の低ランク行列だけを訓練することで、学習パラメータ数を大幅に削減しつつ性能を維持します。例えば70億パラメータのモデルをLoRAでファインチューニングする場合、全体ではなく100~200万程度の追加パラメータのみを訓練します。アダプタモジュールは、固定された事前学習済みモデルの層間に小型の学習可能ネットワークを挿入し、タスク固有の適応を可能にします。プロンプトエンジニアリングやインコンテキストラーニングはパラメータを変更せず、入力の工夫によって既存のパラメータを効果的に活用するアプローチです。これらのパラメータ効率手法により、大規模言語モデルのカスタマイズが計算資源の限られた組織にも広がりました。パラメータ効率と性能のバランスは今も研究が盛んで、実務では計算コストとタスク特化精度の間で最適化が求められます。

AmICitedのように、ChatGPT、Perplexity、Claude、Google AI Overviewsなど複数システムでブランドやドメインのAI応答出現をモニタリングするプラットフォームにとっても、モデルパラメータの理解は不可欠です。異なるパラメータ構成のAIモデルは、同じクエリに対しても異なる出力を生成し、ブランドの出現場所や頻度に影響します。GPT-4oの2,000億パラメータは、Claude 3.5 SonnetやPerplexityのモデルとは異なる構成であり、応答生成に違いが生じます。異なるデータセットや学習目標でトレーニングされたパラメータは、モデルの知識・推論パターン・引用傾向にも違いを生みます。ブランド出現のモニタリング時には、こうした違いがパラメータ由来であることを理解することで、あるAIではブランドが目立つが別のAIではほとんど言及されない理由も説明できます。アテンション機構を制御するパラメータは、どのトレーニングデータ部分がクエリに関連するかを決め、引用パターンに影響します。出力生成層のパラメータは情報の構造化や提示方法を決定します。AmICitedは、異なるパラメータ構成のAIシステムでどのようにブランドが扱われるかを追跡し、パラメータ駆動のモデル挙動がAI検索領域でのブランド可視性に及ぼす影響を分析します。

モデルパラメータの未来は、AIシステムの設計・運用を根本的に変える複数のトレンドによって形作られつつあります。Mixture of Experts (MoE)アーキテクチャは大きな進化であり、複数の専門サブネットワーク(エキスパート)が個別のパラメータを持ち、ルーティング機構が入力ごとに担当エキスパートを決めます。この手法により、すべての入力で全パラメータを使用せずに推論時の計算効率を保ちつつ、モデルを数兆パラメータ級までスケーリングできます。GPT-4は16のエキスパート(各1,100億パラメータ)を持ち、合計1.8兆パラメータでありながら一度に使うのは一部のみとされています。スパースパラメータやプルーニング技術も発展し、重要度の低いパラメータを除去して性能を維持したままモデルサイズを削減できます。継続学習は、新しいデータが得られるたびに効率的にパラメータを更新し、全体の再学習なしでモデルを適応させることを目指します。フェデレーテッドラーニングは、複数デバイス上でパラメータトレーニングを分散実行し、プライバシーを守りながら大規模学習を可能にします。数十億パラメータ規模の**小型言語モデル(SLM)**の登場は、パラメータ効率が単なる規模と並ぶ重要課題となる未来を示唆します。AIが社会基盤に統合されるほど、モデルパラメータの理解と制御は、安全性・公平性・人間の価値観への整合性確保にとってますます重要になります。パラメータ数とモデル挙動の関係性はAI研究の中心的テーマであり、計算持続性から解釈性・信頼性まで多方面に影響を与え続けます。

モデルパラメータは、勾配降下法などの最適化アルゴリズムによってトレーニング中に学習される内部変数です。一方、ハイパーパラメータはトレーニング開始前に設定される外部の設定値です。パラメータはモデルが入力から出力への写像を決定し、ハイパーパラメータは学習率やエポック数などトレーニングプロセス自体を制御します。例えば、ニューラルネットワークの重みやバイアスはパラメータ、学習率はハイパーパラメータです。

現代の大規模言語モデルは数十億から数兆のパラメータを持っています。GPT-4oは約2,000億のパラメータを持ち、GPT-4o-miniは約80億パラメータです。Claude 3.5 Sonnetも数千億のパラメータで動作しています。これらの膨大なパラメータ数が、モデルに複雑な言語パターンを捉え、多様なトピックで洗練された適切な応答を生成する能力を与えています。

パラメータが多いほど、モデルは複雑なパターンやデータ内の関係性を学習できる能力が高まります。追加のパラメータにより、より微細な特徴や相互作用を表現でき、トレーニングデータでの精度向上につながります。しかし、パラメータが多すぎると訓練データに対して過学習を起こし、ノイズを記憶してしまい新しいデータへの汎化性能が低下するため、バランスが重要です。

モデルパラメータは、誤差逆伝播法と勾配降下法のような最適化アルゴリズムによって更新されます。トレーニング中、モデルは予測を行い、予測値と実際の値の誤差(損失)を計算し、それぞれのパラメータがその誤差にどの程度寄与したかを示す勾配を求めます。最適化手法が損失を減らす方向にパラメータを調整し、このプロセスを繰り返して最適なパラメータ値に収束させます。

重みはニューラルネットワーク内のニューロン間の接続の強さを決定し、入力特徴が出力にどのように影響するかを制御します。バイアスはしきい値の調整役として機能し、入力がゼロでもニューロンが活性化できるようになり、柔軟性が増します。重みとバイアスはニューラルネットワークの中核となる学習可能なパラメータであり、複雑な関数の近似や正確な予測を可能にします。

モデルパラメータは、ChatGPT、Perplexity、ClaudeといったAIシステムがクエリにどのように応答するかを直接左右します。パラメータ数や設定を理解することで、同じプロンプトに対して異なるAIモデルが異なる出力を生成する理由が説明できます。AmICitedのようなブランドモニタリングプラットフォームでは、パラメータがモデルの挙動にどのように影響するかを追跡することが、ブランドがAI応答にどこでどのように現れるかを予測し、異なるAIシステム間の一貫性を理解する上で重要です。

はい。転移学習を用いることで、事前学習済みモデルのパラメータを新しいタスクに適応できます。この手法はファインチューニングと呼ばれ、学習済みパラメータを新しいデータで調整することで特定の用途に対応させます。LoRA(Low-Rank Adaptation)のようなパラメータ効率の良いファインチューニング手法は、パラメータの一部だけを選択的に更新し、計算コストを抑えつつ性能を維持できます。この技術は大規模言語モデルのカスタマイズに広く利用されています。

モデルパラメータはトレーニングおよび推論時の計算要件に直接影響します。パラメータが多いほど、より多くのメモリや計算資源、トレーニング・デプロイにかかる時間が必要になります。例えば、1,750億パラメータを持つモデル(GPT-3など)は、70億パラメータのモデルよりも大幅に多くの計算リソースを必要とします。この関係はAIシステムの運用時のインフラコストやレイテンシ、エネルギー消費にとって重要な要素です。

ChatGPT、Perplexity、その他のプラットフォームでAIチャットボットがブランドを言及する方法を追跡します。AI存在感を向上させるための実用的なインサイトを取得します。

MUMはGoogleのマルチタスク・ユニファイド・モデルであり、テキスト・画像・動画・音声を75以上の言語で処理するマルチモーダルAIです。検索の変革やAI可視性への影響について解説します。...

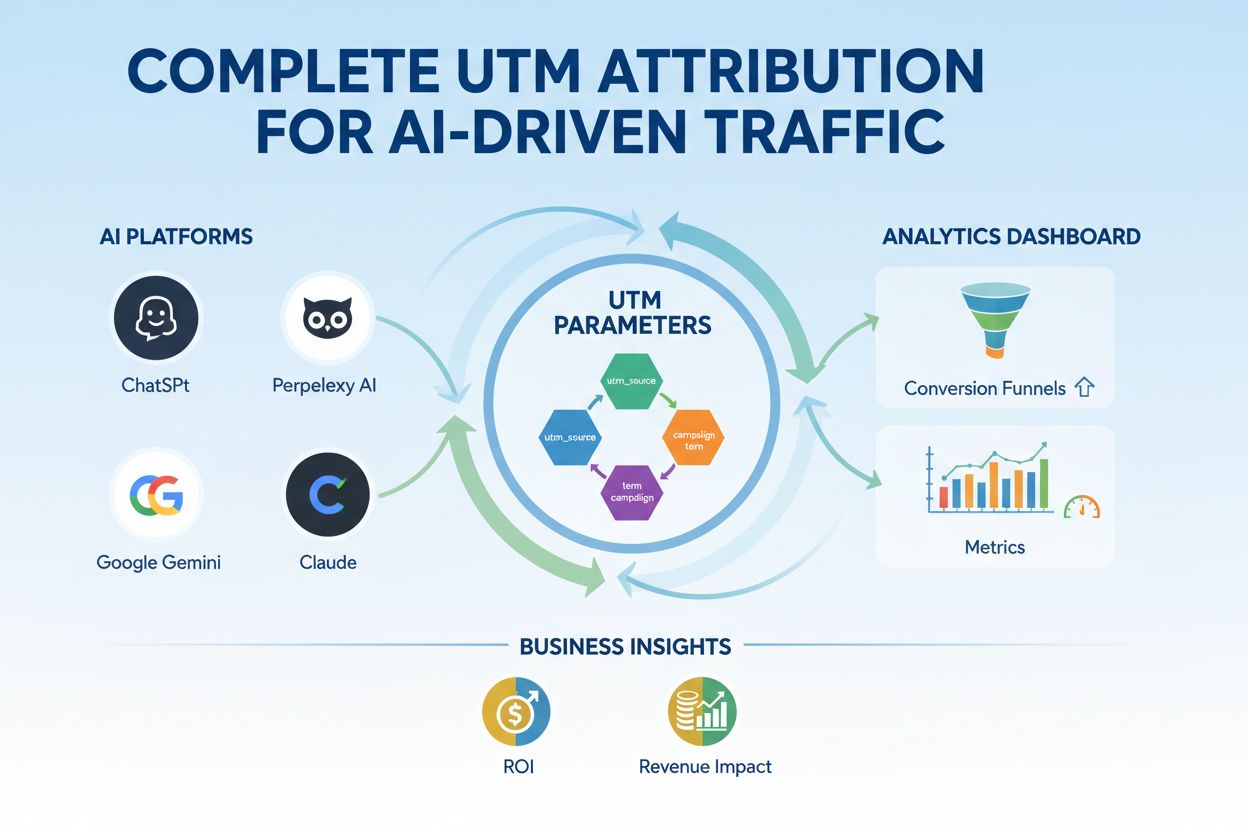

UTMパラメータは、マーケティングキャンペーンの効果を追跡するURLタグです。utm_source、utm_medium、utm_campaignなどのパラメータが、トラフィックの発信元を測定し、マーケティングROIの最適化に役立つ方法を学びましょう。...

ChatGPT、Perplexity、Google GeminiのようなAIプラットフォーム向けにUTMトラッキングをマスターしましょう。セットアップ方法、ベストプラクティス、GA4でAIトラフィックを正確に帰属させる方法を学びます。...

クッキーの同意

閲覧体験を向上させ、トラフィックを分析するためにクッキーを使用します。 See our privacy policy.