コンテンツにおけるパープレキシティスコアとは?

パープレキシティスコアとは何か、コンテンツや言語モデルにおいてどのような意味があるのかを学びましょう。モデルの不確実性、予測精度、テキスト品質評価の指標としての役割を理解します。...

パープレキシティ・スコアは、言語モデルによるテキストの不確実性や予測可能性を定量的に測定する指標であり、予測されたトークンの負の対数尤度の平均を指数化して算出されます。スコアが低いほどモデルの自信が高く、より優れたテキスト予測能力を示し、スコアが高いほど次に出現する語の予測に対する不確実性が大きいことを示します。

パープレキシティ・スコアは、言語モデルによるテキストの不確実性や予測可能性を定量的に測定する指標であり、予測されたトークンの負の対数尤度の平均を指数化して算出されます。スコアが低いほどモデルの自信が高く、より優れたテキスト予測能力を示し、スコアが高いほど次に出現する語の予測に対する不確実性が大きいことを示します。

パープレキシティ・スコアは、自然言語処理における基本的な指標であり、言語モデルが生成するテキストの不確実性や予測可能性を定量化します。正式には系列に対する負の対数尤度の平均を指数化したものと定義され、パープレキシティ・スコアは、確率モデルがサンプルをどれだけうまく予測できているかを、次のトークンを予測する際にモデルが考慮する等確率の語彙の平均数として算出します。この指標は1977年、IBMのFrederick Jelinek率いる音声認識の研究において、統計モデルが予測課題で直面する困難さを測定しようとしたことに端を発します。現代のAIシステム、例えばChatGPT、Claude、Perplexity AI、Google AI Overviewsなどの文脈では、パープレキシティ・スコアはモデルの自信度やテキスト生成品質を評価する重要な仕組みとして機能しています。スコアが低いほどモデルが予測に自信があり正しい語に高い確率を割り当てていることを示し、スコアが高いほど次に来る単語に対する不確実性や混乱が大きいことを示します。

パープレキシティ・スコアの概念は、1940年代から1950年代にかけてClaude Shannonが確立した情報理論の原理から生まれました。Shannonによる「印刷英語の予測とエントロピー」に関する画期的な研究は、人間がテキスト中の次の文字を驚くほど高い精度で予測できることを示し、計算言語モデリングの理論的土台を築きました。1980~90年代を通じて、パープレキシティ・スコアはn-gram言語モデルの評価における主要指標となり、ディープラーニング革命以前の最先端手法の基準でした。その後、ニューラル言語モデルやRNN、トランスフォーマーベースのアーキテクチャが登場しても、この指標はNLPの評価スタンダードとして広く用いられ続けています。現在でもBERTScore、ROUGE、LLM-as-a-Judgeなど新しい指標と併用される場面が多いですが、総合的なモデル評価には他の指標の補完が重要であると研究者の認識が高まっています。パープレキシティの長寿命は、その数学的な優雅さと実用性の高さを示していますが、現代の応用では補助的な評価手法が必要な限界も明らかになっています。

パープレキシティ・スコアの数学的基盤は、情報理論のエントロピー、クロスエントロピー、対数尤度という3つの概念にあります。エントロピーは単一確率分布における平均的不確実性を測り、過去文脈に基づく次単語の予測困難さを定量化します。クロスエントロピーは真のデータ分布とモデルによる予測分布との差を測り、不正確な予測をペナルティ化します。パープレキシティ・スコアの公式な計算式は PPL(X) = exp{-1/t ∑ log p_θ(x_i|x_<i)} で表され、tは系列内のトークン数、p_θ(x_i|x_<i)はそれまでのトークンに基づくi番目トークンの予測確率です。この式は、平均負対数尤度を指数関数により解釈可能な指標へと変換し、対数を“打ち消す”ことで確率空間へ戻しています。この値は有効な分岐数—すなわちモデルが各予測ステップで考慮する等確率の単語選択肢の平均数—を示します。例えば、パープレキシティ・スコアが10なら次単語の平均的な選択肢が10通り、100なら100通りと、予測の不確実性が大きいことを意味します。

| 指標 | 定義 | 測定内容 | 解釈 | 制限 |

|---|---|---|---|---|

| パープレキシティ・スコア | 平均負対数尤度の指数化 | 予測におけるモデルの不確実性・自信度 | 低い=自信あり、高い=不確実 | 正確性や意味理解は測定しない |

| エントロピー | 単一確率分布の平均的不確実性 | 結果の本質的予測困難性 | 高いほど予測困難な言語 | 予測分布と真の分布の比較はしない |

| クロスエントロピー | 真の分布と予測分布の差 | モデル予測が実データにどれだけ合致するか | 低いほど真の分布に近い | 対数空間で解釈が難しい |

| BLEUスコア | 生成文と参照文のn-gram一致精度 | 翻訳・要約品質 | 高いほど参照に近い | 意味や流暢さは評価しない |

| ROUGEスコア | 生成文と参照文のn-gram一致再現率 | 要約品質・内容網羅性 | 高いほど参照内容の網羅率が高い | 参照ベース評価に限定される |

| 精度(Accuracy) | 正解予測・分類の割合 | モデル出力の正確性 | 高いほど正解予測が多い | 自信や不確実性は測定しない |

| BERTScore | BERT埋め込みによる文脈的類似性 | 生成・参照文の意味的類似度 | 高いほど意味的に近い | 計算負荷が高く参照テキスト必須 |

パープレキシティ・スコアは、言語モデルが系列内の各トークンを、それまでのトークンを条件としてどれだけうまく予測できるかを評価します。モデルは各位置ごとに語彙全体に対する確率分布を生成し、ありえる単語に高い確率、そうでないものに低い確率を割り当てます。モデルはテストデータで実際に出現した次単語の対数確率を計算し、これらを系列全体で平均化。平均値を-1倍して正の値にし、指数化することで対数空間から確率空間へ戻します。これにより、パープレキシティ・スコアはモデルが“どれだけ驚いたか(困惑したか)”を表現し、スコアが低いほど実際に現れた単語に高い確率を割り当てていたこと、スコアが高いほど低い確率を割り当てていたことを示します。現代のトランスフォーマーモデル(GPT-2、GPT-3、Claude等)では、入力テキストのトークナイズ、モデルへの入力~ロジット出力、ソフトマックスによる確率化、有効トークンの負対数尤度平均化までを実装します。固定長文脈モデルではスライディングウィンドウ戦略がよく使われ、文脈ウィンドウをずらして最大限の文脈を利用することで、非重複チャンク法よりも精度の高いパープレキシティ推定が可能です。

企業や研究現場において、パープレキシティ・スコアは言語モデルの導入・監視における重要な品質保証指標です。組織はパープレキシティ・スコアを活用し、モデルの再学習・ファインチューニング・設計改善の必要性を判断したり、スコア悪化が性能劣化の兆候となることを監視します。AmICitedのようなAI監視プラットフォームでは、パープレキシティ・スコアがChatGPT、Perplexity AI、Claude、Google AI Overviewsなど複数プラットフォームでブランド・ドメイン・URLに関する回答の自信度を定量的に把握する根拠となります。ブランド関連クエリで一貫して低パープレキシティなら、安定した自信ある引用パターン、スコアの上昇は不確実性や表現の揺れを示します。約78%の企業がAIガバナンスにパープレキシティを含む自動評価指標を導入しており、特に医療・法律・金融等の高リスク分野ではモデル自信度の把握が不可欠です。過信した誤答よりも、不確実な回答で人間確認を促す方がリスクは低いためです。パープレキシティ・スコアは学習やファインチューニング時のリアルタイム監視にも有効で、数分で過学習・未学習・収束問題を検知でき、下流タスクの最終指標を待つ必要がありません。計算効率も高く、単一のフォワードパスのみで済むため、本番環境での常時モニタリングにも実用的です。

各AIプラットフォームはパープレキシティ・スコアの評価を異なる方法・文脈で実施しています。ChatGPTや他のOpenAIモデルは多様なドメインの独自データセットと評価フレームワークでパープレキシティを測定し、詳細なスコアは非公開です。Claude(Anthropic開発)も包括的評価の一部としてパープレキシティを用い、長文脈理解に強みを示していますが、長期依存に弱いという制限も認識されています。Perplexity AI(検索特化AI)はリアルタイム情報検索や引用正確性を重視し、パープレキシティ・スコアで出力の自信度を評価します。Google AI Overviews(旧SGE)は、複数情報源統合時の応答一貫性・整合性をパープレキシティで評価します。AmICitedの監視目的では、各プラットフォームごとにトークナイズの方法、語彙サイズ、文脈ウィンドウ戦略が異なることを理解することが重要で、これらはスコアに直接影響します。例えば、同じブランドについて1つのプラットフォームでパープレキシティ15、別のプラットフォームで22となる場合、品質差ではなく設計や前処理差が原因の場合もあります。このためAmICitedは絶対値だけでなくトレンドや一貫性、プラットフォーム間比較も重視し、どのAIがどのようにエンティティを参照しているかの有意な洞察を提供します。

パープレキシティ・スコア評価の実装には、いくつかの技術的・方法論的配慮が不可欠です。まずトークナイゼーションの一貫性が最重要で、文字単位・単語単位・サブワード単位で大きくスコアが異なり、標準化なしではモデル間比較が困難です。次に文脈ウィンドウ戦略も結果に大きく影響し、最大文脈長の半分でスライドするスライディングウィンドウ法が非重複チャンク法よりも精度の高い推定を実現しますが、計算コストは増加します。データセット選定も極めて重要で、パープレキシティはデータセット依存のため、異なるテストセット間での比較には正規化が必要です。ベストプラクティスとしては、WikiText-2やPenn Treebankなど標準データセットでのベースライン確立、全ての評価で同じ前処理・トークナイゼーション・文脈ウィンドウ戦略の明記、パープレキシティとBLEU、ROUGE、事実正確性、人手評価等の補完指標の併用、そして単発値でなくトレンド監視が挙げられます。実運用での自動アラート設定により、パープレキシティの悪化をデータ品質・モデル劣化・インフラ問題の早期発見につなげられます。

その普及と理論的優雅さにもかかわらず、パープレキシティ・スコアは単独では十分な評価指標とは言えません。最も重要なのは、パープレキシティ・スコアが意味理解や事実の正確性を測定しないことです。モデルはありふれた語やフレーズを自信満々に生成して低スコアを達成できても、内容的には全く無意味・誤った文を出すことがあります。2024年の研究では、パープレキシティと長期的理解は相関しないことが示されており、直近トークンの予測しか評価できず、長文での論理一貫性や意味的整合性は捉えられません。トークナイゼーションの違いも大きな課題で、文字単位モデルは単語単位モデルよりもスコアが低くなる場合がある一方で、テキスト品質は劣ることも少なくありません。BPEやWordPiece、SentencePieceなどサブワード法の違いも、スコアの単純比較を難しくしています。また、頻出語・句読点・繰り返しテキストに高確率を割り当てることでスコアが人為的に低下しやすく、実際のテキスト品質や有用性向上とは限りません。データセット特性への高い感度もあり、異なるテストセット間でのスコア比較はできず、ドメイン固有テキストは一般テキストよりスコアが高くなります。さらに、固定長文脈モデルでは文脈ウィンドウの制限により、理想的な自己回帰分解を正しく反映できず、特に長文での評価精度が損なわれる場合があります。

パープレキシティ・スコアのAI評価における今後は、他指標との統合による活用が主流となります。モデルが巨大化・高度化するにつれ、パープレキシティ・スコアは意味的理解指標・事実正確性・人手評価等と組み合わせて初めて有意義な評価となる、という認識が研究者の間で定着しつつあります。新たな研究では、長期依存・一貫性をより的確に捉える文脈対応型パープレキシティ変種も模索されています。テキスト・画像・音声・動画のマルチモーダルAIの隆盛により、一般化パープレキシティフレームワークの開発も進んでいます。AmICitedのようなAI監視プラットフォームはパープレキシティと他指標を組み合わせ、AIがブランドやドメインをどれだけ自信を持って参照しているか、その一貫性や“幻覚”・引用の揺れまで追跡できるようになっています。業界ではパープレキシティベースのモニタリング導入が加速し、主要AIラボや企業がモデルガバナンスの一環として常時監視を実装しています。今後は、リアルタイムパープレキシティダッシュボードによるモデル劣化アラート、クロスプラットフォーム正規化による公正比較、解釈可能なパープレキシティ解析による不確実性の原因トークンや文脈の特定なども進むでしょう。AIが企業や社会の重要基盤となる中、パープレキシティ・スコアを他指標と併用した理解と監視は、信頼できるAI運用のために今後も不可欠です。

パープレキシティ・スコアは、PPL(X) = exp{-1/t ∑ log p_θ(x_i|x_

パープレキシティ・スコアは予測の正しさではなく、モデルの自信や不確実性を測定します。モデルが低いパープレキシティでも誤った予測をしたり、高いパープレキシティでも正確な予測をしたりすることがあります。精度指標は予測が正しいかどうかを評価しますが、パープレキシティはモデルがどれだけ自信を持って予測しているかを定量化します。したがって、両者は包括的なモデル評価のための補完的なアプローチです。

パープレキシティ・スコアは、ChatGPT、Claude、Perplexityなどの言語モデルが特定ブランドやドメインに関する回答をどれだけ自信を持って生成しているかをAI監視プラットフォームが追跡するのに役立ちます。テキスト予測性を測定することで、AmICitedはAIシステムが一貫性のある自信に満ちた引用を生成しているのか、不確実で変動的な参照がされているのかを把握し、AI応答の信頼性をよりよく理解できます。

パープレキシティ・スコアは意味理解、事実の正確性、長期的な一貫性を測定しません。句読点や繰り返しテキストにより偏りやすく、トークナイゼーションの方法や語彙サイズにも影響を受けます。研究ではパープレキシティは長期的理解と相関しないことが示されており、BLEUやROUGE、人手評価などの補完的な指標無しでは単独で十分な評価指標とは言えません。

異なる言語モデルはアーキテクチャ、学習データ、トークナイゼーションの違いにより様々なパープレキシティ・スコアを示します。GPT-2はWikiText-2で約19.44のパープレキシティを達成し、GPT-3やClaudeなどの大規模モデルは通常さらに低い値です。ただし、語彙サイズや文脈長、前処理の違いによりスコアの直接比較はできず、公正な比較には標準化された評価データセットが必要です。

パープレキシティ・スコアは情報理論のエントロピーおよびクロスエントロピーの概念から数学的に導かれています。エントロピーは単一分布の不確実性を測り、クロスエントロピーは真の分布とモデル予測分布の差を測ります。パープレキシティはクロスエントロピーに指数関数を適用し、対数空間から確率空間へ戻すことで、モデルが考慮する“有効な単語選択肢数”として解釈できるようにします。

パープレキシティ・スコアは大規模な学習データセット、長い文脈ウィンドウ、優れたトークナイゼーション戦略、洗練されたモデルアーキテクチャによって改善されます。ドメイン特化データでのファインチューニング、パラメータの増加、評価時のスライディングウィンドウ戦略の活用などもスコア低減に有効です。ただし、モデルが自信を持つだけでなく、正確かつ一貫性のあるテキストを生成できているか他の指標と合わせて評価する必要があります。

ChatGPT、Perplexity、その他のプラットフォームでAIチャットボットがブランドを言及する方法を追跡します。AI存在感を向上させるための実用的なインサイトを取得します。

パープレキシティスコアとは何か、コンテンツや言語モデルにおいてどのような意味があるのかを学びましょう。モデルの不確実性、予測精度、テキスト品質評価の指標としての役割を理解します。...

コンテンツや言語モデルにおけるパープレキシティスコアについてのコミュニティディスカッション。ライターやAI専門家が、コンテンツ制作や最適化において重要かどうかを議論します。...

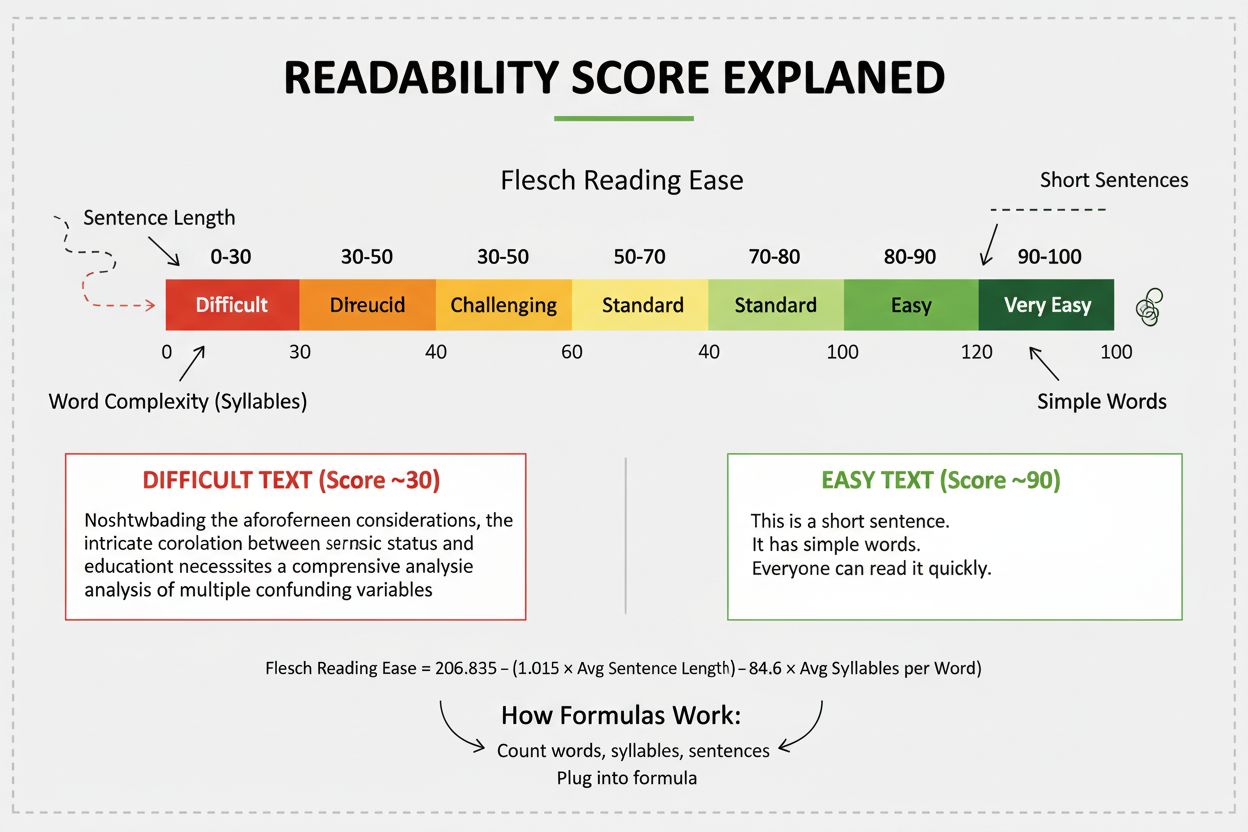

可読性スコアは、言語的分析を用いてコンテンツ理解の難易度を測定します。フレッシュ、ガニング・フォグなどの数式がSEO、ユーザーエンゲージメント、AIコンテンツ監視にどう影響するかを学びましょう。...

クッキーの同意

閲覧体験を向上させ、トラフィックを分析するためにクッキーを使用します。 See our privacy policy.