YouTube SEO(YouTube検索エンジン最適化)

YouTube SEOは、動画やチャンネルを最適化してYouTube検索結果でより高く表示させるプロセスです。ランキング要因や最適化戦略、動画の可視性を高めるベストプラクティスを学びましょう。...

テクニカルSEOは、検索エンジンがウェブサイトを正確かつ効率的にクロール、レンダリング、インデックス、そしてコンテンツを提供できるよう、ウェブサイトのインフラを最適化するプロセスです。これにはウェブサイトの速度、モバイル対応、サイト構造、セキュリティ、構造化データの実装などが含まれ、検索エンジンがページを発見し、ランキングできるようにします。

テクニカルSEOは、検索エンジンがウェブサイトを正確かつ効率的にクロール、レンダリング、インデックス、そしてコンテンツを提供できるよう、ウェブサイトのインフラを最適化するプロセスです。これにはウェブサイトの速度、モバイル対応、サイト構造、セキュリティ、構造化データの実装などが含まれ、検索エンジンがページを発見し、ランキングできるようにします。

テクニカルSEOとは、検索エンジンがウェブサイトのコンテンツを効率的にクロール、レンダリング、インデックスし、正しく提供できるようにするため、ウェブサイトのバックエンドインフラを最適化するプロセスです。オンページSEOがコンテンツの質やキーワード最適化に焦点を当てるのに対し、テクニカルSEOは検索エンジンがウェブサイトにアクセスし理解できるかどうかを決定する基盤要素を扱います。これにはウェブサイトの速度、モバイル対応、サイトアーキテクチャ、セキュリティプロトコル、構造化データ実装、クロール可能性などが含まれます。テクニカルSEOは、他のすべてのSEO施策を支える不可視の基盤であり、これがなければどんな高品質なコンテンツも検索エンジンやユーザーに認識されません。業界調査によると、2024年には91%のマーケターがSEOによってウェブサイトのパフォーマンスが向上したと報告しており、その実現にはテクニカル最適化が重要な役割を果たしました。検索エンジンの高度化やAI主導の検索プラットフォームの登場により、可視性のための技術要件はますます厳しくなっており、テクニカルSEOの重要性は一層高まっています。

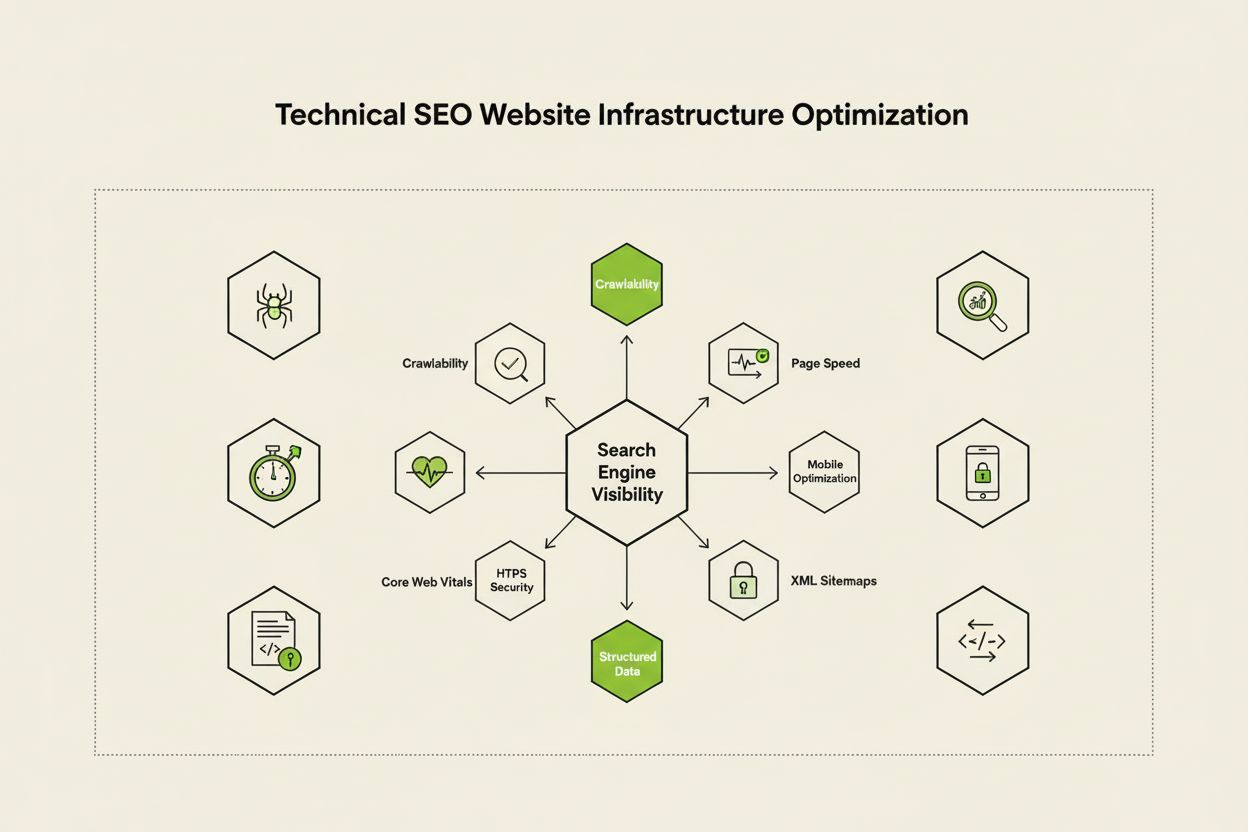

テクニカルSEOは、検索エンジンの可視性を最大化する4つの相互に関連した柱によって成り立っています。クロール可能性は、Googlebotなどの検索エンジンクローラーがリンクやサイトマップ、内部ナビゲーション構造を通じてウェブサイトのページにアクセスできるかどうかを決定します。インデックス可能性は、クロールされたページが実際にGoogleのインデックスに保存され、検索結果に表示される資格があるかどうかを保証します。パフォーマンスおよびCore Web Vitalsは、ページの読み込み速度やユーザー操作への応答性を測定し、ランキングやユーザー体験に直接影響します。モバイル最適化は、スマートフォンやタブレットなどモバイル端末でウェブサイトが問題なく機能することを保証し、Sistrixの調査によると、今や全検索トラフィックの60%以上がモバイル経由です。これら4つの柱は相互依存しており、いずれか1つでも弱点があれば他の効果を損ないます。例えば、デスクトップ版の読み込みが速くてもモバイルでのパフォーマンスが低ければ、クロール可能性がどれほど最適化されていてもGoogleのモバイルファーストインデックスでのランキングは難しくなります。これらの柱がどのように相互作用するかを理解することは、検索エンジン可視性のあらゆる側面に対応する包括的なテクニカルSEO戦略の立案に不可欠です。

しばしば混同されがちですが、クロール可能性とインデックス可能性は、検索エンジン処理の2つの異なる段階を表します。クロール可能性は、検索エンジンが内部リンク、外部バックリンク、XMLサイトマップを辿ってウェブサイトのページを発見・アクセスできる能力を指します。つまり「Googlebotはこのページに到達できるか?」という問いに答えるものです。robots.txtでブロックされていたり、JavaScriptで隠されていたり、内部リンクがなく孤立している場合、そのページはクロールされずインデックス段階に進めません。インデックス可能性は、クロールされたページが実際にGoogleのインデックスに保存され、検索結果に表示される資格があるかどうかを決定します。ページがクロール可能でも、noindexメタタグがあったり、重複コンテンツであったり、Googleの品質基準を満たしていない場合はインデックスされません。Search Engine Landの技術SEOガイドによると、この違いを理解することは重要で、クロール可能性の問題を解決する方法とインデックス可能性の問題を解決する方法は異なります。クロール可能性の課題は主にサイト構造やrobots.txt、内部リンクに関わり、インデックス可能性の課題はメタタグ、カノニカルタグ、コンテンツ品質、レンダリング問題に関連します。どちらも最適な検索可視性のためには両方への対応が不可欠です。

Core Web Vitalsは、Googleが実際のユーザー体験を測定し、検索順位に直接影響を与える3つの指標です。**Largest Contentful Paint(LCP)**はページ上で最も大きな可視要素が表示されるまでの時間を測り、Googleは2.5秒以内を推奨しています。**Interaction to Next Paint(INP)**は(2024年にFirst Input Delayの代替として導入)クリックやタップなどのユーザー操作への応答性を測定し、200ミリ秒未満が目標です。**Cumulative Layout Shift(CLS)**は読み込み中の予期しないレイアウト変化を追跡し、0.1未満が良好とされます。DebugBearの調査では、全3指標で75%以上のユーザーが「良好」な体験をする必要があり、最大のランキング効果が得られるとされています。INPがランキング要因となったことは、Googleがページの初回ロードだけでなく、ユーザーの一連の操作全体における応答性を評価する姿勢を反映しています。Core Web Vitalsの最適化には多面的なアプローチが必要です:LCP改善には画像最適化、CDN活用、不要なJavaScriptの遅延読み込み、INP改善には長いJavaScriptタスクの分割やイベントハンドラの最適化、CLS削減には動的コンテンツ用のスペース確保やレイアウト変動を起こす広告回避などが挙げられます。これらの指標は競争力のあるSEOでは必須となっており、パフォーマンスが低いページはランキングペナルティや高い直帰率に直結します。

サイトアーキテクチャとは、ウェブサイトのページがどのように構造化され、内部リンクで接続されているかを指します。適切なサイトアーキテクチャは、検索エンジンがコンテンツ階層を理解し、リンクエクイティ(ランキングパワー)を全体に分配し、重要ページを容易に発見できるようにし、ユーザーナビゲーションも向上させます。理想的なアーキテクチャは、トップにホームページ、2階層目にカテゴリページ、それ以下に個別コンテンツページという明確な階層構造を持ちます。ベストプラクティスとして、重要なページはホームページから3クリック以内で到達できるようにすることが推奨され、Googlebotが深く孤立したページでクロールバジェットを浪費しないようにします。内部リンクはサイトアーキテクチャの要であり、ユーザーと検索エンジンの両方をコンテンツ内で誘導します。戦略的な内部リンクは、優先ページにランキングシグナルを集中させ、関連コンテンツ間のトピック関係を形成し、検索エンジンに重要ページを伝えます。例えば、包括的なピラーページから複数の関連サブトピックページへリンクし、サブトピックからもピラーページへ戻す「ハブ&スポーク」モデルは、検索エンジンにトピックオーソリティを強く示します。不適切なアーキテクチャ(孤立ページ、ナビゲーションの不整合、過度な階層化)は、クロールバジェットの浪費やトピックオーソリティの構築困難を招きます。アーキテクチャの再構築でインデックス速度やランキングが劇的に改善する例も多いです。

モバイルファーストインデックスとは、Googleがクロール・インデックス・ランキングの際に主にモバイル版ウェブサイトを使用することを意味します。これは検索の60%以上がモバイル端末から行われている現実を反映しています。テクニカルSEOにおいては、モバイルでの体験が完璧である必要があります。つまり、すべての画面サイズに適応するレスポンシブデザイン、十分な余白のあるタッチ操作しやすいナビゲーション、ズーム不要な読みやすいフォントサイズ、モバイルネットワークでも速い読み込み速度が求められます。レスポンシブデザインは流動レイアウトや柔軟な画像を用いて、端末ごとに自動調整し一貫した機能性を実現します。よくあるモバイル最適化の失敗例は、メインコンテンツを妨げるポップアップ、文字が小さくて読みにくい、ボタンが近すぎてタップしにくい、モバイルネットワークでの読み込み遅延などです。GoogleのモバイルフレンドリーテストやLighthouse監査で問題を特定できますが、実機によるテストも不可欠です。モバイル最適化とランキングは直結しており、体験が悪いページはランキングペナルティを受け、最適化されたページは可視性が向上します。ECサイトやSaaS、コンテンツサイトにとって、モバイル最適化は必須です。

XMLサイトマップは、検索エンジンにインデックスしてほしいURLを一覧し、最終更新日や優先度などのメタデータも提供するウェブサイトの地図です。サイトマップには正規・インデックス可能なURLのみ含め、リダイレクトや404、重複コンテンツは除外しましょう。robots.txtはウェブサイトのルートディレクトリに置かれるテキストファイルで、検索エンジンボットへのクロール指示を与え、特定のディレクトリやファイルへのアクセス可否を指定します。robots.txtでクロールをブロックしても、他の方法で発見された場合はインデックスされる可能性があるため、完全な除外にはnoindexメタタグが必要です。クロールバジェットは、Googlebotが一定期間にウェブサイトをクロールするページ数の上限であり、戦略的な管理が求められます。数百万ページを持つ大規模サイトでは、Googlebotが価値の高いコンテンツに集中できるよう、低優先ページや重複コンテンツ、ファセットナビゲーションのバリエーションでクロールバジェットを浪費しないよう最適化しましょう。よくあるクロールバジェットの浪費例は、検索パラメータによる無限のURL生成、ステージング環境の公開、薄いコンテンツページへの過剰な内部リンクなどです。Google公式ガイドによれば、クロールバジェット管理は大規模サイトで特に重要で、非効率なクロールは新規・更新コンテンツの発見とインデックスを遅らせます。Google Search Consoleのクロール統計やサーバーログ分析で、Googlebotの巡回ページや頻度を把握し、データ主導で最適化しましょう。

構造化データは、スキーママークアップを通じて、検索エンジンにコンテンツの意味や文脈を伝える役割を果たします。スキーママークアップはschema.orgの標準語彙を用い、製品、記事、レシピ、イベント、店舗など様々なコンテンツタイプに適用できます。正しくスキーマを実装すると、リッチリザルトとして検索結果に星評価や価格、調理時間、イベント日付などが表示され、クリック率やユーザーエンゲージメントが大幅に向上します。コンテンツタイプごとに適切なスキーマを選択します:Articleスキーマはブログやニュース、ProductスキーマはECページ、FAQスキーマはよくある質問、Local Businessスキーマは実店舗、Eventスキーマはイベントに利用されます。実装は通常Google推奨のJSON-LD形式を用います。ただし、スキーマは実際のページ内容と正確に一致する必要があり、偽造・誤用すると手動ペナルティを受けます。Search Engine Landの調査によれば、有効かつ関連性の高いスキーマのみがリッチリザルトの対象となります。主要ページに包括的なスキーマを実装した組織は、従来の検索結果だけでなく、AI主導の検索プラットフォームでも可視性が向上する傾向にあり、これらのシステムは正確な引用や内容理解のために構造化データに依存しています。

HTTPS(Hypertext Transfer Protocol Secure)は、ユーザーのブラウザとウェブサーバー間のデータ通信を暗号化し、機密情報を保護し、ユーザーや検索エンジンに信頼性を示します。GoogleはHTTPSをランキング要因と明言しており、HTTPS非対応サイトは直接的なランキング低下や、ユーザーが離脱するブラウザ警告など間接的な不利益も受けます。HTTPS導入には、信頼できる認証局からSSL/TLS証明書を取得し、すべてのページでHTTPSを利用するサーバー設定が必要です。基本的なHTTPS対応に加え、Content-Security-PolicyやStrict-Transport-Security、X-Content-Type-Optionsなどのセキュリティヘッダーも脆弱性対策として有効です。HTTPSページでHTTPリソースを読み込む「混在コンテンツエラー」は、セキュリティを損ない、ブラウザ警告を引き起こします。セキュリティとSEOの関係はランキングだけにとどまらず、信頼性向上、直帰率低下、コンバージョン率向上にも寄与します。決済情報を扱うECサイトや、ユーザーデータを持つSaaS、個人情報を収集するサイトは、セキュリティを絶対視すべきです。Google Search Consoleの「セキュリティの問題」やサードパーティの脆弱性スキャナーで定期的に監査し、ランキングや信頼性に影響する前に問題を修正しましょう。

| 項目 | テクニカルSEO | オンページSEO | オフページSEO |

|---|---|---|---|

| 主な焦点 | サイトインフラ、速度、クロール可能性、インデックス可能性 | コンテンツ品質、キーワード、メタタグ、見出し | バックリンク、ブランド言及、ソーシャルシグナル |

| 検索エンジンへのアクセス | 検索エンジンがページをクロール・インデックスできるようにする | 検索エンジンがページの関連性を理解する手助け | 権威性や信頼シグナルを構築 |

| 主な要素 | サイト速度、モバイル最適化、Core Web Vitals、サイト構造、HTTPS、構造化データ | キーワード配置、コンテンツの深さ、内部リンク、メタディスクリプション | バックリンクプロファイル、ドメインオーソリティ、ブランド言及 |

| 使用ツール | PageSpeed Insights、Google Search Console、Screaming Frog、Lighthouse | Yoast SEO、Surfer SEO、Content Genius | Ahrefs、Semrush、Moz、Majestic |

| ランキングへの影響 | 基礎的—これがなければページは全くランクしない | 直接的—ターゲットキーワードの関連性向上 | 重要—権威性や信頼を高める |

| ユーザー体験への影響 | 高い—ページ速度、モバイル使いやすさ、アクセシビリティに影響 | 中程度—可読性やエンゲージメントに影響 | 低い—ブランド認知など間接的 |

| 実装タイムライン | 継続的—常時モニタリング・最適化 | 継続的—コンテンツ更新・最適化 | 長期的—持続的なリンク構築が必要 |

| ROI測定 | クロール効率、インデックス率、Core Web Vitalsスコア、ランキング | キーワード順位、オーガニックトラフィック、クリック率 | バックリンク増加、ドメインオーソリティ、リファラルトラフィック |

JavaScript SEOは、JavaScript中心のウェブサイトやSPA(シングルページアプリケーション)、動的レンダリングコンテンツの特有課題に対応します。従来、GooglebotはJavaScriptの実行(レンダリング)を必要とするページのクロールが苦手で、このプロセスが複雑化・遅延の原因となっていました。現在のGooglebotは多くのページをインデックス前にレンダリングしますが、これには新たな技術的SEOの配慮が必要です。**サーバーサイドレンダリング(SSR)**は、HTMLをサーバー上で生成してからブラウザに送るため、検索エンジンが即座にすべてのコンテンツを認識できます。**静的サイト生成(SSG)**はビルド時に静的HTMLを作成し、高速な表示を実現します。動的レンダリングは、検索エンジンにはプレレンダリングHTML、ユーザーにはJavaScriptを配信しますが、Googleはこれは一時的な解決策であるとしています。重要な原則は、全ての主要コンテンツ・メタタグ・構造化データを初期HTMLで可視化することです。JavaScript経由でコンテンツを隠すと、インデックス不完全や遅延のリスクがあります。React、Vue、Angularなどのフレームワークは特に注意が必要で、Next.jsやNuxt.jsなどSSR対応フレームワークがSEO強化のためによく利用されます。Google Search ConsoleのURL検査ツールやレンダリングスナップショット機能で、JavaScript依存コンテンツが正しくインデックスされているかを確認できます。

テクニカルSEOを効果的に実装するには、インパクトが大きい順に体系的にアプローチすることが重要です。まず基礎要素の確認:robots.txtや内部リンクでクロール可能かを確認し、重要ページがnoindexタグやカノニカルの問題なくインデックス可能かを検証、Core Web Vitalsの基準値を把握します。次にパフォーマンス最適化:画像圧縮・最適化、ファーストビュー以外の遅延読み込み、不要なJavaScriptの遅延実行、CDN活用による高速配信を行います。サイト構造の最適化:重要ページをホームから3クリック以内に配置、スキーマ付きパンくずリストを実装、明確な内部リンクパターンでユーザー・検索エンジンを誘導します。主要コンテンツタイプに構造化データを実装:製品、記事、店舗情報、イベントなどのJSON-LD形式スキーマをGoogleのリッチリザルトテストで検証します。継続的なモニタリング:Google Search Consoleでインデックス問題、PageSpeed InsightsでCore Web Vitals、サーバーログでクローリングパターンを監視します。KPIの可視化と責任分担:インデックスページ数、Core Web Vitalsスコア、クロール効率などの指標を継続的に追跡します。テクニカルSEOを一度きりの監査で終わらせず継続的に取り組む組織は、検索可視性やユーザー体験で競合を上回る傾向があります。

Google AI Overviews、Perplexity、ChatGPT、ClaudeなどAI主導の検索プラットフォームが台頭する中、テクニカルSEOの重要性は従来のGoogle検索を超えて拡大しています。これらのAIシステムは、検索エンジンインデックス上の正しく構造化・インデックスされたコンテンツを引用・回答生成に活用します。テクニカルSEOは、コンテンツをAIシステムに発見・正確に解釈させることを保証します。具体的には、インデックス化によりAIの学習・検索対象となり、構造化データが文脈や意味理解を助け、セマンティックな豊かさがAIによる権威性・関連性の認識を促進します。ConductorやBotifyの調査によると、AI Overviewsに登場するページは、技術的に堅固でセマンティック信号が強いサイトが多いことが分かっています。この関係は双方向であり、従来SEOがキーワード順位重視なのに対し、AI検索は複数ソースを引用した包括的な回答を重視します。つまり、テクニカルSEOは両方に対応できることが求められます。AmICitedのようなツールで複数AIプラットフォームでの可視性をモニタリングすることで、どの技術的最適化が引用・可視性向上に最も効果的かを特定できます。

効果的なテクニカルSEOには、ウェブサイトの健全性や検索エンジンでのアクセス性を示す具体的な指標の追跡が不可欠です。インデックスページ数は、意図したページのうち実際にGoogleインデックスに保存されている数を示し、総インデックス可能ページ数と比較してインデックス効率比を算出できます。クロール効率は、Googlebotがクロールバジェットをどれだけ有効活用しているかを測り、クロールページ数÷全ページ数で算出します。Core Web Vitalsスコアは、LCP(読み込み速度)、INP(操作性)、CLS(視覚安定性)によるユーザー体験品質を示します。モバイルユーザビリティ問題は、Google Search Consoleでタップターゲットの小ささやビューポート設定エラー、ポップアップの過剰表示などが検出できます。リダイレクトチェーンの長さは、リンクエクイティの保持やクロール遅延を防ぐため最小化すべきです。構造化データカバレッジは、有効なスキーマを実装しているページの割合を示します。ページ速度指標(FCP、TTI、TBT)は詳細なパフォーマンス分析に役立ちます。これらの指標は初期値を計測し、改善目標を設定して月次や四半期ごとに進捗を追跡しましょう。指標の急変は、ランキング影響前に技術的問題を示すことが多く、迅速な対応を可能にします。Google Search Console、PageSpeed Insights、Lighthouse、Semrush等で全体的なダッシュボード管理が可能です。

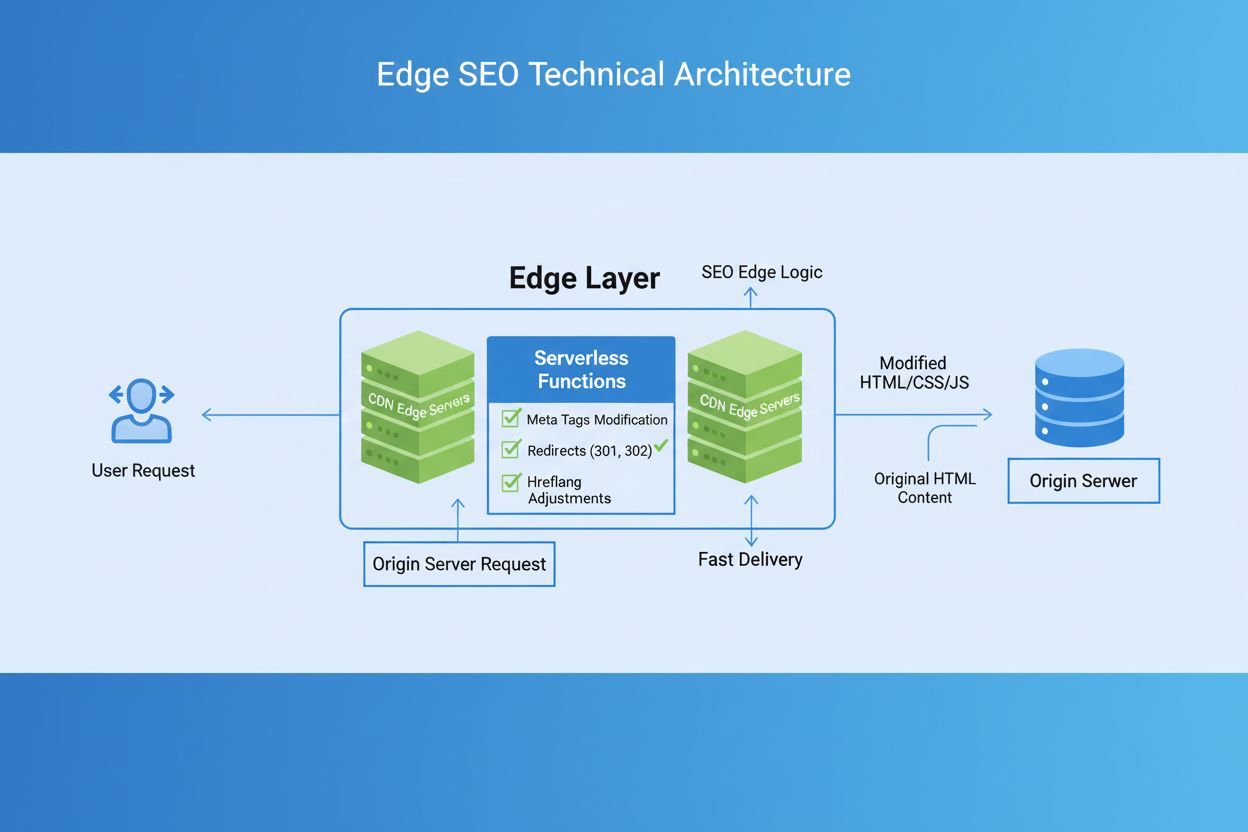

テクニカルSEOの環境は、検索エンジンアルゴリズムの進化、新技術、ユーザー行動の変化に応じて常に変化しています。AI主導のインデックス・ランキングが今後さらに強まり、セマンティック理解やエンティティ認識の支援が技術的SEOに求められます。エッジコンピューティングやサーバーレスアーキテクチャは、ネットワークエッジで高速なコンテンツ配信・リアルタイム最適化を実現し、Core Web Vitals向上に寄与します。E-E-A-T(経験・専門性・権威性・信頼性)シグナル重視の流れでは、適切

テクニカルSEOは、サイト速度、クロール可能性、インデックス可能性、サーバー構成など、ウェブサイトのバックエンドインフラの最適化に重点を置き、検索エンジンがコンテンツを発見・処理しやすくします。一方、オンページSEOは、キーワード配置、メタタグ、見出し、コンテンツの質など、個々のページ要素の最適化に注力し、特定の検索クエリに対する関連性を高めます。テクニカルSEOは検索エンジンがサイトにアクセスできるようにし、オンページSEOはコンテンツの内容とその重要性を検索エンジンに理解させます。

Core Web Vitals(LCP、INP、CLS)は、実際のユーザー体験を測定するランキング要因です。DebugBearの調査によると、全3指標すべてで75%以上のユーザーが「良好」な体験をする必要があり、最大のランキング効果が得られます。Core Web Vitalsが低いと、ランキング低下、クリック率減少、直帰率上昇を招き、オーガニックでの可視性やユーザーエンゲージメントに直接影響します。

クロール可能性は、検索エンジンのボットがウェブサイト全体のリンクを辿ってアクセスできるかどうかを決定します。Googlebotがリソースのブロック、サイト構造の不備、robots.txtの制限などでページをクロールできない場合、それらのページはインデックスもランキングもされません。クロール可能性が不十分だと、質の高いコンテンツも検索エンジンに認識されず、オーガニックでの可視性を獲得できません。

Google AI OverviewsやPerplexityなどAI主導の検索プラットフォームが普及する中、テクニカルSEOは基盤となり続けます。これらのAIシステムはGoogleインデックスの適切に構造化・インデックスされたコンテンツから回答を生成します。テクニカルSEOは、コンテンツが発見され、正しくレンダリングされ、AIシステムに引用・参照されるためのセマンティックな豊かさを保証します。基礎が弱いと、AI Overviewsや生成型検索結果にコンテンツが表示されません。

多くのウェブサイトでは、包括的なテクニカルSEO監査を四半期ごとに実施し、重大な問題については月次でモニタリングすることが推奨されます。頻繁に更新される大規模サイトは月次監査や継続的な監視体制を導入すべきです。大規模なサイト変更・移転・リニューアル後は直ちに監査を行いましょう。定期的な監査で問題の早期発見が可能になり、最適なクロール・インデックス・パフォーマンスを維持できます。

サイトアーキテクチャは、検索エンジンがウェブサイトのコンテンツ階層をどのように把握し、巡回するかを左右します。最適化されたアーキテクチャは、重要なページがホームページから3クリック以内で到達でき、リンクエクイティが効果的に分配され、価値の高いコンテンツが優先的にクロールされるようにします。不適切なアーキテクチャは、孤立したページやクロールバジェットの浪費、トピックオーソリティ構築の困難を招き、ランキングや可視性に悪影響を及ぼします。

ページ速度は検索順位とユーザー行動の両方に直接影響します。GoogleはCore Web Vitals(読み込み速度、操作性、視覚的安定性)がランキング要因であると明言しています。表示が遅いページは直帰率が高く、エンゲージメントやコンバージョンが低下します。2.5秒以内で表示されるページは、遅いページに比べユーザー維持やランキングで大きな優位性があるため、速度最適化はSEO成功の鍵です。

ChatGPT、Perplexity、その他のプラットフォームでAIチャットボットがブランドを言及する方法を追跡します。AI存在感を向上させるための実用的なインサイトを取得します。

YouTube SEOは、動画やチャンネルを最適化してYouTube検索結果でより高く表示させるプロセスです。ランキング要因や最適化戦略、動画の可視性を高めるベストプラクティスを学びましょう。...

エッジSEOは、CDN上のサーバーレス関数を用いてネットワークエッジで技術的SEOの変更を実装する手法です。パフォーマンスの向上、迅速な最適化、プラットフォーム制限の克服について学び、現代のウェブサイトでの利点を理解しましょう。...

JavaScript SEOは、JavaScriptレンダリングされたウェブサイトを検索エンジンのクロールとインデックスに最適化します。ベストプラクティス、レンダリング手法、GoogleやAI検索プラットフォームでの可視性向上の戦略を学べます。...

クッキーの同意

閲覧体験を向上させ、トラフィックを分析するためにクッキーを使用します。 See our privacy policy.