Hoe volg je AI-vermeldingen van concurrenten op ChatGPT, Perplexity & AI Search

Leer hoe je vermeldingen van concurrenten in AI-zoekmachines volgt. Monitor ChatGPT, Perplexity, Claude en Google AI-zichtbaarheid met share of voice-metrics.

Leer hoe AI-systemen concurrentievergelijkingen rangschikken en waarom jouw merk mogelijk ontbreekt bij ‘vs’-vragen. Ontdek strategieën om AI-vergelijkingszichtbaarheid te domineren.

AI-systemen verwerken nu ongeveer 80% van de consumentenzoekopdrachten naar productaanbevelingen, wat de manier waarop aankoopbeslissingen worden genomen fundamenteel verandert. Wanneer gebruikers “X vs Y”-vragen stellen aan ChatGPT, Gemini of Perplexity, maken ze gebruik van momenten met hoge intentie die direct het koopgedrag beïnvloeden—maar deze interacties werken anders dan traditionele zoekopdrachten in zoekmachines. In tegenstelling tot Google, waar keyword-dichtheid en backlinkautoriteit de boventoon voeren, synthetiseren AI-systemen informatie uit meerdere bronnen en creëren verhalende vergelijkingen die jouw merk kunnen verheffen of juist naar de achtergrond drukken. Voor SaaS- en B2B-bedrijven betekent dit zowel een kritieke zichtbaarheidsuitdaging als een ongekende kans: de aanwezigheid van je merk in deze AI-gegenereerde vergelijkingen bepaalt direct of potentiële klanten je überhaupt als optie overwegen. De inzet is hoger dan ooit, omdat AI-vergelijkingsresultaten als gezaghebbend en volledig worden ervaren, waardoor ze het nieuwe strijdtoneel voor marktaandeel vormen.

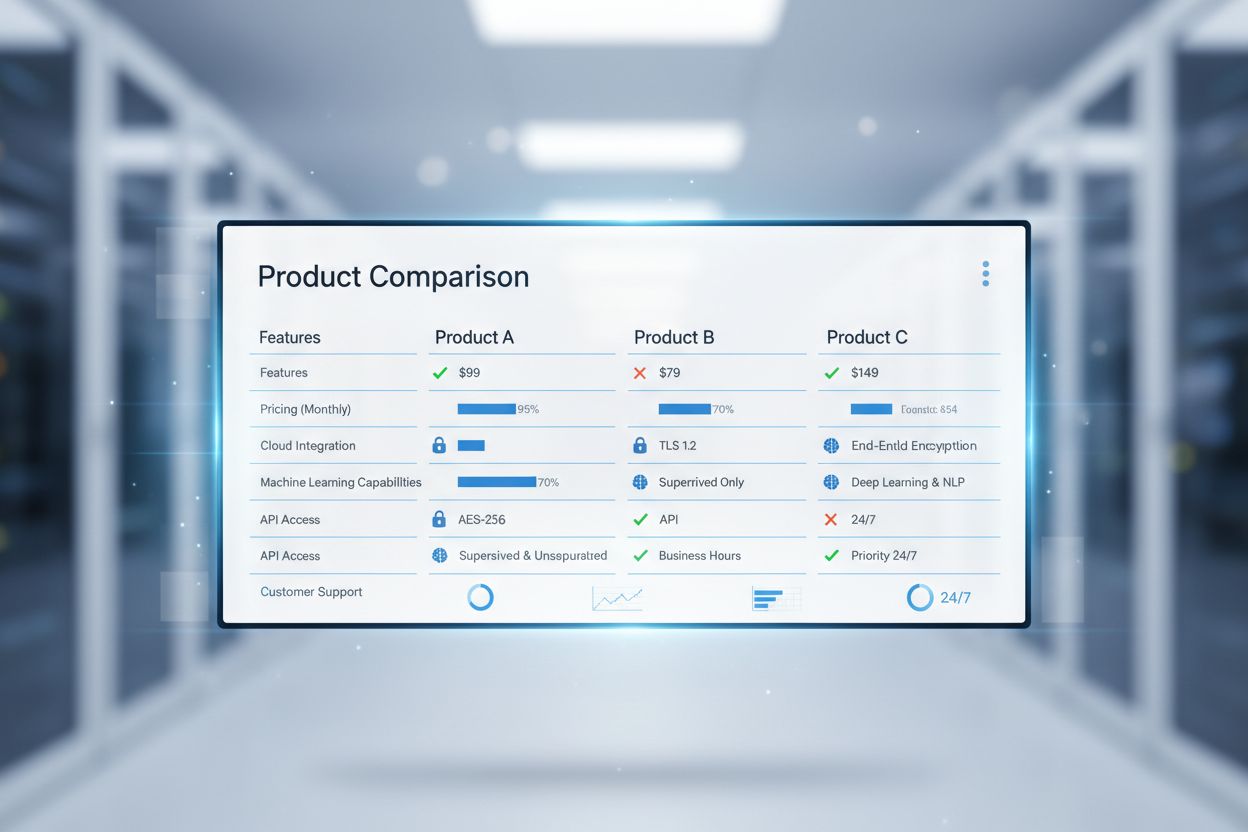

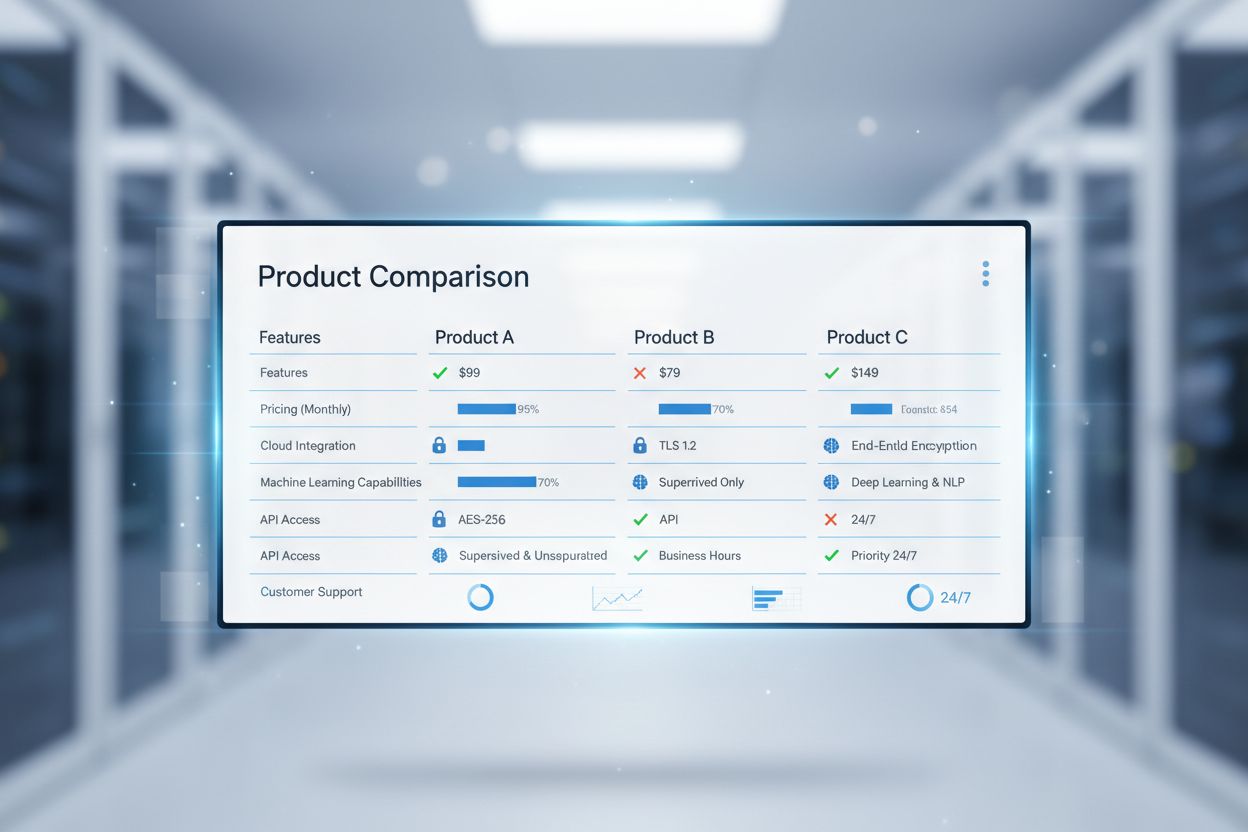

Wanneer je een LLM vraagt om twee producten te vergelijken, haalt het systeem niet simpelweg bestaande vergelijkingspagina’s op en rangschikt ze—het analyseert de semantische intentie van je vraag, identificeert relevante entiteiten en legt relaties tussen deze entiteiten om een nieuw antwoord te creëren. LLM’s geven een sterke voorkeur aan gestructureerde data en duidelijke positioneringsstatements boven verhalende inhoud, wat betekent dat een goed opgestelde vergelijkingstabel met expliciete feature-vermeldingen zwaarder wordt gewogen dan een blogpost van 2.000 woorden die is ondergedompeld in proza. Het systeem voert entiteitherkenning en relatie-mapping uit om niet alleen te begrijpen welke producten er zijn, maar ook hoe ze zich tot elkaar verhouden op dimensies als prijs, gebruiksscenario’s en doelgroepen. Citatiepatronen zijn van groot belang: LLM’s volgen van welke bronnen ze informatie halen en wegen bronnen met meer geloofwaardigheid en consistentie zwaarder. Dit is fundamenteel anders dan hoe mensen vergelijkingspagina’s lezen—waar een persoon je hele pagina kan scannen, haalt een AI-systeem specifieke beweringen eruit, valideert deze met andere bronnen en signaleert inconsistenties. Duidelijke positionering en onderscheid zijn veel belangrijker dan keyword-dichtheid, omdat de AI zoekt naar semantische helderheid en verifieerbare beweringen, niet naar keyword-overeenkomsten.

Achter elke AI-vergelijking zit een rangschikkingsalgoritme dat bepaalt welk product als ‘beter’ wordt gepositioneerd voor specifieke gebruiksscenario’s—en inzicht in deze systemen is essentieel voor strategische positionering. Onderzoekers hebben vier hoofdbenaderingen geïdentificeerd die LLM’s en vergelijkingsplatforms gebruiken: het Elo-rating-systeem (afkomstig uit de schaakwereld), het Bradley-Terry-model (ontworpen voor gecontroleerde datasets), het Glicko-systeem (een evolutie van Elo voor grote, onevenwichtige datasets) en Markov Chain-methoden (voor gebalanceerde, probabilistische vergelijkingen). Elk systeem heeft zijn eigen sterke en zwakke punten op drie belangrijke dimensies: transitiviteit (of A>B en B>C betrouwbaar betekent dat A>C), voorspellende nauwkeurigheid en gevoeligheid voor hyperparameters.

| Algoritme | Beste voor | Transitiviteit | Voorspellende nauwkeurigheid | Hyperparametersensitiviteit |

|---|---|---|---|---|

| Elo | Grote onevenwichtige datasets | Matig | Hoog | Zeer hoog |

| Bradley-Terry | Kleine gecontroleerde datasets | Uitstekend | Hoog | Geen |

| Glicko | Grote onevenwichtige datasets | Goed | Hoog | Matig |

| Markov Chain | Gebalanceerde datasets | Goed | Matig | Hoog |

Het Elo-systeem blinkt uit in het verwerken van enorme, onevenwichtige datasets (zoals miljoenen gebruikersvergelijkingen), maar is extreem gevoelig voor hyperparametertuning en kan niet-transitieve resultaten opleveren. Bradley-Terry biedt perfecte transitiviteit en geen hyperparametercomplexiteit, waardoor het ideaal is voor gecontroleerde productvergelijkingen met een vaste set concurrenten en consistente evaluatiecriteria. Glicko combineert de voordelen van beide methoden, met goede transitiviteit en nauwkeurigheid, terwijl het slechts matig gevoelig is voor afstelling. Markov Chain-methoden werken het beste als je gebalanceerde, rechtstreekse vergelijkingsdata hebt en matige voorspellende nauwkeurigheid accepteert in ruil voor probabilistische inzichten. Begrijpen welk algoritme een AI-systeem gebruikt—of waarop je concurrenten optimaliseren—onthult strategische positioneringskansen.

De meeste SaaS-bedrijven worden geconfronteerd met een harde realiteit: je merk wordt veel minder vaak genoemd in AI-vergelijkingen dan in traditionele zoekresultaten, en als je wel verschijnt, is het vaak als tweede keus. Deze zichtbaarheidskloof ontstaat door verschillende onderling verbonden factoren. Citatiepatronen en bronautoriteit zijn van enorm belang—als je merk vooral op je eigen website en een paar reviewwebsites verschijnt, terwijl concurrenten op vakpublicaties, analistenrapporten en externe vergelijkingen staan, zal het AI-systeem concurrentievermeldingen zwaarder laten wegen. Entity-clarity en consistente naamgeving over al je digitale kanalen (website, documentatie, sociale profielen, reviewwebsites) bepalen direct of de AI je herkent als een aparte entiteit die het waard is om te vergelijken. Veel bedrijven laten na om gestructureerde datamarkering toe te passen die expliciet hun features, prijzen en positionering aan AI-systemen communiceert, waardoor de LLM deze informatie uit ongestructureerde tekst moet afleiden. De cijfers zijn schokkend: onderzoek toont aan dat AI-gegenereerde zoekresultaten 91% minder klikken genereren dan traditionele Google-zoekresultaten voor dezelfde vragen, wat betekent dat zichtbaarheid in AI-vergelijkingen nog belangrijker is dan traditionele SEO. Je concurrenten bouwen waarschijnlijk al aan een sterkere AI-aanwezigheid via strategische contentplaatsing, gestructureerde data en bewuste positionering in externe vergelijkingscontexten—en elke dag dat je wacht, wordt de kloof groter.

Om te winnen bij AI-vergelijkingsvragen moeten je vergelijkingspagina’s specifiek zijn opgebouwd voor hoe LLM’s informatie verwerken en synthetiseren. De essentiële optimalisatiepraktijken:

Zichtbaarheid zonder meting is slechts hoop, daarom is systematische monitoring van je AI-vergelijkingsaanwezigheid onmisbaar. Begin met het vaststellen van een nulmeting op de grote AI-platforms—ChatGPT, Google Gemini, Perplexity en Claude—door een standaard prompt-playbook te draaien met categorie-shortlists (“top 5 projectmanagement tools”), rechtstreekse vergelijkingen (“Asana vs Monday.com”), constraint-based vragen (“beste CRM voor non-profits”) en migratiescenario’s (“overstappen van Salesforce naar…”). Houd voor elk resultaat vier metrics bij: aanwezigheid (word je genoemd?), positionering (eerste, midden of laatste?), nauwkeurigheid (kloppen de uitspraken over je product?), en gebruik van bewijs (welke bronnen citeert de AI bij het beschrijven van jou?). Stel een basisscores vast per vraag en platform, en volg je vooruitgang per kwartaal om te zien of je zichtbaarheid verbetert, stagneert of juist daalt ten opzichte van concurrenten. Tools zoals Ahrefs Brand Radar, Semrush Brand Monitoring en opkomende AI-specifieke platforms als AmICited.com bieden automatische tracking over meerdere AI-systemen, waardoor handmatig testen overbodig wordt. Het doel is niet perfectie—het is systematische zichtbaarheid en het vermogen om gaten te signaleren voordat ze concurrentienadelen worden.

AI Share of Voice geeft het percentage van je merk aan in het totaal aantal vermeldingen en positieve positionering in AI-vergelijkingsresultaten binnen je categorie—en het wordt de belangrijkste metric voor concurrentievoordeel. In tegenstelling tot traditionele Share of Voice, die keyword-vermeldingen in zoekresultaten meet, vangt AI Share of Voice hoe vaak je merk verschijnt in AI-gegenereerde vergelijkingen en hoe gunstig je wordt gepositioneerd ten opzichte van concurrenten. Het identificeren van zichtbaarheidsgaten vereist concurrentieanalyse op drie dimensies: topic gaps (welke vergelijkingsvragen noemen concurrenten maar jou niet?), format gaps (verschijnen concurrenten in tabellen, casestudy’s of expert-roundups waar jij ontbreekt?), en freshness gaps (zijn concurrentievermeldingen recent terwijl die van jou verouderd zijn?). Citatieanalyse onthult welke bronnen de AI het meest vertrouwt—als je concurrenten consequent worden geciteerd uit vakpublicaties en jij alleen van je eigen site, heb je een kritisch autoriteitsgat geïdentificeerd. Duurzame AI-zichtbaarheid vraagt om meer dan quick wins zoals het optimaliseren van losse vergelijkingspagina’s; ontwikkel een contentstrategie die je aanwezigheid systematisch uitbouwt bij externe bronnen, analistenrapporten en vakpublicaties waar AI-systemen informatie ontdekken en citeren. De bedrijven die deze strijd winnen, zijn niet degenen met het beste product—maar met de meest strategische, zichtbare aanwezigheid bij bronnen die AI-systemen vertrouwen.

De positionering van je concurrenten in AI-vergelijkingen onthult strategische inzichten die traditionele concurrentieanalyse vaak mist. Door systematisch te volgen hoe AI-systemen de sterke en zwakke punten en positionering van je concurrenten beschrijven, kun je marktgaten en kansen identificeren die concurrenten zelf mogelijk nog niet benutten. Reverse-engineer concurrentiestrategieën door te analyseren in welke bronnen ze het vaakst verschijnen, welke claims ze benadrukken en welke gebruiksscenario’s ze prioriteren—dit onthult hun contentstrategie en focus qua marktpositionering. Gebruik tools als Ahrefs Brand Radar om te volgen op welke domeinen je concurrenten het vaakst worden genoemd, en analyseer of diezelfde domeinen jou noemen; dit gat betekent onbenutte zichtbaarheid. Vergelijkingsdata onthult ook positioneringskansen: als concurrenten consequent claimen “beste voor enterprise” te zijn, maar jij klantreviews en use cases hebt die aantonen dat jij even sterk bent in dat segment, heb je een messaging gap om te benutten. Het meest geavanceerde concurrentie-inzicht komt door patronen te analyseren over meerdere AI-systemen—als een concurrent domineert in ChatGPT-vergelijkingen maar nauwelijks voorkomt in Perplexity-resultaten, zegt dat iets over hun contentdistributiestrategie en bronautoriteit. Door AI-vergelijkingsdata als strategische inlichtingenbron te behandelen in plaats van alleen als zichtbaarheidscijfer, maak je van reactief monitoren een proactief concurrentievoordeel.

AI-systemen werken hun vergelijkingsranglijsten continu bij naarmate nieuwe informatie wordt geïndexeerd en gebruikersinteracties worden verwerkt. De frequentie verschilt echter per platform—ChatGPT werkt zijn trainingsdata periodiek bij, terwijl Perplexity en andere realtime systemen de resultaten bij elke vraag vernieuwen. Voor jouw merk betekent dit dat veranderingen in je zichtbaarheid binnen enkele dagen kunnen plaatsvinden na het publiceren van nieuwe vergelijkingsinhoud of het verkrijgen van citaties van gezaghebbende bronnen.

Traditionele zoekrangschikkingen geven prioriteit aan keyword-dichtheid, backlinks en domeinautoriteit. AI-vergelijkingszichtbaarheid daarentegen legt de nadruk op de duidelijkheid van gestructureerde data, entiteitherkenning, citatie-credibiliteit en consistente positionering over meerdere bronnen. Een pagina kan op #1 staan in Google maar nauwelijks verschijnen in AI-vergelijkingen als het geen duidelijke structuur en verifieerbare claims heeft.

Ja, absoluut. Door gestructureerde datamarkering (Schema.org) toe te passen, consistente naamgeving over al je kanalen te behouden, heldere positioneringsstatements te publiceren en citaties te verkrijgen van gezaghebbende externe bronnen, beïnvloed je direct hoe AI-systemen je product begrijpen en beschrijven. De sleutel is om je informatie machineleesbaar en geloofwaardig te maken.

Voer een gestandaardiseerd prompt-playbook uit op grote AI-platforms (ChatGPT, Gemini, Perplexity, Claude) met vergelijkingsvragen die relevant zijn voor jouw categorie. Houd bij of je wordt genoemd, hoe je wordt gepositioneerd en welke bronnen de AI citeert. Tools zoals AmICited.com automatiseren deze monitoring en bieden kwartaalrapportages en concurrentiebenchmarks.

De snelste winst behaal je door: (1) gestructureerde datamarkering toe te passen op bestaande vergelijkingspagina's, (2) consistente naamgeving en positionering op alle digitale kanalen te waarborgen, (3) citaties te verkrijgen uit vakpublicaties en analistenrapporten, en (4) vergelijkingsinhoud te creëren die specifiek is geoptimaliseerd voor AI-leesbaarheid. De meeste bedrijven zien meetbare verbeteringen binnen 4-6 weken.

Gestructureerde data (JSON-LD schema markup) maakt je informatie machineleesbaar, waardoor de AI geen feiten hoeft af te leiden uit ongestructureerde tekst. Dit verbetert de nauwkeurigheid en frequentie van citaties aanzienlijk. Producten met correcte schema-markering verschijnen 2-3x vaker in AI-vergelijkingen dan producten zonder, en worden nauwkeuriger beschreven.

Hoewel de kernprincipes van optimalisatie hetzelfde blijven, heeft elk platform zijn eigen kenmerken. ChatGPT waardeert uitgebreide, goed onderbouwde inhoud. Perplexity geeft prioriteit aan realtime, geciteerde informatie. Google Gemini legt de nadruk op gestructureerde data en entiteithelderheid. In plaats van platformspecifieke optimalisatie, focus op universele best practices: heldere structuur, geloofwaardige citaties en consistente positionering.

De vier belangrijkste metrics zijn: (1) Aanwezigheid—word je genoemd in relevante vergelijkingsvragen? (2) Positionering—verschijn je als eerste, midden of laatste? (3) Nauwkeurigheid—kloppen de uitspraken over je product? (4) Gebruik van bewijs—welke bronnen citeert de AI bij het beschrijven van jou? Houd deze metrics per kwartaal bij om trends en concurrentieverschillen te identificeren.

Volg hoe AI-systemen je merk noemen in concurrentievergelijkingen over ChatGPT, Gemini, Perplexity en meer. Krijg realtime inzichten in je AI-zoekzichtbaarheid.

Leer hoe je vermeldingen van concurrenten in AI-zoekmachines volgt. Monitor ChatGPT, Perplexity, Claude en Google AI-zichtbaarheid met share of voice-metrics.

Leer hoe je AI-merkmonitoring opzet om je merk te volgen in ChatGPT, Perplexity en Google AI Overviews. Complete gids met tools, strategieën en best practices v...

Leer hoe je productpagina's optimaliseert voor AI-zoekmachines zoals ChatGPT en Perplexity. Ontdek implementatie van gestructureerde data, contentstrategieën en...