AI-verkeersconversieratio’s: Waarom kwaliteit belangrijker is dan kwantiteit

Ontdek waarom AI-verkeer 23x beter converteert dan organisch zoeken. Leer hoe je optimaliseert voor AI-platforms en de echte ROI van AI-gedreven bezoekers meet.

Ontdek waarom datakwaliteit belangrijker is dan kwantiteit voor AI-modellen. Leer strategieën voor resourceallocatie, kostenimplicaties en praktische raamwerken om je investering in AI-trainingsdata te optimaliseren.

De gangbare wijsheid in machine learning was lange tijd “meer data is altijd beter”. Recent onderzoek daagt deze aanname echter uit met overtuigend bewijs dat datakwaliteit veel zwaarder weegt dan kwantiteit bij het bepalen van de prestaties van AI-modellen. Een arxiv-studie uit 2024 (2411.15821) naar kleine taalmodellen wees uit dat de kwaliteit van trainingsdata een veel grotere rol speelt dan de pure omvang, en toonde aan dat de relatie tussen datakwantiteit en modelnauwkeurigheid veel genuanceerder is dan eerder werd gedacht. De kostenimplicaties zijn aanzienlijk: organisaties die zwaar investeren in dataverzameling zonder kwaliteit voorop te stellen, verspillen vaak middelen aan opslag, verwerking en rekenkracht, terwijl ze afnemende meeropbrengsten op modelprestaties realiseren.

Datakwaliteit is geen monolithisch concept maar een multidimensionaal raamwerk dat verschillende kritische aspecten omvat. Nauwkeurigheid verwijst naar hoe correct data de werkelijkheid weergeeft en of labels juist zijn toegekend. Consistentie zorgt ervoor dat data overal in de dataset uniforme formaten en standaarden volgt. Volledigheid meet of alle benodigde informatie aanwezig is, zonder grote hiaten of ontbrekende waarden. Relevantie bepaalt of data direct betrekking heeft op het probleem dat het AI-model moet oplossen. Betrouwbaarheid geeft de betrouwbaarheid van de databron en de stabiliteit ervan in de tijd aan. Tot slot staat ruis voor ongewenste variaties of fouten die het model tijdens de training kunnen misleiden. Inzicht in deze dimensies helpt organisaties hun inspanningen voor datacuratie strategisch te prioriteren.

| Kwaliteitsdimensie | Definitie | Impact op AI |

|---|---|---|

| Nauwkeurigheid | Correctheid van labels en datavoorstelling | Beïnvloedt direct de betrouwbaarheid van modelvoorspellingen; verkeerd gelabelde data veroorzaakt systematische fouten |

| Consistentie | Uniforme opmaak en gestandaardiseerde datastructuur | Maakt stabiele training mogelijk; inconsistenties verwarren leeralgoritmen |

| Volledigheid | Aanwezigheid van alle noodzakelijke informatie zonder hiaten | Ontbrekende waarden verminderen effectieve trainingsdata; beïnvloedt generalisatie |

| Relevantie | Data sluit direct aan bij het probleemgebied | Sterk relevante data presteert beter dan grote hoeveelheden generieke data |

| Betrouwbaarheid | Betrouwbaarheid van databronnen en stabiliteit | Onbetrouwbare bronnen zorgen voor systematische bias; beïnvloedt modelrobuustheid |

| Ruis | Ongewenste variaties en meetfouten | Gecontroleerde ruis verbetert robuustheid; overmatige ruis verlaagt prestaties |

Het najagen van datakwantiteit zonder kwaliteitswaarborgen creëert een keten van problemen die veel verder reiken dan alleen modelprestatiestatistieken. Onderzoek van Rishabh Iyer toont aan dat labelruisexperimenten dramatische nauwkeurigheidsdalingen laten zien—verkeerd gelabelde data verslechtert de modelprestaties actief, in plaats van slechts neutrale trainingsvoorbeelden te leveren. Naast nauwkeurigheidszorgen krijgen organisaties te maken met oplopende opslag- en verwerkingskosten voor datasets die de modeluitkomsten niet verbeteren, en met aanzienlijke milieukosten door onnodige rekencapaciteit. Medische beeldvorming biedt een confronterend praktijkvoorbeeld: een dataset met duizenden verkeerd gelabelde röntgenfoto’s kan een model trainen dat vol vertrouwen gevaarlijke diagnostische fouten maakt, met mogelijk schade voor patiënten. De schijnbare besparing van het verzamelen van goedkope, slechte data wordt duidelijk als je de kosten van modelhertraining, debuggen en uitrolfouten door slechte trainingsdata meerekent.

Domeinspecifieke kwaliteit presteert consequent beter dan generieke omvang in praktische AI-toepassingen. Neem een sentiment-classifier getraind op filmrecensies: een zorgvuldig samengestelde dataset van 10.000 filmrecensies presteert aanzienlijk beter dan een generieke sentimentdataset van 100.000 voorbeelden uit financieel nieuws, sociale media en productrecensies. De relevantie van de trainingsdata voor het specifieke probleemgebied is veel belangrijker dan pure omvang, omdat modellen patronen leren die specifiek zijn voor hun trainingsverdeling. Wanneer data niet relevant is voor de beoogde toepassing, leert het model schijnverbanden en faalt het om te generaliseren naar echte gebruikssituaties. Organisaties zouden kleinere datasets moeten verzamelen die precies aansluiten op hun probleemgebied, in plaats van enorme generieke datasets die veel filteren en voorbewerken vereisen.

De optimale datastrategie ligt niet in uitersten, maar in het vinden van de “Goudlokje-zone"—het punt waarop datakwantiteit en -kwaliteit in het juiste evenwicht zijn gebracht voor het specifieke probleem. Te weinig data, zelfs als die perfect gelabeld is, zorgt voor underfitting en onvermogen om de complexiteit van echte patronen te vangen. Omgekeerd leidt te veel data met kwaliteitsproblemen tot verspilling van rekenkracht en instabiele training. De arxiv-studie maakt dit concreet: minimale duplicatie verbeterde de nauwkeurigheid met 0,87% bij 25% duplicatieniveau, terwijl overmatige duplicatie bij 100% leidde tot een catastrofale daling van 40% in nauwkeurigheid. Het ideale evenwicht hangt af van meerdere factoren, waaronder het type algoritme, probleemcomplexiteit, beschikbare rekenmiddelen en de natuurlijke variatie in je doelgroep. De dataverdeling moet de werkelijke variatie in de praktijk weerspiegelen, in plaats van kunstmatig uniform te zijn, zodat modellen leren omgaan met de variatie die ze in productie zullen tegenkomen.

Niet alle extra data is gelijk—het onderscheid tussen nuttige augmentatie en schadelijke degradatie is cruciaal voor een effectieve datastrategie. Gecontroleerde verstoringen en augmentatietechnieken verbeteren de robuustheid van modellen door algoritmen te leren omgaan met variaties zoals kleine rotaties, veranderingen in belichting of minimale labelvariaties. De MNIST-handgeschreven cijfers dataset illustreert dit principe: modellen getraind met geaugmenteerde versies (gedraaide, geschaalde of licht vervormde cijfers) generaliseren beter naar echte handschriften dan modellen die alleen met de originele afbeeldingen zijn getraind. Ernstige corruptie—willekeurige ruis, systematisch verkeerde labeltoekenning of het toevoegen van irrelevante data—verslechtert echter actief de prestaties en verspilt rekenkracht. Het cruciale verschil zit in de intentie: augmentatie is doelbewust ontworpen om realistische variaties te weerspiegelen, terwijl waardeloze data willekeurige ruis is die leeralgoritmen in de war brengt. Organisaties moeten deze benaderingen onderscheiden wanneer ze hun datasets uitbreiden.

Voor organisaties met beperkte middelen biedt actief leren een krachtige oplossing die de databehoefte vermindert terwijl de modelprestaties behouden of verbeterd blijven. In plaats van passief alle beschikbare data te verzamelen en te labelen, identificeren algoritmen voor actief leren welke niet-gelabelde voorbeelden het meest informatief zijn voor het model. Hierdoor neemt de menselijke annotatielast drastisch af. Deze aanpak stelt organisaties in staat sterke modelprestaties te bereiken met aanzienlijk minder gelabelde data door menselijke inspanning te richten op de meest impactvolle voorbeelden. Actief leren democratiseert AI-ontwikkeling door het toegankelijk te maken voor teams zonder enorme labelbudgetten, zodat ze effectieve modellen kunnen bouwen door strategische dataselectie in plaats van brute omvang. Door efficiënt te leren met minder data kunnen organisaties sneller itereren, kosten verlagen en middelen inzetten voor kwaliteitsbewaking in plaats van eindeloze dataverzameling.

Strategische resourceallocatie vereist dat in datastrategiebeslissingen kwaliteit fundamenteel voorrang krijgt boven kwantiteit. Organisaties dienen te investeren in robuuste datavalidatiepipelines die fouten onderscheppen voordat ze in trainingsdatasets terechtkomen, door geautomatiseerde controles op consistentie, volledigheid en nauwkeurigheid toe te passen. Dataprofileringstools kunnen kwaliteitsproblemen op grote schaal signaleren, zoals patronen van verkeerde labeling, ontbrekende waarden of irrelevante voorbeelden die vóór de training moeten worden aangepakt. Implementaties van actief leren verminderen de hoeveelheid data die menselijke beoordeling vereist, terwijl ze ervoor zorgen dat de beoordeelde voorbeelden zo informatief mogelijk zijn. Continue monitoring van modelprestaties in productie laat zien of kwaliteitsproblemen met trainingsdata zich uiten als echte fouten, waardoor snelle feedbackloops voor verbetering mogelijk zijn. De optimale strategie balanceert dataverzameling met rigoureuze curatie, in de wetenschap dat 1.000 perfect gelabelde voorbeelden vaak beter presteren dan 100.000 ruisachtige, zowel qua modelprestaties als totale eigendomskosten.

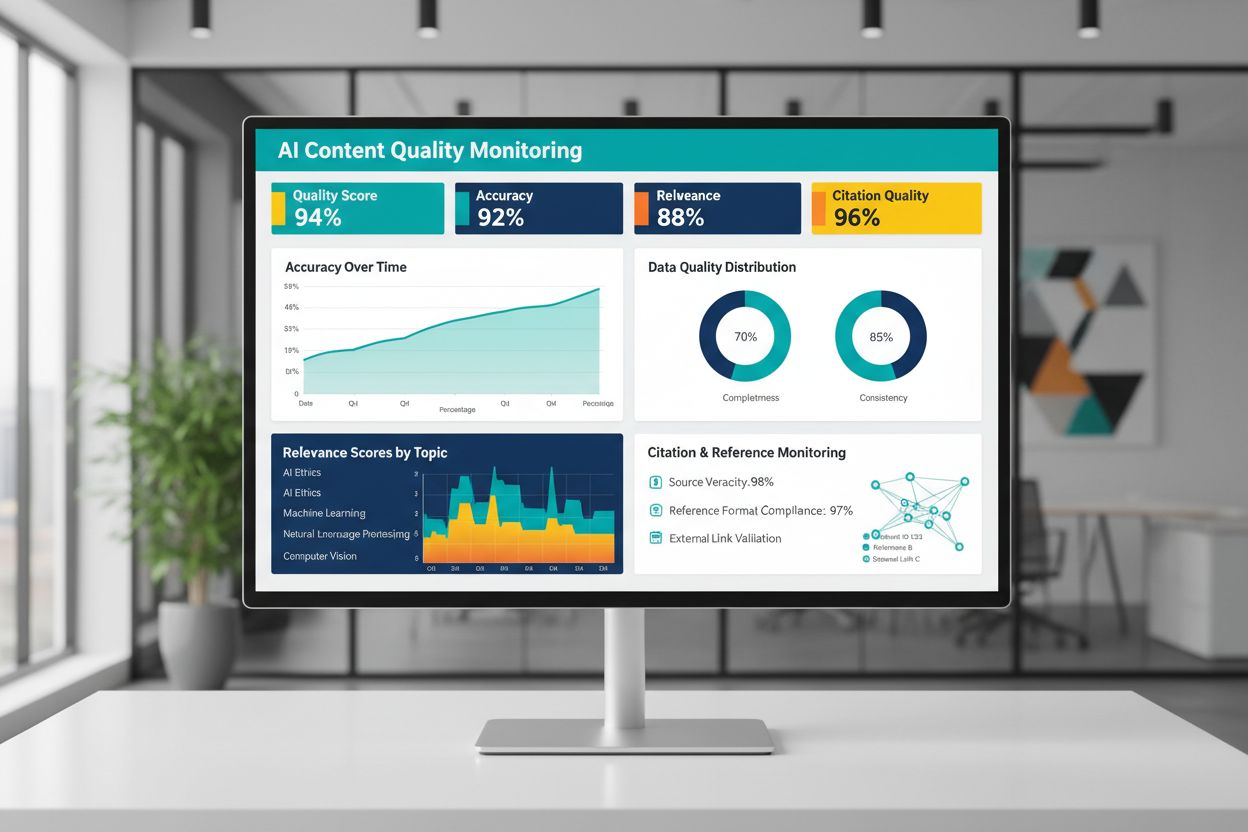

De kwaliteit van AI-gegenereerde of AI-getrainde content hangt fundamenteel af van de kwaliteit van de trainingsdata, waardoor continue bewaking van AI-uitvoer essentieel is om betrouwbaarheid te waarborgen. Platforms zoals AmICited.com voorzien in deze kritieke behoefte door AI-antwoorden te monitoren en de nauwkeurigheid van citaties te volgen—een directe graadmeter voor contentkwaliteit en betrouwbaarheid. Wanneer AI-systemen getraind worden op data van lage kwaliteit met slechte citaties of onjuiste informatie, nemen hun uitkomsten deze gebreken over, wat kan leiden tot grootschalige verspreiding van desinformatie. Monitoringshulpmiddelen moeten niet alleen nauwkeurigheidsstatistieken bijhouden, maar ook relevantie, consistentie en het bestaan van onderbouwing voor beweringen van AI-systemen. Organisaties die AI inzetten, moeten feedbackloops implementeren die signaleren wanneer uitkomsten afwijken van verwachte kwaliteitsnormen, zodat snel kan worden hergetraind of onderliggende data kan worden aangepast. Investeren in monitoringinfrastructuur betaalt zich terug door kwaliteitsdegradatie vroegtijdig te signaleren, voordat het gebruikers raakt of de reputatie schaadt.

Het vertalen van datakwaliteitsprincipes naar de praktijk vereist een gestructureerde aanpak die begint met beoordeling en zich uitstrekt tot meting en iteratie. Begin met het beoordelen van uw huidige uitgangssituatie—krijg inzicht in de bestaande kwaliteit van uw trainingsdata door audits en profilering. Definieer duidelijke kwaliteitsmaatstaven die aansluiten bij uw specifieke toepassing, zoals nauwkeurigheidsdrempels, consistentienormen of relevantiecriteria. Implementeer datagovernancepraktijken die eigenaarschap, validatieprocedures en kwaliteitscontroles vastleggen voordat data in trainingspijplijnen terechtkomt. Start met kleinere, zorgvuldig samengestelde datasets in plaats van direct enorme volumes te verwerken, zodat u kwaliteitsnormen en processen op beheersbare schaal kunt opbouwen. Meet verbeteringen grondig door modelprestaties vóór en na kwaliteitsinterventies te vergelijken, zodat u evidence-based investeringen kunt onderbouwen. Schaal geleidelijk op naarmate u processen verfijnt, en breid dataverzameling pas uit nadat is aangetoond dat kwaliteitsverbeteringen daadwerkelijk leiden tot betere prestaties.

Nee. Recent onderzoek toont aan dat datakwaliteit vaak belangrijker is dan kwantiteit. Data van slechte kwaliteit, verkeerd gelabeld of irrelevant, kan de prestaties van het model zelfs op schaal actief verslechteren. De sleutel is het juiste evenwicht vinden tussen voldoende data om effectief te trainen en het behouden van hoge kwaliteitsnormen.

Datakwaliteit omvat meerdere dimensies: nauwkeurigheid (juiste labels), consistentie (eenduidige opmaak), volledigheid (geen ontbrekende waarden), relevantie (afstemming op uw probleem), betrouwbaarheid (betrouwbare bronnen) en ruisniveaus. Definieer maatstaven die specifiek zijn voor uw use case en implementeer validatiecontroles om kwaliteitsproblemen vóór de training te onderscheppen.

De ideale grootte hangt af van de complexiteit van uw algoritme, het type probleem en beschikbare middelen. Streef niet naar maximale omvang, maar naar de 'Goudlokje-zone'—genoeg data om patronen uit de werkelijkheid vast te leggen zonder overspoeld te raken door irrelevante of overbodige voorbeelden. Begin klein met samengestelde data en schaal geleidelijk op op basis van prestatieverbeteringen.

Data-augmentatie past gecontroleerde verstoringen toe (rotaties, lichte vervormingen, variaties in belichting) die het ware label behouden, terwijl modellen leren omgaan met variabiliteit uit de echte wereld. Dit verschilt van waardeloze data—augmentatie is doelbewust en weerspiegelt realistische variaties, waardoor modellen robuuster worden voor inzetomstandigheden.

Actieve learning identificeert welke niet-gelabelde voorbeelden het meest informatief zouden zijn voor het model om van te leren, waardoor de annotatielast sterk vermindert. In plaats van alle beschikbare data te labelen, richt u menselijke inspanning op de meest impactvolle voorbeelden en behaalt u sterke prestaties met aanzienlijk minder gelabelde data.

Geef voorrang aan kwaliteit boven kwantiteit. Investeer in datavalidatiepipelines, profieltools en governance-processen die hoge kwaliteit van trainingsdata waarborgen. Onderzoek toont aan dat 1.000 perfect gelabelde voorbeelden vaak beter presteren dan 100.000 ruisachtige voorbeelden, zowel qua modelprestaties als totale eigendomskosten.

Data van slechte kwaliteit leidt tot meerdere kosten: model hertraining, debuggen, uitrolfouten, opslagoverhead en verspilling van rekenkracht. In kritieke domeinen zoals medische beeldvorming kan slechte trainingsdata tot gevaarlijke fouten leiden. De schijnbare besparing van goedkope, slechte data wordt duidelijk als je deze verborgen kosten meerekent.

Implementeer continue monitoring van AI-uitvoer op nauwkeurigheid, relevantie, consistentie en citatiekwaliteit. Platforms zoals AmICited monitoren hoe AI-systemen informatie vermelden en volgen de nauwkeurigheid van citaties. Stel feedbackloops in die de productieprestaties koppelen aan de kwaliteit van trainingsdata voor snelle verbetering.

Volg hoe AI-systemen uw merk noemen en waarborg de nauwkeurigheid van content met het AI-monitoringsplatform van AmICited. Begrijp de kwaliteit van AI-gegenereerde antwoorden over uw bedrijf.

Ontdek waarom AI-verkeer 23x beter converteert dan organisch zoeken. Leer hoe je optimaliseert voor AI-platforms en de echte ROI van AI-gedreven bezoekers meet.

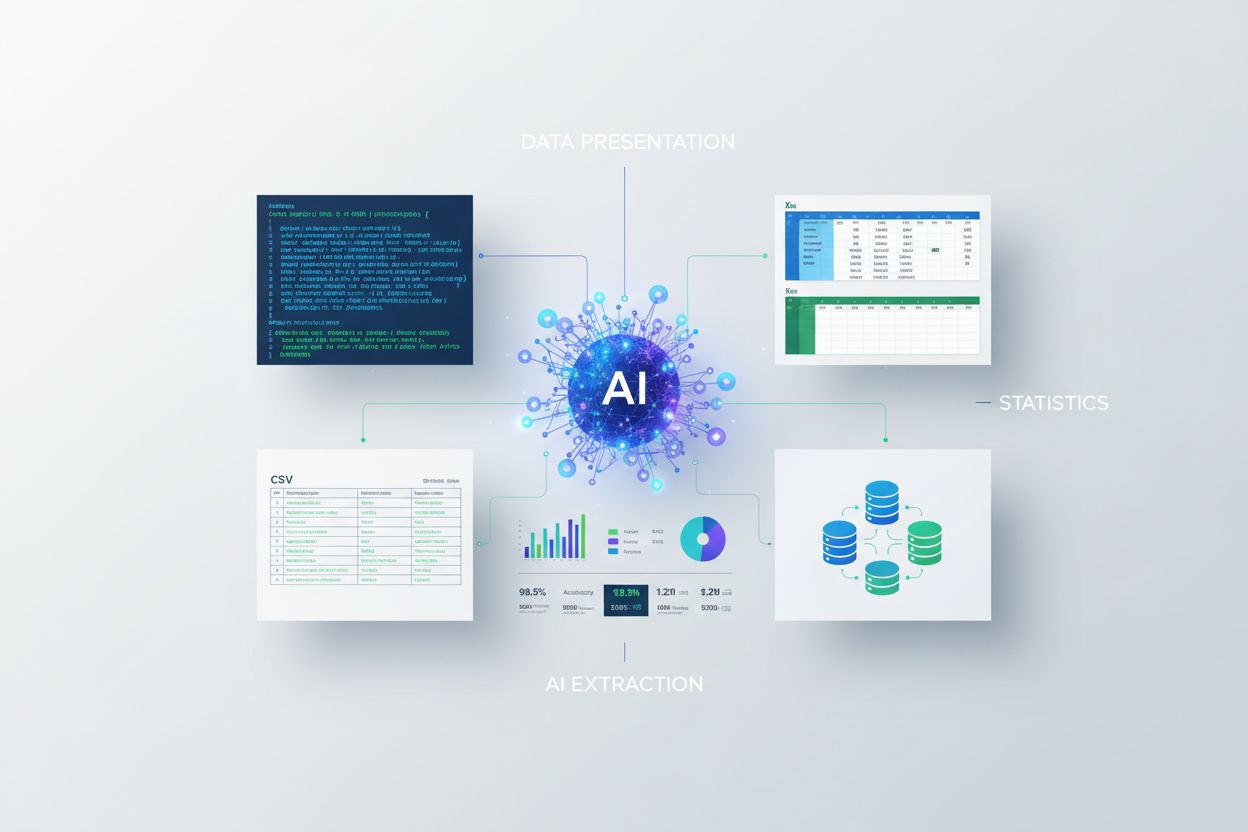

Leer hoe je statistieken presenteert voor AI-extractie. Ontdek best practices voor gegevensformattering, JSON versus CSV, en hoe je je data AI-klaar maakt voor ...

Discussie binnen de community over contentkwaliteitsvereisten voor AI-zoekcitaten. Inzicht in welke kwaliteitsdrempel content moet halen voor ChatGPT, Perplexit...