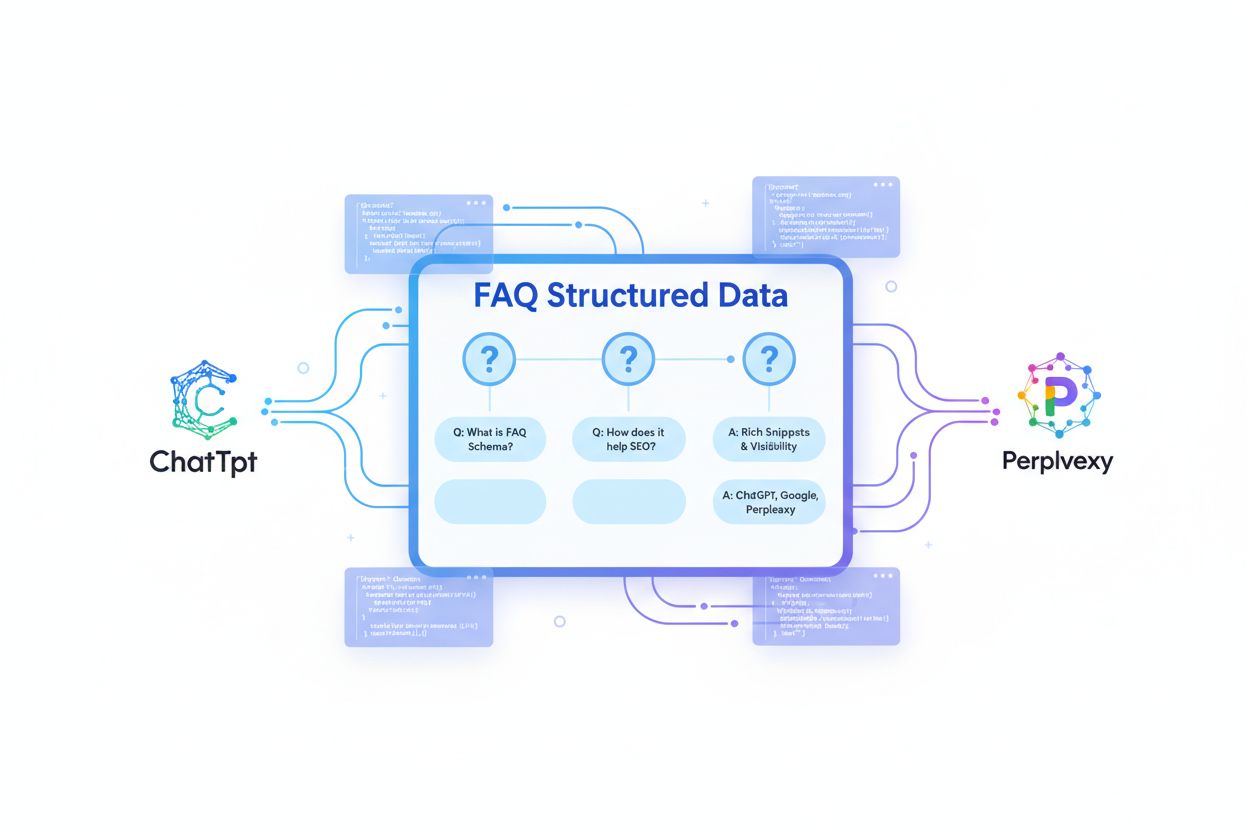

FAQ-secties: Gestructureerde Q&A voor AI-extractie

Ontdek hoe FAQ-secties met de juiste schema markup de zichtbaarheid verbeteren in AI-gegenereerde antwoorden van ChatGPT, Perplexity en Google AI Overzichten. O...

Ontdek waarom FAQ-schema de hoogste citatiepercentages heeft voor AI-zoekopdrachten. Complete gids voor FAQPage gestructureerde data voor ChatGPT, Perplexity en Google AI Overviews.

FAQ-schema is uitgegroeid tot een van de krachtigste gestructureerde dataformaten voor AI-zoekzichtbaarheid, met 28-40% hogere citatiekans ten opzichte van ongestructureerde content. Waar traditionele SEO zich richtte op rich results en featured snippets in de zoekinterface van Google, is het landschap fundamenteel veranderd. AI-platformen zoals ChatGPT, Perplexity en Google AI Overviews halen actief FAQ-gestructureerde data op en geven deze prioriteit bij het genereren van antwoorden, waardoor implementatie van schema cruciaal is voor moderne zichtbaarheid. Het concurrentievoordeel is aanzienlijk: slechts 12,4% van de websites gebruikt momenteel gestructureerde data, waardoor de overgrote meerderheid van de concurrenten onzichtbaar is voor AI-systemen. Deze kloof heeft een meetbaar effect—AI-verwezen sessies stegen 527% tussen januari en mei 2025, wat aangeeft dat bedrijven die AI-zoekoptimalisatie negeren, exponentiële verkeer kansen missen. De overgang van traditionele SEO-metrics (rich result-impressies) naar AI-zoekmetrics (citatie-frequentie) is de belangrijkste verandering in zoekzichtbaarheid sinds mobile-first indexing.

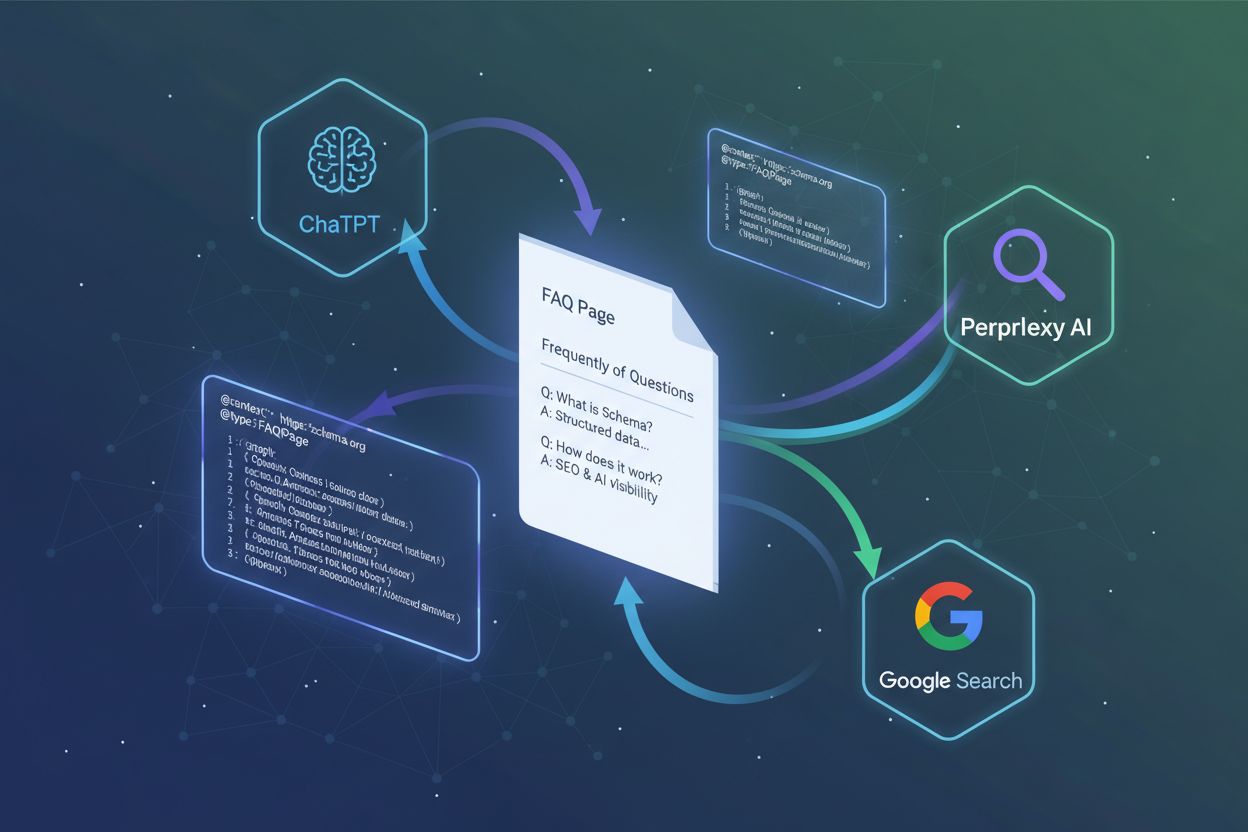

In augustus 2023 voerde Google een belangrijke beperking door op FAQ-rich results, waardoor deze alleen nog werden weergegeven op websites van de overheid en gezondheidszorg. Deze beslissing leek de waarde van FAQ-schema te verminderen—de meeste bedrijven verloren plotseling de zichtbare FAQ-snippets die eerder in zoekresultaten verschenen. Toch ontstond hierdoor wat wij de “FAQ-schema paradox” noemen: terwijl FAQ-rich results minder zichtbaar werden in traditionele Google-zoekopdrachten, namen AI-platformen tegelijkertijd hun afhankelijkheid van FAQ-gestructureerde data toe voor antwoordgeneratie. De kwaliteitszorgen die tot Google’s beslissing leidden (spam, misleidende content en lage kwaliteit antwoorden), maakten FAQ-schema juist waardevoller voor AI-systemen, die gestructureerde data gebruiken om contentkwaliteit en authenticiteit te verifiëren. Deze paradox veranderde fundamenteel hoe we FAQ-schema succes meten. In plaats van “rich result-impressies” te volgen in Google Search Console, is de nieuwe metric “AI-citaties”—hoe vaak jouw FAQ-antwoorden verschijnen in ChatGPT, Perplexity en andere AI-platformen. Inzicht in deze verschuiving is essentieel voor moderne SEO-strategie, omdat de zichtbaarheid die nu het meest telt plaatsvindt in AI-interfaces, niet in traditionele zoekresultaten.

| Metriek | Traditionele SEO (voor 2023) | AI-zoeken (2024-2025) |

|---|---|---|

| Succesmeting | Rich result-impressies | AI-citaties |

| Zichtbaarheidstype | Google SERP-snippets | ChatGPT, Perplexity, Google AI Overviews |

| Citatiekans | 5-15% | 28-40% |

| Platformfocus | Google Zoeken | Meerdere AI-platformen |

| Meetinstrument | Search Console | Handmatige monitoring + AI-trackingtools |

AI-systemen halen niet willekeurig tekst van webpagina’s; ze zoeken actief naar gestructureerde data die de interpretatielast voor natural language processing-algoritmen wegneemt. FAQ-schema biedt precies dat—een machineleesbaar formaat dat vragen duidelijk scheidt van antwoorden, waardoor ambiguïteit bij contentanalyse verdwijnt. Het vraag-antwoordformaat sluit aan bij hoe AI-platformen informatie aan gebruikers presenteren, waardoor een natuurlijke afstemming ontstaat tussen je contentstructuur en de manier waarop AI-systemen deze willen tonen. Onderzoek toont aan dat 78% van AI-gegenereerde antwoorden lijstformaten gebruikt, en FAQ-schema biedt precies deze structuur. Wikipedia, dat goed is voor 47,9% van de ChatGPT-citaties, gebruikt een vergelijkbare Q&A-structuur door de hele content heen, wat aangeeft dat dit formaat effectief is voor AI-systemen. Schema fungeert als een “machineleesbare taal” die AI-platformen vertelt: “Dit is een vraag. Dit is het antwoord. Dit antwoord is volledig en zelfstandig.” Deze duidelijkheid maakt schone extractie mogelijk zonder dat het AI-systeem je content hoeft te interpreteren, samenvatten of herschrijven.

Zo ziet correcte FAQ-schema in JSON-LD eruit:

{

"@context": "https://schema.org",

"@type": "FAQPage",

"mainEntity": [

{

"@type": "Question",

"name": "Wat is FAQ-schema en waarom is het belangrijk voor AI-zoeken?",

"acceptedAnswer": {

"@type": "Answer",

"text": "FAQ-schema is gestructureerde data die AI-platformen helpt vraag-antwoordparen te begrijpen en te extraheren uit je content. Het verhoogt de citatiekans met 28-40% ten opzichte van ongestructureerde content."

}

},

{

"@type": "Question",

"name": "Hoe implementeer ik FAQ-schema op mijn website?",

"acceptedAnswer": {

"@type": "Answer",

"text": "Gebruik JSON-LD-indeling met @context, @type (FAQPage), mainEntity-array en Question/Answer-objecten. Valideer met Google's Rich Results Test voor publicatie."

}

}

]

}

FAQ-schema presteert consequent beter dan andere schema-types wat betreft AI-citatiekans. Pagina’s met FAQPage-markering zijn 3,2 keer vaker zichtbaar in Google AI Overviews dan pagina’s zonder gestructureerde data. Het citatievoordeel is aanzienlijk: FAQ-geoptimaliseerde pagina’s tonen 28% hogere citatiepercentages op grote AI-platformen. Dit prestatievoordeel bestaat omdat FAQ-schema direct inspeelt op de manier waarop AI-systemen informatie willen extraheren en presenteren—het gestructureerde formaat vermindert verwerkingscomplexiteit en verhoogt het vertrouwen in antwoordnauwkeurigheid.

| Schema-type | Citatiekans | AI-platformvoorkeur | Traditionele SERP-zichtbaarheid |

|---|---|---|---|

| FAQPage | 28-40% hoger | Zeer hoog | Laag (na aug. 2023) |

| Artikel | 15-22% hoger | Gemiddeld | Gemiddeld |

| HowTo | 18-25% hoger | Gemiddeld-hoog | Gemiddeld |

| BreadcrumbList | 8-12% hoger | Laag | Laag |

| Organisatie | 5-10% hoger | Laag | Laag |

Featured snippets blijven effectief voor traditionele zoekzichtbaarheid, maar FAQ-schema biedt nu dubbele voordelen: het behoudt enige traditionele zoekwaarde terwijl het de AI-citatiekans drastisch verhoogt. Deze dubbele kanaalbenadering betekent dat bedrijven die FAQ-schema effectief implementeren zichtbaarheid winnen in zowel traditionele zoekresultaten als AI-gegenereerde antwoorden—een aanzienlijk concurrentievoordeel in het veranderende zoeklandschap.

De citatiepatronen van ChatGPT laten een voorkeur zien voor neutrale, encyclopedische content met een gezaghebbende structuur en duidelijke labeling. Bij het optimaliseren van FAQ-schema voor ChatGPT moet elk antwoord zelfstandig en volledig zijn—ChatGPT zal geen informatie uit verschillende bronnen samenvoegen als één antwoord incompleet is. Voeg specifieke statistieken en data toe met bronvermelding; ChatGPT geeft prioriteit aan antwoorden die feitelijke onderbouwing tonen. De citatiedata van het platform toont dat 47,9% van de citaties afkomstig is van Wikipedia, dat uitgebreide, neutraal getoonzette antwoorden biedt met volledige context zonder externe verwijzing te vereisen.

Zwak FAQ-antwoord voor ChatGPT: “Wat is machine learning? Machine learning is een type AI dat leert van data.”

Sterk FAQ-antwoord voor ChatGPT: “Wat is machine learning? Machine learning is een deelgebied van kunstmatige intelligentie waarmee systemen kunnen leren en verbeteren op basis van ervaring zonder expliciete programmering. Ontwikkeld in de jaren 50 identificeren machine learning-algoritmen patronen in data en doen voorspellingen of nemen beslissingen op basis van die patronen. Veelvoorkomende toepassingen zijn aanbevelingssystemen (Netflix gebruikt collaborative filtering), beeldherkenning (gebruikt in medische diagnostiek) en natuurlijke taalverwerking (drijft chatbots aan). In tegenstelling tot traditionele programmering, waar ontwikkelaars expliciete regels schrijven, ontwikkelen machine learning-systemen hun eigen regels door training op datasets.”

Het sterke antwoord biedt context, historische achtergrond, concrete voorbeelden en praktische toepassingen—precies wat de trainingsdata van ChatGPT benadrukt.

Perplexity AI legt de nadruk op door de community gegenereerde content en een conversatietoon, waarbij Reddit goed is voor 6,6% van de citaties—aanzienlijk hoger dan bij andere platformen. Bij het optimaliseren van FAQ-schema voor Perplexity, gebruik je conversatievraagstelling die lijkt op hoe echte mensen vragen stellen op fora en sociale media. Voeg echte voorbeelden en klantverhalen toe die praktische toepassing laten zien; Perplexity waardeert antwoorden die demonstreren hoe concepten in de praktijk werken. Antwoorden moeten concrete vervolgstappen en een persoonlijke, behulpzame toon bevatten in plaats van klinische neutraliteit.

Voor Perplexity geoptimaliseerd FAQ-antwoord: “Hoe weet ik of mijn website FAQ-schema nodig heeft? Als je herhaaldelijk dezelfde vragen krijgt in reacties, e-mails of supporttickets, is dat een teken dat je FAQ-schema ontbreekt. Ik begon FAQ-schema toe te voegen aan mijn blog nadat ik merkte dat steeds dezelfde drie vragen in elke reactie opdoken. Binnen twee weken stopten die vragen—mensen vonden de antwoorden in het FAQ-gedeelte. Als je in een technische sector, e-commerce of SaaS zit, is FAQ-schema vrijwel zeker waardevol. Begin met het verzamelen van de 10-15 meest gestelde vragen en structureer deze met FAQ-schema. Je zult waarschijnlijk binnen 2-4 weken zien dat Perplexity en andere AI-platformen je antwoorden citeren.”

Deze benadering voelt als advies van een deskundige collega in plaats van een encyclopedie, wat aansluit op de citatievoorkeuren van Perplexity.

Google AI Overviews hanteert een domeinonafhankelijke benadering, waarbij antwoorden met de kenmerken van featured snippets prioriteit krijgen—meestal antwoorden van 40-60 woorden die direct de vraag beantwoorden. E-E-A-T-signalen (Experience, Expertise, Authoritativeness, Trustworthiness) wegen zwaar mee bij de vraag of Google AI Overviews je FAQ-antwoorden citeren. Mobile-first-inhoud is essentieel, aangezien Google’s AI-systemen prioriteit geven aan mobiel geoptimaliseerde pagina’s. Overweeg meerdere schema-types te combineren—FAQ-schema werkt het beste in combinatie met Article- en Organization-schema, waardoor een volledige contentcontext ontstaat die AI-systemen kunnen beoordelen.

E-E-A-T-signalen checklist voor FAQ-schema:

Google AI Overviews geven ook de voorkeur aan verse content—het maandelijks updaten van FAQ-antwoorden geeft Google’s systemen een signaal dat je informatie actueel en betrouwbaar blijft. Dit “freshness”-signaal verhoogt de citatiekans, vooral bij onderwerpen die snel veranderen (technologie, gezondheid, financiën).

FAQ-schema correct implementeren vereist aandacht voor specifieke technische vereisten. JSON-LD-formaat heeft de voorkeur boven Microdata of RDFa omdat het makkelijker te valideren is en de HTML-weergave niet beïnvloedt. De vereiste eigenschappen zijn @context (altijd “https://schema.org

”), @type (FAQPage), mainEntity (array van Question-objecten), en elke Question moet @type en name bevatten. Elk Answer vereist @type en text eigenschappen.

Checklist voor FAQ-schema implementatie:

<head> of <body> sectie@context op “https://schema.org

” en @type op “FAQPage”mainEntity array met Question-objecten@type: "Question" en name (de vraag)@type: "Answer" en text (het antwoord)Veelvoorkomende syntaxfouten zijn ontbrekende verplichte eigenschappen, verkeerde @type-waarden, foutieve nesting van Answer-objecten of HTML-tags in het tekstveld (gebruik alleen platte tekst). Valideer na implementatie je markup en monitor Search Console voor gestructureerde datafouten. Mobiele weergavetests zijn cruciaal omdat AI-systemen steeds meer prioriteit geven aan mobile-first content.

De ideale lengte voor een FAQ-antwoord is 40-60 woorden—lang genoeg voor volledige context, maar kort genoeg voor AI-systemen om het zonder afkapping te extraheren en tonen. Zelfstandige antwoorden zijn essentieel; elk antwoord moet te begrijpen zijn zonder dat lezers hoeven door te klikken of andere antwoorden moeten raadplegen. Specifieke data en statistieken met bronnen verhogen de citatiekans aanzienlijk; vage claims zoals “veel mensen” of “onderzoek toont aan” zijn rode vlaggen voor AI-systemen. Externe citaties en links bieden verificatiepaden die AI-systemen gebruiken om de juistheid van het antwoord te controleren.

Zwak FAQ-antwoord: “Wat is het rendement van FAQ-schema implementatie? FAQ-schema levert goed rendement omdat het helpt bij zoekzichtbaarheid.”

Sterk FAQ-antwoord: “Wat is het rendement van FAQ-schema implementatie? Pagina’s met FAQ-schema tonen 28-40% hogere citatiekans in AI-platformen, met AI-verwezen sessies die met 527% toenamen tussen januari-mei 2025. Implementatie vraagt meestal 4-8 uur technisch werk en doorlopende contentonderhoud. Voor e-commerce websites correleert FAQ-schema implementatie met 15-22% stijging in organisch verkeer binnen 60 dagen. Het rendement wordt voor de meeste bedrijven binnen 2-3 maanden positief, met langetermijnvoordelen zoals blijvende AI-zichtbaarheid en minder supporttickets.”

Het sterke antwoord bevat specifieke percentages, tijdframes en meetbare resultaten—precies wat AI-systemen prioriteren bij het beoordelen van antwoordkwaliteit. Gekwantificeerde claims met verificatiepaden geven AI-systemen het signaal dat je antwoord feitelijk en betrouwbaar is.

Verschillende veelvoorkomende implementatiefouten voorkomen dat FAQ-schema AI-citaties oplevert. De belangrijkste fout is FAQ-content verbergen voor gebruikers—Google en AI-platformen bestraffen schema dat niet overeenkomt met zichtbare pagina-inhoud. FAQ-schema gebruiken voor marketing- of promotionele content is in strijd met de richtlijnen en activeert kwaliteitsfilters. Vage of onvolledige antwoorden voldoen niet aan de eisen voor AI-citatie; antwoorden moeten specifiek en zelfstandig zijn. Schema-markup niet valideren voor publicatie veroorzaakt syntaxfouten die AI-systemen verhinderen je content correct te parsen.

Veelgemaakte fouten en oplossingen:

Platform-specifieke optimalisatie negeren betekent dat je FAQ-schema wel werkt voor sommige AI-systemen, maar niet voor andere. Niet overeenkomende schema en zichtbare content veroorzaken vertrouwensproblemen bij AI-systemen, die gestructureerde data vergelijken met de weergegeven HTML om de juistheid te controleren. Regelmatig content updaten geeft AI-systemen het signaal dat je informatie actueel en betrouwbaar blijft.

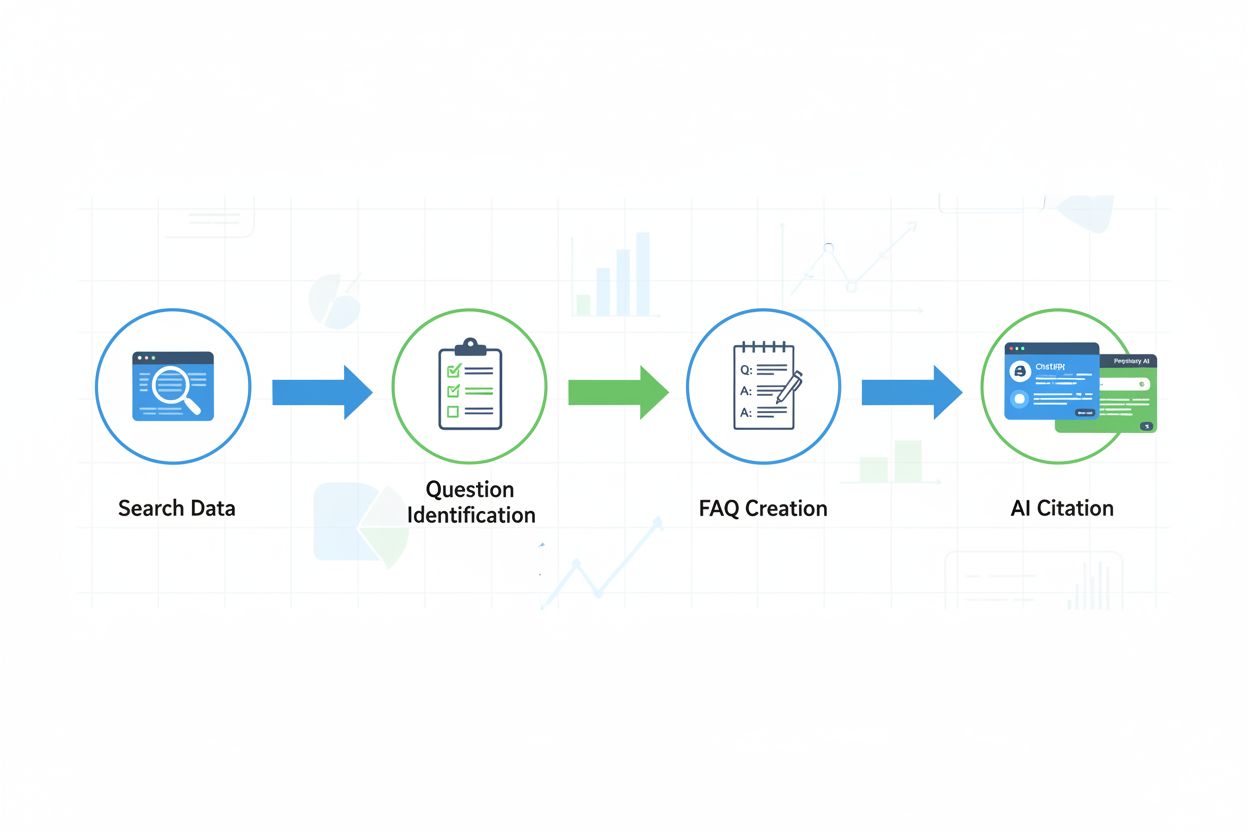

FAQ-schema is alleen waardevol als je vragen beantwoordt die echte gebruikers daadwerkelijk stellen. Vraagonderzoek identificeert kansen met hoge waarde door zoekvolume, People Also Ask-boxen, forumberichten en social media gesprekken te analyseren. Datagedreven vraagselectie verhoogt de citatiekans aanzienlijk omdat je inspeelt op echte gebruikersintentie in plaats van aannames te doen over welke vragen belangrijk zijn. Tools als SEMrush, Ahrefs en Answer the Public analyseren zoekpatronen om veelgestelde vragen in jouw branche te ontdekken.

Content die gebruikersvragen beantwoordt genereert 3x meer engagement dan content op basis van aannames over wat het publiek wil weten. Vragen met hoog zoekvolume verhogen de citatiekans omdat AI-systemen deze herkennen als belangrijke onderwerpen die een volledig antwoord verdienen. Begin met het verzamelen van vragen uit verschillende bronnen: klantenservice-tickets, e-mailvragen, social media-reacties, FAQ-secties van concurrenten en zoektools. Geef prioriteit aan vragen met een maandelijks zoekvolume boven de 100 en aan vragen die in meerdere bronnen voorkomen (wat op echte gebruikersinteresse duidt). Deze onderzoeksbasis zorgt ervoor dat je FAQ-schema zich richt op vragen die belangrijk zijn voor zowel gebruikers als AI-systemen, waardoor de citatiekans en de impact op organisch verkeer maximaal zijn.

Het meetkader voor FAQ-schema succes is fundamenteel verschoven van traditionele SEO-metrics naar AI-specifieke metrics. In plaats van “rich result-impressies” te volgen in Google Search Console (die grotendeels zijn verdwenen na augustus 2023), focus je op “AI-citaties”—hoe vaak jouw FAQ-antwoorden verschijnen in ChatGPT, Perplexity, Google AI Overviews en andere AI-platformen. Monitor de citatiefrequentie gedurende 2-4 weken na implementatie; de meeste websites zien meetbare citaties binnen deze termijn als FAQ-schema goed geoptimaliseerd is.

Belangrijkste metrics om te volgen:

Gebruik Search Console voor traditionele metrics (impressies, klikken, gemiddelde positie), maar vul dit aan met handmatige monitoring of tools van derden om AI-citaties te volgen. Prestaties van featured snippets blijven relevant omdat deze vaak als bron dienen voor AI-systemen. De belangrijkste metric is citatie-snelheid—als citaties niet toenemen binnen 4 weken na implementatie, moet je FAQ-schema waarschijnlijk worden geoptimaliseerd voor platformspecifieke eisen of moeten je antwoorden kwalitatief verbeterd worden.

FAQ-schema (FAQPage) is gestructureerde datamarkering die zoekmachines en AI-platformen helpt om de vraag-antwoordrelatie in je content te begrijpen. Het gebruikt JSON-LD-indeling om vragen en bijbehorende antwoorden expliciet te labelen, waardoor AI-systemen je inhoud gemakkelijker kunnen extraheren, verifiëren en citeren in gegenereerde antwoorden. Het schema fungeert als metadata die machines kunnen lezen om de Q&A-structuur te identificeren, zelfs wanneer paginavormgeving en opmaak variëren.

Ja, maar de waarde is verschoven van traditionele SEO naar AI-zoeken. Google beperkte FAQ-rich results tot overheids- en gezondheidswebsites in augustus 2023, waardoor zichtbare FAQ-snippets voor de meeste bedrijven afnamen. Toch blijft FAQ-schema cruciaal voor featured snippets, voice search en vooral AI-platformen zoals ChatGPT en Perplexity, die sterk leunen op gestructureerde FAQ-data voor citaties. Het schema werd belangrijker voor generative engine optimization, zelfs nu het minder zichtbaar is in traditionele zoekresultaten.

FAQ-schema heeft een van de hoogste citatiepercentages onder schema-types in AI-gegenereerde antwoorden, omdat het vraag-antwoordformaat aansluit bij hoe AI-platformen informatie presenteren. Gestructureerde FAQ-data haalt de interpretatielast weg bij natural language processing, waardoor AI direct antwoorden kan extraheren en bronnen nauwkeurig kan citeren. Pagina's met FAQ-schema verschijnen 3,2 keer vaker in Google AI Overviews dan pagina's zonder FAQ-gestructureerde data.

Voor traditionele SEO was FAQ-schema gericht op rich results en featured snippets in Google zoekresultaten. Voor GEO (Generative Engine Optimization) en AEO (Answer Engine Optimization) stelt FAQ-schema AI-platformen in staat om je content te extraheren, begrijpen en te citeren in gegenereerde antwoorden op ChatGPT, Perplexity en Google AI Overviews. De focus is verschoven van klikken genereren via zichtbare rich results naar citaties verdienen in AI-gegenereerde antwoorden die gebruikers lezen zonder door te klikken naar de bron.

Neem 5-10 FAQ-vragen per pagina op voor pilaarcontent. Minder dan 5 biedt beperkte waarde voor gebruikers en AI-extractiemogelijkheden; meer dan 10 kan de focus verwateren en lezers overweldigen. Kwaliteit is belangrijker dan kwantiteit—beantwoord echte gebruikersvragen volledig met reacties van 40-60 woorden die specifieke data, externe citaties en volledige context bevatten. Gebruik vraagonderzoektools om te bepalen welke vragen daadwerkelijk zoekvolume hebben.

Ja, zolang de FAQ's echt informatief zijn en niet promotioneel. Google's richtlijnen voor gestructureerde data verbieden FAQ-schema voor reclame- of marketinginhoud. Focus op het beantwoorden van echte klantvragen over functies, prijzen, verzending, gebruik, compatibiliteit of ondersteuning. Acceptabele vragen zijn bijvoorbeeld 'Welke functies zijn inbegrepen?' of 'Hoe werkt de verzending?' Onacceptabele vragen zijn 'Waarom zou je nu kopen?' of 'Waarom zijn wij de beste?'

40-60 woorden is ideaal voor AI-extractie, featured snippets en gebruikerservaring. Kortere antwoorden (minder dan 30 woorden) bieden vaak onvoldoende context om op zichzelf te staan. Langere antwoorden (meer dan 80 woorden) zijn moeilijker voor AI-platformen om schoon als eenheid te extraheren en lastiger voor gebruikers om snel te scannen. Zorg dat antwoorden zelfstandig zijn met volledige informatie, specifieke data en waar passend externe citaties—niet afhankelijk van omringende content voor begrip.

Gebruik de Google Rich Results Test om de JSON-LD-syntax te valideren, ontbrekende eigenschappen te detecteren en te bekijken hoe Google je markering interpreteert. Controleer daarnaast mobiele weergave (waar voice assistants actief zijn), zorg dat vragen exact overeenkomen met zichtbare paginaheadings, test dat antwoorden zelfstandig en volledig zijn, en monitor of je FAQ-content verschijnt in AI-gegenereerde antwoorden gedurende 2-4 weken na implementatie. Periodieke her-validatie na site-updates voorkomt regressie.

Volg hoe AI-platformen je FAQ-inhoud citeren in ChatGPT, Perplexity en Google AI Overviews met AmICited

Ontdek hoe FAQ-secties met de juiste schema markup de zichtbaarheid verbeteren in AI-gegenereerde antwoorden van ChatGPT, Perplexity en Google AI Overzichten. O...

Discussie in de community over het implementeren van FAQ-schema voor AI-zichtbaarheid. Technische SEO-professionals delen ervaringen, beste implementatiepraktij...

Leer hoe je FAQ-schema implementeert voor AI-zoekmachines. Stapsgewijze gids met JSON-LD-formaat, best practices, validatie en optimalisatie voor AI-platforms z...