Indexdekking

Indexdekking meet welke websitepagina's door zoekmachines zijn geïndexeerd. Leer wat het betekent, waarom het belangrijk is voor SEO en hoe je indexatieprobleme...

Het percentage van de inhoud van een website dat succesvol wordt geïndexeerd en toegankelijk is voor AI-systemen zoals ChatGPT, Google AI Overviews en Perplexity. Een sterke AI-indexdekkingsgraad zorgt ervoor dat je content vindbaar is in AI-gegenereerde antwoorden en als bron kan worden geciteerd. In tegenstelling tot traditionele zoekindexering bepaalt AI-indexdekkingsgraad de zichtbaarheid op meerdere AI-platforms en door LLM aangedreven systemen.

Het percentage van de inhoud van een website dat succesvol wordt geïndexeerd en toegankelijk is voor AI-systemen zoals ChatGPT, Google AI Overviews en Perplexity. Een sterke AI-indexdekkingsgraad zorgt ervoor dat je content vindbaar is in AI-gegenereerde antwoorden en als bron kan worden geciteerd. In tegenstelling tot traditionele zoekindexering bepaalt AI-indexdekkingsgraad de zichtbaarheid op meerdere AI-platforms en door LLM aangedreven systemen.

AI-indexdekkingsgraad verwijst naar het percentage van de content op je website dat succesvol wordt ontdekt, gecrawld en geïndexeerd door kunstmatige intelligentiesystemen zoals ChatGPT, Google AI Overviews, Perplexity en andere grote taalmodellen (LLM’s). In tegenstelling tot traditionele zoekmachine-indexering, die zich richt op zichtbaarheid in zoekresultaten, bepaalt AI-indexdekkingsgraad of je content toegankelijk is voor AI-systemen voor training, citatie en opname in AI-gegenereerde antwoorden. Wanneer je content een sterke AI-indexdekkingsgraad heeft, wordt deze vindbaar op meerdere AI-platforms, waardoor de kans groter is dat je merk, producten of informatie wordt genoemd wanneer gebruikers deze systemen raadplegen. Een slechte AI-indexdekkingsgraad betekent dat waardevolle content onzichtbaar blijft voor AI-systemen, waardoor je belangrijke kansen op merkzichtbaarheid mist in het snelgroeiende AI-zoeklandschap.

AI-indexdekkingsgraad beïnvloedt direct de zichtbaarheid van je merk in een steeds meer door AI gedreven digitaal ecosysteem. Nu AI-gestuurde resultaten in meer dan 91% van de productgerelateerde zoekopdrachten verschijnen en AI-platforms zoals ChatGPT wekelijks meer dan 1 miljard zoekopdrachten verwerken, is het essentieel dat je content door deze systemen wordt geïndexeerd voor een moderne digitale strategie. De zakelijke impact is groot: content met een sterke AI-indexdekkingsgraad kan worden geciteerd in AI-antwoorden, wat gericht verkeer en merkbekendheid oplevert, terwijl content die wordt geblokkeerd of slecht wordt geïndexeerd volledig onzichtbaar blijft voor deze krachtige kanalen. Bovendien citeren AI-systemen vaak bronnen die niet in traditionele zoekresultaten staan—slechts ongeveer 20% van de pagina’s die door AI worden geciteerd, verschijnen in Google’s top 10 organische resultaten, wat betekent dat AI-indexering geheel nieuwe zichtbaarheid biedt.

| Scenario | Impact op AI-zichtbaarheid | Zakelijk resultaat |

|---|---|---|

| Goed geïndexeerde, hoogwaardige content | Vaak geciteerd in AI-antwoorden | Meer merkvermeldingen, gericht verkeer, autoriteit opbouwen |

| Geïndexeerd maar zelden geciteerd | Weinig vermeldingen in AI-resultaten | Beperkte zichtbaarheid ondanks technische toegankelijkheid |

| Geblokkeerd of niet geïndexeerd | Geen zichtbaarheid in AI-systemen | Gemiste kansen, concurrenten krijgen meer stem |

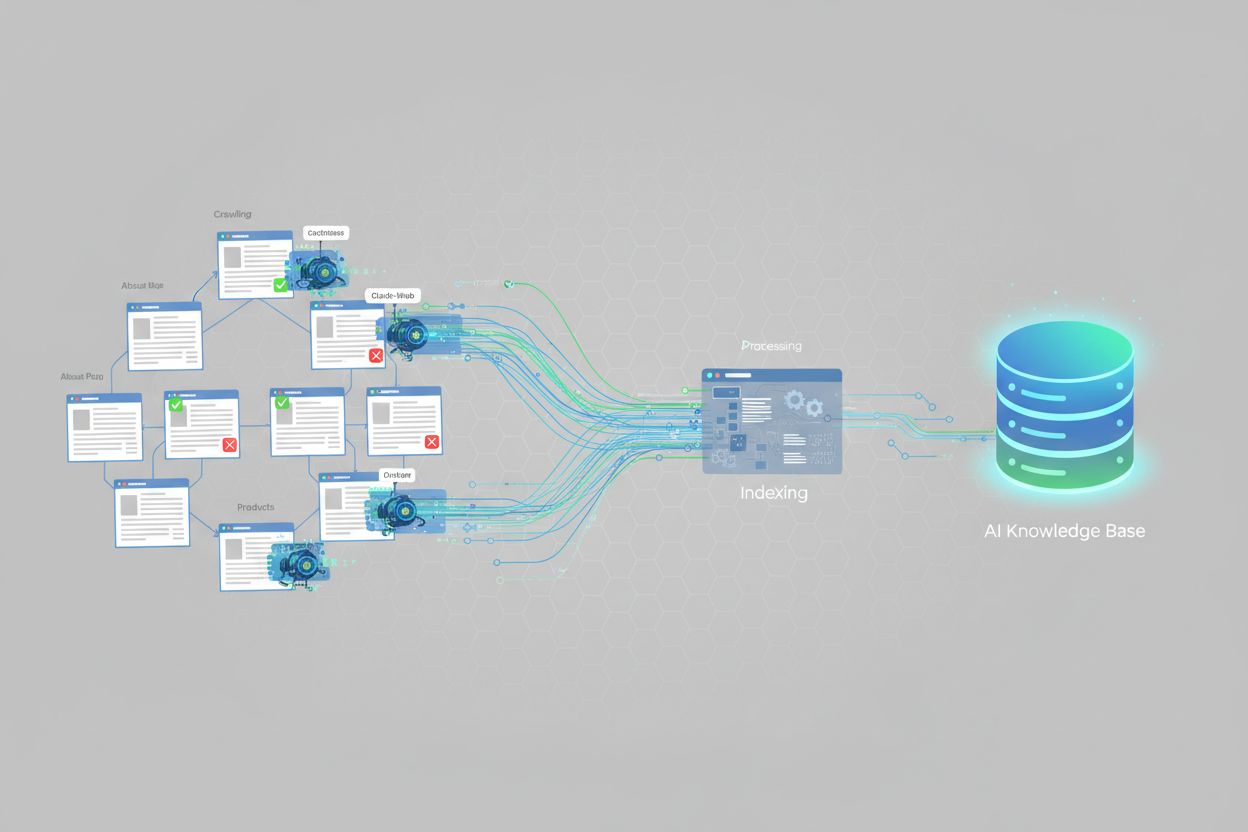

AI-systemen indexeren content via gespecialiseerde crawlers die ontworpen zijn om informatie te begrijpen en te verwerken voor grote taalmodellen. ChatGPT gebruikt crawlers zoals GPTBot om het web continu te scannen en trainingsdata te verzamelen, maar vertrouwt ook op realtime websearch voor actuele informatie. Google AI Overviews maakt gebruik van Google’s bestaande crawl-infrastructuur, maar past extra verwerking toe om contentstructuur, relevantie en autoriteit te begrijpen voor AI-gegenereerde samenvattingen. Perplexity AI hanteert een andere benadering door realtime websearch te benadrukken en per zoekopdracht meer dan 20 bronnen te raadplegen, met een duidelijke voorkeur voor platforms zoals Reddit en community-gedreven content. Elk AI-platform heeft eigen indexeringsvoorkeuren: sommigen geven de voorkeur aan gestructureerde data en schema-markup, anderen aan uitgebreide, goed geschreven content, en weer anderen hechten meer aan citaties en reviews van derden. Het is belangrijk deze verschillen te begrijpen, want optimalisatie voor het ene AI-systeem betekent niet automatisch optimalisatie voor alle systemen—je contentstrategie moet rekening houden met de specifieke indexeringsgedragingen van de platforms die voor je doelgroep relevant zijn.

Verschillende technische factoren bepalen direct of AI-systemen je content succesvol kunnen indexeren. De belangrijkste zijn:

<meta name="robots" content="noindex"> worden expliciet uitgesloten van AI-indexering. Deze tags worden soms per ongeluk op live pagina’s achtergelaten na ontwikkeling.Het aanpakken van deze technische factoren vormt de basis voor het verbeteren van de AI-indexdekkingsgraad. Tools zoals AmICited.com kunnen helpen monitoren hoe effectief je content wordt geïndexeerd op verschillende AI-platforms en inzicht geven in technische problemen die je dekking kunnen beperken.

Het bijhouden van je AI-indexdekkingsgraad vereist een combinatie van traditionele SEO-tools en AI-specifieke monitoringsoplossingen. Google Search Console biedt indexdekkingsrapporten die tonen welke pagina’s door Google zijn geïndexeerd, al weerspiegelt dit de traditionele zoekindexering en niet die van AI-systemen. Bing Webmaster Tools biedt vergelijkbare functionaliteit voor Bing. Voor AI-specifieke monitoring is AmICited.com gespecialiseerd in het volgen van hoe je merk verschijnt in ChatGPT, Google AI Overviews, Perplexity en andere AI-systemen, inclusief citatiefrequentie, sentiment en aandeel van stem. Derde partij SEO-platforms zoals Semrush, Ahrefs en Moz bevatten steeds vaker AI-zichtbaarheidsstatistieken naast traditionele SEO-data. Belangrijke meetpunten zijn: het percentage sitepagina’s dat in AI-antwoorden verschijnt, hoe vaak je merk wordt geciteerd vergeleken met concurrenten, het sentiment van AI-vermeldingen en welke contenttypen de meeste AI-citaties genereren. Door regelmatig te monitoren kun je technische problemen, contentgaten en kansen ontdekken om je AI-indexdekkingsgraad te verbeteren.

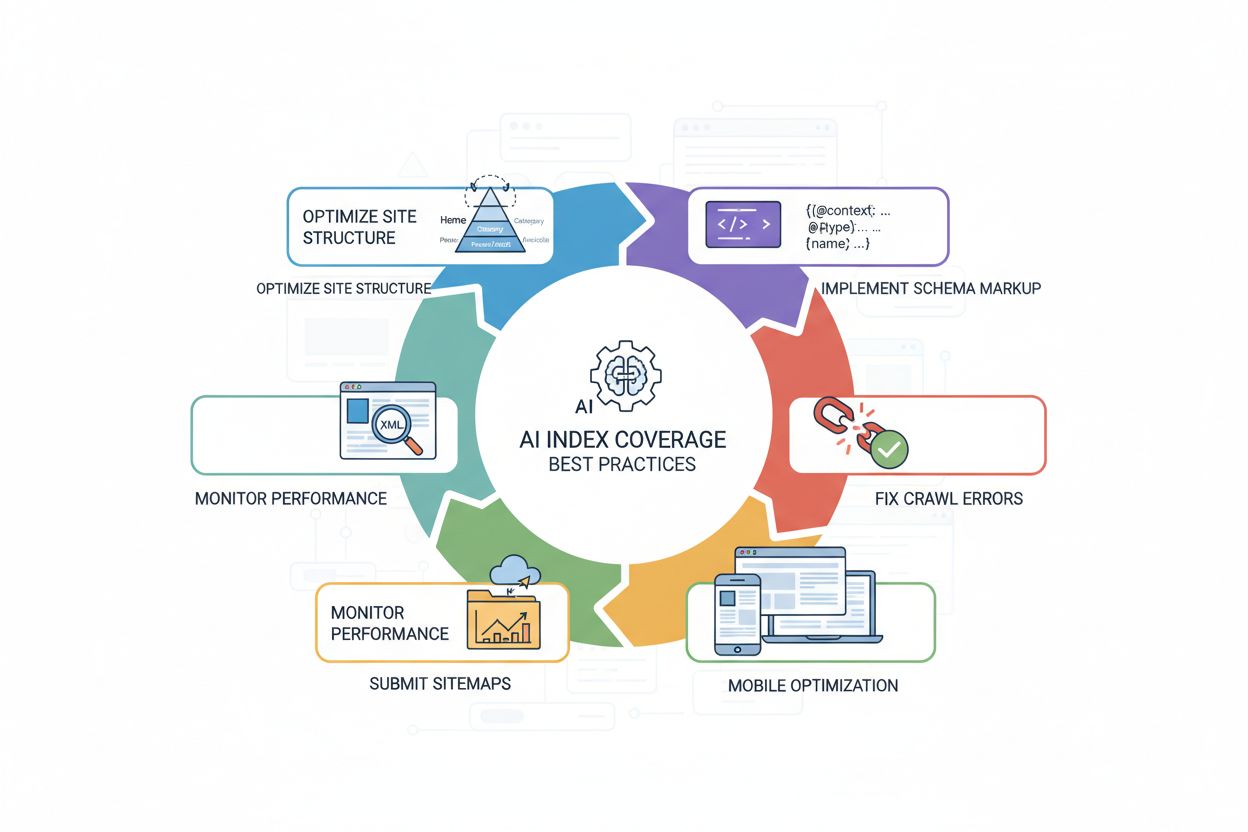

Het verbeteren van je AI-indexdekkingsgraad vereist een strategische aanpak die technische optimalisatie combineert met sterke content. De meest effectieve praktijken zijn onder andere:

<article>, <section>, <header>, <nav>) om contentstructuur en betekenis duidelijk aan AI-systemen te communiceren.Deze practices zorgen samen voor een AI-vriendelijke website die makkelijk toegankelijk, begrijpelijk en citeerbaar is voor crawlers. Het resultaat is een sterkere AI-indexdekkingsgraad en meer zichtbaarheid op AI-gestuurde platforms.

Hoewel AI-indexdekkingsgraad en traditionele zoekindexdekkingsgraad verwant zijn, zijn ze niet identiek. Traditionele zoekindexering richt zich op zichtbaarheid in zoekmachineresultatenpagina’s (SERP’s), met ranking op basis van factoren als backlinks, trefwoordrelevantie en gebruikerssignalen. AI-indexdekkingsgraad daarentegen bepaalt of content toegankelijk is voor AI-systemen voor training en realtime citatie, met geheel andere rankingfactoren. AI-systemen citeren vaak bronnen die niet goed scoren in de traditionele zoekresultaten—de 20% overlap tussen AI-geciteerde pagina’s en de top 10 organische resultaten laat dit verschil duidelijk zien. Bovendien geven AI-systemen soms de voorkeur aan andere contenttypen: waar traditionele zoekmachines vooral letten op autoriteit op domeinniveau, geven AI-systemen vaak meer gewicht aan specifieke formats (FAQ’s, lijstjes, vergelijkingsgidsen, reviews). Een pagina kan hoog ranken in Google, maar zelden door AI-systemen worden geciteerd, of andersom. Dit betekent dat je optimalisatiestrategie op beide kanalen gericht moet zijn: traditionele SEO verbetert zoekzichtbaarheid, terwijl AI-specifieke optimalisaties (schema-markup, contentstructuur, toegankelijkheid) de AI-indexdekkingsgraad en citatiekans vergroten.

Er zijn verschillende veelvoorkomende problemen die websites verhinderen een sterke AI-indexdekkingsgraad te behalen. Te restrictieve robots.txt-bestanden zijn een van de belangrijkste boosdoeners—veel sites blokkeren per ongeluk AI-crawlers terwijl ze alleen traditionele zoekbots willen weren, waardoor AI-indexering volledig wordt verhinderd. Verkeerd geplaatste noindex-tags die op live pagina’s blijven staan na ontwikkeling of migratie, kunnen hele secties onzichtbaar maken voor AI-systemen. Slechte contentstructuur maakt het moeilijk voor AI-crawlers om informatie te begrijpen en te extraheren; pagina’s zonder duidelijke koppen, semantische HTML of logische organisatie worden minder snel geïndexeerd en geciteerd. Ontbrekende of onvolledige schema-markup ontneemt AI-systemen expliciete context over je content, waardoor indexering en citatiekans afnemen. JavaScript-zware sites zonder server-side rendering vormen een groot probleem, omdat veel AI-crawlers geen JavaScript kunnen uitvoeren, waardoor belangrijke content verborgen blijft. Dubbele content zonder juiste canonicalisatie verwart AI-systemen over welke versie leidend is, wat dekking kan verminderen. Tot slot verminderen trage pagina’s en slechte mobiele optimalisatie de crawl-efficiëntie, waardoor minder van je site wordt geïndexeerd. Door deze problemen systematisch aan te pakken—te beginnen met robots.txt-verificatie, het toevoegen van schema-markup, het verbeteren van sitestructuur en zorgen voor snelle, mobiele pagina’s—kun je je AI-indexdekkingsgraad en zichtbaarheid op AI-platforms aanzienlijk verbeteren.

Momenteel bestaat er geen gestandaardiseerde metriek voor AI-indexdekkingsgraad over alle websites, maar onderzoek toont aan dat AI-gestuurde resultaten verschijnen in meer dan 91% van de productgerelateerde zoekopdrachten. Veel websites hebben echter een slechte AI-indexdekkingsgraad door technische problemen zoals robots.txt-blokkades, ontbrekende schema-markup of problemen met JavaScript-rendering. Websites met sterke technische SEO en gestructureerde data behalen doorgaans een betere AI-indexdekkingsgraad.

Traditionele Google-indexdekkingsgraad richt zich op het zichtbaar maken van content in zoekresultaten, terwijl AI-indexdekkingsgraad bepaalt of content toegankelijk is voor AI-systemen voor training en citatie. AI-systemen citeren vaak bronnen die niet in de top 10 van Google staan—slechts ongeveer 20% van de door AI geciteerde pagina’s verschijnt in de traditionele top 10 organische resultaten. Verschillende AI-platforms hebben bovendien verschillende indexeringsvoorkeuren en bronwegingen.

Ja, je kunt specifieke AI-crawlers blokkeren via je robots.txt-bestand. Je kunt bijvoorbeeld GPTBot (OpenAI), CCBot (Common Crawl) of Claude-Web (Anthropic) uitsluiten. Het blokkeren van AI-crawlers betekent echter dat je content niet door deze systemen wordt geïndexeerd en niet verschijnt in AI-gegenereerde antwoorden. De meeste bedrijven profiteren van het toestaan van AI-crawlers om de zichtbaarheid op AI-platforms te vergroten.

Indexeringstijden verschillen per AI-platform. GPTBot van ChatGPT crawlt continu, maar het kan dagen of weken duren voordat nieuwe content wordt ontdekt. Google AI Overviews gebruikt de bestaande crawl-infrastructuur van Google, dus indexering kan binnen enkele uren tot dagen plaatsvinden. Perplexity richt zich op realtime websearch, waardoor recente content snel kan verschijnen in antwoorden. Door XML-sitemaps te gebruiken en indexering aan te vragen via webmastertools kun je het proces versnellen.

AI-indexdekkingsgraad en traditionele zoekrangschikking zijn gerelateerd maar verschillend. Optimaliseren voor AI-indexdekkingsgraad (via schema-markup, sitestructuur en toegankelijkheid) verbetert ook de traditionele SEO. Een pagina kan echter goed scoren in Google, maar zelden worden geciteerd door AI-systemen, of omgekeerd. De beste strategie is om voor beide te optimaliseren: traditionele SEO verbetert zoekzichtbaarheid, AI-specifieke optimalisaties verbeteren de AI-indexdekkingsgraad.

De meest voorkomende oorzaken zijn: 1) Te restrictieve robots.txt-bestanden die AI-crawlers per ongeluk blokkeren, 2) Ontbrekende of onvolledige schema-markup waardoor AI-systemen de context van content niet begrijpen, 3) JavaScript-zware sites zonder server-side rendering die AI-crawlers niet kunnen verwerken, en 4) Slechte sitestructuur waardoor crawlers content moeilijk kunnen vinden. Het oplossen van deze technische problemen verbetert doorgaans de AI-indexdekkingsgraad aanzienlijk.

Je kunt AI-indexdekkingsgraad monitoren met tools zoals AmICited.com, die bijhoudt hoe je merk verschijnt in ChatGPT, Google AI Overviews, Perplexity en andere AI-systemen. Let op statistieken zoals citatiefrequentie, aandeel van stem ten opzichte van concurrenten en sentiment van vermeldingen. Je kunt ook handmatig testen door je merk en belangrijke onderwerpen in AI-systemen te zoeken en te controleren of je content in antwoorden verschijnt.

Hoewel het niet strikt vereist is, verbetert schema-markup de AI-indexdekkingsgraad aanzienlijk. Gestructureerde data (JSON-LD) helpt AI-systemen de context van content te begrijpen, informatie nauwkeurig te extraheren en relevantie te bepalen. Pagina’s met correcte schema-markup voor producten, artikelen, FAQ’s en organisaties worden eerder geïndexeerd en geciteerd door AI-systemen. Het wordt beschouwd als een best practice voor het optimaliseren van AI-indexdekkingsgraad.

Volg hoe AI-systemen je merk ontdekken en citeren via ChatGPT, Google AI Overviews, Perplexity en meer. Krijg realtime inzichten in je AI-zichtbaarheid, citatiefrequentie en aandeel in AI-gegenereerde antwoorden.

Indexdekking meet welke websitepagina's door zoekmachines zijn geïndexeerd. Leer wat het betekent, waarom het belangrijk is voor SEO en hoe je indexatieprobleme...

Ontdek wat een AI Visibility Index is, hoe het citatiefrequentie, positie, sentiment en bereik combineert, en waarom het belangrijk is voor merkzichtbaarheid in...

Ontdek wat Query Coverage Rate is, hoe je het meet en waarom het cruciaal is voor merkzichtbaarheid in AI-gestuurde zoekopdrachten. Leer over benchmarks, optima...