Hoe robots.txt configureren voor AI-crawlers: Complete gids

Leer hoe je robots.txt configureert om AI-crawlerstoegang te beheren, inclusief GPTBot, ClaudeBot en Perplexity. Beheer de zichtbaarheid van je merk in AI-gegen...

Configuratie van robots.txt met user-agent regels die specifiek gericht zijn op AI crawlers. Een AI-specifieke robots.txt stelt website-eigenaren in staat te bepalen hoe kunstmatige intelligentie-systemen, large language models en AI-trainingsbots hun content kunnen benaderen en gebruiken. Het maakt onderscheid tussen verschillende typen AI-crawlers—training crawlers, zoekcrawlers en door gebruikers geactiveerde fetchers—en biedt zo gedetailleerde controle over de zichtbaarheid van content voor AI-systemen. Deze configuratie is essentieel geworden nu AI-crawlers ongeveer 80% van het botverkeer naar veel websites voor hun rekening nemen.

Configuratie van robots.txt met user-agent regels die specifiek gericht zijn op AI crawlers. Een AI-specifieke robots.txt stelt website-eigenaren in staat te bepalen hoe kunstmatige intelligentie-systemen, large language models en AI-trainingsbots hun content kunnen benaderen en gebruiken. Het maakt onderscheid tussen verschillende typen AI-crawlers—training crawlers, zoekcrawlers en door gebruikers geactiveerde fetchers—en biedt zo gedetailleerde controle over de zichtbaarheid van content voor AI-systemen. Deze configuratie is essentieel geworden nu AI-crawlers ongeveer 80% van het botverkeer naar veel websites voor hun rekening nemen.

AI-specifieke robots.txt-configuratie verwijst naar het opstellen van gerichte regels in je robots.txt-bestand die specifiek gericht zijn op crawlers en trainingsbots van kunstmatige intelligentie, anders dan traditionele zoekmachinecrawlers zoals Googlebot. Waar de conventionele robots.txt zich historisch richtte op het beheren van Googlebot, Bingbot en andere zoekindexers, heeft de opkomst van large language models en AI-trainingssystemen een geheel nieuwe categorie botverkeer gecreëerd die een aparte beheerstrategie vereist. Volgens recente gegevens van november 2025 is circa 80% van al het botverkeer naar veel uitgeverswebsites nu afkomstig van AI-crawlers, waardoor het belang van robots.txt-configuratie is verschoven van een handige SEO-tool naar een essentieel mechanisme voor contentbescherming. Het onderscheid is belangrijk omdat AI-training crawlers volgens andere bedrijfsmodellen werken dan zoekmachines—ze verzamelen data om eigen modellen te trainen en niet om verwijzingsverkeer te genereren—waardoor de traditionele ruil van crawlers toelaten in ruil voor zoekzichtbaarheid niet meer opgaat. Voor uitgevers betekent dit dat robots.txt-beslissingen nu direct invloed hebben op de zichtbaarheid van content voor AI-systemen, mogelijk ongeoorloofd gebruik van eigen content in trainingsdatasets, en de algemene gevolgen voor verkeer en inkomsten door AI-ontdekking.

AI-crawlers vallen uiteen in drie operationele categorieën, elk met verschillende kenmerken, verkeersimplicaties en strategische overwegingen voor uitgevers. Training crawlers zijn ontworpen om grote hoeveelheden tekstdata te verzamelen voor machine learning modelontwikkeling; ze werken meestal met hoge bandbreedte, zorgen voor veel serverbelasting en leveren geen verwijzingsverkeer op—voorbeelden zijn OpenAI’s GPTBot en Anthropic’s ClaudeBot. Zoek- en citatiecrawlers werken vergelijkbaar met traditionele zoekmachines door content te indexeren en te voorzien van bronvermelding; ze genereren matig verkeer en kunnen verwijzingsverkeer opleveren via citaties en links—dit zijn bijvoorbeeld OpenAI’s OAI-SearchBot en Google’s AI Overviews crawler. Door gebruikers geactiveerde crawlers werken op aanvraag wanneer eindgebruikers expliciet AI-analyse van een webpagina aanvragen, zoals ChatGPT’s web-browse functie of Claude’s documentanalyse; deze zorgen voor minder verkeer maar vertegenwoordigen directe gebruikersinteractie met je content. Deze indeling is strategisch belangrijk omdat training crawlers het grootste risico voor contentbescherming vormen met weinig zakelijk voordeel, zoekcrawlers een middenweg bieden met enige verwijzingspotentie, en door gebruikers geactiveerde crawlers doorgaans aansluiten bij gebruikersintentie en de zichtbaarheid van content kunnen vergroten.

| Categorie Crawler | Doel | Verkeersvolume | Verwijzingspotentieel | Contentrisico | Voorbeelden |

|---|---|---|---|---|---|

| Training | Modelontwikkeling | Zeer hoog | Geen | Zeer hoog | GPTBot, ClaudeBot |

| Zoek/Citatie | Contentindexatie & bronvermelding | Matig | Matig | Matig | OAI-SearchBot, Google AI |

| Gebruiker-geactiveerd | Analyse op aanvraag | Laag | Laag | Laag | ChatGPT Web Browse, Claude |

De belangrijkste AI-bedrijven die crawlers exploiteren zijn OpenAI, Anthropic, Google, Meta, Apple en Amazon, elk met onderscheidende user-agent strings die identificatie in serverlogs en robots.txt-configuratie mogelijk maken. OpenAI beheert meerdere crawlers: GPTBot (user-agent: GPTBot/1.0) voor trainingsdataverzameling, OAI-SearchBot (user-agent: OAI-SearchBot/1.0) voor zoek- en citatie-indexering, en ChatGPT-User (user-agent: ChatGPT-User/1.0) voor door gebruikers gestuurde web browsing. De belangrijkste crawler van Anthropic is ClaudeBot (user-agent: Claude-Web/1.0 of anthropic-ai), gebruikt voor training en kennisbankontwikkeling. Google exploiteert Google-Extended (user-agent: Google-Extended/1.1) voor Gemini en andere AI-producten, terwijl Meta gebruikmaakt van facebookexternalhit voor contentanalyse, Apple AppleBot voor Siri en zoekfuncties, en Amazon Amazonbot voor Alexa en zoekmogelijkheden. Om deze crawlers in je serverlogs te identificeren, bekijk je de User-Agent header in HTTP-verzoeken—de meeste legitieme AI-crawlers vermelden hun bedrijfsnaam en versienummer in dit veld. Voor meer veiligheid kun je de legitimiteit van crawlers verifiëren door het opvragende IP-adres te controleren aan de hand van gepubliceerde IP-bereiken van ieder bedrijf; OpenAI publiceert zijn crawler-IP-ranges, net als Google en andere grote aanbieders, waardoor je legitieme crawlers kunt onderscheiden van gespoofde user-agents.

De basis-syntaxis voor AI-specifieke robots.txt-regels volgt het standaard robots.txt-formaat met user-agent matching en allow/disallow-directieven gericht op specifieke crawlers. Om OpenAI’s GPTBot te blokkeren voor trainingsdataverzameling en hun zoekcrawler toe te staan, zou je robots.txt er als volgt uitzien:

User-agent: GPTBot

Disallow: /

User-agent: OAI-SearchBot

Allow: /

Voor meer gedetailleerde controle kun je pad-specifieke regels toepassen die bepaalde secties blokkeren en andere toestaan—bijvoorbeeld AI-crawlers blokkeren voor toegang tot je betaalmuurcontent of gebruikersgegenereerde content:

User-agent: GPTBot

Disallow: /premium/

Disallow: /user-content/

Allow: /public-articles/

User-agent: ClaudeBot

Disallow: /

Je kunt meerdere user-agents groeperen onder één set regels om identieke restricties toe te passen op verschillende crawlers, wat de configuratie vereenvoudigt. Het testen en valideren van je robots.txt-configuratie is cruciaal; tools zoals de robots.txt-tester van Google Search Console en externe validators kunnen controleren of je regels syntactisch correct zijn en goed worden geïnterpreteerd door crawlers. Onthoud dat robots.txt adviserend is en niet afdwingbaar—crawlers die zich aan de regels houden zullen deze respecteren, maar kwaadwillenden of niet-conforme bots kunnen ze negeren, waardoor aanvullende server-level handhaving nodig is voor gevoelige content.

De keuze om AI-crawlers te blokkeren of toe te staan, draait om fundamentele afwegingen tussen contentbescherming en zichtbaarheid, die sterk variëren afhankelijk van je businessmodel en contentstrategie. Het blokkeren van training crawlers zoals GPTBot elimineert het risico dat jouw content wordt gebruikt om eigen AI-modellen te trainen zonder compensatie, maar betekent ook dat je content niet verschijnt in AI-gegenereerde antwoorden, waardoor ontdekking en verkeer via AI-systemen kunnen afnemen. Anderzijds vergroot het toestaan van training crawlers de kans dat je content wordt opgenomen in AI-trainingsdatasets, mogelijk zonder bronvermelding of vergoeding, maar kan het de zichtbaarheid vergroten als deze AI-systemen uiteindelijk jouw content citeren of refereren. De strategische keuze hangt af van het concurrentievoordeel van je content—eigen onderzoek, originele analyses en unieke data vragen om strikte blokkering, terwijl algemene educatieve content of commodity informatie kan profiteren van bredere AI-zichtbaarheid. Verschillende uitgeverstypes hanteren een andere afweging: nieuwsorganisaties kunnen zoekcrawlers toestaan voor citatieverkeer en training crawlers blokkeren, educatieve uitgevers kunnen bredere toegang toestaan om hun bereik te vergroten, en SaaS-bedrijven blokkeren vaak alle AI-crawlers ter bescherming van eigen documentatie. Monitor de impact van je blokkades via serverlogs en verkeersanalyses om te valideren of je configuratie je beoogde zakelijke doelen bereikt.

Hoewel robots.txt een duidelijk mechanisme biedt om crawlerbeleid te communiceren, is het in de kern adviserend en juridisch niet afdwingbaar—crawlers die zich aan de regels houden zullen je richtlijnen volgen, maar niet-conforme actoren kunnen ze negeren, waardoor aanvullende technische handhaving nodig is. IP-verificatie en allowlisting is de meest betrouwbare handhavingsmethode; door een lijst bij te houden van legitieme IP-adressen die door OpenAI, Google, Anthropic en andere grote AI-bedrijven worden gepubliceerd, kun je controleren of verzoeken die beweren van deze crawlers te komen daadwerkelijk van hun infrastructuur afkomstig zijn. Firewallregels en server-niveau blokkering bieden het sterkste handhavingsmechanisme, zodat je verzoeken van specifieke user-agents of IP-bereiken bij het netwerk al kunt afwijzen voordat ze serverresources gebruiken. Voor Apache-servers kun je met .htaccess-configuratie crawler-beperkingen afdwingen:

<IfModule mod_rewrite.c>

RewriteEngine On

RewriteCond %{HTTP_USER_AGENT} GPTBot [NC]

RewriteRule ^.*$ - [F,L]

</IfModule>

Meta-tags in je HTML-headsectie bieden gedetailleerde, paginaniveau controle over crawler-toegang zonder robots.txt te wijzigen:

<meta name="robots" content="noindex, noimageindex, nofollowbyai">

Regelmatig serverlogs controleren op crawleractiviteit stelt je in staat nieuwe crawlers te identificeren, te verifiëren of je regels worden nageleefd en gespoofde user-agents te detecteren die proberen je restricties te omzeilen. Tools zoals Knowatoa en Merkle bieden geautomatiseerde validatie en monitoring van je robots.txt-configuratie en crawlergedrag, zodat je inzicht krijgt in welke crawlers je site bezoeken en of ze je richtlijnen respecteren.

Doorlopende onderhoud van je AI-specifieke robots.txt-configuratie is cruciaal omdat het landschap van AI-crawlers snel verandert, met regelmatig nieuwe crawlers en aanpassingen in user-agent strings en gedrag. Je monitoringsstrategie zou het volgende moeten omvatten:

Door de snelle evolutie van AI-crawlertechnologie kan een robots.txt-configuratie die zes maanden geleden geschikt was nu niet langer passen bij je behoeften of het actuele dreigingslandschap, waardoor regelmatige review en aanpassing essentieel zijn voor effectieve contentbescherming.

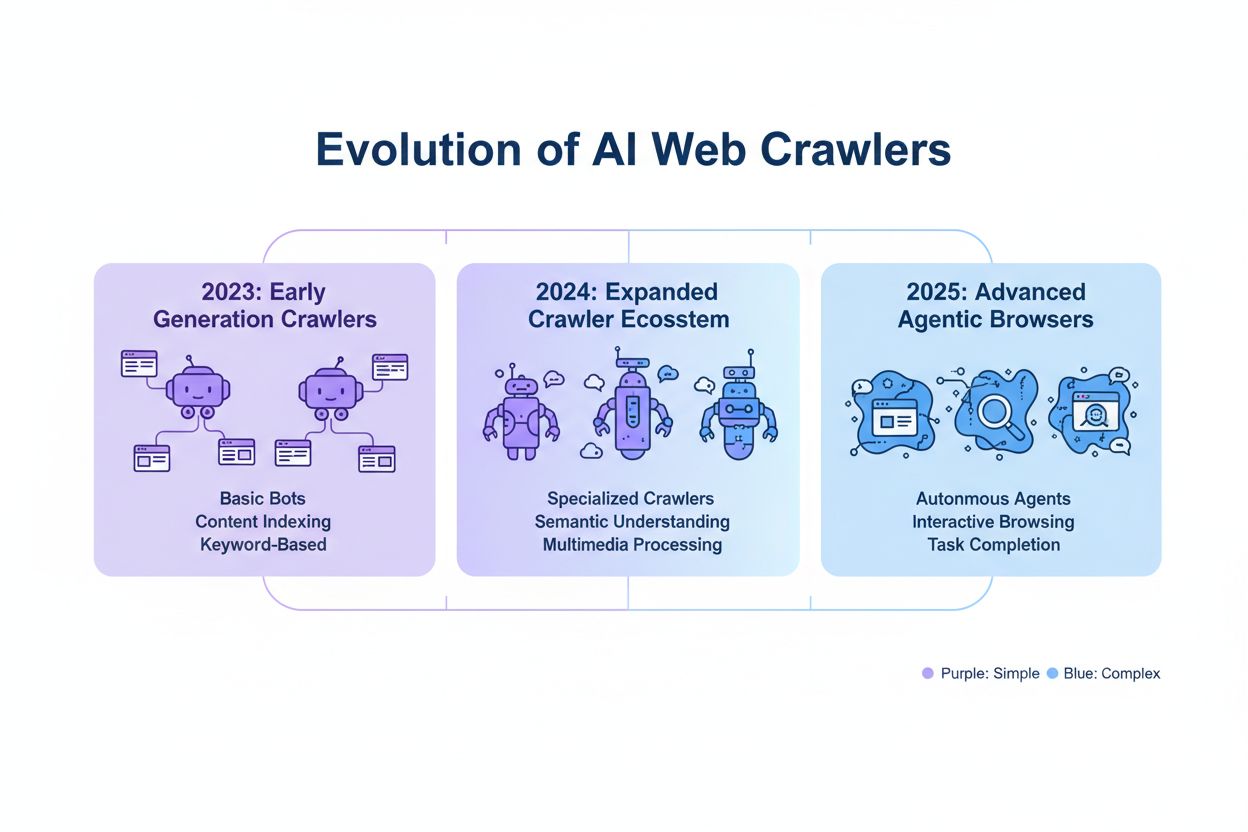

De volgende generatie AI-crawlers brengt nieuwe uitdagingen met zich mee die traditionele robots.txt-configuratie mogelijk niet effectief kan adresseren. Agentic browser crawlers zoals ChatGPT Atlas en Google Project Mariner functioneren als volwaardige webbrowsers in plaats van eenvoudige HTTP-clients, voeren JavaScript uit, interacteren met gebruikers en gedragen zich niet te onderscheiden van echte bezoekers—deze crawlers identificeren zich vaak niet met een herkenbare user-agent string, waardoor blokkade via robots.txt niet werkt. Veel opkomende crawlers nemen standaard Chrome user-agent strings aan om detectie en blokkering te omzeilen en hun identiteit te verhullen om robots.txt-regels en toegangscontroles te omzeilen. Deze trend leidt tot een verschuiving naar IP-gebaseerde blokkering als noodzakelijkheid, waarbij uitgevers lijsten bijhouden van legitieme crawler-IP-adressen en al het andere verdachte verkeer blokkeren, waarmee de handhaving verschuift van user-agent matching naar netwerktoegangscontrole. Gespoofde user-agents en omzeilingstechnieken worden steeds gebruikelijker, waarbij kwaadwillenden zich voordoen als legitieme crawlers of generieke user-agent strings gebruiken om detectie te vermijden. De toekomst van AI-crawlerbeheer zal waarschijnlijk een meerlagige aanpak vereisen met robots.txt-configuratie, IP-verificatie, firewallregels en mogelijk gedragsanalyse om legitieme crawlers te onderscheiden van kwaadwillende actoren. Op de hoogte blijven van nieuwe crawlertechnologieën en deelnemen aan discussies over crawler-ethiek en standaarden is essentieel voor uitgevers die effectieve contentbeschermingsstrategieën willen behouden.

Effectieve AI-specifieke robots.txt-configuratie vereist een integrale benadering die contentbescherming in balans brengt met strategische zichtbaarheid. Begin met een duidelijk contentbeschermingsbeleid waarin je bepaalt welke contentcategorieën geblokkeerd moeten worden (eigen onderzoek, premium content, gebruikerscontent) en welke veilig toegankelijk zijn voor AI-crawlers (publieke artikelen, educatieve content, algemene informatie). Voer een gelaagde blokkeringsstrategie in waarbij je onderscheid maakt tussen training crawlers (meestal blokkeren), zoekcrawlers (meestal toestaan met monitoring) en door gebruikers geactiveerde crawlers (meestal toestaan), in plaats van een alles-of-niets benadering voor alle AI-crawlers. Combineer robots.txt met server-niveau handhaving door firewallregels en IP-verificatie toe te passen voor je meest gevoelige content, aangezien robots.txt alleen ontoereikend is voor sterke contentbescherming. Integreer AI-crawlerbeheer in je bredere SEO- en contentstrategie door te overwegen hoe blokkeringsbeslissingen je zichtbaarheid in AI-antwoorden, citaties en AI-zoekfuncties beïnvloeden—zo zorg je ervoor dat je robots.txt-configuratie je bedrijfsdoelen ondersteunt in plaats van ondermijnt. Stel een monitorings- en onderhoudsritme vast met wekelijkse logreviews, maandelijkse IP-verificatie en kwartaalgewijze audits om de effectiviteit van je configuratie te waarborgen naarmate het crawlerlandschap verandert. Gebruik tools zoals AmICited.com om de zichtbaarheid van je content binnen AI-systemen te monitoren en de impact van je blokkeringsbeslissingen op AI-ontdekking en citatie te begrijpen. Voor verschillende uitgeverstypes: nieuwsorganisaties doen er doorgaans goed aan zoekcrawlers toe te staan en training crawlers te blokkeren om citatieverkeer te maximaliseren; educatieve uitgevers kunnen bredere toegang overwegen voor groter bereik; en SaaS-bedrijven dienen strikte blokkering toe te passen op eigen documentatie. Als blokkering via robots.txt niet volstaat door gespoofde user-agents of niet-conforme crawlers, schakel dan over op firewallregels en IP-gebaseerde blokkering om je contentbeschermingsbeleid op netwerkniveau te handhaven.

Training crawlers zoals GPTBot en ClaudeBot verzamelen data voor modelontwikkeling en leveren geen verwijzingsverkeer, waardoor ze een groot risico vormen voor contentbescherming. Zoekcrawlers zoals OAI-SearchBot en PerplexityBot indexeren content voor AI-zoekopdrachten en kunnen verwijzingsverkeer opleveren via citaties. De meeste uitgevers blokkeren training crawlers, terwijl ze zoekcrawlers toestaan om contentbescherming in balans te brengen met zichtbaarheid.

Google geeft officieel aan dat het blokkeren van Google-Extended geen invloed heeft op zoekrangschikking of opname in AI Overviews. Sommige webmasters hebben echter zorgen geuit, dus monitor je zoekprestaties nadat je blokkades hebt ingevoerd. AI Overviews in Google Search volgen de standaard Googlebot-regels, niet die van Google-Extended.

Ja, robots.txt is adviserend en niet afdwingbaar. Betrouwbare crawlers van grote bedrijven respecteren doorgaans robots.txt-richtlijnen, maar sommige crawlers negeren ze. Voor sterkere bescherming kun je blokkeren op serverniveau via .htaccess of firewallregels, en legitieme crawlers verifiëren aan de hand van gepubliceerde IP-adresbereiken.

Controleer en werk je blocklist minimaal elk kwartaal bij. Er verschijnen regelmatig nieuwe AI-crawlers, dus bekijk maandelijks je serverlogs om nieuwe crawlers te identificeren. Volg communitybronnen zoals het ai.robots.txt GitHub-project voor updates over nieuwe crawlers en user-agent strings.

Dit hangt af van je zakelijke prioriteiten. Door training crawlers te blokkeren bescherm je je content tegen opname in AI-modellen zonder compensatie. Het blokkeren van zoekcrawlers kan je zichtbaarheid op AI-platforms als ChatGPT search of Perplexity verkleinen. Veel uitgevers kiezen voor selectieve blokkering: training crawlers blokkeren en zoek- en citatiecrawlers toestaan.

Bekijk je serverlogs op crawler user-agent strings en controleer of geblokkeerde crawlers geen toegang hebben tot je contentpagina's. Gebruik analysetools om botverkeer te monitoren. Test je configuratie met Knowatoa AI Search Console of Merkle robots.txt Tester om te valideren dat je regels correct werken.

Agentic browser crawlers zoals ChatGPT Atlas en Google Project Mariner functioneren als volwaardige webbrowsers in plaats van eenvoudige HTTP-clients. Ze gebruiken vaak standaard Chrome user-agent strings, waardoor ze niet te onderscheiden zijn van normaal browserverkeer. IP-gebaseerde blokkering wordt noodzakelijk om deze geavanceerde crawlers te controleren.

AI-specifieke robots.txt regelt de toegang tot je content, terwijl tools zoals AmICited monitoren hoe AI-platforms jouw content aanhalen en citeren. Samen bieden ze volledig inzicht en controle: robots.txt beheert crawler-toegang en monitoringtools volgen de impact van je content op AI-systemen.

AmICited volgt hoe AI-systemen zoals ChatGPT, Claude, Perplexity en Google AI Overviews jouw merk noemen en citeren. Combineer robots.txt-configuratie met AI-zichtbaarheidsmonitoring om de impact van je content op AI-platforms te begrijpen.

Leer hoe je robots.txt configureert om AI-crawlerstoegang te beheren, inclusief GPTBot, ClaudeBot en Perplexity. Beheer de zichtbaarheid van je merk in AI-gegen...

Ontdek wat robots.txt is, hoe het zoekmachinecrawlers instrueert en best practices voor het beheren van crawlertoegang tot je website-inhoud en het beschermen v...

Communitydiscussie over het configureren van robots.txt voor AI-crawlers zoals GPTBot, ClaudeBot en PerplexityBot. Echte ervaringen van webmasters en SEO-specia...