Hoe optimaliseer ik supportcontent voor AI?

Leer essentiële strategieën om je supportcontent te optimaliseren voor AI-systemen zoals ChatGPT, Perplexity en Google AI Overzichten. Ontdek best practices voo...

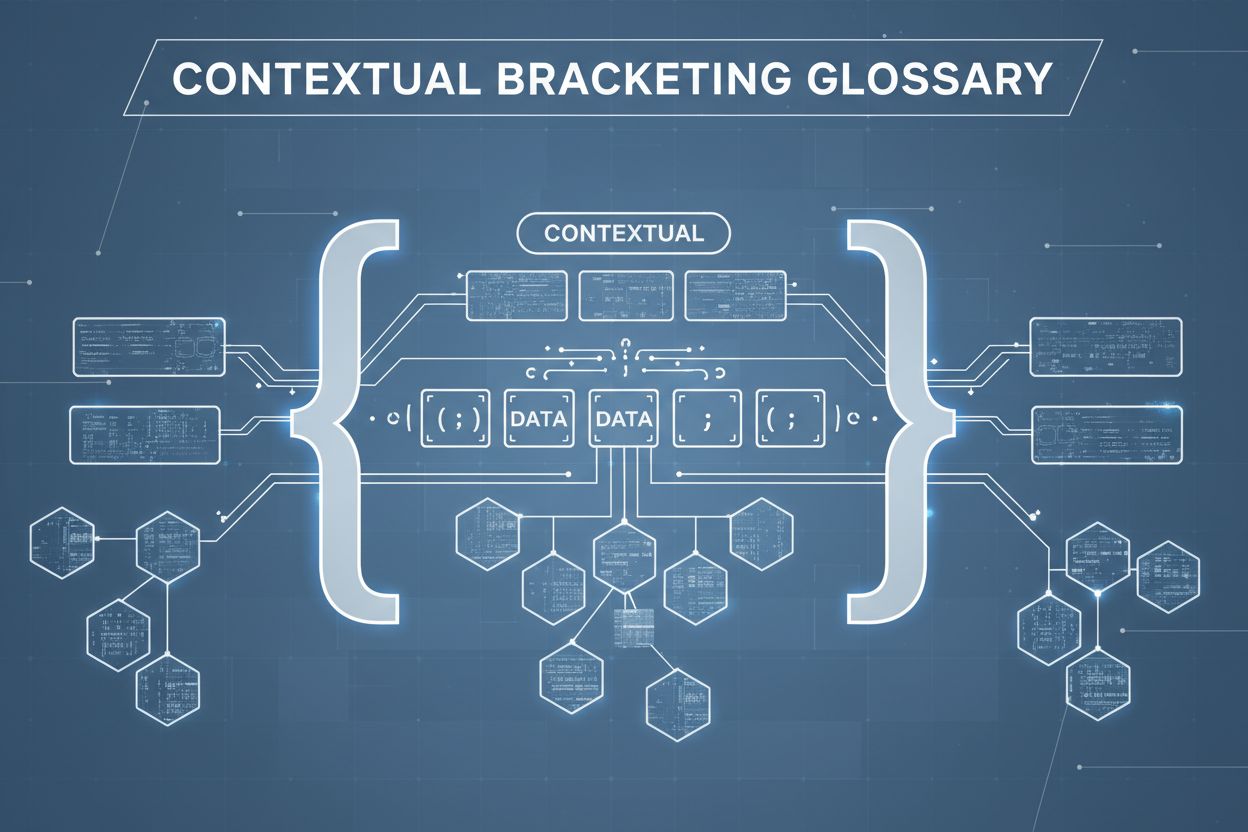

Contextuele bracketing is een contentoptimalisatietechniek die duidelijke grenzen rond informatie aanbrengt om AI-misinterpretatie en hallucinatie te voorkomen. Het gebruikt expliciete afbakeningen en contextmarkeringen om ervoor te zorgen dat AI-modellen precies begrijpen waar relevante informatie begint en eindigt, zodat het genereren van antwoorden op basis van aannames of verzonnen details wordt voorkomen.

Contextuele bracketing is een contentoptimalisatietechniek die duidelijke grenzen rond informatie aanbrengt om AI-misinterpretatie en hallucinatie te voorkomen. Het gebruikt expliciete afbakeningen en contextmarkeringen om ervoor te zorgen dat AI-modellen precies begrijpen waar relevante informatie begint en eindigt, zodat het genereren van antwoorden op basis van aannames of verzonnen details wordt voorkomen.

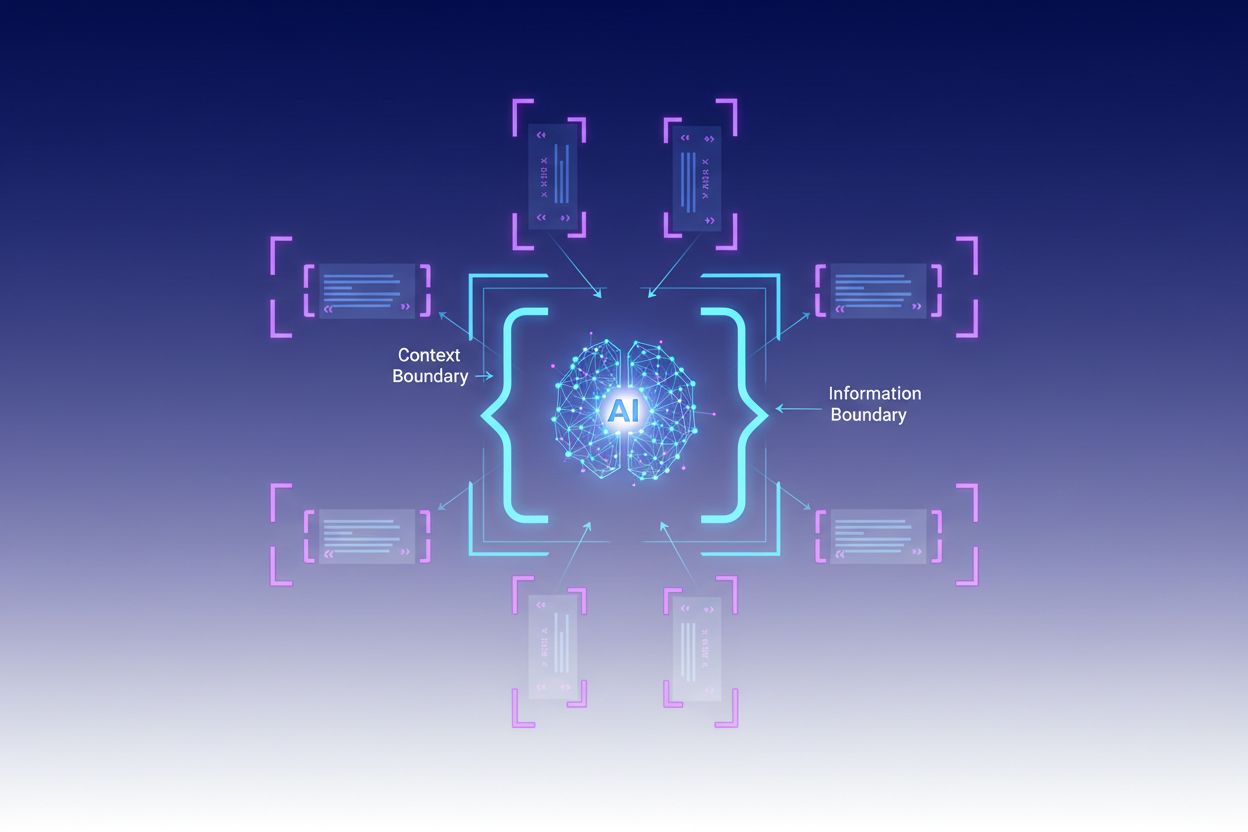

Contextuele bracketing is een contentoptimalisatietechniek die duidelijke grenzen rond informatie aanbrengt om AI-misinterpretatie en hallucinatie te voorkomen. Deze methode houdt in dat expliciete afbakeningen—zoals XML-tags, markdown-koppen of speciale tekens—worden gebruikt om het begin en einde van specifieke informatieblokken te markeren, waarmee experts een “contextgrens” creëren. Door prompts en data met deze duidelijke markeringen te structureren, zorgen ontwikkelaars ervoor dat AI-modellen precies begrijpen waar relevante informatie begint en eindigt, zodat het model geen antwoorden genereert op basis van aannames of verzonnen details. Contextuele bracketing vertegenwoordigt een evolutie van traditionele prompt engineering en breidt zich uit tot de bredere discipline van context engineering, die zich richt op het optimaliseren van alle informatie die aan een LLM wordt gegeven om gewenste resultaten te bereiken. De techniek is met name waardevol in productieomgevingen waar nauwkeurigheid en consistentie cruciaal zijn, omdat het wiskundige en structurele vangrails biedt die AI-gedrag sturen zonder complexe conditionele logica.

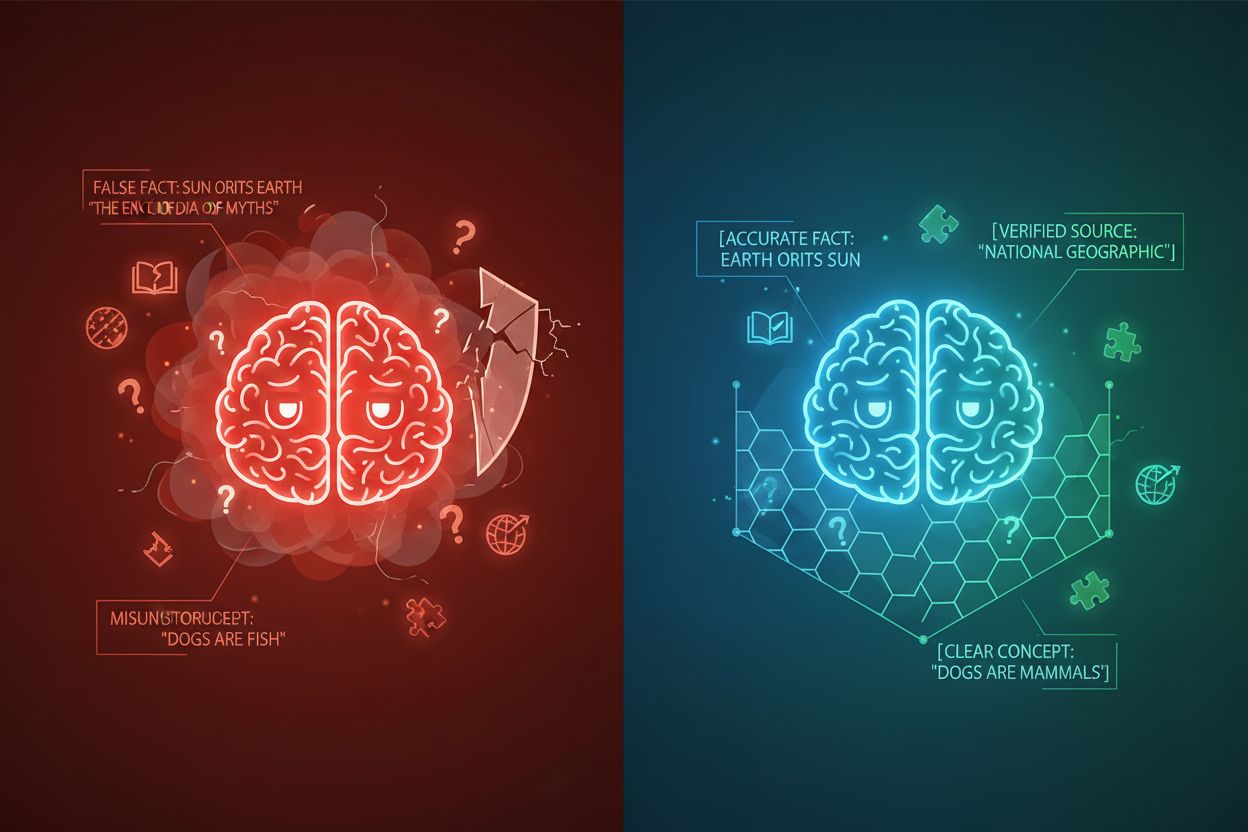

AI-hallucinatie treedt op wanneer taalmodellen antwoorden genereren die niet gebaseerd zijn op feitelijke informatie of de specifieke gegeven context, wat resulteert in foute feiten, misleidende uitspraken of verwijzingen naar niet-bestaande bronnen. Onderzoek toont aan dat chatbots ongeveer 27% van de tijd feiten verzinnen, met 46% van hun teksten die feitelijke fouten bevatten, terwijl ChatGPT’s journalistieke citaten 76% van de tijd onjuist waren. Deze hallucinaties ontstaan uit meerdere bronnen: modellen kunnen patronen leren uit bevooroordeelde of onvolledige trainingsdata, de relatie tussen tokens verkeerd begrijpen of onvoldoende beperkingen hebben die mogelijke outputs beperken. De gevolgen zijn ernstig in alle sectoren— in de gezondheidszorg kunnen hallucinaties leiden tot verkeerde diagnoses en onnodige medische ingrepen; in juridische contexten kunnen ze resulteren in verzonnen jurisprudentie (zoals te zien was in de zaak Mata v. Avianca, waar een advocaat werd gesanctioneerd voor het gebruik van ChatGPT’s nep-juridische citaten); in het bedrijfsleven verspillen ze middelen door gebrekkige analyses en prognoses. Het fundamentele probleem is dat zonder duidelijke contextgrenzen, AI-modellen opereren in een informatiewacuum waarin ze eerder geneigd zijn “de gaten op te vullen” met geloofwaardig klinkende maar onjuiste informatie, en hallucinatie als een feature in plaats van een bug behandelen.

| Type hallucinatie | Frequentie | Impact | Voorbeeld |

|---|---|---|---|

| Feitelijke onnauwkeurigheden | 27-46% | Verspreiding desinformatie | Valse producteigenschappen |

| Bronfabricage | 76% (citaten) | Verlies van geloofwaardigheid | Niet-bestaande bronvermeldingen |

| Verkeerd begrepen concepten | Variabel | Foute analyses | Verkeerde juridische precedenten |

| Bevooroordeelde patronen | Voortdurend | Discriminerende output | Stereotiepe antwoorden |

De effectiviteit van contextuele bracketing rust op vijf fundamentele principes:

Gebruik van afbakeningen: Hanteer consistente, ondubbelzinnige markeringen (XML-tags zoals <context>, markdown-koppen of speciale tekens) om informatieblokken duidelijk te scheiden en te voorkomen dat het model grenzen tussen verschillende databronnen of instructietypes verwart.

Beheer van de contextwindow: Wijs tokens strategisch toe aan systeeminstructies, gebruikersinputs en opgehaalde kennis, zodat de meest relevante informatie in het beperkte aandachtsbudget van het model komt, terwijl minder kritische details worden gefilterd of just-in-time opgehaald.

Informatiehiërarchie: Stel duidelijke prioriteitsniveaus vast voor verschillende typen informatie, zodat het model weet welke data als gezaghebbende bron moet worden beschouwd en wat slechts aanvullende context is, zodat primaire en secundaire informatie niet gelijk worden gewogen.

Grensdefinitie: Geef expliciet aan welke informatie het model moet meenemen en wat het moet negeren, en creëer harde stops die voorkomen dat het model verder extrapoleert dan de aangeboden data of aannames maakt over niet-gespecificeerde informatie.

Scope-markers: Gebruik structurele elementen om de reikwijdte van instructies, voorbeelden en data aan te geven, zodat duidelijk is of richtlijnen globaal, voor specifieke secties of enkel voor bepaalde type vragen gelden.

Het implementeren van contextuele bracketing vereist zorgvuldige aandacht voor de manier waarop informatie gestructureerd en gepresenteerd wordt aan AI-modellen. Gestructureerde inputformattering met JSON- of XML-schema’s biedt expliciete velddefinities die het gedrag van het model sturen— bijvoorbeeld door gebruikersvragen te omwikkelen met <user_query>-tags en verwachte uitkomsten met <expected_output>-tags, ontstaan ondubbelzinnige grenzen. Systeemprompts moeten worden georganiseerd in afzonderlijke secties met markdown-koppen of XML-tags: <background_information>, <instructions>, <tool_guidance> en <output_description> hebben elk een specifiek doel en helpen het model de hiërarchie van informatie te begrijpen. Few-shot voorbeelden moeten context tussen haakjes bevatten die exact tonen hoe het model zijn antwoorden moet structureren, met duidelijke afbakeningen rond input en output. Tooldefinities profiteren van expliciete parameterbeschrijvingen en gebruiksbeperkingen, zodat het model tools niet verkeerd gebruikt of buiten hun bedoelde scope toepast. Retrieval-Augmented Generation (RAG)-systemen kunnen contextuele bracketing implementeren door opgehaalde documenten in bronmarkeringen (<source>document_naam</source>) te zetten en grounding scores te gebruiken om te verifiëren dat gegenereerde antwoorden binnen de grenzen van opgehaalde informatie blijven. Zo werkt de contextgrensfunctie van CustomGPT door modellen uitsluitend te trainen op geüploade datasets, zodat antwoorden nooit buiten de kennisbasis komen—een praktische implementatie van contextuele bracketing op architectuurniveau.

Hoewel contextuele bracketing overeenkomsten vertoont met verwante technieken, neemt het een unieke positie in binnen AI-engineering. Basis prompt engineering richt zich vooral op het formuleren van effectieve instructies en voorbeelden, maar mist de systematische aanpak van contextuele bracketing voor het beheren van alle contextele elementen. Context engineering, de bredere discipline, omvat contextuele bracketing als één onderdeel—het bevat promptoptimalisatie, toolontwerp, geheugenbeheer en dynamische contextophaling, waardoor het een overkoepelend gebied is ten opzichte van het meer gefocuste contextuele bracketing. Eenvoudig instructievolgen vertrouwt op het vermogen van het model om natuurlijke taal te begrijpen zonder expliciete structurele grenzen, wat vaak faalt bij complexe instructies of wanneer het model ambiguïteit tegenkomt. Guardrails en validatiesystemen werken op het outputniveau en controleren antwoorden achteraf, terwijl contextuele bracketing op het inputniveau werkt om hallucinaties vooraf te voorkomen. Het belangrijkste verschil is dat contextuele bracketing preventief en structureel is—het vormt het informatielandschap waarin het model opereert—in plaats van corrigerend of reactief, waardoor het efficiënter en betrouwbaarder is voor het behouden van nauwkeurigheid in productieomgevingen.

Contextuele bracketing levert meetbare waarde op in uiteenlopende toepassingen. Klantenservicechatbots gebruiken contextgrenzen om antwoorden te beperken tot door het bedrijf goedgekeurde kennisbanken, zodat agenten geen producteigenschappen verzinnen of onbevoegde toezeggingen doen. Systemen voor juridische documentanalyse plaatsen relevante jurisprudentie, wetten en precedenten tussen grenzen, zodat AI alleen naar geverifieerde bronnen verwijst en geen juridische citaten verzint. Medische AI-systemen hanteren strikte contextgrenzen rond klinische richtlijnen, patiëntgegevens en goedgekeurde behandelingsprotocollen, om gevaarlijke hallucinaties die patiënten kunnen schaden te voorkomen. Contentgeneratieplatforms gebruiken contextuele bracketing om merkrichtlijnen, toonvereisten en feitelijke beperkingen af te dwingen, zodat gegenereerde content aansluit bij de organisatiestandaarden. Onderzoeks- en analysetools plaatsen primaire bronnen, datasets en geverifieerde informatie tussen haakjes, zodat AI inzichten kan synthetiseren met duidelijke bronvermelding en het verzinnen van valse statistieken of studies wordt voorkomen. AmICited.com geeft hier een voorbeeld van door te monitoren hoe AI-systemen merken citeren en vermelden in GPT’s, Perplexity en Google AI Overviews—het volgt of AI-modellen binnen passende contextgrenzen blijven bij het bespreken van specifieke bedrijven of producten, en helpt organisaties te begrijpen of AI-systemen over hun merk hallucineren of hun informatie juist weergeven.

Succesvolle implementatie van contextuele bracketing vereist het naleven van bewezen best practices:

Begin met minimale context: Start met de kleinste set informatie die nodig is voor accurate antwoorden, en breid alleen uit wanneer testen hiaten aantoont om contextvervuiling te voorkomen en de focus van het model te behouden.

Gebruik consistente afbakeningspatronen: Stel uniforme afbakeningsconventies vast en houd deze aan in het hele systeem, zodat het model grenzen makkelijker herkent en verwarring door inconsistente opmaak wordt verminderd.

Test en valideer grenzen: Test systematisch of het model de gedefinieerde grenzen respecteert door te proberen het uit te dagen om eroverheen te gaan, en los eventuele hiaten op vóór uitrol.

Monitor op contextdrift: Houd continu bij of de antwoorden van het model binnen de bedoelde grenzen blijven, aangezien het gedrag van het model kan veranderen door verschillende inputpatronen of als kennisbanken evolueren.

Implementeer feedbackloops: Zorg voor mechanismen waarmee gebruikers of menselijke reviewers kunnen aangeven wanneer het model zijn grenzen overschrijdt, en gebruik deze feedback om contextdefinities te verfijnen en toekomstige prestaties te verbeteren.

Versiebeheer van contextdefinities: Behandel contextgrenzen als code, houd een versiegeschiedenis en documentatie van wijzigingen bij en maak het mogelijk om terug te draaien als nieuwe grensdefinities slechtere resultaten opleveren.

Verschillende platforms hebben contextuele bracketing geïntegreerd in hun kernfunctionaliteit. CustomGPT.ai implementeert contextgrenzen via de “context boundary”-functie, die als een beschermende muur fungeert zodat de AI alleen door de gebruiker aangeleverde data gebruikt en nooit algemene kennis of verzonnen informatie toevoegt—deze aanpak is effectief gebleken voor organisaties als MIT die absolute nauwkeurigheid in kennislevering vereisen. Anthropic’s Claude benadrukt context engineering-principes en biedt gedetailleerde documentatie over het structureren van prompts, beheren van contextvensters en implementeren van guardrails die antwoorden binnen gedefinieerde grenzen houden. AWS Bedrock Guardrails biedt automatische redeneerc ontroles die gegenereerde content toetsen aan wiskundige, logische regels, met grounding scores die aangeven of antwoorden binnen het bronmateriaal blijven (scores boven 0,85 zijn vereist voor financiële toepassingen). Shelf.io biedt RAG-oplossingen met contextbeheer, zodat organisaties retrieval-augmented generation kunnen implementeren terwijl ze strikte grenzen handhaven rond welke informatie het model kan raadplegen en vermelden. AmICited.com vervult een aanvullende rol door te monitoren hoe AI-systemen uw merk citeren en vermelden op meerdere AI-platforms, zodat u begrijpt of AI-modellen passende contextgrenzen respecteren bij het bespreken van uw organisatie of bij het weergeven van accurate, geverifieerde informatie over uw merk—en biedt zo inzicht in of contextuele bracketing effectief werkt in de praktijk.

Prompt engineering richt zich voornamelijk op het opstellen van effectieve instructies en voorbeelden, terwijl contextuele bracketing een systematische aanpak is voor het beheren van alle contextele elementen via expliciete afbakeningen en grenzen. Contextuele bracketing is gestructureerder en preventiever, en werkt op het inputniveau om hallucinaties te voorkomen voordat ze optreden, terwijl prompt engineering breder is en verschillende optimalisatietechnieken omvat.

Contextuele bracketing voorkomt hallucinaties door duidelijke informatiegrenzen te stellen met behulp van afbakeningen zoals XML-tags of markdown-koppen. Dit vertelt het AI-model precies welke informatie het moet meenemen en wat het moet negeren, zodat het geen details verzint of aannames maakt over niet-gespecificeerde informatie. Door de aandacht van het model te beperken tot gedefinieerde grenzen, vermindert het de kans op het genereren van foute feiten of niet-bestaande bronnen.

Veelgebruikte afbakeningen zijn XML-tags (zoals

De principes van contextuele bracketing kunnen op de meeste moderne taalmodellen worden toegepast, hoewel de effectiviteit varieert. Modellen die beter getraind zijn in het opvolgen van instructies (zoals Claude, GPT-4 en Gemini) respecteren grenzen doorgaans betrouwbaarder. De techniek werkt het beste in combinatie met modellen die gestructureerde outputs ondersteunen en getraind zijn op diverse, goed geformatteerde data.

Begin met het organiseren van uw systeemprompts in afzonderlijke secties met duidelijke afbakeningen. Structureer input en output met JSON- of XML-schema's. Gebruik consistente afbakeningspatronen overal. Implementeer few-shot voorbeelden die het model precies laten zien hoe het grenzen moet respecteren. Test uitgebreid om te zorgen dat het model de gedefinieerde grenzen respecteert en monitor prestaties in de tijd om contextdrift te detecteren.

Contextuele bracketing kan het aantal tokens licht verhogen door extra afbakeningen en structurele markeringen, maar dit wordt meestal gecompenseerd door verbeterde nauwkeurigheid en minder hallucinaties. De techniek verhoogt de efficiëntie juist door te voorkomen dat het model tokens verspilt aan verzonnen informatie. In productiesystemen wegen de nauwkeurigheidswinst ruimschoots op tegen de minimale extra tokenbelasting.

Contextuele bracketing en RAG zijn complementaire technieken. RAG haalt relevante informatie op uit externe bronnen, terwijl contextuele bracketing ervoor zorgt dat het model binnen de grenzen van die opgehaalde informatie blijft. Samen creëren ze een krachtig systeem waarbij het model toegang heeft tot externe kennis, maar alleen verwijst naar geverifieerde, opgehaalde bronnen.

Verschillende platforms bieden ingebouwde ondersteuning: CustomGPT.ai heeft functies voor contextgrenzen, Anthropic's Claude biedt documentatie over context engineering en gestructureerde output, AWS Bedrock Guardrails bevat automatische redeneerc ontroles, en Shelf.io biedt RAG met contextbeheer. AmICited.com monitort hoe AI-systemen uw merk citeren, zodat u kunt controleren of contextuele bracketing effectief werkt.

Contextuele bracketing zorgt ervoor dat AI-systemen nauwkeurige informatie over uw merk bieden. Gebruik AmICited om te volgen hoe AI-modellen uw content citeren en vermelden in GPT's, Perplexity en Google AI Overviews.

Leer essentiële strategieën om je supportcontent te optimaliseren voor AI-systemen zoals ChatGPT, Perplexity en Google AI Overzichten. Ontdek best practices voo...

Leer hoe AI-vriendelijke opmaak met tabellen, lijsten en duidelijke secties de AI-parsing nauwkeurigheid verbetert en de zichtbaarheid van je content vergroot i...

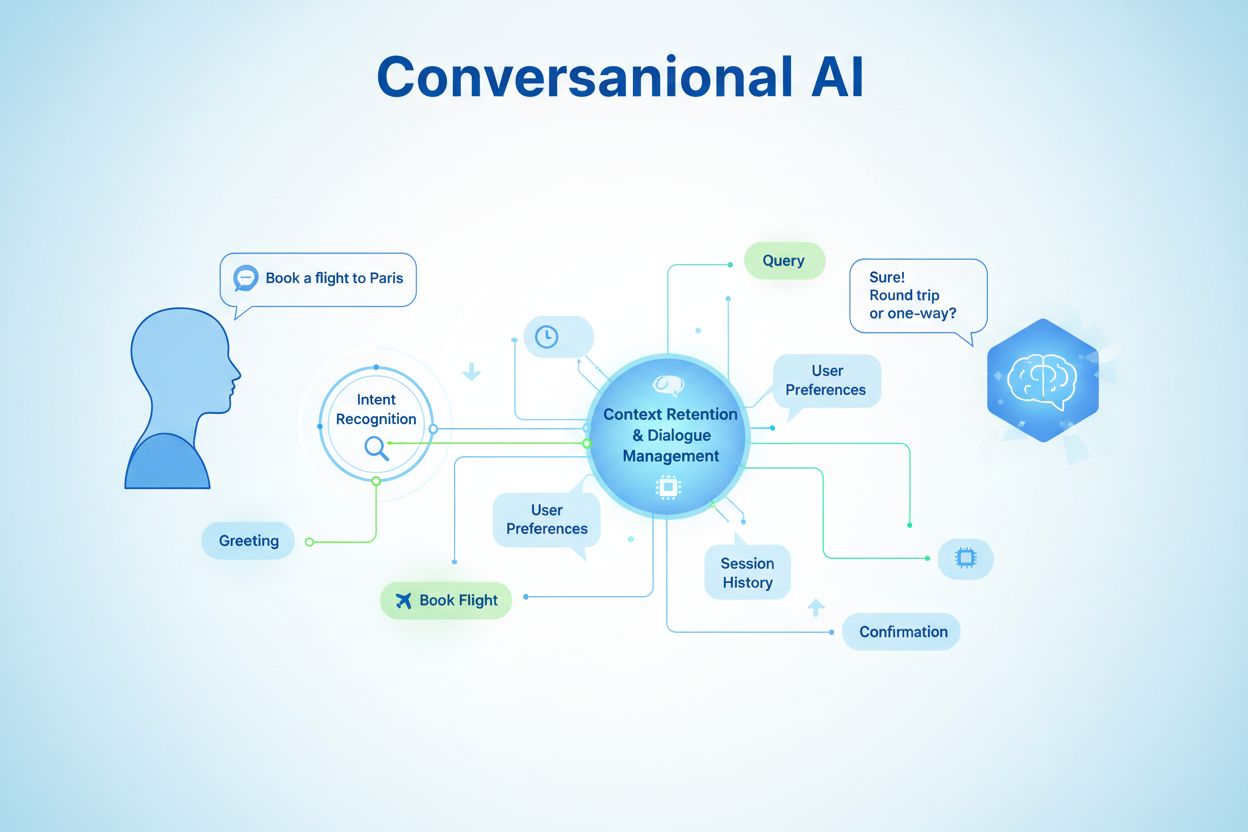

Ontdek hoe conversational content mapping de contentstructuur afstemt op natuurlijke meer-turns conversatiestromen in AI-interacties. Leer over kernelementen, i...