Maakt Zoekwoorddichtheid uit voor AI? Wat Moderne Zoekmachines Echt Waarderen

Ontdek waarom zoekwoorddichtheid niet langer belangrijk is voor AI-zoekopdrachten. Leer wat ChatGPT, Perplexity en Google AI Overviews daadwerkelijk belangrijk ...

Keyworddichtheid is het percentage keren dat een doelzoekwoord op een webpagina voorkomt ten opzichte van het totale aantal woorden. Hoewel het historisch belangrijk was in SEO, geven moderne zoekmachines prioriteit aan inhoudskwaliteit en relevantie boven strikte zoekwoordfrequentie. Experts raden een gebalanceerde dichtheid van 1-2% aan om straffen voor keyword stuffing te voorkomen.

Keyworddichtheid is het percentage keren dat een doelzoekwoord op een webpagina voorkomt ten opzichte van het totale aantal woorden. Hoewel het historisch belangrijk was in SEO, geven moderne zoekmachines prioriteit aan inhoudskwaliteit en relevantie boven strikte zoekwoordfrequentie. Experts raden een gebalanceerde dichtheid van 1-2% aan om straffen voor keyword stuffing te voorkomen.

Keyworddichtheid is het percentage keren dat een doelzoekwoord op een webpagina voorkomt ten opzichte van het totale aantal woorden op die pagina. Keyworddichtheid wordt berekend door het aantal zoekwoordvermeldingen te delen door het totaal aantal woorden en te vermenigvuldigen met 100. Keyworddichtheid fungeert als een basismaatstaf binnen zoekmachineoptimalisatie. Bijvoorbeeld: als een artikel van 1.500 woorden een bepaald zoekwoord 20 keer noemt, is de keyworddichtheid 1,3%. Hoewel het historisch werd beschouwd als een belangrijke rankingfactor, zijn moderne zoekalgoritmen aanzienlijk geëvolueerd en geldt keyworddichtheid nu als een van de vele signalen die zoekmachines helpen de relevantie van inhoud te begrijpen, in plaats van als directe rankingfactor. Inzicht in deze maatstaf blijft belangrijk voor contentmakers en SEO-professionals, omdat het helpt de balans te bewaren tussen natuurlijke taal en strategische zoekwoordplaatsing, waardoor content zowel gebruiksvriendelijk als vindbaar blijft voor zoekmachines.

In de begindagen van zoekmachineoptimalisatie, grofweg tussen 1995 en 2010, werd keyworddichtheid beschouwd als een primaire rankingfactor. Zoekalgoritmen waren relatief eenvoudig en vertrouwden sterk op zoekwoordfrequentie om te bepalen of een webpagina relevant was voor een bepaalde zoekopdracht. In deze periode streefden SEO-specialisten bewust naar specifieke keyworddichtheidpercentages, vaak 5-7% of hoger, in de overtuiging dat meer zoekwoordvermeldingen tot betere rankings zouden leiden. Dit leidde tot het wijdverspreide gebruik van keyword stuffing—het volproppen van webpagina’s met zoveel mogelijk zoekwoorden, vaak in verborgen tekst, footers of onnatuurlijke zinsconstructies. Hotelsites bijvoorbeeld, plaatsten lange keyword-rijke footers met honderden keren “goedkope hotels in [plaatsnaam]”, om zo de beperkingen van zoekmachines uit te buiten en te scoren op talloze locatievarianten. Naarmate zoekalgoritmen geavanceerder werden, vooral na Google’s Panda-update in 2011, werd deze aanpak niet alleen ineffectief maar zelfs schadelijk. Google’s algoritmen evolueerden om keyword stuffing te detecteren en te bestraffen, waarbij ze het als manipulatief beschouwden en een slechte gebruikerservaring boden. Tegenwoordig is keyworddichtheid nog steeds relevant als monitoringsmaatstaf, maar het is verschoven van primaire optimalisatiedoelstelling naar een van de vele factoren die bijdragen aan algemene inhoudskwaliteit en relevantiesignalen.

De berekening van keyworddichtheid is eenvoudig en kan handmatig of met geautomatiseerde SEO-tools worden uitgevoerd. De basisformule is: (Aantal zoekwoordvermeldingen ÷ Totaal aantal woorden) × 100 = Keyworddichtheid in procent. Ter illustratie: als je een artikel van 2.000 woorden schrijft en je doelzoekwoord “duurzame mode” 25 keer noemt, is de berekening (25 ÷ 2.000) × 100 = 1,25% keyworddichtheid. Een geavanceerdere methode om zoekwoordrelevantie te meten is TF-IDF (Term Frequency-Inverse Document Frequency), die het belang van een specifieke frase berekent ten opzichte van een collectie documenten. TF-IDF kijkt niet alleen naar hoe vaak een zoekwoord in je content voorkomt, maar ook hoe uniek dat zoekwoord is op het bredere internet, waardoor het een genuanceerder beeld van het belang van een zoekwoord geeft. Google’s John Mueller heeft echter afgeraden om te veel te focussen op TF-IDF, omdat moderne zoekmachines veel geavanceerdere methoden gebruiken om relevantie te bepalen. De meeste SEO-professionals gebruiken nu tools als Semrush, Ahrefs of Yoast SEO om automatisch keyworddichtheid te berekenen, omdat deze platformen realtime analyses en vergelijkingen met concurrenten bieden, waardoor handmatig rekenen grotendeels overbodig is voor professioneel SEO-werk.

Onderzoek en expertadviezen over de optimale keyworddichtheid lopen uiteen, maar de meeste SEO-professionals komen uit op een veilige marge van 1-2%. Deze aanbeveling is ontstaan uit jarenlang testen en analyseren, waaruit blijkt dat pagina’s met een keyworddichtheid in dit bereik goed scoren zonder spamfilters te activeren of te over-geoptimaliseerd over te komen. Recente gegevens uit Rankability’s onderzoek van 2025, waarbij 1.536 Google-zoekresultaten werden geanalyseerd over 32 zeer concurrerende zoekwoorden, onthullen echter verrassende bevindingen: de gemiddelde keyworddichtheid voor de top 10 Google-resultaten is slechts 0,04%, terwijl pagina’s op posities 11-20 gemiddeld 0,07% halen, en posities 21-30 op 0,08% zitten. Deze data suggereren dat een lagere keyworddichtheid juist kenmerkend is voor goed presterende pagina’s, waarschijnlijk omdat goed geschreven, uitgebreide content zoekwoorden op natuurlijke wijze en met lagere frequentie bevat. Het onderzoek wijst uit dat pagina’s met een gematigd zoekwoordgebruik hoger scoren dan pagina’s met agressieve targeting, wat de verschuiving naar kwaliteit-gedreven SEO ondersteunt. Bovendien heeft 78% van de pagina’s in de top 10 een 50% lagere keyworddichtheid dan pagina’s die twee jaar geleden scoorden, volgens gegevens van BrightEdge, wat een duidelijke trend laat zien van keywordgerichte optimalisatie naar focus op contentkwaliteit en gebruikerservaring. Deze bevindingen suggereren dat contentmakers zich beter kunnen richten op natuurlijk schrijven voor hun doelgroep, met strategische plaatsing van zoekwoorden in titels, koppen en de introductie, in plaats van op een specifiek keyworddichtheidspercentage te mikken.

| Maatstaf | Definitie | Belangniveau | Optimale Bereik | Primaire Focus |

|---|---|---|---|---|

| Keyworddichtheid | Percentage keren dat een zoekwoord voorkomt t.o.v. totaal aantal woorden | Medium (ondersteunend signaal) | 1-2% of 0,04% (gebaseerd op topposities) | Zoekwoordfrequentie en natuurlijke integratie |

| Keywordprominentie | Positie en plaatsing van zoekwoorden op kritieke plekken (titel, H1, eerste 100 woorden) | Hoog (directe rankingfactor) | Zoekwoorden in titel, H1 en openingsalinea | Strategische plaatsing voor relevantiesignalen |

| Semantische relevantie | Gebruik van verwante termen, synoniemen en contextuele frases | Zeer hoog (primaire factor) | Volledige dekking van het onderwerp met LSI-zoekwoorden | Diepte van het onderwerp en contextbegrip |

| Zoekintentie-alignment | Hoe goed de inhoud aansluit bij de onderliggende zoekintentie van de gebruiker | Zeer hoog (primaire factor) | 100% match met informatieve, commerciële of transactionele intentie | Gebruikerstevredenheid en engagementmetrieken |

| Contentkwaliteitscore | Algemene leesbaarheid, volledigheid en waarde voor de gebruiker | Zeer hoog (primaire factor) | Hoge E-E-A-T-signalen met expertcitaten | Gebruikerservaring en inhoudsautoriteit |

| TF-IDF-score | Statistische maat voor het belang van een zoekwoord t.o.v. documentcollectie | Laag-middel (aanvullend) | Varieert per branche en concurrentie | Zoekwoorduniekheid en relevantieweging |

| Keyword stuffing | Overmatig, onnatuurlijk zoekenwoordgebruik voor rankingmanipulatie | Negatief (penaliseringsrisico) | 0% (volledig vermijden) | Spambestrijding en schade aan gebruikerservaring |

Moderne zoekmachines zoals Google gebruiken geavanceerde natural language processing (NLP) en machine learning-algoritmen om inhoud te begrijpen, veel verder dan simpelweg zoekwoorden tellen. Wanneer een zoekmachinecrawler een webpagina tegenkomt, telt hij niet alleen het aantal zoekwoorden, maar analyseert ook de semantische context, woordrelaties en onderwerpen van het gehele document. Keyworddichtheid is een van de honderden signalen die deze algoritmen overwegen. Zoekmachines kijken naar waar zoekwoorden verschijnen—of dat nu in de title-tag, H1-kop, metabeschrijving of bodytekst is—en wegen deze plaatsingen verschillend. Zoekwoorden in titels en koppen wegen zwaarder dan die diep in paragrafen, waardoor strategische plaatsing belangrijker is dan ruwe frequentie. Daarnaast analyseren zoekmachines variaties en synoniemen, waarbij ze begrijpen dat “digitale marketing”, “online marketing” en “internetmarketing” semantisch verwant zijn en allemaal bijdragen aan relevantie. Het algoritme kijkt ook naar engagementsignalen zoals doorklikratio, tijd op pagina en bouncepercentage, die aangeven of de content daadwerkelijk voldoet aan de zoekintentie. Dit betekent dat een pagina met een lagere keyworddichtheid maar hogere gebruiksbetrokkenheid beter kan scoren dan een keyword-rijke pagina met slechte gebruikerservaring. Bovendien bevatten Google’s systemen nu E-E-A-T-signalen (Expertise, Authoritativeness, Trustworthiness en Experience), waardoor inhoud van erkende experts of autoritatieve bronnen hoger scoort, ongeacht keyworddichtheid. Deze ontwikkeling verklaart waarom keyworddichtheid minder kritisch is geworden—zoekmachines zijn van keyword-matching verschoven naar semantisch begrip en gebruikerstevredenheid als belangrijkste rankingfactoren.

Vanuit zakelijk perspectief draagt inzicht in en optimalisatie van keyworddichtheid bij aan een bredere SEO-strategie die organisch verkeer, leads en omzet stimuleert. Volgens onderzoek uit 2025 levert SEO $22 op voor elke $1 die wordt uitgegeven, waardoor het het marketingkanaal met de hoogste ROI is, en organisch zoeken is goed voor 57,8% van al het internetverkeer wereldwijd. Een juiste keyworddichtheid zorgt ervoor dat je content vindbaar is voor zoekmachines én leesbaar en waardevol blijft voor gebruikers. Als de keyworddichtheid te laag is, kunnen zoekmachines moeite hebben het hoofdonderwerp van je pagina te begrijpen, waardoor je rankingkansen mist. Is de keyworddichtheid te hoog, dan verslechtert de leesbaarheid, stijgt het bouncepercentage en kun je door zoekmachines worden bestraft wegens keyword stuffing. De praktische impact is groot: pagina’s met 100+ backlinks ontvangen 3,2x meer verkeer dan pagina’s met minder links, maar dit voordeel komt alleen tot uiting als de pagina in eerste instantie goed scoort, waarvoor juiste zoekwoordoptimalisatie vereist is. Voor contentmakers en marketingteams is de zakelijke conclusie duidelijk—investeer in het maken van uitgebreide, kwalitatief hoogwaardige content die zoekwoorden op natuurlijke wijze verwerkt op een dichtheid van 1-2%, in plaats van te focussen op exacte percentages. Deze aanpak vermindert het risico op straffen, verbetert de gebruikerservaring en zorgt voor content die goed presteert in zowel traditionele zoekresultaten als opkomende AI-zoekplatforms. Bovendien gaf 91% van de marketeers aan dat SEO de websiteprestaties in 2024 verbeterde, en wie keywordoptimalisatie combineerde met kwaliteitsinhoud rapporteerde de hoogste tevredenheid.

Nu AI-zoekmachines en grote taalmodellen (LLM’s) zoals ChatGPT, Perplexity en Google AI Overviews steeds belangrijker worden voor merkzichtbaarheid, krijgt keyworddichtheid een nieuwe rol in het kader van AI-citatie en contentextractie. Deze AI-systemen analyseren content om samenvattingen en citaties te genereren en vertrouwen op duidelijke, goed gestructureerde zoekwoordgebruik om thematische relevantie te begrijpen en gezaghebbende informatie te extraheren. Wanneer je content de juiste keyworddichtheid heeft, met strategische plaatsing in titels, koppen en openingsalinea’s, herkennen AI-systemen je pagina gemakkelijker als relevante bron voor specifieke onderwerpen. Deze herkenning vergroot de kans dat je content wordt geciteerd in AI-gegenereerde antwoorden, wat merkzichtbaarheid oplevert in een nieuw zoekklimaat. AI-systemen zijn echter nog geavanceerder dan traditionele zoekmachines in het herkennen van keyword stuffing en onnatuurlijke patronen. Ze geven de voorkeur aan semantisch begrip en inhoudskwaliteit, wat betekent dat keyworddichtheid alleen geen garantie biedt op AI-citaties—de content moet daadwerkelijk waarde en expertise bieden. Onderzoek toont aan dat informatieve zoekopdrachten het vaakst AI Overviews activeren, en deze AI-samenvattingen kunnen het traditionele organische doorklikpercentage met 20-40% verminderen. Deze verschuiving betekent dat merken niet alleen moeten optimaliseren voor traditionele zoekresultaten, maar ook voor AI-extractie, wat een gebalanceerde keyworddichtheid vereist in combinatie met uitgebreide thematische dekking. Voor platforms als AmICited, die merkvermeldingen monitoren binnen AI-systemen, is inzicht in de invloed van keyworddichtheid op AI-zichtbaarheid essentieel. Content met optimale keyworddichtheid en sterke semantische relevantie wordt vaker geciteerd door AI-systemen, waardoor je merk beter zichtbaar wordt in AI-zoekresultaten en waardevolle attributiemogelijkheden ontstaan.

Effectieve keyworddichtheid-optimalisatie vereist een strategische, gebruikergerichte aanpak die zoekmachine-eisen in balans brengt met de ervaring van de lezer. De volgende best practices helpen bij moderne zoekwoordoptimalisatie:

Schrijf in de eerste plaats natuurlijk voor je doelgroep: Focus op waardevolle, leesbare content die inspeelt op de behoeften van de gebruiker. Zoekwoorden moeten natuurlijk in de zinnen passen en niet geforceerd of herhaald aanvoelen. Als je voor gebruikers schrijft, valt de keyworddichtheid meestal vanzelf binnen de optimale marge van 1-2%.

Plaats zoekwoorden strategisch op belangrijke plekken: Zet je hoofdzoekwoord in de title-tag, H1-kop, metabeschrijving en binnen de eerste 100 woorden van je content. Deze plaatsen geven effectiever relevantiesignalen aan zoekmachines dan alleen zoekwoordfrequentie.

Gebruik zoekwoordvariaties en semantische synoniemen: Herhaal niet steeds hetzelfde zoekwoord, maar gebruik verwante termen en long-tail varianten. Dit verbetert de dekking van het onderwerp, helpt je te scoren op zoekwoordclusters en zorgt voor natuurlijke leesbaarheid.

Voer uitgebreid zoekwoordenonderzoek uit: Bepaal primaire, secundaire en semantisch verwante zoekwoorden voordat je begint met schrijven. Tools zoals Semrush’s Keyword Magic Tool en Google’s Keyword Planner helpen je inzicht te krijgen in zoekvolume, concurrentie en intentie.

Monitor en controleer keyworddichtheid regelmatig: Gebruik SEO-tools om de keyworddichtheid van je content te controleren. Identificeer pagina’s die onder- of overgeoptimaliseerd zijn en stuur bij op basis van prestatiegegevens.

Geef prioriteit aan inhoudskwaliteit en volledigheid: Maak diepgaande content die de zoekintentie volledig beantwoordt. Uitgebreide content bevat vanzelf meer zoekwoordvariaties en semantiek, wat zowel de ranking als AI-extractie verbetert.

Test en meet resultaten: Test verschillende keyworddichtheden en meet het effect op ranking, verkeer en conversies. Gebruik Google Analytics en Google Search Console om prestaties te volgen en op basis van data je aanpak te verfijnen.

De toekomst van keyworddichtheid in SEO evolueert verder naarmate zoektechnologie en nieuwe platforms zich ontwikkelen. Enkele belangrijke trends bepalen hoe keyworddichtheid de komende jaren zal worden begrepen en toegepast. Ten eerste verschuift de opkomst van generative engine optimization (GEO) en AI-zoekplatforms de focus van traditionele keyworddichtheid naar semantische relevantie en thematische autoriteit. Naarmate AI-systemen taal en context beter begrijpen, neemt het belang van exacte zoekwoordfrequentie verder af. Ten tweede verandert optimalisatie voor voice search het zoekwoordgebruik, omdat spraakopdrachten langer, meer conversatiegericht en minder keyword-gedreven zijn dan tekstzoekopdrachten. Dit wijst erop dat toekomstige contentoptimalisatie natuurlijke taal en vraaggestuurde zoekwoorden zal benadrukken boven traditionele keyworddichtheidsdoelstellingen. Ten derde zorgt de integratie van entity-based search ervoor dat zoekmachines steeds beter relaties tussen concepten begrijpen in plaats van alleen zoekwoordovereenkomsten. Dit impliceert dat toekomstige SEO-strategieën zich zullen richten op het vestigen van thematische autoriteit en entiteitrelaties, in plaats van op specifieke keyworddichtheden. Ten vierde verminderen zero-click searches en AI Overviews het belang van alleen rankingpositie, waardoor merken moeten optimaliseren voor AI-citatie en extractie, niet enkel voor zoekplaatsing. Deze evolutie betekent dat keyworddichtheid steeds minder draait om het behalen van een specifiek percentage, maar meer om duidelijke, semantische relevantie die AI-systemen makkelijk kunnen begrijpen en citeren. Tot slot worden E-E-A-T-signalen steeds belangrijker, waardoor content van erkende experts en autoriteiten goed scoort, ongeacht keyworddichtheid. Het beeld is duidelijk: keyworddichtheid blijft een nuttige monitoringsmaatstaf, maar de relevantie ervan neemt verder af ten opzichte van contentkwaliteit, semantische relevantie, gebruikerservaring en thematische autoriteit.

Keyworddichtheid blijft een relevant begrip binnen SEO, maar de rol ervan is fundamenteel verschoven van primaire rankingfactor naar een ondersteunend signaal dat helpt content goed te optimaliseren voor zoekzichtbaarheid. De evolutie van keywordgerichte optimalisatie naar kwaliteit- en gebruikersgerichte SEO weerspiegelt bredere veranderingen in hoe zoekmachines en AI-systemen content begrijpen en ranken. Moderne SEO-professionals moeten keyworddichtheid zien als een balans om te bewaken, niet als een doel op zich—streef naar natuurlijke integratie van zoekwoorden op ongeveer 1-2% dichtheid, terwijl je prioriteit geeft aan contentkwaliteit, semantische relevantie en gebruikerservaring. De data tonen aan dat toppagina’s lagere keyworddichtheid hebben dan lager scorende pagina’s, wat suggereert dat kwaliteit en relevantie zwaarder wegen dan frequentie. Voor merken die hun aanwezigheid op AI-platforms als ChatGPT, Perplexity en Google AI Overviews monitoren, wordt inzicht in de rol van keyworddichtheid in contentextractie steeds belangrijker. Content met de juiste keyworddichtheid, strategische plaatsing en volledige dekking van het onderwerp wordt vaker geciteerd door AI-systemen, wat waardevolle merkzichtbaarheid oplevert in het nieuwe AI-zoeklandschap. Door een gebalanceerde aanpak te hanteren—die zowel rekening houdt met zoekmachine-eisen als gebruikerservaring—kunnen contentmakers duurzame, goed presterende content bouwen die scoort in traditionele zoekresultaten, verschijnt in AI-citaties en daadwerkelijk tegemoetkomt aan de behoeften van hun publiek.

De meeste SEO-experts raden aan om een keyworddichtheid tussen 1-2% te behouden voor optimale resultaten. Dit bereik signaleert relevantie aan zoekmachines zonder straffen voor keyword stuffing te activeren. Onderzoek van Rankability, waarbij 1.536 Google-zoekresultaten werden geanalyseerd, toont echter aan dat pagina's die hoog scoren gemiddeld slechts 0,04% keyworddichtheid hebben, wat suggereert dat een lagere dichtheid gecombineerd met hoogwaardige content beter presteert dan strikt vasthouden aan percentage-doelstellingen.

Om keyworddichtheid te berekenen, deel je het aantal keren dat je doelzoekwoord voorkomt door het totale aantal woorden op de pagina en vermenigvuldig je dit met 100 om een percentage te krijgen. Bijvoorbeeld: als een artikel van 1.500 woorden je zoekwoord 20 keer noemt, is de berekening: (20 ÷ 1.500) × 100 = 1,3% keyworddichtheid. Deze formule helpt je te monitoren of je content een natuurlijke keyword-integratie behoudt zonder over-optimalisatie.

Keyworddichtheid is niet langer een primaire rankingfactor voor Google. Volgens John Mueller van Google en de officiële richtlijnen richten zoekmachines zich op inhoudskwaliteit, gebruikersintentie en relevantie in plaats van op zoekwoordfrequentie. Hoewel het natuurlijk noemen van je doelzoekwoord zoekmachines helpt het onderwerp van je pagina te begrijpen, biedt overmatige herhaling geen rankingvoordeel en kan het leiden tot straffen voor keyword stuffing.

Keyworddichtheid verwijst naar het natuurlijke, strategische gebruik van zoekwoorden op een optimaal percentage (1-2%), terwijl keyword stuffing de overmatige, geforceerde herhaling van zoekwoorden is om rankings te manipuleren. Keyword stuffing is in strijd met de spamrichtlijnen van Google en kan resulteren in handmatige straffen of verwijdering uit de index. Het belangrijkste verschil is intentie: keyworddichtheid ondersteunt gebruikerservaring en relevantie, terwijl keyword stuffing zoekmachinemanipulatie boven lezerswaarde plaatst.

Keyworddichtheid beïnvloedt hoe AI-systemen zoals ChatGPT, Perplexity en Google AI Overviews je content begrijpen en citeren. Duidelijke, natuurlijk geïntegreerde zoekwoorden helpen AI-modellen de thematische relevantie van je pagina te herkennen en deze te extraheren voor citaties. AI-systemen geven echter prioriteit aan semantisch begrip en inhoudskwaliteit boven het ruwe aantal zoekwoorden, waardoor uitgebreide, goed gestructureerde content eerder wordt geciteerd dan keyword-rijke pagina's.

Populaire SEO-tools zoals Semrush, Ahrefs, Yoast SEO en de On-Page SEO Checker van WebFX bieden keyworddichtheid-analyse. Deze tools berekenen automatisch de zoekwoordfrequentie, vergelijken je dichtheid met die van concurrenten en signaleren problemen met over-optimalisatie. Veel van deze tools geven ook aanbevelingen voor zoekwoordplaatsing op kritieke plekken zoals title-tags, H1-koppen en metabeschrijvingen om zowel zoekzichtbaarheid als gebruikerservaring te verbeteren.

Ja, het gebruik van zoekwoordvariaties en semantische synoniemen is een effectieve strategie om thematische relevantie te verbeteren zonder de ruwe keyworddichtheid te verhogen. In plaats van het exacte zoekwoord te herhalen, gebruik je verwante termen zoals 'betaalbare hotels' in plaats van 'goedkope hotels', of 'digitale marketing' in plaats van 'online marketing.' Deze aanpak helpt je te scoren op bredere zoekwoordclusters en zorgt voor natuurlijke, leesbare content die zowel zoekmachines als menselijke lezers aanspreekt.

Met de opkomst van AI-zoekmachines en antwoordmachines is keyworddichtheid minder belangrijk geworden dan semantische relevantie en thematische autoriteit. AI-systemen zoals Google AI Overviews en ChatGPT geven prioriteit aan uitgebreide, contextueel rijke content boven zoekwoordfrequentie. Deze verschuiving betekent dat moderne SEO-strategieën zich moeten richten op diepgaande behandeling van onderwerpen, natuurlijk taalgebruik en het vestigen van thematische autoriteit in plaats van op specifieke keyworddichtheid-percentages.

Begin met het volgen van hoe AI-chatbots uw merk vermelden op ChatGPT, Perplexity en andere platforms. Krijg bruikbare inzichten om uw AI-aanwezigheid te verbeteren.

Ontdek waarom zoekwoorddichtheid niet langer belangrijk is voor AI-zoekopdrachten. Leer wat ChatGPT, Perplexity en Google AI Overviews daadwerkelijk belangrijk ...

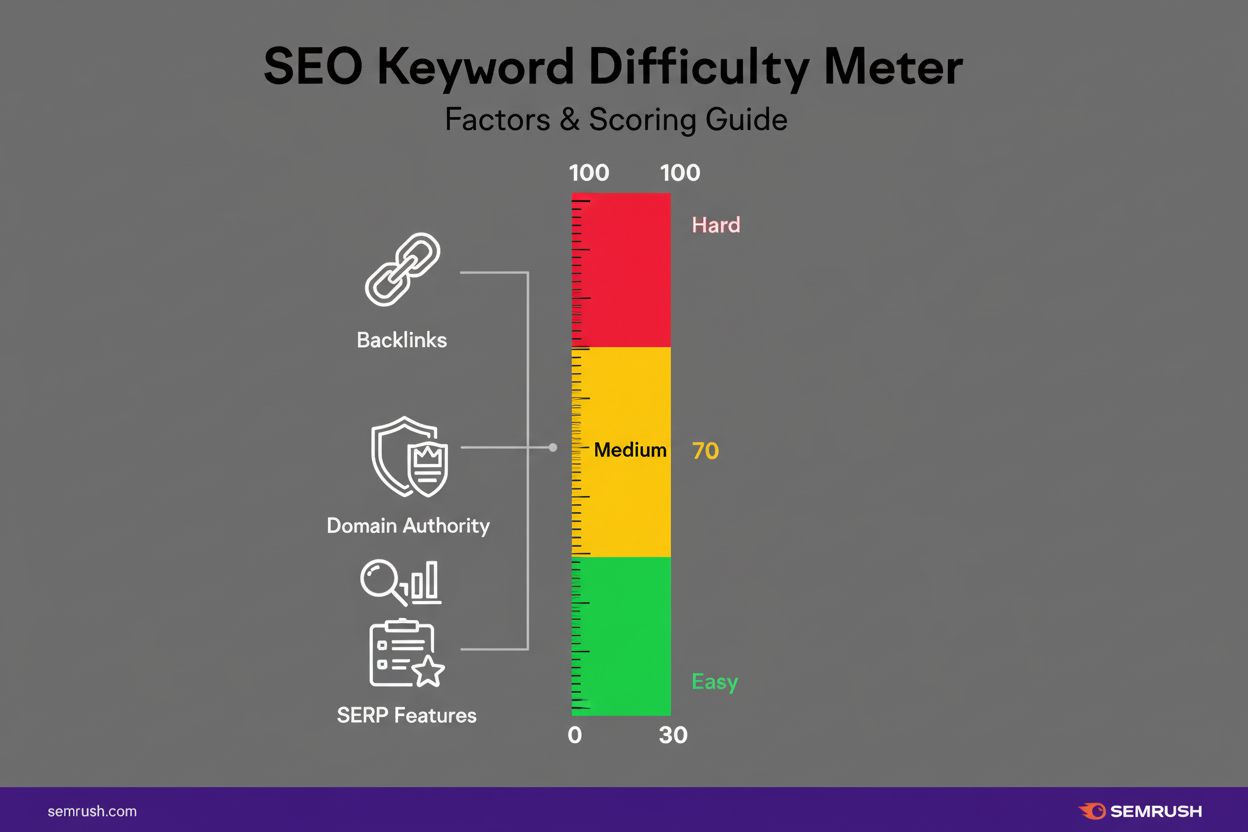

Leer wat keyword difficulty is, hoe het wordt berekend en waarom het belangrijk is voor SEO-strategieën. Begrijp concurrentiemetingen voor rankings en hoe je KD...

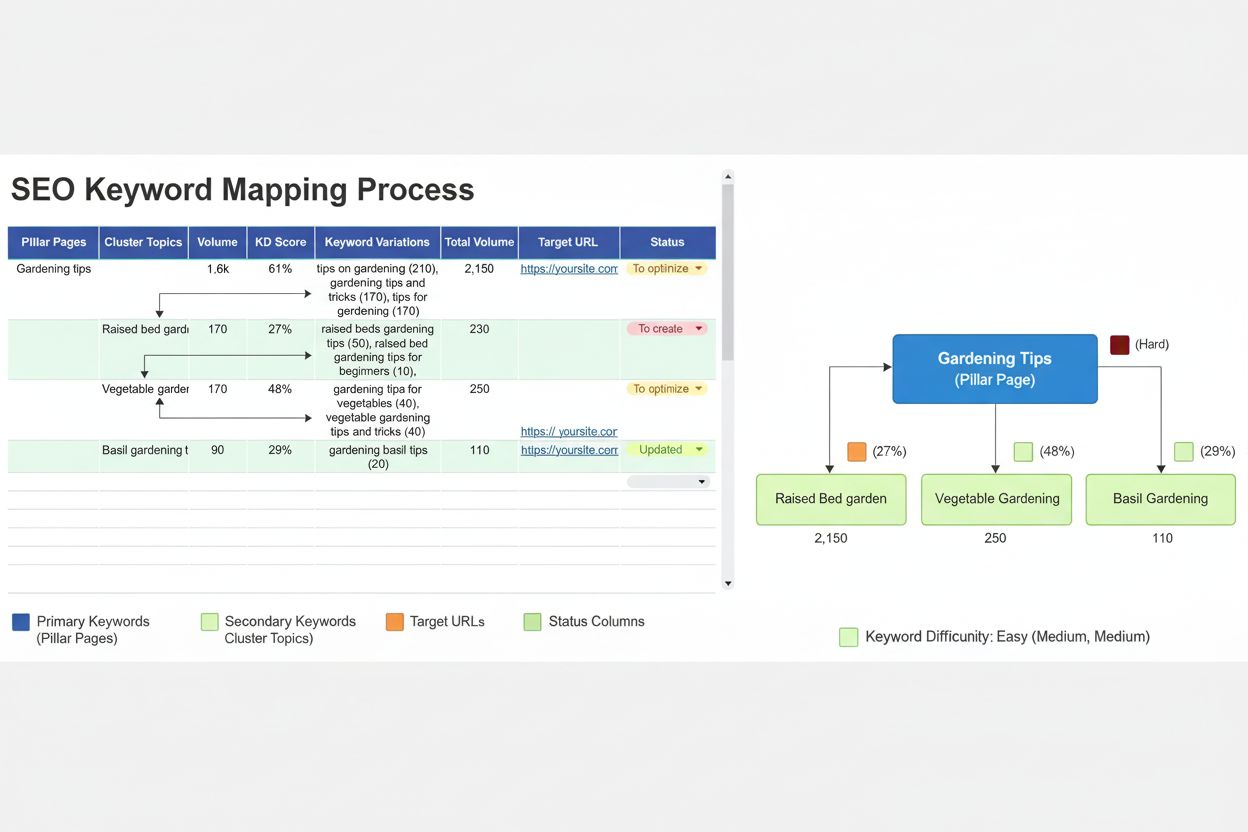

Leer keyword mapping: het proces van het toewijzen van doelzoekwoorden aan webpagina's. Ontdek hoe je kannibalisatie voorkomt, de sitestructuur optimaliseert en...