Wat is Google MUM en hoe beïnvloedt het de zichtbaarheid in AI-zoekopdrachten?

Discussie in de community waarin Google MUM en de impact ervan op AI-zoekopdrachten wordt uitgelegd. Experts delen hoe dit multimodale AI-model contentoptimalis...

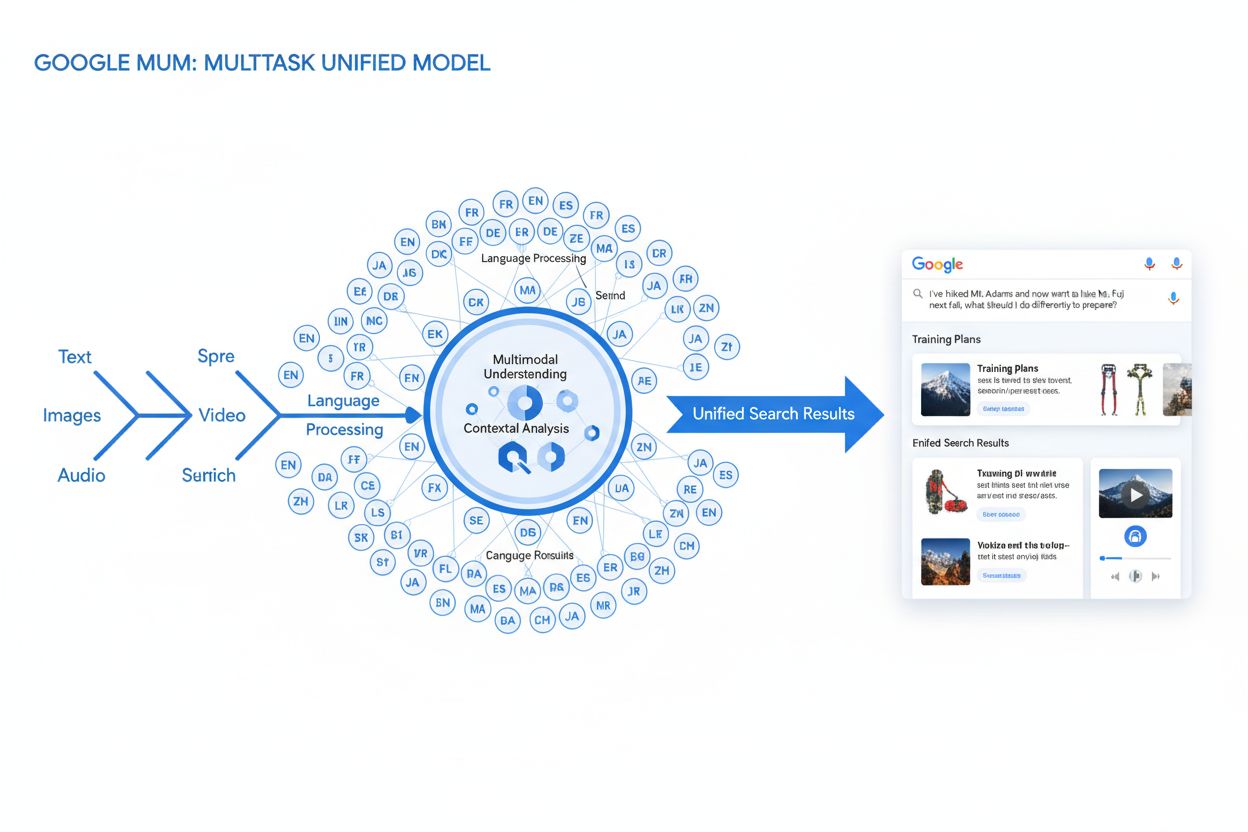

MUM (Multitask Unified Model) is het geavanceerde multimodale AI-model van Google dat tekst, afbeeldingen, video en audio gelijktijdig verwerkt in meer dan 75 talen om meer uitgebreide, contextuele zoekresultaten te leveren. Gelanceerd in 2021 is MUM 1.000 keer krachtiger dan BERT en vertegenwoordigt het een fundamentele verschuiving in hoe zoekmachines complexe gebruikersvragen begrijpen en beantwoorden.

MUM (Multitask Unified Model) is het geavanceerde multimodale AI-model van Google dat tekst, afbeeldingen, video en audio gelijktijdig verwerkt in meer dan 75 talen om meer uitgebreide, contextuele zoekresultaten te leveren. Gelanceerd in 2021 is MUM 1.000 keer krachtiger dan BERT en vertegenwoordigt het een fundamentele verschuiving in hoe zoekmachines complexe gebruikersvragen begrijpen en beantwoorden.

MUM (Multitask Unified Model) is het geavanceerde multimodale kunstmatige intelligentiemodel van Google dat is ontworpen om te revolutioneren hoe zoekmachines complexe gebruikersvragen begrijpen en beantwoorden. Aangekondigd in mei 2021 door Pandu Nayak, Google Fellow en Vice President of Search, vertegenwoordigt MUM een fundamentele verschuiving in informatieretrieventechnologie. Gebouwd op het T5 text-to-text framework en bestaande uit ongeveer 110 miljard parameters, is MUM 1.000 keer krachtiger dan BERT, het vorige baanbrekende model voor natuurlijke taalverwerking van Google. In tegenstelling tot traditionele zoekalgoritmen die tekst geïsoleerd verwerken, verwerkt MUM gelijktijdig tekst, afbeeldingen, video en audio, terwijl het informatie begrijpt in meer dan 75 talen native. Deze multimodale en meertalige mogelijkheden stellen MUM in staat complexe vragen te doorgronden die voorheen meerdere zoekopdrachten vereisten, waardoor zoeken verandert van een eenvoudige zoekwoord-matchoefening in een intelligent, contextbewust informatieretrievensysteem. MUM begrijpt niet alleen taal, maar genereert deze ook, waardoor het informatie uit diverse bronnen en formaten kan synthetiseren om uitgebreide, genuanceerde antwoorden te bieden die volledig aansluiten bij de gebruikersintentie.

Google’s ontwikkeling richting MUM is het resultaat van jarenlange, stapsgewijze innovatie in natuurlijke taalverwerking en machine learning. De evolutie begon met Hummingbird (2013), dat semantisch begrip introduceerde om de betekenis achter zoekopdrachten te interpreteren in plaats van enkel zoekwoorden te matchen. Daarna volgde RankBrain (2015), dat machine learning gebruikte om long-tail zoekwoorden en nieuwe zoekpatronen te begrijpen. Neural Matching (2018) bracht dit verder door neurale netwerken te gebruiken om zoekopdrachten en relevante content op een dieper semantisch niveau te matchen. BERT (Bidirectional Encoder Representations from Transformers), gelanceerd in 2019, markeerde een belangrijke mijlpaal door context binnen zinnen en alinea’s te begrijpen, waardoor Google’s vermogen om genuanceerde taal te interpreteren werd verbeterd. Toch kende BERT aanzienlijke beperkingen—het verwerkte alleen tekst, had beperkte meertalige ondersteuning en kon de complexiteit van vragen die synthese over meerdere formaten vereisten, niet aan. Volgens onderzoek van Google voeren gebruikers gemiddeld acht afzonderlijke zoekopdrachten uit om complexe vragen te beantwoorden, zoals het vergelijken van twee wandelbestemmingen of het beoordelen van productopties. Dit cijfer wees op een kritisch tekort in zoektechnologie dat MUM specifiek moest oplossen. De Helpful Content Update (2022) en het E-E-A-T framework (2023) verfijnden vervolgens hoe Google gezaghebbende, betrouwbare content prioriteert. MUM bouwt voort op al deze innovaties en introduceert mogelijkheden die eerdere beperkingen overstijgen, wat niet slechts een stapsgewijze verbetering is, maar een paradigmaverschuiving in hoe zoekmachines informatie verwerken en leveren.

MUM’s technische basis is het Transformer-architectuur, specifiek het T5 (Text-to-Text Transfer Transformer) framework dat Google eerder ontwikkelde. Het T5-framework behandelt alle natuurlijke taalverwerkingstaken als text-to-text problemen, waarbij invoer en uitvoer worden omgezet in uniforme tekstrepresentaties. MUM breidt deze aanpak uit door multimodale verwerkingsmogelijkheden te integreren, zodat het tekst, afbeeldingen, video en audio gelijktijdig binnen één uniform model kan verwerken. Deze architecturale keuze is belangrijk omdat MUM hierdoor relaties en context tussen verschillende mediavormen kan begrijpen op manieren die eerdere modellen niet konden. Bijvoorbeeld: bij het verwerken van een vraag over wandelen op Mt. Fuji gecombineerd met een afbeelding van specifieke wandelschoenen, analyseert MUM de tekst en afbeelding niet apart—het verwerkt ze samen en begrijpt hoe de eigenschappen van de schoen samenhangen met de context van de vraag. Het model beschikt over 110 miljard parameters waarmee het enorme hoeveelheden kennis over taal, visuele concepten en hun onderlinge relaties kan opslaan en verwerken. MUM is getraind in 75 verschillende talen en vele verschillende taken tegelijkertijd, waardoor het een meer omvattend begrip ontwikkelt van informatie en wereldkennis dan modellen die getraind zijn op één taal of taak. Deze multitask-leeraanpak betekent dat MUM patronen en relaties herkent die overdraagbaar zijn tussen talen en domeinen, waardoor het robuuster en generaliseerbaarder is dan eerdere modellen. De gelijktijdige verwerking van meerdere talen tijdens training stelt MUM in staat tot kennisoverdracht tussen talen, wat inhoudt dat het informatie in de ene taal kan begrijpen en toepassen op zoekopdrachten in een andere taal, waardoor taalbarrières die voorheen zoekresultaten beperkten, worden opgeheven.

| Kenmerk | MUM (2021) | BERT (2019) | RankBrain (2015) | T5 Framework |

|---|---|---|---|---|

| Primaire functie | Multimodale vraagverwerking en antwoordsynthese | Contextueel tekstbegrip | Interpretatie van long-tail zoekwoorden | Text-to-text transfer learning |

| Invoermodaliteiten | Tekst, afbeeldingen, video, audio | Alleen tekst | Alleen tekst | Alleen tekst |

| Taalondersteuning | Meer dan 75 talen native | Beperkte meertalige ondersteuning | Voornamelijk Engels | Voornamelijk Engels |

| Modelparameters | ~110 miljard | ~340 miljoen | Niet bekendgemaakt | ~220 miljoen |

| Krachtvergelijking | 1.000x krachtiger dan BERT | Baseline | Voorloper van BERT | Basis voor MUM |

| Mogelijkheden | Begrip + generatie | Alleen begrip | Patroonherkenning | Teksttransformatie |

| SERP-impact | Verrijkte multiformat resultaten | Betere snippets en context | Verbeterde relevantie | Fundamentele technologie |

| Verwerking complexiteit zoekopdracht | Complexe meerstapsvragen | Context van enkele zoekopdracht | Long-tail variaties | Texttransformatietaken |

| Kennisoverdracht | Taal- en modaliteitsoverstijgend | Alleen binnen dezelfde taal | Beperkte overdracht | Taakoverstijgende overdracht |

| Toepassing in de praktijk | Google Search, AI Overviews | Google Search ranking | Google Search ranking | Technische basis van MUM |

De verwerking van zoekopdrachten door MUM omvat meerdere geavanceerde stappen die samenwerken om uitgebreide, contextuele antwoorden te leveren. Wanneer een gebruiker een zoekopdracht indient, start MUM met taalonafhankelijke pre-processing, waarbij de zoekopdracht in elk van de meer dan 75 ondersteunde talen wordt begrepen zonder vertaling. Dit native taalbegrip behoudt taalkundige nuances en regionale context die anders verloren zouden gaan. Vervolgens gebruikt MUM sequence-to-sequence matching, waarbij de gehele zoekopdracht als een betekenisvolle reeks wordt geanalyseerd in plaats van afzonderlijke zoekwoorden. Zo begrijpt MUM relaties tussen concepten—bijvoorbeeld dat een zoekopdracht over “voorbereiden op Mt. Fuji na het beklimmen van Mt. Adams” draait om vergelijking, voorbereiding en contextuele aanpassing. Tegelijkertijd voert MUM multimodale inputanalyse uit door afbeeldingen, video’s of andere media in de zoekopdracht te verwerken. Het model voert vervolgens simultane verwerking van de zoekopdracht uit, waarbij het meerdere mogelijke gebruikersintenties parallel evalueert in plaats van zich te beperken tot één interpretatie. Dit betekent dat MUM kan herkennen dat een zoekopdracht over wandelen op Mt. Fuji verband houdt met fysieke voorbereiding, materiaalkeuze, culturele ervaringen of reisinformatie—en relevante informatie voor al deze interpretaties toont. Vector-gebaseerd semantisch begrip zet de zoekopdracht en geïndexeerde content om in hoog-dimensionale vectoren die semantische betekenis representeren, waardoor retrieval op basis van conceptuele gelijkenis mogelijk is in plaats van zoekwoordmatching. MUM past vervolgens contentfiltering via kennisoverdracht toe, waarbij met machine learning op zoeklogs, surfdata en gebruikersgedrag patronen worden gebruikt om hoogwaardige, gezaghebbende bronnen te prioriteren. Tot slot genereert MUM een multimedia verrijkte SERP-compositie, waarin tekstsnippets, afbeeldingen, video’s, gerelateerde vragen en interactieve elementen worden gecombineerd tot één visueel gelaagde zoekervaring. Dit proces vindt plaats in milliseconden, waardoor MUM resultaten levert die niet alleen de expliciete zoekopdracht beantwoorden, maar ook voorziet in verwachte vervolgvragen en gerelateerde informatiebehoeften.

MUM’s multimodale mogelijkheden zijn een fundamentele breuk met tekst-only zoeksystemen. Het model kan gelijktijdig informatie uit tekst, afbeeldingen, video en audio verwerken en begrijpen, waarbij het betekenis uit elke modaliteit haalt en deze samenvoegt tot samenhangende antwoorden. Dit is vooral krachtig voor zoekopdrachten die baat hebben bij visuele context. Bijvoorbeeld: als een gebruiker vraagt “Kan ik deze wandelschoenen gebruiken voor Mt. Fuji?” en een afbeelding van de schoenen toont, begrijpt MUM de eigenschappen van de schoen uit de afbeelding—materiaal, profiel, hoogte, kleur—en koppelt dat visuele begrip aan kennis over het terrein, klimaat en de wandelvereisten van Mt. Fuji om een contextueel antwoord te geven. De meertalige dimensie van MUM is minstens zo baanbrekend. Met native ondersteuning voor meer dan 75 talen kan MUM kennisoverdracht tussen talen uitvoeren, wat betekent dat het leert van bronnen in de ene taal en die kennis toepast op zoekopdrachten in een andere taal. Dit doorbreekt een belangrijke barrière die eerder zoekresultaten beperkte tot content in de moedertaal van de gebruiker. Als uitgebreide informatie over Mt. Fuji vooral in Japanse bronnen beschikbaar is—zoals lokale wandelgidsen, seizoensgebonden weerpatronen en culturele inzichten—kan MUM deze Japanstalige content begrijpen en relevante informatie tonen aan Engelstalige gebruikers. Volgens Google was MUM in staat om 800 variaties van COVID-19 vaccins in meer dan 50 talen binnen enkele seconden op te sommen, wat de schaal en snelheid van zijn meertalige verwerkingsmogelijkheden toont. Dit meertalige begrip is waardevol voor gebruikers in niet-Engelssprekende markten en voor vragen over onderwerpen met rijke informatie in meerdere talen. Door multimodale en meertalige verwerking kan MUM de meest relevante informatie tonen, ongeacht het formaat of de oorspronkelijke publicatietaal, wat zorgt voor een werkelijk wereldwijde zoekervaring.

MUM transformeert fundamenteel hoe zoekresultaten worden weergegeven en beleefd door gebruikers. In plaats van de traditionele lijst met blauwe links die decennialang het zoeken domineerde, creëert MUM verrijkte, interactieve SERP’s waarin meerdere contentformaten op één pagina samenkomen. Gebruikers zien tekstsnippets, hoge-resolutie afbeeldingen, videocarrousels, gerelateerde vragen en interactieve elementen zonder de zoekpagina te verlaten. Deze verandering heeft grote gevolgen voor de interactie met zoeken. In plaats van meerdere zoekopdrachten te doen om informatie over een complex onderwerp te verzamelen, kunnen gebruikers direct binnen de SERP verschillende invalshoeken en subonderwerpen verkennen. Bijvoorbeeld: een zoekopdracht over “voorbereiden op Mt. Fuji in de herfst” kan hoogtevergelijkingen, weersvoorspellingen, uitrustingsadviezen, videogidsen en gebruikersrecensies tonen—alles contextueel georganiseerd op één pagina. Google Lens-integratie aangedreven door MUM maakt zoeken met afbeeldingen in plaats van zoekwoorden mogelijk, waardoor visuele elementen in foto’s interactieve ontdekkingshulpmiddelen worden. “Things to Know”-panelen splitsen complexe zoekopdrachten op in behapbare subonderwerpen, zodat gebruikers door verschillende aspecten van een onderwerp worden geleid met relevante snippets voor elk. Inzoom-bare, hoge-resolutie afbeeldingen verschijnen direct in zoekresultaten, waardoor visuele vergelijking mogelijk is en de eerste beslisfase wordt versneld. De “Verfijn en Vergroot”-functionaliteit suggereert verwante concepten zodat gebruikers dieper in specifieke aspecten kunnen duiken of naastgelegen onderwerpen kunnen verkennen. Deze veranderingen maken van zoeken een interactieve, verkennende ervaring die anticipeert op gebruikersbehoeften en uitgebreide informatie biedt binnen de zoekinterface zelf. Onderzoek toont aan dat deze rijkere SERP-ervaring het gemiddelde aantal zoekopdrachten om complexe vragen te beantwoorden verlaagt, maar ook dat gebruikers vaker informatie direct in zoekresultaten consumeren in plaats van door te klikken naar websites.

Voor organisaties die hun aanwezigheid in AI-systemen monitoren, vertegenwoordigt MUM een cruciale evolutie in hoe informatie wordt ontdekt en getoond. Naarmate MUM steeds meer wordt geïntegreerd in Google Search en andere AI-systemen beïnvloedt, is het essentieel te begrijpen hoe merken en domeinen verschijnen in door MUM aangedreven resultaten om zichtbaarheid te behouden. MUM’s multimodale verwerking betekent dat merken moeten optimaliseren voor meerdere contentformaten, niet alleen tekst. Een merk dat eerder vertrouwde op ranking voor specifieke zoekwoorden, moet nu zorgen dat content vindbaar is via afbeeldingen, video’s en gestructureerde data. Het vermogen van het model om informatie uit verschillende bronnen te synthetiseren betekent dat de zichtbaarheid van een merk niet alleen afhangt van de eigen website, maar van hoe informatie over het merk op het bredere web wordt gepresenteerd. MUM’s meertalige mogelijkheden bieden nieuwe kansen en uitdagingen voor wereldwijde merken. Content in één taal kan nu worden ontdekt door gebruikers die in andere talen zoeken, wat het potentiële bereik vergroot. Maar dit betekent ook dat merken moeten zorgen dat hun informatie accuraat en consistent is over talen heen, omdat MUM mogelijk informatie uit meerdere talen voor één zoekopdracht toont. Voor AI-monitoringplatforms zoals AmICited is het volgen van de impact van MUM cruciaal, omdat het laat zien hoe moderne AI-systemen informatie ophalen en presenteren. Wie monitort waar een merk verschijnt in AI-antwoorden—zoals Google AI Overviews, Perplexity, ChatGPT of Claude—begrijpt dankzij kennis van MUM’s technologie waarom bepaalde content wordt getoond en hoe optimalisatie voor zichtbaarheid werkt. De verschuiving naar multimodaal, meertalig zoeken vraagt om uitgebreide monitoring van de aanwezigheid in verschillende contentformaten en talen, niet alleen traditionele zoekwoordposities. Organisaties die MUM’s mogelijkheden begrijpen, kunnen hun contentstrategie beter optimaliseren voor zichtbaarheid in dit nieuwe zoeklandschap.

Hoewel MUM een belangrijke vooruitgang betekent, brengt het ook nieuwe uitdagingen en beperkingen met zich mee waar organisaties rekening mee moeten houden. Lagere doorklikpercentages zijn een grote zorg voor uitgevers en contentmakers, omdat gebruikers nu uitgebreide informatie direct in zoekresultaten kunnen consumeren zonder door te klikken naar websites. Dit betekent dat traditionele trafficstatistieken minder betrouwbare indicatoren worden voor het succes van content. Hogere technische SEO-eisen betekenen dat content goed gestructureerd moet zijn met de juiste schema markup, semantische HTML en heldere entiteitsrelaties om goed door MUM begrepen te worden. Content zonder deze technische basis wordt mogelijk niet goed geïndexeerd of verwerkt door MUM’s multimodale algoritme. SERP-verzadiging maakt zichtbaarheid lastiger, omdat meer contentformaten om aandacht concurreren op één pagina. Zelfs sterke content krijgt mogelijk minder of geen klikken als gebruikers voldoende informatie vinden binnen de SERP zelf. Risico op misleidende resultaten bestaat als MUM informatie toont uit bronnen die elkaar tegenspreken of als context verloren gaat bij het synthetiseren. Afhankelijkheid van gestructureerde data betekent dat ongestructureerde of slecht opgemaakte content mogelijk niet goed wordt begrepen of getoond door MUM. Uitdagingen rond taal- en cultuurnuance kunnen optreden bij kennisoverdracht tussen talen, waardoor culturele context of regionale variaties in betekenis mogelijk verloren gaan. Computational resource-eisen voor het opschalen van MUM zijn aanzienlijk, al heeft Google geïnvesteerd in efficiëntieverbeteringen om de ecologische voetafdruk te verminderen. Bias- en fairnesszorgen vereisen voortdurende aandacht om te waarborgen dat MUM geen vooroordelen uit trainingsdata overneemt of bepaalde perspectieven of gemeenschappen benadeelt.

De opkomst van MUM vraagt om fundamentele aanpassingen in SEO- en contentstrategie. Traditionele keywordgerichte optimalisatie wordt minder effectief nu MUM intentie en context begrijpt, ook zonder exacte zoekwoordovereenkomsten. Onderwerpgerichte contentstrategie wordt belangrijker dan zoekwoordstrategie: organisaties moeten uitgebreide contentclusters maken die onderwerpen vanuit meerdere invalshoeken behandelen. Multimedia contentcreatie is niet langer optioneel—organisaties moeten investeren in kwalitatieve afbeeldingen, video’s en interactieve content die tekst aanvullen. Implementatie van gestructureerde data wordt cruciaal, omdat schema markup MUM helpt de structuur en relaties in content te begrijpen. Entiteitopbouw en semantische optimalisatie dragen bij aan het opbouwen van thematische autoriteit en verbeteren hoe MUM contentrelaties begrijpt. Meertalige contentstrategie wint aan belang, omdat MUM’s taaloverdracht betekent dat content in meerdere taalmarkten gevonden kan worden. Gebruikersintentie-mapping wordt geavanceerder, waarbij organisaties niet alleen primaire intentie, maar ook gerelateerde vragen en subonderwerpen moeten identificeren die gebruikers mogelijk verkennen. Actualiteit en nauwkeurigheid van content worden belangrijker, omdat MUM informatie uit meerdere bronnen synthetiseert—verouderde of onjuiste content kan worden gedeprioriteerd. Cross-platform optimalisatie reikt verder dan Google Search en omvat ook hoe content verschijnt in AI-systemen zoals Google AI Overviews, Perplexity, en andere AI-aangedreven zoekinterfaces. E-E-A-T-signalen (Experience, Expertise, Authoritativeness, Trustworthiness) worden steeds belangrijker, aangezien MUM content van gezaghebbende bronnen prioriteert. Organisaties die hun strategieën aanpassen aan MUM’s mogelijkheden—met focus op uitgebreide, multimodale, goed gestructureerde content die expertise en autoriteit uitstraalt—blijven zichtbaar in dit veranderende zoeklandschap.

MUM is geen eindpunt, maar een tussenstation in de evolutie van AI-aangedreven zoeken. Google heeft aangegeven dat MUM zijn mogelijkheden zal blijven uitbreiden, met steeds geavanceerdere video- en audioprocessing. Het bedrijf doet actief onderzoek naar het verkleinen van de rekenkracht die MUM vereist zonder in te leveren op prestaties, om duurzaamheidskwesties rond grootschalige AI-modellen aan te pakken. De integratie van MUM met andere Google-technologieën wijst op toekomstige ontwikkelingen waarbij MUM niet alleen search, maar ook Google Assistant, Google Lens en andere producten aanstuurt. Concurrentiedruk van andere AI-systemen zoals OpenAI’s ChatGPT, Anthropic’s Claude en Perplexity’s AI-zoekmachine betekent dat MUM zich zal blijven ontwikkelen om Google’s voorsprong te behouden. Regulatoire aandacht rond AI-systemen kan de ontwikkeling van MUM beïnvloeden, vooral op het gebied van bias, eerlijkheid en transparantie. Aanpassing van gebruikersgedrag zal MUM’s evolutie mede vormgeven—naarmate gebruikers gewend raken aan rijkere, interactievere zoekervaringen, stijgen de verwachtingen voor zoekkwaliteit en volledigheid. De opkomst van generatieve AI betekent dat MUM’s vermogen om informatie te synthetiseren en genereren prominenter zal worden, mogelijk zelfs in staat om originele content te creëren in plaats van alleen bestaande content te verzamelen en ordenen. Multimodale AI als standaard suggereert dat MUM’s aanpak van gelijktijdige verwerking van meerdere formaten de norm zal worden voor AI-systemen. Privacy- en datavraagstukken zullen bepalen hoe MUM gebruikersdata en gedragsignalen gebruikt voor personalisatie en verbetering van resultaten. Organisaties kunnen zich het beste voorbereiden op voortdurende evolutie door flexibele, aanpasbare contentstrategieën te bouwen die kwaliteit, volledigheid en technische excellentie prioriteren in plaats van specifieke tactieken die snel kunnen verouderen. Het fundamentele principe—content creëren die daadwerkelijk voorziet in gebruikersintentie over meerdere formaten en talen—blijft relevant, ongeacht hoe MUM’s specifieke mogelijkheden zich ontwikkelen.

Waar BERT (2019) zich richtte op het begrijpen van natuurlijke taal binnen tekstgebaseerde zoekopdrachten, betekent MUM een aanzienlijke evolutie. MUM is gebouwd op het T5 text-to-text framework en is 1.000 keer krachtiger dan BERT. In tegenstelling tot BERT's tekst-only verwerking, is MUM multimodaal—het verwerkt tekst, afbeeldingen, video en audio gelijktijdig. Daarnaast ondersteunt MUM meer dan 75 talen native, terwijl BERT bij lancering beperkte meertalige ondersteuning had. MUM kan zowel taal begrijpen als genereren, waardoor het complexe, meerstapsvragen aankan die BERT niet effectief kon oplossen.

Multimodaal verwijst naar MUM's vermogen om informatie uit meerdere soorten invoerformaten gelijktijdig te verwerken en te begrijpen. In plaats van tekst apart van afbeeldingen of video te analyseren, verwerkt MUM al deze formaten samen op een uniforme manier. Dit betekent dat wanneer je zoekt naar iets als 'wandelschoenen voor Mt. Fuji', MUM je tekstuele vraag begrijpt, afbeeldingen van schoenen analyseert, videorecensies bekijkt en audiobeschrijvingen extraheert—allemaal tegelijkertijd. Deze geïntegreerde aanpak stelt MUM in staat om rijkere, meer contextuele antwoorden te geven die informatie uit al deze verschillende mediavormen meenemen.

MUM is getraind in meer dan 75 talen, wat een grote vooruitgang is op het gebied van wereldwijde zoektoegankelijkheid. Deze meertalige capaciteit betekent dat MUM kennis kan overdragen tussen talen—als nuttige informatie over een onderwerp in het Japans beschikbaar is, kan MUM dit begrijpen en relevante resultaten tonen aan Engelstalige gebruikers. Dit doorbreekt taalbarrières die eerder zoekresultaten beperkten tot de moedertaal van de gebruiker. Voor merken en contentmakers betekent dit dat hun content zichtbaar kan zijn in meerdere taalmarkten, en dat gebruikers wereldwijd toegang hebben tot informatie, ongeacht de oorspronkelijke publicatietaal.

T5 (Text-to-Text Transfer Transformer) is het eerdere transformer-gebaseerde model van Google waarop MUM is gebouwd. Het T5 framework behandelt alle NLP-taken als text-to-text problemen, wat inhoudt dat het invoer en uitvoer omzet naar tekstformaat voor uniforme verwerking. MUM breidt de mogelijkheden van T5 uit door multimodale verwerking (afbeeldingen, video en audio) te integreren en het op te schalen naar ongeveer 110 miljard parameters. Deze basis stelt MUM in staat taal zowel te begrijpen als te genereren, met behoud van de efficiëntie en flexibiliteit die T5 succesvol maakten.

MUM verandert fundamenteel hoe content wordt ontdekt en weergegeven in zoekresultaten. In plaats van traditionele lijsten met blauwe links, creëert MUM verrijkte SERP's met meerdere contentformaten—afbeeldingen, video's, tekstfragmenten en interactieve elementen—samen op één pagina. Dit betekent dat merken moeten optimaliseren voor meerdere formaten, niet alleen tekst. Content waarvoor gebruikers eerder meerdere pagina's moesten doorlopen, kan nu direct in de zoekresultaten worden getoond. Dit betekent echter ook een lager doorklikpercentage voor sommige content, omdat gebruikers informatie binnen de SERP zelf consumeren. Merken moeten nu focussen op zichtbaarheid binnen zoekresultaten en zorgen dat hun content is gestructureerd met schema markup zodat MUM deze goed begrijpt.

MUM is cruciaal voor AI-monitoringplatforms omdat het laat zien hoe moderne AI-systemen informatie begrijpen en ophalen. Naarmate MUM vaker voorkomt in Google Search en andere AI-systemen beïnvloedt, wordt het essentieel om te monitoren waar merken en domeinen verschijnen in MUM-aangedreven resultaten. AmICited volgt hoe merken worden geciteerd en verschijnen in AI-systemen, waaronder Google's door MUM verbeterde zoekopdrachten. Inzicht in de multimodale en meertalige mogelijkheden van MUM helpt organisaties hun aanwezigheid te optimaliseren over verschillende contentformaten en talen, zodat ze zichtbaar zijn wanneer AI-systemen als MUM hun informatie aan gebruikers tonen.

Ja, MUM kan afbeeldingen en video geavanceerd begrijpen. Wanneer je een afbeelding uploadt of video toevoegt aan een zoekopdracht, herkent MUM niet alleen objecten—het haalt ook context, betekenis en relaties eruit. Bijvoorbeeld: als je MUM een foto van wandelschoenen laat zien en vraagt 'kan ik deze gebruiken voor Mt. Fuji?', begrijpt MUM de kenmerken van de schoen uit de afbeelding en koppelt dat aan je vraag om een contextueel antwoord te geven. Deze multimodale interpretatie is een van de krachtigste eigenschappen van MUM en stelt het in staat vragen te beantwoorden die visueel begrip vereisen, gecombineerd met tekstuele kennis.

Begin met het volgen van hoe AI-chatbots uw merk vermelden op ChatGPT, Perplexity en andere platforms. Krijg bruikbare inzichten om uw AI-aanwezigheid te verbeteren.

Discussie in de community waarin Google MUM en de impact ervan op AI-zoekopdrachten wordt uitgelegd. Experts delen hoe dit multimodale AI-model contentoptimalis...

Ontdek het Multitask Unified Model (MUM) van Google en de impact ervan op AI-zoekresultaten. Begrijp hoe MUM complexe zoekopdrachten verwerkt over meerdere form...

Beheers optimalisatie voor multimodale AI-zoekopdrachten. Leer hoe je afbeeldingen en spraakvragen optimaliseert voor door AI aangedreven zoekresultaten, met st...